Seien wir ehrlich: KI-Coding-Assistenten wie GitHub Copilot sind fantastisch, aber ihre Abonnementkosten können ein Loch in Ihren Geldbeutel reißen. Hier kommt DeepSeek R1 ins Spiel – ein kostenloses Open-Source-Sprachmodell, das in Bezug auf Argumentation und Coding-Aufgaben mit GPT-4 und Claude 3.5 konkurriert. Kombinieren Sie es mit Cline, einem VS Code-Plugin, das diese KI in einen vollwertigen Coding-Agenten verwandelt, und Sie erhalten ein leistungsstarkes Setup, das autonom Code schreibt, debuggt und sogar ausführt – und das alles ohne einen Cent auszugeben.

In diesem Leitfaden führe ich Sie durch alles, was Sie wissen müssen, von der Installation von Cline bis zur Optimierung von DeepSeek R1 für Ihre Projekte. Fangen wir an!

Was DeepSeek R1 so besonders macht?

1. Es ist kostenlos (ja, wirklich!)

Im Gegensatz zu proprietären Modellen ist DeepSeek R1 vollständig Open Source und kommerziell nutzbar. Keine Token-Limits, keine versteckten Gebühren – nur rohe KI-Power.

2. Leistung, die mit kostenpflichtigen Modellen konkurriert

DeepSeek R1 zeichnet sich in den Bereichen Coding, Mathematik und logisches Denken aus. Beispielsweise übertrifft seine 32B-Parameter-Variante OpenAI’s o1-mini in Code-Generierungs-Benchmarks, und sein 70B-Modell erreicht bei komplexen Aufgaben Claude 3.5 Sonnet.

3. Flexible Bereitstellungsoptionen

Führen Sie es lokal aus, um Datenschutz und Geschwindigkeit zu gewährleisten, oder nutzen Sie die erschwingliche API von DeepSeek (ab 0,01 $ pro Million Token) für den Cloud-basierten Zugriff.

Einrichten von DeepSeek R1 in VS Code mit Cline

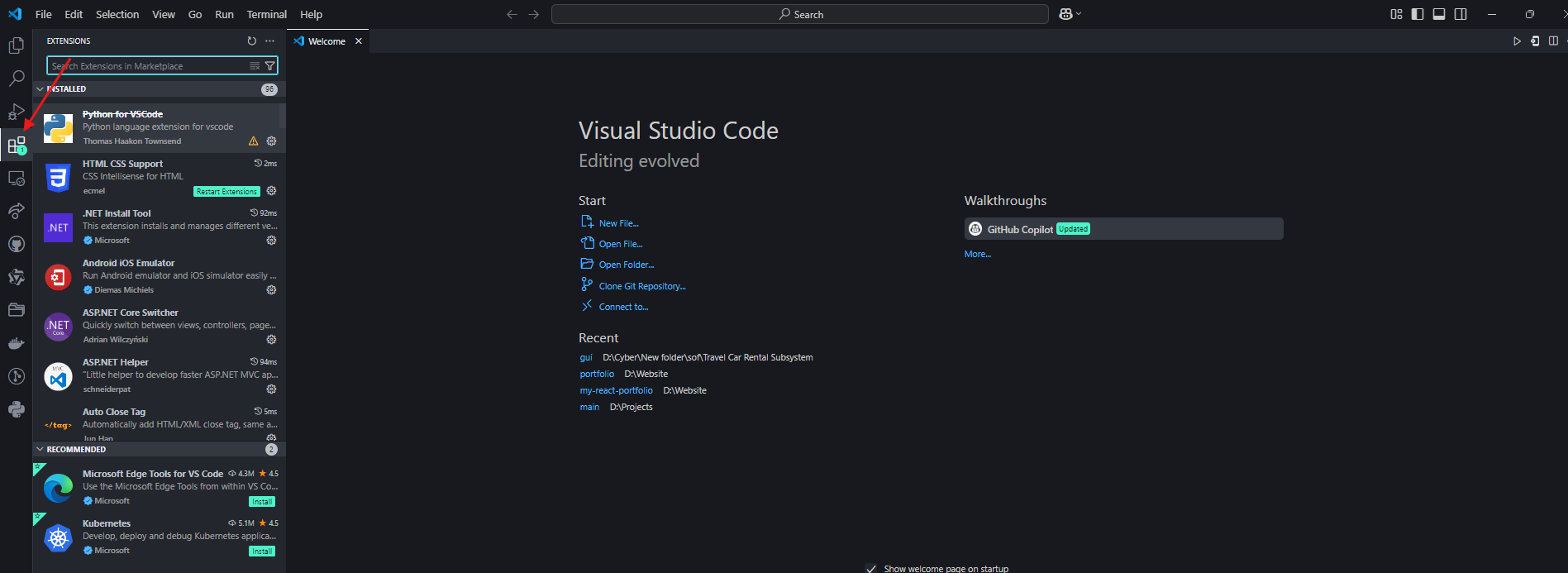

Schritt 1: Installieren Sie das Cline-Plugin

- Öffnen Sie VS Code und navigieren Sie zur Registerkarte Extensions (Erweiterungen).

2. Suchen Sie nach “Cline” und installieren Sie es.

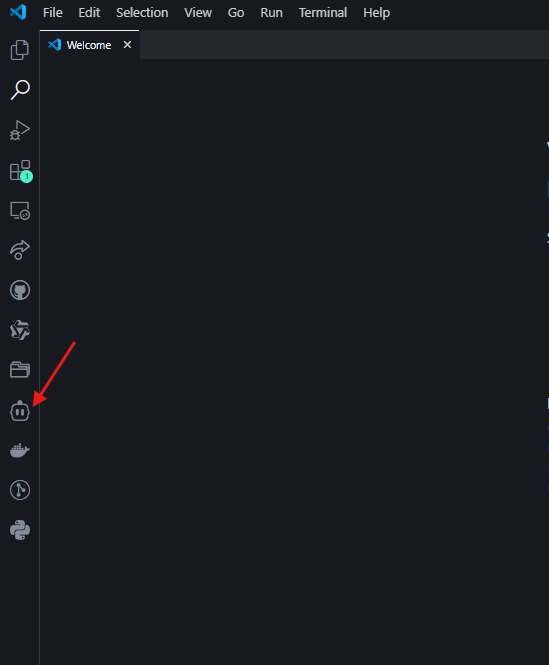

3. Klicken Sie auf das Robotersymbol in der linken Seitenleiste, um Cline zu aktivieren.

Schritt 2: Wählen Sie Ihren DeepSeek R1-Workflow

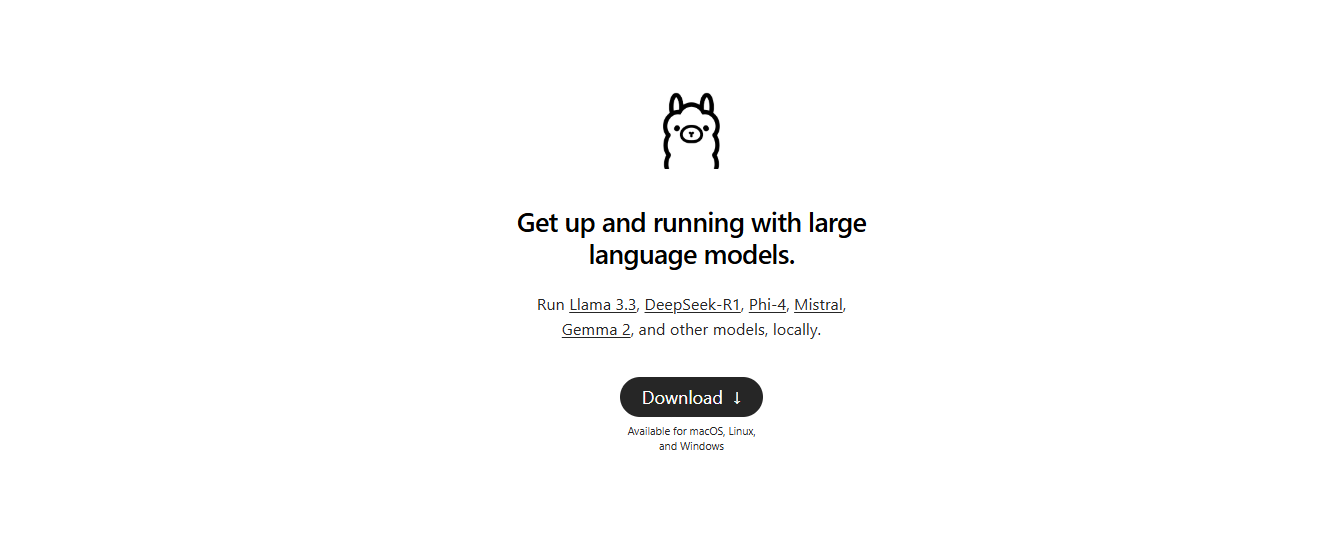

Option A: Lokales Setup (kostenlos, Datenschutz-orientiert)

- Installieren Sie Ollama: Laden Sie es von ollama.com herunter, um lokale KI-Modelle zu verwalten.

2. Ziehen Sie das Modell: Führen Sie in Ihrem Terminal Folgendes aus:

ollama pull deepseek-r1:14b # Für Mid-Tier-Hardware (z. B. RTX 3060)

Kleinere Modelle wie 1.5b funktionieren für grundlegende Aufgaben, aber 14B+ wird für das Coding empfohlen.

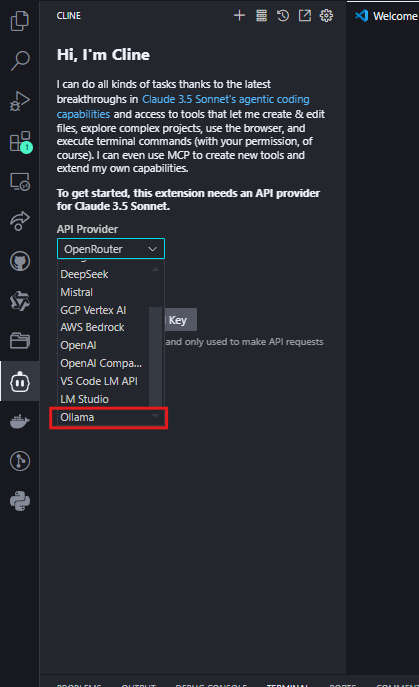

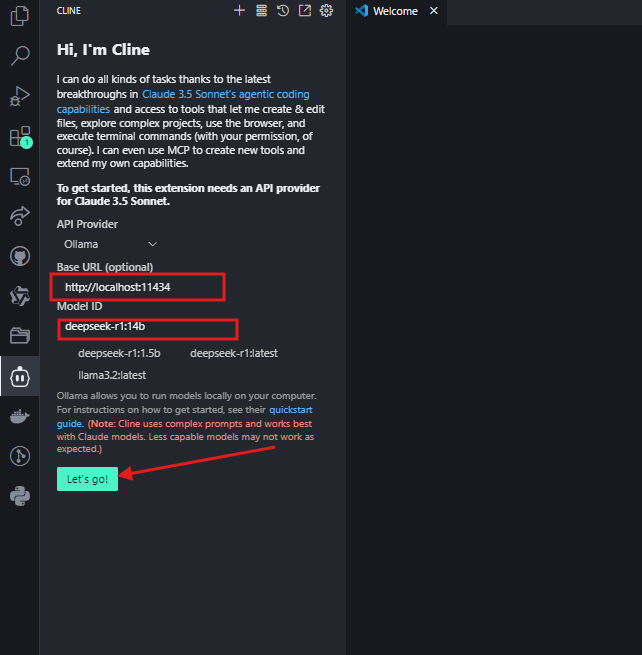

- Konfigurieren Sie Cline:

- Stellen Sie den API-Anbieter auf “Ollama” ein.

- Geben Sie

http://localhost:11434als Basis-URL ein und wählen Sie Ihr Modell aus (z. B.deepseek-r1:14b).

Klicken Sie auf "Lets go" und Sie können es jetzt verwenden.

Option B: OpenRouter-Integration (flexibles Modell-Switching)

Für Entwickler, die über einen einzigen API-Schlüssel Zugriff auf mehrere KI-Modelle (einschließlich DeepSeek R1) haben möchten, bietet OpenRouter eine optimierte Lösung. Dies ist ideal, wenn Sie gelegentlich Ausgaben mit Modellen wie GPT-4 oder Claude vergleichen müssen, aber DeepSeek R1 als Standard verwenden möchten.

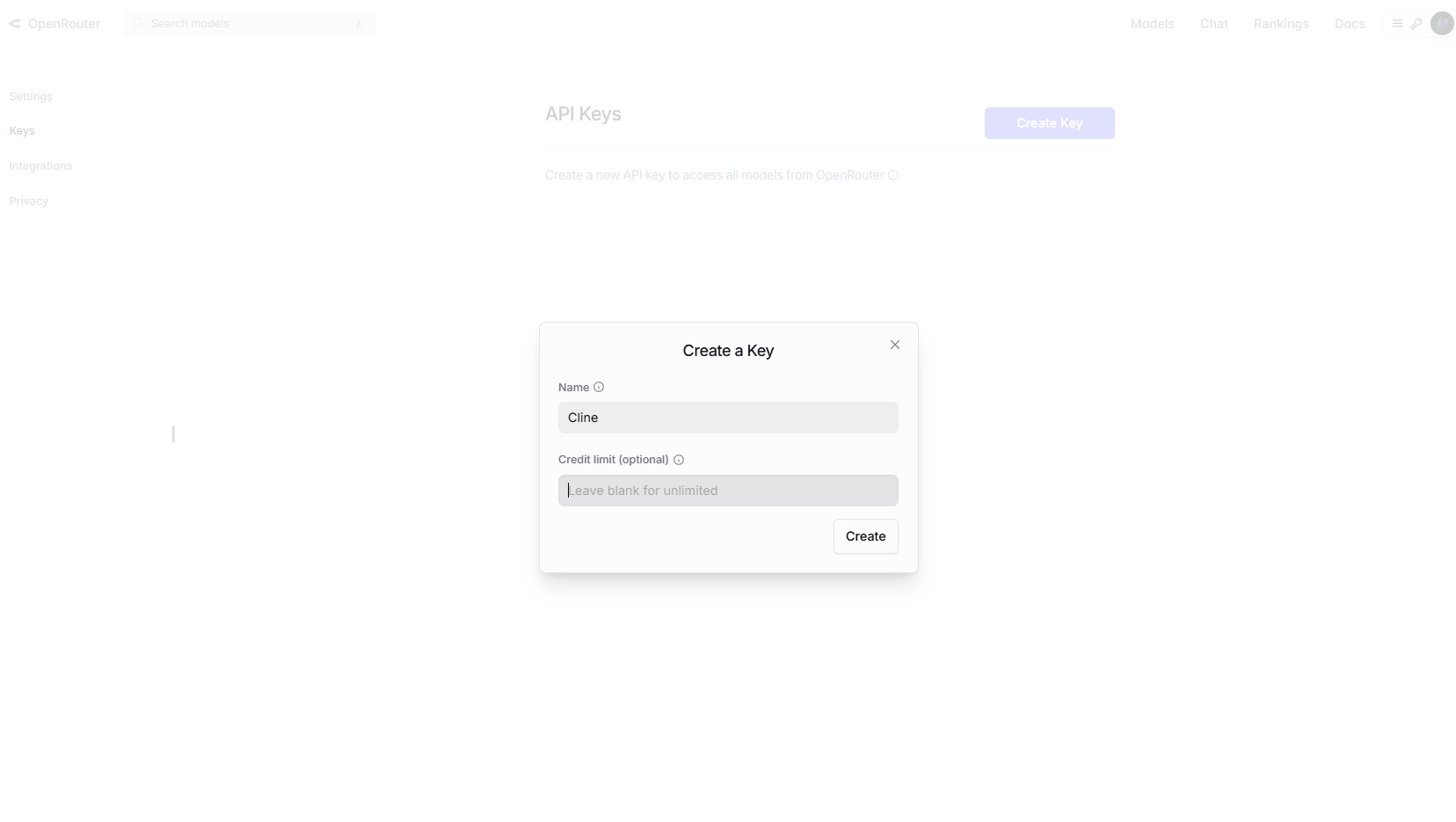

Schritt 1: Holen Sie sich Ihren OpenRouter-API-Schlüssel

- Besuchen Sie OpenRouter.ai und melden Sie sich an.

- Navigieren Sie zu API Keys (API-Schlüssel) und erstellen Sie einen neuen Schlüssel.

Optional: Aktivieren Sie Ausgabenlimits in den Kontoeinstellungen zur Kostenkontrolle.

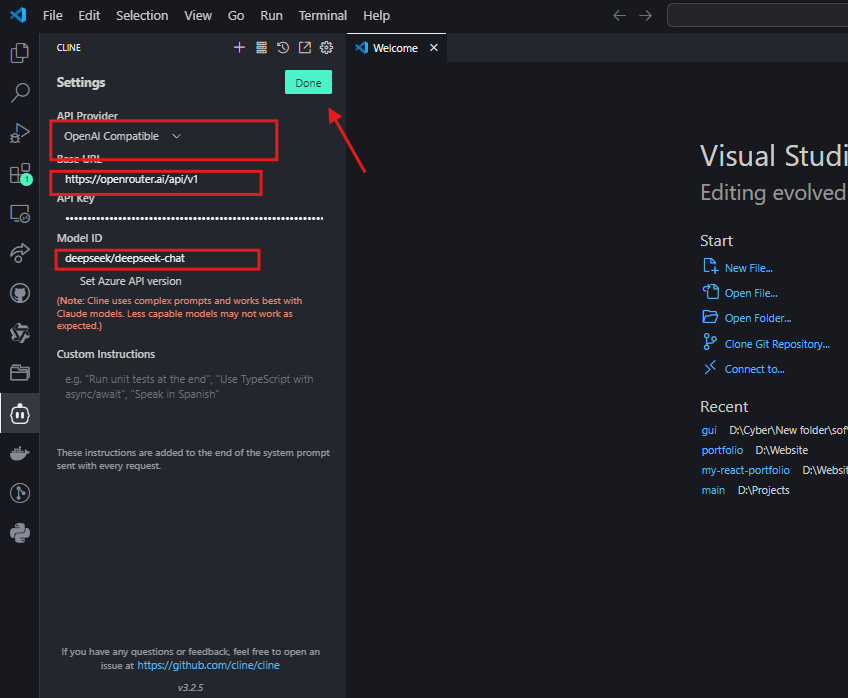

Schritt 2: Konfigurieren Sie Cline für OpenRouter

- Öffnen Sie in VS Code die Einstellungen von Cline.

- Wählen Sie “OpenAI-Compatible” als API-Anbieter.

- Stellen Sie die Basis-URL auf

https://openrouter.ai/api/v1ein. - Fügen Sie Ihren OpenRouter-API-Schlüssel ein.

- Geben Sie im Feld Model ID (Modell-ID)

deepseek/deepseek-chatein.

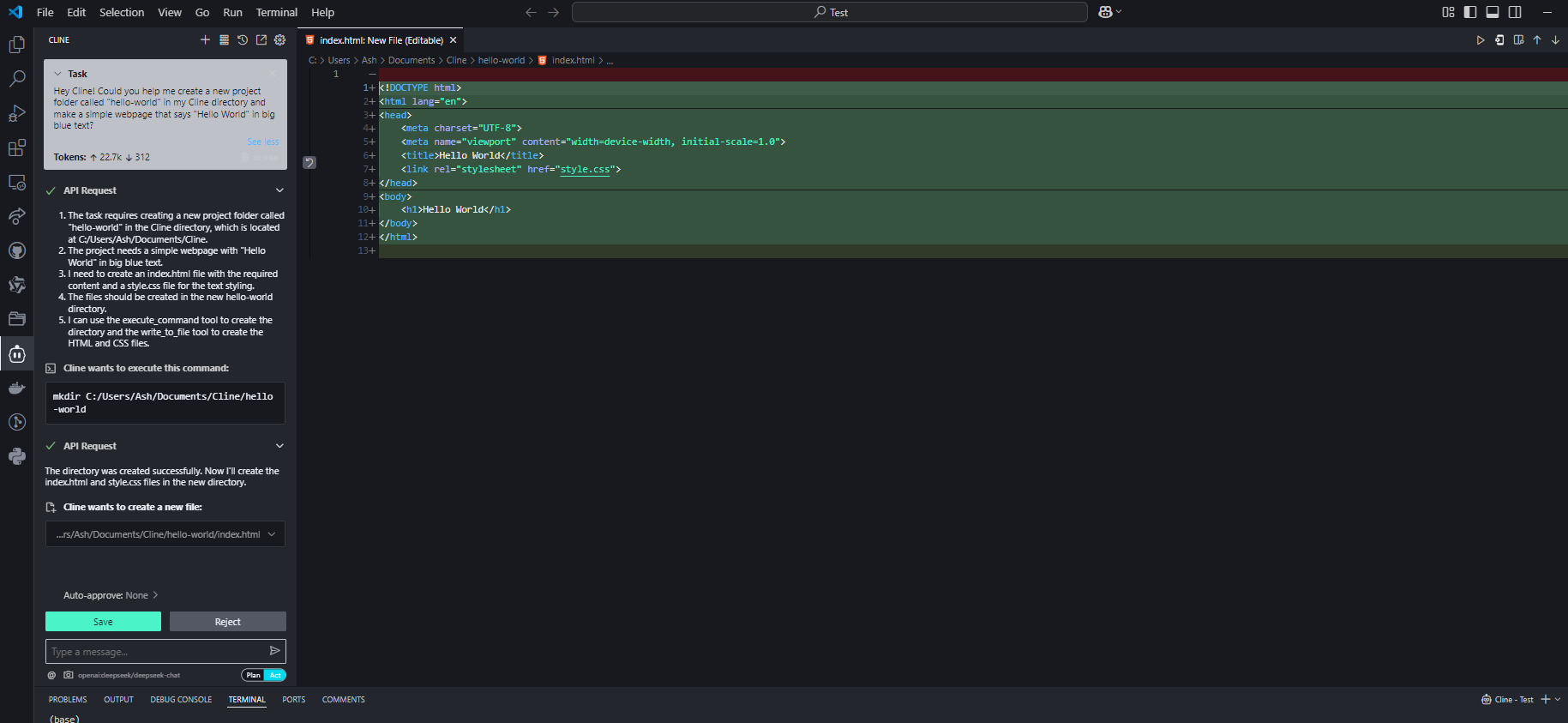

Schritt 3: Testen Sie die Integration

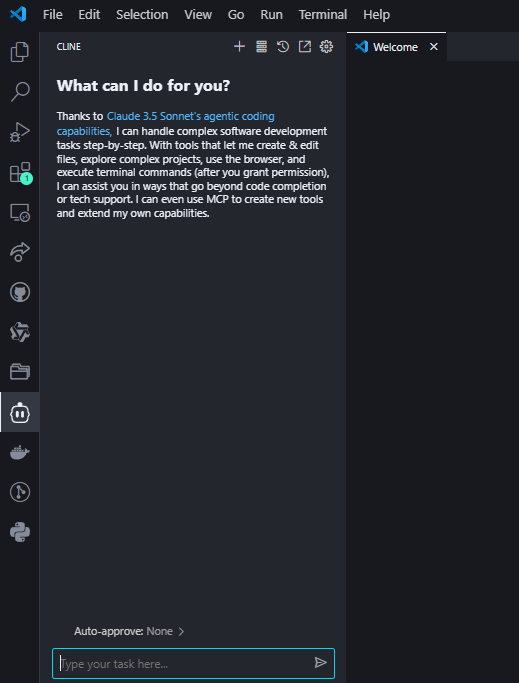

Stellen Sie Cline eine Coding-Frage, um das Setup zu bestätigen:

Bei korrekter Konfiguration generiert DeepSeek R1 Code mit Erklärungen in der Cline-Oberfläche.

Warum OpenRouter wählen?

- Multi-Model-Zugriff: Wechseln Sie einfach zwischen DeepSeek R1 und über 50 anderen Modellen (z. B. GPT-4, Claude), ohne APIs neu konfigurieren zu müssen4.

- Kostentransparenz: Verfolgen Sie die Token-Nutzung über alle Modelle in einem Dashboard4.

- Fallback-Unterstützung: Leiten Sie Anfragen automatisch an Backup-Modelle weiter, wenn die API von DeepSeek R1 überlastet ist4.

Kostenüberlegungen

Obwohl die Preisgestaltung von OpenRouter für DeepSeek R1 eng mit den direkten API-Kosten übereinstimmt (~0,01 $ pro Million Eingabe-Token), sollten Sie die Preisseite für Echtzeit-Raten immer überprüfen. Für Vielnutzer kann die einheitliche Abrechnung von OpenRouter die Ausgabenverwaltung vereinfachen25.

Profi-Tipps zur Leistungsoptimierung

1. Modellgröße vs. Hardware

| Modell | RAM benötigt | Empfohlene GPU |

|---|---|---|

| 1.5B | 4GB | Integriert |

| 7B | 8–10GB | NVIDIA GTX 1660 |

| 14B | 16GB+ | RTX 3060/3080 |

| 70B | 40GB+ | RTX 4090/A100 |

Tipp: Quantisierte Modelle (z. B. Q4_K_M.gguf) reduzieren die VRAM-Nutzung um 30 % ohne größere Qualitätsverluste.

2. Prompt Engineering

- Für Code: Fügen Sie explizite Anweisungen wie „Verwenden Sie Python 3.11 und Typ-Hinweise“ ein.

- Für das Debuggen: Fügen Sie Fehlerprotokolle ein und fragen Sie „Erklären Sie diesen Fehler und beheben Sie ihn“.

Behebung häufiger Probleme

1. Langsame Antworten

- Behebung: Wechseln Sie zu einem kleineren Modell oder aktivieren Sie die GPU-Beschleunigung in Ollama mit

OLLAMA_GPU_LAYERS=12.

2. Halluzinationen oder falsche Antworten

- Behebung: Verwenden Sie strengere Prompts (z. B. „Antworten Sie nur unter Verwendung des bereitgestellten Kontexts“) oder aktualisieren Sie auf größere Modelle wie 32B.

3. Cline ignoriert den Datei-Kontext

- Behebung: Geben Sie immer vollständige Dateipfade an (z. B.

/src/components/Login.jsx) anstelle vager Verweise.

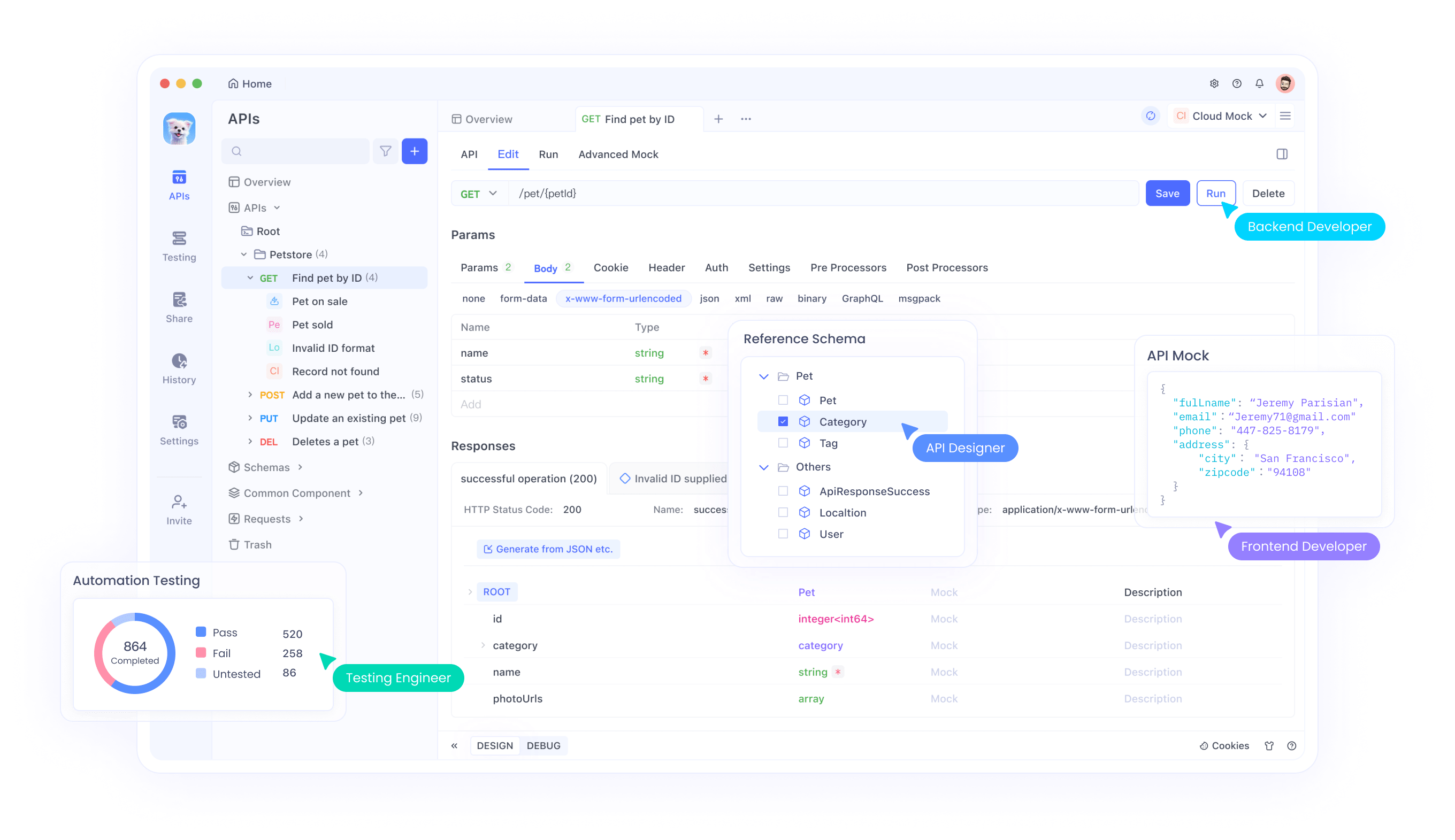

Erweiterte Anwendungsfälle mit Apidog-Integration

Sobald Ihr DeepSeek R1 + Cline-Setup läuft, verwenden Sie Apidog, um:

- API-Endpunkte zu testen: Validieren Sie die Antworten von DeepSeek programmgesteuert.

- Workflows zu automatisieren: Verketten Sie die Code-Generierung von Cline mit API-Aufrufen (z. B. Bereitstellen eines generierten Skripts in AWS).

- Leistung zu überwachen: Verfolgen Sie Latenz und Genauigkeit im Laufe der Zeit.

Fazit: Warum diese Kombination überzeugt

DeepSeek R1 und Cline sind nicht nur Werkzeuge – sie sind ein Paradigmenwechsel. Sie erhalten Intelligenz auf GPT-4-Niveau ohne Kosten, volle Kontrolle über die Privatsphäre und einen Workflow, der sich wie die Zusammenarbeit mit einem erfahrenen Entwickler anfühlt.

Bereit, Ihr Coding aufzuladen?

- Installieren Sie Cline und Ollama.

- Wählen Sie Ihr DeepSeek R1-Modell.

- Bauen Sie etwas Erstaunliches – und lassen Sie mich wissen, wie es läuft!

Vergessen Sie nicht, Apidog herunterzuladen, um API-Tests und -Automatisierung zu optimieren. Es ist der perfekte Sidekick für Ihre KI-gestützte Coding-Reise!