Entwickler sind ständig auf der Suche nach Tools, die komplexe Arbeitsabläufe rationalisieren, und Mistral AIs Devstral 2 erweist sich in diesem Bereich als bahnbrechend. Diese Open-Source-Modellfamilie für die Codegenerierung, bestehend aus Devstral 2 und Devstral Small 2, zeichnet sich durch Aufgaben wie Codebasis-Erkundung, Fehlerbehebung und Multi-Datei-Bearbeitungen aus. Was sie auszeichnet? Ihre Integration mit der Mistral API ermöglicht nahtlosen Zugriff auf hochperformante Codegenerierung direkt in Ihren Anwendungen. Darüber hinaus ermöglicht die Kombination mit dem Vibe CLI-Tool eine terminalbasierte Automatisierung, die sich intuitiv und dennoch leistungsstark anfühlt.

Devstral 2 verstehen: Eine technische Aufschlüsselung der Modellfamilie

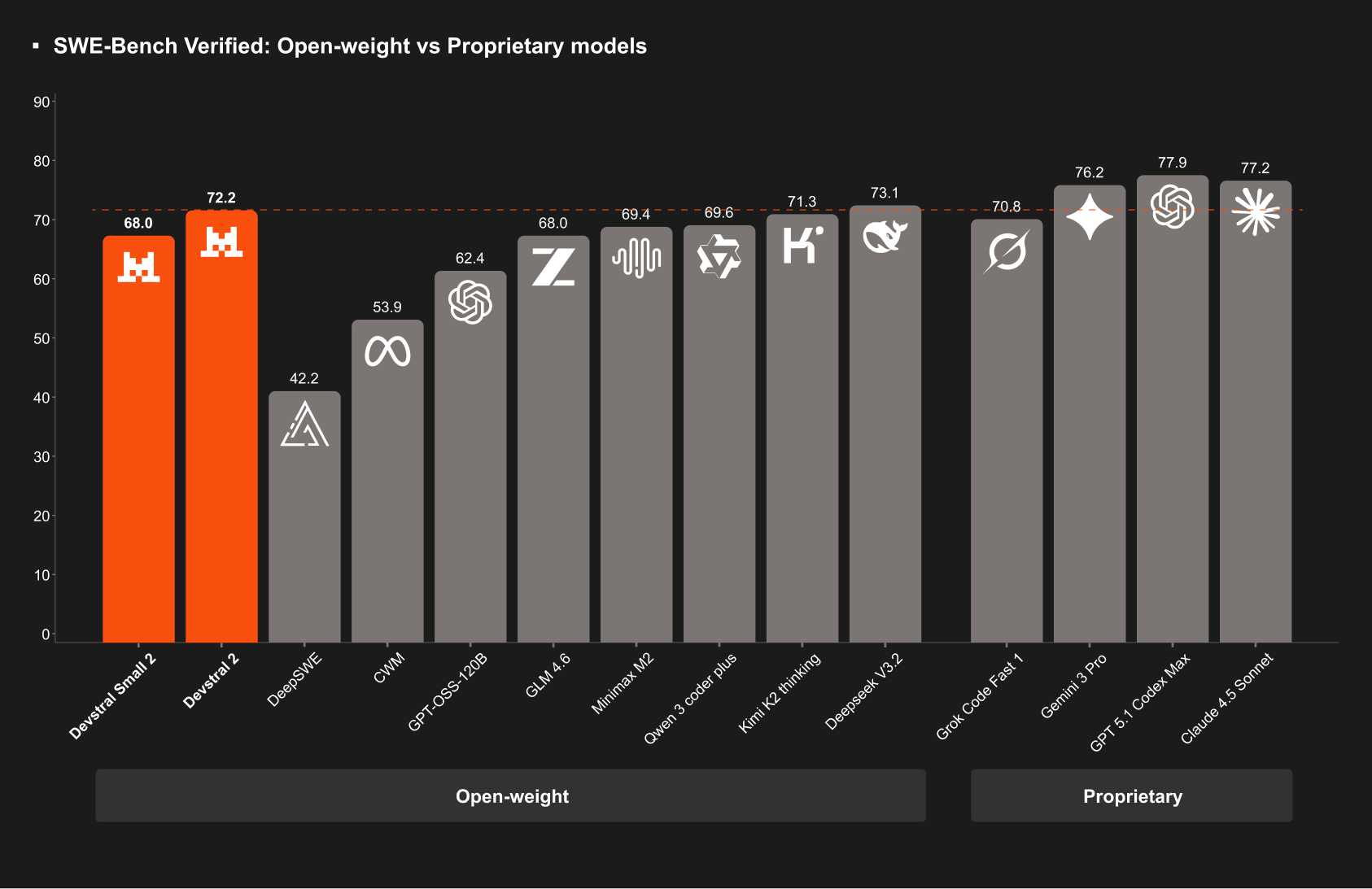

Mistral AI-Ingenieure haben Devstral 2 entwickelt, um reale Herausforderungen im Software-Engineering direkt anzugehen. Im Kern verarbeitet Devstral 2 – ein 123B Parameter dichter Transformer – Code mit Präzision und erreicht 72,2 % im SWE-bench Verified Benchmark. Dieser Wert spiegelt seine Fähigkeit wider, GitHub-Probleme autonom zu lösen, und übertrifft Modelle wie DeepSeek V3.2 mit einer Gewinnrate von 42,8 % in menschlichen Bewertungen. Folglich wird es von Teams für produktionsreife Aufgaben eingesetzt, ohne den Overhead größerer Konkurrenten.

Devstral Small 2 hingegen zielt mit 24B Parametern auf ressourcenbeschränkte Umgebungen ab. Es erreicht 68,0 % im SWE-bench und bietet multimodale Unterstützung, indem es Bildeingaben für Aufgaben wie die Screenshot-basierte Codegenerierung akzeptiert. Beide Modelle arbeiten unter permissiven Lizenzen: Devstral 2 über eine modifizierte MIT-Lizenz und Devstral Small 2 unter Apache 2.0. Diese Offenheit fördert Community-Beiträge und benutzerdefinierte Feinabstimmung.

Technisch gesehen nutzen diese Modelle ein 256K-Token-Kontextfenster, das es ihnen ermöglicht, ganze Repositorys für eine ganzheitliche Analyse aufzunehmen. Zum Beispiel verfolgt Devstral 2 Framework-Abhängigkeiten über Dateien hinweg, erkennt Fehler und schlägt Wiederholungen vor – Funktionen, die das manuelle Debugging in Benchmarks um bis zu 50 % reduzieren. Darüber hinaus ist seine Architektur auf Kosteneffizienz optimiert; Entwickler berichten von 7-fachen Einsparungen gegenüber Claude Sonnet für gleichwertige Ergebnisse.

Betrachten Sie die Auswirkungen für den Unternehmenseinsatz. Devstral 2 bewältigt Argumentationen auf Architekturebene und modernisiert Altsysteme, indem es monolithischen Code in Microservices umstrukturiert. Im Gegensatz dazu läuft Devstral Small 2 auf Einzel-GPU-Setups, was es ideal für Edge-Implementierungen macht. Infolgedessen skalieren Organisationen KI-gestütztes Coding ohne Infrastruktur-Überarbeitungen.

Zur Quantifizierung der Leistung untersuchen Sie die wichtigsten Metriken:

| Modell | Parameter | SWE-bench Score | Kontextfenster | Multimodale Unterstützung | Lizenz |

|---|---|---|---|---|---|

| Devstral 2 | 123B | 72.2% | 256K | Nein | Modifizierte MIT |

| Devstral Small 2 | 24B | 68.0% | 256K | Ja | Apache 2.0 |

Diese Spezifikationen positionieren Devstral 2 als vielseitiges Rückgrat für Code-Agenten. Als Nächstes wenden wir uns dem Vibe CLI zu, das diese Leistung auf Ihre Befehlszeile bringt.

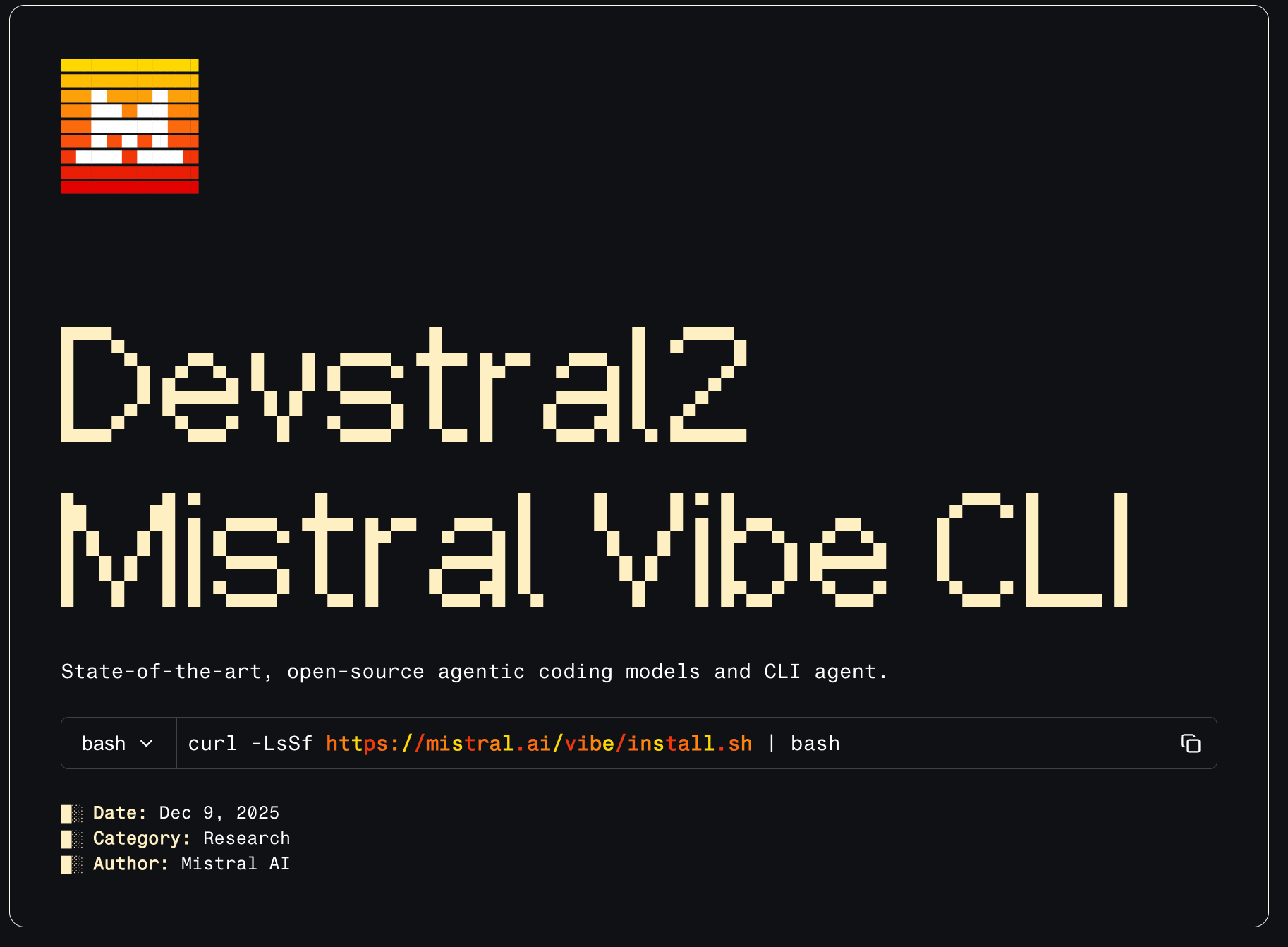

Vibe CLI erkunden: Befehlszeilenschnittstelle für die Devstral 2-Automatisierung

Vibe CLI ist Mistral AIs Open-Source-Begleiter zu Devstral 2, der natürliche Sprachprompts in ausführbare Codeänderungen umwandelt. Entwickler installieren es über einen einfachen Curl-Befehl: curl -LsSf https://mistral.ai/vibe/install.sh | bash. Einmal eingerichtet, startet es eine interaktive Chat-Schnittstelle im Terminal, komplett mit Autovervollständigung und dauerhaftem Verlauf.

Was macht Vibe CLI so effektiv? Es integriert projektbezogenen Kontext, indem es Verzeichnisse scannt, um Dateien mit der @-Notation zu referenzieren. Geben Sie beispielsweise @main.py ein, um ein Skript zur Analyse abzurufen. Führen Sie außerdem Shell-Befehle mit ! aus, wie !git status, um die Versionskontrolle nahtlos zu integrieren. Slash-Befehle verbessern die Benutzerfreundlichkeit weiter: /config passt die Einstellungen an, während /theme die Oberfläche anpasst.

Unter der Haube hält sich Vibe CLI an das Agent Communication Protocol, was IDE-Erweiterungen wie das Zed-Plugin ermöglicht. Konfigurieren Sie es über eine config.toml-Datei, in der Sie Modell-Provider (z. B. lokale Devstral-Instanzen oder Mistral API-Schlüssel), Tool-Berechtigungen und automatische Genehmigungsregeln für Ausführungen festlegen. Diese Flexibilität verhindert eine Überbeanspruchung; für sensible Projekte deaktivieren Sie Dateischreibzugriffe standardmäßig.

In der Praxis glänzt Vibe CLI bei iterativen Workflows. Angenommen, Sie warten eine Python-Webanwendung. Geben Sie den Prompt ein: "Refaktorieren Sie das Authentifizierungsmodul in @auth.py, um JWT anstelle von Sessions zu verwenden." Vibe CLI erkundet Abhängigkeiten, generiert Diffs und wendet Änderungen über !git apply an. Wenn Konflikte auftreten, erkennt es diese und schlägt Alternativen vor – ähnlich den Wiederholungsmechanismen von Devstral 2.

Benchmarks zeigen, dass Vibe CLI End-to-End-Aufgaben in Multi-Datei-Szenarien 3x schneller erledigt als manuelle Bearbeitung. Darüber hinaus unterstützt sein Skriptmodus Automatisierungsskripte, wie die Stapelverarbeitung von PR-Überprüfungen. Für lokale Ausführungen kombinieren Sie es mit Devstral Small 2 auf Consumer-Hardware; die Inferenzzeiten sinken auf Sekunden pro Antwort.

Die wahre Stärke von Vibe CLI liegt jedoch in seiner API-Synergie. Es leitet Anfragen an die Mistral API weiter und speichert Antworten zur Effizienz im Cache. Im weiteren Verlauf wird diese Brücke entscheidend für benutzerdefinierte Integrationen.

Zugriff auf die Devstral 2 API: Schritt-für-Schritt-Implementierungsanleitung

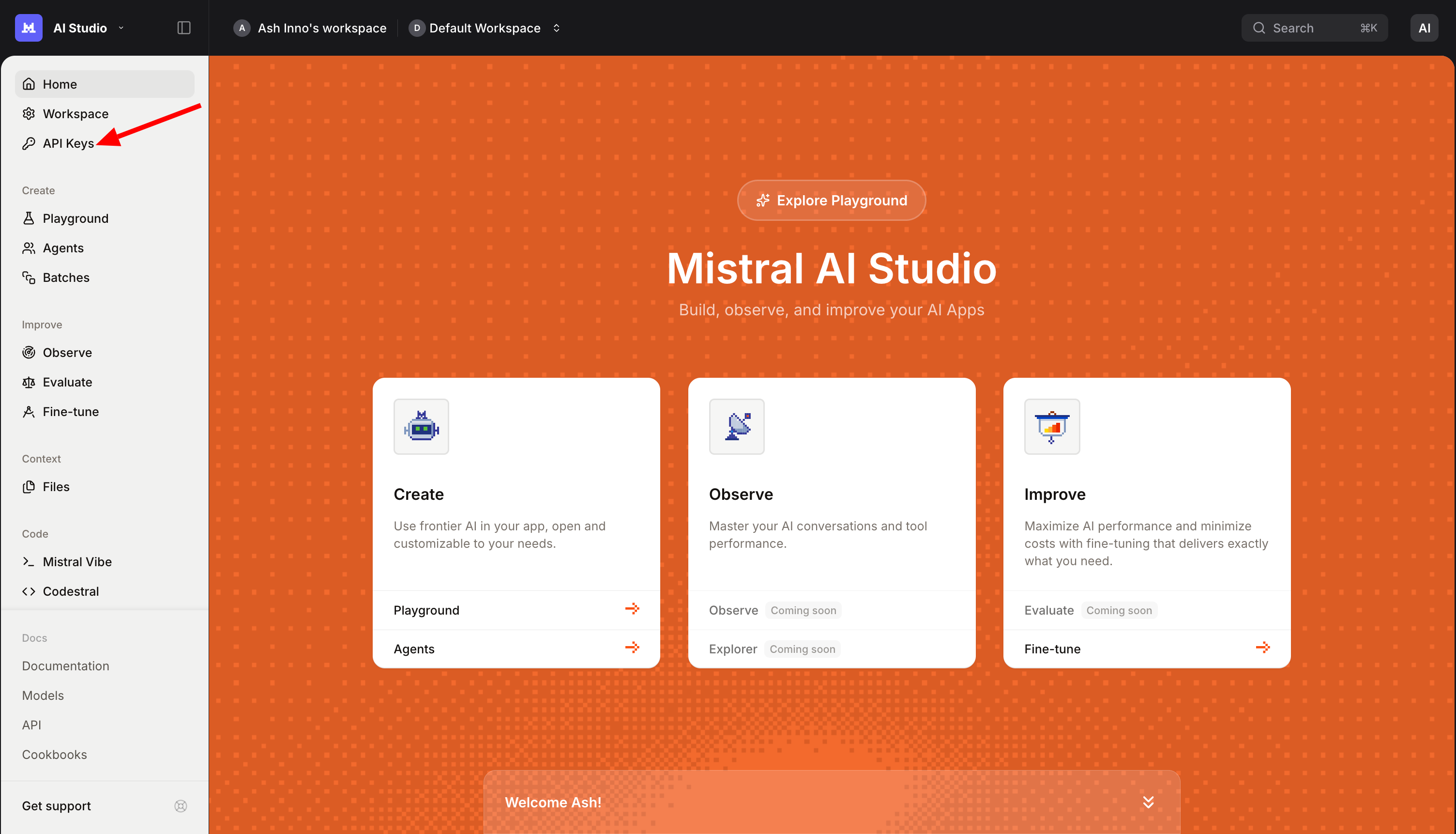

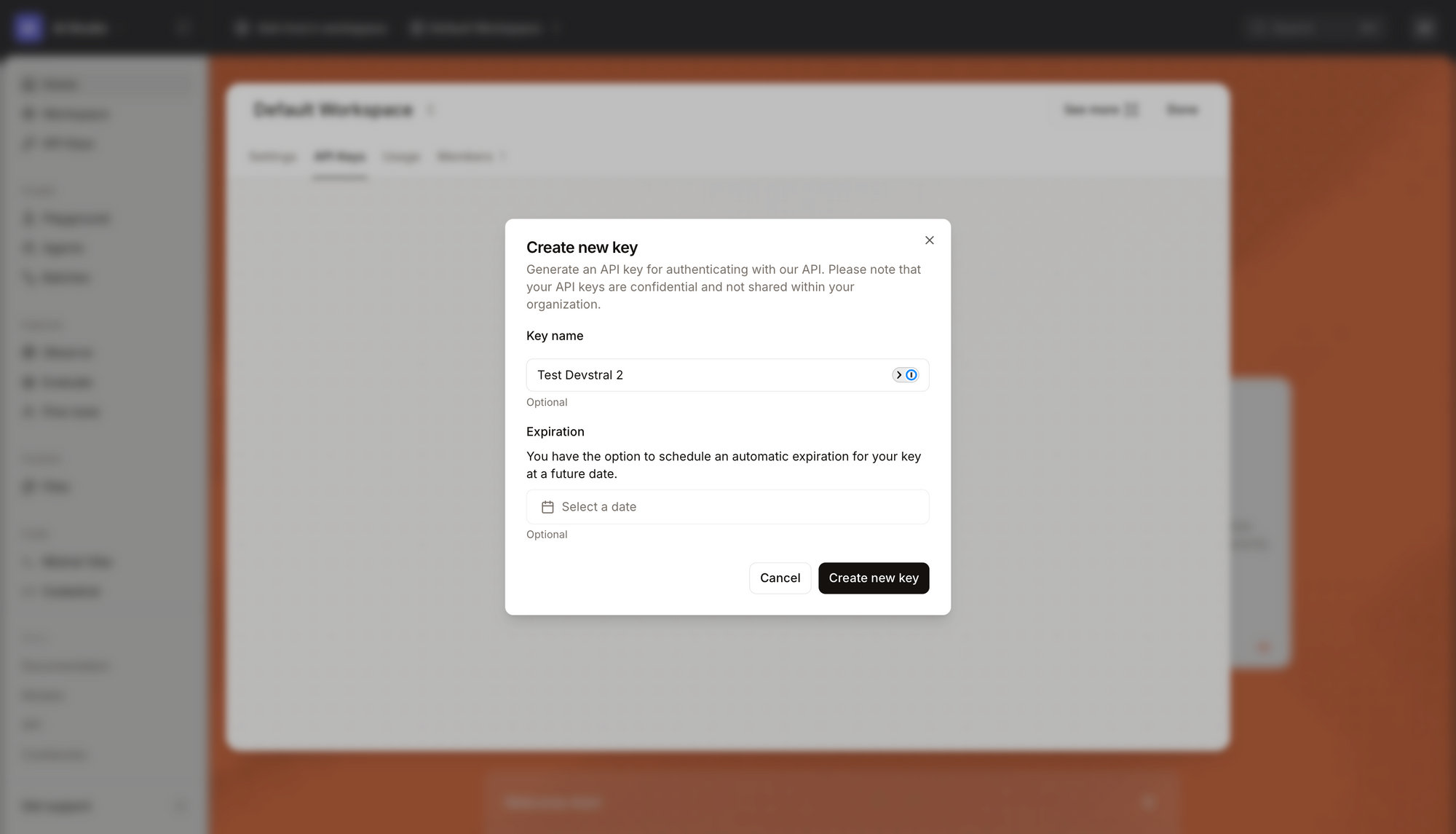

Der Zugriff auf die Devstral 2 API erfordert ein Mistral AI-Konto, das in der Konsole verfügbar ist. Die Anmeldung gewährt während der Einführungsphase sofortigen kostenlosen Zugang, der in ein Pay-as-you-go-Preismodell übergeht: 0,40 $ Input / 2,00 $ Output pro Million Tokens für Devstral 2 und 0,10 $ / 0,30 $ für Devstral Small 2. Die Authentifizierung erfolgt über API-Schlüssel, die im Konsolen-Dashboard generiert werden.

Beginnen Sie mit dem Erhalt Ihres Schlüssels. Navigieren Sie zum API-Bereich, erstellen Sie einen neuen Schlüssel und speichern Sie ihn sicher.

Die API folgt RESTful-Konventionen über HTTPS, mit Endpunkten, die unter https://api.mistral.ai/v1 gehostet werden. Kernoperationen umfassen Chat-Vervollständigungen, Feinabstimmung und Embeddings, aber für die Codierung konzentrieren Sie sich auf /v1/chat/completions.

Erstellen Sie Anfragen im JSON-Format. Ein einfaches Curl-Beispiel für Devstral 2:

curl https://api.mistral.ai/v1/chat/completions \

-H "Content-Type: application/json" \

-H "Authorization: Bearer $MISTRAL_API_KEY" \

-d '{

"model": "devstral-2",

"messages": [{"role": "user", "content": "Write a Python function to parse JSON configs."}],

"max_tokens": 512,

"temperature": 0.1

}'

Dieser Aufruf gibt generierten Code im Feld choices[0].message.content zurück. Passen Sie die temperature für Kreativität (0.0 für deterministische Ausgaben) und max_tokens für die Antwortlänge an. Für Codebasis-Aufgaben fügen Sie Kontext in den Prompt ein: Fügen Sie Dateiinhalte voran oder verwenden Sie Systemnachrichten für Anweisungen.

Fortgeschrittene Nutzung beinhaltet das Streamen von Antworten mit "stream": true, ideal für Echtzeit-IDE-Plugins. Die API unterstützt bis zu 256K Tokens, daher stapeln Sie große Eingaben. Fehlerbehandlung ist wichtig; häufige Codes umfassen 401 (nicht autorisiert) und 429 (Ratenbegrenzungen). Implementieren Sie Wiederholungen mit exponentiellem Backoff:

import requests

import time

import os

def call_devstral(prompt, model="devstral-2"):

url = "https://api.mistral.ai/v1/chat/completions"

headers = {

"Authorization": f"Bearer {os.getenv('MISTRAL_API_KEY')}",

"Content-Type": "application/json"

}

data = {

"model": model,

"messages": [{"role": "user", "content": prompt}],

"max_tokens": 1024,

"temperature": 0.2

}

while True:

response = requests.post(url, json=data, headers=headers)

if response.status_code == 429:

time.sleep(2 ** attempt) # Exponential Backoff

attempt += 1

elif response.status_code == 200:

return response.json()["choices"][0]["message"]["content"]

else:

raise Exception(f"API error: {response.status_code}")

# Beispielanwendung

code = call_devstral("Optimize this SQL query: SELECT * FROM users WHERE age > 30;")

print(code)

Dieses Python-Snippet demonstriert robuste Aufrufe. Für multimodale Anwendungen mit Devstral Small 2 laden Sie Bilder über Base64-Kodierung im Inhalts-Array hoch.

Ratenbegrenzungen variieren je nach Stufe; überwachen Sie die Nutzung über die Konsole. Feinabstimmungsendpunkte (/v1/fine_tuning/jobs) ermöglichen die Anpassung an proprietäre Datensätze, was JSONL-Dateien mit Prompt-Completion-Paaren erfordert.

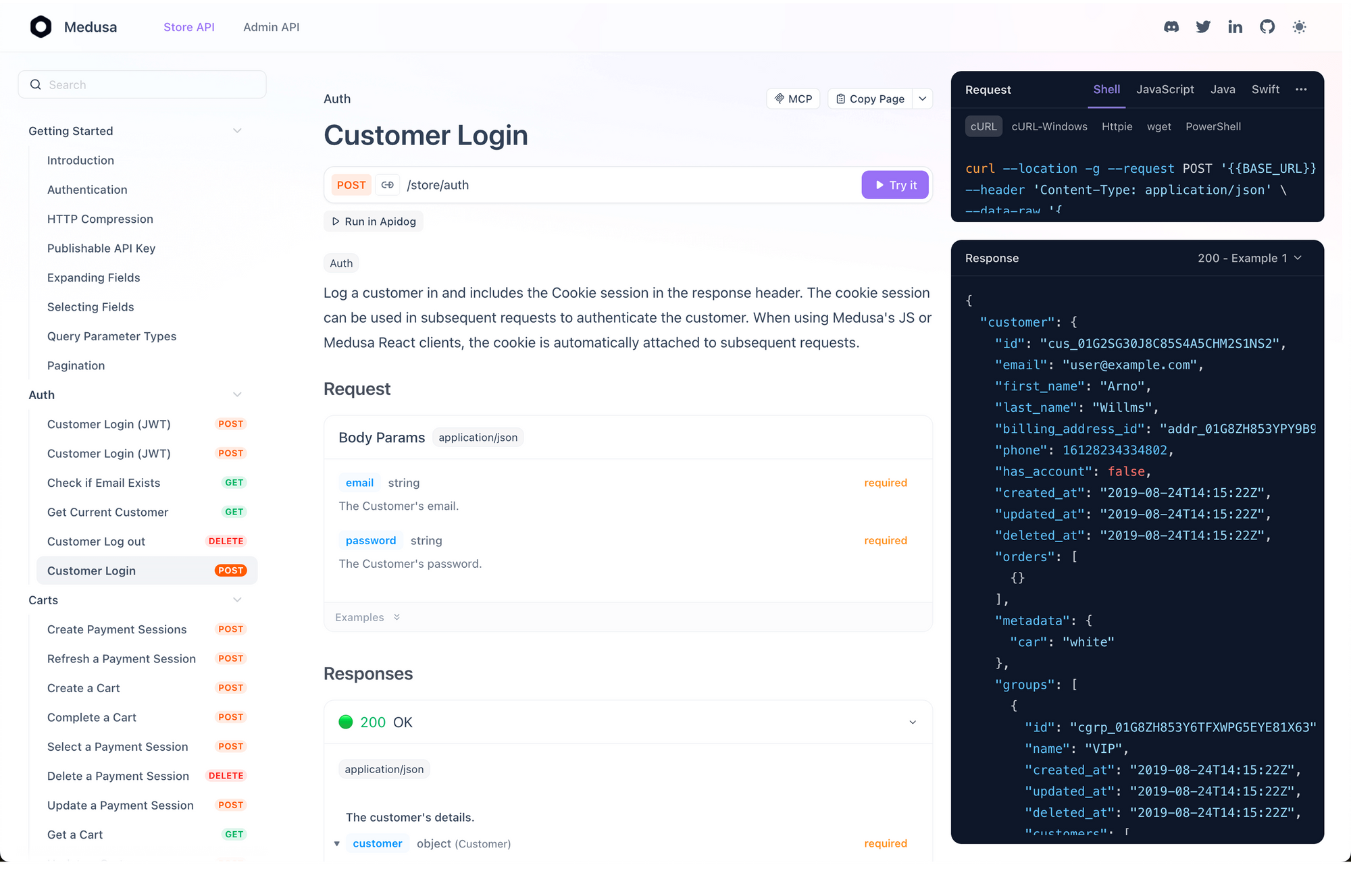

Beim Übergang zum Testen vereinfacht Apidog die Validierung. Importieren Sie die Mistral OpenAPI-Spezifikation in Apidog, simulieren Sie Umgebungen und führen Sie Sammlungen aus, um Workflows zu simulieren. Dieser Ansatz fängt Grenzfälle frühzeitig ab.

Devstral 2 API in Apidog integrieren: Best Practices für API-getriebene Entwicklung

Apidog erweitert die Nutzung der Devstral 2 API, indem es eine einheitliche Plattform für Design, Tests und Dokumentation bietet. Beginnen Sie mit dem kostenlosen Download von Apidog – kostenlos für Einzelpersonen – und der Erstellung eines neuen Projekts. Fügen Sie das Mistral API-Schema (verfügbar in der Konsole) ein, um Endpunkte automatisch zu generieren.

Warum Apidog? Es unterstützt OpenAPI 3.0, was mit Mistrals Spezifikation übereinstimmt, und bietet visuelle Request Builder. Testen Sie eine Chat-Vervollständigung: Stellen Sie die Methode auf POST ein, fügen Sie Ihr Bearer-Token hinzu und geben Sie JSON-Payloads ein. Apidogs Antwort-Viewer parst JSON und hebt Codeausgaben zur schnellen Überprüfung hervor.

Für die Automatisierung nutzen Sie Apidogs Skripting. Pre-Request-Skripte rufen dynamische Kontexte ab, wie z. B. aktuelle Git-Diffe, bevor sie die API aufrufen. Post-Response-Skripte parsen Generierungen und lösen Vibe CLI-Befehle aus. Beispielskript in JavaScript:

// Pre-request: Repo-Kontext abrufen

pm.sendRequest({

url: 'https://api.github.com/repos/user/repo/contents/',

method: 'GET',

header: {

'Authorization': 'token {{github_token}}'

}

}, (err, res) => {

if (!err) {

pm.variables.set('context', res.json().map(f => f.name).join('\n'));

}

});

// Hauptanfrage verwendet {{context}} im Prompt

Diese Integration stellt sicher, dass Prompts relevant bleiben. Darüber hinaus ermöglichen Apidogs Kollaborationsfunktionen Teams, Sammlungen zu teilen und die Nutzung von Devstral 2 zu standardisieren.

Fortgeschrittene Anwendungsfälle: Devstral 2 und Vibe CLI in der Produktion nutzen

Über die Grundlagen hinaus treibt die Devstral 2 API hochentwickelte Agenten an. Kombinieren Sie sie mit Vibe CLI für hybride Workflows: Verwenden Sie CLI für lokales Prototyping und stellen Sie dann API-Endpunkte in CI/CD-Pipelines bereit. Integrieren Sie sie beispielsweise in GitHub Actions:

name: Code Review

on: [pull_request]

jobs:

review:

runs-on: ubuntu-latest

steps:

- uses: actions/checkout@v3

- name: Run Devstral Review

run: |

curl -X POST https://api.mistral.ai/v1/chat/completions \

-H "Authorization: Bearer ${{ secrets.MISTRAL_API_KEY }}" \

-d '{

"model": "devstral-2",

"messages": [{"role": "user", "content": "Review changes in ${{ github.event.pull_request.diff_url }}"}]

}' | jq '.choices[0].message.content' > review.md

- name: Comment PR

uses: actions/github-script@v6

with:

script: |

github.rest.pulls.createReview({

owner: context.repo.owner,

repo: context.repo.repo,

pull_number: context.payload.pull_request.number,

body: fs.readFileSync('review.md', 'utf8')

})

Dieses YAML automatisiert Überprüfungen, indem es Diffs abruft und Feedback generiert. Vibe CLI ergänzt dies durch die Handhabung lokaler Merges: vibe "Apply suggested changes from review.md".

In multimodalen Szenarien verarbeitet die Devstral Small 2 API UI-Screenshots. Führen Sie Base64-Bilder ein: {"type": "image_url", "image_url": {"url": "data:image/png;base64,iVBOR..."}}. Anwendungen umfassen Barrierefreiheitsprüfungen, bei denen das Modell Vorschläge zur Verbesserung von Alt-Texten macht.

Für den Unternehmenseinsatz optimieren Sie auf domänenspezifische Daten. Laden Sie Datensätze auf /v1/fine_tuning/jobs hoch und geben Sie Epochen und Lernraten an. Nach dem Training stellt die API benutzerdefinierte Modelle an dedizierten Endpunkten bereit, wodurch die Latenz um 30 % reduziert wird.

Edge Computing profitiert von Devstral Small 2s On-Device-Laufzeit. Stellen Sie über ONNX bereit und integrieren Sie API-Fallbacks für Überlaufverkehr. Tools wie Kilo Code oder Cline erweitern dies, indem sie die Vibe CLI-Logik in VS Code einbetten.

Metriken von Anwendern zeigen einen 5-fachen Produktivitätsgewinn: Ein Startup refaktorierte einen 100.000 Zeilen umfassenden Monolithen in Wochen und schreibt dies Devstral 2s Abhängigkeitsverfolgung zu.

Fazit: Transformieren Sie Ihre Codierung noch heute mit der Devstral 2 API

Devstral 2 definiert die KI-gestützte Entwicklung durch seine robuste Modellfamilie, die intuitive Vibe CLI und die zugängliche API neu. Entwickler nutzen diese für alles, von schnellen Korrekturen bis hin zu vollständigen Refaktorierungen, unterstützt durch beeindruckende Benchmarks und Kosteneinsparungen.

Implementieren Sie die beschriebenen Strategien – beginnen Sie mit Vibe CLI-Installationen, sichern Sie API-Schlüssel und testen Sie über Apidog. Kleine Optimierungen, wie präzise Prompts oder gecachte Kontexte, führen zu erheblichen Effizienzsteigerungen. Während sich KI weiterentwickelt, positioniert Devstral 2 Sie an vorderster Front.

Bereit zum Experimentieren? Gehen Sie zur Mistral-Konsole, starten Sie Vibe CLI und laden Sie Apidog kostenlos herunter. Ihr nächster Durchbruch wartet.