Entwickler suchen oft nach robusten APIs, um KI-Anwendungen zu betreiben. Die DeepSeek-V3.1 API sticht als vielseitige Option hervor. Sie bietet fortschrittliche Sprachmodellierungsfähigkeiten. Sie erhalten Zugriff auf Funktionen wie Chat-Vervollständigungen und Tool-Integrationen. Dieser Beitrag erklärt Ihnen Schritt für Schritt, wie Sie sie verwenden.

Zuerst besorgen Sie sich einen API-Schlüssel von der DeepSeek-Plattform. Registrieren Sie sich auf deren Website und generieren Sie den Schlüssel. Damit können Sie Anfragen stellen.

Als Nächstes verstehen Sie die Kernkomponenten. DeepSeek-V3.1 basiert auf großskaligen Modellen. Es unterstützt Kontexte von bis zu 128K Tokens. Sie bearbeiten komplexe Anfragen effizient. Darüber hinaus enthält es Denkmodi für tieferes Schlussfolgern. Während Sie fortfahren, beachten Sie, wie diese Elemente zusammenpassen.

Was ist DeepSeek-V3.1 und warum sollten Sie es wählen?

DeepSeek-V3.1 stellt eine Evolution in KI-Modellen dar. Ingenieure bei DeepSeek-ai entwickelten es als hybride Architektur. Das Modell umfasst insgesamt 671 Milliarden Parameter, aktiviert jedoch während der Inferenz nur 37 Milliarden. Dieses Design reduziert den Rechenaufwand bei gleichzeitig hoher Leistung.

Sie finden zwei Hauptvarianten: DeepSeek-V3.1-Base und das vollständige DeepSeek-V3.1. Die Basisversion dient als Grundlage für weiteres Training. Sie durchlief eine zweiphasige Erweiterung des langen Kontexts. In der ersten Phase wurde das Training auf 630 Milliarden Tokens für 32K Kontext erweitert. Dann fügte die zweite Phase 209 Milliarden Tokens für 128K Kontext hinzu. Zusätzliche lange Dokumente bereicherten den Datensatz.

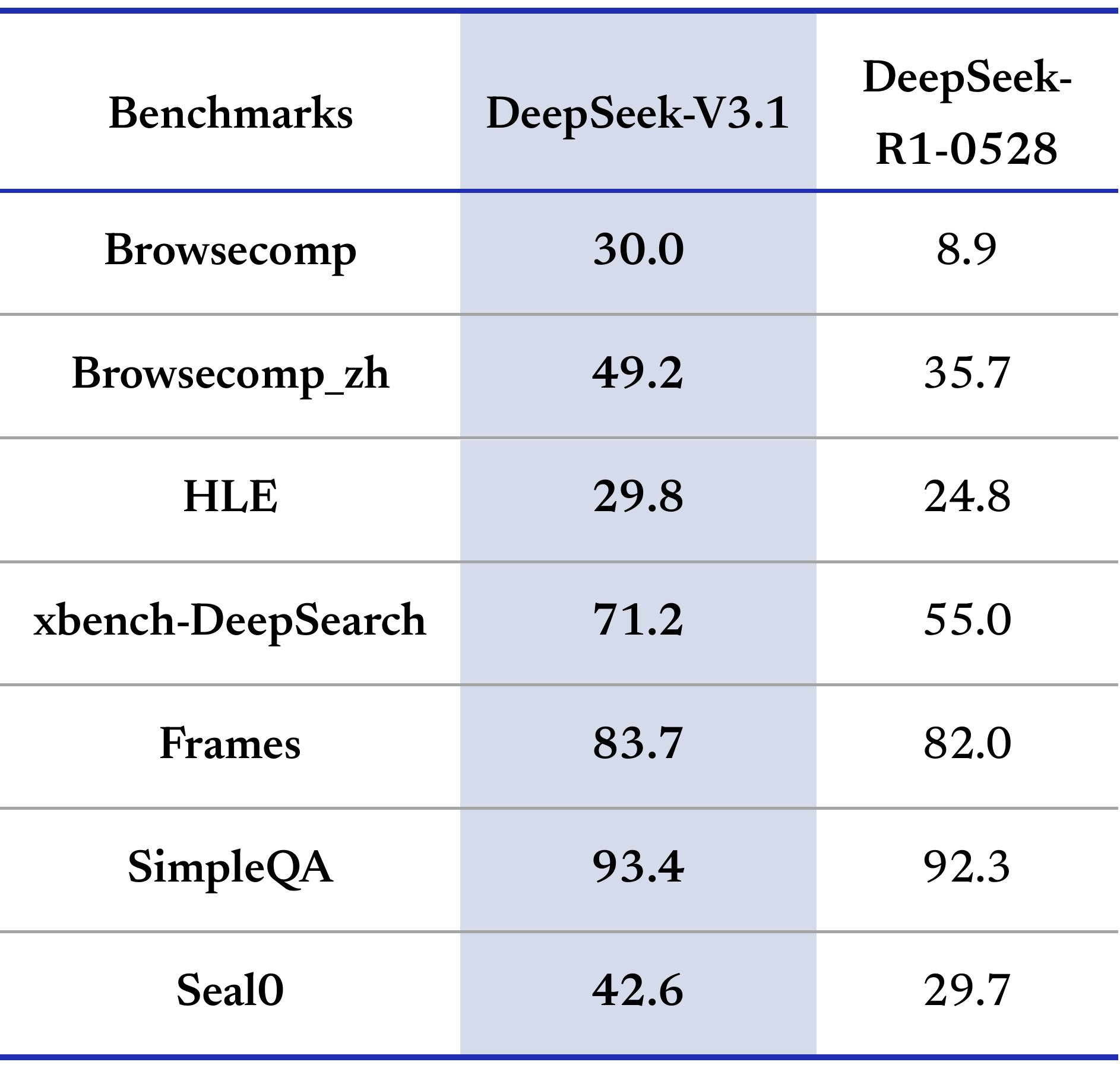

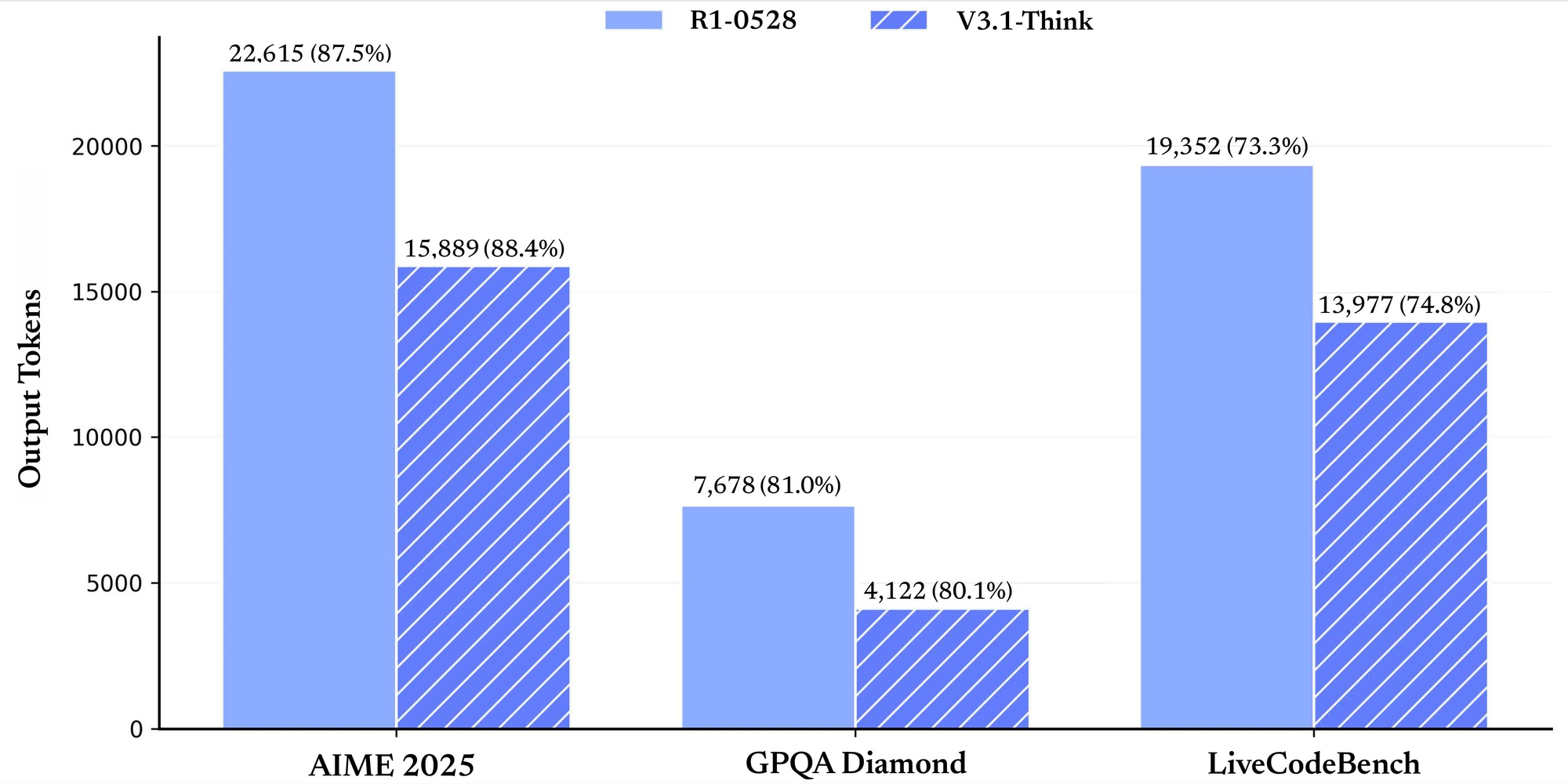

Leistungsbenchmarks unterstreichen seine Stärken. Für allgemeine Aufgaben erzielt es 91,8 auf MMLU-Redux im Nicht-Denkmodus und 93,7 im Denkmodus. Auf GPQA-Diamond erreicht es 74,9 bzw. 80,1. Bei codebezogenen Evaluierungen liefert LiveCodeBench 56,4 im Nicht-Denkmodus und 74,8 im Denkmodus. Mathematik-Benchmarks wie AIME 2024 zeigen 66,3 und 93,1. Diese Zahlen belegen die Zuverlässigkeit über verschiedene Domänen hinweg.

Warum die DeepSeek-V3.1 API wählen? Sie zeichnet sich bei Agentenaufgaben und Tool-Aufrufen aus. Sie können sie für Suchagenten oder Code-Agenten integrieren. Im Vergleich zu anderen APIs bietet sie kostengünstige Preise und Kompatibilitätsfunktionen. Infolgedessen übernehmen Teams sie für skalierbare KI-Lösungen. Beim Übergang zur Einrichtung bereiten Sie Ihre Umgebung sorgfältig vor.

Erste Schritte mit der DeepSeek-V3.1 API-Integration

Sie beginnen mit der Einrichtung Ihrer Entwicklungsumgebung. Installieren Sie die notwendigen Bibliotheken. Für Python verwenden Sie pip, um `requests` oder kompatible SDKs hinzuzufügen. DeepSeek-V3.1 API-Endpunkte folgen Standard-HTTP-Protokollen. Die Basis-URL ist https://api.deepseek.com.

Generieren Sie Ihren API-Schlüssel über das Dashboard. Speichern Sie ihn sicher in Umgebungsvariablen. Setzen Sie beispielsweise DEEPSEEK_API_KEY in Ihrer Shell. Nun stellen Sie Ihre erste Anfrage. Verwenden Sie den Chat-Vervollständigungs-Endpunkt. Senden Sie einen POST an /chat/completions.

Fügen Sie Header mit Authorization: Bearer your_key hinzu. Der Body enthält das Modell als "deepseek-chat", ein Nachrichten-Array und Parameter wie max_tokens. Eine einfache Anfrage sieht so aus:

import requests

url = "https://api.deepseek.com/chat/completions"

headers = {

"Authorization": "Bearer YOUR_API_KEY",

"Content-Type": "application/json"

}

data = {

"model": "deepseek-chat",

"messages": [{"role": "user", "content": "Hello, DeepSeek-V3.1!"}],

"max_tokens": 100

}

response = requests.post(url, headers=headers, json=data)

print(response.json())

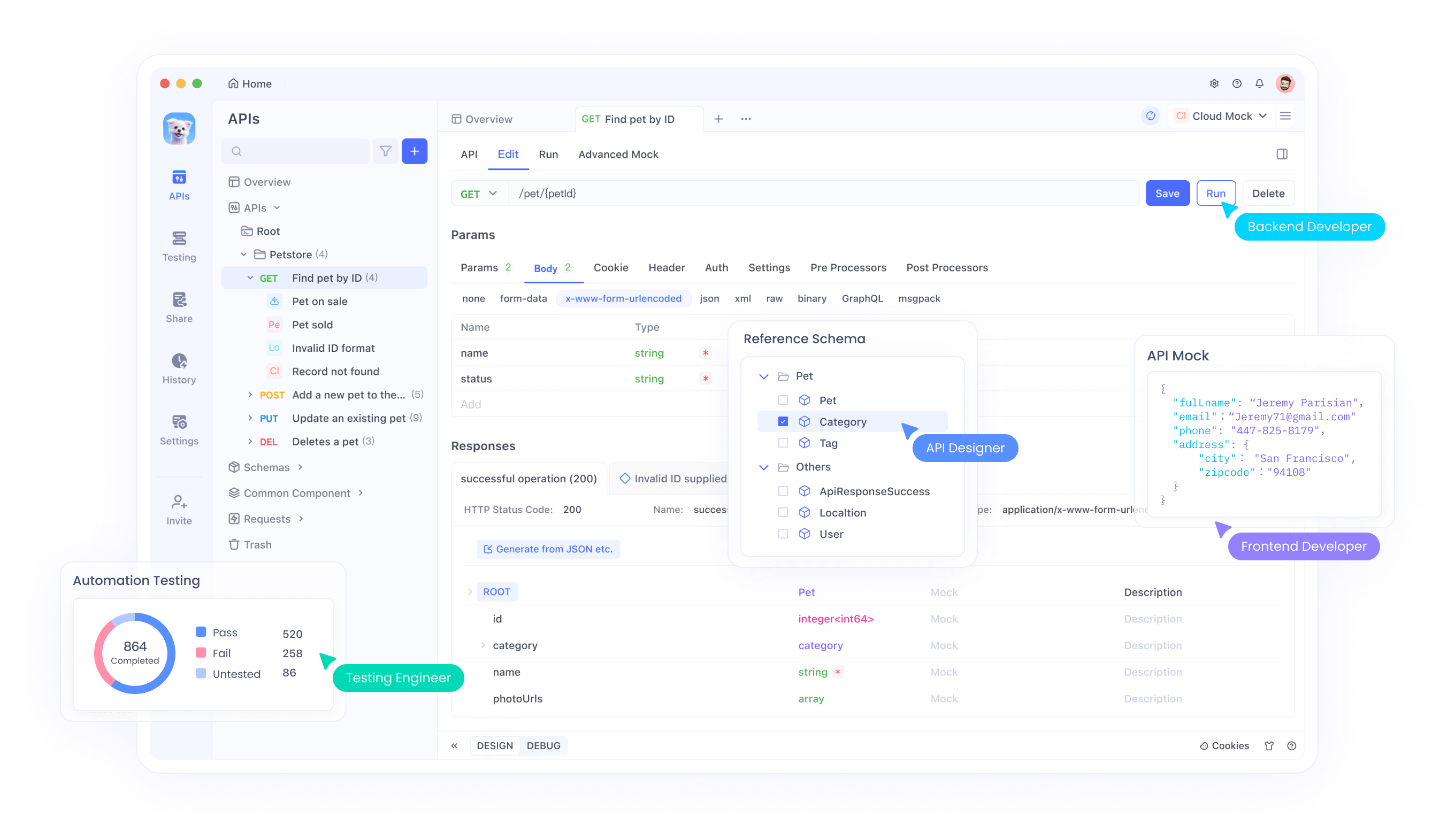

Dieser Code ruft eine Antwort ab. Überprüfen Sie das Feld `content` auf die Ausgabe. Wenn Fehler auftreten, überprüfen Sie den Schlüssel und die Payload. Testen Sie außerdem mit Apidog. Importieren Sie den Endpunkt und simulieren Sie Aufrufe. Apidog visualisiert Antworten und erleichtert das Debugging.

Erkunden Sie Modelloptionen. DeepSeek-chat eignet sich für allgemeine Chats. DeepSeek-reasoner bearbeitet Schlussfolgerungsaufgaben. Wählen Sie basierend auf Ihren Bedürfnissen. Wenn Sie Fortschritte machen, integrieren Sie Streaming für Echtzeit-Ausgaben. Setzen Sie `stream` in der Anfrage auf `true`. Verarbeiten Sie die Chunks entsprechend.

Sicherheit ist ebenfalls wichtig. Verwenden Sie immer HTTPS. Begrenzen Sie die Schlüssel-Exposition. Rotieren Sie Schlüssel regelmäßig. Nachdem die Grundlagen abgedeckt sind, gehen Sie zu erweiterten Funktionen wie dem Funktionsaufruf über.

Funktionsaufrufe in der DeepSeek-V3.1 API meistern

Der Funktionsaufruf erweitert die DeepSeek-V3.1 API. Sie definieren Tools, die das Modell aufruft. Dies ermöglicht dynamische Interaktionen, wie das Abrufen von Wetterdaten.

Definieren Sie Tools in der Anfrage. Jedes Tool hat den Typ "function", einen Namen, eine Beschreibung und Parameter. Parameter verwenden JSON-Schema. Zum Beispiel ein `get_weather`-Tool:

{

"type": "function",

"function": {

"name": "get_weather",

"description": "Get current weather",

"parameters": {

"type": "object",

"properties": {

"location": {"type": "string", "description": "City name"}

},

"required": ["location"]

}

}

}

Fügen Sie dies in das `tools`-Array Ihrer Chat-Vervollständigungsanfrage ein. Das Modell analysiert die Benutzernachricht. Falls relevant, gibt es `tool_calls` in der Antwort zurück. Jeder Aufruf hat eine ID, einen Namen und Argumente.

Behandeln Sie den Aufruf. Führen Sie die Funktion lokal aus. Für `get_weather` fragen Sie eine externe API ab oder verwenden Sie Mock-Daten. Fügen Sie das Ergebnis als Tool-Nachricht an:

{

"role": "tool",

"tool_call_id": "call_id_here",

"content": "Temperature: 24°C"

}

Senden Sie die aktualisierten Nachrichten zurück. Das Modell generiert eine endgültige Antwort.

Verwenden Sie den Strict-Modus für bessere Validierung. Setzen Sie `strict` auf `true` und verwenden Sie die Beta-Basis-URL. Dies erzwingt die Schema-Konformität. Unterstützte Typen sind `string`, `number`, `array`. Vermeiden Sie nicht unterstützte Felder wie `minLength`.

Best Practices umfassen klare Beschreibungen. Testen Sie Tools mit Apidog, um Antworten zu simulieren. Überwachen Sie Argumentfehler. Dadurch werden Ihre Anwendungen interaktiver. Als Nächstes untersuchen wir die Kompatibilität mit anderen Ökosystemen.

Nutzung der Anthropic API-Kompatibilität in DeepSeek-V3.1

Die DeepSeek-V3.1 API unterstützt das Anthropic-Format. Dies ermöglicht Ihnen die nahtlose Nutzung von Anthropic SDKs. Setzen Sie die Basis-URL auf https://api.deepseek.com/anthropic.

Installieren Sie das Anthropic SDK: `pip install anthropic`. Konfigurieren Sie die Umgebung:

export ANTHROPIC_BASE_URL=https://api.deepseek.com/anthropic

export ANTHROPIC_API_KEY=YOUR_DEEPSEEK_KEY

Nachrichten erstellen:

import anthropic

client = anthropic.Anthropic()

message = client.messages.create(

model="deepseek-chat",

max_tokens=1000,

system="You are helpful.",

messages=[{"role": "user", "content": [{"type": "text", "text": "Hi"}]}]

)

print(message.content)

Dies funktioniert wie Anthropic, verwendet aber DeepSeek-Modelle. Unterstützte Felder: `max_tokens`, `temperature` (0-2.0), `tools`. Ignoriert: `top_k`, `cache_control`.

Es gibt Unterschiede. Keine Bild- oder Dokumentenunterstützung. Tool-Auswahlmöglichkeiten begrenzt. Verwenden Sie dies für die Migration von Anthropic. Testen Sie mit Apidog, um Antworten zu vergleichen. Folglich erweitern Sie Ihr Toolkit, ohne Code neu schreiben zu müssen.

DeepSeek-V3.1 Modellarchitektur und Tokenizer verstehen

DeepSeek-V3.1-Base bildet den Kern. Es verwendet ein hybrides Design für Effizienz. Die Kontextlänge erreicht 128K, ideal für lange Dokumente.

Das Training umfasste erweiterte Phasen. Zuerst 32K mit 630B Tokens. Dann 128K mit 209B. Das FP8-Format gewährleistet Kompatibilität.

Tokenizer-Konfiguration: `add_bos_token true`, `model_max_length 131072`. BOS-Token "<|begin of sentence|>", EOS "<|end of sentence|>". Das Chat-Template verarbeitet Rollen wie Benutzer, Assistent, `think`-Tags.

Wenden Sie Templates für Konversationen an. Für den Denkmodus umschließen Sie die Argumentation mit ``-Tags. Dies steigert die Leistung bei komplexen Aufgaben.

Sie laden das Modell über Hugging Face. Verwenden Sie `from_pretrained("deepseek-ai/DeepSeek-V3.1")`. Tokenisieren Sie Eingaben sorgfältig. Überwachen Sie die Token-Anzahl, um unter den Limits zu bleiben. So optimieren Sie die Genauigkeit.

Preise und Kostenmanagement für die DeepSeek-V3.1 API

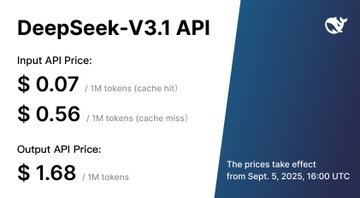

Die Preisgestaltung beeinflusst die Akzeptanz. Die DeepSeek-V3.1 API berechnet pro Million Tokens. Modelle: `deepseek-chat` und `deepseek-reasoner`.

Ab dem 5. September 2025, 16:00 UTC: Beide Modelle kosten 0,07 $ für Cache-Hit-Eingabe, 0,56 $ für Cache-Miss-Eingabe, 1,68 $ für Ausgabe.

Davor, Standard (00:30-16:30 UTC): `deepseek-chat` 0,07 $ Hit, 0,27 $ Miss, 1,10 $ Ausgabe; `reasoner` 0,14 $ Hit, 0,55 $ Miss, 2,19 $ Ausgabe. Rabatt (16:30-00:30): ungefähr halbe Preise.

Es werden keine kostenlosen Stufen erwähnt. Kosten berechnen: Schätzen Sie Tokens pro Anfrage. Verwenden Sie Caching für wiederholte Eingaben. Optimieren Sie Prompts, um Tokens zu reduzieren.

Verfolgen Sie die Nutzung im Dashboard. Legen Sie Budgets fest. Mit Apidog simulieren Sie Aufrufe, um Kosten vorherzusagen. Verwalten Sie somit Ausgaben effektiv.

Best Practices und Fehlerbehebung für die DeepSeek-V3.1 API

Befolgen Sie Richtlinien für den Erfolg. Erstellen Sie prägnante Prompts. Geben Sie Kontext in Nachrichten an.

Überwachen Sie die Latenz. Lange Kontexte verlangsamen Antworten. Teilen Sie Eingaben, wenn möglich, in Chunks auf.

Daten sichern: Vermeiden Sie das Senden sensibler Informationen.

Fehlerbehebung: Überprüfen Sie Statuscodes. 401 bedeutet ungültiger Schlüssel. 429 zu viele Anfragen.

Aktualisieren Sie SDKs regelmäßig. Lesen Sie die Dokumentation für Änderungen.

Skalieren: Batch-Anfragen, falls unterstützt. Verwenden Sie `async` für Parallelität.

Community-Foren helfen. Teilen Sie Erfahrungen.

Durch die Anwendung dieser erreichen Sie zuverlässige Integrationen.

Fazit: Heben Sie Ihre KI-Projekte mit der DeepSeek-V3.1 API auf ein neues Niveau

Sie wissen nun, wie Sie die DeepSeek-V3.1 API effektiv nutzen können. Von der Einrichtung bis zu den erweiterten Funktionen befähigt sie Entwickler. Integrieren Sie Apidog für reibungslosere Workflows. Beginnen Sie noch heute mit dem Bauen und sehen Sie die Auswirkungen.