Entwickler weltweit verlassen sich auf CodeX, den leistungsstarken KI-gesteuerten Programmierassistenten von OpenAI, um ihre Arbeitsabläufe zu optimieren und komplexe Programmieraufgaben zu bewältigen. Jüngste Diskussionen auf Plattformen wie X offenbaren jedoch eine wachsende Besorgnis: Viele Benutzer empfinden, dass CodeX im Vergleich zu seiner anfänglichen Leistung suboptimale Ergebnisse liefert. Sie stoßen auf frustrierende Fehler, langsamere Antworten oder unvollständige Code-Vorschläge und fragen sich, ob das Tool tatsächlich nachgelassen hat. Diese Wahrnehmung hält an, obwohl OpenAI kontinuierliche Verbesserungen und Metriken, die ein Wachstum der Nutzung zeigen, behauptet.

Ingenieure berichten von Fällen, in denen CodeX bei komplexen Aufgaben wie dem Anwenden von Patches oder der Bewältigung längerer Gespräche Schwierigkeiten hat, was zu Annahmen einer Verschlechterung führt. Dennoch geht das Team von OpenAI diese Probleme durch rigorose Untersuchungen aktiv an und demonstriert damit ein Engagement für Transparenz. Zum Beispiel veröffentlichten sie kürzlich einen detaillierten Bericht, der die Ergebnisse aus Benutzerfeedback und internen Evaluierungen darlegt.

CodeX verstehen: Seine Kernfunktionalität und Entwicklung

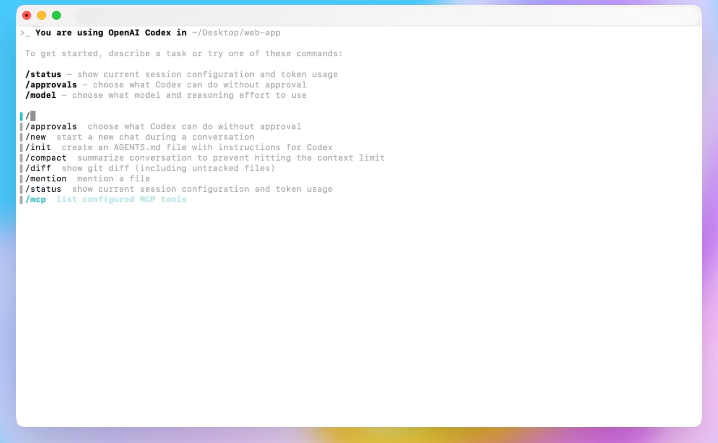

CodeX stellt einen bedeutenden Fortschritt in der KI-gestützten Programmierung dar, aufbauend auf OpenAIs Grundlage in großen Sprachmodellen. Ingenieure entwickeln CodeX, um Eingabeaufforderungen in natürlicher Sprache zu interpretieren und Code-Snippets zu generieren, Probleme zu debuggen und sogar ganze Repositories zu verwalten. Im Gegensatz zu traditionellen IDE-Plugins integriert sich CodeX tiefgreifend in Kommandozeilen-Schnittstellen und Editoren und ermöglicht so nahtlose Interaktionen.

OpenAI führte CodeX als Weiterentwicklung früherer Modelle wie Codex ein und integrierte Verbesserungen aus der GPT-5-Architektur. Diese Iteration konzentriert sich auf Persistenz, wodurch die KI Aufgaben wiederholen und sich innerhalb von Sitzungen an Benutzerfeedback anpassen kann. Folglich nutzen Entwickler CodeX für vielfältige Anwendungen, vom einfachen Skriptschreiben bis hin zu komplexen Systemintegrationen.

Mit zunehmender Akzeptanz stoßen Benutzer jedoch an die Grenzen von CodeX. Zum Beispiel könnten anfängliche Aufgaben grundlegende Funktionen umfassen, aber fortgeschrittene Benutzer versuchen Multi-Datei-Bearbeitungen oder API-Orchestrierungen. Diese Verschiebung offenbart Einschränkungen und wirft Fragen zur Leistungskonsistenz auf.

Darüber hinaus verwendet CodeX Tools wie apply_patch für Dateiänderungen und Komprimierung für das Kontextmanagement. Diese Funktionen verbessern die Benutzerfreundlichkeit, führen aber Variablen ein, die die Ergebnisse beeinflussen. Wenn Sie eine Eingabeaufforderung eingeben, verarbeitet CodeX diese über eine Responses API, die Tokens streamt und Ergebnisse parst. Jede Diskrepanz in dieser Pipeline kann sich als wahrgenommene Verdummung manifestieren.

Benutzerberichte: Anzeichen dafür, dass CodeX möglicherweise unterdurchschnittlich ist

Benutzer teilen aktiv Erfahrungen auf sozialen Plattformen und heben Fälle hervor, in denen CodeX die Erwartungen nicht erfüllt. Zum Beispiel bemerkte ein Entwickler auf X, dass CodeX bei anfänglichen Aufgaben hervorragend ist, aber bei zunehmender Komplexität Schwierigkeiten hat, was zu Annahmen einer Modellverschlechterung führt.

Insbesondere umfassen Berichte, dass CodeX während der Patch-Anwendung falsche Diffs generiert, was zu Dateilöschungen und -neuerstellungen führt. Dieses Verhalten stört Arbeitsabläufe, insbesondere bei unterbrochenen Sitzungen. Eine weitere häufige Beschwerde betrifft die Latenz; Aufgaben, die einst schnell erledigt wurden, dauern jetzt aufgrund von Wiederholungsversuchen mit verlängerten Timeouts länger.

Darüber hinaus beobachten Benutzer Sprachwechsel mitten in der Antwort, wie den Wechsel von Englisch zu Koreanisch, was auf Fehler bei der eingeschränkten Stichprobenentnahme zurückzuführen ist. Diese Anomalien betreffen weniger als 0,25 % der Sitzungen, verstärken aber die Frustration, wenn sie auftreten.

Zusätzlich wird die Komprimierung – eine Funktion, die Gespräche zusammenfasst, um den Kontext zu verwalten – kritisiert. Wenn Sitzungen länger werden, verschlechtern mehrere Komprimierungen die Genauigkeit, was OpenAI dazu veranlasst, Warnungen hinzuzufügen: Starten Sie neue Gespräche für gezielte Interaktionen.

Des Weiteren tragen Hardware-Variationen dazu bei; ältere Setups führen zu leichten Leistungseinbrüchen, die die Bindung beeinträchtigen. Entwickler mit Premium-Plänen berichten von Inkonsistenzen, obwohl Metriken ein Gesamtwachstum zeigen.

Nach diesen Berichten liefert die Analyse quantitativer Beweise Klarheit darüber, ob diese Probleme eine echte Verschlechterung oder eine sich entwickelnde Nutzung anzeigen.

Analyse der Beweise: Metriken, Feedback und Nutzungsmuster

OpenAI sammelt umfangreiche Daten zur CodeX-Leistung, einschließlich Evaluierungen über CLI-Versionen und Hardware hinweg. Evaluierungen bestätigen Verbesserungen, wie eine 10%ige Reduzierung des Token-Verbrauchs nach CLI 0.45-Updates, ohne Regressionen bei Kernaufgaben.

Benutzerfeedback über den Befehl /feedback offenbart jedoch Trends. Ingenieure sichten täglich über 100 Probleme und verknüpfen sie mit spezifischer Hardware oder Funktionen. Prädiktive Modelle korrelieren die Bindung mit Faktoren wie Betriebssystem und Plantyp und identifizieren Hardware als geringfügigen Verursacher.

Zusätzlich zeigt die Sitzungsanalyse eine erhöhte Nutzung der Komprimierung im Laufe der Zeit, was mit Leistungseinbrüchen korreliert. Evaluierungen quantifizieren dies: Die Genauigkeit nimmt mit wiederholten Komprimierungen ab.

Darüber hinaus zeigen die Integration der Websuche (--search) und Prompt-Änderungen über zwei Monate hinweg keine negativen Auswirkungen. Dennoch verursachen Ineffizienzen im Authentifizierungs-Cache eine zusätzliche Latenz von 50 ms pro Anfrage, was die Benutzerwahrnehmung verstärkt.

Des Weiteren entwickelt sich die Nutzung weiter; mehr Entwickler setzen MCP-Tools ein, was die Komplexität der Einrichtung erhöht. OpenAI empfiehlt minimalistische Konfigurationen für optimale Ergebnisse.

Folglich deuten die Beweise darauf hin, dass Wahrnehmungen aus der Verwendung von CodeX für schwierigere Aufgaben stammen, anstatt einer inhärenten Verdummung. Wie ein X-Benutzer zusammenfasste: "CodeX ist so gut, dass die Leute immer wieder versuchten, es für schwierigere Aufgaben zu verwenden, und es diese nicht so gut erledigte, und dann nahmen die Leute einfach an, dass das Modell schlechter wurde."

Diese Analyse bereitet den Boden für OpenAIs investigative Antwort, die diese Punkte direkt anspricht.

OpenAIs Antwort: Die transparente Untersuchung der CodeX-Leistung

OpenAI verpflichtet sich zur Transparenz und verspricht, Berichte über Leistungsabfälle ernsthaft zu untersuchen. Tibo, ein Mitglied des Codex-Teams, kündigte die Untersuchung auf X an und skizzierte einen Plan zur Verbesserung der Feedback-Mechanismen, zur Standardisierung der internen Nutzung und zur Durchführung zusätzlicher Evaluierungen.

Ingenieure handelten schnell und veröffentlichten CLI 0.50 mit verbessertem /feedback, das Probleme mit Clustern und Hardware verknüpfte. Sie entfernten über 60 Feature-Flags, wodurch der Stack vereinfacht wurde.

Darüber hinaus stellte ein engagiertes Team täglich Hypothesen auf und testete Probleme. Dieser Ansatz deckte Lösungen auf, von der Ausmusterung älterer Hardware bis zur Verfeinerung der Komprimierung.

Zusätzlich veröffentlichte OpenAI einen umfassenden Bericht mit dem Titel "Ghosts in the Codex Machine", der Ergebnisse ohne größere Regressionen detailliert darlegte, aber kombinierte Faktoren anerkannte.

Ferner setzten sie Ratenbegrenzungen zurück und erstatteten Guthaben aufgrund eines Abrechnungsfehlers, was benutzerzentrierte Maßnahmen demonstriert.

Im Übergang zu den Details beleuchten die wichtigsten Erkenntnisse des Berichts die technischen Nuancen hinter den Benutzerbedenken.

Wichtige Erkenntnisse aus OpenAIs CodeX-Degradationsbericht

Der Bericht kommt zu dem Schluss, dass es kein einzelnes großes Problem gibt; stattdessen häufen sich Verhaltensänderungen und kleinere Probleme an. Bei der Hardware wurden durch Evaluierungen und Modelle ältere Einheiten identifiziert, was zu deren Entfernung und Optimierungen des Lastausgleichs führte.

Bezüglich der Komprimierung verschlechtert eine höhere Frequenz im Laufe der Zeit die Sitzungen. OpenAI verbesserte die Implementierungen, um rekursive Zusammenfassungen zu vermeiden, und fügte Benutzerhinweise hinzu.

Bei apply_patch führen seltene Fehler zu riskanten Löschungen; Abhilfemaßnahmen begrenzen solche Sequenzen, wobei Modellverbesserungen geplant sind.

Timeouts zeigen keine breiten Regressionen – die Latenz verbessert sich –, aber ineffiziente Wiederholungsversuche bleiben bestehen. Investitionen zielen auf eine bessere Handhabung langer Prozesse ab.

Ein Fehler bei der eingeschränkten Stichprobenentnahme verursacht Out-of-Distribution-Tokens, der in Kürze behoben wird.

Audits der Responses API zeigen geringfügige Kodierungsänderungen ohne Leistungsauswirkungen.

Andere Untersuchungen, wie Evaluierungen von CLI-Versionen und Prompts, bestätigen die Stabilität.

Darüber hinaus empfehlen sich bei sich entwickelnden Setups mit mehr Tools Einfachheit.

Diese Ergebnisse bestätigen die Benutzererfahrungen, während sie keine allgemeine Verdummung belegen.

Implementierte Verbesserungen und zukünftige Richtungen für CodeX

OpenAI handelt auf der Grundlage der Ergebnisse und führt Korrekturen wie Komprimierungswarnungen und Stichprobenkorrekturen ein. Hardwarebereinigungen und Latenzreduzierungen erhöhen die Zuverlässigkeit.

Darüber hinaus bilden sie ein permanentes Team zur Überwachung der realen Leistung und rekrutieren Talente für laufende Optimierungen.

Zusätzlich wird die Sozialisierung von Feedback verstärkt, um kontinuierlichen Input zu gewährleisten.

Zukünftige Arbeiten umfassen Verbesserungen der Modellpersistenz und der Tool-Anpassungsfähigkeit.

Folglich entwickelt sich CodeX weiter und begegnet Wahrnehmungen durch datengesteuerte Verbesserungen.

Während sie jedoch auf diese warten, suchen Entwickler nach Ergänzungen wie Apidog.

Ergänzende Tools: Wie Apidog CodeX-Workflows verbessert

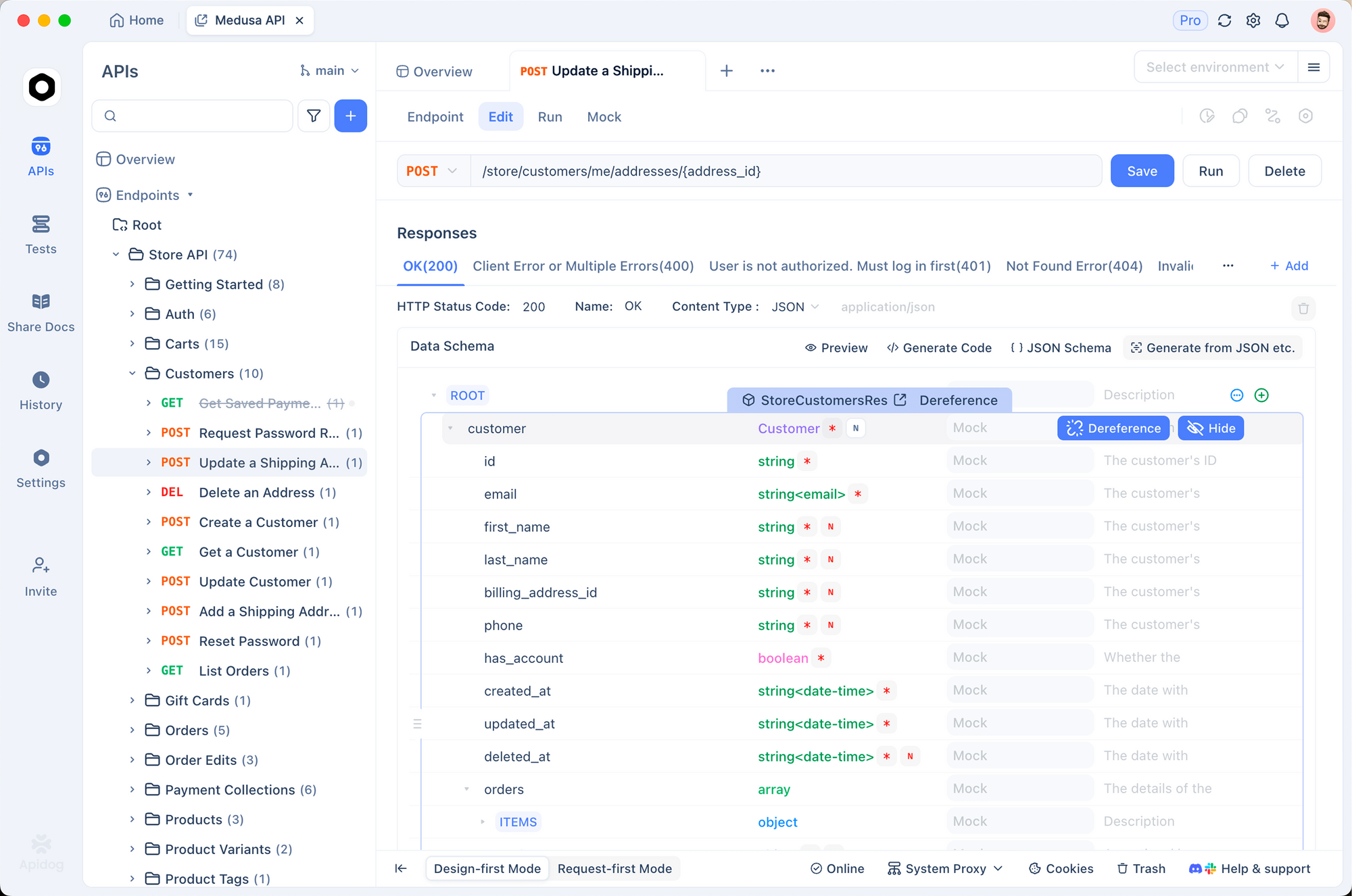

Wenn CodeX API-Aufgaben bearbeitet, treten Inkonsistenzen auf, insbesondere bei Integrationen. Apidog, eine robuste API-Plattform, schließt diese Lücke.

Entwickler nutzen Apidog, um APIs zu entwerfen, zu testen und zu dokumentieren, wodurch die korrekte Funktion des von CodeX generierten Codes sichergestellt wird.

Simulieren Sie beispielsweise Endpunkte in Apidog vor der CodeX-Implementierung, um Fehler zu reduzieren.

Darüber hinaus bietet der kostenlose Download von Apidog Kollaborationsfunktionen, Versionsverwaltung und Automatisierung – ideal für Teams, die mit CodeX-Einschränkungen konfrontiert sind.

Apidog lässt sich nahtlos in Entwicklungsumgebungen integrieren und validiert KI-Ausgaben.

Somit optimiert die Kombination von CodeX mit Apidog die Entwicklung und mindert wahrgenommene Verschlechterungen.

Fallstudien: Beispiele aus der Praxis aus X-Diskussionen

X-Threads liefern anschauliche Beispiele. Ein Benutzer hob hervor, dass der Erfolg von CodeX zu übermäßigem Ehrgeiz führte, was die Nutzungsentwicklung des Berichts widerspiegelt.

Ein anderer diskutierte die CLI-Geschwindigkeit und wechselte für schnelle Aufgaben zu Alternativen, was die Bedenken hinsichtlich der Latenz unterstreicht.

Darüber hinaus wurden durch die Rücksetzung der Abrechnung überhöhte Gebühren behoben, was das Vertrauen wiederherstellte.

Diese Anekdoten, kombiniert mit Berichtsdaten, illustrieren vielschichtige Probleme.

Best Practices zur Maximierung der CodeX-Leistung

Um Wahrnehmungen entgegenzuwirken, sollten Sie Praktiken anwenden: Halten Sie Sitzungen kurz, minimieren Sie Tools, verwenden Sie /feedback.

Überwachen Sie außerdem Updates; CLI-Verbesserungen wirken sich direkt auf die Ergebnisse aus.

Experimentieren Sie zusätzlich mit Prompts für Präzision.

Folglich verbessern diese Schritte die Erfahrungen.

Fazit: Veränderungen in CodeX und darüber hinaus annehmen

Benutzer empfinden CodeX aufgrund komplexer Aufgaben und kleinerer Probleme als dümmer, aber die Beweise zeigen Evolution, nicht Rückgang. OpenAIs Untersuchung und Korrekturen bestätigen das Engagement.

Darüber hinaus gewährleistet die Integration von Apidog widerstandsfähige Workflows.

Letztendlich passen Sie Strategien an, nutzen Sie Tools und geben Sie Feedback – kleine Anpassungen führen zu erheblichen Produktivitätssteigerungen.