Da KI zunehmend in die API-Entwicklung und -Tests integriert wird, sinkt die Einstiegshürde für automatisierte Tests stetig. Aufgaben, die einst wiederholte manuelle Operationen und Datenvorbereitung erforderten, können nun von KI übernommen werden. Apidog spiegelt diese Veränderung auch im API-Test wider.

In Apidog dreht sich das automatisierte Testen hauptsächlich um zwei Ansätze: Endpoint-Tests und Testszenarien.

Wenn Sie das Modul Endpoint-Test nicht sehen, bedeutet dies, dass Ihre Apidog-Version veraltet ist. Aktualisieren Sie einfach auf die neueste Version.

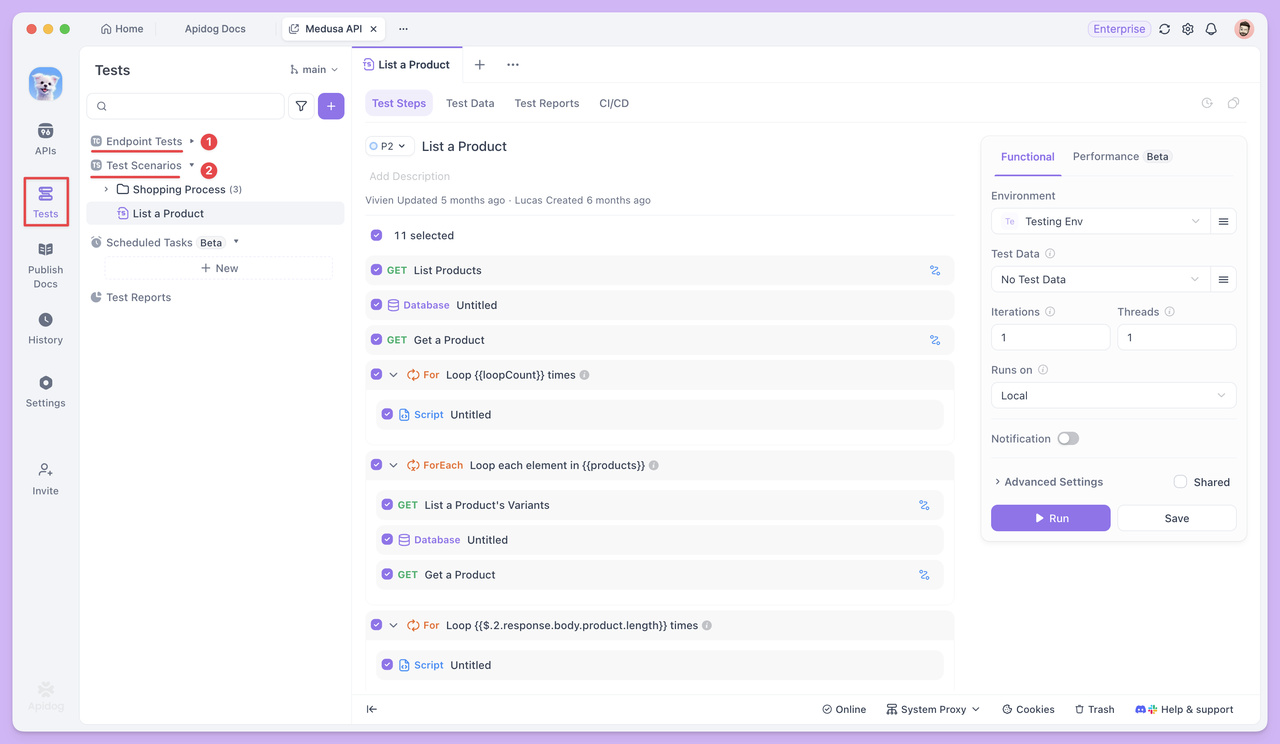

Das Modul Endpoint-Tests zeigt alle HTTP-Endpunkte Ihrer APIs an, wodurch QA-Entwickler fokussierter arbeiten können. Es enthält nur Testfälle, Testberichte und Dokumentation – ohne die Bearbeitung von Endpunkten zu ermöglichen. Dieses Design stellt sicher, dass Tester sich auf das effiziente Erstellen und Ausführen von Testfällen konzentrieren können.

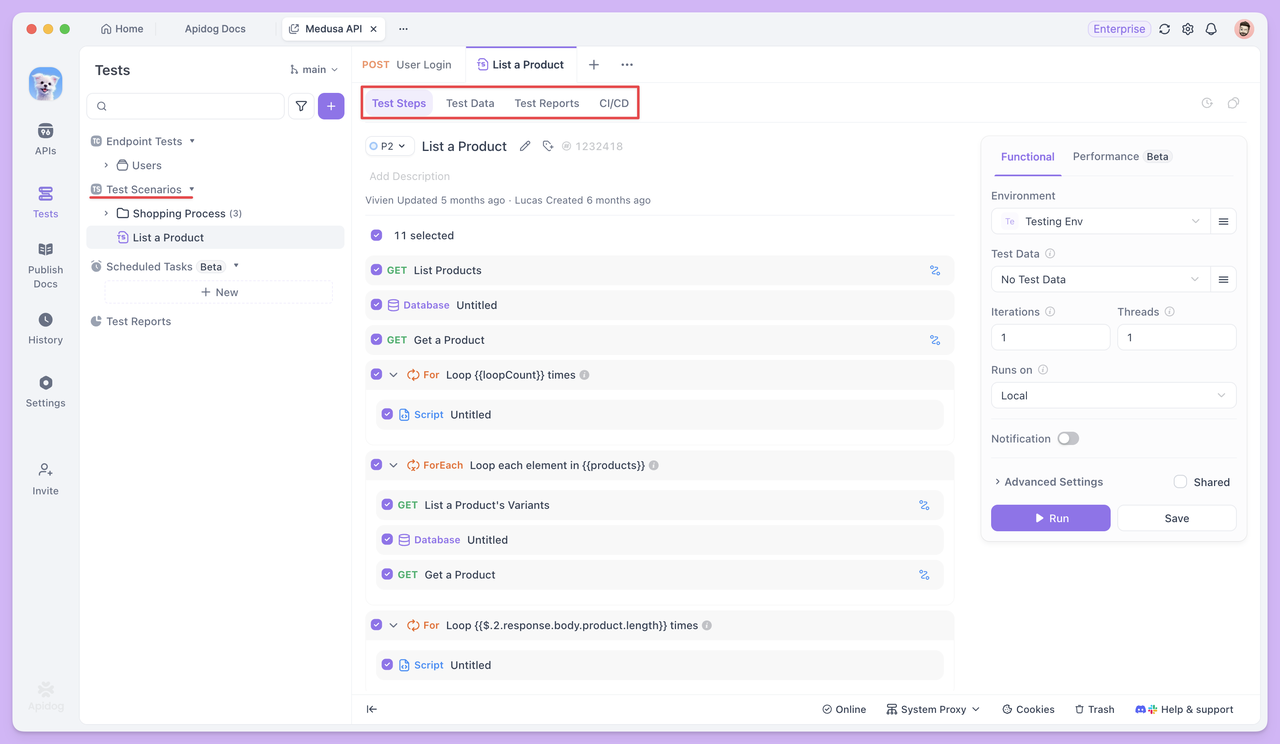

Testszenarien hingegen verknüpfen mehrere Endpunkte oder Testfälle miteinander. Sie ermöglichen es Ihnen, die Ausführungsreihenfolge und Datenübergabebeziehungen zwischen Endpunkten zu definieren und so einen vollständigen Geschäftsprozess effektiv zu simulieren.

Mit KI, die sowohl in Endpoint-Tests als auch in Testszenarien integriert ist, können API-Tests schrittweise zu einer automatisierteren, wiederverwendbaren und effizienteren Ausführung übergehen. Als Nächstes werden wir untersuchen, wie diese beiden Testmethoden bei der Lösung realer Herausforderungen helfen.

Endpoint-Tests mit Automatisierung

Der Endpoint-Test konzentriert sich darauf, ob der Endpunkt selbst stabil ist und ob die Eingabe/Ausgabe den Erwartungen entspricht. Jeder Testfall wird unabhängig ausgeführt, wobei der Schwerpunkt auf der gründlichen Überprüfung eines einzelnen Endpunkts mit unterschiedlichen Daten liegt.

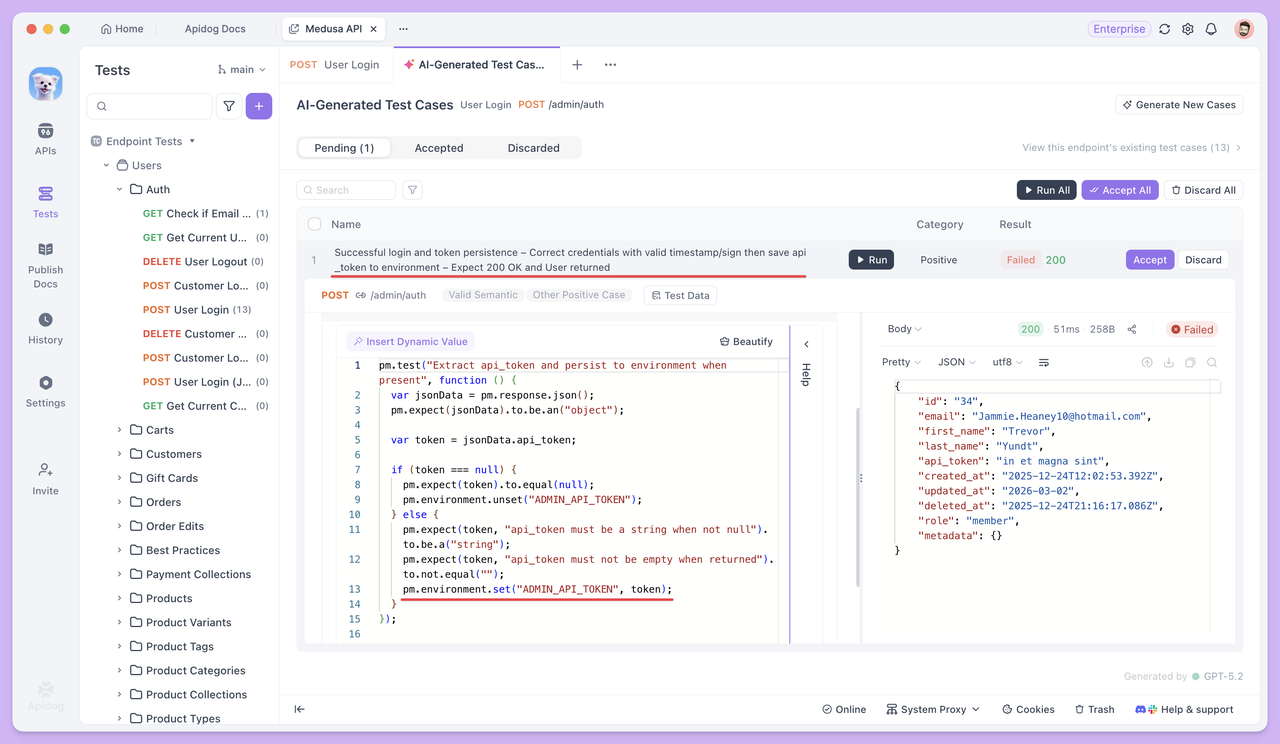

KI-generierte Testfälle

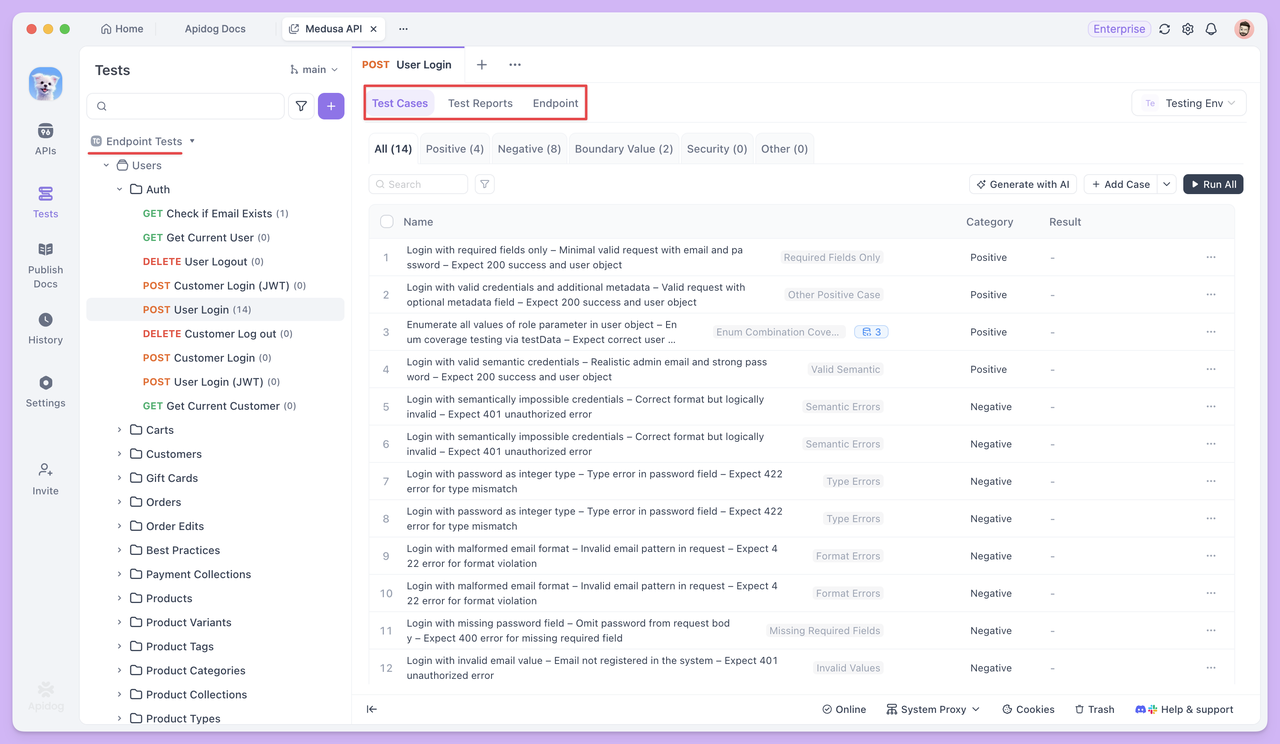

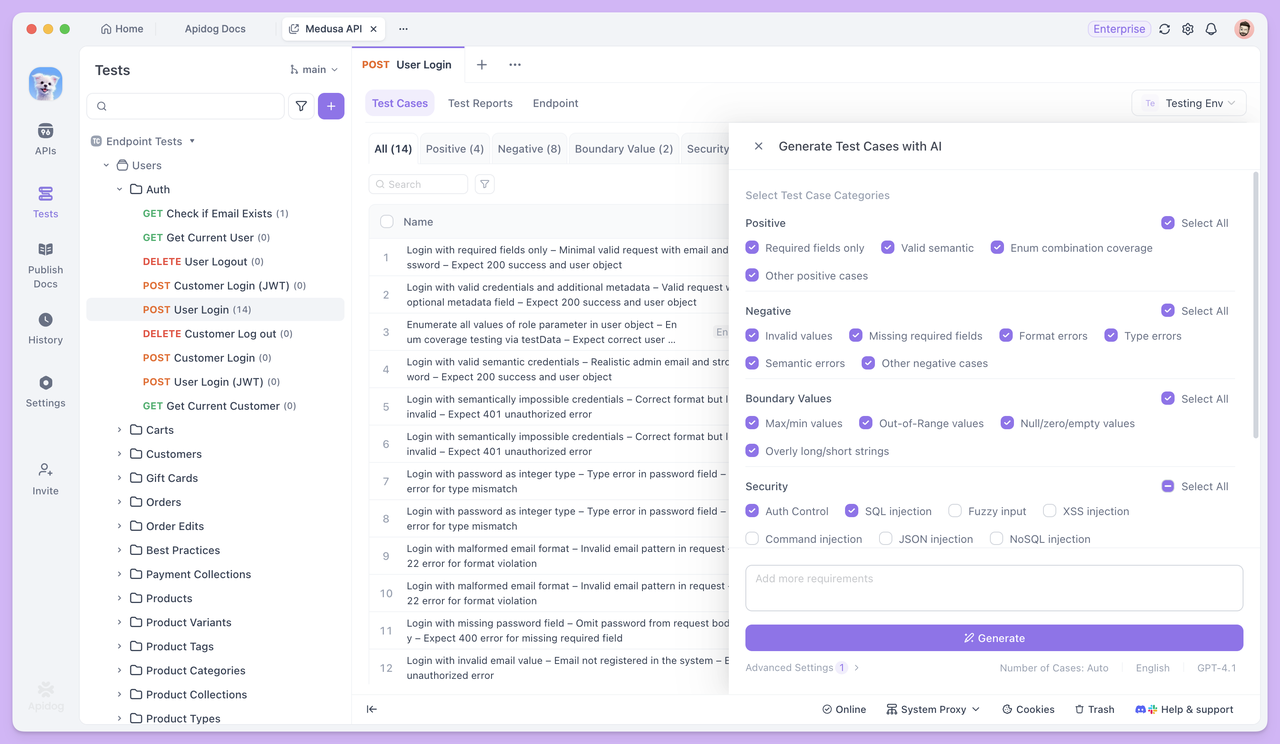

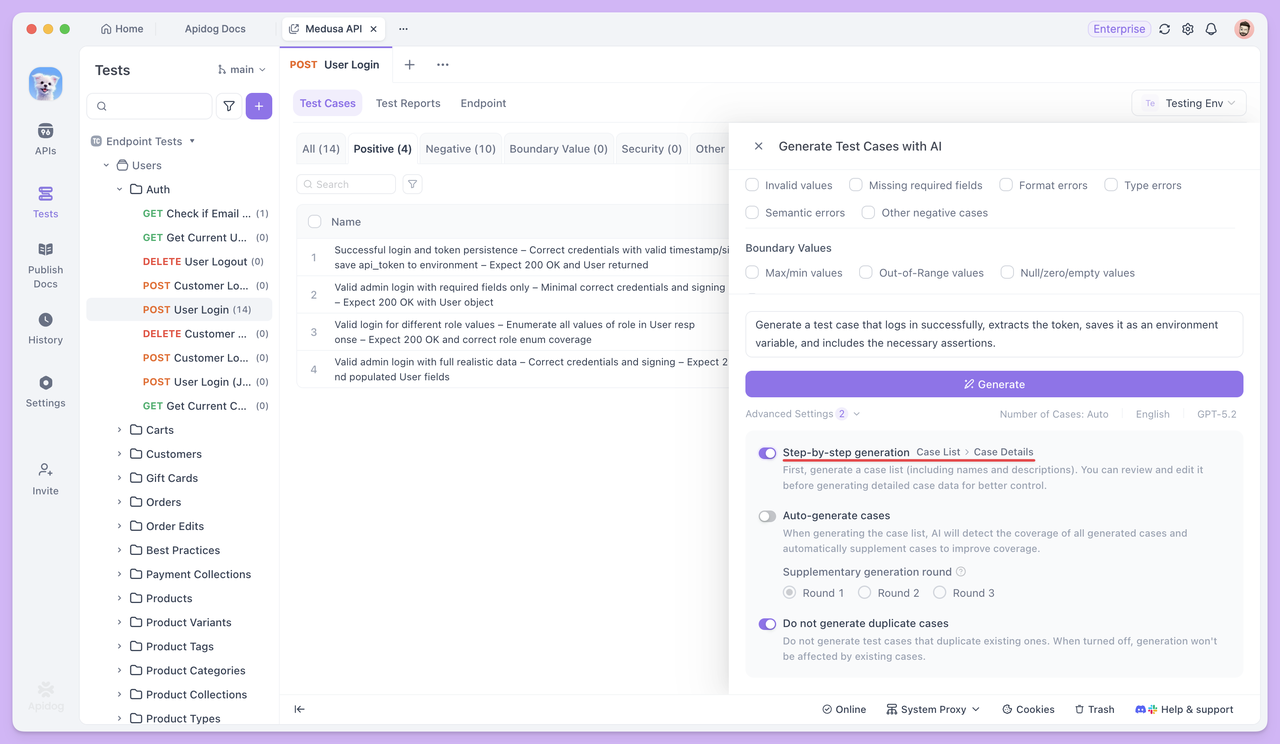

Öffnen Sie einen beliebigen Endpunkt im Modul Endpoint-Test und klicken Sie auf Mit KI generieren. Die KI generiert automatisch eine Reihe von Testfällen basierend auf den Endpunktparametern und der Antwortstruktur.

Wenn Sie nur spezifische Testfälle benötigen, müssen Sie nicht die Standardtypen auswählen. Beschreiben Sie Ihre Anforderungen einfach direkt der KI, und sie generiert den entsprechenden Testfall. Zum Beispiel können Sie die KI bitten,:

- Einen Testfall für „erfolgreich anmelden und den Token extrahieren“ zu generieren.

- Einen Testfall zu generieren, um das Signaturfeld

signbasierend auf bestehenden Parametern zu erstellen und zu senden.

Für präzisere Ergebnisse können Sie detaillierte Bedingungen und Regeln angeben, wie zum Beispiel:

Generate a positive test case for this endpoint.

The endpoint requires a signature parameter sign, with the following signing rules:

1. Collect all non-empty request parameters (excluding sign), sort them by parameter name in ASCII order, concatenate them in the format key=value joined by &, and append the secret key SECRET_KEY at the end.

2. Apply MD5 hashing to the resulting string and convert the hash to uppercase. The final result is used as the value of sign.

Test case requirements:

1. Before sending the request, use a pre-request script to generate the sign, with clear comments included.

2. Add the generated sign to the request parameters and send the request.Auf diese Weise generiert die KI Fälle strikt nach Ihren Regeln, ohne Auslassungen oder Missverständnisse.

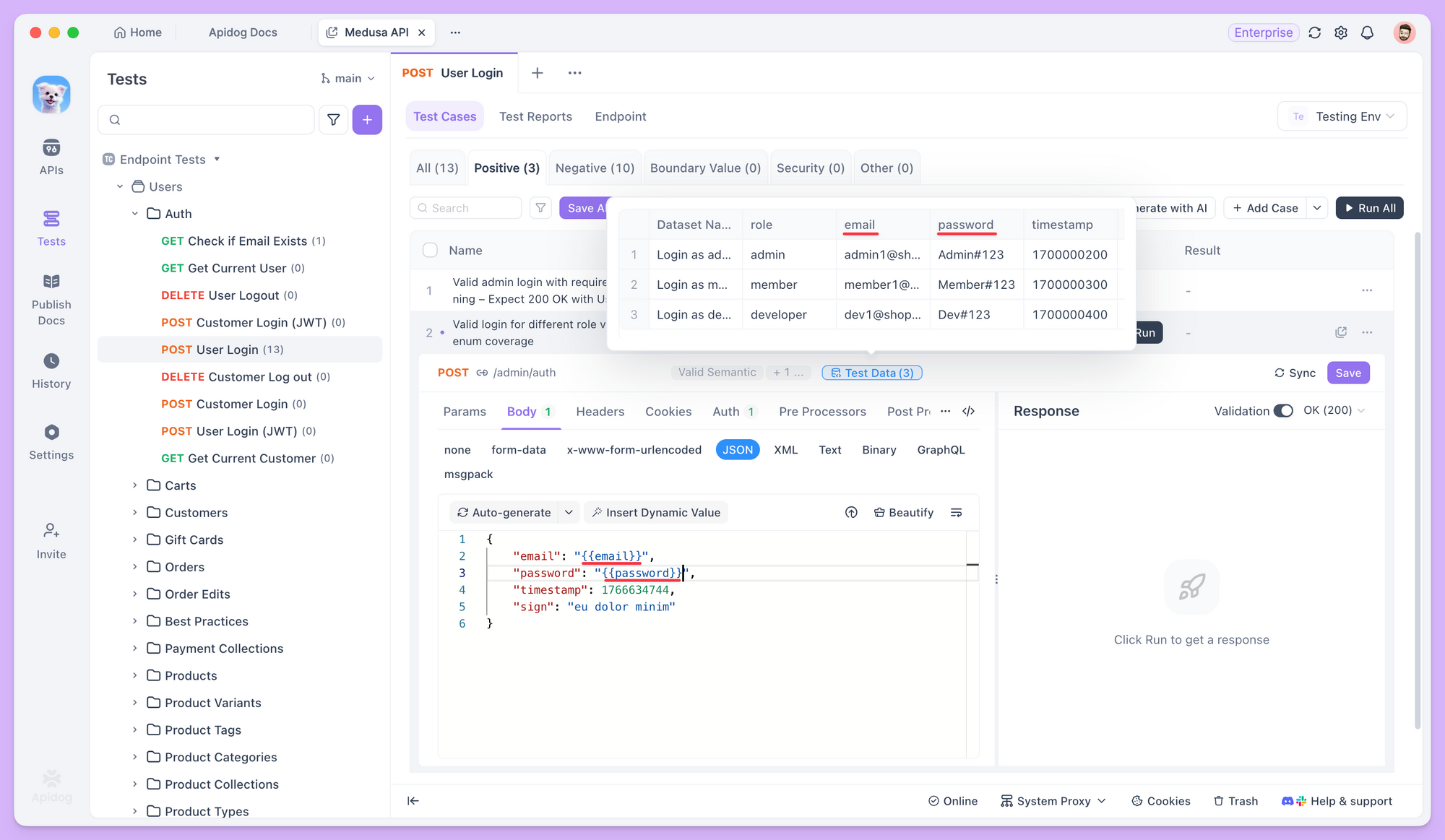

Testdatengenerierung

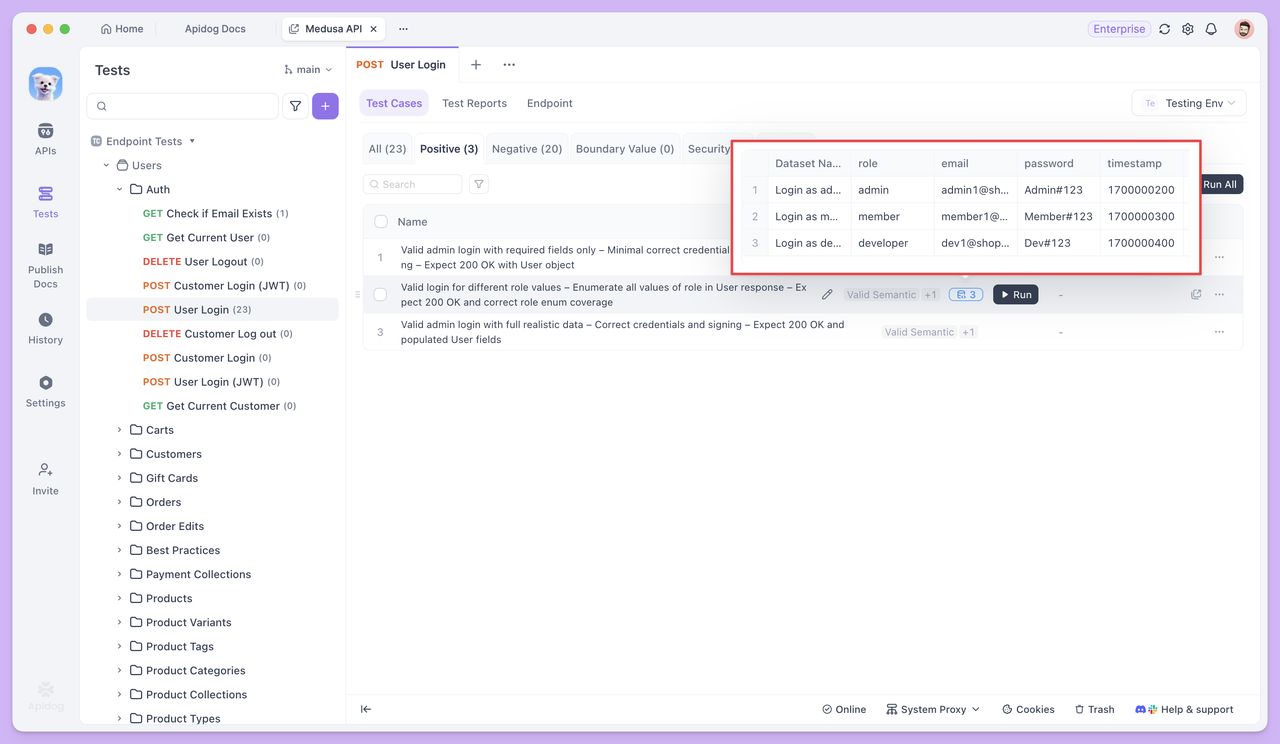

Beim Generieren von Testfällen bereitet die KI auch entsprechende Testdatensätze für verschiedene Arten von Fällen vor, um eine Vielzahl realer Eingabesituationen abzudecken.

In Standard-Geschäftsszenarien bestehen Testdaten in der Regel aus mehreren Sätzen semantisch gültiger Parameterwerte. Zum Beispiel enthält der Datensatz bei einem Login-Endpunkt-Test, obwohl alle E-Mails und Passwörter gültig sind, verschiedene gängige E-Mail-Formate – wie solche mit Punkten, Pluszeichen, numerische E-Mails oder Unternehmens-E-Mails – um die Kompatibilität und Stabilität des Endpunkts unter normalen Nutzungsszenarien zu überprüfen.

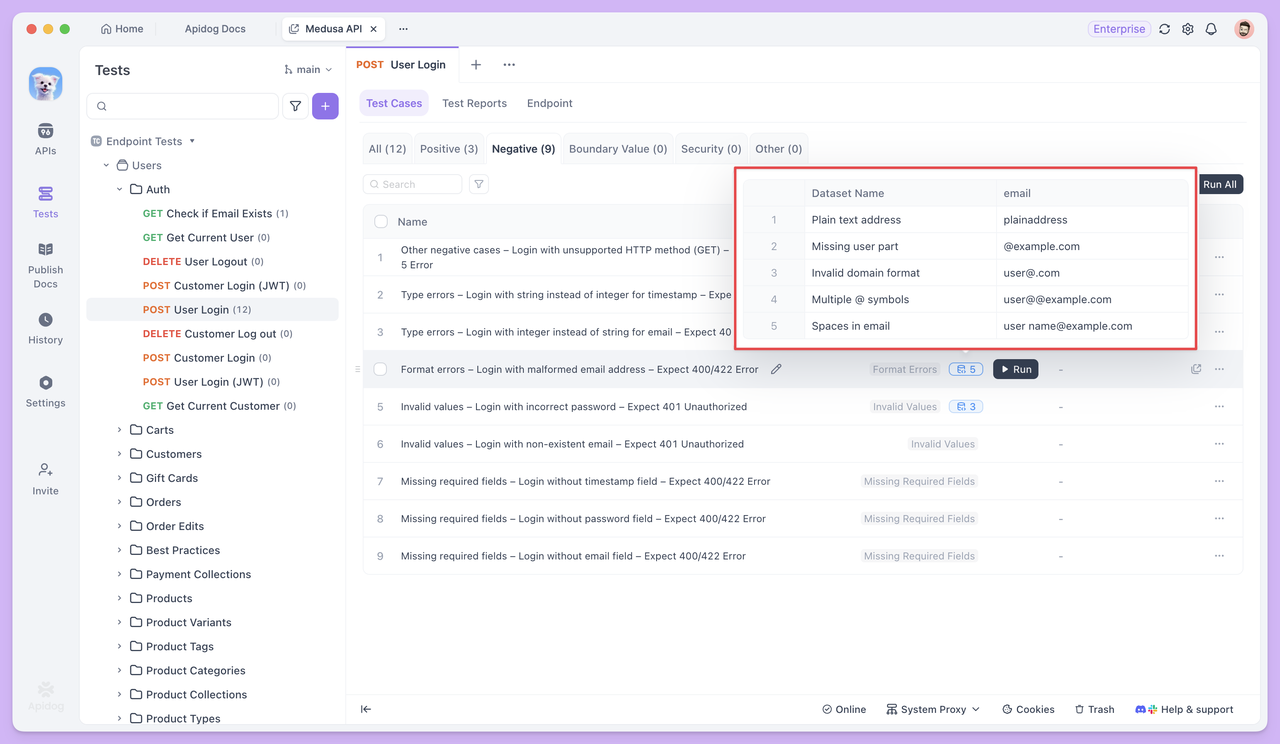

In abnormalen oder Grenzfall-Testfällen sind die Testdaten bewusst so konzipiert, dass sie Eingaben enthalten, die Validierungsregeln verletzen.

Zum Beispiel würde in einem Testfall wie „Anmeldung mit ungültigem E-Mail-Format und Erwartung eines 400-Fehlers“ der Datensatz verschiedene Arten ungültiger E-Mail-Adressen enthalten – wie E-Mails ohne das @-Symbol, ohne Domänennamen oder mit Leerzeichen. Ziel ist es zu überprüfen, ob der API-Endpunkt diese ungültigen Eingaben korrekt erkennen und die Anforderung ordnungsgemäß ablehnen kann.

Referenzierung von Testdaten

In Testfällen können Sie die Syntax {{variable_name}} verwenden, um Testdaten zu referenzieren und Variablen in Anforderungsparameter, Anforderungs-Bodies und andere Felder einzufügen.

Wenn der Test läuft, zieht Apidog automatisch nacheinander Werte aus dem Datensatz und sendet Anfragen mit jedem Wert. So können Sie denselben Endpunkt mehrmals mit unterschiedlichen Daten testen, ohne den Testfall neu schreiben zu müssen.

Stapelverarbeitung und Testberichte

Sobald die Testfälle und die entsprechenden Daten bereit sind, können Sie mehrere Testfälle auswählen und gemeinsam ausführen. Jeder Testfall wird unabhängig basierend auf seiner eigenen Konfiguration ausgeführt, und alle Ergebnisse werden in einem einzigen Testbericht zur einfachen Überprüfung gesammelt.

In realen Anwendungen funktionieren Endpunkte selten isoliert. Wenn die Antwort einer Anfrage als Eingabe für die nächste verwendet wird, geht es beim Testen nicht mehr um einen einzelnen Endpunkt, sondern um die gesamte Aufrufkette.

Hier kommen Testszenarien ins Spiel.

Testszenarien

Ein einzelner Endpunkt reicht in der Regel nicht aus, um eine Geschäftsaufgabe zu erfüllen. Zum Beispiel muss sich ein Benutzer anmelden, bevor er eine Bestellung aufgibt, und erst nachdem die Bestellung erfolgreich erstellt wurde, können die Bestelldetails abgefragt werden. Die Antwort eines Endpunkts wird oft zur Eingabe für den nächsten.

Diese Abhängigkeiten sind mit einem einzelnen Endpoint-Test schwer vollständig zu validieren.

Testszenarien verlagern den Fokus von der Überprüfung, ob ein Endpunkt korrekt funktioniert, auf die Überprüfung, ob eine gesamte Aufrufkette reibungslos und wie erwartet abläuft.

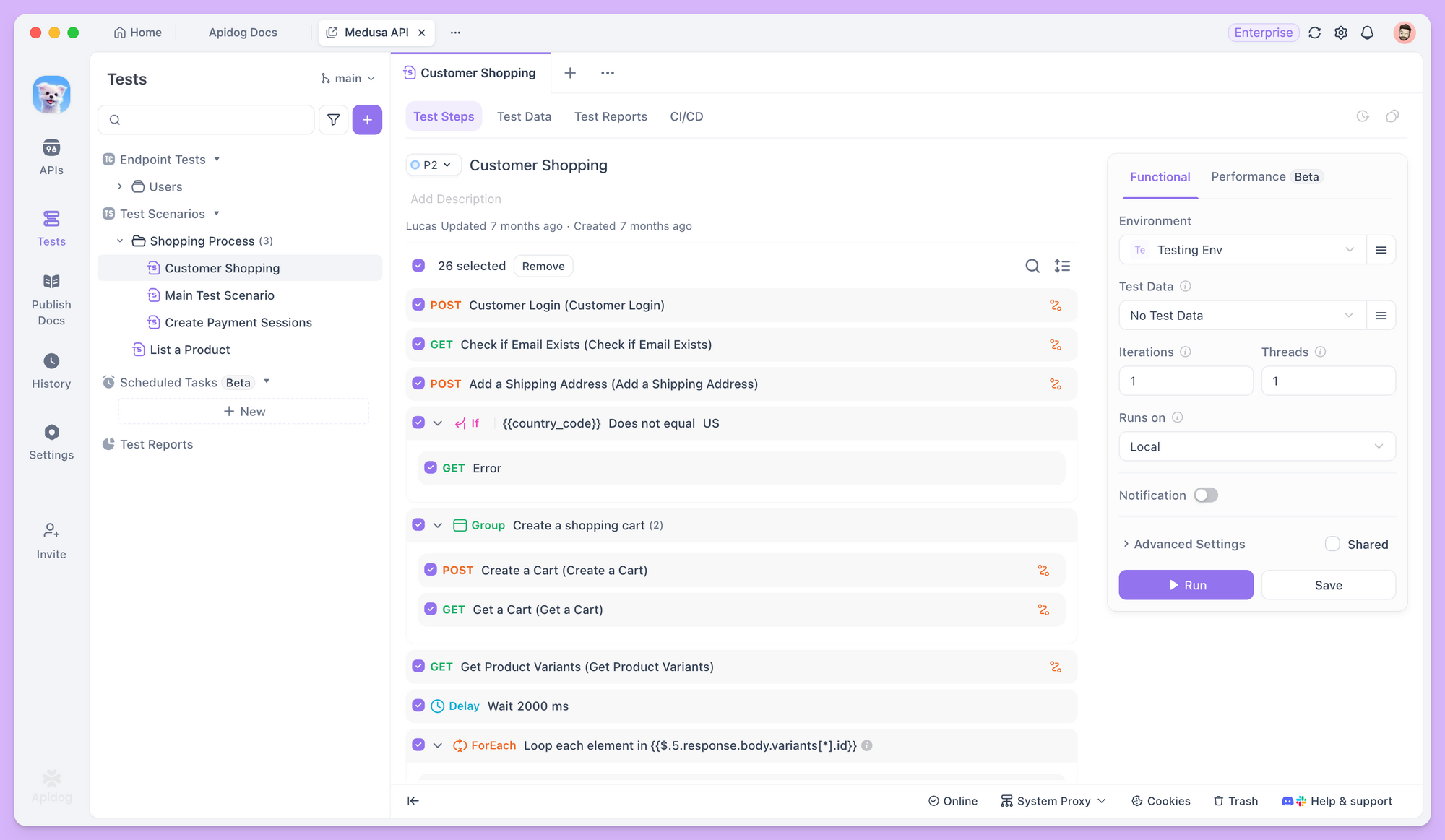

Endpunkte in einen Workflow orchestrieren

In Apidog können Sie nach dem Erstellen eines neuen Testszenarios mehrere Endpunkte oder bestehende Testfälle in einer bestimmten Reihenfolge hinzufügen, wodurch die Ausführungssequenz für jeden Schritt klar definiert wird.

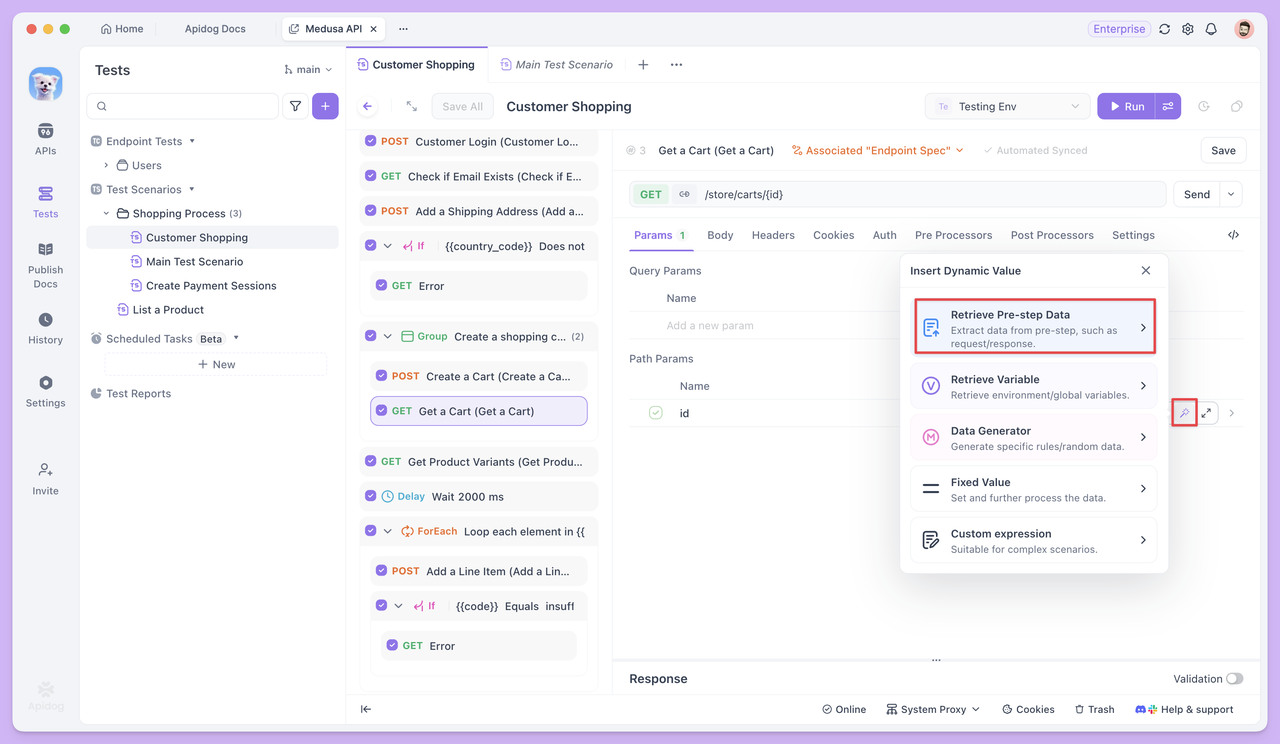

Datenübergabe zwischen den Testschritten

Wenn Endpunkte voneinander abhängen, ermöglichen Ihnen Testszenarien, Daten als Variablen von einem Schritt zum nächsten zu übergeben. Zum Beispiel kann die vom Endpunkt Bestellung erstellen zurückgegebene id direkt in späteren Schritten wiederverwendet werden, wie beim Abfragen oder Aktualisieren der Bestellung.

Diese Datenübergabe erfordert keinen zusätzlichen Code. Stattdessen basiert sie auf der Variablenreferenzierung, um die Upstream- und Downstream-Beziehungen zwischen Endpunkten klar zu definieren.

Was, wenn Testfälle fehlen?

Bei der Orchestrierung von Testszenarien besteht das erste Ziel oft darin, sicherzustellen, dass der Hauptworkflow reibungslos abläuft – zum Beispiel Anmelden → Bestellung erstellen → Bestellung abfragen, wobei jeder Schritt einem bestehenden Testfall entspricht.

In der Praxis kann jedoch eine häufige Herausforderung auftreten: einige Schritte im Workflow verfügen möglicherweise nicht über vorgefertigte Testfälle, oder bestehende Fälle erfüllen die Workflow-Anforderungen nicht vollständig.

Im Anmeldeschritt müssten Sie beispielsweise nicht nur eine erfolgreiche Anmeldung überprüfen, sondern auch den zurückgegebenen Token als Umgebungsvariable für nachfolgende Anfragen extrahieren. Ein bestehender Einzelendpunkt-Testfall würde möglicherweise nur eine grundlegende Anmeldevalidierung durchführen, ohne die Token-Extraktion zu handhaben.

Wenn Sie unsicher sind, wie Sie zurückgegebene Felder als Variablen extrahieren oder mit Skripting nicht vertraut sind, können Sie die Szenario-Orchestrierung pausieren. Gehen Sie dann zur Seite Endpoint-Test für diesen Endpunkt und nutzen Sie KI, um die Anforderung zu bearbeiten. Zum Beispiel könnten Sie angeben:

Einen Testfall generieren, der nach erfolgreicher Anmeldung den Token extrahiert und als Umgebungsvariable speichert, inklusive notwendiger Assertions.

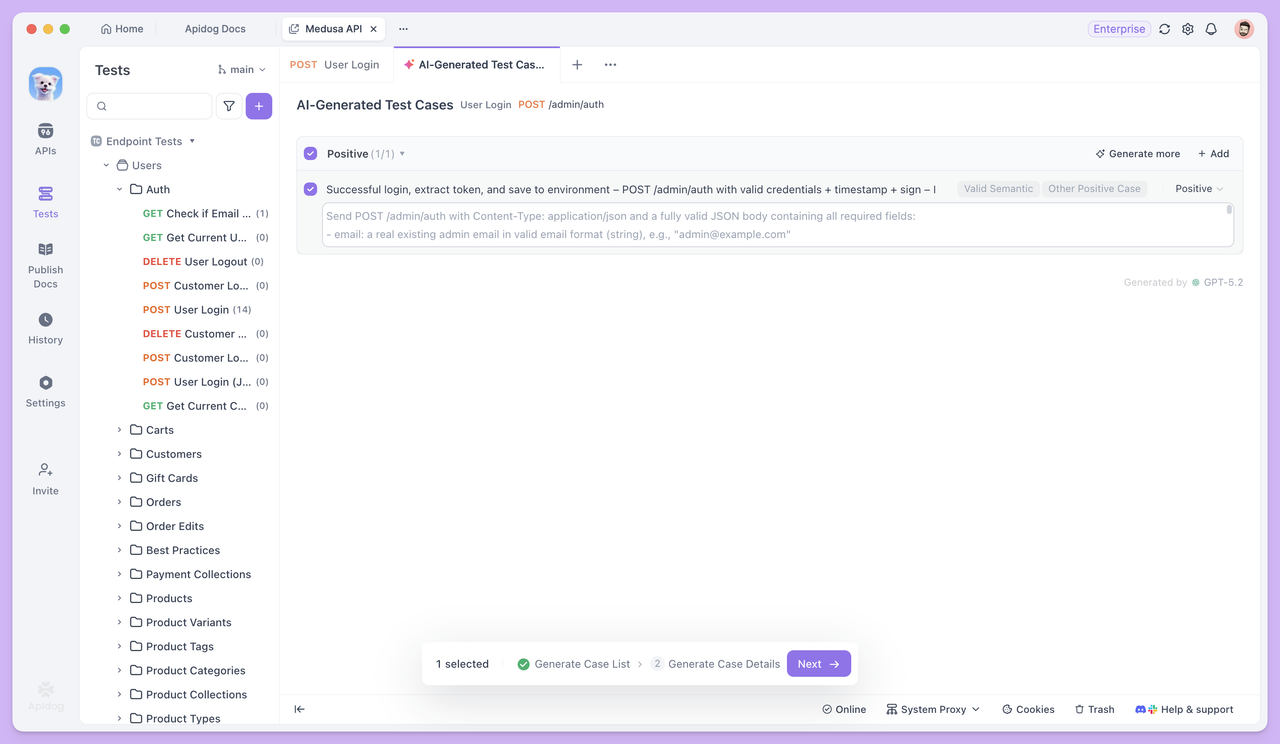

Wenn Sie eine präzisere Kontrolle über Ihre Testfälle wünschen, können Sie die Schritt-für-Schritt-Generierung in den Erweiterten Einstellungen aktivieren.

Nach der Aktivierung generiert Apidog zunächst eine Liste von Testfällen, einschließlich deren Namen und Beschreibungen. Sie können diese dann manuell überprüfen, ändern und bestätigen, bevor die vollständigen detaillierten Testfalldaten generiert werden.

Nachdem der Testfall generiert wurde, kehren Sie zum Testszenario zurück. Sie können diesen Fall direkt als Anmeldeschritt verwenden, und nachfolgende Endpunkte können den Token über Dynamische Werte referenzieren, wodurch der Workflow nahtlos fortgesetzt werden kann.

Wenn Sie Testdaten in Ihren Testszenarien benötigen, können Sie zuerst die KI Fälle mit Testdaten im Endpoint-Test generieren lassen. Kopieren Sie dann den CSV-formatierten Datensatz mit der Funktion Massenbearbeitung in das Testszenario, was die Dateneinrichtung wesentlich schneller und bequemer macht.

Dieser Ansatz stellt sicher, dass das Testszenario immer auf den Hauptworkflow ausgerichtet ist, während KI als „Füll-nach-Bedarf“-Assistent fungiert. Wann immer ein Schritt fehlt, verwenden Sie einfach KI, um den entsprechenden Testfall für diesen Endpunkt zu generieren und ihn dann sofort wieder in den Workflow zu integrieren.

Zusammenfassung

KI hat nicht verändert, was API-Tests überprüfen müssen, aber sie hat den erforderlichen Aufwand, um Tests zu starten und abzuschließen, erheblich gesenkt.

Bei Endpoint-Tests begegnet KI hauptsächlich der langsamen Testfallerstellung und unvollständigen Abdeckung. Dies ermöglicht es, Tests schneller in die Validierungsphase zu bringen, anstatt bei der manuellen Datenvorbereitung und Fallerstellung stecken zu bleiben.

Wenn die Tests zu Testszenarien übergehen, verlagert sich der Fokus von der Überprüfung eines einzelnen Endpunkts auf die Sicherstellung, dass Endpunkte innerhalb realer Aufrufsequenzen korrekt zusammenarbeiten können.

In diesem Workflow müssen Sie nicht alle Testfälle im Voraus vorbereiten. Während das Szenario schrittweise aufgebaut wird, können Sie jederzeit zum Einzel-Endpunkt-Test zurückkehren, um von der KI die spezifischen Fälle generieren zu lassen, die für den aktuellen Workflow benötigt werden, und dann die Schritte weiter orchestrieren. Dies reduziert unnötigen Vorabaufwand und spart Kreditverbrauch.

Insgesamt integriert Apidog Endpoint-Test, Testszenarien und KI-Funktionen in einem einzigen Workflow und verwandelt die üblichen Engpässe von API-Tests – das Schreiben von Fällen, das Vorbereiten von Daten und das Verketten von Prozessen – in beherrschbare Aufgaben.

Wenn Sie immer noch denken, dass automatisiertes Testen „komplexe Konfiguration und eine steile Lernkurve“ bedeutet, fangen Sie klein an: Wählen Sie einen einzelnen Endpunkt in Apidog, generieren Sie einige Fälle und führen Sie ein Testszenario aus. Sie werden schnell erleben, wie viel reibungsloser und schneller der Prozess in der Praxis sein kann.