تخيل أن لديك حاسوبًا فائقًا في جيبك، قادرًا على فهم وتوليد نصوص شبيهة بالإنسان حول أي موضوع. يبدو كأنه خيال علمي، أليس كذلك؟ حسنًا، بفضل الابتكارات الأخيرة في الذكاء الاصطناعي، أصبح هذا الحلم واقعًا - ويطلق عليه اسم Ollama.

Ollama يشبه سكين الجيش السويسري للـ LLMs المحلية. إنه أداة مفتوحة المصدر تتيح لك تشغيل نماذج لغوية قوية على جهاز الكمبيوتر الخاص بك. لا حاجة لخدمات سحابية فاخرة أو درجة في علوم الكمبيوتر. لكن هنا يصبح الأمر مثيرًا حقًا: لدى Ollama قوة خفية تسمى API. تخيلها كلغة سرية تتيح لبرامجك التحدث مباشرةً إلى هذه العقول الذكية.

الآن، أعلم ما تفكر فيه. "API؟ يبدو أن الأمر معقد!"

لا تقلق - هذا هو المكان الذي تتدخل فيه Apidog. إنها مثل مترجم ودود يساعدك على التواصل مع API الخاص بـ Ollama دون أن تتعب. في هذه المقالة، سنشرع في رحلة معًا. سأكون مرشدك بينما نستكشف كيفية إطلاق العنان للإمكانات الكاملة لـ Ollama باستخدام Apidog. بحلول النهاية، ستتمكن من صنع تطبيقات مدعومة بالذكاء الاصطناعي مثل المحترفين، وكل ذلك من راحة جهازك الخاص. لذا، استعد - حان الوقت للغوص في عالم الذكاء الاصطناعي المحلي واكتشاف مدى سهولة الأمر!

ما هو Ollama وكيفية استخدام Ollama لتشغيل LLMs محليًا؟

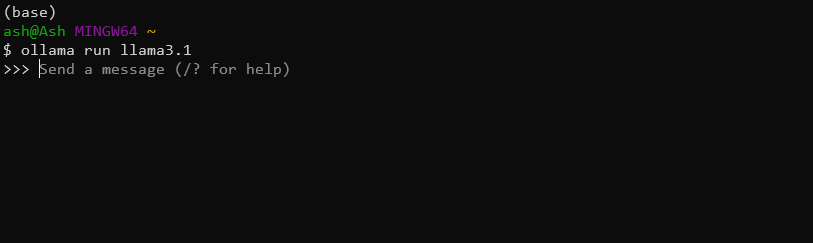

Ollama هي أداة مريحة تتيح للمستخدمين تشغيل نماذج لغوية كبيرة على أجهزتهم المحلية. إنها تبسط عملية تحميل وتشغيل وضبط نماذج LLM المختلفة، مما يجعل القدرات المتقدمة للذكاء الاصطناعي متاحة لجمهور أوسع. على سبيل المثال، يمكنك ببساطة تحميل وتثبيت النموذج الأحدث Llama 3.1 8B باستخدام هذا الأمر وحده:

ollama run llama3.1

هل لدى Ollama API؟

نعم، يمكنك استخدام API الخاص بـ Ollama لدمج هذه LLMs المحلية القوية في تطبيقاتك بسلاسة.

تشمل الميزات الرئيسية لـ API الخاص بـ Ollama:

- إدارة النماذج (سحب، تصنيف، وحذف النماذج)

- توليد النص (الإكمالات وتفاعلات الدردشة)

- توليد التضمينات

- إمكانيات الضبط الدقيق

باستخدام API الخاص بـ Ollama، يمكنك بسهولة استغلال قوة LLMs في تطبيقاتك دون الحاجة إلى بنية تحتية معقدة أو الاعتماد على السحابة.

استخدام Apidog لاختبار APIs الخاصة بـ Ollama

Apidog هي منصة متعددة الاستخدامات لتطوير API وتوثيقها مصممة لتبسيط دورة حياة API بالكامل. إنها تقدم واجهة سهلة الاستخدام لتصميم واختبار وتوثيق APIs، مما يجعلها أداة مثالية للعمل مع API الخاص بـ Ollama.

بعض ميزات APIDog المميزة تشمل:

- واجهة تصميم API بديهية

- توليد وثائق تلقائية

- أدوات اختبار وتصحيح API

- ميزات التعاون لمشاريع الفرق

- دعم بروتوكولات وصيغ API المختلفة

مع Apidog، يمكن للمطورين بسهولة إنشاء وإدارة ومشاركة توثيقات API، مما يضمن أن تكاملاتهم مع API الخاص بـ Ollama موثقة بشكل جيد وقابلة للصيانة.

المتطلبات السابقة

قبل الغوص في إجراء مكالمات API الخاصة بـ Ollama باستخدام Apidog، تأكد من أن لديك المتطلبات السابقة التالية:

تثبيت Ollama: قم بتحميل وتثبيت Ollama على جهاز الكمبيوتر المحلي الخاص بك. اتبع وثائق Ollama الرسمية للحصول على التعليمات المتعلقة بنظام التشغيل الخاص بك.

حساب APIDog: قم بالتسجيل للحصول على حساب Apidog إذا لم تكن قد فعلت ذلك بالفعل. يمكنك استخدام النسخة المستندة إلى الويب أو تحميل تطبيق سطح المكتب، بحسب تفضيلاتك.

نموذج Ollama: اسحب نموذجًا باستخدام واجهة سطر الأوامر الخاصة بـ Ollama. على سبيل المثال، لتحميل نموذج "llama2"، يمكنك تشغيل:

ollama pull llama3.1

أداة اختبار API: بينما توفر Apidog قدرات اختبار مدمجة، قد ترغب أيضًا في الحصول على أداة مثل cURL أو Postman للاختبار والتحقق الإضافي.

مع هذه العناصر في المكان، أنت مستعد للبدء في استكشاف API الخاص بـ Ollama باستخدام Apidog.

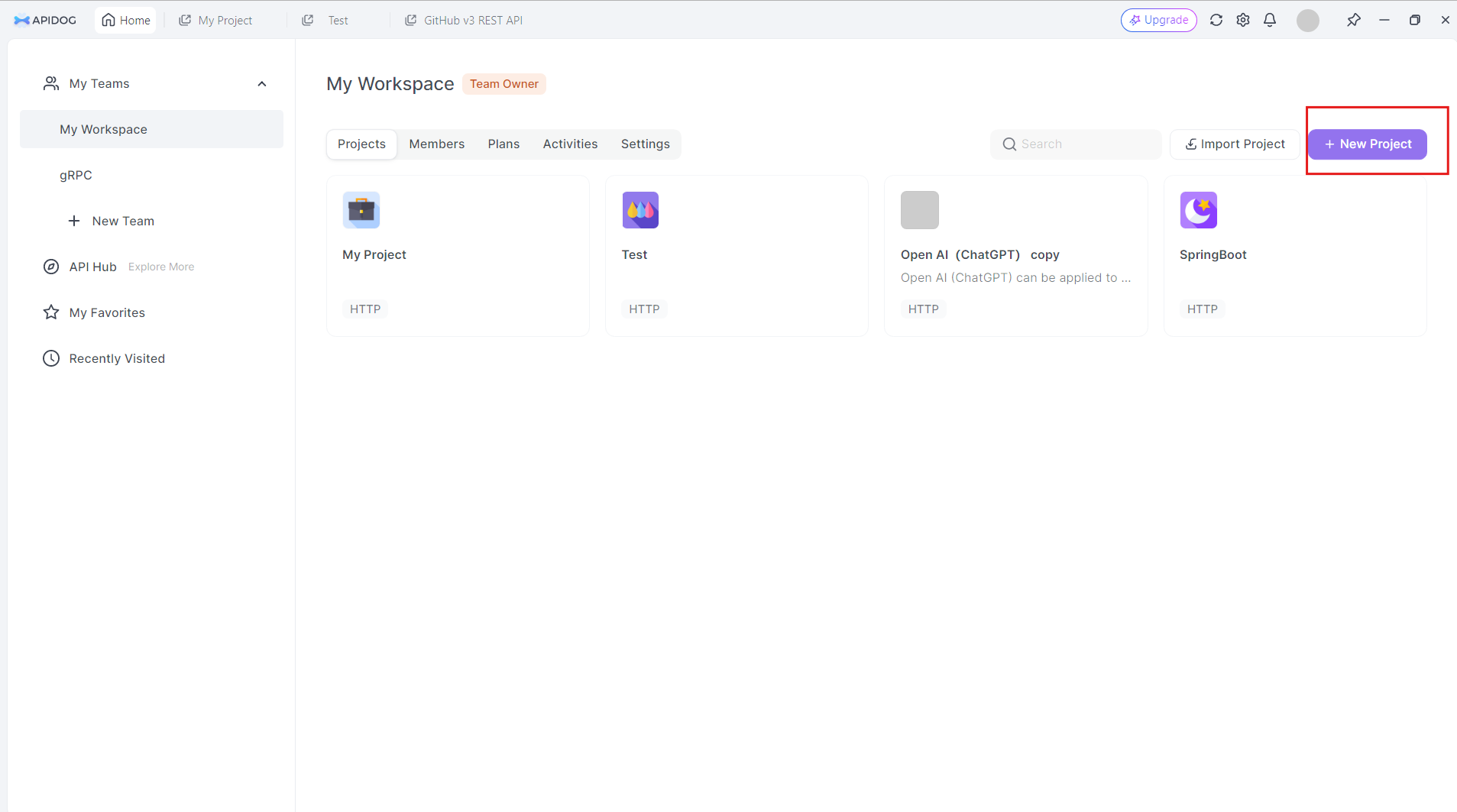

إنشاء مشروع API لـ Ollama في Apidog

للبدء في العمل مع API الخاص بـ Ollama في Apidog، اتبع هذه الخطوات:

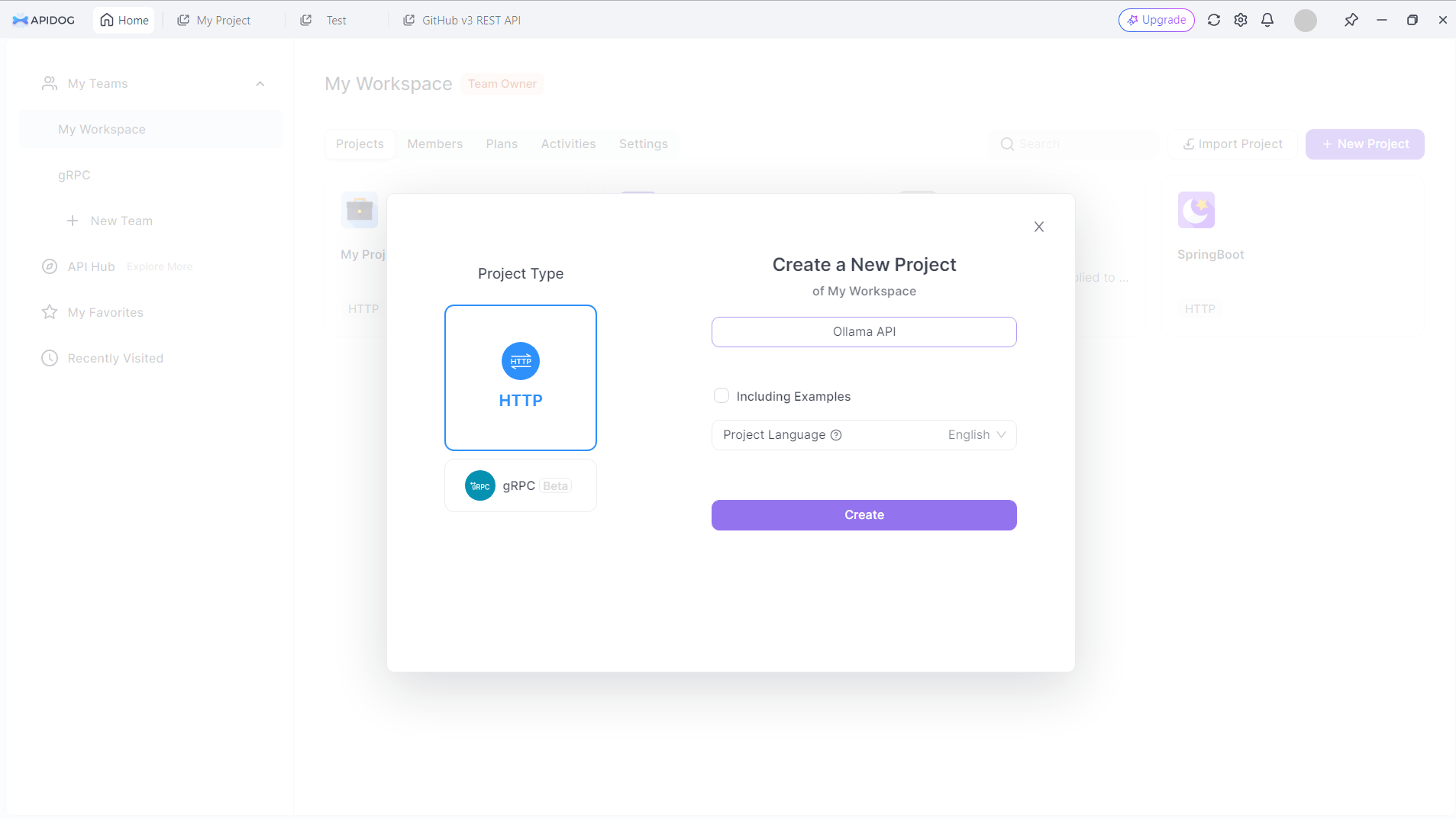

إنشاء مشروع جديد: قم بتسجيل الدخول إلى Apidog وأنشئ مشروعًا جديدًا خصيصًا لعملك مع API الخاص بـ Ollama. انقر على زر المشروع الجديد في الزاوية العلوية اليمنى

أعط مشروعك الجديد اسمًا. دعنا نقول: API الخاص بـ Ollama:

انقر على زر الإنشاء للمتابعة.

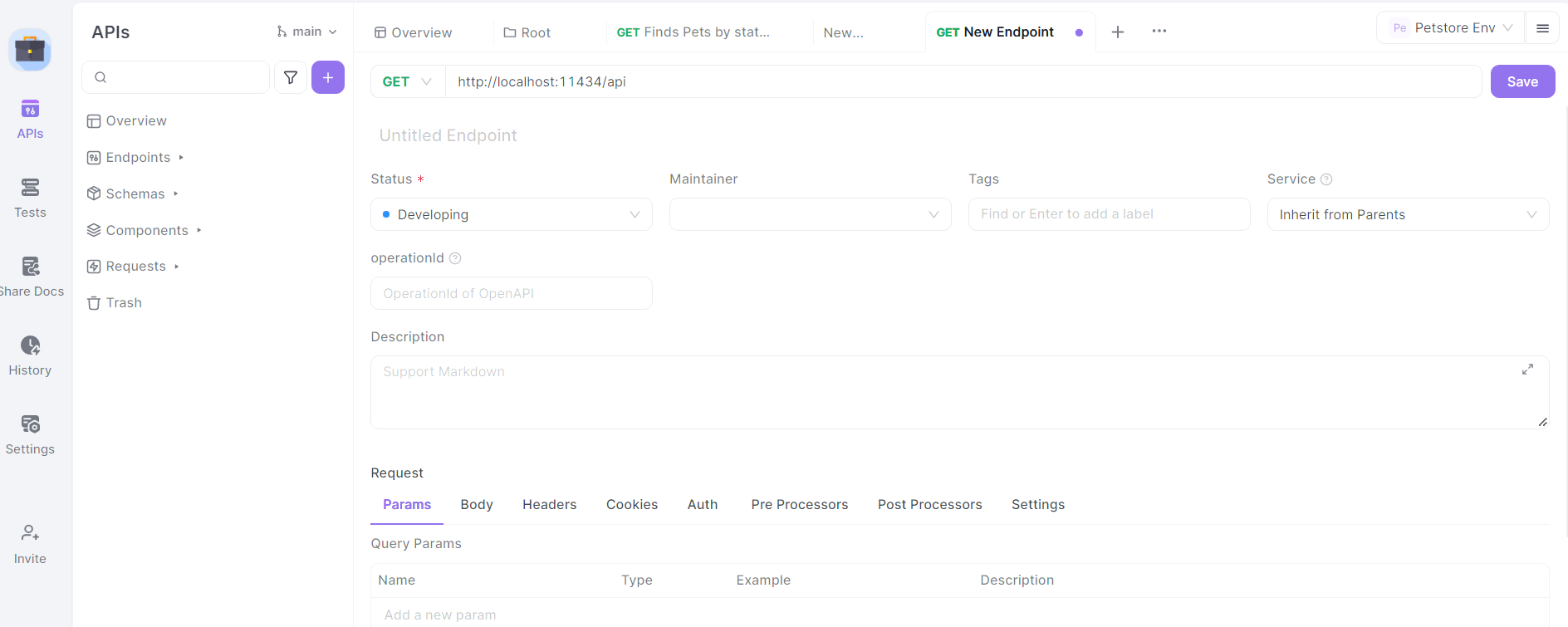

إعداد عنوان URL الأساسي: في إعدادات مشروعك، قم بتعيين عنوان URL الأساسي إلى http://localhost:11434/api. هذا هو العنوان الافتراضي الذي يكشف فيه Ollama عن نقاط النهاية الخاصة بـ API.

استيراد مواصفات API لـ Ollama: بينما لا يقدم Ollama مواصفة OpenAPI رسمية، يمكنك إنشاء هيكل أساسي لنقاط النهاية الخاصة بـ API يدويًا في APIDog.

تحديد نقاط النهاية: ابدأ بتحديد نقاط النهاية الرئيسية لـ API الخاص بـ Ollama في APIDog. بعض النقاط الرئيسية التي يجب تضمينها هي:

/generate(POST): لتوليد النصوص/chat(POST): لتفاعلات الدردشة/embeddings(POST): لتوليد التضمينات/pull(POST): لسحب نماذج جديدة/list(GET): لعرض النماذج المتاحة

بالنسبة لكل نقطة نهاية، حدد طريقة HTTP، ومعلمات الطلب، وشكل الاستجابة المتوقع بناءً على وثائق API الخاصة بـ Ollama.

تصميم مكالمات API الخاصة بـ Ollama في Apidog

دعونا نتخطى عملية تصميم مكالمات API لبعض من أكثر نقاط النهاية المستخدمة شيوعًا لـ Ollama باستخدام Apidog:

نقطة نهاية توليد النص (/generate)

في Apidog، قم بإنشاء نقطة API جديدة باستخدام المسار /generate وتعيين طريقة HTTP إلى POST.

حدد مخطط جسم الطلب:

{

"model": "string",

"prompt": "string",

"system": "string",

"template": "string",

"context": "array",

"options": {

"temperature": "number",

"top_k": "integer",

"top_p": "number",

"num_predict": "integer",

"stop": "array"

}

}

قدم وصفًا لكل معلمة، موضحًا غرضها وأي قيود.

حدد مخطط الاستجابة بناءً على وثائق API الخاصة بـ Ollama، بما في ذلك حقول مثل response، context، وtotal_duration.

نقطة نهاية الدردشة (/chat)

قم بإنشاء نقطة جديدة باستخدام المسار /chat وتعيين طريقة HTTP إلى POST.

حدد مخطط جسم الطلب:

{

"model": "string",

"messages": [

{

"role": "string",

"content": "string"

}

],

"format": "string",

"options": {

"temperature": "number",

"top_k": "integer",

"top_p": "number",

"num_predict": "integer",

"stop": "array"

}

}

قدم أوصافًا تفصيلية لمصفوفة messages، موضحًا هيكل رسائل الدردشة مع الأدوار (نظام، مستخدم، معاون) والمحتوى.

حدد مخطط الاستجابة، بما في ذلك كائن message مع حقول role وcontent.

نقاط إدارة النماذج

قم بإنشاء نقاط لنشاطات إدارة النماذج:

- سحب نموذج (

/pull): طلب POST مع معلمةnameللنموذج الذي ترغب في تنزيله. - قائمة النماذج (

/list): طلب GET لاسترداد النماذج المتاحة. - حذف نموذج (

/delete): طلب DELETE مع معلمةnameللنموذج الذي ترغب في إزالته.

بالنسبة لكل من هذه النقاط، حدد مخططات الطلب والاستجابة المناسبة بناءً على وثائق API الخاصة بـ Ollama.

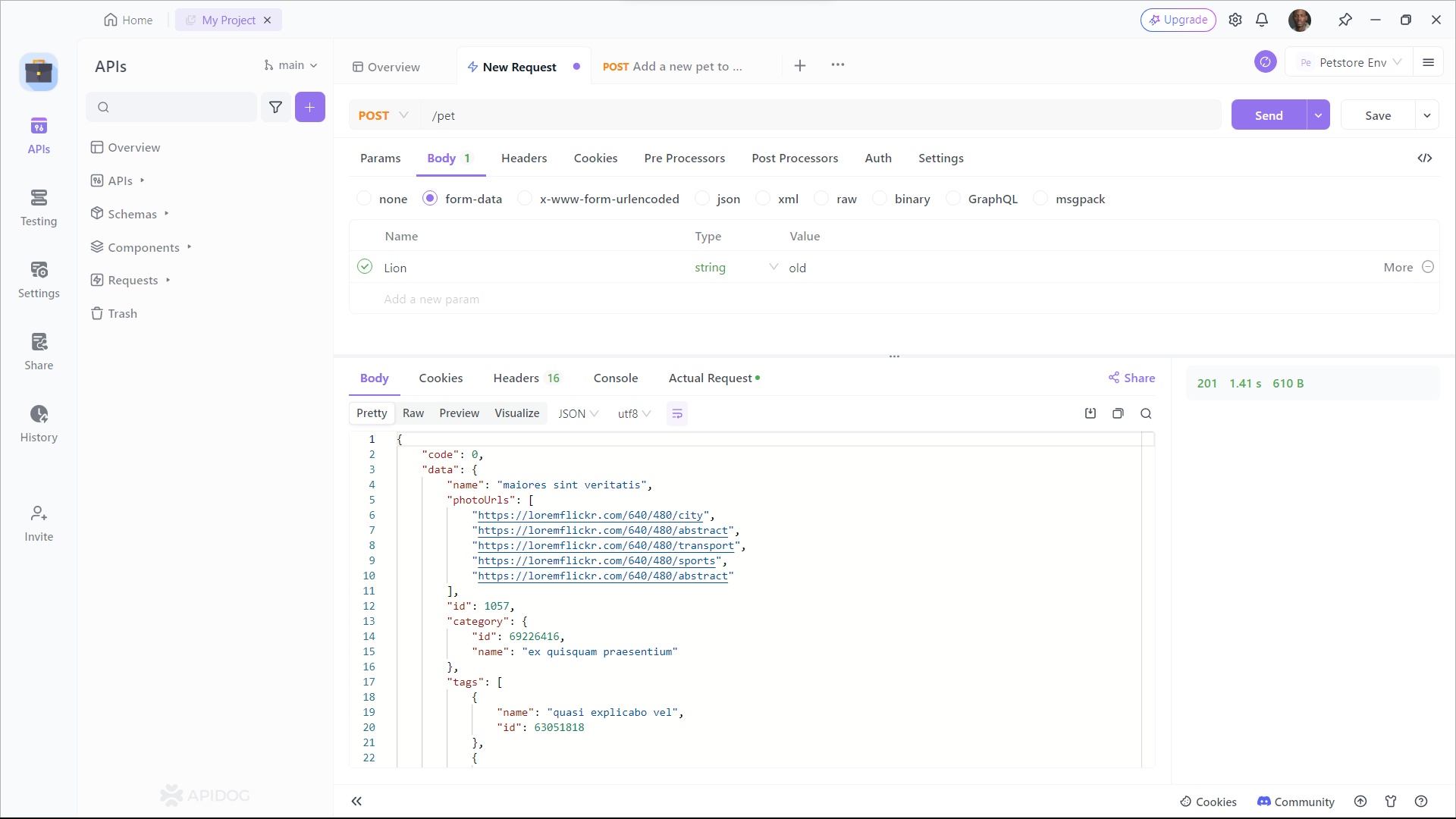

اختبار مكالمات API الخاصة بـ Ollama في Apidog

Apidog يوفر بيئة اختبار مدمجة تتيح لك إرسال الطلبات إلى API الخاص بـ Ollama والتحقق من الاستجابات. إليك كيفية استخدامها:

اختر نقطة نهاية: اختر واحدة من نقاط نهاية API الخاصة بـ Ollama التي قمت بتعريفها في Apidog.

تكوين معلمات الطلب: املأ المعلمات المطلوبة للنقطة المحددة. على سبيل المثال، بالنسبة لنقطة /generate، قد تحدد:

{

"model": "llama2",

"prompt": "اشرح مفهوم الذكاء الاصطناعي بكلمات بسيطة."

}

إرسال الطلب: استخدم زر "إرسال" في Apidog لتنفيذ مكالمة API إلى مثيل Ollama المحلي الخاص بك.

افحص الاستجابة من Ollama، والتحقق من أنها تتطابق مع الشكل المتوقع وتحتوي على النص المولد أو معلومات ذات صلة أخرى. إذا واجهت أي مشاكل، استخدم أدوات تصحيح الأخطاء في Apidog لفحص رؤوس الطلب والاستجابة، والجسم، وأي رسائل خطأ.

توليد وثائق API

واحدة من أقوى ميزات Apidog هي قدرته على توليد وثائق API شاملة تلقائيًا. لإنشاء وثائق لمشروع API الخاص بـ Ollama:

الخطوة 1: التسجيل في Apidog

لبدء استخدام Apidog لتوليد وثائق API، ستحتاج إلى التسجيل للحصول على حساب إذا لم تكن قد فعلت ذلك بالفعل. بمجرد تسجيل الدخول، ستُرحب بك واجهة Apidog سهلة الاستخدام.

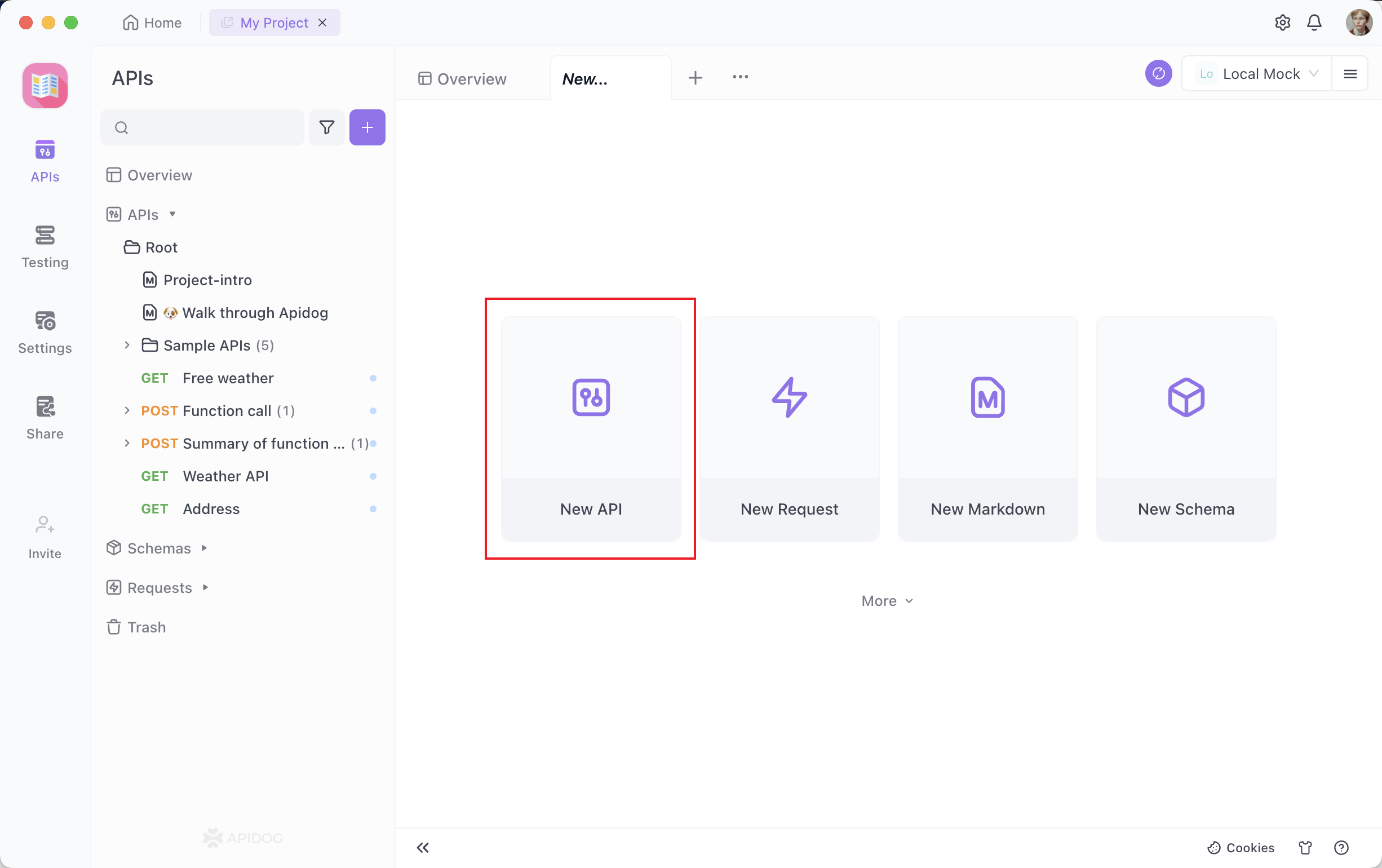

الخطوة 2: إنشاء طلب API الخاص بك

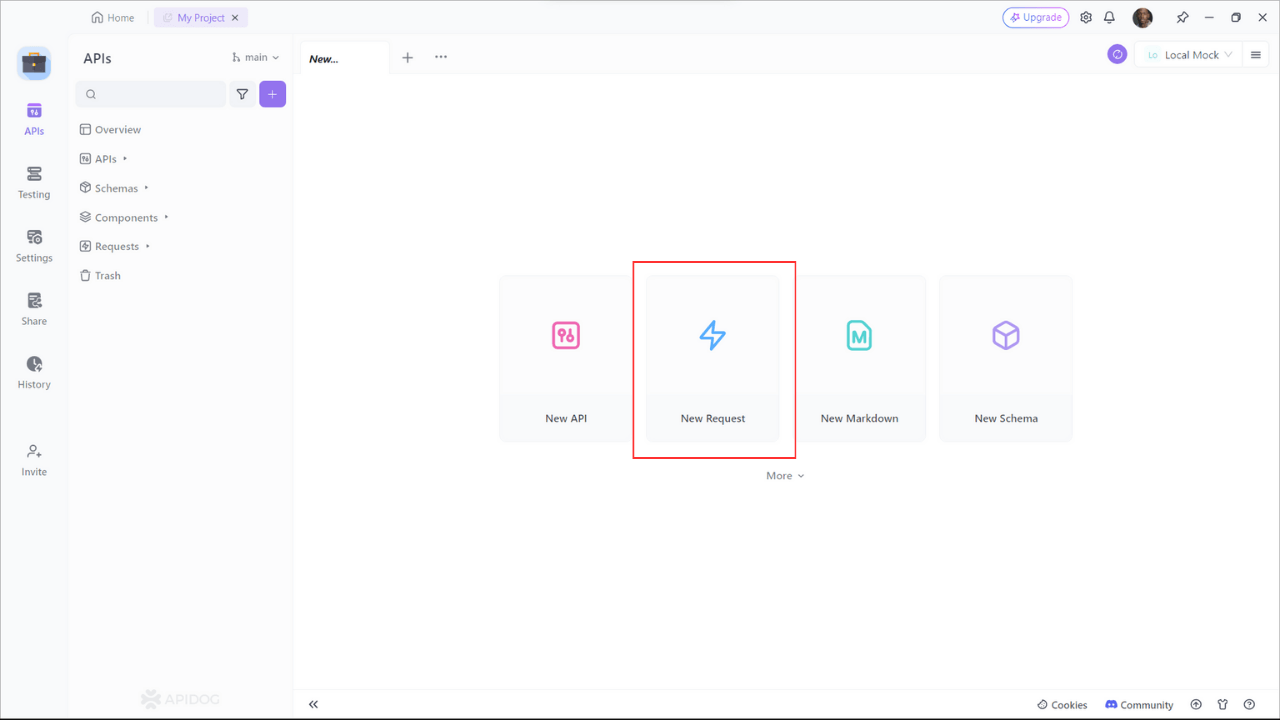

يتكون مشروع وثائق API من نقاط نهاية مختلفة، كل واحدة تمثل مسار API محدد أو وظيفة محددة. لإضافة نقطة نهاية، انقر على زر "+" أو "API جديد" داخل مشروعك.

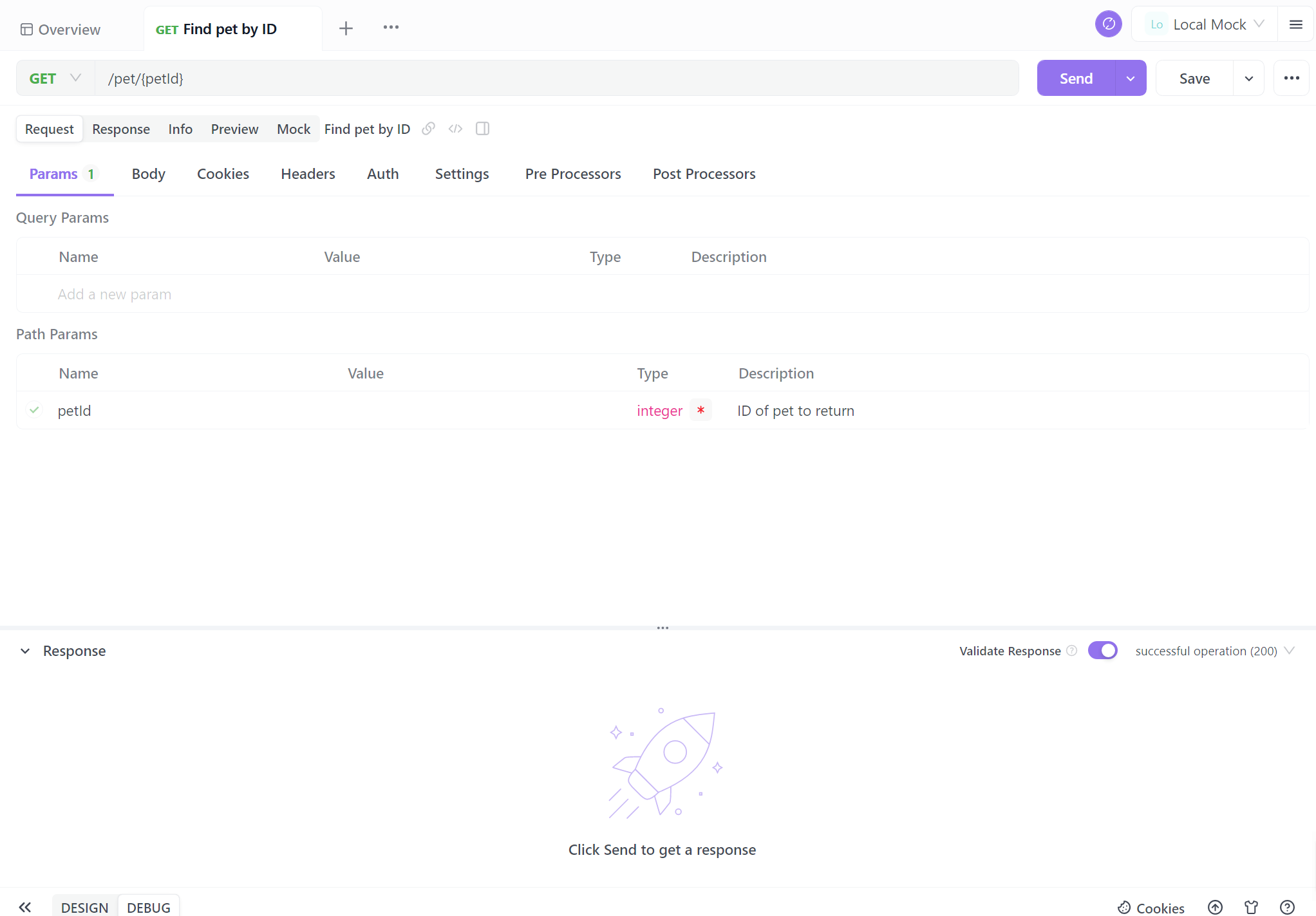

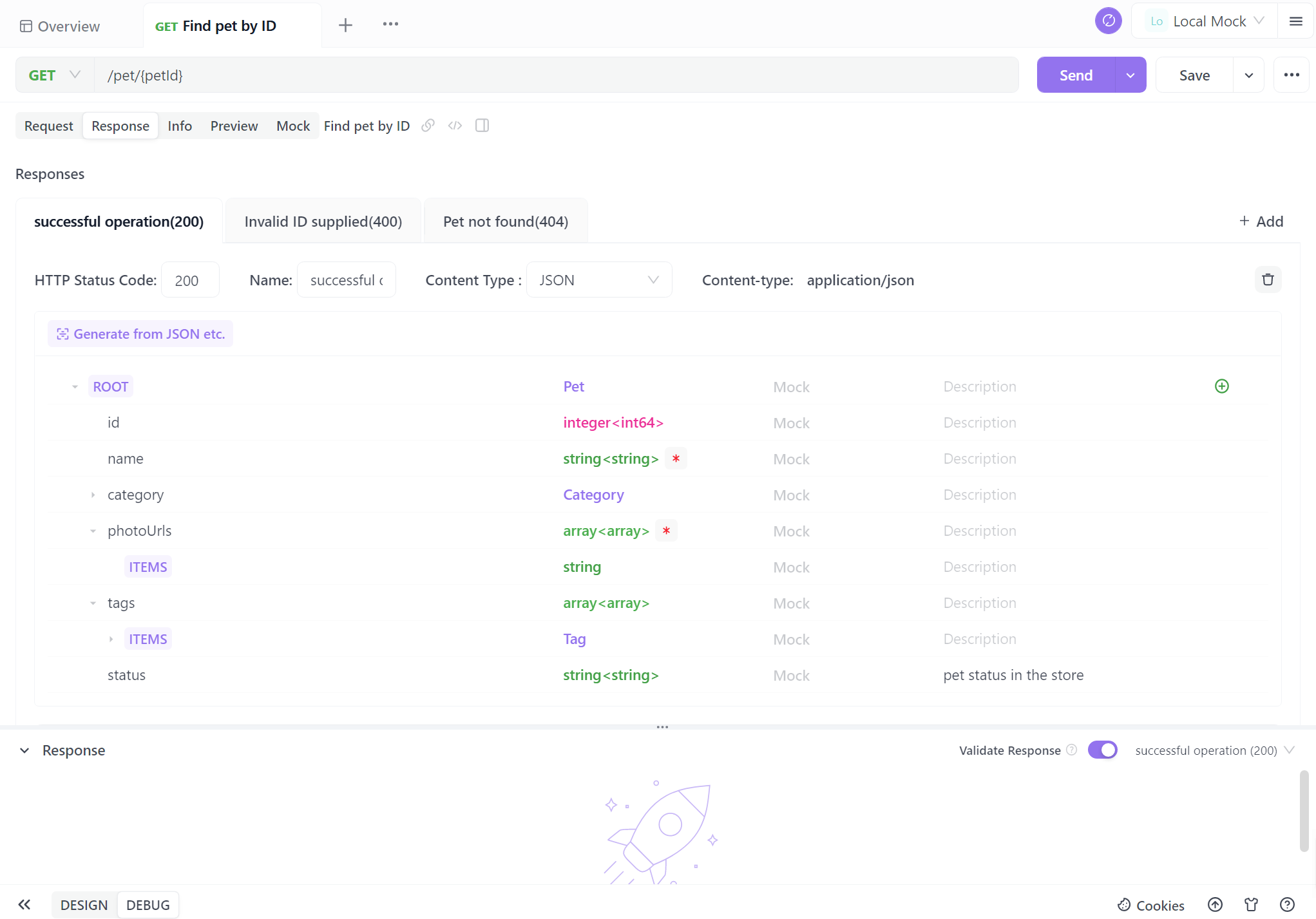

الخطوة 3: إعداد معلمات الطلب

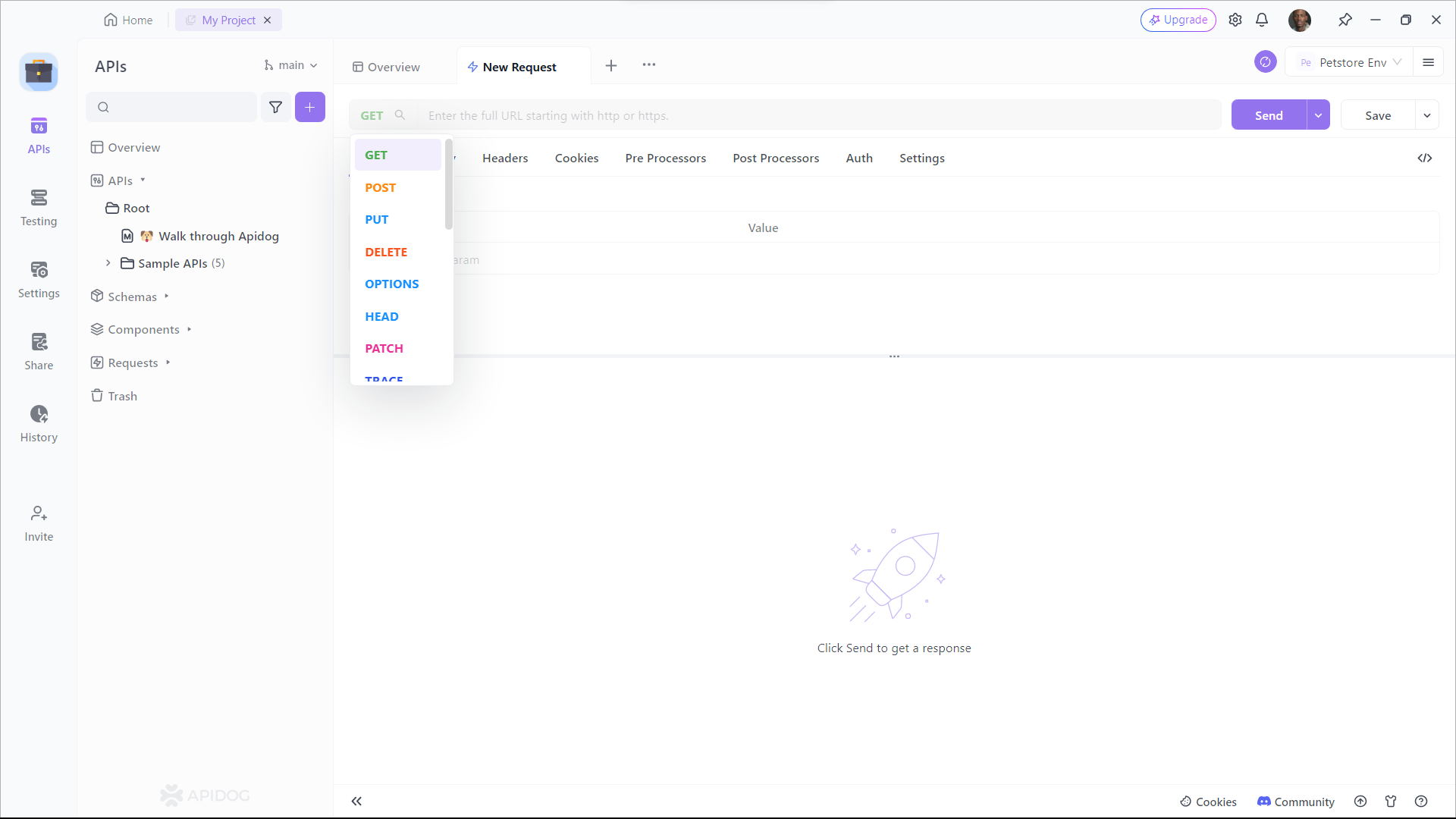

ستحتاج إلى تقديم تفاصيل مثل عنوان URL الخاص بالنقطة، الوصف، وتفاصيل الطلب/الاستجابة. الآن تأتي الجزء الحرج - توثيق نقاط النهاية الخاصة بك. تجعل Apidog هذه العملية بسيطة بشكل كبير. بالنسبة لكل نقطة نهاية، يمكنك:

- تحديد طريقة HTTP (GET، POST، PUT، DELETE، إلخ).

- تحديد معلمات الطلب، بما في ذلك أسمائها، أنواعها، وأوصافها.

- وصف الاستجابة المتوقعة، بما في ذلك رموز الحالة، صيغ الاستجابة (JSON، XML، إلخ)، واستجابات أمثلة.

يعاني العديد من المطورين من تجنب كتابة وثائق API، وغالبًا ما يجدونه معقدًا. ومع ذلك، في الواقع، مع Apidog، يمكنك إكمالها ببضع نقرات فقط. واجهة Apidog المرئية سهلة الاستخدام، مما يجعلها أبسط بكثير من توليد وثائق API من الكود.

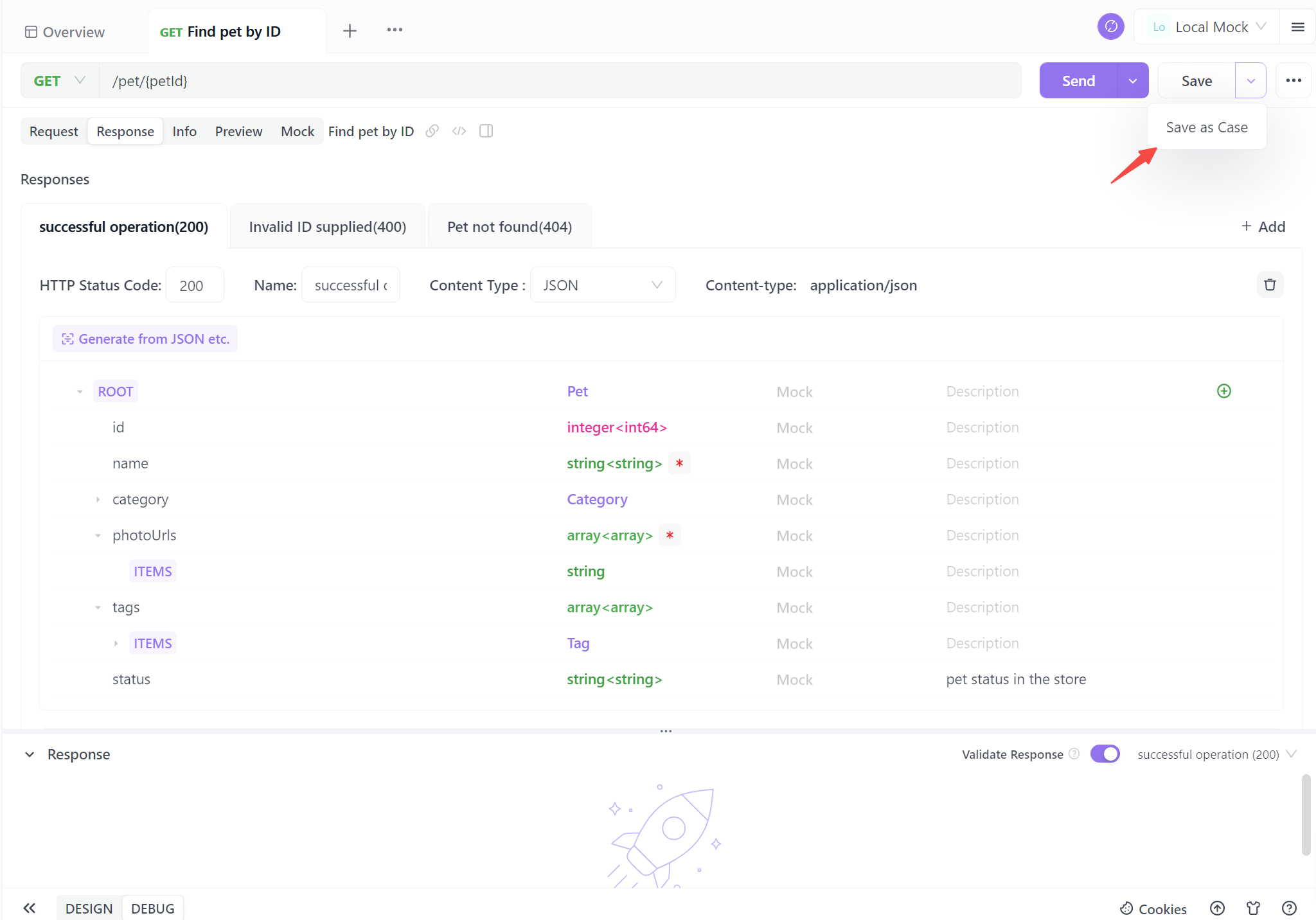

الخطوة 4. توليد API الخاص بك

عندما تكمل المعلومات الأساسية للـ API، يكفي نقرة واحدة لحفظها كحالة. يمكنك أيضًا حفظها مباشرة، لكن يُوصى بحفظها كحالة اختبار للرجوع إليها بسهولة في المستقبل.

تمنحك هذه الخطوات الأربع القدرة على توليد وثائق API موحدة بسهولة. تضمن هذه العملية المبسطة الوضوح والاتساق بينما توفر أيضًا وقتًا ثمينًا. مع التوثيق التلقائي، أنت مجهز جيدًا لتعزيز التعاون، وتبسيط تفاعل المستخدم، ودفع مشاريعك قدمًا بثقة.

أفضل الممارسات لتكامل API الخاص بـ Ollama

بينما تعمل مع API الخاص بـ Ollama عبر APIDog، تذكر هذه الممارسات الفضلى:

- تحكم في الإصدار: استخدم ميزات التحكم في الإصدار لـ APIDog لتتبع التغييرات في تعريفات API الخاصة بك على مر الزمن.

- التعامل مع الأخطاء: وثق ردود الأخطاء الشائعة وضمن أمثلة حول كيفية التعامل معها في وثائق API الخاصة بك.

- تحديد المعدلات: كن على دراية بأي قيود على المعدلات قد يتم تطبيقها بواسطة Ollama، خاصة عند التشغيل على أنظمة مقيدة بالموارد، ودوّن هذه القيود.

- اعتبارات الأمان: بينما يعمل Ollama عادةً محليًا، ضع في اعتبارك تنفيذ المصادقة إذا كنت تقوم بتعريض API على شبكة.

- تحسين الأداء: وثق أفضل الممارسات لتحسين الطلبات، مثل إعادة استخدام السياق لاستفسارات ذات صلة لتحسين أوقات الاستجابة.

الخاتمة

يتيح لك دمج API الخاص بـ Ollama في مشاريعك فتح عالم من الإمكانيات لاستغلال نماذج لغوية قوية في تطبيقاتك. من خلال استخدام APIDog لتصميم، اختبار، وتوثيق مكالمات API الخاصة بـ Ollama، تقوم بإنشاء تكامل قوي وقابل للصيانة يمكن أن يتطور مع احتياجات مشروعك.

يوفر الجمع بين قدرات LLM المحلية لـ Ollama وميزات إدارة API الشاملة لـ APIDog أدوات قوية للمطورين لبناء تطبيقات معززة بالذكاء الاصطناعي. أثناء استمرارك في استكشاف إمكانيات Ollama وتنقيح تكاملات API الخاصة بك، تذكر أن الوثائق الواضحة والاختبارات الشاملة هي المفتاح للتنفيذ الناجح.

من خلال اتباع الخطوات وأفضل الممارسات الموضحة في هذه المقالة، ستكون مؤهلاً جيدًا للاستفادة من الإمكانيات الكاملة لـ API الخاص بـ Ollama، مما يسمح بإنشاء تطبيقات معقدة مدعومة بالذكاء الاصطناعي بثقة وسهولة. إن رحلة تكامل الذكاء الاصطناعي هي رحلة مثيرة، ومع أدوات مثل Ollama وAPIDog تحت تصرفك، فإن الإمكانيات حقًا غير محدودة.