مؤخراً، أُطلق نموذج Llama 3.2 القوي من ميتا كنموذج لغوي يغير قواعد اللعبة، مما يوفر قدرات مدهشة لمعالجة النصوص والصور. لمطوري البرمجيات ومحبي الذكاء الاصطناعي المتحمسين للاستفادة من قوة هذا النموذج المتقدم على أجهزتهم المحلية، تبرز أدوات مثل LM Studio. ستأخذك هذه الدليل الشامل عبر خطوات تشغيل Llama 3.2 محلياً باستخدام هذه المنصات القوية، مما يمكنك من استخدام أحدث تقنيات الذكاء الاصطناعي دون الاعتماد على خدمات السحابة.

ما الجديد في Llama 3.2: أحدث ابتكارات الذكاء الاصطناعي

قبل الغوص في عملية التثبيت، دعنا نستعرض بإيجاز ما يجعل Llama 3.2 مميزاً:

- قدرته متعددة النماذج: Llama 3.2 يمكنه معالجة النصوص والصور، مما يفتح آفاقاً جديدة لتطبيقات الذكاء الاصطناعي.

- كفاءة محسنة: مصمم لأداء أفضل مع تقليل زمن الاستجابة، مما يجعله مثالياً للتطبيق المحلي.

- أحجام نماذج متنوعة: متاح بأحجام متعددة، من نماذج خفيفة 1B و3B المناسبة للأجهزة المحدودة إلى إصدارات قوية 11B و90B لمهام أكثر تعقيداً.

- سياق ممتد: يدعم طول سياق يصل إلى 128K، مما يسمح بفهم شامل وتوليد المحتوى.

تشغيل Llama 3.2 مع LM Studio محلياً

LM Studio يقدم أسلوباً أكثر سهولة مع واجهة رسومية. إليك كيفية تشغيل Llama 3.2 محلياً باستخدام LM Studio:

الخطوة 1: تنزيل وتثبيت LM Studio

- قم بزيارة موقع LM Studio.

- قم بتنزيل النسخة المتوافقة مع نظام التشغيل الخاص بك.

- اتبع تعليمات التثبيت المقدمة.

الخطوة 2: إطلاق LM Studio

عند التثبيت، قم بفتح LM Studio. ستجد واجهة بديهية في انتظارك.

الخطوة 3: البحث عن Llama 3.2 وتنزيله

- استخدم وظيفة البحث في LM Studio للعثور على Llama 3.2.

- اختر النسخة المناسبة من Llama 3.2 لاحتياجاتك (مثل 3B للتطبيقات الخفيفة أو 11B للمهام الأكثر تعقيداً).

- انقر على زر التنزيل لبدء عملية التنزيل.

الخطوة 4: تكوين النموذج

بعد التنزيل، يمكنك تكوين معلمات مختلفة:

- قم بضبط طول السياق إذا لزم الأمر (Llama 3.2 يدعم حتى 128K).

- قم بتحديد قيم درجة الحرارة والتقنيات الأخرى للتحكم في عشوائية الإخراج.

- جرب إعدادات أخرى لضبط سلوك النموذج بدقة.

الخطوة 5: ابدأ بالتفاعل مع Llama 3.2

بعد تكوين النموذج، يمكنك الآن:

- استخدام واجهة المحادثة لإجراء محادثات مع Llama 3.2.

- جرب مطالبات مختلفة لاستكشاف قدرات النموذج.

- استخدم ميزة Playground للتجربة بمطالبات وإعدادات أكثر تقدماً.

الخطوة 6: إعداد خادم محلي (اختياري)

بالنسبة للمطورين، يسمح لك LM Studio بإعداد خادم محلي:

- اذهب إلى علامة التبويب Server في LM Studio.

- قم بتكوين إعدادات الخادم (المنفذ، نقاط النهاية API، إلخ).

- ابدأ الخادم لاستخدام Llama 3.2 عبر استدعاءات API في تطبيقاتك.

أفضل الممارسات لتشغيل Llama 3.2 محلياً

لتحقيق أقصى استفادة من إعداد Llama 3.2 المحلي، ضع في اعتبارك هذه الممارسات الجيدة:

- اعتبارات الأجهزة: تأكد من أن جهازك يلبي الحد الأدنى من المتطلبات. يمكن أن يؤدي وجود وحدة معالجة الرسومات المخصصة إلى تحسين الأداء بشكل كبير، خاصةً للأحجام الكبيرة من النماذج.

- هندسة المطالبات: اصنع مطالبات واضحة ودقيقة للحصول على أفضل النتائج من Llama 3.2. جرب صيغ مختلفة لتحسين جودة الإخراج.

- التحديثات المنتظمة: احتفظ بالأداة التي اخترتها (LM Studio) ونموذج Llama 3.2 محدثين لأفضل أداء وأحدث الميزات.

- تجربة المعلمات: لا تتردد في ضبط الإعدادات لإيجاد التوازن الصحيح لحالة الاستخدام الخاصة بك. القيم الأقل تنتج بشكل عام مخرجات أكثر تركيزاً وثباتاً، بينما القيم الأعلى تضيف مزيدًا من الإبداع والتغير.

- الاستخدام الأخلاقي: استخدم نماذج الذكاء الاصطناعي دائماً بمسؤولية وكن على دراية بالانحياز المحتمل في المخرجات. ضع في اعتبارك تنفيذ تدابير أمان إضافية أو مرشحات عند نشر النماذج في بيئات الإنتاج.

- خصوصية البيانات: يؤدي تشغيل Llama 3.2 محلياً إلى تعزيز خصوصية البيانات. كن حذراً بشأن البيانات التي تقوم بإدخالها وطريقة استخدام مخرجات النموذج، خاصة عند التعامل مع المعلومات الحساسة.

- إدارة الموارد: راقب موارد النظام الخاصة بك عند تشغيل Llama 3.2، خاصة لفترات طويلة أو مع أحجام نماذج أكبر. ضع في اعتبارك استخدام مديري المهام أو أدوات مراقبة الموارد لضمان الأداء الأمثل.

استكشاف الأخطاء الشائعة وإصلاحها

عند تشغيل Llama 3.2 محليًا، قد تواجه بعض التحديات. إليك حلول للمشكلات الشائعة:

- أداء بطيء:

- تأكد من وجود ذاكرة RAM وقوة معالجة CPU/GPU كافية.

- حاول استخدام حجم نموذج أصغر إذا كان متاحًا (مثل 3B بدلاً من 11B).

- أغلق التطبيقات الخلفية غير الضرورية لتحرير موارد النظام.

2. أخطاء نفاد الذاكرة:

- قلل من طول السياق في إعدادات النموذج.

- استخدم نسخة نموذج أصغر إذا كانت متاحة.

- قم بترقية ذاكرة النظام الخاصة بك إذا كان ذلك ممكنًا.

3. مشكلات في التثبيت:

- تحقق مما إذا كان نظامك يلبي الحد الأدنى من المتطلبات لـ LM Studio.

- تأكد من أنك تستخدم أحدث إصدار من الأداة التي تستخدمها.

- حاول تشغيل التثبيت مع امتيازات المسؤول.

4. فشل في تنزيل النموذج:

- تحقق من استقرار اتصال الإنترنت لديك.

- قم بتعطيل جدران الحماية أو الشبكات الافتراضية الخاصة مؤقتًا التي قد تتداخل مع التنزيل.

- حاول التنزيل في أوقات غير الذروة للحصول على نطاق ترددي أفضل.

5. مخرجات غير متوقعة:

- راجع وحقق مطالباتك للحصول على وضوح ودقة.

- قم بضبط درجة الحرارة والمعلمات الأخرى للتحكم في عشوائية الإخراج.

- تأكد من أنك تستخدم النسخة الصحيحة من النموذج والتكوين.

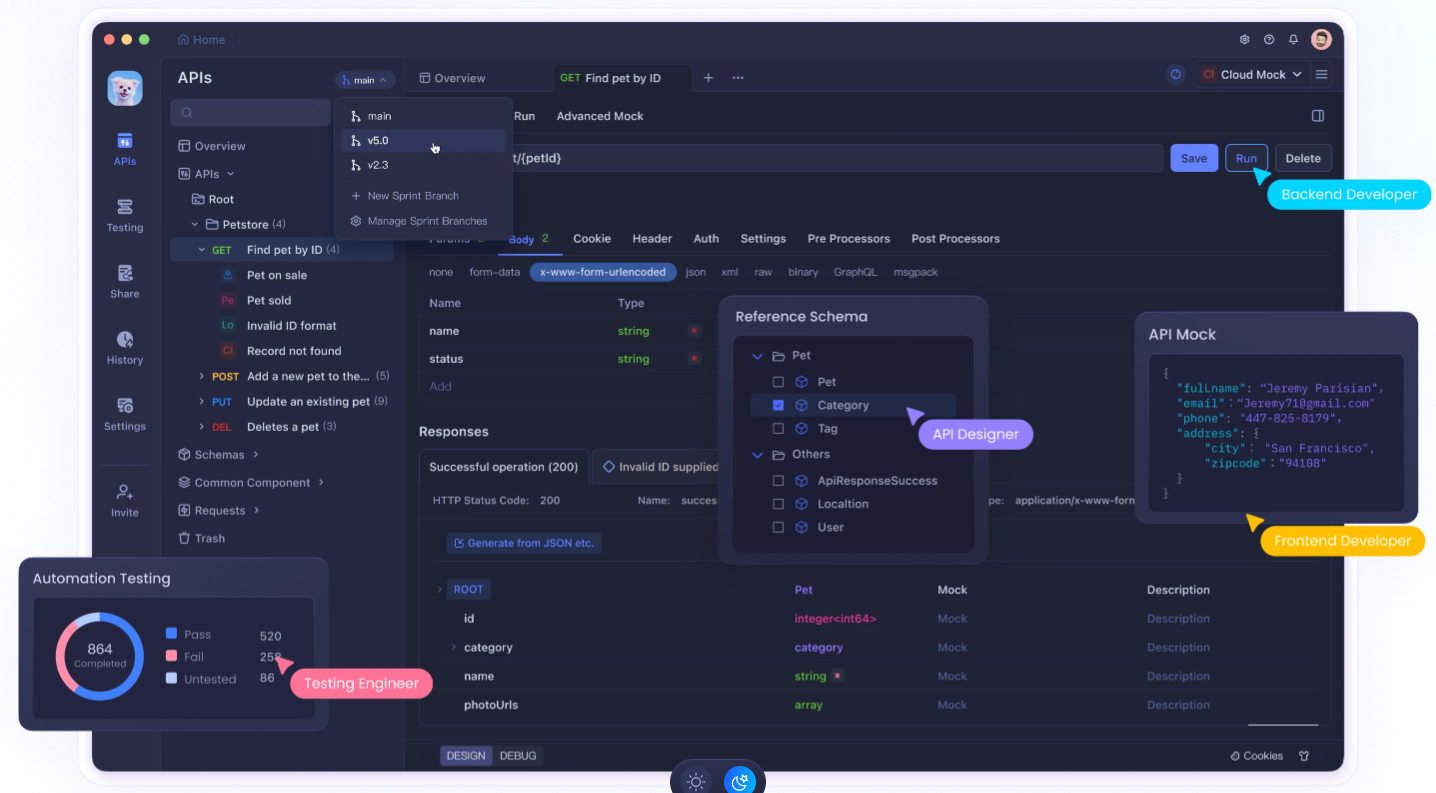

استخدام Apidog لتعزيز تطوير API الخاص بك

تشغيل Llama 3.2 محلياً هو أمر قوي، لكن دمجه في تطبيقاتك غالباً ما يتطلب تطوير واختبار API قويين. هنا يأتي دور Apidog. Apidog هو منصة شاملة لتطوير API يمكن أن تعزز بشكل كبير سير العمل الخاص بك عند العمل مع LLMs المحلية مثل Llama 3.2.

الميزات الرئيسية لـ Apidog من أجل تكامل LLM المحلي:

- تصميم API وتوثيقها: سهولة تصميم وتوثيق APIs لتكاملات Llama 3.2 الخاصة بك، مما يضمن تواصلاً واضحاً بين النموذج المحلي الخاص بك وأجزاء أخرى من تطبيقك.

- اختبارات آلية: إنشاء وتشغيل اختبارات آلية لنقاط النهاية API الخاصة بـ Llama 3.2، مما يضمن موثوقية وتناسق في ردود النموذج.

- خوادم وهمية: استخدام وظيفة الخادم الوهمي في Apidog لمحاكاة ردود Llama 3.2 أثناء التطوير، مما يتيح لك التقدم حتى عندما لا يكون لديك وصول فوري إلى إعدادك المحلي.

- إدارة البيئات: إدارة البيئات المختلفة (مثل Llama 3.2 المحلية، API الإنتاج) ضمن Apidog، مما يجعل من السهل التبديل بين التكوينات أثناء التطوير والاختبار.

- أدوات التعاون: مشاركة تصميمات API الخاصة بك ونتائج الاختبار مع أعضاء الفريق، مما يعزز التعاون الأفضل في المشاريع المدفوعة بالذكاء الاصطناعي.

- مراقبة الأداء: مراقبة أداء نقاط نهاية API الخاصة بـ Llama 3.2، مما يساعدك على تحسين أوقات الاستجابة واستخدام الموارد.

- اختبار الأمان: تنفيذ اختبارات الأمان لدمج API الخاصة بـ Llama 3.2، مما يضمن أن نشر النموذج المحلي لا يقدم أي ثغرات.

البدء مع Apidog لتطوير Llama 3.2:

- سجل للحصول على حساب Apidog.

- قم بإنشاء مشروع جديد لتكامل API الخاص بـ Llama 3.2.

- صمم نقاط النهاية API الخاصة بك التي ستتفاعل مع نسخة Llama 3.2 المحلية لديك.

- قم بإعداد البيئات لإدارة تكوينات مختلفة (مثل إعدادات LM Studio).

- قم بإنشاء اختبارات آلية لضمان أن تكاملات Llama 3.2 الخاصة بك تعمل بشكل صحيح.

- استخدم ميزة الخادم الوهمي لمحاكاة ردود Llama 3.2 أثناء مراحل التطوير المبكرة.

- تعاون مع فريقك من خلال مشاركة تصميمات API ونتائج الاختبار.

من خلال الاستفادة من Apidog جنبًا إلى جنب مع إعداد Llama 3.2 المحلي لديك، يمكنك إنشاء تطبيقات مدفوعة بالذكاء الاصطناعي أكثر متانة وموثوقية وقابلة للتوثيق بشكل جيد.

الخاتمة: احتضان قوة الذكاء الاصطناعي المحلي

يمثل تشغيل Llama 3.2 محلياً خطوة هامة نحو ديمقراطية تقنية الذكاء الاصطناعي. سواء اخترت واجهة المستخدم السهلة الاستخدام لـ LM Studio أو غيرها، لديك الآن الأدوات للاستفادة من قوة النماذج اللغوية المتقدمة على جهازك الخاص.

تذكر أن النشر المحلي لنماذج اللغة الكبيرة مثل Llama 3.2 هو مجرد البداية. لتحقيق التميز الحقيقي في تطوير الذكاء الاصطناعي، ضع في اعتبارك دمج أدوات مثل Apidog في سير عملك. يمكن أن تساعدك هذه المنصة القوية في تصميم واختبار وتوثيق APIs التي تتفاعل مع نسخة Llama 3.2 المحلية لديك، مما يسهل عملية تطويرك ويضمن موثوقية تطبيقاتك المدفوعة بالذكاء الاصطناعي.

بينما تبدأ رحلتك مع Llama 3.2، استمر في التجربة، وكن فضولياً، واسعى دائماً لاستخدام الذكاء الاصطناعي بمسؤولية. مستقبل الذكاء الاصطناعي ليس فقط في السحابة – إنه هنا على جهازك المحلي، في انتظار أن يتم استكشافه واستغلاله لتطبيقات مبتكرة. مع الأدوات والممارسات الصحيحة، يمكنك فتح الإمكانات الكاملة للذكاء الاصطناعي المحلي وإنشاء حلول رائدة تدفع حدود ما هو ممكن في التقنية.