في مشهد اليوم الرقمي، تُعتبر واجهات برمجة التطبيقات (APIs) العمود الفقري للتطبيقات الحديثة، مما يسهل التواصل السلس بين أنظمة البرمجيات المختلفة. مع استمرار زيادة الطلب على واجهات برمجة التطبيقات القوية وقابلة التوسع، يصبح من الضروري بشكل متزايد ضمان أدائها تحت ظروف تحميل مختلفة. تستكشف هذه الدليل الشامل أفضل 10 تقنيات وأدوات لاختبار أداء واجهات برمجة التطبيقات على نطاق واسع، مما يوفر للمطورين والمحترفين في ضمان الجودة المعرفة والموارد اللازمة لتحسين أداء واجهات برمجة التطبيقات الخاصة بهم.

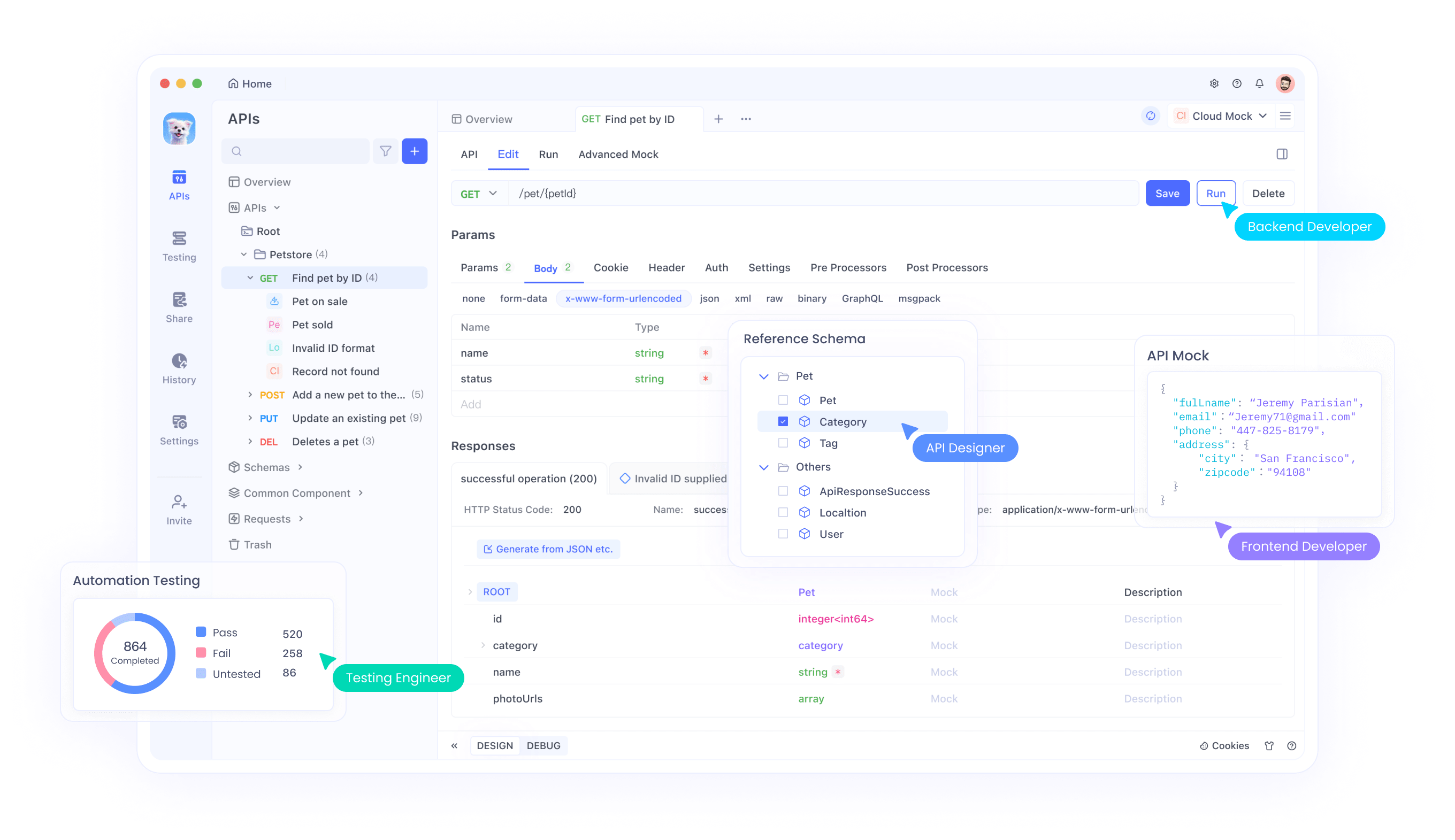

1. Apidog: القوة الشاملة لاختبار واجهات برمجة التطبيقات

عندما يتعلق الأمر باختبار أداء واجهات برمجة التطبيقات على نطاق واسع، تُبرز Apidog كأداة متعددة الاستخدامات وفعالة تجمع بين عدة وظائف في منصة واحدة. تقدم هذه الحل الشامل مجموعة من الميزات المصممة خصيصًا لتبسيط عملية اختبار واجهات برمجة التطبيقات وضمان الأداء الأمثل.

الميزات الرئيسية لـ Apidog لاختبار أداء واجهات برمجة التطبيقات

- منشئ واجهة برمجة التطبيقات المرئي: يسمح واجهة Apidog البديهية للمستخدمين بإنشاء وتعديل اختبارات واجهة برمجة التطبيقات دون كتابة رموز معقدة، مما يجعلها متاحة لكل من المطورين وأعضاء الفريق غير التقنيين.

- توليد اختبارات تلقائي: يمكن للمنصة توليد حالات اختبار تلقائيًا بناءً على مواصفات واجهة برمجة التطبيقات، مما يوفر الوقت ويقلل من احتمال وقوع الأخطاء البشرية.

- قدرات اختبار التحميل: يوفر Apidog ميزات اختبار التحميل المدمجة التي تمكن المستخدمين من محاكاة حركة مرور ذات حجم عالٍ وتقييم أداء واجهات برمجة التطبيقات تحت الضغط.

- المراقبة في الوقت الحقيقي: خلال تنفيذ الاختبار، يوفر Apidog مقاييس الأداء في الوقت الحقيقي، مما يسمح للمختبرين بتحديد أماكن الازدحام والمشاكل عند حدوثها.

- تقارير شاملة: تقدم التقارير التفصيلية والتحليلات رؤى حول أداء واجهات برمجة التطبيقات، مما يساعد الفرق على اتخاذ قرارات مدفوعة بالبيانات من أجل التحسين.

تنفيذ اختبارات الأداء باستخدام Apidog

لاستخدام Apidog لاختبار أداء واجهات برمجة التطبيقات، اتبع هذه الخطوات:

- حدد نقاط النهاية الخاصة بواجهة برمجة التطبيقات وسيناريوهات الاختبار ضمن واجهة Apidog.

- قم بتكوين معلمات اختبار التحميل، مثل عدد المستخدمين الافتراضيين ومدة الاختبار.

- نفذ اختبار الأداء وراقب النتائج في الوقت الحقيقي.

- حلل التقارير الناتجة لتحديد أماكن الازدحام في الأداء والمجالات التي تحتاج إلى تحسين.

مثال على إعداد اختبار تحميل في Apidog:

// إعداد اختبار تحميل في Apidog

const loadTest = {

endpoint: 'https://api.example.com/users',

method: 'GET',

virtualUsers: 1000,

rampUpPeriod: 60, // ثواني

duration: 300, // ثواني

assertions: [

{ type: 'responseTime', maxValue: 500 }, // مللي ثانية

{ type: 'successRate', minValue: 99.5 } // نسبة مئوية

]

};

apidog.runLoadTest(loadTest);من خلال الاستفادة من ميزات Apidog الشاملة، يمكن لفرق التطوير اختبار وتحسين واجهات برمجة التطبيقات الخاصة بهم بكفاءة من حيث الأداء على نطاق واسع، مما يضمن تجربة مستخدم سلسة حتى تحت ظروف تحميل عالية. لمزيد من التفاصيل، قم بزيارة مركز المساعدة الخاص بـ Apidog لفهم قدرات المنصة بشكل أفضل.

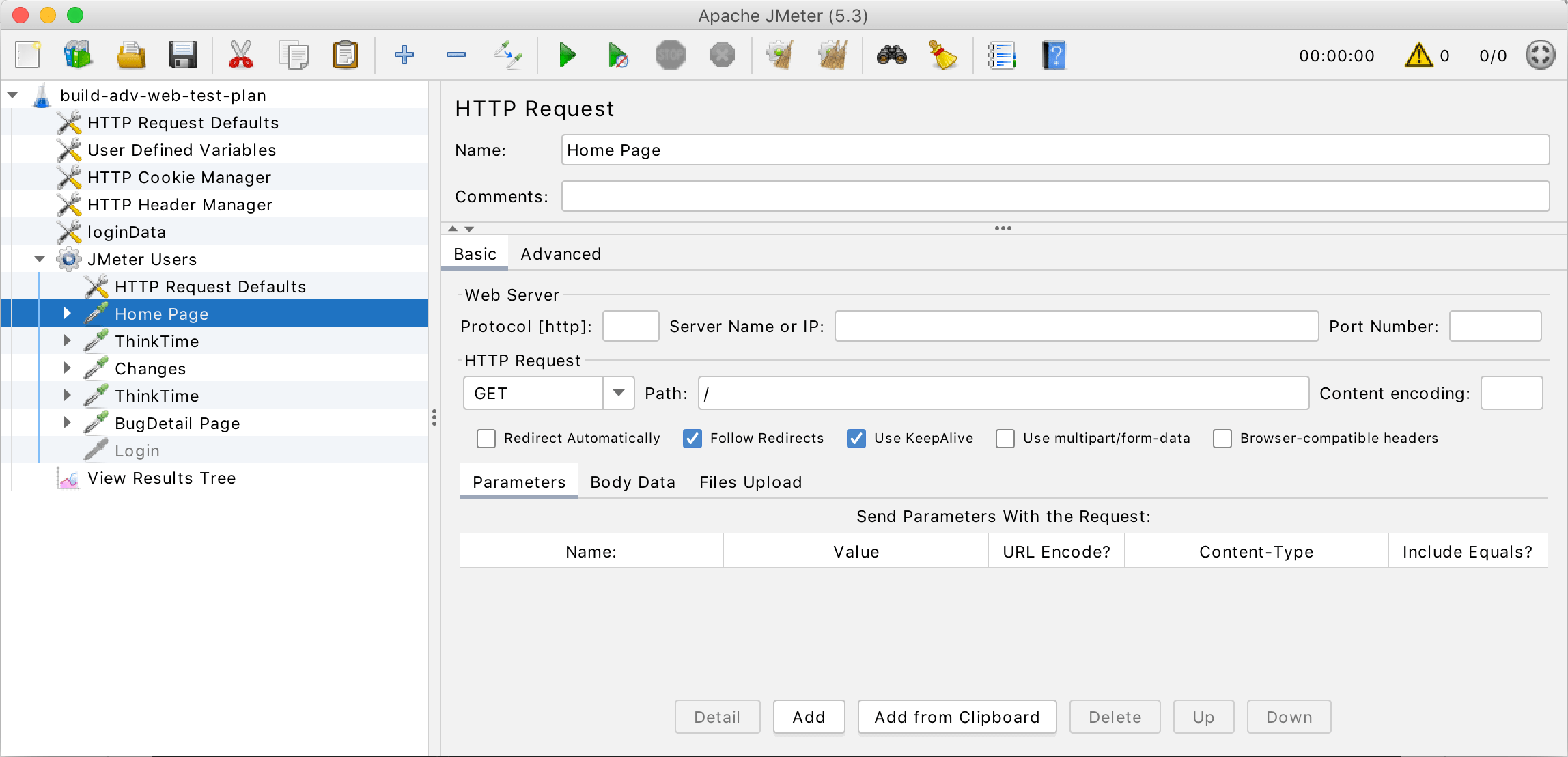

2. Apache JMeter: العملاق مفتوح المصدر لاختبار الأداء

Apache JMeter كان لفترة طويلة عنصرًا أساسيًا في عالم اختبار الأداء، وقدراته في اختبار واجهات برمجة التطبيقات على نطاق واسع ليست استثناء. توفر هذه الأداة القوية مفتوحة المصدر مجموعة واسعة من الميزات التي تجعلها خيارًا ممتازًا للمطورين وفرق ضمان الجودة الذين يتطلعون إلى تقييم أداء واجهات برمجة التطبيقات بشكل شامل تحت ظروف مختلفة.

الاستفادة من JMeter لاختبار أداء واجهات برمجة التطبيقات

تجعل مرونة JMeter وقابليته للتوسع مناسبين بشكل خاص لاختبار أداء واجهات برمجة التطبيقات على نطاق واسع. إليك بعض الجوانب الرئيسية لاستخدام JMeter لهذا الغرض:

- مجموعات الخيوط: محاكاة مستخدمين متعددين يصلون إلى واجهة برمجة التطبيقات الخاصة بك في آن واحد.

- عينات طلب HTTP: إنشاء طلبات إلى نقاط النهاية لواجهة برمجة التطبيقات الخاصة بك مع معلمات قابلة للتخصيص.

- التأكيدات: التحقق من استجابات واجهة برمجة التطبيقات لضمان صحتها تحت الحمل.

- المستمعون: جمع وتصوير نتائج الاختبار في الوقت الحقيقي.

- المكونات الإضافية: توسيع وظائف JMeter مع مجموعة واسعة من المكونات الإضافية.

إعداد اختبار أداء واجهة برمجة التطبيقات في JMeter

لإنشاء اختبار أداء بسيط لواجهة برمجة التطبيقات في JMeter:

- إنشاء مجموعة خيوط لتحديد عدد المستخدمين الافتراضيين.

- إضافة عينة طلب HTTP لنقطة النهاية الخاصة بواجهة برمجة التطبيقات.

- تكوين معلمات الاختبار مثل الرؤوس والجسم والمصادقة.

- إضافة مستمعين لجمع وتحليل النتائج.

- تشغيل الاختبار وتحليل المخرجات.

مثال على هيكل خطة اختبار JMeter:

<?xml version="1.0" encoding="UTF-8"?>

<jmeterTestPlan version="1.2" properties="5.0" jmeter="5.4.1">

<hashTree>

<ThreadGroup guiclass="ThreadGroupGui" testclass="ThreadGroup" testname="اختبار تحميل واجهة برمجة التطبيقات" enabled="true">

<stringProp name="ThreadGroup.num_threads">100</stringProp>

<stringProp name="ThreadGroup.ramp_time">10</stringProp>

<boolProp name="ThreadGroup.scheduler">false</boolProp>

<stringProp name="ThreadGroup.duration"></stringProp>

<stringProp name="ThreadGroup.delay"></stringProp>

</ThreadGroup>

<hashTree>

<HTTPSamplerProxy guiclass="HttpTestSampleGui" testclass="HTTPSamplerProxy" testname="طلب واجهة برمجة التطبيقات" enabled="true">

<stringProp name="HTTPSampler.domain">api.example.com</stringProp>

<stringProp name="HTTPSampler.port">443</stringProp>

<stringProp name="HTTPSampler.protocol">https</stringProp>

<stringProp name="HTTPSampler.path">/users</stringProp>

<stringProp name="HTTPSampler.method">GET</stringProp>

</HTTPSamplerProxy>

<hashTree/>

<ResultCollector guiclass="ViewResultsFullVisualizer" testclass="ResultCollector" testname="عرض نتائج الشجرة" enabled="true"/>

<hashTree/>

</hashTree>

</hashTree>

</jmeterTestPlan>تجعل مجموعة ميزات JMeter القوية والمجتمع النشط منها أداة قوية لاختبار أداء واجهات برمجة التطبيقات على نطاق واسع، مما يسمح للفرق بتحديد ومعالجة مشكلات الأداء قبل أن تؤثر على المستخدمين النهائيين.

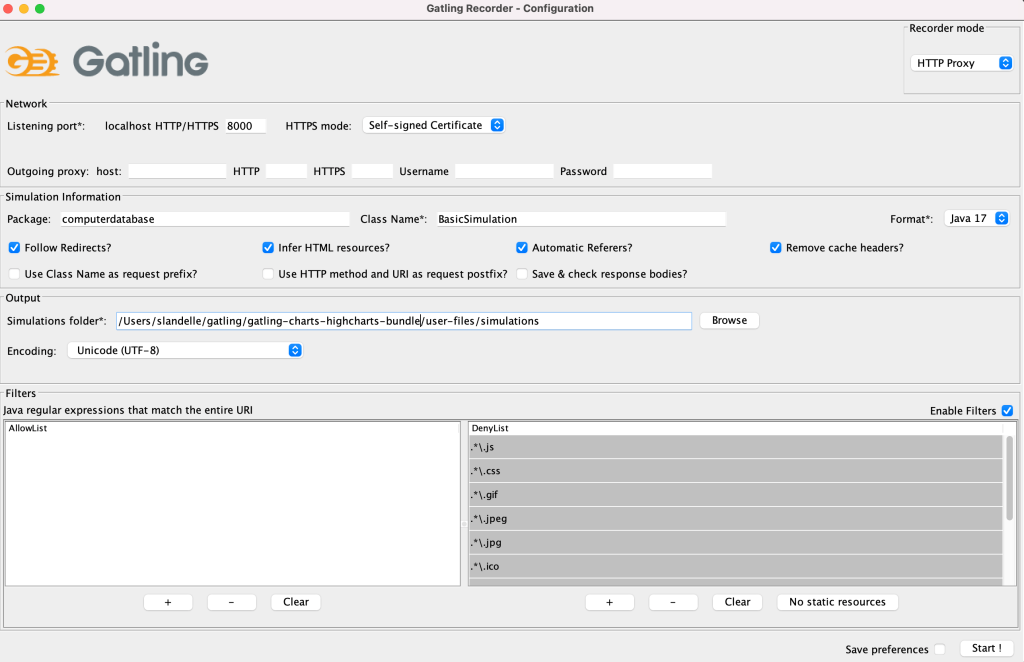

3. Gatling: اختبار تحميل عالي الأداء لواجهات برمجة التطبيقات

Gatling هي أداة حديثة لاختبار التحميل تميزت في اختبار أداء واجهات برمجة التطبيقات على نطاق واسع. تجعل لغتها القائمة على Scala وهندستها المعمارية غير المتزامنة منها مناسبة بشكل خاص لمحاكاة السيناريوهات عالية التداخل، وهو أمر حاسم لاختبار واجهات برمجة التطبيقات تحت ظروف تحميل قصوى.

المزايا الرئيسية لـ Gatling لاختبار أداء واجهات برمجة التطبيقات

- Scala DSL: كتابة سيناريوهات اختبار تعبيرية وقابلة للصيانة باستخدام Scala.

- التصميم غير المتزامن: التعامل بكفاءة مع عدد كبير من الاتصالات المتزامنة.

- مقاييس في الوقت الحقيقي: مراقبة تقدم الاختبار والنتائج في الوقت الحقيقي.

- تقارير مفصلة: إنشاء تقارير HTML شاملة تحتوي على رؤى حول الأداء.

- دمج Jenkins: دمج سهل مع أنظمة CI/CD لاختبارات آلية.

إنشاء اختبار أداء واجهة برمجة التطبيقات باستخدام Gatling

لإعداد اختبار أداء بسيط لواجهة برمجة التطبيقات باستخدام Gatling:

- تعريف فصل المحاكاة الخاص بك الذي يمتد من

Simulation. - إنشاء تكوين بروتوكول HTTP.

- تحديد السيناريو الخاص بك مع طلبات واجهة برمجة التطبيقات وسلوك المستخدم.

- تكوين معلمات محاكاة التحميل.

- تشغيل الاختبار وتحليل النتائج.

مثال على محاكاة Gatling لاختبار واجهة برمجة التطبيقات:

import io.gatling.core.Predef._

import io.gatling.http.Predef._

import scala.concurrent.duration._

class APILoadTest extends Simulation {

val httpProtocol = http

.baseUrl("https://api.example.com")

.acceptHeader("application/json")

val scn = scenario("اختبار واجهة برمجة التطبيقات")

.exec(http("الحصول على المستخدمين")

.get("/users")

.check(status.is(200)))

.pause(1)

setUp(

scn.inject(

rampUsers(1000) during (1 minute)

)

).protocols(httpProtocol)

}تركز Gatling على الأداء العالي وقابلية التوسع، مما يجعلها خيارًا ممتازًا للفرق التي تتطلع إلى دفع واجهات برمجة التطبيقات خاصتها إلى الحدود وضمان قدرتها على معالجة أحمال ضخمة دون المساس بأوقات الاستجابة أو الموثوقية.

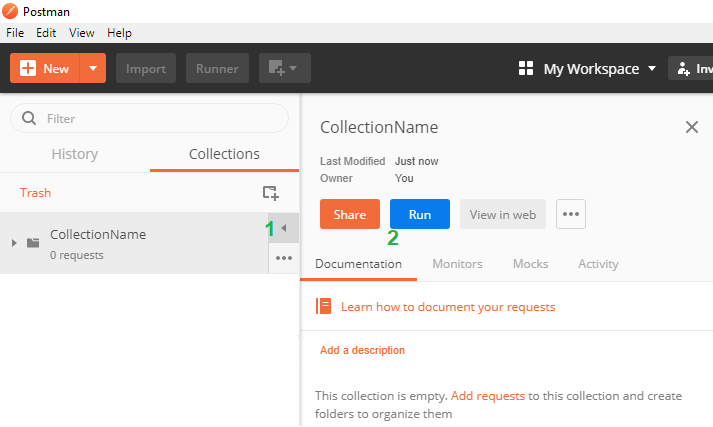

4. Postman: من تطوير واجهات برمجة التطبيقات إلى اختبار الأداء

بينما يُعرف بشكل أساسي كأداة لتطوير واختبار واجهات برمجة التطبيقات، تطورت Postman لتشمل ميزات قوية لاختبار أداء واجهات برمجة التطبيقات على نطاق واسع. تجعل واجهته البديهية ومجموعة ميزاته الواسعة خيارًا جذابًا للفرق التي تتطلع إلى دمج اختبار الأداء بسلاسة في سير العمل الخاص بتطوير واجهات برمجة التطبيقات.

نهج Postman لاختبار أداء واجهات برمجة التطبيقات

توفر Postman العديد من الميزات التي تسهل اختبار أداء واجهات برمجة التطبيقات:

- جهاز تشغيل المجموعة: تنفيذ سلسلة من طلبات واجهة برمجة التطبيقات بالتتابع أو بالتوازي.

- Newman: أداة سطر أوامر لتشغيل مجموعات Postman، مثالية لتكامل CI/CD.

- مراقبون: جدول وتشغيل اختبارات واجهة برمجة التطبيقات في السحابة لمحاكاة حركة المرور العالمية.

- تصورات: إنشاء تصورات مخصصة لنتائج الاختبارات لسهولة التحليل.

إعداد اختبارات الأداء في Postman

لإجراء اختبار أداء باستخدام Postman:

- إنشاء مجموعة من طلبات واجهة برمجة التطبيقات لاختبارها.

- تكوين سكريبتات الاختبار للتحقق من الاستجابات وقياس الأداء.

- استخدام جهاز تشغيل المجموعة لتنفيذ عدة تكرارات من الطلبات.

- تحليل النتائج باستخدام تصورات Postman المدمجة أو تصدير البيانات لمزيد من التحليل.

مثال على سكريبت اختبار Postman لقياس الأداء:

pm.test("وقت الاستجابة مقبول", function () {

pm.expect(pm.response.responseTime).to.be.below(200);

});

pm.test("رمز الحالة هو 200", function () {

pm.response.to.have.status(200);

});

// سجّل وقت الاستجابة للتحليل لاحقًا

console.log("وقت الاستجابة: " + pm.response.responseTime + "ms");بينما قد لا تقدم Postman نفس مستوى القابلية للتوسع كأدوات اختبار التحميل المخصصة، فإن تكاملها مع عملية تطوير واجهة برمجة التطبيقات يجعلها أصلًا قيمًا للفرق التي تتطلع إلى دمج اختبار الأداء مبكرًا في دورة التطوير.

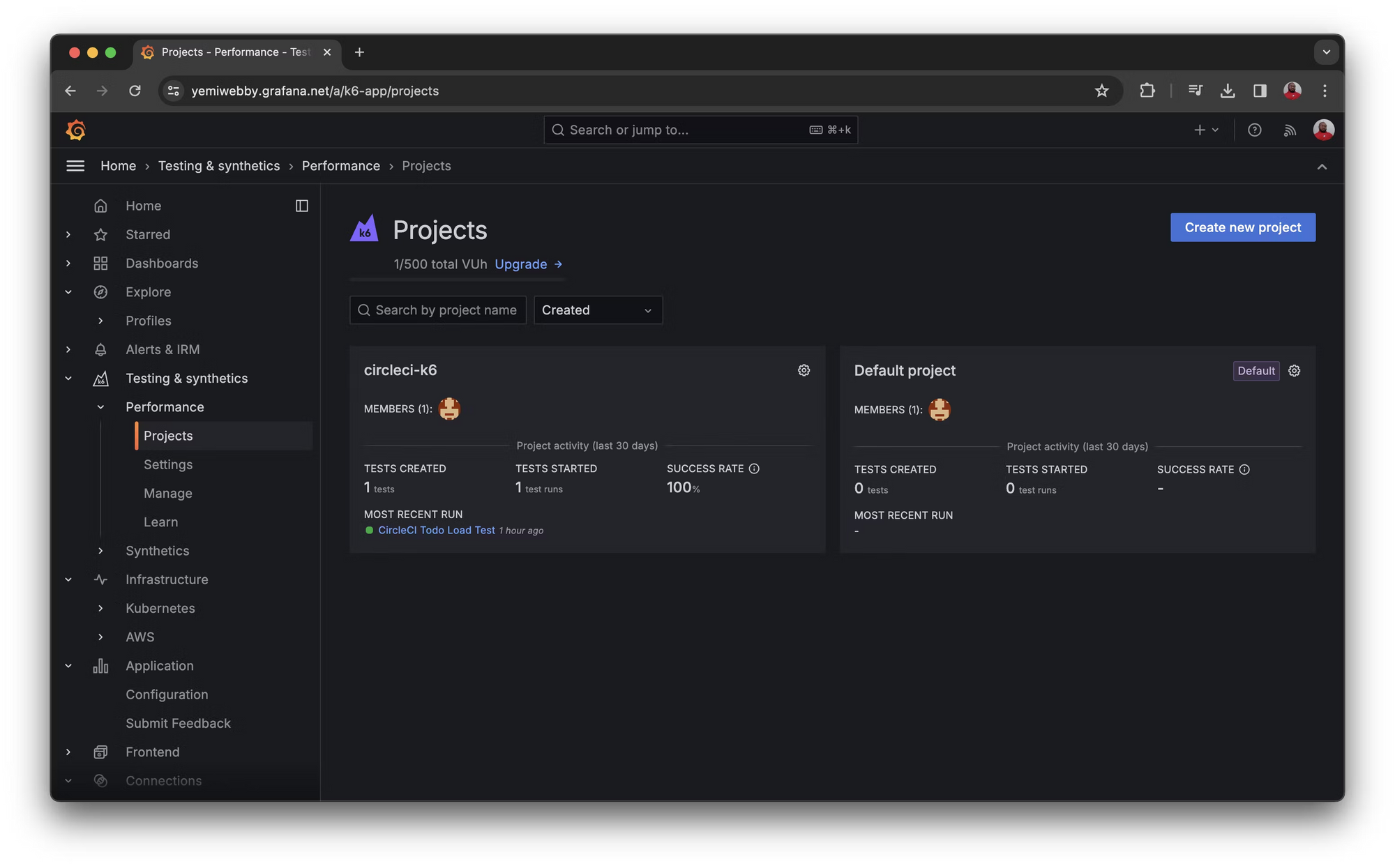

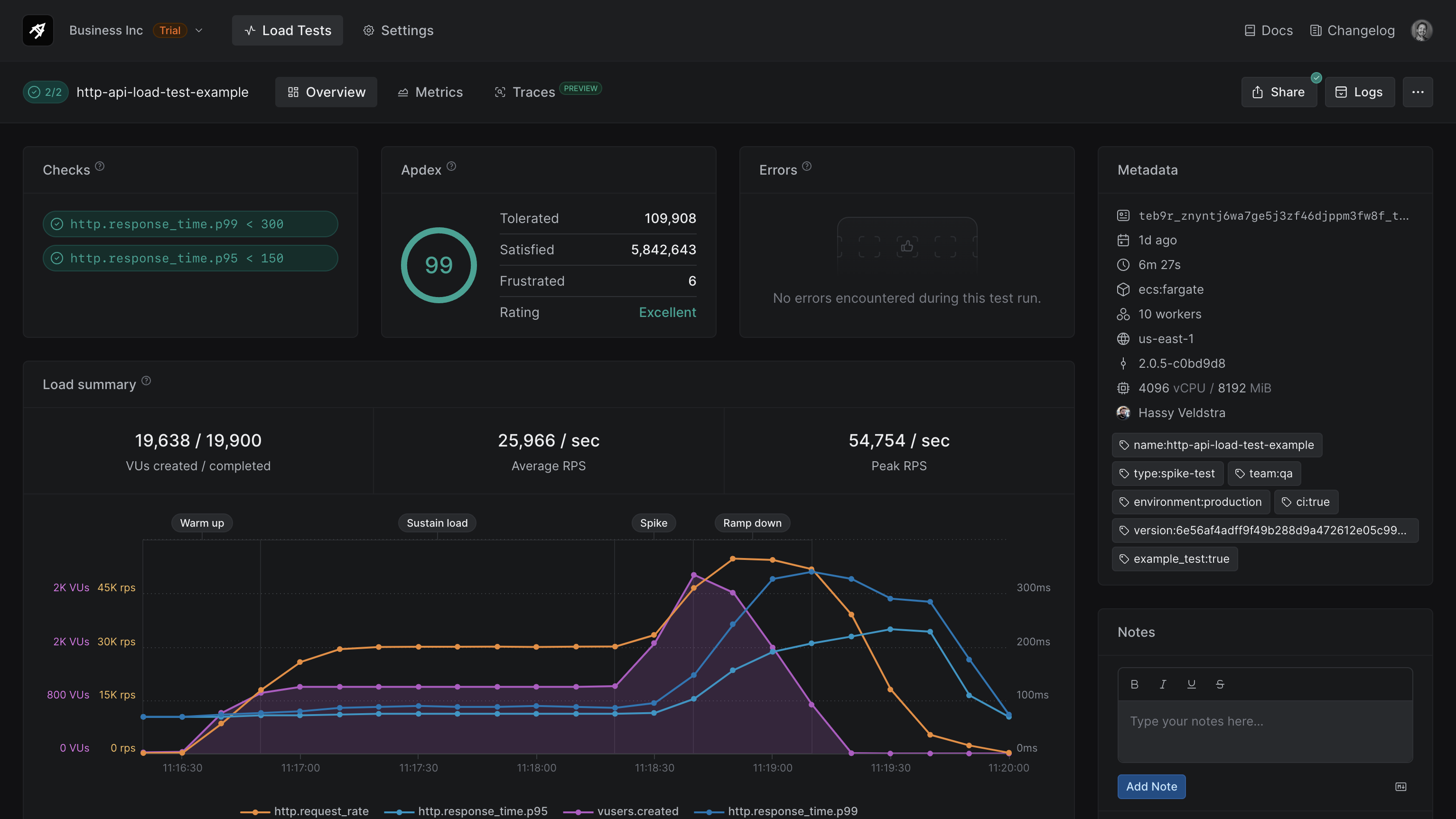

5. K6: اختبار أداء حديث للمطورين

K6 هي أداة حديثة لاختبار التحميل تبرز في اختبار أداء واجهات برمجة التطبيقات على نطاق واسع. تجعل برمجة Javascript والشغف بتجربة المطور منها خيارًا ممتازًا للفرق التي تتطلع إلى دمج اختبار الأداء بسلاسة في سير العمل الخاص بالتطوير.

لماذا تبرز K6 في اختبار أداء واجهات برمجة التطبيقات

- واجهة برمجة التطبيقات بلغة JavaScript: كتابة الاختبارات باستخدام بناء جملة JavaScript المألوف.

- التنفيذ المحلي والسحابي: تشغيل الاختبارات محليًا أو في السحابة لإنشاء تحميل موزع.

- قابلية التوسع: توسيع الوظائف مع مقاييس وإخراج مخصص.

- دمج CI/CD: دمج بسلاسة مع أدوات CI/CD الشائعة.

- دمج Prometheus وGrafana: تصور نتائج الاختبار في الوقت الحقيقي.

إنشاء اختبارات أداء واجهة برمجة التطبيقات باستخدام K6

لإنشاء اختبار أداء لواجهة برمجة التطبيقات الخاصة بك باستخدام K6:

- اكتب سكريبت الاختبار بلغة JavaScript.

- حدد سيناريوهات المستخدم الافتراضية وطلبات واجهة برمجة التطبيقات.

- قم بتعيين عتبات الأداء ومدة الاختبار.

- نفذ الاختبار محليًا أو في السحابة.

- حلل النتائج وقم بتحسين واجهة برمجة التطبيقات الخاصة بك بناءً على الرؤى.

مثال على سكريبت K6 لاختبار أداء واجهة برمجة التطبيقات:

import http from 'k6/http';

import { check, sleep } from 'k6';

export let options = {

vus: 100,

duration: '5m',

};

export default function() {

let res = http.get('https://api.example.com/users');

check(res, {

'الحالة هي 200': (r) => r.status === 200,

'وقت الاستجابة < 500ms': (r) => r.timings.duration < 500,

});

sleep(1);

}إن الأسلوب الصديق للمطورين وميزات K6 القوية تجعلها أداة ممتازة للفرق التي تتطلع إلى التحول لليمين في اختبار الأداء، مما يساعد على اكتشاف ومعالجة مشكلات أداء واجهات برمجة التطبيقات مبكرًا في عملية التطوير.

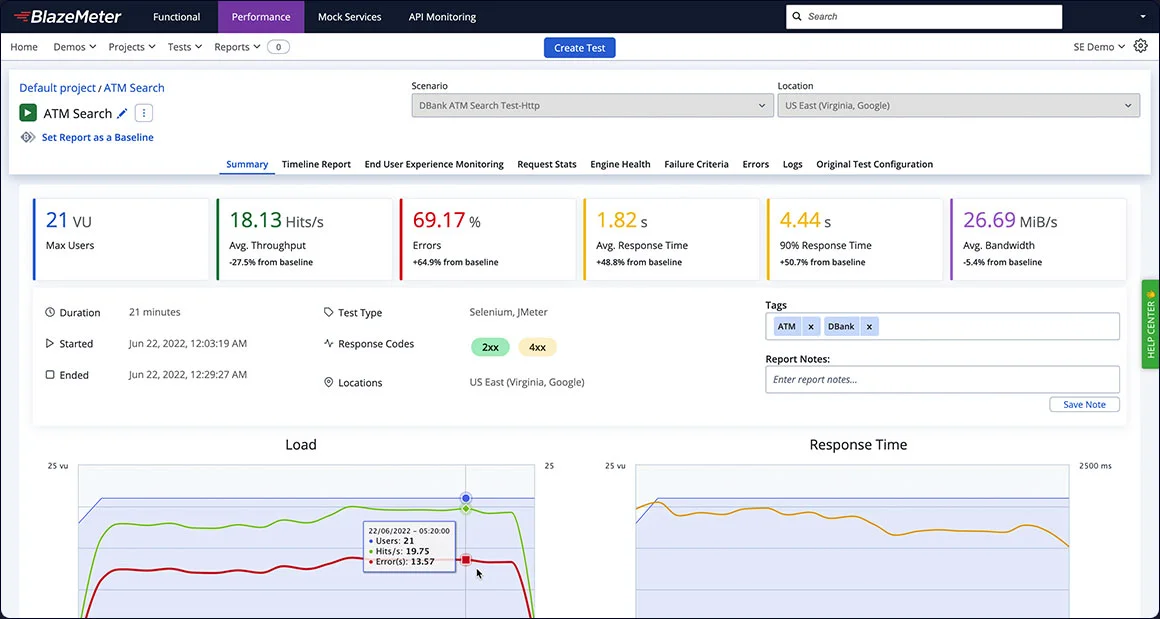

6. BlazeMeter: اختبار أداء قائم على السحابة على نطاق واسع

BlazeMeter تقدم حلًا قويًا قائمًا على السحابة لاختبار أداء واجهات برمجة التطبيقات على نطاق واسع. إن قدرتها على محاكاة أحمال ضخمة من المستخدمين من مواقع جغرافية متعددة تجعلها خيارًا مثاليًا للمنظمات التي تسعى لاختبار أداء واجهات برمجة التطبيقات العالمية تحت ظروف واقعية.

نقاط قوة BlazeMeter في اختبار أداء واجهات برمجة التطبيقات

- قابلية التوسع الضخمة: محاكاة ملايين المستخدمين الافتراضيين من مواقع عالمية مختلفة.

- دعم بروتوكولات متعددة: اختبار RESTful وSOAP وGraphQL وغيرها من أنواع واجهات برمجة التطبيقات.

- تكوين الاختبارات: إنشاء سيناريوهات معقدة تجمع بين أنواع الاختبارات المختلفة.

- تحليلات في الوقت الحقيقي: مراقبة وتحليل نتائج الاختبار أثناء حدوثها.

- قدرات التكامل: دمج بسلاسة مع أدوات CI/CD وحلول APM.

تنفيذ اختبارات أداء واجهة برمجة التطبيقات باستخدام BlazeMeter

لإعداد اختبار أداء واجهة برمجة التطبيقات باستخدام BlazeMeter:

- إنشاء أو استيراد سكريبت الاختبار الخاص بك (يدعم JMeter وGatling وغيرها من التنسيقات).

- تكوين معلمات الاختبار مثل حمل المستخدم ووقت التزايد ومدة الاختبار.

- تحديد المواقع الجغرافية لإنشاء التحميل.

- تنفيذ الاختبار ومراقبة النتائج في الوقت الحقيقي.

- تحليل التقارير الشاملة ومشاركة النتائج مع أصحاب المصلحة.

مثال على تكوين اختبار BlazeMeter (بتنسيق YAML):

execution:

- concurrency: 1000

ramp-up: 5m

hold-for: 30m

scenario: api-test

scenarios:

api-test:

requests:

- url: https://api.example.com/users

method: GET

headers:

Content-Type: application/json

- url: https://api.example.com/orders

method: POST

body: '{"product_id": 123, "quantity": 1}'

reporting:

- module: final-stats

- module: console

إن نهج BlazeMeter القائم على السحابة وميزاته الواسعة تجعلها أداة قوية للمنظمات التي تحتاج إلى إجراء اختبارات أداء واجهات برمجة التطبيقات على نطاق واسع وتوزيع جغرافي بسهولة ومرونة.

7. Apache Benchmark (ab): اختبار أداء خفيف على سطر الأوامر

Apache Benchmark (ab) هي أداة بسيطة ولكن فعالة لاختبار أداء خوادم HTTP، بما في ذلك واجهات برمجة التطبيقات. على الرغم من أنها قد لا توفر الميزات المتقدمة لبعض الأدوات الأخرى في هذه القائمة، إلا أن بساطتها وسهولة استخدامها تجعلها خيارًا ممتازًا للتحقق السريع من الأداء والقياسات الأساسية.

مزايا Apache Benchmark لاختبار واجهات برمجة التطبيقات

- البساطة: سهلة الاستخدام مع واجهة أوامر بسيطة.

- استخدام الموارد المنخفض: مثالية لتشغيل الاختبارات على الأنظمة ذات الموارد المحدودة.

- نتائج سريعة: توفر تعليقات سريعة حول أداء واجهات برمجة التطبيقات.

- قابلية التخصيص: تدعم خيارات متنوعة لتكييف الاختبارات مع الاحتياجات المحددة.

- عبر المنصات: متاحة على أنظمة تشغيل متعددة.

تشغيل اختبارات أداء واجهات برمجة التطبيقات باستخدام Apache Benchmark

لإجراء اختبار أداء بسيط لواجهة برمجة التطبيقات باستخدام Apache Benchmark:

- فتح نافذة طرفية أو موجه أوامر.

- استخدام الأمر

abمع الخيارات المناسبة لتحديد معلمات الاختبار. - تحليل المخرجات للحصول على مقاييس الأداء الرئيسية.

مثال على أمر Apache Benchmark لاختبار واجهة برمجة التطبيقات:

ab -n 10000 -c 100 -H "Accept: application/json" https://api.example.com/usersهذا الأمر يرسل 10000 طلب مع 100 مستخدم متزامن إلى نقطة النهاية المحددة لواجهة برمجة التطبيقات. إن بساطة Apache Benchmark تجعلها أداة ممتازة للمطورين الذين يحتاجون إلى تقييم أداء واجهات برمجة التطبيقات بسرعة أو إنشاء معيار قبل الانتقال إلى سيناريوهات اختبار أكثر تعقيدًا.

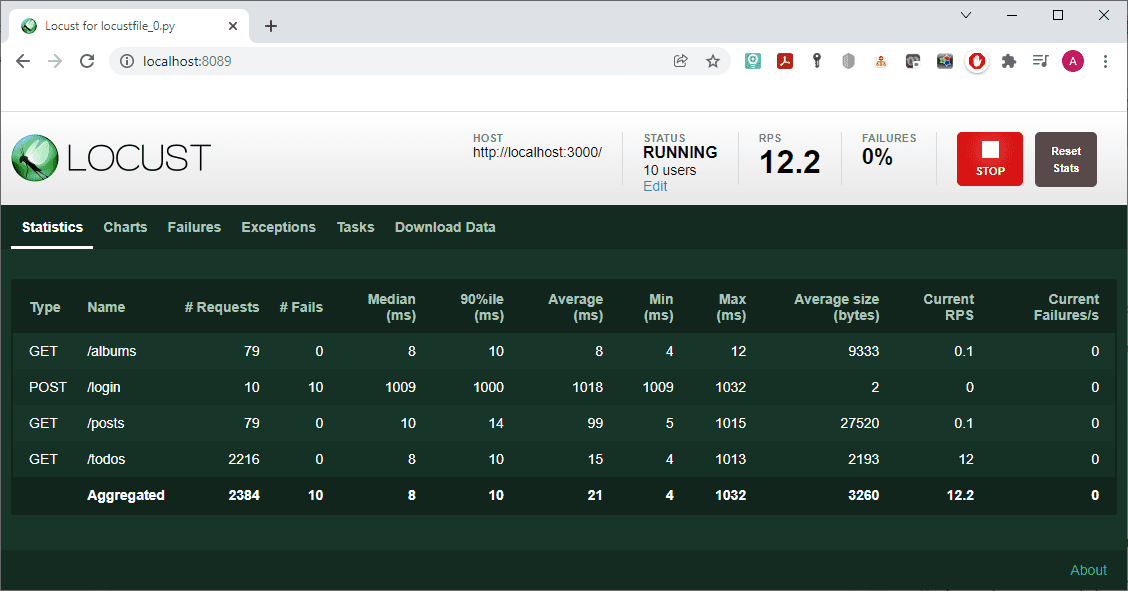

8. Locust: اختبار أداء مدعوم بـ Python لواجهات برمجة التطبيقات

Locust هي أداة اختبار تحميل مفتوحة المصدر تسمح للمطورين بكتابة اختبارات الأداء باستخدام Python. تجعل طريقة استخدامها الودية وميزاتها القوية منها خيارًا ممتازًا للفرق التي ترغب في إنشاء اختبارات أداء معقدة لواجهات برمجة التطبيقات مع مرونة لغة برمجة كاملة.

الميزات الرئيسية لـ Locust لاختبار أداء واجهات برمجة التطبيقات

- مبني على Python: كتابة الاختبارات باستخدام بناء جملة Python المألوف.

- اختبار موزع: توسيع الاختبارات عبر عدة آلات لزيادة الحمل.

- واجهة ويب حية في الوقت الحقيقي: مراقبة تقدم الاختبار والنتائج في واجهة بسيطة للمستخدم.

- تقارير قابلة للتخصيص: إنشاء تقارير تفصيلية وتصدير البيانات للتحليل.

- قابلية التوسع: توسيع الوظائف بسهولة باستخدام وحدات ومكتبات Python.

إنشاء اختبارات أداء واجهة برمجة التطبيقات باستخدام Locust

لإعداد اختبار أداء واجهة برمجة التطبيقات باستخدام Locust:

- اكتب سكريبت Python يحدد سلوك المستخدم وطلبات واجهة برمجة التطبيقات.

- تكوين معلمات الاختبار مثل عدد المستخدمين ومعدل التزايد.

- تشغيل الأمر Locust لبدء الاختبار.

- راقب النتائج في الوقت الحقيقي من خلال واجهة الويب.

- حلل التقارير الناتجة لتحديد مشكلات الأداء.

مثال على سكريبت Locust لاختبار واجهة برمجة التطبيقات:

from locust import HttpUser, task, between

class APIUser(HttpUser):

wait_time = between(1, 5)

@task

def get_users(self):

self.client.get("/users")

@task

def create_order(self):

self.client.post("/orders", json={"product_id": 123, "quantity": 1})

def on_start(self):

self.client.post("/login", json={"username": "test", "password": "password"})يمكن أن تتيح نهج Locust القائم على Python إنشاء سيناريوهات اختبار معقدة وقابلة للتخصيص، مما يجعلها اختيارًا ممتازًا للفرق التي تتمتع بخبرة في Python والتي بحاجة لاختبار واجهات برمجة التطبيقات في ظروف واقعية ومتنوعة.

9. Artillery: اختبار أداء سحابي لواجهات برمجة التطبيقات

Artillery هي مجموعة أدوات حديثة وقوية ومتاحة للمطورين مصممة خصيصًا لاختبار واجهات برمجة التطبيقات والخدمات الدقيقة والمواقع الإلكترونية. إن نهجها القائم على السحابة وقابليتها للتوسع تجعلها خيارًا ممتازًا للفرق التي تعمل في أنظمة موزعة وتتطلع لدمج اختبار الأداء في أنظمة CI/CD الخاصة بها.

نقاط قوة Artillery في اختبار أداء واجهات برمجة التطبيقات

- تكوين YAML: سيناريوهات اختبار سهلة القراءة باستخدام بناء جملة YAML.

- بيئة مكونات إضافية: توسيع الوظائف مع مكونات إضافية مختلفة للبروتوكولات والتكاملات المختلفة.

- مقاييس قابلة للتخصيص: تعريف وتتبع مقاييس مخصصة ذات صلة بواجهة برمجة التطبيقات الخاصة بك.

- سيناريوهات قابلة للبرمجة: استخدام JavaScript لإنشاء سيناريوهات اختبار ديناميكية ومعقدة.

- دمج السحابة: تشغيل الاختبارات بسلاسة على AWS أو Azure أو GCP.

تنفيذ اختبارات أداء واجهة برمجة التطبيقات باستخدام Artillery

لإنشاء اختبار أداء لواجهة برمجة التطبيقات باستخدام Artillery:

- حدد سيناريو الاختبار الخاص بك في ملف YAML.

- تحديد نقاط النهاية ومعدلات الطلب ومدة الاختبار.

- إضافة وظائف مخصصة أو مكونات إضافية إذا لزم الأمر.

- تشغيل الاختبار باستخدام واجهة سطر أوامر Artillery.

- تحليل التقرير الناتج للحصول على رؤى الأداء.

مثال على تكوين اختبار Artillery:

config:

target: "https://api.example.com"

phases:

- duration: 60

arrivalRate: 5

rampTo: 50

defaults:

headers:

Content-Type: "application/json"

scenarios:

- name: "اختبار واجهة برمجة التطبيقات"

flow:

- get:

url: "/users"

- think: 1

- post:

url: "/orders"

json:

productId: 123

quantity: 1إن تركيز Artillery على الاختبار السحابي وخيارات التكوين المرنة تجعلها أداة مثالية للفرق الحديثة التي تعمل بأنظمة موزعة وهياكل الخدمات الدقيقة.

10. Vegeta: أداة ومكتبة اختبار تحميل HTTP

Vegeta هي أداة ومكتبة اختبار تحميل HTTP متعددة الاستخدامات، معروفة ببساطتها وواجهة سطر الأوامر القوية. إنها مناسبة بشكل خاص لاختبار أداء واجهات برمجة التطبيقات نظرًا لقدرتها على الحفاظ على معدل طلب ثابت، وهو أمر حاسم لمحاكاة أنماط الحركة الحقيقية لواجهات برمجة التطبيقات بدقة.

مزايا Vegeta لاختبار أداء واجهات برمجة التطبيقات

- تحميل بمعدل ثابت: محاكاة حركة المرور API بشكل دقيق.

- تنسيقات الإدخال المرنة: دعم لأساليب الإدخال المختلفة بما في ذلك ملف طلبات HTTP.

- مقاييس تفصيلية: توفير إحصائيات شاملة حول الكمون وسرعة النقل وأكواد الحالة.

- قدرات الرسم البياني: إنشاء الرسوم البيانية للتحليل البصري لنتائج الاختبار.

- وضع المكتبة: يمكن استخدامه كمكتبة Go لتنفيذ الاختبارات المخصصة.

إجراء اختبارات أداء واجهة برمجة التطبيقات باستخدام Vegeta

لإجراء اختبار أداء واجهة برمجة التطبيقات باستخدام Vegeta:

- إنشاء ملف أهداف أو استخدام سطر الأوامر لتحديد نقاط النهاية لواجهة برمجة التطبيقات.

- تحديد معدل الطلب المطلوب والمدة.

- تشغيل الاختبار باستخدام واجهة سطر أوامر Vegeta.

- تحليل النتائج باستخدام تقارير Vegeta وأوامر الرسم.

مثال على أمر Vegeta لاختبار واجهة برمجة التطبيقات:

echo "GET https://api.example.com/users" | vegeta attack -rate=50 -duration=30s | vegeta reportهذا الأمر يرسل 50 طلبًا في الثانية لمدة 30 ثانية إلى نقطة النهاية المحددة لواجهة برمجة التطبيقات وينتج تقريرًا. إن تركيز Vegeta على الحفاظ على معدل طلب ثابت وتقاريرها المفصلة يجعلها اختيارًا ممتازًا للفرق التي تسعى لإجراء اختبارات أداء واجهات برمجة التطبيقات بدقة وقابلية التكرار.

الخاتمة: اختيار الأدوات الصحيحة لاختبار أداء واجهات برمجة التطبيقات على نطاق واسع

بينما استكشفنا أفضل 10 تقنيات وأدوات لاختبار أداء واجهات برمجة التطبيقات على نطاق واسع، من الواضح أن كل خيار يقدم نقاط قوة وقدرات فريدة. وغالبًا ما يعتمد اختيار الأداة على متطلبات المشروع المحددة، وخبرة الفريق، وطبيعة واجهات برمجة التطبيقات التي يتم اختبارها.

النقاط الرئيسية التي يجب مراعاتها عند اختيار أدوات اختبار أداء واجهات برمجة التطبيقات

- قابلية التوسع: تأكد من أن الأداة يمكنها توليد الحمل المطلوب لاختبار واجهة برمجة التطبيقات على نطاق واسع.

- سهولة الاستخدام: ضع في اعتبارك منحنى التعلم ومدى توافقه مع مهارات فريقك.

- التكامل: ابحث عن أدوات تتكامل بشكل جيد مع عمليات التطوير الحالية وعمليات CI/CD.

- التقارير: قيّم عمق ووضوح تقارير الأداء والتحليلات.

- التكلفة: احسب كل من التكلفة المالية والاستثمار الزمني المطلوب لتنفيذ وصيانة حل الاختبار.

مستقبل اختبار أداء واجهات برمجة التطبيقات

بينما تستمر واجهات برمجة التطبيقات في لعب دور حاسم في بنية البرمجيات الحديثة، ستزداد أهمية اختبار الأداء على نطاق واسع فقط. من المحتمل أن تتشكل الاتجاهات الناشئة مثل توليد الاختبارات بمساعدة الذكاء الاصطناعي، والمراقبة في الوقت الحقيقي للأداء، والتكامل مع منصات المراقبة مستقبل أدوات اختبار أداء واجهات برمجة التطبيقات. من خلال الاستفادة من هذه الأدوات والتقنيات القوية، يمكن لفرق التطوير ضمان أن تكون واجهات برمجة التطبيقات قوية وقابلة للتوسع وقادرة على تقديم أداء استثنائي حتى تحت أكثر الظروف تطلبًا. تذكر أن اختبار أداء واجهات برمجة التطبيقات الفعال ليس نشاطًا لمرة واحدة، بل هو عملية مستمرة من التحسين والتطوير، وهو أمر بالغ الأهمية للحفاظ على جودة وموثوقية خدماتك الرقمية.