Vercel đã bước chân vào lĩnh vực AI với API v0 của mình, nổi bật với mô hình v0-1.0-md. API này được thiết kế để trao quyền cho các nhà phát triển trong việc tạo ra các ứng dụng web hiện đại, cung cấp một bộ tính năng được thiết kế cho tốc độ, hiệu quả và dễ dàng tích hợp. Bài viết này cung cấp một cái nhìn tổng quan toàn diện về API Vercel v0-1.0-md, bao gồm các tính năng, giá cả và cách bắt đầu, cùng với cách tận dụng nó với các công cụ phát triển API như APIdog.

Bạn muốn một nền tảng tích hợp, Tất cả trong Một để Nhóm phát triển của bạn làm việc cùng nhau với năng suất tối đa?

Apidog đáp ứng mọi nhu cầu của bạn và thay thế Postman với mức giá phải chăng hơn nhiều!

Các tính năng của API Vercel v0-1.0-md

Mô hình v0-1.0-md là trung tâm của API v0, mang đến một bộ khả năng mạnh mẽ được thiết kế riêng cho các thách thức phát triển web đương đại.

Hoàn thành nhận biết Framework: Một trong những tính năng nổi bật là khả năng nhận biết các ngăn xếp phát triển web hiện đại. Mô hình đã được đánh giá và tối ưu hóa cho các framework phổ biến như Next.js và, đương nhiên, nền tảng của chính Vercel. Điều này có nghĩa là các nhà phát triển có thể mong đợi các đề xuất và hoàn thành mã liên quan và chính xác theo ngữ cảnh hơn khi làm việc trong các hệ sinh thái này.

Khả năng tự sửa lỗi: Viết mã hoàn hảo ngay từ lần thử đầu tiên là điều hiếm thấy. Mô hình v0-1.0-md hỗ trợ điều này bằng cách xác định và tự động sửa các vấn đề mã hóa phổ biến trong quá trình tạo. Điều này có thể giảm đáng kể thời gian gỡ lỗi và cải thiện chất lượng mã tổng thể.

Chức năng chỉnh sửa nhanh: Tốc độ là một chủ đề lặp đi lặp lại với API v0. Tính năng chỉnh sửa nhanh truyền trực tiếp các chỉnh sửa nội tuyến khi chúng có sẵn. Vòng phản hồi thời gian thực này cho phép các nhà phát triển xem các thay đổi ngay lập tức, thúc đẩy trải nghiệm phát triển năng động và tương tác hơn.

Khả năng tương thích với OpenAI: Nhận thấy sự phổ biến rộng rãi của các tiêu chuẩn API của OpenAI, Vercel đã đảm bảo rằng mô hình v0-1.0-md tương thích với định dạng API OpenAI Chat Completions. Đây là một lợi thế đáng kể, vì nó cho phép các nhà phát triển sử dụng API v0 với bất kỳ công cụ, SDK hoặc thư viện hiện có nào đã hỗ trợ cấu trúc của OpenAI. Khả năng tương tác này làm giảm rào cản gia nhập và cho phép tích hợp dễ dàng hơn vào các quy trình làm việc hiện có.

Đầu vào đa phương thức: API không giới hạn ở các tương tác dựa trên văn bản. Nó hỗ trợ đầu vào đa phương thức, nghĩa là nó có thể xử lý cả dữ liệu văn bản và hình ảnh. Hình ảnh cần được cung cấp dưới dạng dữ liệu được mã hóa base64. Điều này mở ra nhiều khả năng cho các ứng dụng yêu cầu hiểu hoặc tạo nội dung dựa trên thông tin hình ảnh cùng với lời nhắc văn bản.

Gọi hàm/công cụ: Các ứng dụng AI hiện đại thường yêu cầu tương tác với các hệ thống bên ngoài hoặc thực thi các chức năng cụ thể. Mô hình v0-1.0-md hỗ trợ gọi hàm và công cụ, cho phép các nhà phát triển xác định các công cụ tùy chỉnh mà AI có thể gọi. Điều này mở rộng khả năng của mô hình vượt ra ngoài việc tạo văn bản đơn giản, cho phép nó thực hiện các hành động, truy xuất dữ liệu từ các API khác hoặc tương tác với các dịch vụ khác như một phần của quá trình tạo phản hồi.

Phản hồi truyền trực tuyến độ trễ thấp: Đối với các ứng dụng yêu cầu tương tác thời gian thực, chẳng hạn như chatbot hoặc trợ lý viết mã trực tiếp, độ trễ là yếu tố quan trọng. API v0 được thiết kế để cung cấp các phản hồi truyền trực tuyến nhanh chóng. Điều này có nghĩa là thay vì chờ toàn bộ phản hồi được tạo, dữ liệu được gửi theo từng phần khi có sẵn, dẫn đến trải nghiệm người dùng phản hồi nhanh hơn và hấp dẫn hơn nhiều.

Tối ưu hóa cho Phát triển Web: Mô hình được tối ưu hóa đặc biệt cho các tác vụ phát triển web frontend và full-stack. Sự tập trung này đảm bảo rằng quá trình đào tạo và khả năng của nó phù hợp với các thách thức và yêu cầu phổ biến khi xây dựng các ứng dụng web hiện đại, từ tạo các thành phần giao diện người dùng đến viết logic phía máy chủ.

Các nhà phát triển có thể thử nghiệm với mô hình v0-1.0-md trực tiếp trong AI Playground do Vercel cung cấp. Điều này cho phép kiểm tra các lời nhắc khác nhau, quan sát phản hồi của mô hình và cảm nhận khả năng của nó trước khi tích hợp vào một dự án.

Giá cả và Quyền truy cập API Vercel v0

Quyền truy cập vào API Vercel v0, và do đó là mô hình v0-1.0-md, hiện đang ở giai đoạn beta. Để sử dụng API, người dùng cần phải có gói Premium hoặc Team với tính năng thanh toán dựa trên mức sử dụng được bật. Thông tin chi tiết về cấu trúc giá thường có thể được tìm thấy trên trang giá chính thức của Vercel. Giống như nhiều chương trình beta, nên kiểm tra các điều khoản và điều kiện mới nhất trực tiếp từ Vercel.

Để bắt đầu sử dụng API, bước đầu tiên là tạo khóa API trên v0.dev. Khóa này sẽ được sử dụng để xác thực các yêu cầu đến API.

Giới hạn sử dụng

Giống như hầu hết các dịch vụ API, API Vercel v0 có các giới hạn sử dụng được áp dụng để đảm bảo sử dụng công bằng và duy trì sự ổn định của dịch vụ. Các giới hạn hiện được ghi nhận cho mô hình v0-1.0-md là:

- Số tin nhắn tối đa mỗi ngày: 200

- Kích thước cửa sổ ngữ cảnh tối đa: 128.000 token

- Kích thước ngữ cảnh đầu ra tối đa: 32.000 token

Các giới hạn này có thể thay đổi, đặc biệt khi API thoát khỏi giai đoạn beta. Đối với người dùng hoặc ứng dụng yêu cầu giới hạn cao hơn, Vercel cung cấp điểm liên hệ (support@v0.dev) để thảo luận về khả năng tăng giới hạn. Cũng cần lưu ý rằng bằng cách sử dụng API, các nhà phát triển đồng ý với Điều khoản API của Vercel.

Cách sử dụng API Vercel v0

Việc tích hợp API Vercel v0 vào một dự án được thiết kế đơn giản, đặc biệt đối với các nhà phát triển quen thuộc với định dạng API OpenAI hoặc sử dụng hệ sinh thái của Vercel.

Tích hợp với AI SDK: Vercel khuyến nghị sử dụng AI SDK của mình, một thư viện TypeScript được thiết kế đặc biệt để làm việc với <V0Text /> và các mô hình tương thích với OpenAI khác. SDK này đơn giản hóa quá trình thực hiện các lệnh gọi API, xử lý phản hồi và tích hợp khả năng AI vào các ứng dụng.

Để bắt đầu, bạn thường sẽ cài đặt các gói cần thiết:

npm install ai @ai-sdk/openai

Ví dụ sử dụng (JavaScript/TypeScript):

Ví dụ sau đây minh họa cách sử dụng hàm generateText từ AI SDK để tương tác với mô hình v0-1.0-md:

import { generateText } from 'ai';

import { createOpenAI } from '@ai-sdk/openai';

// Configure the Vercel v0 API client

const vercel = createOpenAI({

baseURL: 'https://api.v0.dev/v1', // The v0 API endpoint

apiKey: process.env.VERCEL_V0_API_KEY, // Your Vercel v0 API key

});

async function getAIChatbotResponse() {

try {

const { text } = await generateText({

model: vercel('v0-1.0-md'), // Specify the Vercel model

prompt: 'Create a Next.js AI chatbot with authentication',

});

console.log(text);

return text;

} catch (error) {

console.error("Error generating text:", error);

// Handle the error appropriately

}

}

getAIChatbotResponse();

Trong ví dụ này:

- Chúng ta nhập

generateTexttừ thư việnaivàcreateOpenAItừ@ai-sdk/openai. - Một client tương thích với OpenAI được tạo bằng cách sử dụng

createOpenAI, được cấu hình với URL cơ sở của API v0 (https://api.v0.dev/v1) và khóa API Vercel v0 của bạn (nên được lưu trữ an toàn, ví dụ: dưới dạng biến môi trường). - Hàm

generateTextđược gọi, truyền clientvercelđã cấu hình (chỉ định mô hìnhv0-1.0-md) và lời nhắc mong muốn. - Phản hồi từ API, chứa văn bản được tạo, sau đó có sẵn trong biến

text.

Tham khảo API:

Để tương tác trực tiếp với API, không cần SDK, hoặc để hiểu cơ chế cơ bản, tham khảo API là rất quan trọng.

Điểm cuối (Endpoint): POST https://api.v0.dev/v1/chat/completions

Điểm cuối duy nhất này được sử dụng để tạo phản hồi của mô hình dựa trên lịch sử cuộc trò chuyện.

Tiêu đề (Headers):

Authorization: Bắt buộc. Một mã thông báo Bearer theo định dạngBearer $V0_API_KEY.Content-Type: Bắt buộc. Phải làapplication/json.

Nội dung yêu cầu (Request Body): Nội dung yêu cầu là một đối tượng JSON với các trường chính sau:

model(chuỗi, Bắt buộc): Tên của mô hình. Đối với API này, nó phải là"v0-1.0-md".messages(mảng, Bắt buộc): Một danh sách các đối tượng tin nhắn tạo thành lịch sử cuộc trò chuyện. Mỗi đối tượng tin nhắn phải có:role(chuỗi, Bắt buộc): Xác định người gửi, có thể là"user","assistant", hoặc"system".content(chuỗi hoặc mảng, Bắt buộc): Nội dung tin nhắn thực tế. Đây có thể là một chuỗi đơn giản hoặc một mảng các khối văn bản và hình ảnh cho đầu vào đa phương thức.stream(boolean, Tùy chọn): Nếu đặt làtrue, API sẽ trả về phản hồi dưới dạng luồng Server-Sent Events (SSE). Mặc định làfalse.tools(mảng, Tùy chọn): Định nghĩa về bất kỳ công cụ tùy chỉnh nào (ví dụ: hàm) mà mô hình có thể gọi.tool_choice(chuỗi hoặc đối tượng, Tùy chọn): Chỉ định công cụ nào mô hình nên gọi, nếu có cung cấp công cụ.

Ví dụ yêu cầu (cURL):

Đây là cách bạn có thể thực hiện lệnh gọi API trực tiếp bằng cURL:

curl https://api.v0.dev/v1/chat/completions \

-H "Authorization: Bearer $V0_API_KEY" \

-H "Content-Type: application/json" \

-d '{

"model": "v0-1.0-md",

"messages": [

{ "role": "user", "content": "Create a Next.js AI chatbot" }

]

}'

Ví dụ với truyền trực tuyến (cURL):

Để nhận phản hồi truyền trực tuyến:

curl https://api.v0.dev/v1/chat/completions \

-H "Authorization: Bearer $V0_API_KEY" \

-H "Content-Type: application/json" \

-d '{

"model": "v0-1.0-md",

"stream": true,

"messages": [

{ "role": "user", "content": "Add login to my Next.js app" }

]

}'

Định dạng phản hồi:

Không truyền trực tuyến (stream: false): API trả về một đối tượng JSON duy nhất chứa toàn bộ phản hồi. Đối tượng này bao gồm một id, tên model, loại object (ví dụ: chat.completion), dấu thời gian created và một mảng choices. Mỗi lựa chọn trong mảng chứa message (với role: "assistant" và content của phản hồi) và một finish_reason (ví dụ: "stop").

{

"id": "v0-123",

"model": "v0-1.0-md",

"object": "chat.completion",

"created": 1715620000,

"choices": [

{

"index": 0,

"message": {

"role": "assistant",

"content": "Here's how to add login to your Next.js app..."

},

"finish_reason": "stop"

}

]

}

Truyền trực tuyến (stream: true): Máy chủ gửi một loạt các khối dữ liệu được định dạng dưới dạng Server-Sent Events (SSE). Mỗi sự kiện bắt đầu bằng data: theo sau là một đối tượng JSON đại diện cho một phần delta của phản hồi. Điều này cho phép client xử lý phản hồi một cách tăng dần.

data: {

"id": "v0-123",

"model": "v0-1.0-md",

"object": "chat.completion.chunk",

"choices": [

{

"delta": {

"role": "assistant",

"content": "Here's how"

},

"index": 0,

"finish_reason": null

}

]

}

Một khối cuối cùng thường sẽ có finish_reason khác với null.

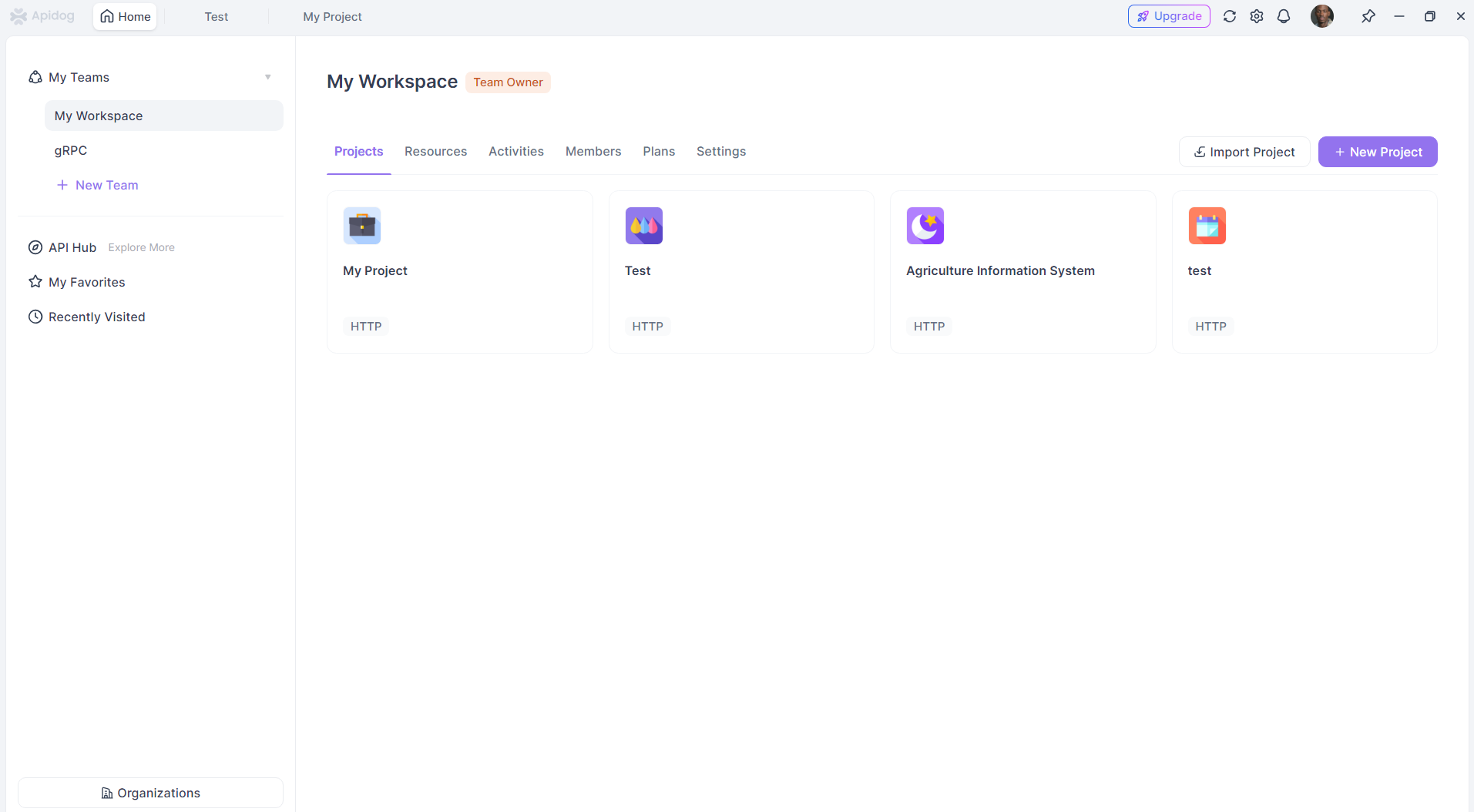

Sử dụng API Vercel v0 với APIdog

APIdog là một nền tảng API toàn diện được thiết kế để thiết kế, phát triển, kiểm thử và tạo tài liệu API. Điểm mạnh của nó nằm ở việc hợp nhất các giai đoạn khác nhau này của vòng đời API. Bạn có thể sử dụng APIdog để tương tác với API Vercel v0, giống như bất kỳ API dựa trên HTTP nào khác.

Dưới đây là cách tiếp cận chung để sử dụng API Vercel v0 với APIdog:

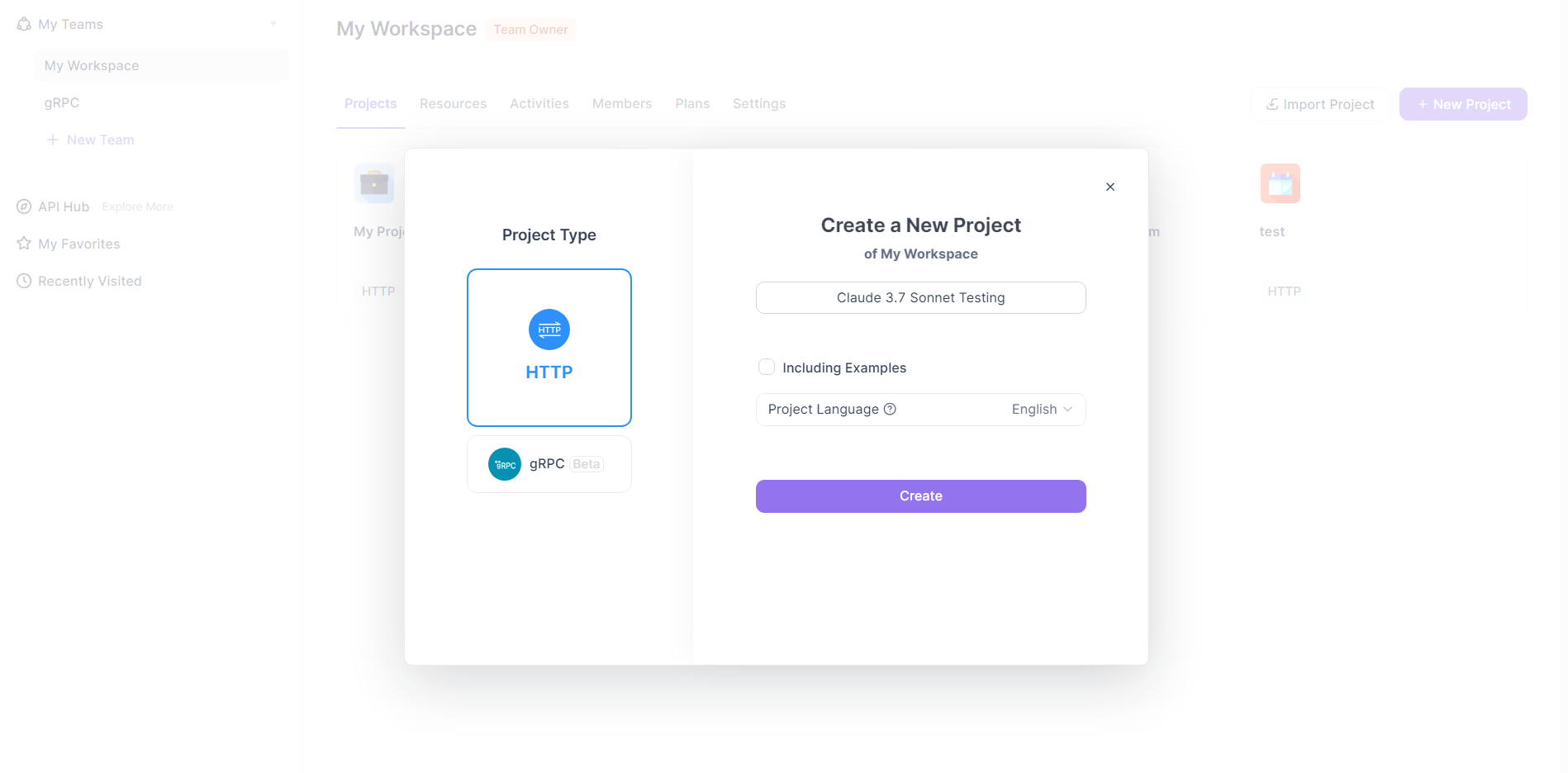

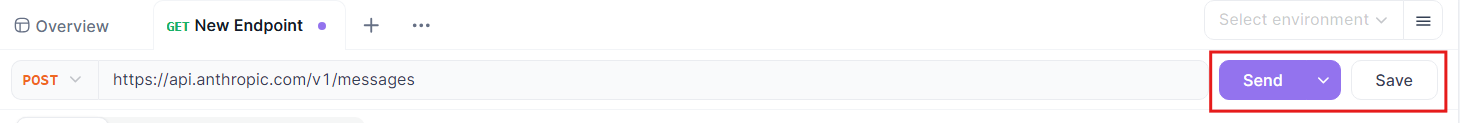

Tạo yêu cầu mới trong APIdog:

- Trong dự án APIdog của bạn, bắt đầu tạo một yêu cầu mới. Điều này thường được thực hiện bằng cách nhấp vào biểu tượng "+" và chọn "New Request" (Yêu cầu mới) hoặc một tùy chọn tương tự.

- APIdog hỗ trợ nhiều loại yêu cầu khác nhau; đối với API Vercel v0, bạn sẽ tạo một yêu cầu HTTP.

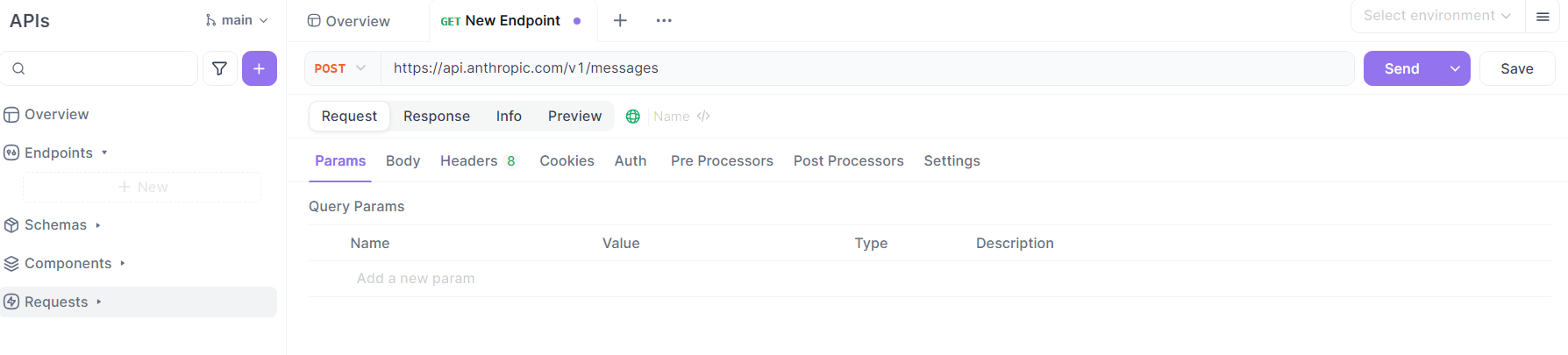

Cấu hình chi tiết yêu cầu:

- Phương thức (Method): Chọn

POSTlàm phương thức HTTP, như được chỉ định trong tài liệu API Vercel v0. - URL: Nhập điểm cuối API Vercel v0:

https://api.v0.dev/v1/chat/completions. - Tiêu đề (Headers):

- Thêm tiêu đề

Authorization. Giá trị phải làBearer YOUR_VERCEL_V0_API_KEY, thay thếYOUR_VERCEL_V0_API_KEYbằng khóa API thực tế bạn nhận được từ v0.dev. - Thêm tiêu đề

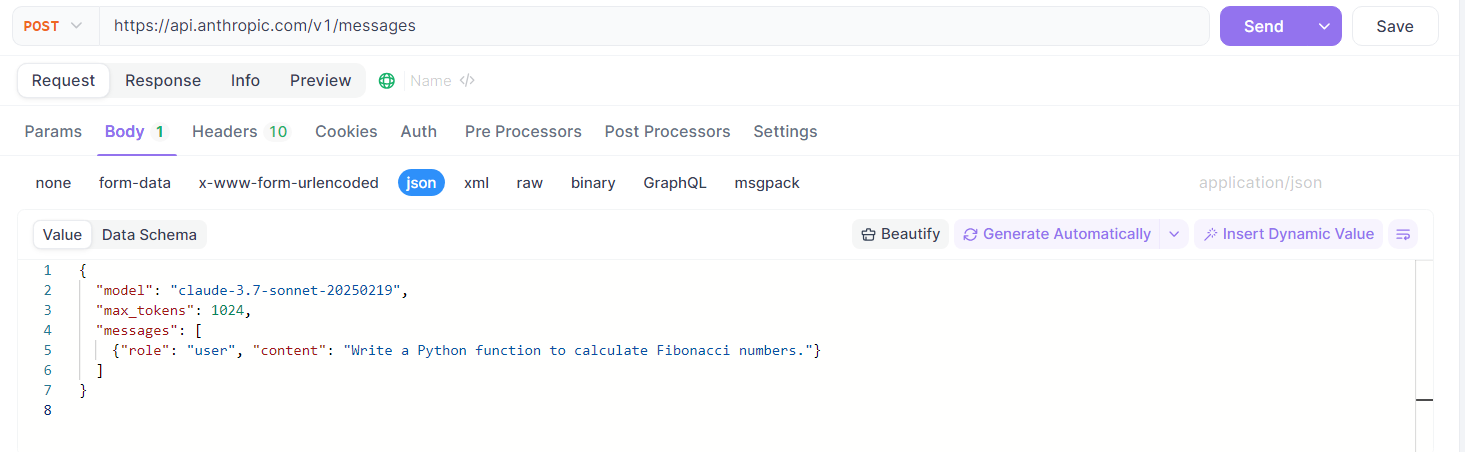

Content-Typevới giá trịapplication/json. - Nội dung (Body):

Chuyển sang tab "Body" trong APIdog và chọn loại đầu vào "raw", sau đó chọn "JSON" làm định dạng.

Xây dựng tải trọng JSON theo thông số kỹ thuật API Vercel v0. Ví dụ:

{

"model": "v0-1.0-md",

"messages": [

{ "role": "user", "content": "Generate a React component for a loading spinner." }

],

"stream": false // or true, depending on your needs

}

Bạn có thể tùy chỉnh mảng messages với lịch sử cuộc trò chuyện và lời nhắc mong muốn của mình. Bạn cũng có thể bao gồm các trường tùy chọn như stream, tools, hoặc tool_choice khi cần.

Gửi yêu cầu:

- Sau khi tất cả các chi tiết đã được cấu hình, nhấp vào nút "Send" (Gửi) trong APIdog.

Xem phản hồi:

- APIdog sẽ hiển thị phản hồi của máy chủ trong bảng phản hồi.

- Nếu

streamlàfalse, bạn sẽ thấy phản hồi JSON hoàn chỉnh. - Nếu

streamlàtrue, cách APIdog xử lý SSE có thể khác nhau. Nó có thể hiển thị các khối khi chúng đến hoặc tích lũy chúng. Tham khảo tài liệu của APIdog để biết chi tiết về cách xử lý phản hồi truyền trực tuyến. Bạn có thể cần sử dụng khả năng scripting của APIdog hoặc các kịch bản kiểm thử để xử lý luồng nâng cao hơn.

Sử dụng các tính năng của APIdog (Tùy chọn):

- Môi trường (Environments): Lưu trữ

V0_API_KEYvà URL cơ sở (https://api.v0.dev) của bạn dưới dạng biến môi trường trong APIdog để quản lý dễ dàng hơn trên các yêu cầu hoặc dự án khác nhau. - Lưu điểm cuối (Endpoint Saving): Lưu yêu cầu đã cấu hình này dưới dạng "Endpoint Case" (Trường hợp điểm cuối) hoặc trong định nghĩa API trong APIdog. Điều này cho phép bạn dễ dàng sử dụng lại và quản lý phiên bản các tương tác của mình với API Vercel v0.

- Kịch bản kiểm thử (Test Scenarios): Nếu bạn cần thực hiện một chuỗi các lệnh gọi hoặc kết hợp API Vercel v0 vào quy trình kiểm thử lớn hơn, hãy tạo Test Scenarios trong APIdog.

- Xác thực tự động (Automated Validation): Nếu bạn định nghĩa thông số kỹ thuật API cho API Vercel v0 trong APIdog (hoặc nhập nếu có), APIdog có thể tự động xác thực phản hồi dựa trên schema này.

Bằng cách làm theo các bước này, bạn có thể sử dụng APIdog một cách hiệu quả như một client để gửi yêu cầu đến API Vercel v0, kiểm tra phản hồi và quản lý các tương tác API của bạn một cách có cấu trúc. Điều này đặc biệt hữu ích cho việc kiểm thử lời nhắc, khám phá các tính năng API và tích hợp nội dung hoặc logic do AI tạo ra vào các ứng dụng trong giai đoạn phát triển và kiểm thử.

Kết luận

API Vercel v0-1.0-md thể hiện một bước tiến đáng kể của Vercel vào lĩnh vực phát triển có sự hỗ trợ của AI. Việc tập trung vào các framework web hiện đại, khả năng tương thích với OpenAI và các tính năng như tự sửa lỗi và đầu vào đa phương thức làm cho nó trở thành một lựa chọn hấp dẫn cho các nhà phát triển muốn xây dựng các ứng dụng web thế hệ tiếp theo. Mặc dù hiện đang ở giai đoạn beta và tuân theo các yêu cầu gói cụ thể, thiết kế của API và AI SDK hỗ trợ cho thấy cam kết cung cấp một công cụ mạnh mẽ nhưng dễ tiếp cận. Dù được sử dụng trực tiếp qua REST API, thông qua AI SDK hay được quản lý bằng các công cụ như APIdog, mô hình v0-1.0-md mang đến một con đường đầy hứa hẹn để tích hợp các khả năng AI nâng cao vào quy trình phát triển web, hợp lý hóa các tác vụ và mở khóa những khả năng sáng tạo mới. Khi API trưởng thành và có khả năng mở rộng các dịch vụ của mình, chắc chắn nó sẽ là một lĩnh vực đáng chú ý đối với các nhà phát triển quan tâm đến việc tận dụng AI trong các dự án của họ.