Giao thức Bối cảnh Mô hình (Model Context Protocol - MCP) là một tiêu chuẩn mở được thiết kế để tạo ra một ngôn ngữ chung giữa các ứng dụng Mô hình ngôn ngữ lớn (Large Language Model - LLM) và các dịch vụ bên ngoài. Nó thiết lập một cách chuẩn hóa để một mô hình AI khám phá và tương tác với các công cụ, truy cập dữ liệu và sử dụng các lời nhắc được xác định trước, bất kể cách mô hình hoặc các dịch vụ bên ngoài được xây dựng.

Về cốt lõi, MCP cho phép một ứng dụng, được gọi là "Máy khách MCP (MCP Client)", kết nối với một hoặc nhiều "Máy chủ MCP (MCP Servers)". Các máy chủ này cung cấp các khả năng mà LLM sau đó có thể sử dụng. Điều này tách rời logic cốt lõi của AI khỏi các triển khai cụ thể của các công cụ mà nó sử dụng, giúp các hệ thống AI trở nên mô-đun hơn, có khả năng mở rộng hơn và tương tác tốt hơn.

Giao thức này định nghĩa một số loại tính năng mà một máy chủ có thể cung cấp. Một máy khách MCP có thể hỗ trợ một số hoặc tất cả các tính năng này, tùy thuộc vào mục đích của nó. Việc hiểu các tính năng này là chìa khóa để nắm bắt những gì một tích hợp MCP cho phép.

| Tính năng | Mô tả |

|---|---|

| Công cụ (Tools) | Các hàm có thể thực thi mà LLM có thể gọi để thực hiện các hành động. |

| Lời nhắc (Prompts) | Các mẫu được xác định trước để cấu trúc các tương tác với LLM. |

| Tài nguyên (Resources) | Dữ liệu và nội dung do máy chủ cung cấp mà LLM có thể đọc. |

| Khám phá (Discovery) | Khả năng được thông báo khi các khả năng của máy chủ thay đổi. |

| Hướng dẫn (Instructions) | Hướng dẫn do máy chủ cung cấp về cách LLM nên hoạt động. |

| Lấy mẫu (Sampling) | Các gợi ý hoàn thành LLM và tham số do máy chủ khởi tạo. |

| Thư mục gốc (Roots) | Định nghĩa ranh giới hệ thống tệp cho các hoạt động của LLM. |

| Gợi mở (Elicitation) | Một cơ chế để máy chủ yêu cầu thông tin từ người dùng. |

| Tác vụ (Tasks) | Một cách để theo dõi trạng thái của các hoạt động dài hạn. |

| Ứng dụng (Apps) | Giao diện HTML tương tác do máy chủ cung cấp. |

Bằng cách hỗ trợ các tính năng này, các ứng dụng khác nhau có thể tận dụng cùng một bộ công cụ và nguồn dữ liệu bên ngoài một cách nhất quán, thúc đẩy một hệ sinh thái phong phú hơn gồm các dịch vụ AI được kết nối với nhau.

Hướng dẫn về các Máy khách MCP

Một Máy khách MCP là bất kỳ ứng dụng nào có thể kết nối với Máy chủ MCP để sử dụng các tính năng mà nó cung cấp. Các máy khách này đóng vai trò là cầu nối giữa người dùng, LLM và thế giới rộng lớn của các khả năng bên ngoài. Chúng có thể bao gồm từ các công cụ dành cho nhà phát triển như trình soạn thảo mã và giao diện dòng lệnh đến các ứng dụng máy tính để bàn thân thiện với người dùng và các nền tảng không mã.

Chức năng chính của một máy khách là quản lý kết nối đến một hoặc nhiều máy chủ MCP và tích hợp các Công cụ (Tools), Lời nhắc (Prompts) và Tài nguyên (Resources) đã khám phá vào trải nghiệm người dùng của chính nó. Ví dụ, một trợ lý lập trình có thể sử dụng MCP để tìm và thực thi một công cụ chạy các bài kiểm tra, trong khi một chatbot có thể sử dụng nó để lấy dữ liệu từ cơ sở tri thức nội bộ của công ty thông qua một Tài nguyên (Resource).

Sự phát triển của hệ sinh thái MCP đã dẫn đến sự ra đời của nhiều loại máy khách đa dạng, mỗi loại được điều chỉnh cho các quy trình làm việc và trường hợp sử dụng khác nhau. Việc khám phá một số máy khách hàng đầu có thể cung cấp cái nhìn rõ ràng hơn về cách giao thức này đang được triển khai trên thực tế để xây dựng các ứng dụng AI mạnh mẽ hơn và nhận biết ngữ cảnh tốt hơn.

10 Máy khách MCP hàng đầu

Các máy khách sau đây thể hiện mức độ phổ biến rộng rãi của MCP, từ các sản phẩm thương mại được sử dụng rộng rãi đến các dự án mã nguồn mở đổi mới. Mỗi loại cung cấp một cách độc đáo để tương tác với hệ sinh thái máy chủ MCP đang phát triển.

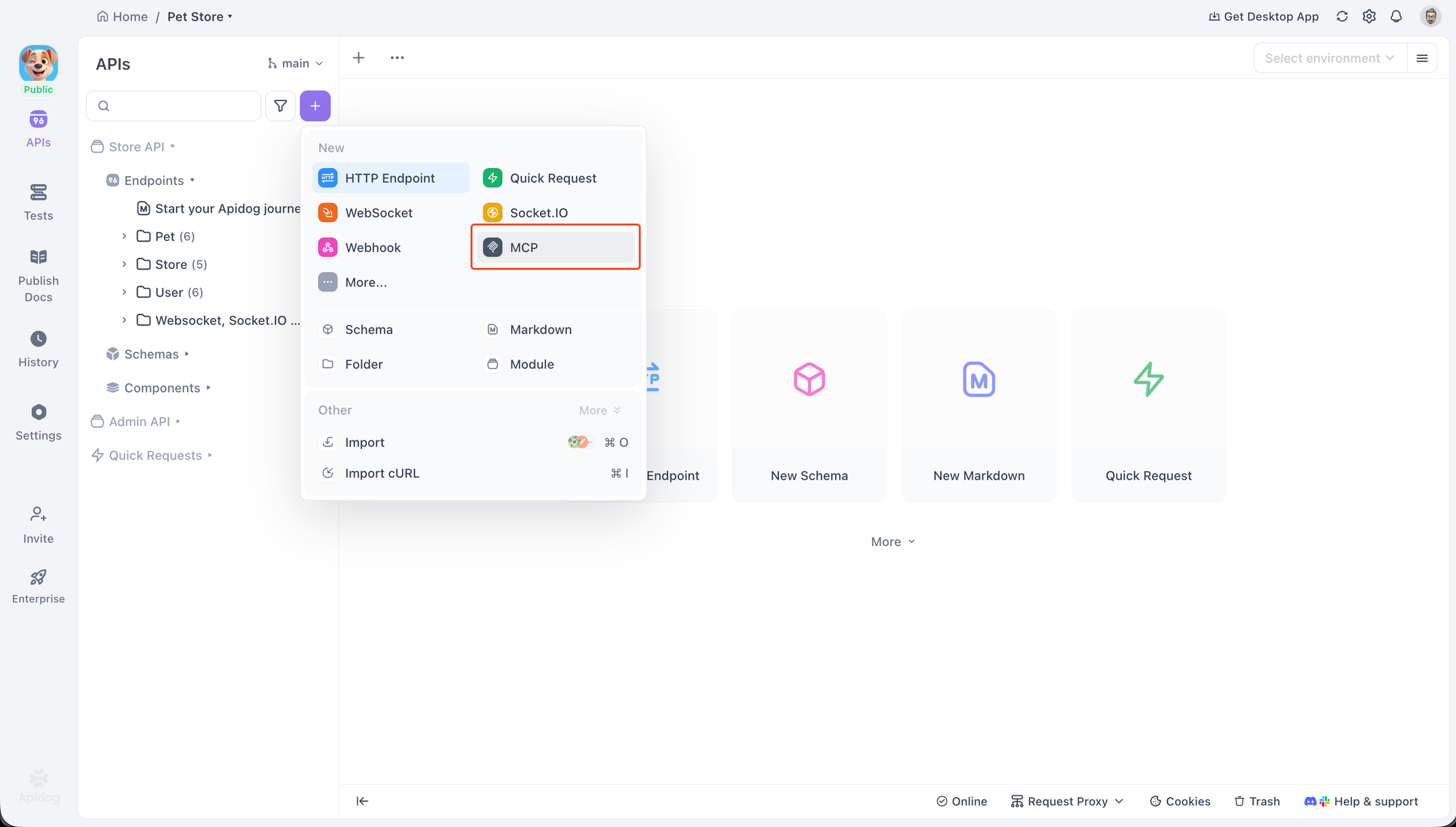

Máy khách MCP của Apidog

Apidog là một nền tảng phát triển API toàn diện bao gồm một Máy khách MCP tích hợp sẵn để gỡ lỗi và kiểm tra các máy chủ MCP. Điều này làm cho nó trở thành một công cụ tuyệt vời cho các nhà phát triển đang xây dựng hoặc tích hợp với MCP, vì nó cung cấp một giao diện chuyên dụng để tương tác với tất cả các tính năng chính của MCP.

Máy khách hỗ trợ hai phương thức vận chuyển chính để kết nối với các máy chủ: STDIO cho các tiến trình cục bộ và HTTP cho các máy chủ từ xa. Sự linh hoạt này cho phép các nhà phát triển kiểm tra nhiều cấu hình máy chủ khác nhau.

Để bắt đầu, một yêu cầu MCP mới có thể được tạo trong một dự án Apidog. Việc kết nối với một máy chủ rất đơn giản. Người dùng chỉ cần dán một lệnh được sử dụng để khởi động một máy chủ cục bộ. Ví dụ, để kết nối với một máy chủ mẫu, bạn có thể sử dụng lệnh như sau:

npx -y @modelcontextprotocol/server-everything

Apidog sẽ nhận ra đây là một lệnh, tự động chọn giao thức STDIO và yêu cầu xác nhận bảo mật trước khi bắt đầu tiến trình cục bộ. Đối với các máy chủ từ xa, việc dán một URL sẽ chuyển giao thức sang HTTP.

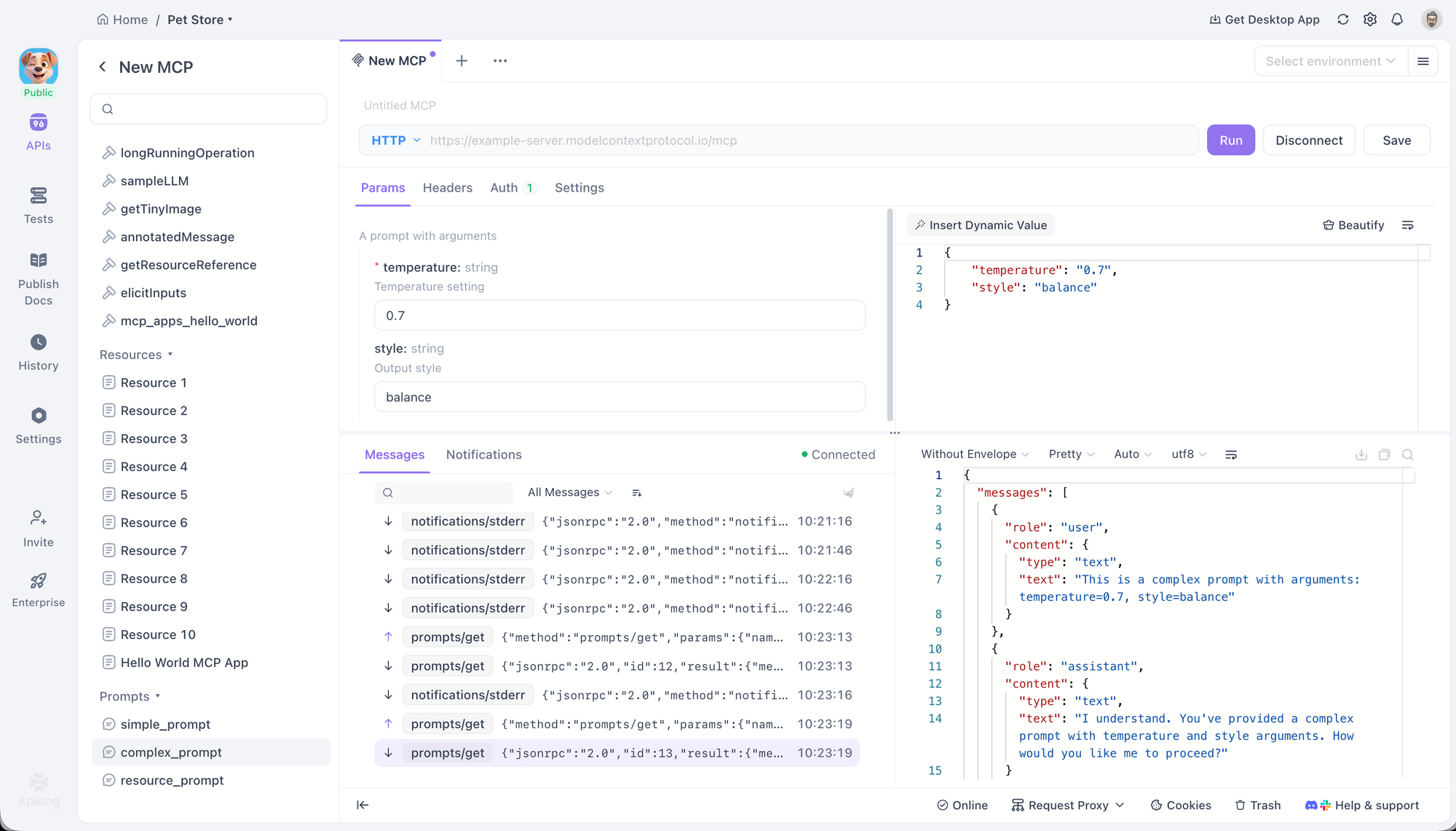

Sau khi kết nối, Apidog hiển thị một cây thư mục của tất cả các Công cụ (Tools), Lời nhắc (Prompts) và Tài nguyên (Resources) do máy chủ cung cấp. Điều này cho phép tương tác trực tiếp và gỡ lỗi. Người dùng có thể chọn một Công cụ (Tool), điền các tham số của nó bằng cách sử dụng một biểu mẫu hoặc trình chỉnh sửa JSON, và thực thi nó để xem phản hồi. Tương tự, Lời nhắc (Prompts) có thể được chạy để xem đầu ra được tạo, và Tài nguyên (Resources) có thể được truy xuất để kiểm tra nội dung của chúng.

Máy khách cũng cung cấp các tùy chọn cấu hình nâng cao. Đối với các kết nối HTTP, nó hỗ trợ nhiều phương thức xác thực khác nhau, bao gồm OAuth 2.0, API Keys và Bearer Tokens, và có thể tự động xử lý luồng OAuth 2.0. Các tiêu đề tùy chỉnh và biến môi trường cũng có thể được thiết lập, với sự hỗ trợ đầy đủ cho hệ thống biến của Apidog.

ChatGPT

Là trợ lý AI hàng đầu của OpenAI, việc tích hợp MCP của ChatGPT là một chỉ số quan trọng cho thấy tầm quan trọng ngày càng tăng của giao thức. Nó hỗ trợ kết nối với các máy chủ MCP từ xa, cho phép nó tận dụng các công cụ bên ngoài để thực hiện nghiên cứu sâu và truy cập các chức năng chuyên biệt.

Việc tích hợp được quản lý thông qua giao diện người dùng kết nối trong cài đặt của ChatGPT. Khi một máy chủ được cấu hình, các công cụ của nó sẽ khả dụng cho mô hình. Điều này cho phép ChatGPT vượt ra ngoài khả năng tích hợp sẵn của nó, sử dụng các công cụ từ các máy chủ đã cấu hình để thực hiện các tác vụ như tìm kiếm cơ sở dữ liệu độc quyền hoặc tương tác với các API của bên thứ ba một cách chuẩn hóa. Hỗ trợ này đặc biệt có giá trị trong môi trường doanh nghiệp nơi bảo mật và tuân thủ là tối quan trọng.

Hệ sinh thái Claude

Anthropic đã tích hợp sâu MCP vào toàn bộ bộ sản phẩm của mình, bao gồm trợ lý web claude.ai, Ứng dụng máy tính để bàn Claude Desktop App và công cụ lập trình tác tử Claude Code. Sự hỗ trợ đa diện này thể hiện các khía cạnh khác nhau của tiêu chuẩn MCP.

claude.ai hỗ trợ các máy chủ MCP từ xa, cho phép người dùng web kết nối các cuộc hội thoại Claude của họ với các công cụ, lời nhắc và tài nguyên bên ngoài.

Claude Desktop App tiến xa hơn bằng cách cho phép kết nối với các máy chủ cục bộ, giúp tăng cường quyền riêng tư và bảo mật bằng cách giữ dữ liệu trên máy của người dùng. Nó hỗ trợ đầy đủ các Tài nguyên (Resources), Lời nhắc (Prompts), Công cụ (Tools) và thậm chí cả Ứng dụng (Apps) tương tác.

Claude Code là một ví dụ mạnh mẽ về tích hợp hai chiều. Nó hoạt động như một máy khách MCP, sử dụng các Công cụ (Tools), Lời nhắc (Prompts) và Tài nguyên (Resources) từ các máy chủ khác để hỗ trợ các tác vụ lập trình của nó. Đồng thời, nó cũng hoạt động như một máy chủ MCP, hiển thị các khả năng của chính nó cho các máy khách MCP khác.

Tác nhân lập trình GitHub Copilot

GitHub Copilot, trợ lý lập trình AI được sử dụng rộng rãi nhất, tận dụng MCP để mở rộng ngữ cảnh và khả năng của nó. Tác nhân lập trình Copilot có thể ủy quyền các tác vụ và tương tác với cả máy chủ MCP cục bộ và từ xa để sử dụng các công cụ bên ngoài.

Việc tích hợp này cho phép các nhà phát triển điều chỉnh Copilot theo nhu cầu dự án cụ thể của họ. Ví dụ, một nhà phát triển có thể kết nối Copilot với một máy chủ MCP nội bộ cung cấp các công cụ để tương tác với một hệ thống xây dựng độc quyền hoặc một cơ sở dữ liệu cụ thể của dự án. Điều này mở rộng nhận thức của Copilot vượt ra ngoài chính mã, cho phép nó thực hiện các tác vụ phát triển phức tạp hơn và nhận biết ngữ cảnh tốt hơn.

Cursor

Cursor là một trình soạn thảo mã AI-first được thiết kế từ đầu cho phát triển dựa trên AI. Hỗ trợ gốc của nó cho MCP là một phần cốt lõi trong kiến trúc của nó, cho phép tích hợp sâu vào quy trình làm việc của nhà phát triển.

Trình soạn thảo hỗ trợ các Công cụ (Tools) MCP thông qua tính năng Composer của nó, cho phép người dùng gọi các hàm bên ngoài trực tiếp trong khi lập trình. Nó cũng hỗ trợ Lời nhắc (Prompts), Thư mục gốc (Roots) và Gợi mở (Elicitation), cho phép nó có các phiên tương tác phức tạp hơn với các máy chủ. Cursor có thể kết nối với các máy chủ thông qua cả STDIO và SSE, cung cấp sự linh hoạt cho cả bộ công cụ cục bộ và từ xa.

LM Studio

LM Studio là một ứng dụng máy tính để bàn phổ biến giúp dễ dàng khám phá, tải xuống và chạy các LLM mã nguồn mở cục bộ. Đóng góp chính của nó cho hệ sinh thái MCP là khả năng kết nối các mô hình cục bộ này với các máy chủ MCP.

Điều này bắc cầu khoảng cách giữa thế giới các mô hình mã nguồn mở và việc sử dụng công cụ được chuẩn hóa do MCP cung cấp. Người dùng có thể thêm cấu hình máy chủ vào một tệp mcp.json cục bộ để bắt đầu. Một tính năng nổi bật là giao diện người dùng xác nhận công cụ của nó, yêu cầu người dùng phê duyệt trước khi một mô hình cục bộ được phép thực hiện một cuộc gọi công cụ, cung cấp một lớp bảo mật và kiểm soát quan trọng.

Amazon Q

Trợ lý AI của Amazon, Amazon Q, đã tích hợp MCP trong cả phiên bản dòng lệnh (Amazon Q CLI) và IDE (Amazon Q IDE). Điều này chứng minh tính hữu ích của giao thức trong môi trường phát triển chuyên nghiệp để quản lý cơ sở hạ tầng đám mây và tối ưu hóa các tác vụ lập trình.

Amazon Q CLI là một trợ lý lập trình tác tử cho terminal, hỗ trợ đầy đủ các máy chủ MCP. Nó cho phép người dùng truy cập các công cụ và lời nhắc đã lưu trực tiếp từ dòng lệnh của họ.

Amazon Q IDE, có sẵn cho các IDE lớn như VS Code và JetBrains, mang lại các khả năng tương tự vào một giao diện đồ họa. Nó cho phép người dùng kiểm soát và tổ chức các tài nguyên AWS cũng như quản lý quyền cho từng công cụ MCP thông qua giao diện người dùng của IDE, cung cấp khả năng kiểm soát chi tiết các khả năng của trợ lý.

AIQL TUUI

AIQL TUUI là một ứng dụng trò chuyện AI trên máy tính để bàn miễn phí và mã nguồn mở nổi bật với sự hỗ trợ toàn diện cho tiêu chuẩn MCP và tính chất đa nền tảng của nó. Nó hoạt động trên macOS, Windows và Linux và hỗ trợ nhiều nhà cung cấp AI và mô hình cục bộ.

Tích hợp MCP của nó rất rộng rãi, bao gồm Tài nguyên (Resources), Lời nhắc (Prompts), Công cụ (Tools), Khám phá (Discovery), Lấy mẫu (Sampling) và Gợi mở (Elicitation). Điều này cho phép một trải nghiệm phong phú, tương tác, nơi người dùng có thể chuyển đổi liền mạch giữa các LLM và tác nhân khác nhau. Ứng dụng cung cấp khả năng kiểm soát nâng cao đối với các tham số lấy mẫu và cho phép tùy chỉnh các công cụ, biến nó thành một lựa chọn mạnh mẽ cho người dùng cao cấp và nhà phát triển muốn có một máy khách có khả năng cấu hình cao.

Langflow

Langflow là một công cụ xây dựng trực quan mã nguồn mở để tạo các ứng dụng AI. Vị trí độc đáo của nó trong hệ sinh thái MCP là vai trò kép của nó vừa là máy khách vừa là máy chủ, được hỗ trợ bởi giao diện đồ họa, dựa trên luồng.

Với tư cách là một máy khách MCP, Langflow có thể sử dụng các công cụ từ bất kỳ máy chủ MCP nào để xây dựng các tác nhân và quy trình làm việc. Điều này cho phép người dùng kéo và thả các nút đại diện cho các công cụ MCP vào các luồng của họ, giúp các tích hợp phức tạp dễ tiếp cận hơn.

Ngược lại, người dùng cũng có thể xuất các tác nhân và luồng đã tạo của họ dưới dạng một máy chủ MCP hoàn chỉnh. Tính năng mạnh mẽ này cho phép các nhà phát triển tạo nguyên mẫu trực quan một bộ công cụ và sau đó hiển thị chúng cho các máy khách MCP khác, giảm đáng kể rào cản trong việc tạo và chia sẻ các khả năng AI tùy chỉnh.

AgenticFlow

AgenticFlow nhắm đến một đối tượng khác bằng cách cung cấp một nền tảng AI không mã để xây dựng các tác nhân xử lý các tác vụ bán hàng, tiếp thị và sáng tạo. Nó sử dụng MCP làm giao thức cơ bản để kết nối an toàn với một thư viện khổng lồ gồm hơn 10.000 công cụ và 2.500 API.

Nền tảng này đơn giản hóa quá trình kết nối với máy chủ MCP chỉ trong vài bước, loại bỏ các chi tiết kỹ thuật phức tạp. Điều này cho phép những người không phải nhà phát triển xây dựng các tác nhân AI mạnh mẽ có thể tương tác với nhiều dịch vụ bên ngoài. Người dùng có thể quản lý kết nối của họ một cách an toàn và thu hồi quyền truy cập bất cứ lúc nào, biến nó thành một điểm truy cập an toàn và dễ tiếp cận vào thế giới sử dụng công cụ AI.

Kết luận

Giao thức Bối cảnh Mô hình (Model Context Protocol) đang nhanh chóng trở thành một lớp nền tảng cho cách các hệ thống AI tương tác với thế giới bên ngoài. Bằng cách chuẩn hóa cách các LLM khám phá và sử dụng công cụ, lời nhắc và nguồn dữ liệu, MCP loại bỏ sự gắn kết chặt chẽ giữa các mô hình và dịch vụ, thay thế bằng một kiến trúc sạch, mô-đun và có khả năng tương tác. Sự thay đổi này giúp các ứng dụng AI dễ mở rộng hơn, an toàn hơn khi vận hành và thích ứng tốt hơn với các quy trình làm việc trong thế giới thực.

Như danh sách ngày càng tăng của các máy khách MCP cho thấy, giao thức này đã được đón nhận rộng rãi trong nhiều trường hợp sử dụng—từ các công cụ dành cho nhà phát triển như Apidog, Cursor và GitHub Copilot, đến các trợ lý doanh nghiệp như ChatGPT và Amazon Q, và thậm chí các nền tảng không mã như Langflow và AgenticFlow. Mỗi máy khách áp dụng MCP khác nhau, nhưng tất cả đều hưởng lợi từ cùng một lời hứa cốt lõi: khả năng tái sử dụng, tính linh hoạt và tích hợp công cụ nhất quán.

Trong tương lai, giá trị thực sự của MCP nằm ở hệ sinh thái mà nó cho phép. Khi nhiều máy chủ hiển thị các công cụ chất lượng cao và nhiều máy khách áp dụng giao thức, các nhà phát triển và người dùng đều có được sự tự do để kết hợp các mô hình, công cụ và quy trình làm việc mà không cần xây dựng lại các tích hợp từ đầu. Cho dù bạn đang gỡ lỗi một máy chủ MCP, xây dựng một trợ lý lập trình tác tử hay thiết kế các quy trình làm việc AI một cách trực quan, MCP đều cung cấp một nền tảng chung cho phép đổi mới mở rộng quy mô.