Bạn đã bao giờ tự hỏi làm thế nào các ứng dụng hiện đại có thể mở rộng quy mô dễ dàng mà không cần bạn quản lý một máy chủ nào chưa? Đó chính là sự kỳ diệu của API phi máy chủ (serverless APIs)—một yếu tố thay đổi cuộc chơi trong điện toán đám mây, đang định hình lại cách chúng ta xây dựng và triển khai các dịch vụ backend. Nếu bạn là một nhà phát triển đã chán ngấy việc cấp phát máy chủ hoặc một chủ doanh nghiệp đang tìm kiếm giải pháp mở rộng quy mô hiệu quả về chi phí, thì API phi máy chủ có thể chính là người bạn tốt nhất của bạn. Trong bài viết chuyên sâu này, chúng ta sẽ khám phá cơ sở hạ tầng đằng sau API phi máy chủ, cân nhắc những lợi ích và hạn chế của chúng, giới thiệu các công cụ phổ biến, so sánh chúng với các backend truyền thống có máy chủ, tìm hiểu cách kiểm thử bằng Apidog, và trả lời câu hỏi lớn: khi nào bạn nên chuyển sang phi máy chủ? Dựa trên những hiểu biết chuyên sâu, hãy cùng phân tích về mặt kỹ thuật và xem tại sao API phi máy chủ lại bùng nổ về mức độ phổ biến vào năm 2025.

Bạn muốn một nền tảng tích hợp, Tất cả trong Một để Đội ngũ Nhà phát triển của bạn làm việc cùng nhau với năng suất tối đa?

Apidog đáp ứng mọi yêu cầu của bạn và thay thế Postman với mức giá phải chăng hơn nhiều!

Tìm hiểu Cơ sở hạ tầng và Kiến trúc của API phi máy chủ

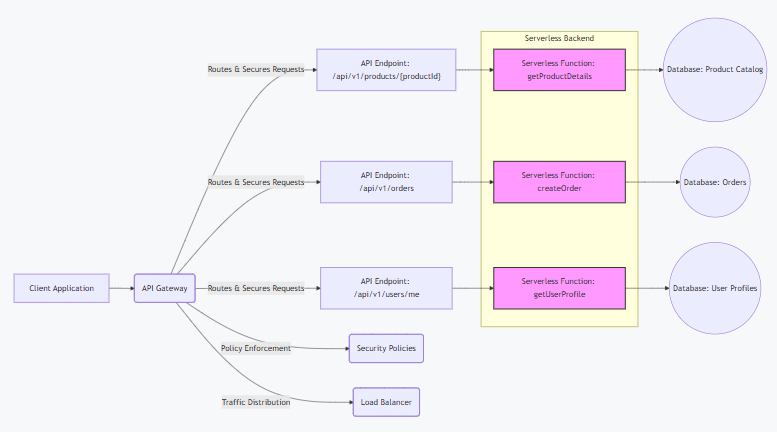

Về cơ bản, một API phi máy chủ là một API được xây dựng trên điện toán phi máy chủ, nơi các nhà cung cấp dịch vụ đám mây xử lý cơ sở hạ tầng backend, cho phép các nhà phát triển chỉ tập trung vào mã. Không giống như các thiết lập truyền thống, API phi máy chủ chạy trên các nền tảng Chức năng dưới dạng Dịch vụ (FaaS), thực thi mã trong các vùng chứa không trạng thái được kích hoạt bởi các sự kiện như yêu cầu HTTP.

Về mặt kỹ thuật, kiến trúc xoay quanh điện toán hướng sự kiện. Khi một yêu cầu đến điểm cuối API phi máy chủ của bạn, nhà cung cấp (ví dụ: AWS Lambda) sẽ khởi tạo một vùng chứa, chạy chức năng của bạn và tự động mở rộng quy mô dựa trên nhu cầu. Điều này sử dụng mô hình trả tiền theo mức sử dụng—không có máy chủ nhàn rỗi đồng nghĩa với không lãng phí chi phí. Các yếu tố chính bao gồm:

- API Gateway: Hoạt động như điểm vào, xử lý định tuyến, xác thực (ví dụ: JWT hoặc OAuth), giới hạn tốc độ và chuyển đổi yêu cầu. Ví dụ, AWS API Gateway tích hợp với Lambda, lưu trữ phản hồi để giảm độ trễ.

- Tầng FaaS: Mã của bạn nằm ở đây dưới dạng các chức năng. Mỗi chức năng được cách ly, với thời gian thực thi bị giới hạn (ví dụ: 15 phút trên Lambda) để khuyến khích thiết kế vi dịch vụ.

- Dịch vụ Backend: API phi máy chủ kết nối với các cơ sở dữ liệu được quản lý như DynamoDB (NoSQL) hoặc Aurora Serverless (SQL), bộ nhớ như S3 và hàng đợi như SQS để xử lý không đồng bộ.

- Cơ chế mở rộng quy mô: Các nhà cung cấp sử dụng các nhóm tự động mở rộng và bộ cân bằng tải ẩn. Đối với lưu lượng truy cập cao, các vùng chứa được nhân rộng trên các vùng sẵn có, đảm bảo thời gian hoạt động 99% thông qua dự phòng.

So với kiến trúc nguyên khối, API phi máy chủ phân tách thành các chức năng nhỏ hơn, cho phép mở rộng quy mô độc lập. Tuy nhiên, điều này gây ra hiện tượng khởi động nguội (cold starts)—độ trễ ban đầu (50-500ms) khi các chức năng khởi động từ trạng thái nhàn rỗi. Các chiến lược giảm thiểu bao gồm cấp phát đồng thời (provisioned concurrency) (làm nóng trước các chức năng) hoặc sử dụng các công cụ làm nóng như AWS Lambda Warmer.

Về bản chất, kiến trúc API phi máy chủ trừu tượng hóa hệ điều hành, mạng và cấp phát, cho phép bạn triển khai mã dưới dạng các chức năng phản hồi các trình kích hoạt. Nó là kiến trúc hướng sự kiện, không trạng thái và có khả năng phục hồi cao, nhưng đòi hỏi thiết kế cẩn thận để tránh bị khóa vào nhà cung cấp.

Lợi ích và Hạn chế của API phi máy chủ

API phi máy chủ không phải là một viên đạn bạc, nhưng những ưu điểm của chúng thường vượt trội hơn nhược điểm đối với nhiều trường hợp sử dụng. Hãy cùng phân tích về mặt kỹ thuật.

Lợi ích

- Hiệu quả chi phí: Chỉ trả tiền cho thời gian thực thi (ví dụ: Lambda tính phí 0,20 đô la cho mỗi triệu yêu cầu + 0,0000166667 đô la/GB-giây). Không có chi phí cho thời gian nhàn rỗi, lý tưởng cho lưu lượng truy cập biến động—tiết kiệm tới 90% so với các phiên bản EC2 luôn hoạt động.

- Tự động mở rộng quy mô: Xử lý các đợt tăng đột biến một cách liền mạch; Lambda mặc định mở rộng lên 1.000 lần thực thi đồng thời mỗi khu vực, với giới hạn tăng đột biến lên tới 3.000. Không cần cấp phát thủ công.

- Thời gian đưa ra thị trường nhanh hơn: Tập trung vào mã, không phải cơ sở hạ tầng. Triển khai các chức năng trong vài giây qua CLI (ví dụ:

aws lambda update-function-code), tăng tốc các đường ống CI/CD. - Khả năng phục hồi tích hợp: Các nhà cung cấp cung cấp triển khai đa AZ, tự động thử lại và hàng đợi thư chết (dead-letter queues) cho các sự kiện thất bại.

- Hệ sinh thái tích hợp: Dễ dàng kết nối với các dịch vụ như S3 (đối với trình kích hoạt tệp) hoặc DynamoDB (đối với luồng dữ liệu), cho phép kiến trúc hướng sự kiện.

Hạn chế

- Khởi động nguội (Cold Starts): Độ trễ tăng đột biến (lên tới 10 giây đối với các chức năng phức tạp) khi mở rộng từ số không. Các giải pháp thay thế như cấp phát đồng thời (provisioned concurrency) làm tăng chi phí (0,035 đô la/GB-giờ).

- Khóa vào nhà cung cấp (Vendor Lock-In): Các tính năng độc quyền (ví dụ: Lambda Layers) khiến việc di chuyển trở nên khó khăn. Sử dụng các tiêu chuẩn như OpenFaaS để dễ dàng di chuyển.

- Giới hạn thực thi: Thời gian chờ (tối đa 15 phút), bộ nhớ (10GB) và kích thước tải trọng (6MB đồng bộ) hạn chế các tác vụ chạy dài—sử dụng Step Functions để điều phối.

- Thử thách gỡ lỗi: Bản chất phân tán khiến việc theo dõi trở nên khó khăn; các công cụ như X-Ray (0,0001 đô la/trace) giúp ích, nhưng làm tăng độ phức tạp.

- Quản lý trạng thái: Các chức năng không trạng thái yêu cầu bộ nhớ ngoài (ví dụ: Redis), làm tăng độ trễ và chi phí cho các ứng dụng có trạng thái.

Nhìn chung, API phi máy chủ vượt trội đối với các khối lượng công việc bùng nổ, hướng sự kiện nhưng có thể không phù hợp với các ứng dụng có thông lượng cao liên tục.

Các công cụ và nền tảng phổ biến cho API phi máy chủ

Xây dựng API phi máy chủ dễ dàng hơn với các nền tảng và công cụ này, mỗi nền tảng cung cấp các tính năng độc đáo cho các nhu cầu khác nhau.

- AWS Lambda + API Gateway: Tiên phong của serverless. Lambda chạy mã bằng hơn 15 ngôn ngữ, với Gateway xử lý định tuyến. Giá: 0,20 đô la/triệu yêu cầu. Ưu điểm: Tích hợp sâu với AWS. Nhược điểm: Khởi động nguội.

- Google Cloud Functions + API Gateway: Hướng sự kiện, hỗ trợ Node.js/Python/Go. Giá: 0,40 đô la/triệu lời gọi. Ưu điểm: Khởi động nguội nhanh (qua Firestore). Nhược điểm: Giới hạn trong hệ sinh thái Google.

- Azure Functions + API Management: Các chức năng được kích hoạt theo thời gian trong C#/Java/JS. Giá: 0,20 đô la/triệu lần thực thi. Ưu điểm: Hỗ trợ đám mây lai. Nhược điểm: Đường cong học tập dốc hơn.

- Vercel Serverless Functions: Các chức năng biên (edge functions) cho ứng dụng Next.js. Giá: Tầng miễn phí (100GB-giờ/tháng). Ưu điểm: Mạng biên toàn cầu. Nhược điểm: Gắn liền với hosting của Vercel.

- Cloudflare Workers: Lưu trữ KV cho trạng thái. Giá: 0,30 đô la/triệu yêu cầu. Ưu điểm: Không có khởi động nguội. Nhược điểm: Giới hạn CPU 10ms.

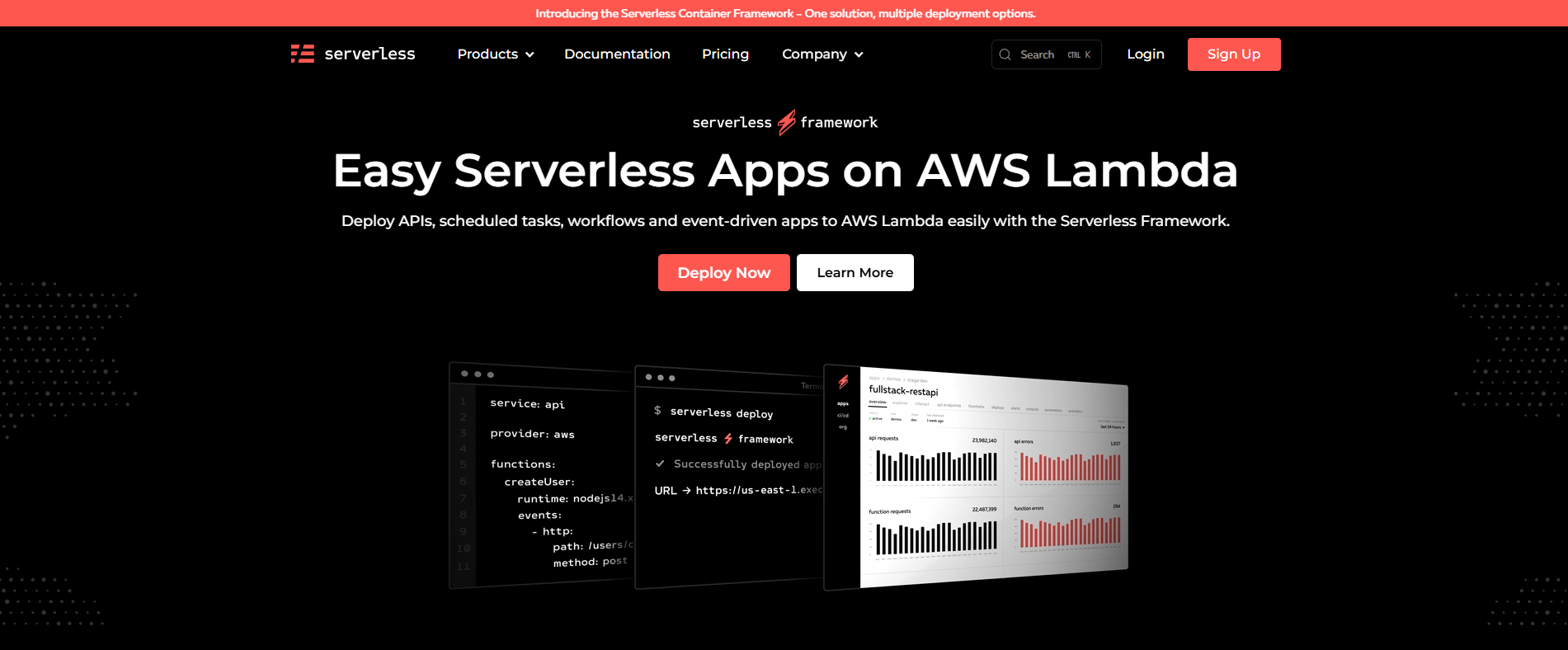

Các công cụ như Serverless Framework (để triển khai đa đám mây) hoặc SAM (đặc thù AWS) đơn giản hóa việc điều phối. Đối với GraphQL, Apollo Server trên Lambda rất phổ biến.

Serverless so với Serverful Backends: So sánh kỹ thuật

Serverless (FaaS) và serverful (máy ảo/container truyền thống) khác nhau về quản lý, mở rộng quy mô và chi phí. Dưới đây là phân tích chi tiết:

- Quản lý: Serverless trừu tượng hóa cơ sở hạ tầng—không cần vá lỗi hệ điều hành hoặc cân bằng tải. Serverful yêu cầu kiểm soát hoàn toàn (ví dụ: điều phối Kubernetes).

- Mở rộng quy mô: Serverless tự động mở rộng quy mô theo từng yêu cầu (từ không đến hàng nghìn trong vài giây). Serverful cần các nhóm mở rộng quy mô thủ công/tự động, với độ trễ cấp phát.

- Mô hình chi phí: Serverless: Trả tiền theo mức sử dụng (ví dụ: GB-giây của Lambda). Serverful: Chi phí cố định cho các phiên bản luôn hoạt động (ví dụ: 0,10 đô la/giờ của EC2).

- Hiệu suất: Serverless có nguy cơ khởi động nguội; serverful cung cấp độ trễ nhất quán nhưng lãng phí tài nguyên trong thời gian lưu lượng truy cập thấp.

- Xử lý trạng thái: Serverless là không trạng thái (sử dụng DB ngoài); serverful hỗ trợ các ứng dụng có trạng thái nguyên bản.

- Trường hợp sử dụng: Serverless cho các microservice/API; serverful cho các ứng dụng nguyên khối hoặc tính toán chuyên sâu.

Trong các thử nghiệm, serverless có thể rẻ hơn 50% đối với các tải không liên tục nhưng chậm hơn 20% do khởi động. Chọn dựa trên các mô hình lưu lượng truy cập—các phương pháp lai kết hợp cả hai.

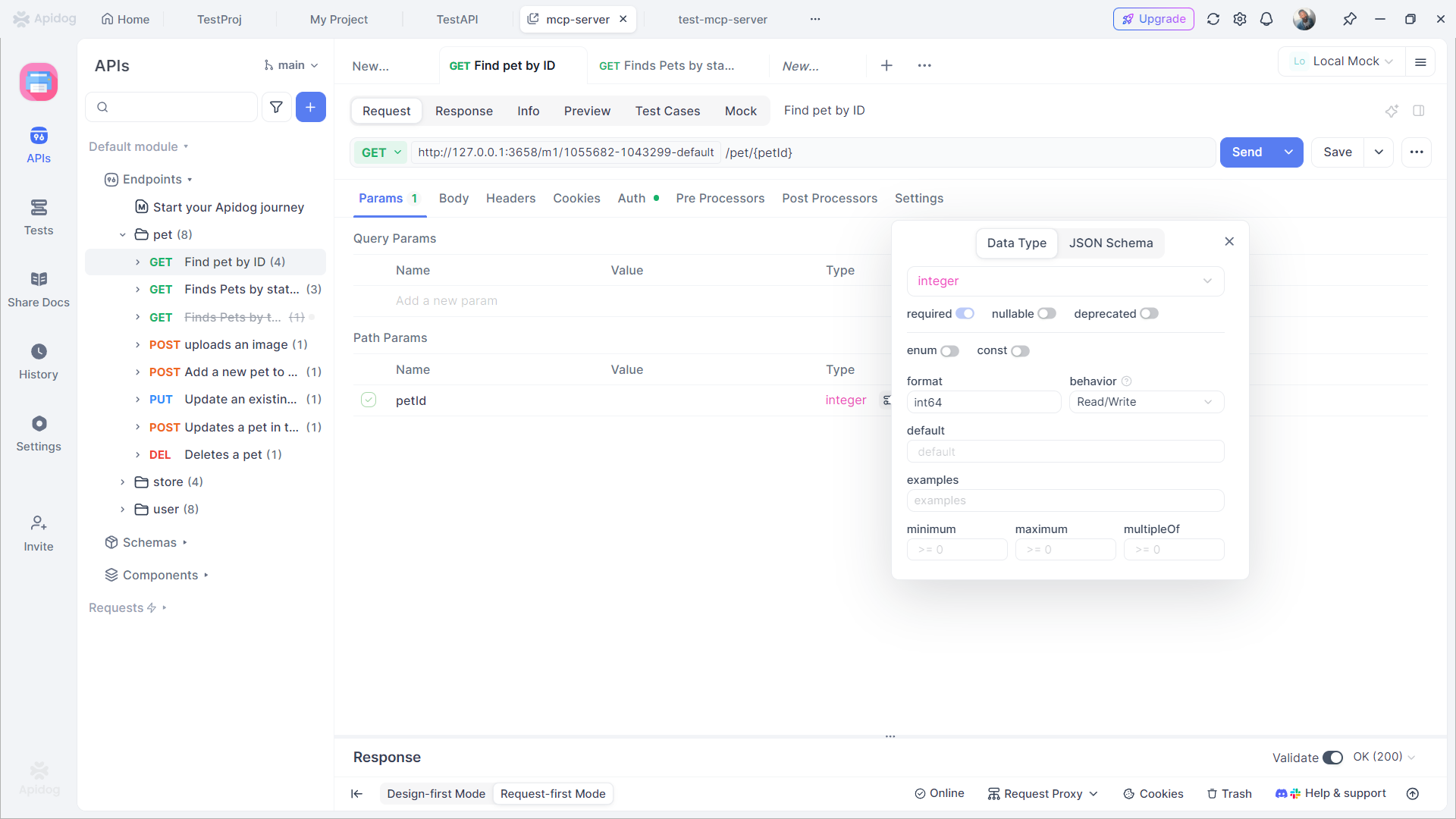

Kiểm thử API phi máy chủ với Apidog

Kiểm thử API phi máy chủ là rất quan trọng để đảm bảo độ tin cậy, và Apidog là một công cụ hàng đầu cho việc đó. Nền tảng tất cả trong một này hỗ trợ thiết kế trực quan, kiểm thử tự động và máy chủ Mock.

Apidog giúp kiểm thử API phi máy chủ như thế nào

- Xác nhận trực quan: Đặt các enum và xác thực phản hồi trực quan—không cần mã.

- Chạy không giới hạn: Chạy bộ sưu tập không giới hạn miễn phí, không giống như giới hạn 25 lần/tháng của Postman.

- Tích hợp CI/CD: Kết nối vào các đường ống như Jenkins để kiểm thử tự động khi triển khai.

- Giả lập (Mocking): Tạo dữ liệu tuân thủ enum để kiểm thử ngoại tuyến.

- Hỗ trợ AI: Tự động tạo kiểm thử từ các lời nhắc, ví dụ: "Kiểm thử enum cho user_status."

Lợi ích: Đồng bộ hóa thời gian thực của Apidog giúp phát hiện sớm các vấn đề, và kết nối cơ sở dữ liệu của nó kiểm thử các luồng có trạng thái. Giá bắt đầu miễn phí, với bản Pro là 9 đô la/tháng—rẻ hơn Postman.

Khi nào bạn nên sử dụng API phi máy chủ?

API phi máy chủ cung cấp một cách tiếp cận hiện đại để xây dựng và triển khai ứng dụng, nhưng chúng không phải là giải pháp phù hợp cho tất cả mọi trường hợp. Hiểu rõ điểm mạnh và hạn chế của chúng là chìa khóa để tận dụng chúng một cách hiệu quả. Dưới đây là phân tích chi tiết về thời điểm nên cân nhắc sử dụng API phi máy chủ:

- Lưu lượng truy cập biến động: Serverless lý tưởng cho các ứng dụng có mô hình lưu lượng truy cập không thể đoán trước hoặc tăng đột biến. Ví dụ, các nền tảng thương mại điện tử trong các đợt giảm giá chớp nhoáng hoặc các trang đăng ký sự kiện trải qua các đợt tăng đột biến đột ngột. Các chức năng serverless tự động mở rộng quy mô để xử lý nhu cầu và thu nhỏ về không khi không hoạt động, đảm bảo bạn chỉ trả tiền cho mức sử dụng thực tế thay vì cấp phát cơ sở hạ tầng đắt tiền, luôn hoạt động.

- Tạo mẫu nhanh và MVP: Nếu bạn cần nhanh chóng xác thực một ý tưởng hoặc xây dựng một sản phẩm khả thi tối thiểu (MVP), serverless cho phép bạn triển khai các chức năng trong vài giây. Sự linh hoạt này giúp tăng tốc thử nghiệm, giảm thời gian đưa ra thị trường và cho phép các nhóm lặp lại dựa trên phản hồi của người dùng thực mà không cần cam kết với các thiết lập cơ sở hạ tầng phức tạp.

- Ứng dụng hướng sự kiện: Serverless vượt trội trong kiến trúc hướng sự kiện. Các trường hợp sử dụng bao gồm xử lý dữ liệu IoT (ví dụ: xử lý các trình kích hoạt cảm biến), quản lý webhook (ví dụ: phản hồi các sự kiện GitHub hoặc Stripe) và điều phối các microservice. Các chức năng được kích hoạt chính xác khi các sự kiện xảy ra, đảm bảo sử dụng tài nguyên hiệu quả và đơn giản hóa các quy trình làm việc dựa trên sự kiện.

- Tối ưu hóa chi phí cho khối lượng công việc không liên tục: Nếu ứng dụng của bạn dành một lượng thời gian đáng kể để không hoạt động (ví dụ: 80% trở lên), serverless có thể giảm đáng kể chi phí. Các máy chủ truyền thống phát sinh chi phí ngay cả khi không hoạt động, nhưng serverless tuân theo mô hình trả tiền theo mức thực thi. Điều này làm cho nó trở nên kinh tế cho các ứng dụng có lưu lượng truy cập thấp, các tác vụ hàng loạt hoặc các tác vụ nền chạy không liên tục.

- Các nhóm DevOps tinh gọn: Các tổ chức có nguồn lực DevOps hạn chế được hưởng lợi từ cơ sở hạ tầng được quản lý của serverless. Các nhà cung cấp dịch vụ đám mây xử lý việc mở rộng quy mô, vá lỗi và bảo trì, cho phép các nhà phát triển chỉ tập trung vào mã. Điều này làm giảm chi phí vận hành và tăng tốc chu kỳ phát triển, giúp các nhóm nhỏ dễ dàng cung cấp các tính năng nhanh hơn.

Khi nào nên tránh API phi máy chủ:

Serverless có thể không phù hợp cho:

- Các quy trình chạy dài: Các chức năng thường có giới hạn thời gian (ví dụ: 15 phút trên AWS Lambda), khiến chúng không phù hợp cho các tác vụ như mã hóa video hoặc xuất dữ liệu lớn.

- Các ứng dụng có trạng thái: Serverless theo thiết kế là không trạng thái; tránh sử dụng nó cho các ứng dụng yêu cầu kết nối liên tục hoặc trạng thái trong bộ nhớ (ví dụ: máy chủ WebSocket).

- Các yêu cầu độ trễ cực thấp: Khởi động nguội (cold starts) (độ trễ khi khởi tạo các chức năng) có thể gây ra độ trễ, vì vậy hãy tránh serverless cho các hệ thống thời gian thực yêu cầu thời gian phản hồi nhất quán dưới 50ms.

Lời kết

Hãy bắt đầu nhỏ bằng cách tạo mẫu một microservice hoặc điểm cuối API duy nhất. Đo lường hiệu suất, chi phí và khả năng mở rộng trong ngữ cảnh cụ thể của bạn. Serverless là một công cụ mạnh mẽ cho các trường hợp sử dụng phù hợp—hãy áp dụng nó cho phát triển linh hoạt, khối lượng công việc biến động và nhu cầu hướng sự kiện, nhưng hãy kết hợp nó với cơ sở hạ tầng truyền thống cho các yêu cầu có trạng thái hoặc hiệu suất cao. Bằng cách điều chỉnh serverless với các mục tiêu kiến trúc của bạn và kiểm thử API của bạn với Apidog, bạn có thể tối đa hóa hiệu quả và sự đổi mới.