Hôm nay là một ngày tuyệt vời khác cho cộng đồng AI mã nguồn mở, đặc biệt, cộng đồng này phát triển mạnh mẽ nhờ những khoảnh khắc như thế này, háo hức phân tích, thử nghiệm và xây dựng dựa trên những công nghệ tiên tiến mới nhất. Vào tháng 7 năm 2025, nhóm Qwen của Alibaba đã tạo ra một sự kiện như vậy với việc ra mắt dòng Qwen3, một họ mô hình mới mạnh mẽ sẵn sàng định nghĩa lại các tiêu chuẩn hiệu suất. Trọng tâm của bản phát hành này là một biến thể hấp dẫn và chuyên biệt cao: Qwen3-235B-A22B-Thinking-2507.

Mô hình này không chỉ là một bản cập nhật tăng dần khác; nó đại diện cho một bước đi có chủ ý và chiến lược hướng tới việc tạo ra các hệ thống AI với khả năng suy luận sâu sắc. Bản thân tên gọi của nó đã là một tuyên bố về ý định, báo hiệu sự tập trung vào logic, lập kế hoạch và giải quyết vấn đề đa bước. Bài viết này đi sâu vào kiến trúc, mục đích và tác động tiềm tàng của Qwen3-Thinking, xem xét vị trí của nó trong hệ sinh thái Qwen3 rộng lớn hơn và ý nghĩa của nó đối với tương lai phát triển AI.

Bạn muốn một nền tảng tích hợp, tất cả trong một để nhóm Phát triển của bạn làm việc cùng nhau với năng suất tối đa?

Apidog đáp ứng mọi yêu cầu của bạn và thay thế Postman với mức giá phải chăng hơn nhiều!

Dòng Qwen3: Một Cuộc Tấn Công Đa Diện Vào Công Nghệ Tiên Tiến Nhất

Để hiểu mô hình Thinking, trước tiên cần phải nắm được bối cảnh ra đời của nó. Nó không xuất hiện một cách độc lập mà là một phần của một họ mô hình Qwen3 toàn diện và đa dạng về chiến lược. Dòng Qwen đã thu hút được một lượng lớn người theo dõi, với lịch sử tải xuống lên đến hàng trăm triệu lượt và nuôi dưỡng một cộng đồng sôi động đã tạo ra hơn 100.000 mô hình phái sinh trên các nền tảng như Hugging Face.

Dòng Qwen3 bao gồm một số biến thể chính, mỗi biến thể được tùy chỉnh cho các lĩnh vực khác nhau:

- Qwen3-Instruct: Một mô hình tuân thủ hướng dẫn đa năng được thiết kế cho nhiều ứng dụng đàm thoại và định hướng tác vụ. Ví dụ, biến thể

Qwen3-235B-A22B-Instruct-2507, nổi bật với khả năng căn chỉnh nâng cao với sở thích của người dùng trong các tác vụ mở và phạm vi kiến thức rộng. - Qwen3-Coder: Một loạt các mô hình được thiết kế rõ ràng cho việc mã hóa tác nhân. Mô hình mạnh nhất trong số này, một mô hình khổng lồ 480 tỷ tham số, đặt ra một tiêu chuẩn mới cho việc tạo mã nguồn mở và tự động hóa phát triển phần mềm. Nó thậm chí còn đi kèm với một công cụ dòng lệnh, Qwen Code, để khai thác tốt hơn các khả năng tác nhân của nó.

- Qwen3-Thinking: Trọng tâm phân tích của chúng tôi, chuyên biệt cho các tác vụ nhận thức phức tạp vượt ra ngoài việc tuân thủ hướng dẫn đơn giản hoặc tạo mã.

Cách tiếp cận theo họ mô hình này thể hiện một chiến lược tinh vi: thay vì một mô hình đơn lẻ, nguyên khối cố gắng làm mọi việc, Alibaba đang cung cấp một bộ công cụ chuyên biệt, cho phép các nhà phát triển chọn nền tảng phù hợp cho nhu cầu cụ thể của họ.

Hãy Nói Về Phần Tư Duy (Thinking) Của Qwen3-235B-A22B-Thinking-2507

Tên của mô hình, Qwen3-235B-A22B-Thinking-2507, chứa đựng nhiều thông tin tiết lộ kiến trúc cơ bản và triết lý thiết kế của nó. Hãy cùng phân tích từng phần.

Qwen3: Điều này cho thấy mô hình thuộc thế hệ thứ ba của dòng Qwen, được xây dựng dựa trên kiến thức và những tiến bộ của các phiên bản tiền nhiệm.235B-A22B(Hỗn hợp các Chuyên gia - MoE): Đây là chi tiết kiến trúc quan trọng nhất. Mô hình không phải là một mạng lưới dày đặc 235 tỷ tham số, nơi mọi tham số được sử dụng cho mọi phép tính. Thay vào đó, nó sử dụng kiến trúc Hỗn hợp các Chuyên gia (MoE).Thinking: Hậu tố này biểu thị sự chuyên biệt của mô hình, được tinh chỉnh trên dữ liệu khuyến khích suy luận logic và phân tích từng bước.2507: Đây là một thẻ phiên bản, có thể là viết tắt của tháng 7 năm 2025, cho biết ngày phát hành hoặc hoàn thành đào tạo của mô hình.

Kiến trúc MoE là chìa khóa cho sự kết hợp giữa sức mạnh và hiệu quả của mô hình này. Nó có thể được hình dung như một đội ngũ lớn gồm các "chuyên gia" chuyên biệt—các mạng thần kinh nhỏ hơn—được quản lý bởi một "mạng cổng" hoặc "bộ định tuyến". Đối với bất kỳ token đầu vào nào, bộ định tuyến sẽ tự động chọn một tập hợp nhỏ các chuyên gia phù hợp nhất để xử lý thông tin.

Trong trường hợp của Qwen3-235B-A22B, các chi tiết cụ thể là:

- Tổng Tham số (

235B): Điều này đại diện cho kho kiến thức rộng lớn được phân bổ trên tất cả các chuyên gia có sẵn. Mô hình chứa tổng cộng 128 chuyên gia riêng biệt. - Tham số Hoạt động (

A22B): Đối với bất kỳ lần truyền suy luận đơn lẻ nào, mạng cổng sẽ chọn 8 chuyên gia để kích hoạt. Kích thước kết hợp của các chuyên gia hoạt động này là khoảng 22 tỷ tham số.

Lợi ích của cách tiếp cận này là rất lớn. Nó cho phép mô hình sở hữu kiến thức, sắc thái và khả năng rộng lớn của một mô hình 235 tỷ tham số trong khi có chi phí tính toán và tốc độ suy luận gần với một mô hình dày đặc 22 tỷ tham số nhỏ hơn nhiều. Điều này làm cho việc triển khai và chạy một mô hình lớn như vậy trở nên khả thi hơn mà không làm mất đi chiều sâu kiến thức của nó.

Thông số kỹ thuật và Hồ sơ hiệu suất

Ngoài kiến trúc cấp cao, các thông số kỹ thuật chi tiết của mô hình vẽ nên một bức tranh rõ ràng hơn về khả năng của nó.

- Kiến trúc Mô hình: Hỗn hợp các Chuyên gia (MoE)

- Tổng Tham số: ~235 Tỷ

- Tham số Hoạt động: ~22 Tỷ mỗi token

- Số lượng Chuyên gia: 128

- Số chuyên gia được kích hoạt mỗi token: 8

- Độ dài ngữ cảnh: Mô hình hỗ trợ một cửa sổ ngữ cảnh 128.000 token. Đây là một cải tiến lớn cho phép nó xử lý và suy luận trên các tài liệu cực dài, toàn bộ cơ sở mã hoặc lịch sử hội thoại dài mà không làm mất dấu thông tin quan trọng từ đầu đầu vào.

- Tokenizer: Nó sử dụng một tokenizer Mã hóa Cặp Byte (BPE) tùy chỉnh với từ vựng hơn 150.000 token. Kích thước từ vựng lớn này cho thấy khả năng đào tạo đa ngôn ngữ mạnh mẽ của nó, cho phép nó mã hóa văn bản hiệu quả từ nhiều ngôn ngữ, bao gồm tiếng Anh, tiếng Trung, tiếng Đức, tiếng Tây Ban Nha và nhiều ngôn ngữ khác, cũng như các ngôn ngữ lập trình.

- Dữ liệu Đào tạo: Mặc dù thành phần chính xác của kho dữ liệu đào tạo là độc quyền, nhưng một mô hình

Thinkingchắc chắn được đào tạo trên một sự kết hợp chuyên biệt của dữ liệu được thiết kế để thúc đẩy khả năng suy luận. Tập dữ liệu này sẽ vượt xa văn bản web tiêu chuẩn và có thể bao gồm: - Các bài báo học thuật và khoa học: Khối lượng lớn văn bản từ các nguồn như arXiv, PubMed và các kho lưu trữ nghiên cứu khác để tiếp thu lý luận khoa học và toán học phức tạp.

- Tập dữ liệu logic và toán học: Các tập dữ liệu như GSM8K (Toán học cấp tiểu học) và tập dữ liệu MATH, chứa các bài toán đố yêu cầu giải pháp từng bước.

- Các bài toán lập trình và mã hóa: Các tập dữ liệu như HumanEval và MBPP, kiểm tra khả năng suy luận logic thông qua việc tạo mã.

- Văn bản triết học và pháp lý: Các tài liệu yêu cầu hiểu các lập luận logic dày đặc, trừu tượng và có cấu trúc cao.

- Dữ liệu Chuỗi suy nghĩ (CoT): Các ví dụ được tạo tổng hợp hoặc do con người tuyển chọn, trong đó mô hình được chỉ rõ cách "suy nghĩ từng bước" để đưa ra câu trả lời.

Sự kết hợp dữ liệu được tuyển chọn này là điều phân biệt mô hình Thinking với người anh em Instruct của nó. Nó không chỉ được đào tạo để hữu ích; nó được đào tạo để nghiêm ngặt.

Sức Mạnh Của "Tư Duy": Tập Trung Vào Nhận Thức Phức Tạp

Lời hứa của mô hình Qwen3-Thinking nằm ở khả năng giải quyết các vấn đề mà trước đây là những thách thức lớn đối với các mô hình ngôn ngữ lớn. Đây là những tác vụ mà việc khớp mẫu đơn giản hoặc truy xuất thông tin là không đủ. Sự chuyên biệt "Tư duy" cho thấy khả năng thành thạo trong các lĩnh vực như:

- Suy luận đa bước: Giải quyết các vấn đề yêu cầu phân tích một truy vấn thành một chuỗi các bước logic. Ví dụ, tính toán các tác động tài chính của một quyết định kinh doanh dựa trên nhiều biến số thị trường hoặc lập kế hoạch quỹ đạo của một vật thể được phóng với một tập hợp các ràng buộc vật lý.

- Suy luận logic: Phân tích một tập hợp các tiền đề và đưa ra một kết luận hợp lệ. Điều này có thể bao gồm giải một câu đố lưới logic, xác định các lỗi logic trong một đoạn văn bản hoặc xác định hậu quả của một tập hợp các quy tắc trong bối cảnh pháp lý hoặc hợp đồng.

- Lập kế hoạch chiến lược: Đề ra một chuỗi hành động để đạt được mục tiêu. Điều này có ứng dụng trong việc chơi game phức tạp (như cờ vua hoặc cờ vây), mô phỏng chiến lược kinh doanh, tối ưu hóa chuỗi cung ứng và quản lý dự án tự động.

- Suy luận nhân quả: Cố gắng xác định mối quan hệ nhân quả trong một hệ thống phức tạp được mô tả bằng văn bản, một nền tảng của lý luận khoa học và phân tích mà các mô hình thường gặp khó khăn.

- Suy luận trừu tượng: Hiểu và thao tác các khái niệm trừu tượng và các phép loại suy. Điều này rất cần thiết cho việc giải quyết vấn đề sáng tạo và trí tuệ cấp độ con người thực sự, vượt ra ngoài các sự kiện cụ thể để đến các mối quan hệ giữa chúng.

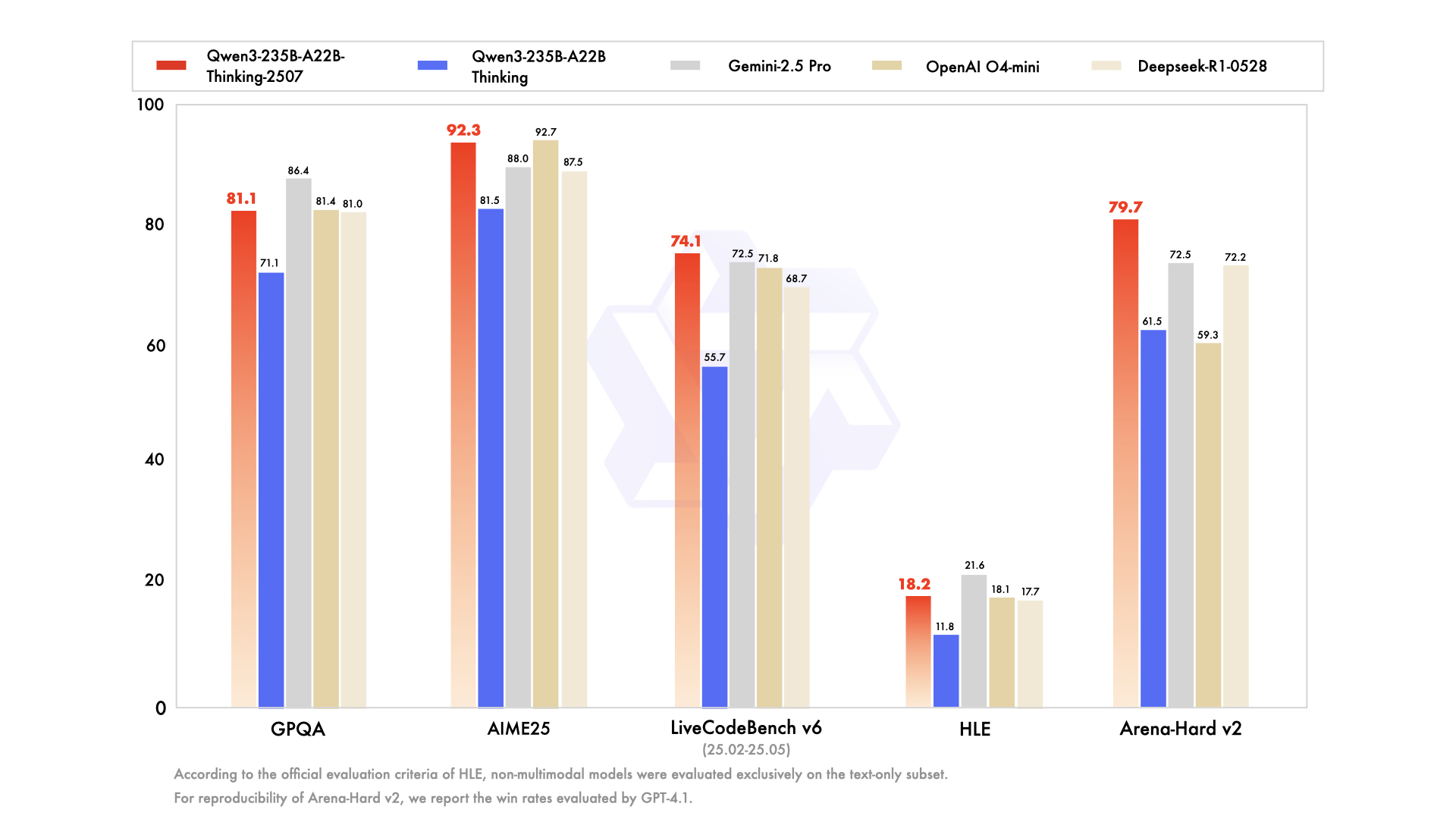

Mô hình được thiết kế để vượt trội trên các điểm chuẩn đo lường cụ thể các khả năng nhận thức nâng cao này, chẳng hạn như MMLU (Hiểu ngôn ngữ đa nhiệm lớn) cho kiến thức tổng quát và giải quyết vấn đề, và GSM8K và MATH đã đề cập ở trên cho lý luận toán học.

Khả năng tiếp cận, Lượng tử hóa và Sự tham gia của Cộng đồng

Sức mạnh của một mô hình chỉ có ý nghĩa nếu nó có thể được truy cập và sử dụng. Giữ đúng cam kết mã nguồn mở của mình, Alibaba đã cung cấp rộng rãi dòng Qwen3, bao gồm cả biến thể Thinking, trên các nền tảng như Hugging Face và ModelScope.

Nhận thấy các tài nguyên tính toán đáng kể cần thiết để chạy một mô hình ở quy mô này, các phiên bản lượng tử hóa cũng có sẵn. Mô hình Qwen3-235B-A22B-Thinking-2507-FP8 là một ví dụ điển hình. FP8 (số dấu phẩy động 8 bit) là một kỹ thuật lượng tử hóa tiên tiến giúp giảm đáng kể dung lượng bộ nhớ của mô hình và tăng tốc độ suy luận.

Hãy cùng phân tích tác động:

- Một mô hình 235B tham số ở độ chính xác 16 bit tiêu chuẩn (BF16/FP16) sẽ yêu cầu hơn 470 GB VRAM, một lượng quá lớn đối với tất cả trừ các cụm máy chủ cấp doanh nghiệp lớn nhất.

- Tuy nhiên, phiên bản lượng tử hóa FP8 làm giảm yêu cầu này xuống dưới 250 GB. Mặc dù vẫn còn đáng kể, điều này đưa mô hình vào phạm vi khả thi cho các tổ chức nghiên cứu, công ty khởi nghiệp và thậm chí cả các cá nhân có máy trạm đa GPU được trang bị phần cứng tiêu dùng hoặc chuyên nghiệp cao cấp.

Điều này giúp khả năng suy luận nâng cao trở nên dễ tiếp cận hơn với nhiều đối tượng. Đối với người dùng doanh nghiệp ưa thích các dịch vụ được quản lý, các mô hình cũng đang được tích hợp vào các nền tảng đám mây của Alibaba. Quyền truy cập API thông qua Model Studio và tích hợp vào trợ lý AI hàng đầu của Alibaba, Quark, đảm bảo rằng công nghệ có thể được tận dụng ở mọi quy mô.

Kết luận: Một Công Cụ Mới Cho Một Lớp Vấn Đề Mới

Việc phát hành Qwen3-235B-A22B-Thinking-2507 không chỉ là một điểm khác trên biểu đồ hiệu suất mô hình AI không ngừng tăng lên. Đó là một tuyên bố về hướng phát triển AI trong tương lai: một sự chuyển dịch từ các mô hình nguyên khối, đa năng sang một hệ sinh thái đa dạng gồm các công cụ mạnh mẽ, chuyên biệt. Bằng cách sử dụng kiến trúc Hỗn hợp các Chuyên gia hiệu quả, Alibaba đã cung cấp một mô hình với kiến thức rộng lớn của một mạng lưới 235 tỷ tham số và khả năng tính toán tương đối thân thiện của một mô hình 22 tỷ tham số.

Bằng cách tinh chỉnh rõ ràng mô hình này cho "Tư duy", nhóm Qwen cung cấp cho thế giới một công cụ chuyên dụng để giải quyết những thách thức phân tích và suy luận khó khăn nhất. Nó có tiềm năng đẩy nhanh khám phá khoa học bằng cách giúp các nhà nghiên cứu phân tích dữ liệu phức tạp, trao quyền cho các doanh nghiệp đưa ra các quyết định chiến lược tốt hơn và đóng vai trò là lớp nền tảng cho một thế hệ ứng dụng thông minh mới có thể lập kế hoạch, suy luận và lý giải với sự tinh vi chưa từng có. Khi cộng đồng mã nguồn mở bắt đầu khám phá sâu hơn, Qwen3-Thinking được định sẵn trở thành một khối xây dựng quan trọng trong hành trình không ngừng nghỉ tìm kiếm AI có khả năng hơn và thực sự thông minh.

Bạn muốn một nền tảng tích hợp, tất cả trong một để nhóm Phát triển của bạn làm việc cùng nhau với năng suất tối đa?

Apidog đáp ứng mọi yêu cầu của bạn và thay thế Postman với mức giá phải chăng hơn nhiều!