Bạn có muốn trò chuyện với các mô hình ngôn ngữ mạnh mẽ như Llama 3.1 hoặc Mistral mà không bị kẹt trong cửa sổ dòng lệnh (terminal)? Open WebUI là "vé" của bạn để có một giao diện đẹp mắt, giống ChatGPT, giúp tương tác với các LLM của Ollama trở nên thú vị và trực quan. Nó cho phép bạn lưu lịch sử trò chuyện, lưu trữ các câu lệnh (prompts) và thậm chí tải lên tài liệu để nhận phản hồi thông minh hơn—tất cả ngay trong trình duyệt của bạn. Trong hướng dẫn thân thiện với người mới bắt đầu này, tôi sẽ hướng dẫn bạn cài đặt Ollama, thử nghiệm một mô hình trong terminal, và sau đó nâng cấp trải nghiệm với Open WebUI để có giao diện thân thiện với người dùng hơn. Chúng ta sẽ sử dụng Docker để thiết lập nhanh chóng và thử nghiệm với một câu lệnh thú vị. Sẵn sàng để biến các cuộc trò chuyện AI trở nên dễ dàng chưa? Hãy bắt đầu nào!

Open WebUI là gì? Trung tâm điều khiển LLM của bạn

Open WebUI là một giao diện web mã nguồn mở, tự host, kết nối với Ollama, cho phép bạn tương tác với các mô hình ngôn ngữ lớn (LLMs) như Llama 3.1 hoặc Mistral trong một bảng điều khiển dựa trên trình duyệt. Khác với giao diện dòng lệnh của Ollama, Open WebUI mang lại cảm giác giống ChatGPT, cung cấp:

- Lịch sử trò chuyện: Lưu và xem lại các cuộc hội thoại của bạn.

- Lưu trữ câu lệnh (Prompt Storage): Lưu trữ và sử dụng lại các câu lệnh thường dùng.

- Tải lên tài liệu: Thêm tệp để nhận phản hồi có ngữ cảnh (Retrieval-Augmented Generation, hay RAG).

- Chuyển đổi mô hình: Dễ dàng chuyển đổi giữa các mô hình chỉ với một cú nhấp chuột.

Với hơn 50 nghìn lượt gắn sao trên GitHub, Open WebUI rất được ưa chuộng bởi các nhà phát triển và những người đam mê AI muốn có một cách làm việc đồ họa, cộng tác với LLMs trên máy tính cục bộ. Đầu tiên, hãy cài đặt Ollama để xem tại sao Open WebUI đáng để thêm vào!

Cài đặt và thử nghiệm Ollama

Trước khi đi sâu vào Open WebUI, hãy thiết lập Ollama và thử nghiệm một mô hình như Llama 3.1 hoặc Mistral trong terminal. Điều này giúp bạn có cơ sở để đánh giá giao diện trực quan của Open WebUI.

1. Kiểm tra yêu cầu hệ thống:

- Hệ điều hành: Windows, macOS, hoặc Linux (Ubuntu 24.04 hoặc tương tự).

- Phần cứng: Ít nhất 16GB RAM và 10GB dung lượng trống cho các mô hình (Llama 3.1 8B cần khoảng 5GB). GPU (ví dụ: NVIDIA 1060 4GB) là tùy chọn để tăng tốc độ.

- Phần mềm: Ollama, có thể tải xuống từ ollama.com.

2. Cài đặt Ollama: Tải xuống và cài đặt Ollama từ ollama.com cho hệ điều hành của bạn. Làm theo hướng dẫn của trình cài đặt—quá trình thiết lập rất nhanh chóng. Xác minh cài đặt bằng lệnh:

ollama --version

Bạn sẽ nhận được một phiên bản như 0.1.44 (tháng 4 năm 2025). Nếu không thành công, hãy đảm bảo Ollama nằm trong biến môi trường PATH của bạn.

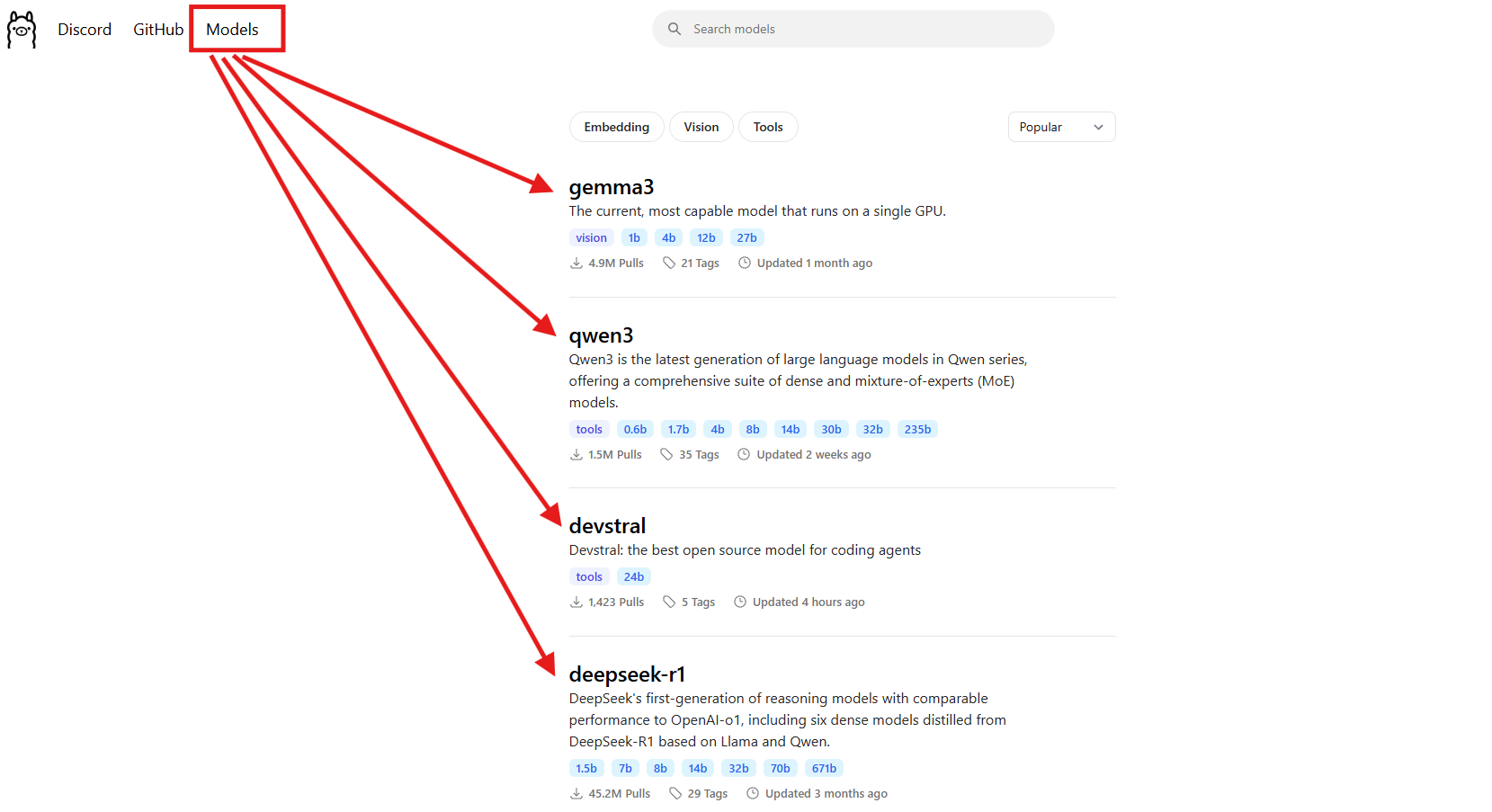

3. Tải xuống một mô hình: Chọn một mô hình như Llama 3.1 (8B) hoặc Mistral (7B). Trong hướng dẫn này, chúng ta sẽ sử dụng Llama 3.1:

ollama pull llama3.1

Lệnh này sẽ tải xuống khoảng 5GB, vì vậy hãy đi pha cà phê nếu mạng internet của bạn chậm. Kiểm tra xem mô hình đã được cài đặt chưa:

ollama list

Tìm kiếm llama3.1:latest. Mistral (ollama pull mistral) cũng là một lựa chọn tuyệt vời nếu bạn muốn một mô hình nhẹ hơn (khoảng 4GB).

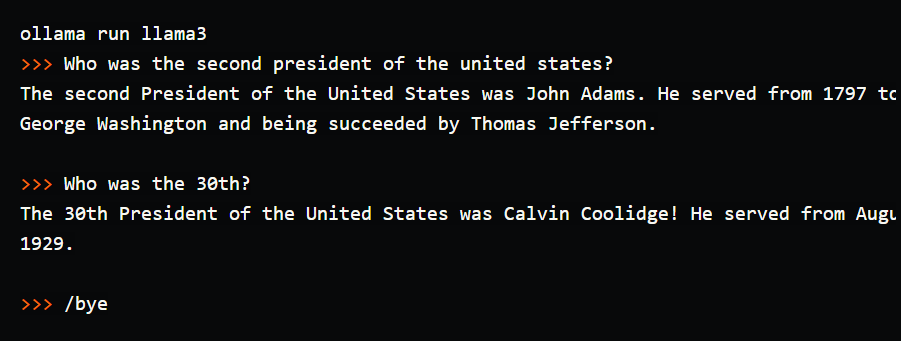

4. Thử nghiệm mô hình trong Terminal: Hãy thử một câu lệnh đơn giản để xem Ollama hoạt động:

ollama run llama3.1

Tại dấu nhắc (>>>), gõ: “Tell me a dad joke about computers.” (Kể cho tôi một câu chuyện cười về máy tính theo kiểu ông bố). Nhấn Enter. Bạn có thể nhận được: “Why did the computer go to the doctor? It had a virus!” (Tại sao máy tính lại đi khám bác sĩ? Nó bị virus!). Thoát bằng lệnh /bye. Tôi đã chạy thử và nhận được một câu chuyện cười khá hài hước, nhưng việc gõ trong terminal cảm thấy khá cồng kềnh—không có lịch sử trò chuyện, không lưu được câu lệnh. Đây là lúc Open WebUI tỏa sáng, cung cấp giao diện trực quan để lưu cuộc trò chuyện, sử dụng lại câu lệnh và tải lên tài liệu để nhận phản hồi phong phú hơn. Hãy cùng thiết lập nó!

Thiết lập môi trường cho Open WebUI

Bây giờ bạn đã thấy giao diện terminal của Ollama, hãy chuẩn bị cho Open WebUI để làm cho trải nghiệm LLM của bạn trực quan hơn. Chúng ta sẽ giả định bạn đã cài đặt Docker, vì nó được yêu cầu cho việc thiết lập Open WebUI.

1. Xác minh Docker: Đảm bảo Docker đã được cài đặt và đang chạy:

docker --version

Bạn sẽ nhận được kết quả như Docker 27.4.0. Nếu bạn chưa có Docker, hãy tải xuống và cài đặt Docker Desktop từ trang web chính thức của họ—quá trình thiết lập nhanh chóng cho Windows, macOS hoặc Linux.

2. Tạo thư mục dự án: Giữ mọi thứ có tổ chức:

mkdir ollama-webui

cd ollama-webui

Thư mục này sẽ là nơi cơ bản để bạn chạy Open WebUI.

3. Đảm bảo Ollama đang chạy: Khởi động Ollama trong một terminal riêng:

ollama serve

Lệnh này chạy API của Ollama tại http://localhost:11434. Giữ cửa sổ terminal này mở, vì Open WebUI cần nó để kết nối với các mô hình của bạn.

Cài đặt Open WebUI bằng Docker

Với Ollama và Llama 3.1 đã sẵn sàng, hãy cài đặt Open WebUI bằng một lệnh Docker duy nhất để thiết lập nhanh chóng, đáng tin cậy.

1. Chạy Open WebUI: Trong thư mục ollama-webui của bạn, thực thi lệnh:

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

Lệnh này:

- Kéo image Open WebUI (

ghcr.io/open-webui/open-webui:main, ~3.77GB). - Ánh xạ cổng 3000 (cục bộ) tới 8080 (container) để truy cập qua trình duyệt.

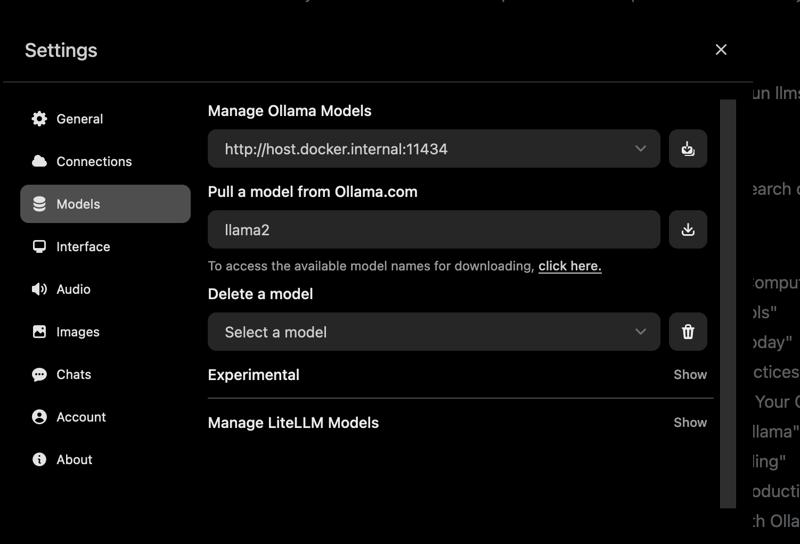

- Thêm

host.docker.internalđể kết nối tới API của Ollama tạilocalhost:11434. - Sử dụng một volume (

open-webui) để lưu trữ lịch sử trò chuyện và cài đặt. - Đặt tên container là

open-webuivà thiết lập để nó tự động khởi động lại.

Quá trình tải xuống mất vài phút. Kiểm tra xem nó đang chạy chưa bằng lệnh docker ps—tìm container có tên open-webui.

2. Truy cập Open WebUI: Mở trình duyệt của bạn và truy cập http://localhost:3000. Bạn sẽ thấy trang chào mừng của Open WebUI. Nhấp vào “Sign Up” để tạo tài khoản (người dùng đầu tiên sẽ có quyền admin). Sử dụng mật khẩu mạnh và lưu trữ nó an toàn. Bây giờ bạn đã sẵn sàng trò chuyện! Nếu trang không tải được, hãy đảm bảo container đang chạy (docker logs open-webui) và cổng 3000 không bị chiếm dụng.

Sử dụng Open WebUI: Trò chuyện và khám phá các tính năng

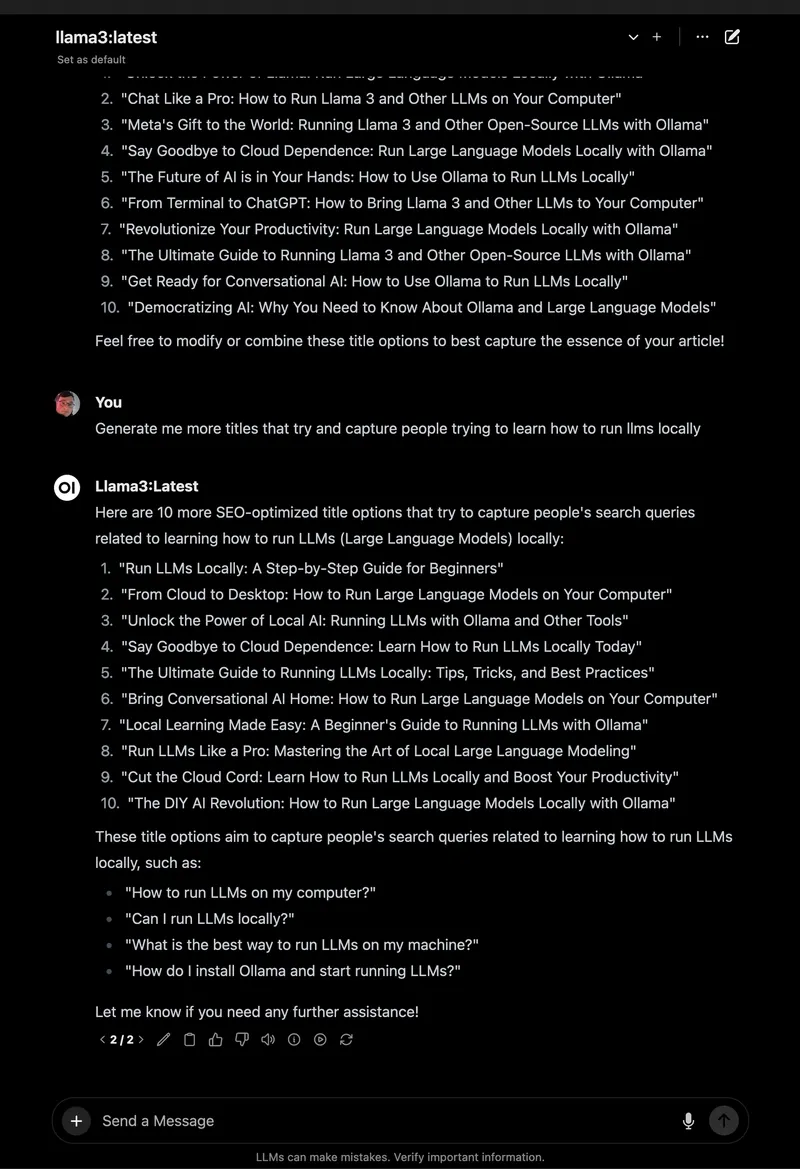

Với Open WebUI đang chạy, hãy cùng đi sâu vào việc trò chuyện với Llama 3.1 và khám phá các tính năng tuyệt vời của nó, điều này làm cho nó trở thành một bản nâng cấp lớn so với terminal.

1. Bắt đầu trò chuyện:

- Trong Open WebUI, chọn

llama3.1:8btừ bộ chọn mô hình ở góc trên bên trái (nó sẽ xuất hiện vì bạn đã tải xuống). - Nhấp vào “New Chat” ở thanh bên.

- Nhập cùng một câu lệnh: “Tell me a dad joke about computers.”

- Nhấn Enter. Bạn sẽ nhận được phản hồi như: “Why did the computer go to art school? Because it wanted to learn to draw a better byte!”

Giao diện rất gọn gàng, với câu lệnh và phản hồi của bạn được tự động lưu trong lịch sử trò chuyện.

2. Lưu và sắp xếp cuộc trò chuyện: Ở thanh bên trái, nhấp vào biểu tượng ghim để lưu cuộc trò chuyện. Đổi tên nó (ví dụ: “Dad Jokes”) để dễ dàng truy cập. Bạn có thể lưu trữ (archive) hoặc xóa các cuộc trò chuyện qua thanh bên, giúp các thử nghiệm của bạn được sắp xếp—tốt hơn nhiều so với việc cuộn trong terminal!

3. Lưu trữ câu lệnh (Prompts): Lưu câu lệnh chuyện cười kiểu bố để sử dụng lại:

- Vào Settings > Prompts.

- Nhấp vào “New Prompt,” đặt tên là “Dad Joke,” và dán: “Tell me a dad joke about computers.”

- Lưu lại. Bây giờ bạn có thể áp dụng nó trong bất kỳ cuộc trò chuyện nào chỉ với một cú nhấp chuột.

4. Tải lên tài liệu cho RAG: Thêm ngữ cảnh cho các cuộc trò chuyện của bạn:

- Nhấp vào biểu tượng “#” trong ô nhập liệu chat để mở thư viện tài liệu.

- Tải lên một tệp văn bản (ví dụ: hướng dẫn Spring Boot 3.2).

- Hỏi: “How do I use the REST Client in Spring Boot 3.2?” (Tôi sử dụng REST Client trong Spring Boot 3.2 như thế nào?). Llama 3.1 sẽ tham chiếu tài liệu, đưa ra một đoạn mã như

RestClient.create().get().uri("/users").retrieve().

Tôi đã thử nghiệm tính năng này với một tệp PDF hướng dẫn Python, và Open WebUI đã đưa ra các câu trả lời có ngữ cảnh rất chính xác, khác biệt với các phản hồi cơ bản của terminal.

5. Khám phá thêm các tính năng khác:

- Chuyển đổi mô hình: Sử dụng bộ chọn mô hình để thử Mistral hoặc các mô hình khác mà bạn đã tải xuống (

ollama pull mistral). - Tùy chỉnh phản hồi: Nhấp vào “Chat Control” để điều chỉnh tông giọng (ví dụ: “funny” - hài hước) hoặc độ dài.

- Công cụ quản trị: Trong Settings > Admin, quản lý người dùng hoặc hạn chế quyền truy cập mô hình (rất hữu ích cho nhóm làm việc).

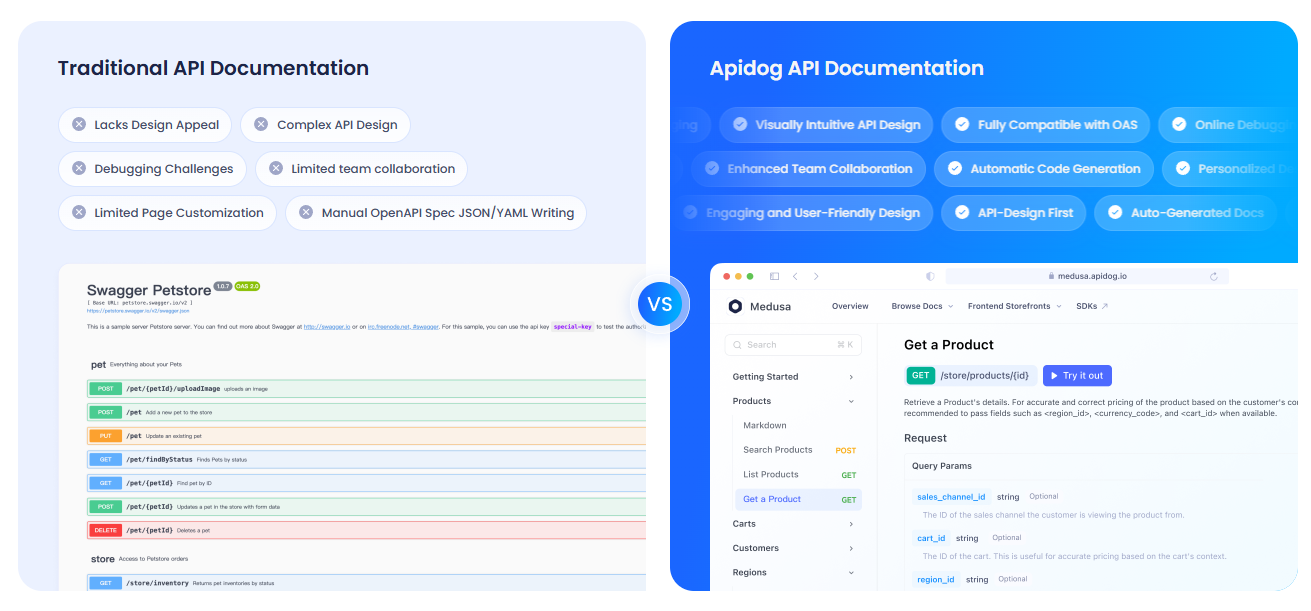

Tài liệu hóa các API của bạn với APIdog

Sử dụng Open WebUI để tương tác với API của Ollama và muốn tài liệu hóa thiết lập của bạn? APIdog là một công cụ tuyệt vời để tạo tài liệu API tương tác. Giao diện đẹp mắt và các tùy chọn tự host của nó lý tưởng để chia sẻ các dự án AI của bạn—hãy thử xem!

Khắc phục sự cố và mẹo

- Sự cố kết nối: Nếu Open WebUI không tìm thấy Ollama, đảm bảo lệnh

ollama serveđang chạy và cổng 11434 đang mở. Kiểm tra nhật ký Docker:docker logs open-webui. - Xung đột cổng: Nếu cổng 3000 đang bị chiếm dụng, dừng container (

docker stop open-webui), xóa nó (docker rm open-webui), và chạy lại lệnhdocker runvới một cổng mới (ví dụ:-p 3001:8080). - Phản hồi chậm: Sử dụng GPU với các thẻ

:cudacủa Ollama hoặc các mô hình nhỏ hơn như Mistral để tăng tốc độ. - Cộng đồng: Tham gia Thảo luận GitHub hoặc Discord của Open WebUI để nhận hỗ trợ và ý tưởng.

Tại sao chọn Open WebUI?

Open WebUI biến Ollama từ một công cụ terminal cồng kềnh thành một nền tảng mạnh mẽ, thân thiện với người dùng:

- Giao diện trực quan: Bảng điều khiển dựa trên trình duyệt hoàn hảo cho người mới bắt đầu và cả chuyên gia.

- Sắp xếp: Các cuộc trò chuyện và câu lệnh đã lưu giữ cho công việc của bạn gọn gàng, không như nhật ký terminal.

- Nhận biết ngữ cảnh: Tải lên tài liệu cho phép RAG để có câu trả lời thông minh hơn.

- Bảo mật: Chạy cục bộ, giữ dữ liệu của bạn an toàn.

Sau khi thử nghiệm cả terminal và Open WebUI, tôi hoàn toàn bị thuyết phục bởi sự dễ dàng và các tính năng của giao diện đồ họa. Nó giống như nâng cấp từ điện thoại "cục gạch" lên điện thoại thông minh vậy!

Tổng kết: Cuộc phiêu lưu Open WebUI của bạn đang chờ đợi

Bạn đã đi từ những cuộc trò chuyện trong terminal đến một thiết lập Open WebUI hoàn chỉnh với Ollama, giúp tương tác với LLM trở nên mượt mà và thú vị! Với Llama 3.1, các cuộc trò chuyện đã lưu và khả năng tải lên tài liệu, bạn đã sẵn sàng khám phá AI như chưa từng có. Hãy thử các mô hình mới, lưu trữ thêm câu lệnh, hoặc tài liệu hóa các API của bạn với APIdog. Chia sẻ những thành công của bạn với Open WebUI trên GitHub của Open WebUI—tôi rất mong được thấy những gì bạn tạo ra! Chúc bạn mày mò AI vui vẻ!