Các mô hình ngôn ngữ hình ảnh (VLMs) đã cách mạng hóa khả năng của AI trong việc hiểu và lý luận về nội dung hình ảnh. Trong số những đổi mới này, mô hình Kimi VL Thinking của Moonshot AI nổi bật với khả năng ấn tượng, kết hợp giữa khả năng lý luận tiên tiến và hiệu suất đáng kinh ngạc. Hướng dẫn này sẽ giúp bạn hiểu về khả năng của Kimi VL Thinking và cách sử dụng nó miễn phí thông qua nền tảng OpenRouter.

Tiêu Chí Đánh Giá Kimi VL Thinking

Kimi VL Thinking (trước đây được gọi là Kimi-VL-A3B-Thinking) là một mô hình ngôn ngữ hình ảnh tiên tiến được phát triển bởi Moonshot AI. Điều khiến mô hình này đặc biệt là kiến trúc Mixture-of-Experts (MoE) chỉ kích hoạt 2,8 tỷ tham số cho mỗi bước suy diễn, trong khi tổng cộng có khoảng 16 tỷ tham số. Điều này cho phép nó đưa ra lý luận tinh vi với tính toán tương đối hiệu quả.

Kimi VL Thinking được thiết kế đặc biệt cho các nhiệm vụ lý luận nâng cao, đặc biệt là những nhiệm vụ yêu cầu suy nghĩ từng bước và phân tích toán học các đầu vào hình ảnh. Nó được tạo ra bằng cách điều chỉnh mô hình cơ sở Kimi VL với các kỹ thuật học có giám sát chuỗi suy nghĩ (CoT) và học tăng cường.

Điểm Nổi Bật của Mô Hình Kimi VL Thinking

- Cửa Sổ Ngữ Cảnh Dài: Hỗ trợ lên đến 128K token, cho phép các cuộc hội thoại nhiều lượt mở rộng và xử lý các tài liệu dài.

- Nhận Thức Độ Phân Giải Bản Địa: Sử dụng bộ mã hóa MoonViT để xử lý các đầu vào hình ảnh độ phân giải cao với khả năng nhận diện chi tiết tuyệt vời.

- Lý Luận Tiên Tiến: Đặc biệt mạnh mẽ trong lý luận hình ảnh toán học và giải quyết vấn đề từng bước.

- Tính Toán Hiệu Quả: Mặc dù có khả năng mạnh mẽ, mô hình chỉ kích hoạt 2,8B tham số, giúp nó dễ tiếp cận hơn so với các lựa chọn lớn hơn.

- Mã Nguồn Mở: Có sẵn dưới giấy phép MIT, cho phép các ứng dụng học thuật và thương mại rộng rãi.

Hiệu Suất Đánh Giá Kimi VL Thinking

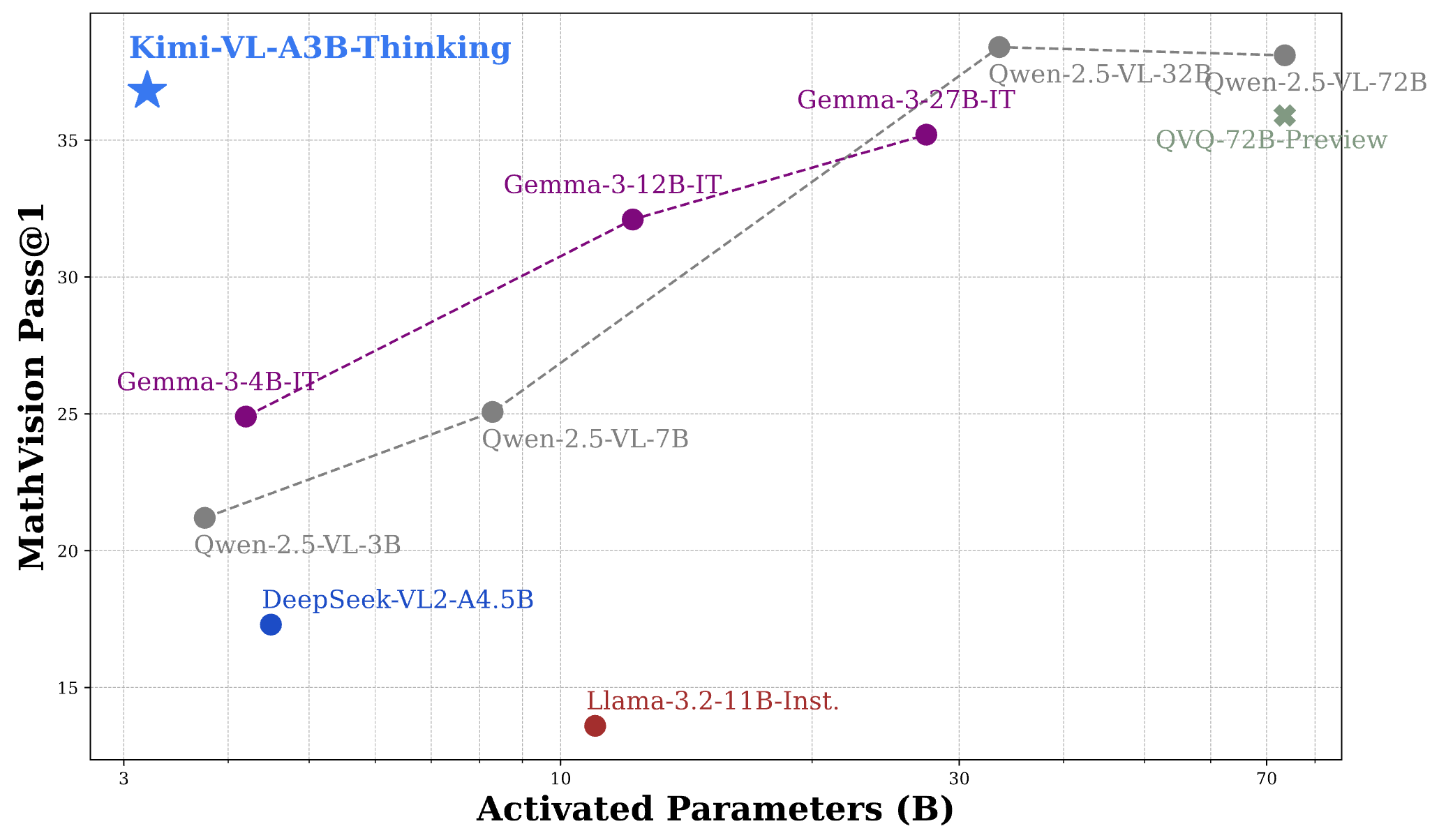

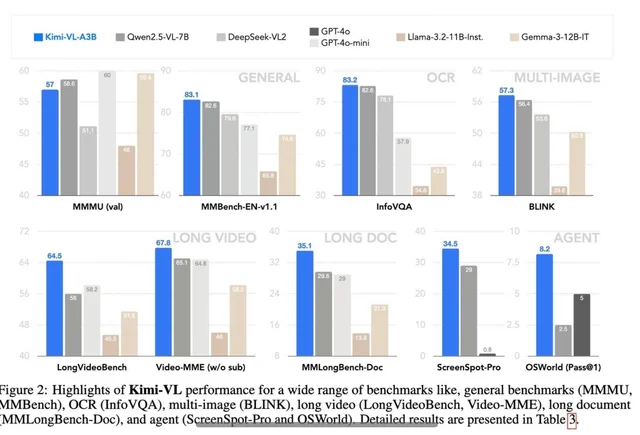

Kimi VL Thinking thể hiện hiệu suất ấn tượng qua một vài tiêu chí đánh giá thách thức, thường cạnh tranh hoặc vượt qua các mô hình lớn hơn:

- MathVision: Đạt được điểm số 36,8 (Pass@1), tương đương với các mô hình như Gemma-3-27B (35,5) và gần bằng Qwen2.5-VL-72B (38,1).

- MathVista: Đạt điểm 71.3 trên tiêu chí đánh giá mini, vượt qua các mô hình như GPT-4o-mini (56,7) và Gemma-3-12B (56,4).

- MMMU (Hiểu Biến Đa Mô Hình Khối Lượng Lớn): Đạt 61,7 trên tập dữ liệu xác thực, thể hiện khả năng mạnh mẽ trong các nhiệm vụ đa mô hình phức tạp.

Để đặt những kết quả này vào bối cảnh, hiệu suất của Kimi VL Thinking thật ấn tượng khi xem xét rằng nó chỉ kích hoạt 2,8B tham số, trong khi cạnh tranh với các mô hình sử dụng 7B, 12B, hoặc thậm chí là 70B+ tham số. Điều này khiến nó trở thành một trong những VLMs có khả năng lý luận hiệu quả nhất hiện có.

Cách Sử Dụng Kimi VL Thinking Miễn Phí Qua OpenRouter

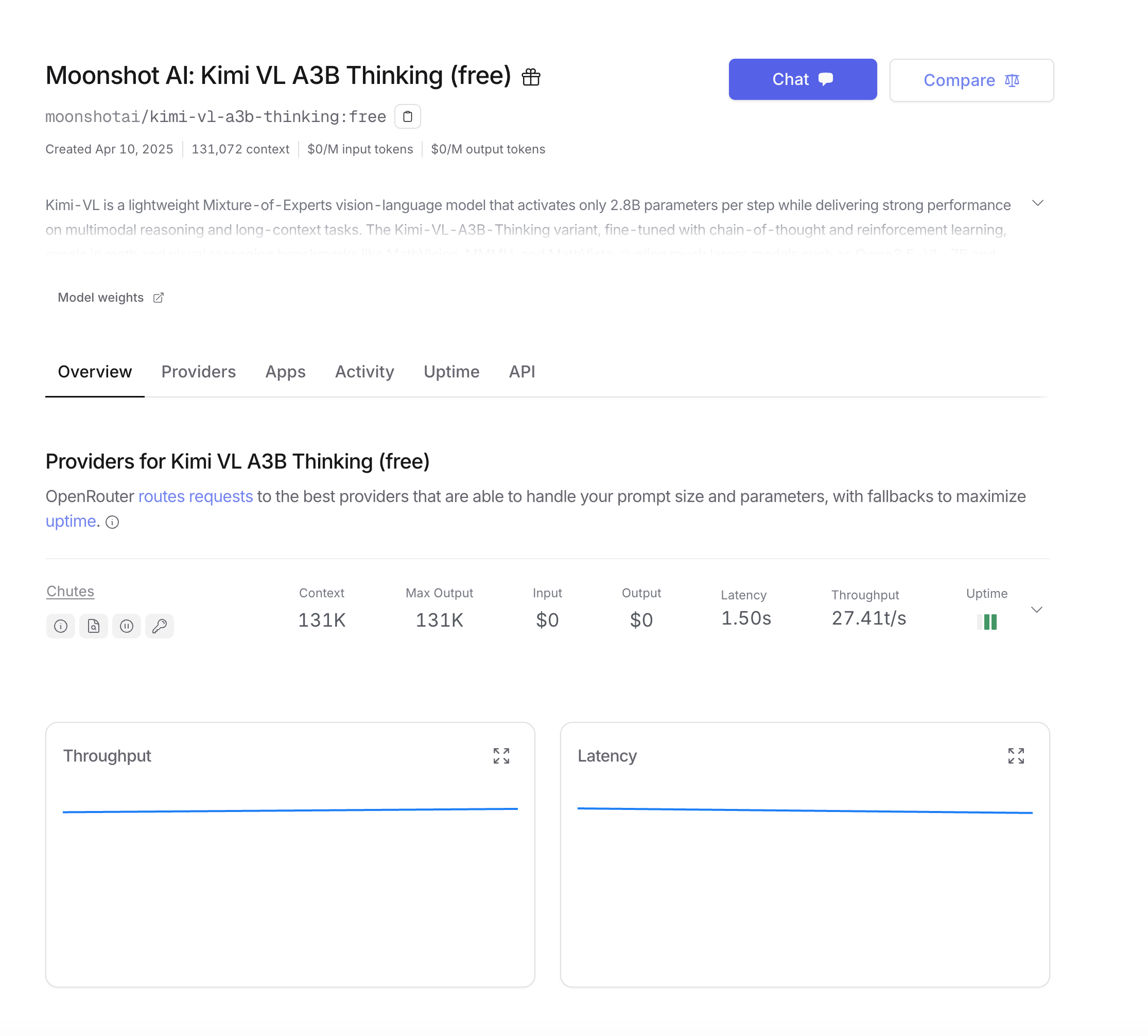

OpenRouter cung cấp một cách tiện lợi để truy cập Kimi VL Thinking mà không cần phải triển khai mô hình tự mình. Cấp miễn phí của họ cho phép bạn thử nghiệm với mô hình mà không tốn bất kỳ chi phí nào. Dưới đây là cách để bắt đầu:

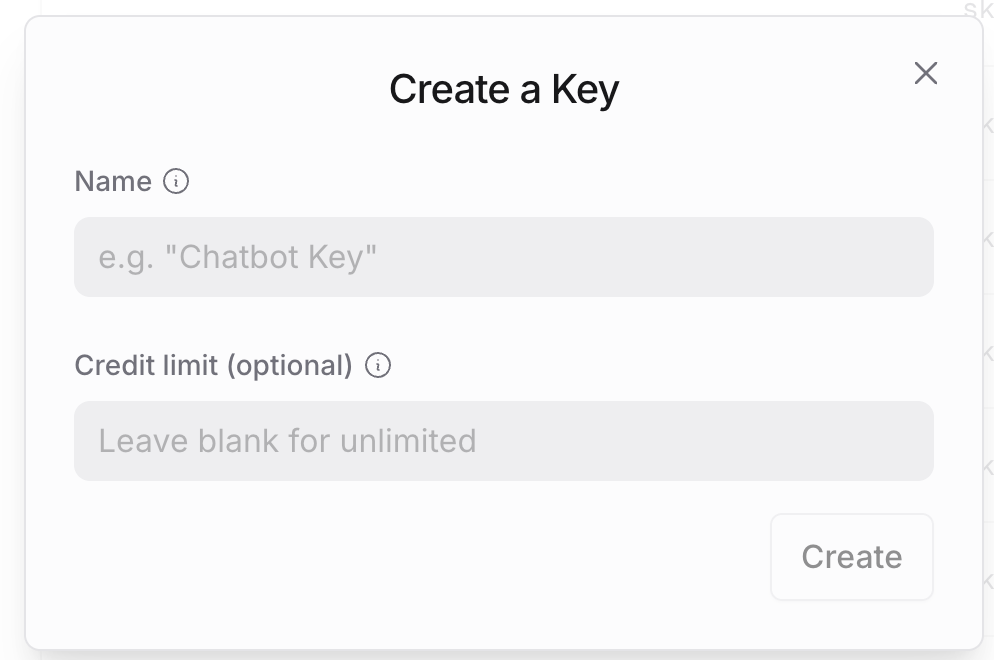

Bước 1: Tạo Tài Khoản OpenRouter

- Truy cập trang web của OpenRouter và đăng ký tài khoản nếu bạn chưa có.

- Sau khi đăng ký, điều hướng đến cài đặt tài khoản của bạn để tạo một khóa API.

- Bảo quản khóa API này một cách an toàn, vì bạn sẽ cần nó cho tất cả các cuộc gọi API.

Bước 2: Hiểu Cấu Trúc API của OpenRouter

API của OpenRouter được thiết kế để tương thích với định dạng API của OpenAI, giúp dễ dàng tích hợp nếu bạn đã quen thuộc với các dịch vụ của OpenAI. Những điểm khác biệt chính là:

- URL cơ sở:

https://openrouter.ai/api/v1 - Tên mô hình:

moonshotai/kimi-vl-a3b-thinking:free - Các tiêu đề tùy chọn bổ sung cho phân tích

Bước 3: Thực Hiện Lần Gọi API Đầu Tiên

Đối với người dùng Python, thiết lập môi trường của bạn với các phụ thuộc này:

pip install openai requests pillow

Chúng ta hãy bắt đầu với một ví dụ cơ bản sử dụng SDK của OpenAI, đây là cách tiếp cận đơn giản nhất:

from openai import OpenAI

from base64 import b64encode

from PIL import Image

import io

# Khởi tạo client với URL cơ sở của OpenRouter

client = OpenAI(

base_url="<https://openrouter.ai/api/v1>",

api_key="your_openrouter_api_key_here",

)

# Hàm mã hóa hình ảnh

def encode_image(image_path):

with open(image_path, "rb") as image_file:

return b64encode(image_file.read()).decode('utf-8')

# Tải và mã hóa hình ảnh của bạn

image_path = "path_to_your_image.jpg"

base64_image = encode_image(image_path)

# Tạo yêu cầu API

completion = client.chat.completions.create(

extra_headers={

"HTTP-Referer": "your_site_url", # Tùy chọn cho phân tích

"X-Title": "your_app_name", # Tùy chọn cho phân tích

},

model="moonshotai/kimi-vl-a3b-thinking:free",

messages=[

{

"role": "user",

"content": [

{

"type": "image",

"image_url": {

"url": f"data:image/jpeg;base64,{base64_image}"

}

},

{

"type": "text",

"text": "Vui lòng xem xét bài toán toán học này và giải quyết nó từng bước."

}

]

}

],

max_tokens=1024

)

print(completion.choices[0].message.content)

Nếu bạn thích sử dụng các cuộc gọi API trực tiếp mà không cần SDK:

import requests

import json

from base64 import b64encode

# Hàm mã hóa hình ảnh

def encode_image(image_path):

with open(image_path, "rb") as image_file:

return b64encode(image_file.read()).decode('utf-8')

# Tải và mã hóa hình ảnh của bạn

image_path = "path_to_your_image.jpg"

base64_image = encode_image(image_path)

# Tạo yêu cầu API

response = requests.post(

url="<https://openrouter.ai/api/v1/chat/completions>",

headers={

"Authorization": "Bearer your_openrouter_api_key_here",

"Content-Type": "application/json",

"HTTP-Referer": "your_site_url", # Tùy chọn cho phân tích

"X-Title": "your_app_name", # Tùy chọn cho phân tích

},

data=json.dumps({

"model": "moonshotai/kimi-vl-a3b-thinking:free",

"messages": [

{

"role": "user",

"content": [

{

"type": "image",

"image_url": {

"url": f"data:image/jpeg;base64,{base64_image}"

}

},

{

"type": "text",

"text": "Vui lòng xem xét bài toán toán học này và giải quyết nó từng bước."

}

]

}

],

"max_tokens": 1024

})

)

print(response.json()["choices"][0]["message"]["content"])

Đối với các phản hồi dài hoặc trải nghiệm người dùng tốt hơn, bạn có thể muốn phát trực tuyến đầu ra của mô hình:

from openai import OpenAI

from base64 import b64encode

client = OpenAI(

base_url="<https://openrouter.ai/api/v1>",

api_key="your_openrouter_api_key_here",

)

# Hàm mã hóa hình ảnh

def encode_image(image_path):

with open(image_path, "rb") as image_file:

return b64encode(image_file.read()).decode('utf-8')

# Tải và mã hóa hình ảnh của bạn

image_path = "path_to_your_image.jpg"

base64_image = encode_image(image_path)

# Tạo yêu cầu phát trực tuyến

stream = client.chat.completions.create(

model="moonshotai/kimi-vl-a3b-thinking:free",

messages=[

{

"role": "user",

"content": [

{

"type": "image",

"image_url": {

"url": f"data:image/jpeg;base64,{base64_image}"

}

},

{

"type": "text",

"text": "Vui lòng xem xét bài toán toán học này và giải quyết nó từng bước."

}

]

}

],

stream=True,

max_tokens=1024

)

# Xử lý phản hồi phát trực tuyến

for chunk in stream:

if chunk.choices[0].delta.content:

print(chunk.choices[0].delta.content, end="", flush=True)

Kiểm Tra Kimi VL Thinking API Với Apidog

Apidog là một công cụ kiểm tra API toàn diện giúp đơn giản hóa quá trình tương tác với các API như Kimi VL Thinking. Các tính năng của nó, chẳng hạn như quản lý môi trường và mô phỏng kịch bản, làm cho nó lý tưởng cho các nhà phát triển. Hãy xem cách sử dụng Apidog để kiểm tra API Kimi VL Thinking.

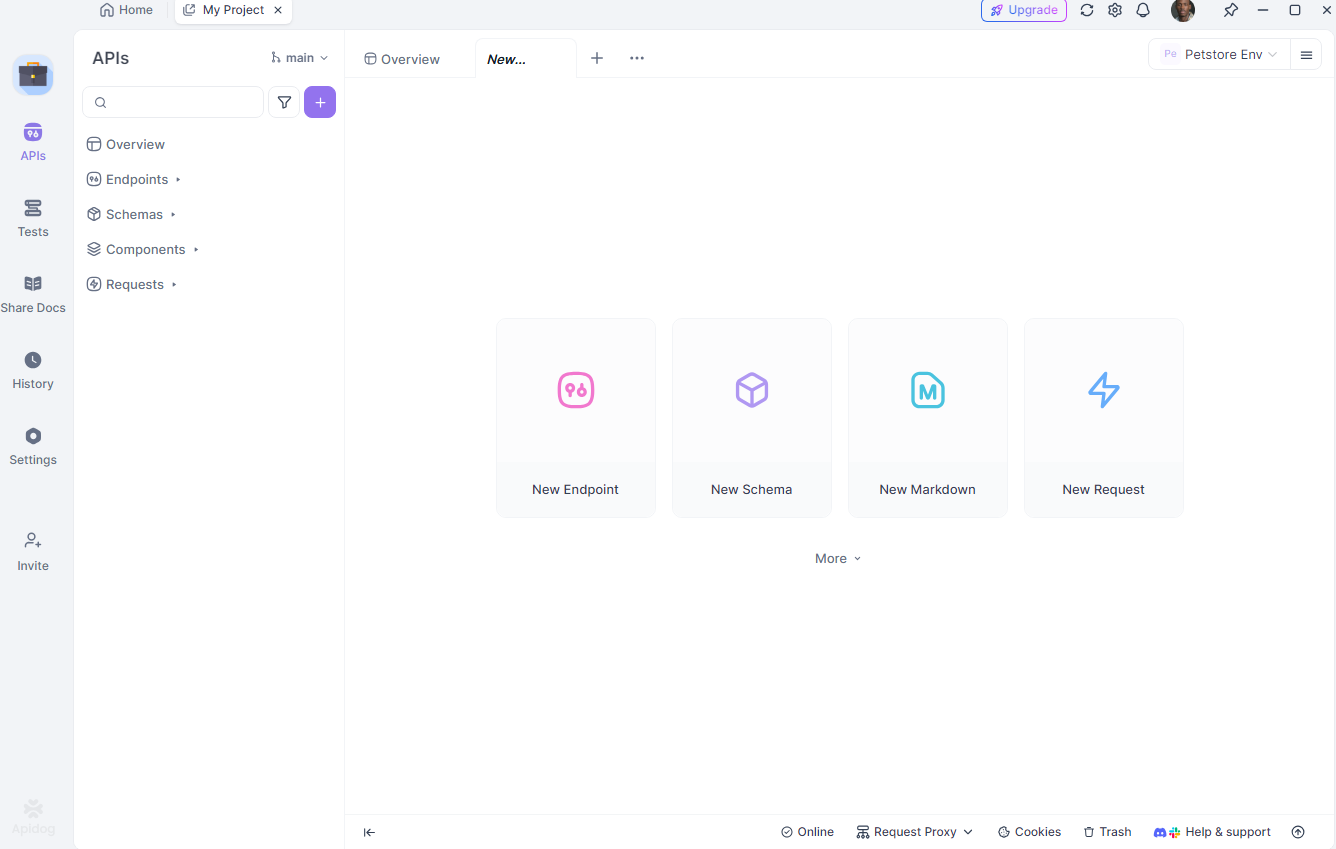

Cài Đặt Apidog

Đầu tiên, tải xuống và cài đặt Apidog từ apidog.com. Sau khi cài đặt, tạo một dự án mới và thêm điểm cuối API Kimi VL Thinking: https://openrouter.ai/api/v1/chat/completions.

Cấu Hình Môi Trường Của Bạn

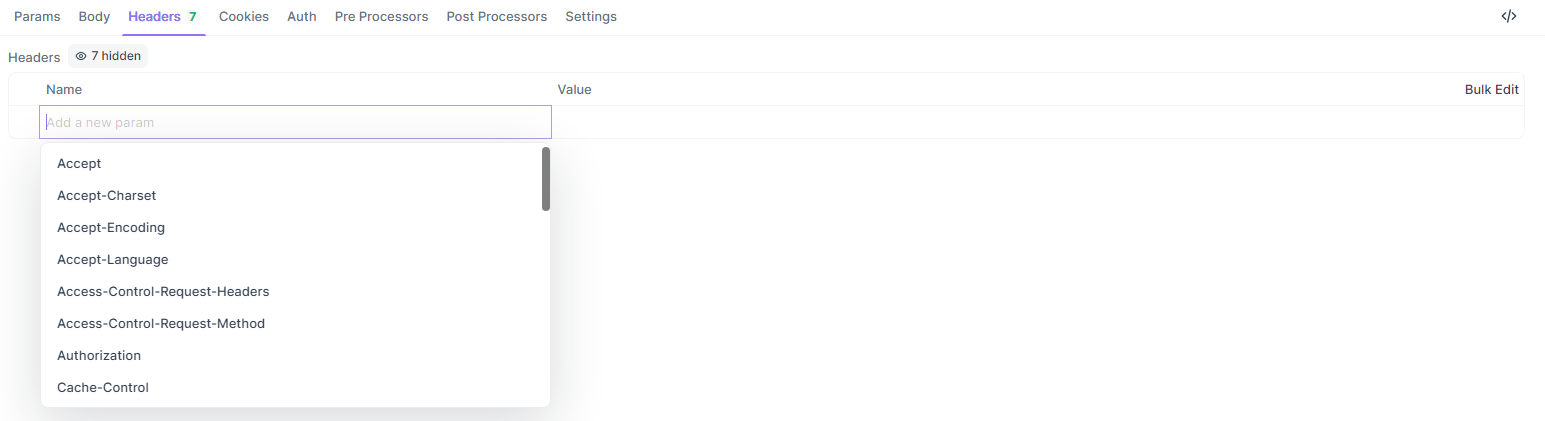

Tiếp theo, thiết lập các môi trường khác nhau (ví dụ: phát triển và sản xuất) trong Apidog. Định nghĩa các biến như khóa API của bạn và URL cơ sở để dễ dàng chuyển đổi giữa các thiết lập. Trong Apidog, chuyển đến tab “Môi Trường” và thêm:

api_key: Khóa API OpenRouter của bạnbase_url:https://openrouter.ai/api/v1

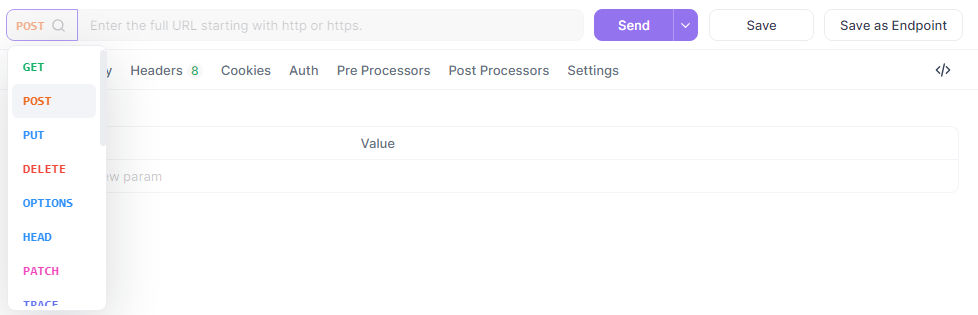

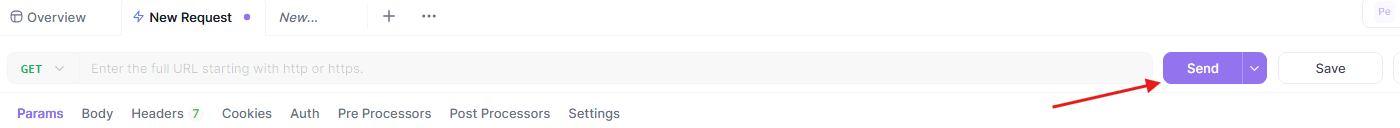

Tạo Yêu Cầu Kiểm Tra

Bây giờ, tạo một yêu cầu POST mới trong Apidog.

Thiết lập URL thành {{base_url}}/chat/completions, thêm tiêu đề của bạn và nhập body JSON:

{

"model": "quasar-alpha",

"messages": [

{"role": "user", "content": "Giải thích sự khác biệt giữa let và const trong JavaScript."}

],

"max_tokens": 300

}

Trong phần tiêu đề, thêm:

Authorization:Bearer {{api_key}}Content-Type:application/json

Chạy và Phân Tích Kiểm Tra

Cuối cùng, gửi yêu cầu và phân tích phản hồi trong giao diện trực quan của Apidog. Apidog cung cấp các báo cáo chi tiết, bao gồm thời gian phản hồi, mã trạng thái và mức sử dụng token. Bạn cũng có thể lưu yêu cầu này dưới dạng kịch bản có thể tái sử dụng cho các kiểm tra sau này.

Khả năng của Apidog trong việc mô phỏng các kịch bản thực tế và tạo ra các báo cáo có thể xuất khẩu khiến nó trở thành một công cụ mạnh mẽ cho việc gỡ lỗi và tối ưu hóa tương tác của bạn với API Kimi VL Thinking. Hãy kết thúc với một số thực tiễn tốt nhất.

Tối Ưu Hóa Các Lời Nhắc Cho Kimi VL Thinking

Kimi VL Thinking xuất sắc trong lý luận từng bước, vì vậy hãy cấu trúc các lời nhắc của bạn để tận dụng khả năng này:

- Rõ Ràng Về Lý Luận: Yêu cầu mô hình "suy nghĩ từng bước" hoặc "lý luận qua vấn đề này một cách cẩn thận."

- Chỉ Một Nhiệm Vụ Tại Một Thời Điểm: Đối với các vấn đề phức tạp, chia nhỏ chúng thành các bước quản lý được thay vì yêu cầu mọi thứ cùng một lúc.

- Cung Cấp Bối Cảnh: Khi có liên quan, hãy cung cấp thông tin nền tảng có thể giúp mô hình hiểu vấn đề tốt hơn.

- Sử Dụng Hướng Dẫn Rõ Ràng: Chỉ rõ chính xác những gì bạn muốn mô hình phân tích trong hình ảnh.

Kết Luận

Kimi VL Thinking thể hiện một thành tựu ấn tượng trong các mô hình ngôn ngữ hình ảnh hiệu quả nhưng mạnh mẽ. Khả năng thực hiện lý luận nâng cao trong khi chỉ kích hoạt 2,8B tham số khiến nó trở thành dễ tiếp cận hơn đối với nhiều người dùng hơn so với các mô hình lớn truyền thống.

Bằng cách tận dụng cấp miễn phí của OpenRouter, bạn có thể thử nghiệm với công nghệ tiên tiến này mà không gặp rào cản chi phí. Dù bạn đang làm việc trong các ứng dụng giáo dục, phân tích dữ liệu, hay tài liệu kỹ thuật, Kimi VL Thinking cung cấp một công cụ mạnh mẽ để hiểu và lý luận về nội dung hình ảnh.

Khi bạn trở nên quen thuộc hơn với mô hình, bạn có thể khám phá các trường hợp sử dụng phức tạp hơn và có thể tích hợp nó vào các ứng dụng sản xuất. Hãy nhớ rằng cấp miễn phí rất thích hợp cho việc thử nghiệm, nhưng đối với các trường hợp sử dụng sản xuất với khối lượng lớn, bạn có thể xem xét nâng cấp lên cấp có phí để đảm bảo độ tin cậy và hiệu suất tốt hơn.

Bắt đầu khám phá Kimi VL Thinking ngay hôm nay và tìm hiểu cách thức các khả năng lý luận hình ảnh tiên tiến có thể nâng cao các dự án của bạn!