Các nhà phát triển xây dựng ứng dụng thông minh thường đối mặt với thách thức trong việc tích hợp các mô hình tiên tiến như GPT-5.2 vào quy trình làm việc của họ. Được OpenAI phát hành như một cột mốc mới nhất về khả năng AI, GPT-5.2 đẩy xa ranh giới trong việc tạo mã, nhận thức hình ảnh và suy luận đa bước. Bạn tích hợp nó không chỉ để thử nghiệm mà còn để triển khai các giải pháp mạnh mẽ, có khả năng mở rộng, xử lý các tác vụ chuyên nghiệp phức tạp. Tuy nhiên, chiều sâu của API—từ việc lựa chọn biến thể đến điều chỉnh tham số—đòi hỏi một phương pháp tiếp cận có cấu trúc. Đó là lúc các công cụ như Apidog xuất hiện, đơn giản hóa việc thiết kế, kiểm thử và tài liệu hóa API để bạn tập trung vào đổi mới thay vì các công việc lặp đi lặp lại.

Hiểu về GPT-5.2: Khả năng cốt lõi và tại sao nó quan trọng đối với các nhà phát triển

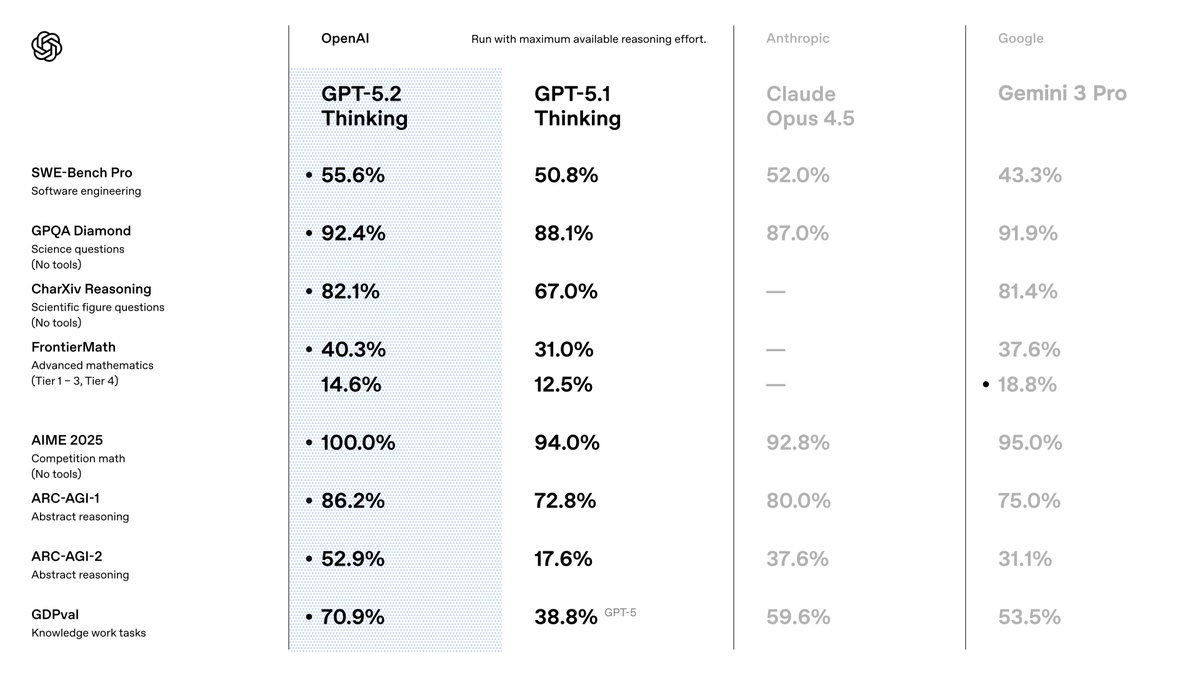

Bạn chọn GPT-5.2 vì nó vượt trội hơn các phiên bản tiền nhiệm về độ chính xác và hiệu quả. OpenAI định vị nó là một bộ công cụ được tối ưu hóa cho công việc trí tuệ, nơi nó đạt được kết quả hàng đầu trên các tiêu chuẩn. Ví dụ, nó đạt 80.0% trên SWE-Bench Verified cho các tác vụ mã hóa, nghĩa là bạn tạo ra các giải pháp phần mềm chính xác hơn với ít lần lặp lại hơn. Hơn nữa, khả năng thị giác của nó giảm một nửa tỷ lệ lỗi trong suy luận biểu đồ, cho phép các ứng dụng như công cụ trực quan hóa dữ liệu tự động.

Khi chuyển từ GPT-5.1, bạn sẽ nhận thấy những cải tiến về tính xác thực—giảm 30% ảo giác trên các truy vấn hỗ trợ tìm kiếm—và khả năng xử lý ngữ cảnh dài, với độ chính xác gần như hoàn hảo lên đến 256k token. Những tính năng này quan trọng vì chúng giảm nhu cầu xử lý hậu kỳ trong quy trình của bạn. Bạn cũng hưởng lợi từ việc gọi công cụ được cải thiện, đạt 98.7% trên các tiêu chuẩn đa lượt, giúp hợp lý hóa các hệ thống tác nhân.

Đối với người dùng API, GPT-5.2 tích hợp liền mạch vào các hệ sinh thái OpenAI hiện có. Bạn truy cập nó thông qua API Chat Completions hoặc Responses, hỗ trợ các tham số như nhiệt độ để kiểm soát sự sáng tạo. Tuy nhiên, thành công phụ thuộc vào việc chọn đúng biến thể. Chúng ta sẽ khám phá những điều đó tiếp theo.

Khám phá các biến thể của GPT-5.2: Điều chỉnh hiệu suất theo nhu cầu của bạn

GPT-5.2 cung cấp các biến thể cân bằng tốc độ, chiều sâu và chi phí, cho phép bạn điều chỉnh hành vi của mô hình theo yêu cầu của tác vụ. Không giống như các mô hình nguyên khối, các tùy chọn này—Instant, Thinking và Pro—cung cấp sự linh hoạt. Bạn kích hoạt chúng thông qua các định danh mô hình cụ thể trong các yêu cầu API của mình.

Hãy bắt đầu với GPT-5.2 Instant (gpt-5.2-chat-latest). Biến thể này ưu tiên độ trễ thấp cho các tương tác hàng ngày, như tìm kiếm thông tin nhanh hoặc viết tài liệu kỹ thuật. Các nhà phát triển ưa chuộng nó cho các chatbot hoặc trợ lý thời gian thực, nơi thời gian phản hồi dưới 200ms là rất cần thiết. Nó xử lý các bản dịch và hướng dẫn với độ chính xác cao, làm cho nó lý tưởng cho các ứng dụng hướng tới người dùng.

Tiếp theo, hãy xem xét GPT-5.2 Thinking (gpt-5.2). Bạn triển khai biến thể này để phân tích sâu hơn, như tóm tắt tài liệu dài hoặc lập kế hoạch logic. Công cụ suy luận của nó xuất sắc trong toán học và ra quyết định, giải quyết 40.3% các bài toán FrontierMath. Sử dụng tham số reasoning ở đây—đặt thành 'high' hoặc 'xhigh'—để khuếch đại chất lượng đầu ra trên các truy vấn phức tạp. Ví dụ, trong các công cụ quản lý dự án, nó điều phối các quy trình làm việc đa bước với lỗi tối thiểu.

Cuối cùng, GPT-5.2 Pro (gpt-5.2-pro) nhắm đến hiệu suất ưu việt trên các lĩnh vực thách thức. Nó đạt 93.2% trên GPQA Diamond cho các câu hỏi khoa học và nổi bật trong lập trình với ít lỗi trường hợp biên hơn. Bạn dành biến thể này cho các nguyên mẫu R&D hoặc các môi trường có rủi ro cao, như mô hình tài chính, nơi độ chính xác quan trọng hơn tốc độ.

Hình ảnh bạn chia sẻ làm nổi bật các nút chuyển đổi cho những biến thể này, bao gồm các chế độ "Max," "Mini," "High," "Low" và "Fast". Chúng phù hợp với nỗ lực suy luận: 'none' cho phản hồi tức thì, 'low' cho các tác vụ cơ bản, lên đến 'xhigh' cho phân tích cặn kẽ. Bạn chuyển đổi chúng thông qua các tham số API, đảm bảo mô hình thích ứng động. Ví dụ, chuyển sang "Max High Fast" cho các phiên mã hóa cân bằng, ưu tiên tốc độ mà không hy sinh chiều sâu.

Bằng cách lựa chọn các biến thể một cách cẩn thận, bạn tối ưu hóa việc sử dụng tài nguyên. Bây giờ, bạn thiết lập quyền truy cập để thực hiện các lệnh gọi này.

Thiết lập quyền truy cập API GPT-5.2 của bạn: Xác thực và chuẩn bị môi trường

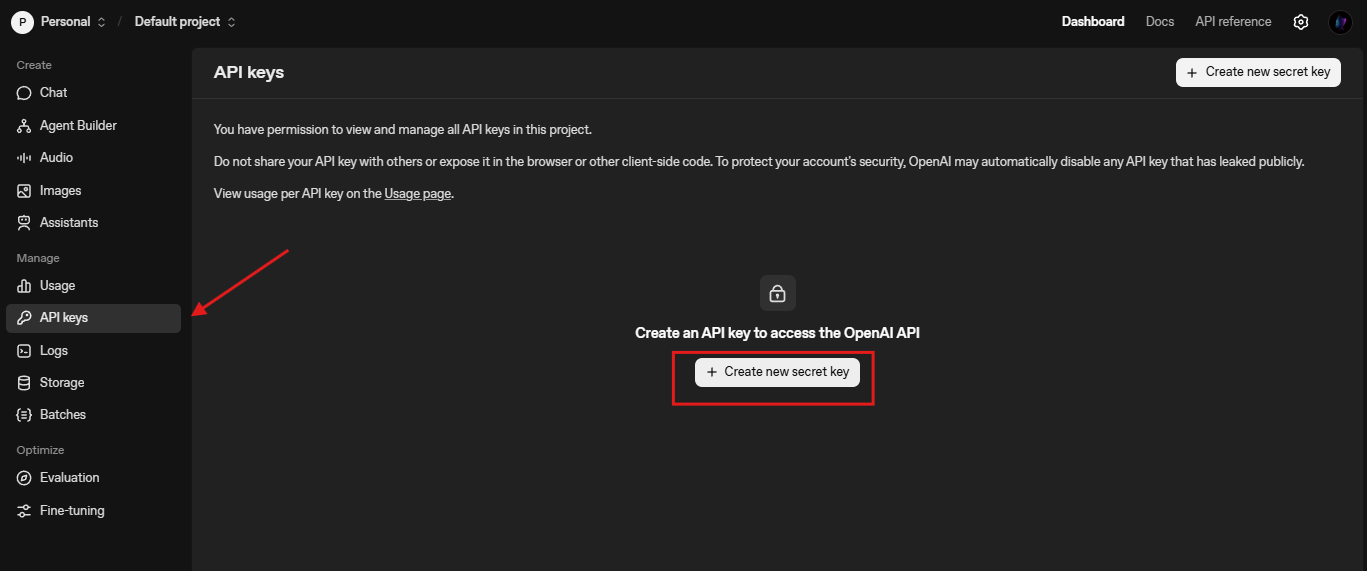

Bạn bắt đầu tích hợp bằng cách bảo mật thông tin đăng nhập API. OpenAI yêu cầu một khóa API, bạn tạo khóa này từ bảng điều khiển nền tảng. Điều hướng đến platform.openai.com, tạo tài khoản nếu cần và cấp một khóa trong phần "API Keys."

Tiếp theo, cài đặt OpenAI Python SDK. Chạy pip install openai trong terminal của bạn. Thư viện này xử lý các yêu cầu HTTP, thử lại và truyền trực tuyến một cách dễ dàng. Đối với người dùng Node.js, npm install openai cung cấp chức năng tương tự. Bạn nhập nó như sau:

from openai import OpenAI

client = OpenAI(api_key=os.getenv("OPENAI_API_KEY"))

Kiểm tra kết nối bằng một lệnh hoàn thành đơn giản:

response = client.chat.completions.create(

model="gpt-5.2-chat-latest",

messages=[{"role": "user", "content": "Explain quantum entanglement briefly."}]

)

print(response.choices[0].message.content)

Lệnh gọi này xác minh thiết lập. Nếu phát sinh lỗi, hãy kiểm tra giới hạn tỷ lệ (mặc định 3.500 RPM cho Cấp 1) hoặc tính hợp lệ của khóa. Bạn cũng cấu hình URL cơ sở cho các endpoint tùy chỉnh, như /compact cho các ngữ cảnh mở rộng: client = OpenAI(base_url="https://api.openai.com/v1", api_key=...).

Với những điều cơ bản đã được thiết lập, bạn khám phá cách tạo yêu cầu.

Tạo các yêu cầu API GPT-5.2 hiệu quả: Các tham số và thực tiễn tốt nhất

Bạn xây dựng các yêu cầu bằng cách sử dụng endpoint Chat Completions (/v1/chat/completions). Phần tải dữ liệu (payload) bao gồm model, messages và các tham số tùy chọn như temperature (0-2 cho tính xác định) và max_tokens (lên đến 4096 đầu ra).

Đối với các tính năng cụ thể của GPT-5.2, hãy tích hợp reasoning_effort để kiểm soát độ sâu:

response = client.chat.completions.create(

model="gpt-5.2",

messages=[{"role": "user", "content": "Write a Python function for Fibonacci sequence."}],

reasoning_effort="high", # Aligns with "Max High" toggle

temperature=0.7,

max_tokens=500

)

Điều này tạo ra mã với suy luận từng bước, giảm lỗi. Bạn liên kết các tin nhắn để tạo cuộc trò chuyện, giữ nguyên ngữ cảnh qua các lượt. Đối với các tác vụ thị giác, tải lên hình ảnh qua content với loại "image_url":

messages = [

{"role": "user", "content": [

{"type": "text", "text": "Describe this chart's trends."},

{"type": "image_url", "image_url": {"url": "https://example.com/chart.png"}}

]}

]

Các thực tiễn tốt nhất bao gồm gộp nhóm yêu cầu để tiết kiệm chi phí và sử dụng truyền trực tuyến (stream=True) cho các giao diện người dùng thời gian thực. Theo dõi việc sử dụng token bằng usage trong các phản hồi để tinh chỉnh lời nhắc. Ngoài ra, hãy bật các công cụ để gọi hàm—xác định lược đồ cho các API bên ngoài, và GPT-5.2 sẽ thực thi chúng một cách tự chủ.

Để kiểm thử hiệu quả những điều này, hãy tích hợp Apidog. Nó giả lập các endpoint của OpenAI, cho phép bạn mô phỏng các biến thể mà không làm ảnh hưởng đến hạn mức trực tiếp.

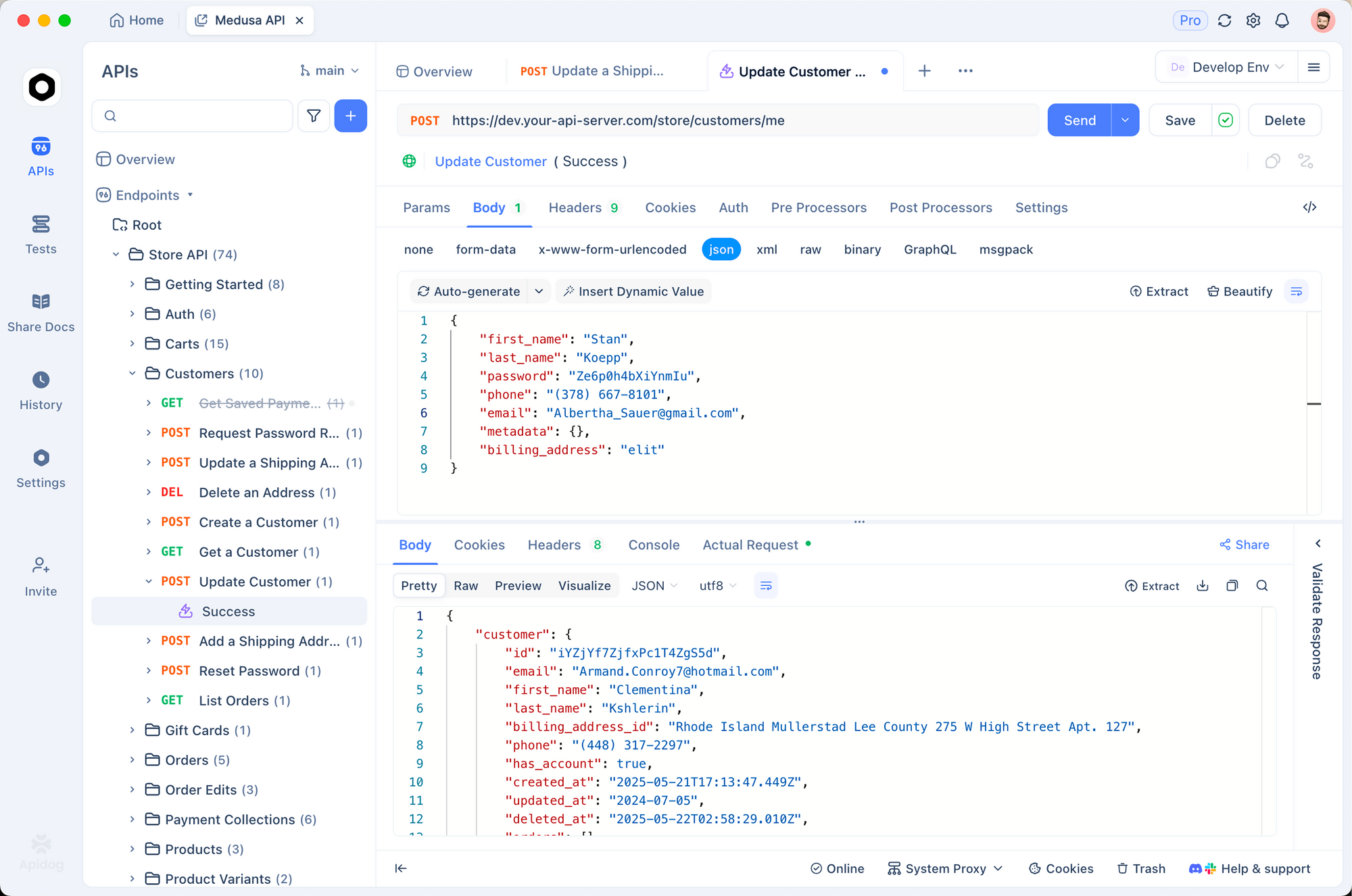

Tích hợp GPT-5.2 với Apidog: Đơn giản hóa kiểm thử và tài liệu hóa

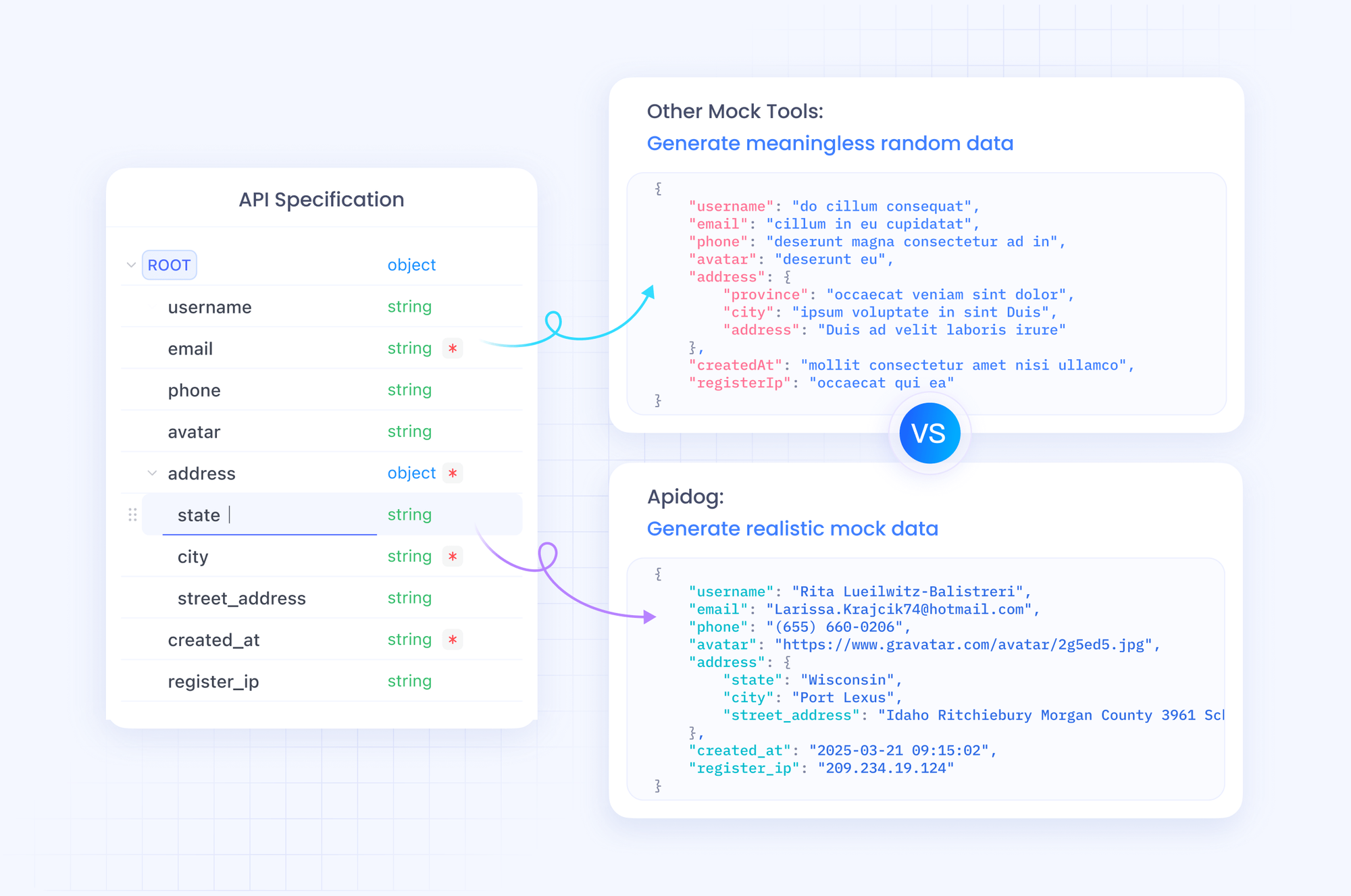

Apidog thay đổi cách bạn quản lý quy trình làm việc API GPT-5.2. Là một nền tảng tất cả trong một, nó hỗ trợ nhập thông số kỹ thuật OpenAPI, xây dựng yêu cầu và kiểm thử tự động. Bạn nhập lược đồ OpenAI vào Apidog, sau đó thiết kế các bộ sưu tập cho các lệnh gọi GPT-5.2.

Bắt đầu bằng cách tạo một dự án mới trong Apidog. Thêm một yêu cầu HTTP đến https://api.openai.com/v1/chat/completions, đặt các tiêu đề (Authorization: Bearer YOUR_KEY, Content-Type: application/json) và dán một nội dung mẫu. Chuyển đổi các biến cho các mô hình như "gpt-5.2-pro" để so sánh các kết quả đầu ra cạnh nhau.

Sức mạnh của Apidog nằm ở máy chủ giả lập của nó. Bạn tạo ra các phản hồi giả lập cấu trúc JSON của GPT-5.2, lý tưởng cho việc phát triển ngoại tuyến. Ví dụ, mô phỏng một phản hồi "Max Extra High" với các dấu vết suy luận chi tiết. Chạy các bài kiểm thử với các khẳng định về số lượng token hoặc tỷ lệ ảo giác.

Hơn nữa, tài liệu hóa API của bạn với trình chỉnh sửa tích hợp của Apidog. Tạo các tài liệu tương tác mà đồng nghiệp sử dụng để khám phá các endpoint. Xuất sang Postman hoặc HAR để dễ dàng di chuyển. Trong sản xuất, Apidog giám sát các lệnh gọi, cảnh báo về các bất thường như độ trễ cao trong các chế độ "Low Fast".

Bằng cách tích hợp Apidog vào quy trình của bạn, bạn tăng tốc lặp lại. Tải xuống miễn phí và nhập yêu cầu GPT-5.2 đầu tiên của bạn—trải nghiệm sự khác biệt chỉ trong vài phút.

Giá API GPT-5.2: Cân bằng chi phí và khả năng một cách chiến lược

Bạn không thể bỏ qua giá cả khi mở rộng ứng dụng GPT-5.2. OpenAI cấu trúc chi phí trên mỗi triệu token, với các bậc phản ánh khối lượng sử dụng. Đối với GPT-5.2 Instant (gpt-5.2-chat-latest), dự kiến $1.75 cho 1 triệu token đầu vào và $14 cho 1 triệu token đầu ra. Các đầu vào được lưu vào bộ nhớ đệm giảm xuống còn $0.175—tiết kiệm 90%—khuyến khích các ngữ cảnh lặp lại.

GPT-5.2 Thinking (gpt-5.2) có mức giá tương tự, làm cho nó hiệu quả về chi phí cho các tác vụ cân bằng. Tuy nhiên, GPT-5.2 Pro (gpt-5.2-pro) đòi hỏi nhiều hơn: $21 cho 1 triệu token đầu vào và $168 cho 1 triệu token đầu ra. Mức giá cao hơn này phản ánh độ chính xác vượt trội của nó đối với các truy vấn cấp chuyên nghiệp, nhưng bạn cần đánh giá cẩn thận ROI (lợi tức đầu tư).

Nhìn chung, GPT-5.2 chứng tỏ hiệu quả về token, thường làm giảm tổng chi tiêu so với GPT-5.1 cho các đầu ra chất lượng. Bạn theo dõi thông qua công cụ phân tích sử dụng trên bảng điều khiển. Đối với các doanh nghiệp, hãy đàm phán các bậc tùy chỉnh. Các công cụ như Apidog giúp dự báo chi phí bằng cách ghi lại các luồng token mô phỏng.

Hiểu rõ các con số này, bạn tiếp tục với các ví dụ thực hành.

Các ví dụ thực tế: Tạo mã và tác vụ thị giác với GPT-5.2

Bạn áp dụng GPT-5.2 trong các kịch bản cụ thể. Hãy xem xét việc tạo mã: Nhắc nó tạo một thành phần React với quản lý trạng thái.

response = client.chat.completions.create(

model="gpt-5.2",

messages=[{"role": "user", "content": "Build a React todo list with useReducer."}],

reasoning_effort="medium"

)

Kết quả đầu ra tạo ra mã sạch, có chú thích—đạt 80% theo tiêu chuẩn. Bạn tinh chỉnh bằng cách lặp lại: Tiếp tục với câu lệnh "Optimize for performance."

Đối với thị giác, hãy phân tích ảnh chụp màn hình. Tải lên một bản thiết kế giao diện người dùng và truy vấn: "Suggest accessibility improvements." GPT-5.2 xác định các vấn đề như độ tương phản màu sắc, tận dụng tỷ lệ lỗi giảm một nửa của nó.

Trong các tác nhân đa công cụ, hãy định nghĩa các hàm cho các truy vấn cơ sở dữ liệu. GPT-5.2 điều phối các lệnh gọi, giảm độ trễ trong các tác nhân lớn với hơn 20 công cụ.

Những ví dụ này cho thấy tính linh hoạt. Tuy nhiên, lỗi vẫn xảy ra—hãy xử lý chúng bằng cách thử lại và dự phòng.

Xử lý lỗi và các trường hợp ngoại lệ trong các lệnh gọi API GPT-5.2

Bạn có thể gặp phải giới hạn tỷ lệ hoặc tham số không hợp lệ. Hãy bao bọc các lệnh gọi trong khối try-except:

try:

response = client.chat.completions.create(...)

except openai.RateLimitError:

time.sleep(60) # Backoff

response = client.chat.completions.create(...)

Đối với các trường hợp ảo giác, hãy kiểm tra chéo với các công cụ tìm kiếm. Trong các ngữ cảnh dài, sử dụng /compact để nén lịch sử. Giám sát các thành kiến trong các ứng dụng nhạy cảm, áp dụng các bộ lọc.

Apidog hỗ trợ ở đây: Viết kịch bản kiểm thử cho các tình huống lỗi, đảm bảo khả năng phục hồi.

Tối ưu hóa nâng cao: Mở rộng quy mô GPT-5.2 cho sản xuất

Bạn mở rộng quy mô bằng cách tinh chỉnh các lời nhắc và sử dụng Assistants API cho các luồng bền vững. Triển khai bộ nhớ đệm cho các đầu vào lặp lại. Đối với các ứng dụng toàn cầu, định tuyến qua các máy chủ biên.

Tích hợp với các framework như LangChain: Xích GPT-5.2 với các kho vector cho các hệ thống RAG.

Cuối cùng, hãy luôn cập nhật—OpenAI lặp lại rất nhanh.

Kết luận: Nắm vững API GPT-5.2 và xây dựng tương lai

Giờ đây bạn đã có trong tay các công cụ để sử dụng GPT-5.2 một cách hiệu quả. Từ việc lựa chọn biến thể đến kiểm thử nâng cao bằng Apidog, hãy áp dụng các bước này để nâng tầm dự án của bạn. Giá cả vẫn hợp lý cho việc sử dụng có cân nhắc, mở khóa các khả năng từng chỉ dành cho phòng thí nghiệm.

Hãy thử nghiệm ngay hôm nay: Tạo nguyên mẫu một tác nhân GPT-5.2 và đo lường lợi ích. Chia sẻ các bản dựng của bạn trong phần bình luận—bạn đối mặt với những thách thức nào? Để tìm hiểu sâu hơn, hãy khám phá tài liệu của OpenAI. Hãy xây dựng một cách táo bạo.