Những tiến bộ đến với tốc độ ngày càng nhanh, và GPT-5.2 là minh chứng mới nhất của OpenAI cho sự đổi mới không ngừng nghỉ. Ra mắt vào ngày 11 tháng 12 năm 2025, mô hình này đã vượt qua các giới hạn về trí tuệ tổng quát, xử lý ngữ cảnh dài, và đặc biệt là các tác vụ mã hóa. Các kỹ sư và nhà phát triển giờ đây có trong tay một công cụ không chỉ hỗ trợ mà còn dự đoán được các quy trình làm việc phức tạp.

Kiến trúc của GPT-5.2: Một Bước Nhảy Vọt về Hiệu Quả của Transformer

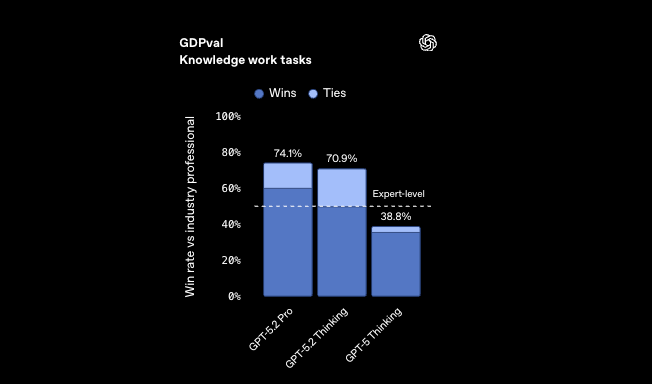

Các kỹ sư của OpenAI đã thiết kế GPT-5.2 để mở rộng quy mô trí tuệ mà không tăng chi phí tính toán một cách tương ứng. Về cơ bản, mô hình sử dụng kiến trúc transformer nâng cao, kết hợp các lớp mixture-of-experts (MoE) để kích hoạt thưa thớt. Phương pháp này chỉ kích hoạt các mạng con liên quan trên mỗi token, giảm độ trễ suy luận lên đến 11 lần so với hiệu suất của chuyên gia con người trên các tác vụ GDPval. Do đó, các nhà phát triển xử lý các tập dữ liệu lớn hơn nhanh hơn, cho phép tạo mã thời gian thực trong các IDE.

Hơn nữa, GPT-5.2 tích hợp các mã hóa vị trí tiên tiến giúp mở rộng cửa sổ ngữ cảnh lên 256k token với khả năng nhớ lại gần như hoàn hảo. Các mô hình truyền thống thường gặp khó khăn khi vượt quá 128k do sự pha loãng của sự chú ý; tuy nhiên, endpoint /compact của GPT-5.2 nén các embedding một cách linh hoạt, bảo toàn độ chính xác ngữ nghĩa. Trong các kịch bản mã hóa, điều này có nghĩa là phân tích toàn bộ kho lưu trữ mà không bị cắt bớt. Ví dụ, khi tái cấu trúc các codebase cũ, mô hình duy trì các phạm vi biến trên các tệp, tránh những cạm bẫy phổ biến của ngữ cảnh bị phân mảnh.

Các cơ chế an toàn được tích hợp sâu vào kiến trúc. GPT-5.2 sử dụng các nguyên tắc AI hiến định, trong đó các mô hình phần thưởng sẽ phạt các lỗi ảo giác trong quá trình tinh chỉnh. Kết quả là, tính xác thực được cải thiện 30% so với GPT-5.1 khi thực hiện các truy vấn đã được ẩn danh. Các nhà phát triển được hưởng lợi trực tiếp: các đoạn mã được tạo ra có ít lỗi cú pháp hoặc mâu thuẫn logic hơn, hợp lý hóa chu kỳ gỡ lỗi.

Chuyển sang các ứng dụng thực tế, GPT-5.2 vượt trội trong các tác vụ đa phương thức. Khả năng thị giác của nó giảm một nửa tỷ lệ lỗi trong việc suy luận biểu đồ, cho phép nó diễn giải các sơ đồ UML hoặc ERD từ ảnh chụp màn hình. Sự tích hợp này chứng tỏ giá trị vô cùng đối với các nhà thiết kế API phác thảo các endpoint bằng hình ảnh trước khi triển khai.

Giải mã các biến thể mã hóa của GPT-5.2: Tùy chỉnh cho mọi quy trình làm việc

GPT-5.2 không ra mắt dưới dạng một khối nguyên khối mà là một bộ các biến thể, mỗi biến thể được tối ưu hóa cho các yêu cầu mã hóa cụ thể. Mặc dù bản phát hành chính thức nhấn mạnh các cấp độ Instant, Thinking và Pro, dòng Codex tập trung vào mã hóa phát triển trong các cấp độ này, biểu hiện dưới dạng các cấu hình chuyên biệt như Codex Max và Mini. Những cấu hình này dựa trên xương sống MoE của mô hình, phân bổ các chuyên gia cho việc phân tích cú pháp, tối ưu hóa thuật toán và dịch từ ngôn ngữ tự nhiên sang mã.

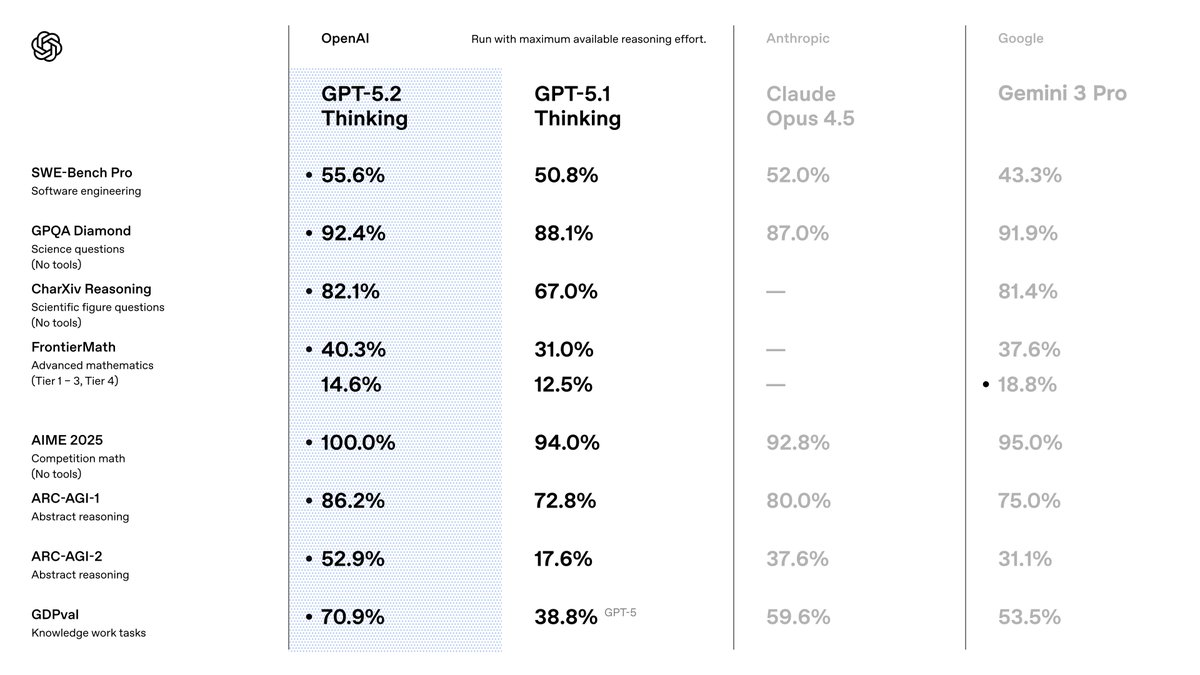

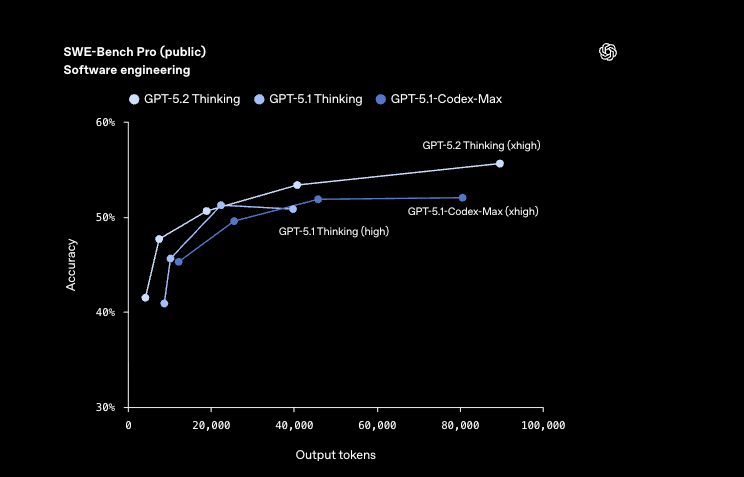

Hãy xem xét GPT-5.2 Codex Max, phiên bản hàng đầu cho các dự án cấp doanh nghiệp. Biến thể này tận dụng khả năng suy luận cấp Pro đầy đủ với nỗ lực xhigh, đạt 55,6% trên SWE-Bench Pro—một benchmark mô phỏng các vấn đề thực tế trên GitHub. Các nhà phát triển kích hoạt nó để sửa lỗi end-to-end, nơi nó tự động gỡ lỗi, tái cấu trúc và triển khai. Ngược lại, GPT-5.2 Codex Mini ưu tiên tốc độ, cung cấp đầu ra với độ trễ dưới một giây cho các tác vụ nhẹ như tạo đoạn mã. Nó phù hợp cho việc tạo mẫu nhanh, nơi các lần lặp nhanh quan trọng hơn việc phân tích kỹ lưỡng.

Các cấu hình khác điều chỉnh sự cân bằng giữa chất lượng và tốc độ. GPT-5.2 Codex Max High cân bằng độ sâu với tốc độ vừa phải, lý tưởng cho việc triển khai tính năng trong các nhóm quy mô vừa. Trong khi đó, GPT-5.2 Codex Low Fast loại bỏ các chuyên gia không cần thiết, tập trung vào mã mẫu như các endpoint RESTful. Biến thể này tỏa sáng trong các pipeline CI/CD, tạo các bài kiểm tra nhanh hơn 40% so với các phiên bản tương đương của GPT-5.1.

Đối với các môi trường có độ rủi ro cao, GPT-5.2 Codex Max Extra High sử dụng các chuỗi suy luận mở rộng, vượt trội trên các benchmark FrontierMath với 40,3%. Nó xử lý suy luận trừu tượng trong mã, chẳng hạn như tối ưu hóa các thuật toán lượng tử hoặc mô hình tài chính. Về hiệu quả, GPT-5.2 Codex Medium Fast tích hợp bộ nhớ cache cho các truy vấn lặp lại, cắt giảm chi phí tới 90% cho các đầu vào đã được lưu trữ.

Các nhà phát triển chọn các biến thể thông qua các tham số API: gpt-5.2-pro cho các cấp Max hoặc gpt-5.2-chat-latest cho các phái sinh Instant. Mỗi biến thể đều hỗ trợ gọi công cụ với độ chính xác 98,7% trên Tau2-bench, cho phép tích hợp liền mạch với các thư viện bên ngoài. Khi chúng ta khám phá các điểm chuẩn tiếp theo, các biến thể này sẽ tiết lộ những lợi thế có thể định lượng được so với các phiên bản tiền nhiệm.

Phân tích điểm chuẩn: GPT-5.2 định nghĩa lại các tiêu chuẩn mã hóa như thế nào

Các điểm chuẩn cung cấp bằng chứng cụ thể về sự ưu việt của GPT-5.2, đặc biệt trong các lĩnh vực mã hóa. Trên SWE-Bench Verified, mô hình đạt 80,0%, tăng 3,7% so với 76,3% của GPT-5.1. Chỉ số này đánh giá các vấn đề GitHub đã được giải quyết, trong đó GPT-5.2 Codex Max tự động vá các lỗ hổng trong các codebase sản xuất. Ví dụ, nó xác định các điều kiện tranh chấp (race conditions) trong các tập lệnh Python đồng thời, đề xuất các giải pháp an toàn luồng với sự gián đoạn tối thiểu.

Hơn nữa, GPQA Diamond đạt độ chính xác 92,4%, vượt trội trong các truy vấn lập trình cấp sau đại học. GPT-5.2 suy luận thông qua các chứng minh thuật toán, tạo ra các giải pháp đã được xác minh thông qua thực thi Python tích hợp. So với 88,1% của GPT-5.1, việc giảm lỗi này đồng nghĩa với ít lần hoàn tác sản xuất hơn cho các nhà phát triển.

Trong mã hóa có hỗ trợ thị giác, GPT-5.2 giảm một nửa lỗi trong việc hiểu giao diện phần mềm. Nó phân tích các bản phác thảo GUI để tự động tạo mã frontend trong React hoặc SwiftUI, duy trì bố cục chính xác từng pixel. Khả năng này mở rộng sang khoa học dữ liệu: trên CharXiv Reasoning với Python, nó đạt 88,7%, tự động hóa các pipeline ETL từ các tập dữ liệu được hình ảnh hóa.

Các điểm chuẩn suy luận trừu tượng càng nhấn mạnh lợi thế của nó. ARC-AGI-1 ở mức 86,2% thể hiện khả năng nhận dạng mẫu trong các câu đố mã hóa mới lạ, như việc đưa ra các thuật toán nén từ các thông số kỹ thuật không đầy đủ. GPT-5.2 Codex High Fast xử lý những vấn đề này trong vòng chưa đầy 5 giây, vượt trội hơn các chuyên gia con người trên GDPval với tỷ lệ thắng 70,9%.

Chuyển sang tác động kinh tế, hiệu quả của GPT-5.2 mang lại tốc độ >11 lần và chi phí <1% so với các chuyên gia trong các tác vụ bảng tính—độ chính xác 68,4% trong các kịch bản ngân hàng đầu tư. Các nhà phát triển tận dụng điều này để tự động hóa các API tài chính, nơi độ chính xác gặp tốc độ.

Quan trọng là, những tiến bộ này đến từ việc đào tạo tinh chỉnh trên các corpus đa dạng, bao gồm kho lưu trữ mã nhiều hơn 10 lần so với GPT-5.1. Tuy nhiên, những thách thức vẫn tồn tại: các trường hợp đặc biệt trong các ngôn ngữ ít tài nguyên như Rust cho thấy sự khác biệt 5-10%. OpenAI giải quyết vấn đề này thông qua việc tinh chỉnh liên tục, hứa hẹn cập nhật hàng quý.

Tích hợp GPT-5.2 với Apidog: Hợp lý hóa phát triển API

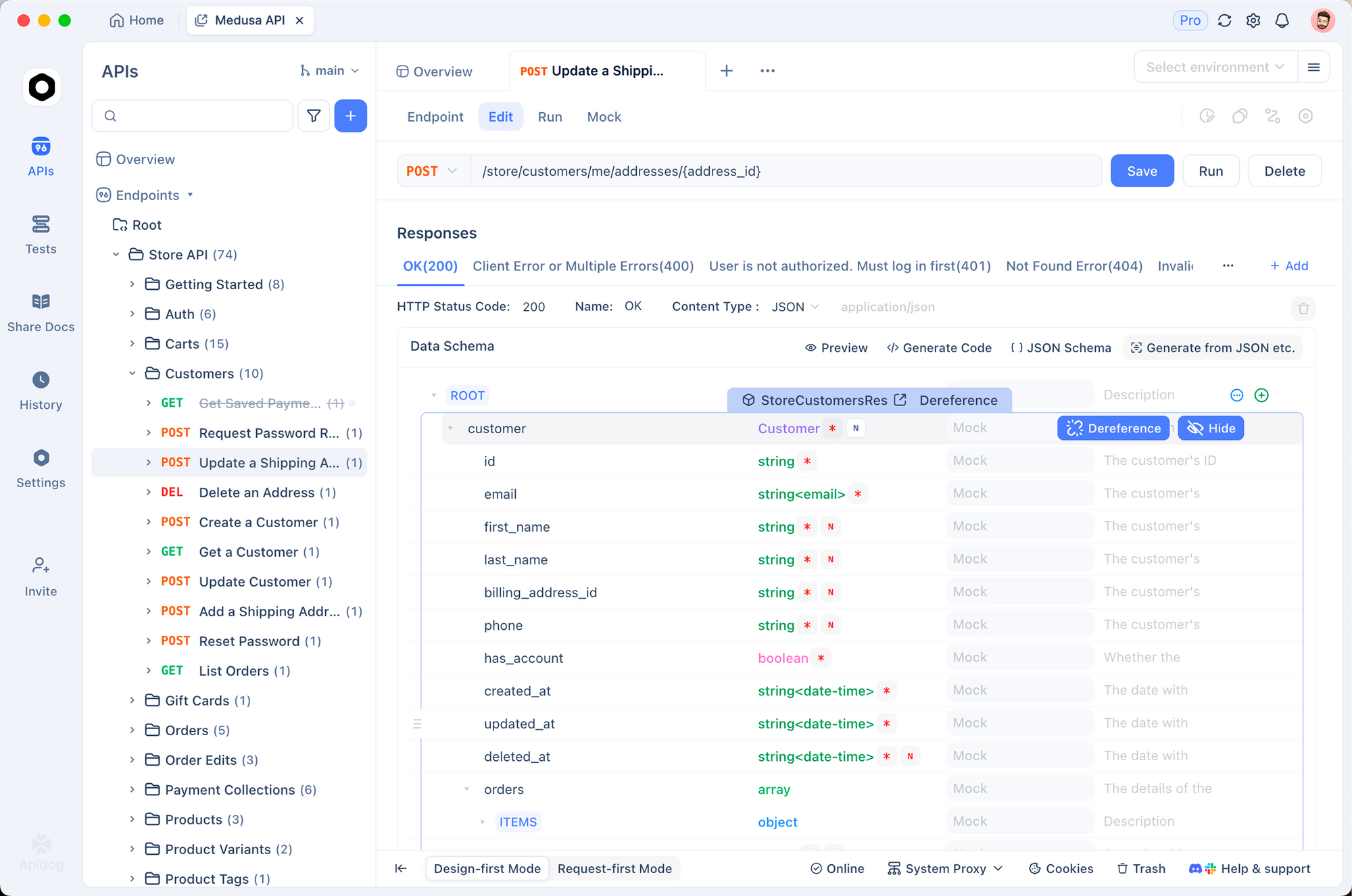

Phát triển API đòi hỏi sự chính xác, và GPT-5.2 kết hợp đặc biệt tốt với Apidog, một nền tảng mạnh mẽ để thiết kế, kiểm thử và tài liệu hóa. Hỗ trợ OpenAPI 3.0 của Apidog hoàn toàn phù hợp với khả năng gọi công cụ của GPT-5.2, cho phép các nhà phát triển tạo định nghĩa schema từ các lời nhắc ngôn ngữ tự nhiên. Chẳng hạn, mô tả một endpoint xác thực người dùng, và GPT-5.2 sẽ xuất ra các đặc tả YAML; Apidog sau đó sẽ trực quan hóa và mô phỏng chúng ngay lập tức.

Hơn nữa, bộ kiểm thử của Apidog xác thực mã do GPT-5.2 tạo ra với các payload thực tế. Tải lên một đầu ra Codex Max cho một API thương mại điện tử, và Apidog sẽ chạy các xác nhận tự động, gắn cờ các lỗi bỏ qua giới hạn tốc độ. Sự kết hợp này giảm thời gian tích hợp 50%, vì các nhà phát triển lặp lại mà không cần chuyển đổi công cụ.

Trong thực tế, hãy bắt đầu với GPT-5.2 Thinking cho logic endpoint: nó tạo ra các trình xử lý với các mẫu chịu lỗi, đạt 100% trên các tác vụ tích hợp toán học AIME 2025. Xuất sang Apidog để cộng tác—các thành viên trong nhóm chú thích schema cùng nhau, đảm bảo tuân thủ các tiêu chuẩn như OAuth 2.0.

Apidog cũng tăng cường các tính năng thị giác của GPT-5.2. Tải lên wireframe, để mô hình suy luận các thao tác CRUD, sau đó tài liệu hóa trong bảng điều khiển tương tác của Apidog. Giá cả phù hợp: GPT-5.2 với 1,75 đô la / 1M token đầu vào bổ sung cho tầng miễn phí của Apidog, giúp việc áp dụng trong doanh nghiệp trở nên khả thi.

Những thách thức phát sinh trong các tương tác đa lượt; tuy nhiên, độ chính xác 98,7% của GPT-5.2 trong việc gọi công cụ đã giảm nhẹ điều này. Các nhà phát triển viết script cho các quy trình làm việc của Apidog để nối chuỗi các cuộc gọi, tự động hóa toàn bộ vòng đời API từ đặc tả đến triển khai.

Hướng đi tương lai: Điều gì nằm ngoài GPT-5.2?

OpenAI gợi ý về vai trò của GPT-5.2 như một nền tảng cho các tác nhân đa phương thức. Các tối ưu hóa Codex sắp tới hứa hẹn các plugin IDE gốc, nhúng mô hình trực tiếp vào VS Code. Hãy mong đợi các tích hợp với các thiết bị biên, chạy các biến thể Mini trên máy tính xách tay để mã hóa ngoại tuyến.

Apidog phát triển song song, thêm tính năng tiến hóa schema có hỗ trợ AI. Các nhà phát triển sẽ nhắc GPT-5.2 cho các API đã được phiên bản hóa, với Apidog tự động xử lý các di chuyển.

Các thách thức bao gồm tiêu thụ năng lượng: việc đào tạo đã tiêu tốn năng lượng ngang với sản lượng của các quốc gia nhỏ, thúc đẩy các thiết kế MoE xanh hơn. Các khung pháp lý yêu cầu sự minh bạch; các đánh giá an toàn của OpenAI, đạt 0.995 về phản hồi sức khỏe tâm thần, đã thiết lập các tiền lệ.

Tóm lại, GPT-5.2 nâng mã hóa từ một nghề thủ công lên thành khoa học. Các biến thể của nó trao quyền cho các quy trình làm việc đa dạng, các điểm chuẩn xác nhận các tuyên bố, và các tích hợp như Apidog làm cho nó dễ tiếp cận. Các nhà phát triển, hãy đón nhận sự thay đổi này—tải xuống Apidog miễn phí và thử nghiệm với GPT-5.2 ngay hôm nay. Tương lai tự mã hóa chính nó.