Bức tranh AI mã nguồn mở vừa chứng kiến một sự thay đổi địa chấn khác. Z.ai, công ty AI Trung Quốc trước đây được biết đến với tên Zhipu, đã phát hành GLM-4.5 và GLM-4.5 Air, hứa hẹn sẽ vượt qua DeepSeek đồng thời thiết lập các tiêu chuẩn mới về hiệu suất và khả năng tiếp cận AI. Những mô hình này không chỉ đại diện cho những cải tiến gia tăng—chúng thể hiện một sự suy nghĩ lại cơ bản về cách suy luận lai và khả năng tác tử nên hoạt động trong môi trường sản xuất.

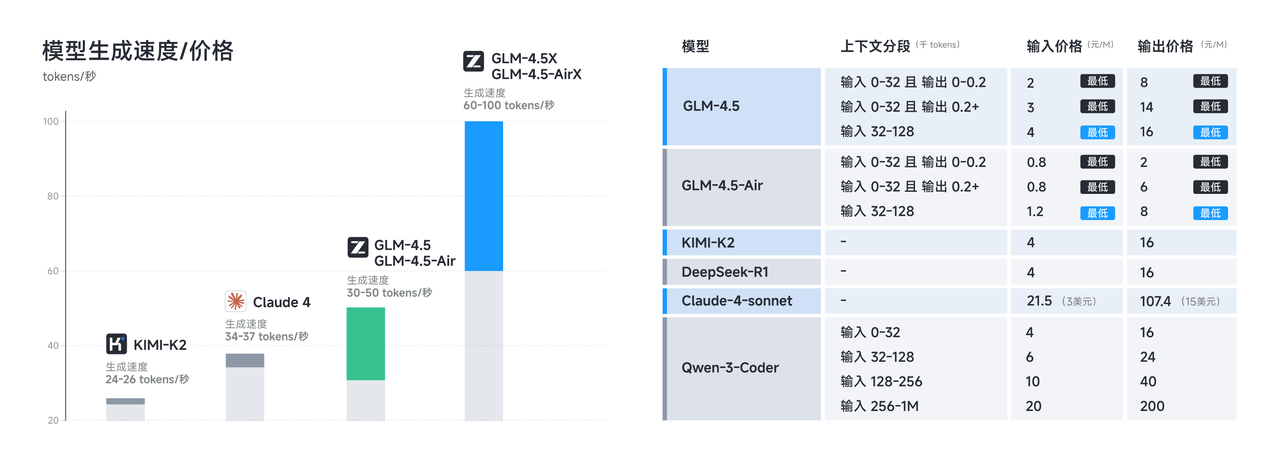

Bản phát hành này đến vào thời điểm quan trọng khi các nhà phát triển ngày càng yêu cầu các lựa chọn thay thế tiết kiệm chi phí cho các mô hình độc quyền mà không phải hy sinh khả năng. Cả GLM-4.5 và GLM-4.5 Air đều thực hiện lời hứa này thông qua các đổi mới kiến trúc tinh vi nhằm tối đa hóa hiệu quả đồng thời duy trì hiệu suất tiên tiến trên các tác vụ suy luận, lập trình và đa phương thức.

Hiểu về Cuộc Cách Mạng Kiến Trúc GLM-4.5

Dòng GLM-4.5 đại diện cho một sự khác biệt đáng kể so với các kiến trúc transformer truyền thống. Được xây dựng trên một kiến trúc tự phát triển hoàn toàn, GLM-4.5 đạt được hiệu suất SOTA trong các mô hình mã nguồn mở thông qua một số đổi mới quan trọng giúp nó nổi bật so với các đối thủ cạnh tranh.

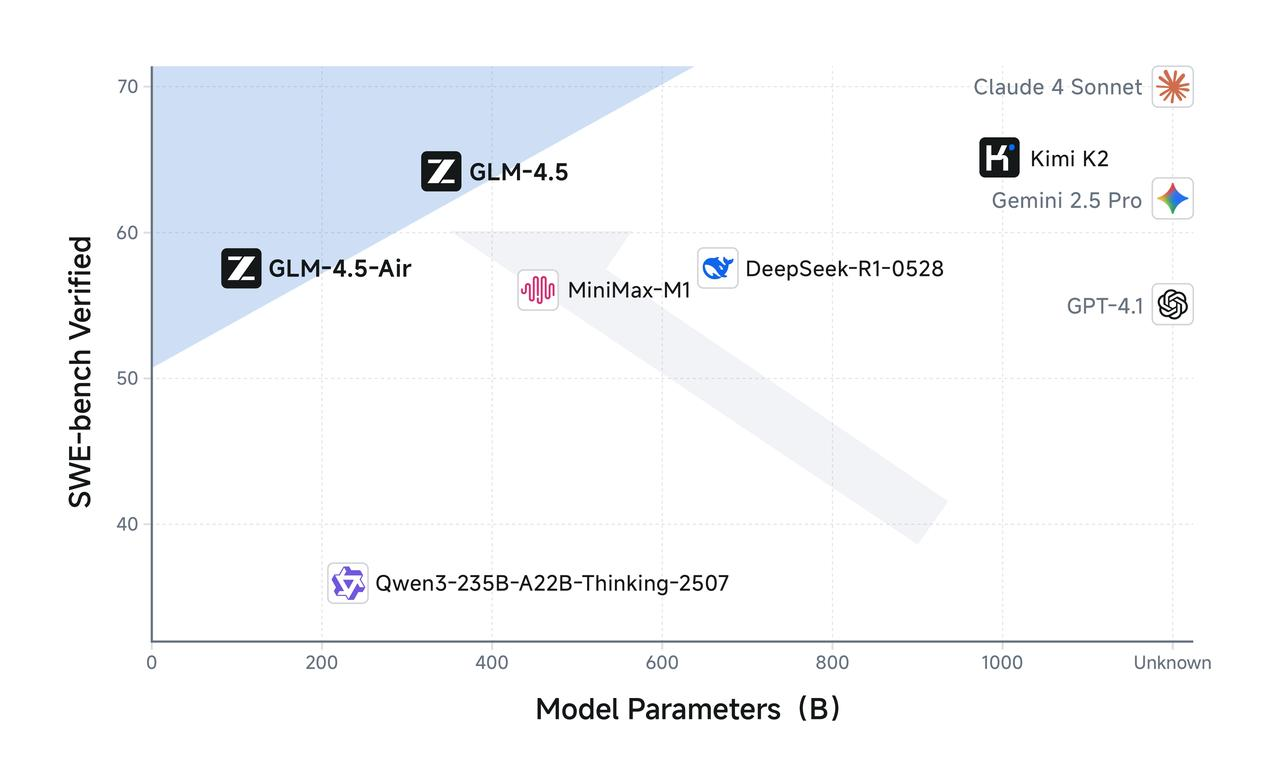

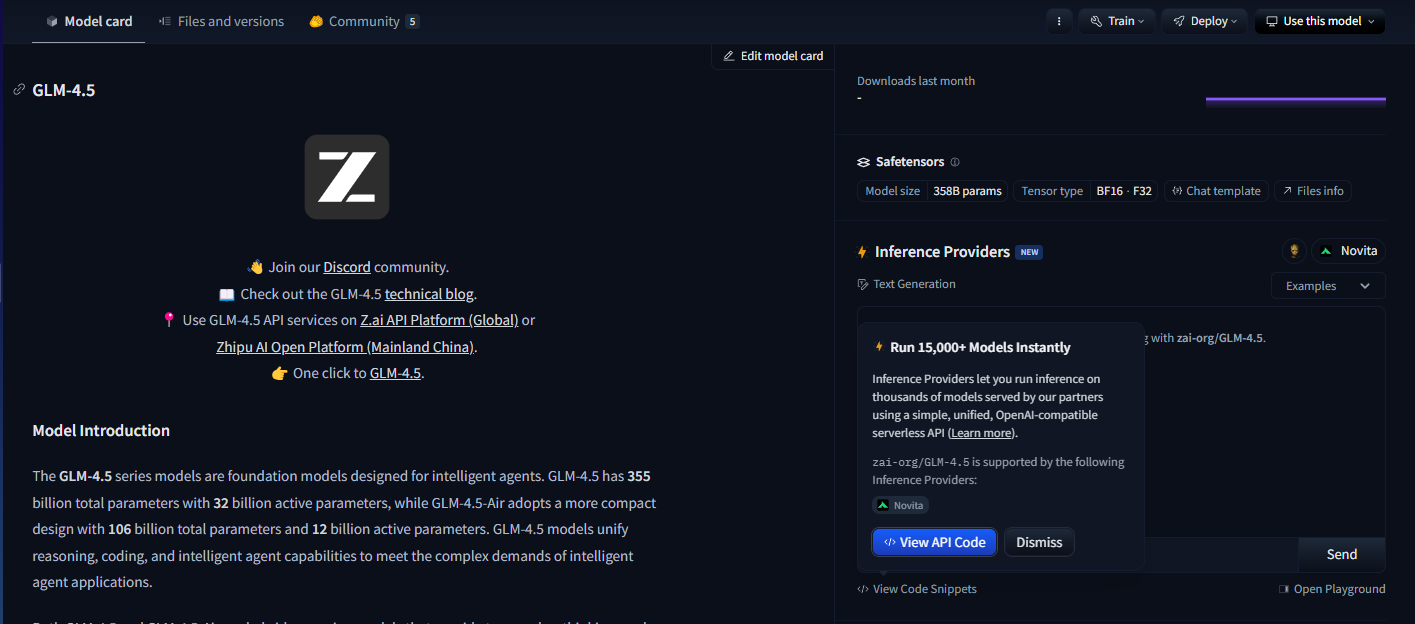

GLM-4.5 có tổng cộng 355 tỷ tham số với 32 tỷ tham số hoạt động, trong khi GLM-4.5 Air áp dụng thiết kế nhỏ gọn hơn với 106 tỷ tham số tổng cộng và 12 tỷ tham số hoạt động. Cấu hình tham số này phản ánh sự cân bằng cẩn thận giữa hiệu quả tính toán và khả năng mô hình, cho phép cả hai mô hình mang lại hiệu suất ấn tượng đồng thời duy trì chi phí suy luận hợp lý.

Các mô hình sử dụng kiến trúc Mixture of Experts (MoE) tinh vi chỉ kích hoạt một tập hợp con các tham số trong quá trình suy luận. Cả hai đều tận dụng thiết kế Mixture of Experts để đạt hiệu quả tối ưu, cho phép GLM-4.5 xử lý các tác vụ phức tạp chỉ bằng 32 tỷ trong số 355 tỷ tham số của nó. Trong khi đó, GLM-4.5 Air duy trì khả năng suy luận tương đương với chỉ 12 tỷ tham số hoạt động từ tổng số 106 tỷ tham số của nó.

Cách tiếp cận kiến trúc này trực tiếp giải quyết một trong những thách thức cấp bách nhất trong việc triển khai mô hình ngôn ngữ lớn: chi phí tính toán của suy luận. Các mô hình dày đặc truyền thống yêu cầu kích hoạt tất cả các tham số cho mỗi hoạt động suy luận, tạo ra gánh nặng tính toán không cần thiết cho các tác vụ đơn giản hơn. Dòng GLM-4.5 giải quyết vấn đề này thông qua định tuyến tham số thông minh phù hợp với độ phức tạp tính toán theo yêu cầu tác vụ.

Hơn nữa, các mô hình hỗ trợ cửa sổ ngữ cảnh đầu vào lên đến 128k và đầu ra 96k, cung cấp khả năng xử lý ngữ cảnh đáng kể cho phép suy luận dạng dài tinh vi và phân tích tài liệu toàn diện. Cửa sổ ngữ cảnh mở rộng này đặc biệt có giá trị cho các ứng dụng tác tử, nơi các mô hình phải duy trì nhận thức về các tương tác đa bước phức tạp.

Đặc Điểm Hiệu Suất Tối Ưu của GLM-4.5 Air

GLM-4.5 Air nổi lên như nhà vô địch về hiệu quả của dòng sản phẩm, được thiết kế đặc biệt cho các kịch bản mà tài nguyên tính toán cần được quản lý cẩn thận. GLM-4.5 Air là một mô hình nền tảng được thiết kế đặc biệt cho các ứng dụng tác tử AI, được xây dựng trên kiến trúc Mixture-of-Experts (MoE) ưu tiên tốc độ và tối ưu hóa tài nguyên mà không ảnh hưởng đến các khả năng cốt lõi.

Biến thể Air chứng minh cách giảm tham số một cách cẩn trọng có thể duy trì chất lượng mô hình đồng thời cải thiện đáng kể khả năng triển khai. Với 106 tỷ tham số tổng cộng và 12 tỷ tham số hoạt động, GLM-4.5 Air đạt được những cải thiện hiệu quả đáng kể, trực tiếp dẫn đến giảm chi phí suy luận và thời gian phản hồi nhanh hơn.

Yêu cầu bộ nhớ là một lĩnh vực khác mà GLM-4.5 Air vượt trội. GLM-4.5 Air yêu cầu 16GB bộ nhớ GPU (lượng tử hóa INT4 khoảng 12GB), giúp các tổ chức có hạn chế phần cứng vừa phải có thể tiếp cận được. Yếu tố khả năng tiếp cận này rất quan trọng để áp dụng rộng rãi, vì nhiều nhóm phát triển không thể biện minh cho chi phí cơ sở hạ tầng liên quan đến các mô hình lớn hơn.

Việc tối ưu hóa không chỉ dừng lại ở hiệu quả tham số thuần túy mà còn bao gồm đào tạo chuyên biệt cho các tác vụ định hướng tác tử. Nó đã được tối ưu hóa rộng rãi cho việc sử dụng công cụ, duyệt web, phát triển phần mềm và phát triển giao diện người dùng, cho phép tích hợp liền mạch với các tác tử lập trình. Chuyên môn hóa này có nghĩa là GLM-4.5 Air mang lại hiệu suất vượt trội trên các tác vụ phát triển thực tế so với các mô hình đa năng có kích thước tương tự.

Độ trễ phản hồi trở nên đặc biệt quan trọng trong các ứng dụng tương tác, nơi người dùng mong đợi phản hồi gần như tức thì. Số lượng tham số giảm và quy trình suy luận được tối ưu hóa của GLM-4.5 Air cho phép thời gian phản hồi dưới một giây cho hầu hết các truy vấn, làm cho nó phù hợp cho các ứng dụng thời gian thực như hoàn thành mã, gỡ lỗi tương tác và tạo tài liệu trực tiếp.

Triển Khai và Lợi Ích của Suy Luận Lai

Đặc điểm nổi bật của cả hai mô hình GLM-4.5 nằm ở khả năng suy luận lai của chúng. Cả GLM-4.5 và GLM-4.5 Air đều là các mô hình suy luận lai cung cấp hai chế độ: chế độ suy nghĩ (thinking mode) cho suy luận phức tạp và sử dụng công cụ, và chế độ không suy nghĩ (non-thinking mode) cho các phản hồi tức thì. Kiến trúc hai chế độ này đại diện cho một sự đổi mới cơ bản trong cách các mô hình AI xử lý các loại tác vụ nhận thức khác nhau.

Chế độ suy nghĩ được kích hoạt khi các mô hình gặp phải các vấn đề phức tạp yêu cầu suy luận đa bước, sử dụng công cụ hoặc phân tích mở rộng. Trong chế độ suy nghĩ, các mô hình tạo ra các bước suy luận trung gian vẫn hiển thị với nhà phát triển nhưng ẩn với người dùng cuối. Sự minh bạch này cho phép gỡ lỗi và tối ưu hóa các quy trình suy luận trong khi vẫn duy trì giao diện người dùng sạch sẽ.

Ngược lại, chế độ không suy nghĩ xử lý các truy vấn đơn giản được hưởng lợi từ phản hồi tức thì mà không có chi phí suy luận mở rộng. Mô hình tự động xác định chế độ nào sẽ sử dụng dựa trên độ phức tạp của truy vấn và ngữ cảnh, đảm bảo sử dụng tài nguyên tối ưu trên các trường hợp sử dụng đa dạng.

Cách tiếp cận lai này giải quyết một thách thức dai dẳng trong các hệ thống AI sản xuất: cân bằng tốc độ phản hồi với chất lượng suy luận. Các mô hình truyền thống hoặc hy sinh tốc độ để suy luận toàn diện hoặc cung cấp phản hồi nhanh nhưng có thể nông cạn. Hệ thống lai của GLM-4.5 loại bỏ sự đánh đổi này bằng cách khớp độ phức tạp suy luận với yêu cầu tác vụ.

Cả hai đều cung cấp chế độ suy nghĩ cho các tác vụ phức tạp và chế độ không suy nghĩ cho các phản hồi tức thì, tạo ra trải nghiệm người dùng liền mạch thích ứng với các yêu cầu nhận thức khác nhau. Các nhà phát triển có thể cấu hình các tham số lựa chọn chế độ để tinh chỉnh sự cân bằng giữa tốc độ và độ sâu suy luận dựa trên các yêu cầu ứng dụng cụ thể.

Chế độ suy nghĩ đặc biệt có giá trị cho các ứng dụng tác tử, nơi các mô hình phải lập kế hoạch hành động đa bước, đánh giá các tùy chọn sử dụng công cụ và duy trì suy luận mạch lạc trong các tương tác mở rộng. Trong khi đó, chế độ không suy nghĩ đảm bảo hiệu suất phản hồi nhanh cho các truy vấn đơn giản như tra cứu thông tin hoặc các tác vụ hoàn thành mã đơn giản.

Thông Số Kỹ Thuật và Chi Tiết Huấn Luyện

Nền tảng kỹ thuật làm nền tảng cho các khả năng ấn tượng của GLM-4.5 phản ánh nỗ lực kỹ thuật rộng lớn và các phương pháp huấn luyện đổi mới. Được huấn luyện trên 15 nghìn tỷ token, với hỗ trợ cửa sổ ngữ cảnh đầu vào lên đến 128k và đầu ra 96k, các mô hình thể hiện quy mô và sự tinh vi cần thiết cho hiệu suất tiên tiến.

Việc quản lý dữ liệu huấn luyện đại diện cho một yếu tố quan trọng trong chất lượng mô hình, đặc biệt đối với các ứng dụng chuyên biệt như tạo mã và suy luận tác tử. Tập dữ liệu huấn luyện 15 nghìn tỷ token kết hợp nhiều nguồn đa dạng bao gồm kho mã nguồn, tài liệu kỹ thuật, ví dụ suy luận và nội dung đa phương thức cho phép hiểu toàn diện trên các lĩnh vực.

Khả năng cửa sổ ngữ cảnh phân biệt GLM-4.5 với nhiều mô hình cạnh tranh. GLM-4.5 cung cấp độ dài ngữ cảnh 128k và khả năng gọi hàm gốc, cho phép phân tích dạng dài tinh vi và các cuộc hội thoại đa lượt mà không bị cắt xén ngữ cảnh. Cửa sổ ngữ cảnh đầu ra 96k đảm bảo các mô hình có thể tạo ra các phản hồi toàn diện mà không có giới hạn độ dài nhân tạo.

Gọi hàm gốc đại diện cho một lợi thế kiến trúc khác loại bỏ nhu cầu về các lớp điều phối bên ngoài. Các mô hình có thể trực tiếp gọi các công cụ và API bên ngoài như một phần của quá trình suy luận của chúng, tạo ra các quy trình làm việc tác tử hiệu quả và đáng tin cậy hơn. Khả năng này rất cần thiết cho các ứng dụng sản xuất, nơi các mô hình phải tương tác với cơ sở dữ liệu, dịch vụ bên ngoài và công cụ phát triển.

Quá trình huấn luyện kết hợp tối ưu hóa chuyên biệt cho các tác vụ tác tử, đảm bảo các mô hình phát triển khả năng mạnh mẽ trong việc sử dụng công cụ, suy luận đa bước và duy trì ngữ cảnh. Kiến trúc thống nhất cho các quy trình làm việc suy luận, lập trình và nhận thức-hành động đa phương thức cho phép chuyển đổi liền mạch giữa các loại tác vụ khác nhau trong một tương tác duy nhất.

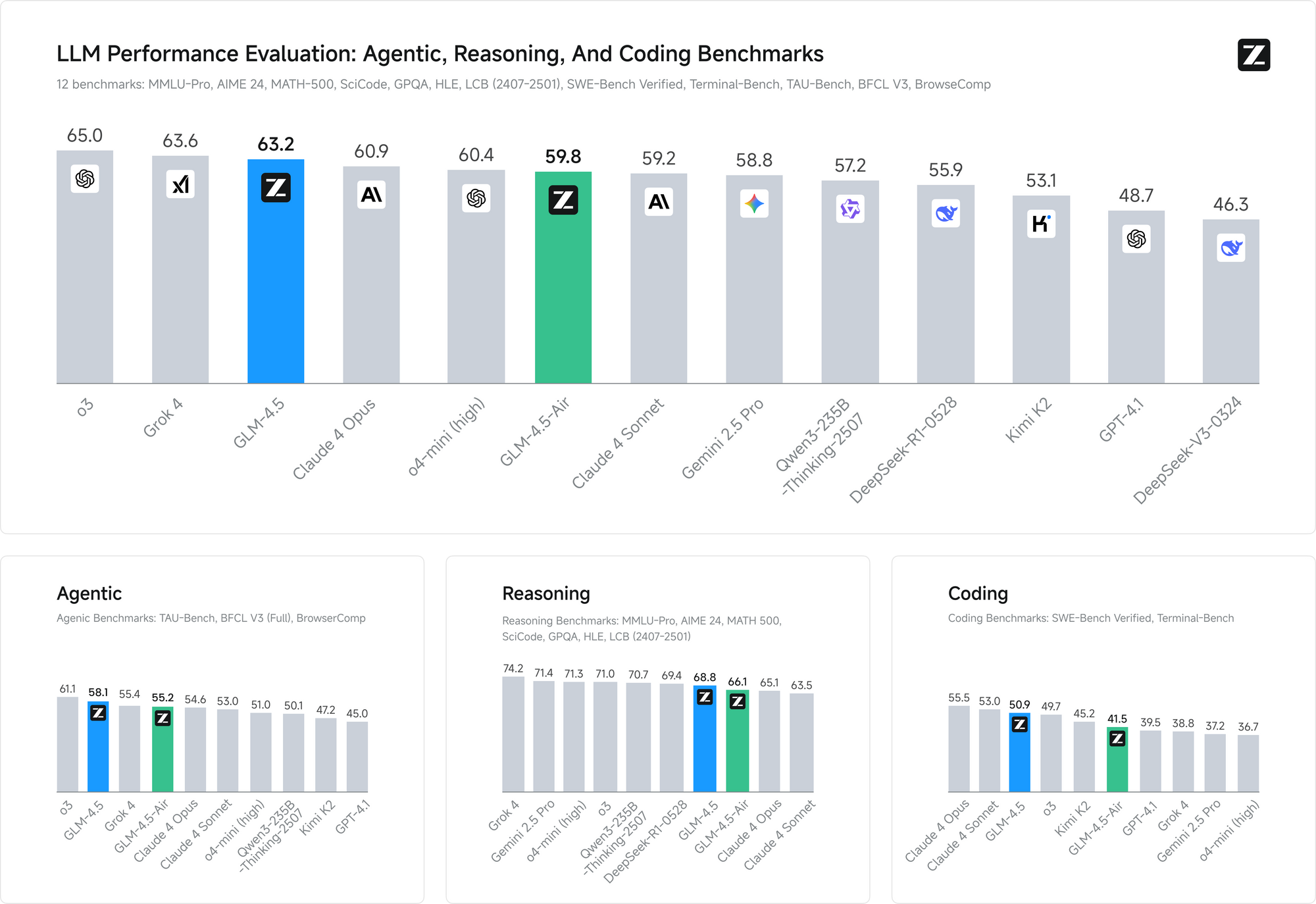

Các điểm chuẩn hiệu suất xác nhận tính hiệu quả của các phương pháp huấn luyện này. Trên cả hai điểm chuẩn, GLM-4.5 khớp với hiệu suất của Claude trong các đánh giá khả năng tác tử, thể hiện khả năng cạnh tranh với các mô hình độc quyền hàng đầu đồng thời duy trì khả năng tiếp cận mã nguồn mở.

Lợi Ích Cấp Phép và Triển Khai Thương Mại

Cấp phép mã nguồn mở đại diện cho một trong những lợi thế cạnh tranh đáng kể nhất của GLM-4.5 trong bối cảnh AI hiện tại. Các mô hình cơ bản, mô hình lai (suy nghĩ/không suy nghĩ) và các phiên bản FP8 đều được phát hành để sử dụng thương mại không hạn chế và phát triển thứ cấp theo giấy phép MIT, cung cấp sự tự do chưa từng có cho việc triển khai thương mại.

Cách tiếp cận cấp phép này loại bỏ nhiều hạn chế đối với các mô hình mã nguồn mở khác. Các tổ chức có thể sửa đổi, phân phối lại và thương mại hóa các triển khai GLM-4.5 mà không phải trả phí cấp phép hoặc hạn chế sử dụng. Giấy phép MIT đặc biệt giải quyết các mối quan tâm thương mại thường làm phức tạp việc triển khai AI doanh nghiệp.

Nhiều Phương Pháp Truy Cập và Tích Hợp Nền Tảng

GLM-4.5 và GLM-4.5 Air cung cấp cho các nhà phát triển nhiều cách truy cập, mỗi cách được tối ưu hóa cho các trường hợp sử dụng và yêu cầu kỹ thuật khác nhau. Hiểu các tùy chọn triển khai này cho phép các nhóm chọn phương pháp tích hợp phù hợp nhất cho các ứng dụng cụ thể của họ.

Trang Web Chính Thức và Truy Cập API Trực Tiếp

Phương pháp truy cập chính bao gồm việc sử dụng nền tảng chính thức của Z.ai tại chat.z.ai, cung cấp giao diện thân thiện với người dùng để tương tác mô hình ngay lập tức. Giao diện dựa trên web này cho phép tạo mẫu nhanh chóng và kiểm thử mà không yêu cầu công việc tích hợp kỹ thuật. Các nhà phát triển có thể đánh giá khả năng mô hình, kiểm thử các chiến lược kỹ thuật nhắc nhở và xác thực các trường hợp sử dụng trước khi cam kết triển khai API.

Truy cập API trực tiếp thông qua các điểm cuối chính thức của Z.ai cung cấp khả năng tích hợp cấp độ sản xuất với tài liệu và hỗ trợ toàn diện. API chính thức cung cấp kiểm soát chi tiết các tham số mô hình, bao gồm lựa chọn chế độ suy luận lai, sử dụng cửa sổ ngữ cảnh và các tùy chọn định dạng phản hồi.

Tích Hợp OpenRouter để Truy Cập Đơn Giản Hóa

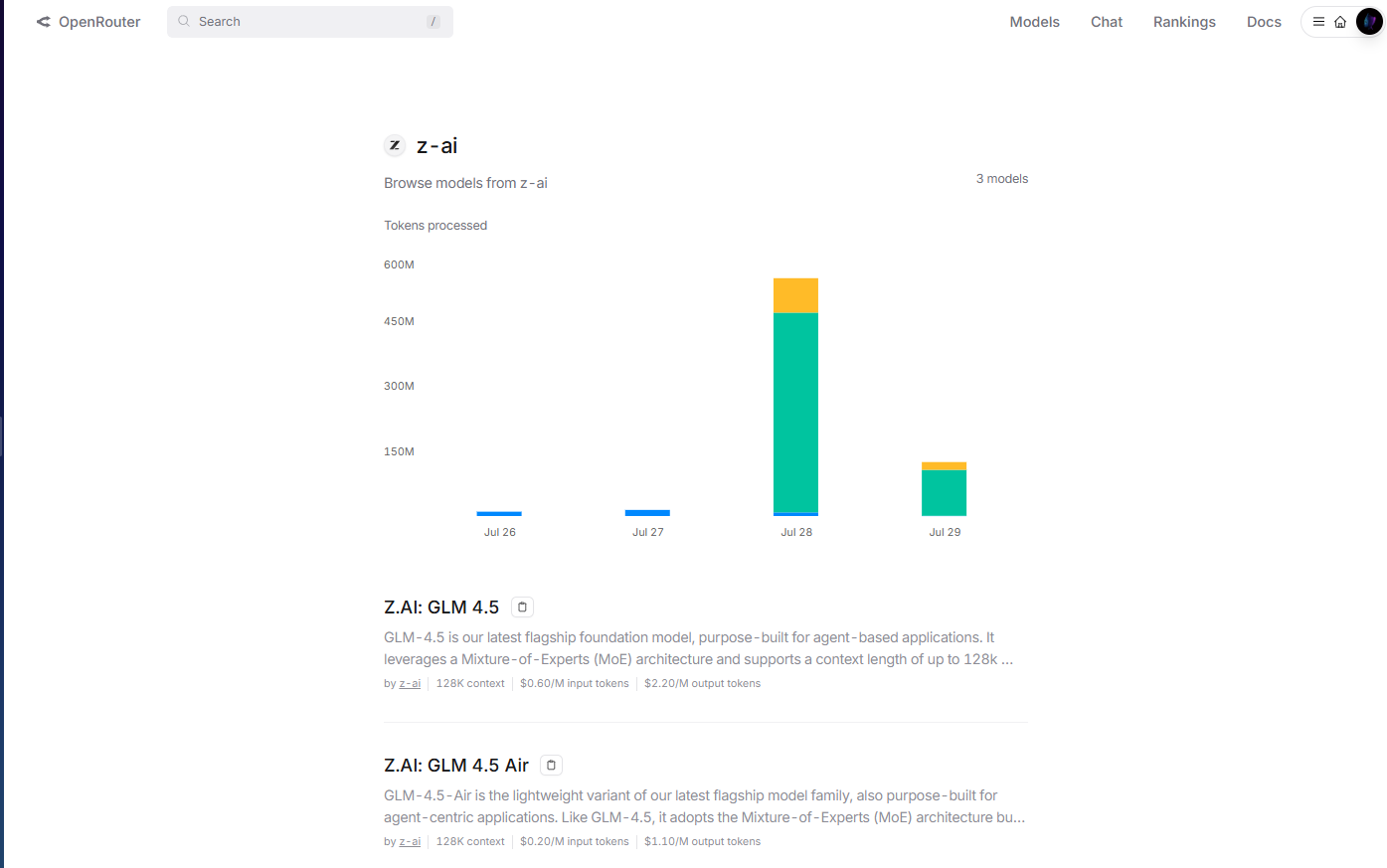

OpenRouter cung cấp quyền truy cập hợp lý vào các mô hình GLM-4.5 thông qua nền tảng API thống nhất của họ tại openrouter.ai/z-ai. Phương pháp tích hợp này đặc biệt có giá trị đối với các nhà phát triển đã sử dụng cơ sở hạ tầng đa mô hình của OpenRouter, vì nó loại bỏ nhu cầu quản lý khóa API và các mẫu tích hợp riêng biệt.

Việc triển khai OpenRouter tự động xử lý xác thực, giới hạn tốc độ và xử lý lỗi, giảm độ phức tạp tích hợp cho các nhóm phát triển. Hơn nữa, định dạng API tiêu chuẩn của OpenRouter cho phép chuyển đổi mô hình dễ dàng và kiểm thử A/B giữa GLM-4.5 và các mô hình có sẵn khác mà không cần sửa đổi mã.

Quản lý chi phí trở nên minh bạch hơn thông qua hệ thống thanh toán hợp nhất của OpenRouter, cung cấp phân tích sử dụng chi tiết và kiểm soát chi tiêu trên nhiều nhà cung cấp mô hình. Cách tiếp cận tập trung này đơn giản hóa việc quản lý ngân sách cho các tổ chức sử dụng nhiều mô hình AI trong ứng dụng của họ.

Hugging Face Hub để Triển Khai Mã Nguồn Mở

Hugging Face Hub lưu trữ các mô hình GLM-4.5, cung cấp các thẻ mô hình toàn diện, tài liệu kỹ thuật và các ví dụ sử dụng do cộng đồng đóng góp. Nền tảng này rất cần thiết cho các nhà phát triển thích các mẫu triển khai mã nguồn mở hoặc yêu cầu tùy chỉnh mô hình rộng rãi.

Tích hợp Hugging Face cho phép triển khai cục bộ bằng thư viện Transformers, mang lại cho các tổ chức toàn quyền kiểm soát việc lưu trữ mô hình và quyền riêng tư dữ liệu. Các nhà phát triển có thể tải xuống trực tiếp trọng số mô hình, triển khai các quy trình suy luận tùy chỉnh và tối ưu hóa cấu hình triển khai cho các môi trường phần cứng cụ thể.

Các Tùy Chọn Triển Khai Tự Lưu Trữ

Các tổ chức có yêu cầu nghiêm ngặt về quyền riêng tư dữ liệu hoặc nhu cầu cơ sở hạ tầng chuyên biệt có thể triển khai các mô hình GLM-4.5 bằng cách sử dụng cấu hình tự lưu trữ. Giấy phép MIT cho phép triển khai không hạn chế trên các môi trường đám mây riêng, cơ sở hạ tầng tại chỗ hoặc kiến trúc lai.

Triển khai tự lưu trữ cung cấp quyền kiểm soát tối đa đối với hành vi mô hình, cấu hình bảo mật và các mẫu tích hợp. Các tổ chức có thể triển khai các hệ thống xác thực tùy chỉnh, cơ sở hạ tầng giám sát chuyên biệt và tối ưu hóa theo miền mà không phụ thuộc vào bên ngoài.

Triển khai dựa trên container bằng Docker hoặc Kubernetes cho phép các triển khai tự lưu trữ có thể mở rộng, có thể thích ứng với các yêu cầu khối lượng công việc khác nhau. Các mẫu triển khai này đặc biệt có giá trị đối với các tổ chức có chuyên môn điều phối container hiện có.

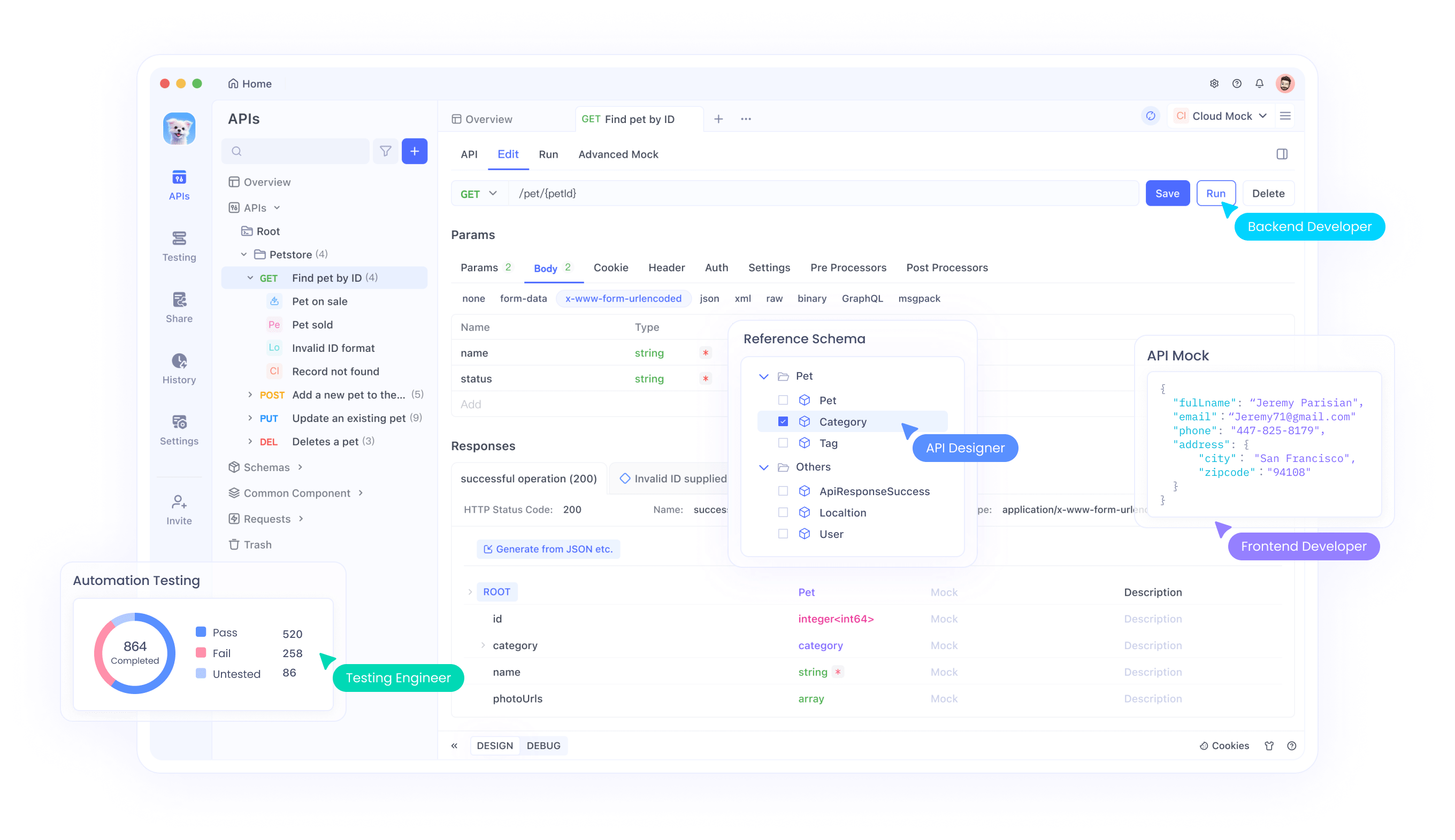

Tích Hợp Với Quy Trình Làm Việc Phát Triển Sử Dụng Apidog

Phát triển AI hiện đại yêu cầu các công cụ tinh vi để quản lý hiệu quả việc tích hợp mô hình, kiểm thử và quy trình làm việc triển khai trên các phương pháp truy cập khác nhau này. Apidog cung cấp các khả năng quản lý API toàn diện giúp hợp lý hóa việc tích hợp GLM-4.5 bất kể cách tiếp cận triển khai được chọn.

Khi triển khai các mô hình GLM-4.5 trên các nền tảng khác nhau—cho dù thông qua OpenRouter, truy cập API trực tiếp, triển khai Hugging Face hay cấu hình tự lưu trữ—các nhà phát triển phải xác thực hiệu suất trên các trường hợp sử dụng đa dạng, kiểm thử các cấu hình tham số khác nhau và đảm bảo xử lý lỗi đáng tin cậy. Khung kiểm thử API của Apidog cho phép đánh giá có hệ thống các phản hồi mô hình, đặc tính độ trễ và các mẫu sử dụng tài nguyên trên tất cả các phương pháp triển khai này.

Khả năng tạo tài liệu của nền tảng đặc biệt có giá trị khi triển khai GLM-4.5 thông qua nhiều phương pháp truy cập cùng lúc. Các nhà phát triển có thể tự động tạo tài liệu API toàn diện bao gồm các tùy chọn cấu hình mô hình, lược đồ đầu vào/đầu ra và các ví dụ sử dụng cụ thể cho khả năng suy luận lai của GLM-4.5 trên OpenRouter, API trực tiếp và triển khai tự lưu trữ.

Các tính năng cộng tác trong Apidog tạo điều kiện chia sẻ kiến thức giữa các nhóm phát triển làm việc với các triển khai GLM-4.5. Các thành viên trong nhóm có thể chia sẻ cấu hình kiểm thử, tài liệu các phương pháp hay nhất và cộng tác trên các mẫu tích hợp nhằm tối đa hóa hiệu quả của mô hình.

Khả năng quản lý môi trường đảm bảo triển khai GLM-4.5 nhất quán trên các môi trường phát triển, thử nghiệm (staging) và sản xuất, bất kể các nhóm có sử dụng dịch vụ được quản lý của OpenRouter, tích hợp API trực tiếp hay triển khai tự lưu trữ. Các nhà phát triển có thể duy trì các cấu hình riêng biệt cho các môi trường khác nhau đồng thời đảm bảo các mẫu triển khai có thể tái tạo.

Chiến Lược Triển Khai và Các Thực Hành Tốt Nhất

Triển khai thành công các mô hình GLM-4.5 yêu cầu xem xét cẩn thận các yêu cầu cơ sở hạ tầng, kỹ thuật tối ưu hóa hiệu suất và các mẫu tích hợp nhằm tối đa hóa hiệu quả của mô hình. Các tổ chức nên đánh giá các trường hợp sử dụng cụ thể của họ dựa trên khả năng mô hình để xác định cấu hình triển khai tối ưu.

Yêu cầu phần cứng khác nhau đáng kể giữa GLM-4.5 và GLM-4.5 Air, cho phép các tổ chức chọn các biến thể phù hợp với hạn chế cơ sở hạ tầng của họ. Các nhóm có cơ sở hạ tầng GPU mạnh mẽ có thể tận dụng mô hình GLM-4.5 đầy đủ để đạt khả năng tối đa, trong khi các môi trường hạn chế tài nguyên có thể thấy GLM-4.5 Air cung cấp hiệu suất đủ ở chi phí cơ sở hạ tầng giảm.

Tinh chỉnh mô hình đại diện cho một cân nhắc quan trọng khác đối với các tổ chức có yêu cầu chuyên biệt. Giấy phép MIT cho phép tùy chỉnh mô hình toàn diện, cho phép các nhóm điều chỉnh GLM-4.5 cho các ứng dụng chuyên biệt theo miền. Tuy nhiên, tinh chỉnh yêu cầu quản lý tập dữ liệu cẩn thận và chuyên môn huấn luyện để đạt được kết quả tối ưu.

Cấu hình chế độ lai yêu cầu tinh chỉnh tham số cẩn thận để cân bằng tốc độ phản hồi với chất lượng suy luận. Các ứng dụng có yêu cầu độ trễ nghiêm ngặt có thể ưu tiên các cài đặt mặc định chế độ không suy nghĩ tích cực hơn, trong khi các ứng dụng ưu tiên chất lượng suy luận có thể hưởng lợi từ ngưỡng chế độ suy nghĩ thấp hơn.

Các mẫu tích hợp API nên tận dụng khả năng gọi hàm gốc của GLM-4.5 để tạo ra các quy trình làm việc tác tử hiệu quả. Thay vì triển khai các lớp điều phối bên ngoài, các nhà phát triển có thể dựa vào khả năng sử dụng công cụ tích hợp sẵn của mô hình để giảm độ phức tạp của hệ thống và cải thiện độ tin cậy.

Các Vấn Đề Bảo Mật và Quản Lý Rủi Ro

Triển khai các mô hình mã nguồn mở như GLM-4.5 đưa ra các vấn đề bảo mật mà các tổ chức phải giải quyết thông qua các chiến lược quản lý rủi ro toàn diện. Sự sẵn có của trọng số mô hình cho phép kiểm tra bảo mật kỹ lưỡng nhưng cũng yêu cầu xử lý cẩn thận để ngăn chặn truy cập trái phép hoặc lạm dụng.

Bảo mật suy luận mô hình yêu cầu bảo vệ chống lại các đầu vào đối nghịch có thể làm tổn hại hành vi mô hình hoặc trích xuất thông tin nhạy cảm từ dữ liệu huấn luyện. Các tổ chức nên triển khai xác thực đầu vào, lọc đầu ra và hệ thống phát hiện bất thường để xác định các tương tác có khả năng gây vấn đề.

Bảo mật cơ sở hạ tầng triển khai trở nên quan trọng khi lưu trữ các mô hình GLM-4.5 trong môi trường sản xuất. Các thực hành bảo mật tiêu chuẩn bao gồm cô lập mạng, kiểm soát truy cập và mã hóa áp dụng cho việc triển khai mô hình AI giống như đối với các ứng dụng truyền thống.

Các vấn đề về quyền riêng tư dữ liệu yêu cầu sự chú ý cẩn thận đến luồng thông tin giữa các ứng dụng và mô hình GLM-4.5. Các tổ chức phải đảm bảo rằng các đầu vào dữ liệu nhạy cảm nhận được sự bảo vệ thích hợp và các đầu ra mô hình không vô tình tiết lộ thông tin bí mật.

Bảo mật chuỗi cung ứng mở rộng đến nguồn gốc mô hình và xác minh tính toàn vẹn. Các tổ chức nên xác thực checksum mô hình, xác minh nguồn tải xuống và triển khai các kiểm soát để đảm bảo các mô hình được triển khai khớp với cấu hình dự định.

Bản chất mã nguồn mở của GLM-4.5 cho phép kiểm tra bảo mật toàn diện, mang lại lợi thế so với các mô hình độc quyền mà các thuộc tính bảo mật vẫn còn mơ hồ. Các tổ chức có thể phân tích kiến trúc mô hình, đặc điểm dữ liệu huấn luyện và các lỗ hổng tiềm ẩn thông qua kiểm tra trực tiếp thay vì dựa vào các cam kết bảo mật của nhà cung cấp.

Kết Luận

GLM-4.5 và GLM-4.5 Air đại diện cho những tiến bộ đáng kể trong khả năng AI mã nguồn mở, mang lại hiệu suất cạnh tranh đồng thời duy trì khả năng tiếp cận và tính linh hoạt định hình các dự án mã nguồn mở thành công. Z.ai đã phát hành mô hình cơ sở thế hệ tiếp theo GLM-4.5 của mình, đạt được hiệu suất SOTA trong các mô hình mã nguồn mở thông qua các đổi mới kiến trúc giải quyết các thách thức triển khai trong thế giới thực.

Kiến trúc suy luận lai chứng minh cách thiết kế cẩn trọng có thể loại bỏ sự đánh đổi truyền thống giữa tốc độ phản hồi và chất lượng suy luận. Đổi mới này cung cấp một khuôn mẫu cho việc phát triển mô hình trong tương lai, ưu tiên tiện ích thực tế hơn là hiệu suất điểm chuẩn thuần túy.

Lợi thế về hiệu quả chi phí giúp GLM-4.5 có thể tiếp cận được với các tổ chức trước đây coi khả năng AI tiên tiến là quá đắt đỏ. Sự kết hợp giữa chi phí suy luận giảm và cấp phép cho phép tạo ra cơ hội triển khai AI trên nhiều ngành công nghiệp và quy mô tổ chức khác nhau.