Các nhà phát triển trên toàn cầu tin tưởng vào CodeX, trợ lý mã hóa mạnh mẽ được hỗ trợ bởi AI của OpenAI, để tối ưu hóa quy trình làm việc và giải quyết các tác vụ lập trình phức tạp. Tuy nhiên, các cuộc thảo luận gần đây trên các nền tảng như X cho thấy một mối lo ngại ngày càng tăng: nhiều người dùng nhận thấy CodeX mang lại kết quả không tối ưu so với hiệu suất ban đầu. Bạn gặp phải các lỗi khó chịu, phản hồi chậm hơn hoặc gợi ý mã không đầy đủ, và bạn tự hỏi liệu công cụ này có thực sự đã suy giảm. Nhận thức này vẫn tồn tại bất chấp những tuyên bố của OpenAI về việc cải tiến liên tục và các số liệu cho thấy mức độ sử dụng tăng trưởng.

Các kỹ sư báo cáo những trường hợp CodeX gặp khó khăn với các tác vụ phức tạp, chẳng hạn như áp dụng các bản vá hoặc xử lý các cuộc hội thoại kéo dài, dẫn đến giả định về sự xuống cấp. Tuy nhiên, nhóm của OpenAI tích cực giải quyết các vấn đề này thông qua các cuộc điều tra nghiêm ngặt, thể hiện cam kết về tính minh bạch. Ví dụ, họ gần đây đã công bố một báo cáo chi tiết phác thảo các phát hiện từ phản hồi của người dùng và các đánh giá nội bộ.

Tìm hiểu về CodeX: Chức năng cốt lõi và sự phát triển của nó

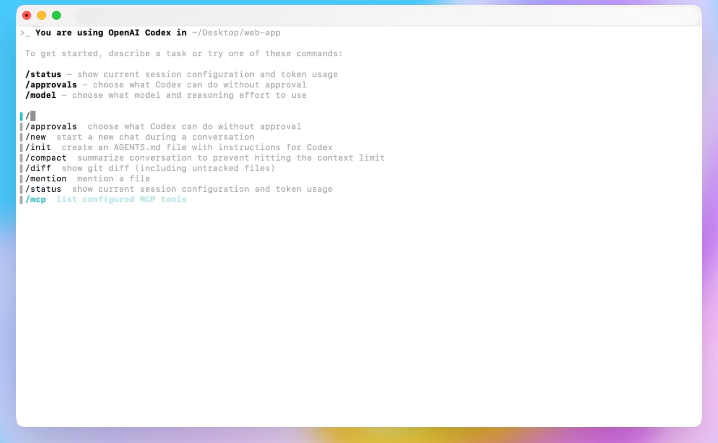

CodeX đại diện cho một bước tiến đáng kể trong lập trình được hỗ trợ bởi AI, xây dựng trên nền tảng của OpenAI về các mô hình ngôn ngữ lớn. Các kỹ sư thiết kế CodeX để diễn giải các lời nhắc ngôn ngữ tự nhiên và tạo ra các đoạn mã, gỡ lỗi các vấn đề, và thậm chí quản lý toàn bộ kho lưu trữ. Không giống như các plugin IDE truyền thống, CodeX tích hợp sâu với giao diện dòng lệnh và trình soạn thảo, cho phép tương tác liền mạch.

OpenAI đã ra mắt CodeX như một sự phát triển của các mô hình trước đó như Codex, kết hợp các cải tiến từ kiến trúc GPT-5. Lần lặp này tập trung vào tính bền bỉ, cho phép AI thử lại các tác vụ và thích ứng với phản hồi của người dùng trong các phiên làm việc. Do đó, các nhà phát triển sử dụng CodeX cho nhiều ứng dụng khác nhau, từ viết script đơn giản đến tích hợp hệ thống phức tạp.

Tuy nhiên, khi việc áp dụng ngày càng tăng, người dùng đã đẩy CodeX đến giới hạn. Ví dụ, các tác vụ ban đầu có thể liên quan đến các chức năng cơ bản, nhưng người dùng nâng cao cố gắng chỉnh sửa nhiều tệp hoặc điều phối API. Sự thay đổi này tiết lộ những hạn chế, đặt ra câu hỏi về tính nhất quán của hiệu suất.

Hơn nữa, CodeX sử dụng các công cụ như apply_patch để sửa đổi tệp và compaction để quản lý ngữ cảnh. Các tính năng này nâng cao khả năng sử dụng nhưng lại đưa vào các biến số ảnh hưởng đến kết quả. Khi bạn nhập một lời nhắc, CodeX xử lý nó thông qua API phản hồi, API này truyền các token và phân tích kết quả. Bất kỳ sự khác biệt nào trong quy trình này đều có thể biểu hiện thành sự "giảm trí thông minh" được cảm nhận.

Báo cáo của người dùng: Dấu hiệu cho thấy CodeX có thể đang hoạt động kém hiệu quả

Người dùng tích cực chia sẻ kinh nghiệm trên các nền tảng xã hội, nêu bật những trường hợp CodeX không đáp ứng được kỳ vọng. Chẳng hạn, một nhà phát triển trên X đã lưu ý rằng CodeX xuất sắc trong các tác vụ ban đầu nhưng lại gặp khó khăn với độ phức tạp leo thang, dẫn đến những giả định về sự suy giảm của mô hình.

Cụ thể, các báo cáo bao gồm việc CodeX tạo ra các diff không chính xác trong quá trình áp dụng bản vá, dẫn đến việc xóa và tạo lại tệp. Hành vi này làm gián đoạn quy trình làm việc, đặc biệt trong các phiên bị gián đoạn. Một khiếu nại phổ biến khác liên quan đến độ trễ; các tác vụ từng hoàn thành nhanh chóng giờ đây kéo dài do thử lại với thời gian chờ kéo dài.

Hơn nữa, người dùng quan sát thấy việc chuyển đổi ngôn ngữ giữa phản hồi, chẳng hạn như chuyển từ tiếng Anh sang tiếng Hàn, được cho là do lỗi trong lấy mẫu bị hạn chế. Những bất thường này ảnh hưởng đến chưa đến 0,25% các phiên nhưng làm tăng sự thất vọng khi gặp phải.

Ngoài ra, compaction—một tính năng tóm tắt các cuộc hội thoại để quản lý ngữ cảnh—nhận được nhiều chỉ trích. Khi các phiên kéo dài, nhiều lần compaction làm giảm độ chính xác, khiến OpenAI phải thêm cảnh báo: bắt đầu các cuộc hội thoại mới cho các tương tác có mục tiêu.

Hơn nữa, các biến thể phần cứng cũng góp phần; các thiết lập cũ hơn mang lại hiệu suất giảm nhẹ, ảnh hưởng đến khả năng giữ chân người dùng. Các nhà phát triển trên các gói cao cấp báo cáo sự không nhất quán, mặc dù các số liệu cho thấy sự tăng trưởng tổng thể.

Chuyển từ những báo cáo này, việc phân tích bằng chứng định lượng cung cấp sự rõ ràng về việc liệu những vấn đề này có cho thấy sự suy giảm thực sự hay sự phát triển trong cách sử dụng.

Phân tích bằng chứng: Số liệu, phản hồi và các mẫu sử dụng

OpenAI thu thập dữ liệu rộng rãi về hiệu suất của CodeX, bao gồm các đánh giá trên các phiên bản CLI và phần cứng. Các đánh giá xác nhận những cải tiến, chẳng hạn như giảm 10% mức sử dụng token sau các bản cập nhật CLI 0.45, mà không có sự suy giảm trong các tác vụ cốt lõi.

Tuy nhiên, phản hồi của người dùng thông qua lệnh /feedback tiết lộ các xu hướng. Các kỹ sư xử lý hơn 100 vấn đề hàng ngày, liên kết chúng với phần cứng hoặc tính năng cụ thể. Các mô hình dự đoán tương quan khả năng giữ chân người dùng với các yếu tố như hệ điều hành và loại gói, xác định phần cứng là một nguyên nhân nhỏ.

Ngoài ra, phân tích phiên cho thấy việc sử dụng compaction tăng lên theo thời gian, tương quan với sự sụt giảm hiệu suất. Các đánh giá định lượng điều này: độ chính xác giảm khi compaction lặp lại.

Hơn nữa, tích hợp tìm kiếm web (--search) và các thay đổi lời nhắc trong hơn hai tháng không cho thấy tác động tiêu cực. Tuy nhiên, sự kém hiệu quả của bộ nhớ đệm xác thực làm tăng thêm 50ms độ trễ cho mỗi yêu cầu, làm tăng thêm nhận thức của người dùng.

Hơn nữa, việc sử dụng đang phát triển; nhiều nhà phát triển sử dụng các công cụ MCP, làm tăng độ phức tạp của thiết lập. OpenAI khuyến nghị các cấu hình tối giản để có kết quả tối ưu.

Do đó, bằng chứng cho thấy nhận thức xuất phát từ việc đẩy CodeX vào các tác vụ khó hơn chứ không phải do sự giảm trí thông minh vốn có. Như một người dùng X đã tóm tắt, "codex tốt đến mức mọi người cứ cố gắng sử dụng nó cho các tác vụ khó hơn và nó không làm tốt những tác vụ đó, rồi mọi người chỉ đơn giản là cho rằng mô hình đã tệ đi."

Phân tích này đặt nền tảng cho phản hồi điều tra của OpenAI, giải quyết trực tiếp những điểm này.

Phản hồi của OpenAI: Cuộc điều tra minh bạch về hiệu suất của CodeX

OpenAI cam kết minh bạch, hứa sẽ điều tra nghiêm túc các báo cáo suy giảm. Tibo, một thành viên nhóm Codex, đã công bố cuộc điều tra trên X, phác thảo một kế hoạch nâng cấp cơ chế phản hồi, tiêu chuẩn hóa việc sử dụng nội bộ và chạy các đánh giá bổ sung.

Các kỹ sư đã thực hiện nhanh chóng, phát hành CLI 0.50 với /feedback được cải thiện, liên kết các vấn đề với các cụm và phần cứng. Họ đã loại bỏ hơn 60 cờ tính năng, đơn giản hóa ngăn xếp.

Hơn nữa, một đội ngũ chuyên trách đã đưa ra giả thuyết và kiểm tra các vấn đề hàng ngày. Cách tiếp cận này đã khám phá ra các bản sửa lỗi, từ việc loại bỏ phần cứng cũ hơn đến tinh chỉnh compaction.

Ngoài ra, OpenAI đã chia sẻ một báo cáo toàn diện có tựa đề "Ghosts in the Codex Machine," trình bày chi tiết các phát hiện mà không có sự suy giảm lớn nhưng thừa nhận các yếu tố kết hợp.

Hơn nữa, họ đã đặt lại giới hạn tốc độ và hoàn lại tín dụng do lỗi thanh toán, thể hiện các hành động lấy người dùng làm trung tâm.

Chuyển sang các chi tiết cụ thể, các phát hiện chính của báo cáo làm sáng tỏ các sắc thái kỹ thuật đằng sau những lo ngại của người dùng.

Các phát hiện chính từ Báo cáo suy giảm của CodeX của OpenAI

Báo cáo kết luận không có một vấn đề lớn nào tồn tại; thay vào đó, sự thay đổi trong hành vi và các vấn đề nhỏ tích lũy. Đối với phần cứng, các đánh giá và mô hình đã chỉ ra các đơn vị cũ hơn, dẫn đến việc loại bỏ chúng và tối ưu hóa cân bằng tải.

Về compaction, tần suất cao hơn theo thời gian làm suy giảm các phiên. OpenAI đã cải thiện các triển khai để tránh các tóm tắt đệ quy và thêm các lời nhắc cho người dùng.

Đối với apply_patch, các lỗi hiếm gặp gây ra các hành động xóa rủi ro; các biện pháp giảm thiểu hạn chế các chuỗi như vậy, với các cải tiến mô hình được lên kế hoạch.

Thời gian chờ không thấy sự suy giảm rộng rãi nào—độ trễ được cải thiện—nhưng các lần thử lại không hiệu quả vẫn tồn tại. Các khoản đầu tư nhắm mục tiêu xử lý quy trình dài tốt hơn.

Một lỗi lấy mẫu bị hạn chế gây ra các token ngoài phân phối, sẽ được khắc phục ngay lập tức.

Kiểm toán API phản hồi tiết lộ các thay đổi mã hóa nhỏ mà không ảnh hưởng đến hiệu suất.

Các cuộc thăm dò khác, như đánh giá trên các phiên bản CLI và lời nhắc, xác nhận sự ổn định.

Hơn nữa, các thiết lập đang phát triển với nhiều công cụ hơn khuyến nghị sự đơn giản.

Những phát hiện này xác nhận trải nghiệm của người dùng đồng thời chứng minh không có sự suy giảm trí thông minh tổng thể.

Các cải tiến đã triển khai và định hướng tương lai cho CodeX

OpenAI hành động dựa trên các phát hiện, triển khai các bản sửa lỗi như cảnh báo compaction và hiệu chỉnh lấy mẫu. Việc loại bỏ phần cứng và giảm độ trễ giúp tăng cường độ tin cậy.

Hơn nữa, họ thành lập một nhóm thường trực để giám sát hiệu suất thực tế, tuyển dụng nhân tài cho các tối ưu hóa liên tục.

Ngoài ra, việc xã hội hóa phản hồi được tăng cường, đảm bảo đầu vào liên tục.

Công việc trong tương lai bao gồm cải thiện tính bền bỉ của mô hình và khả năng thích ứng của công cụ.

Do đó, CodeX phát triển, giải quyết các nhận thức thông qua các cải tiến dựa trên dữ liệu.

Tuy nhiên, trong khi chờ đợi những điều này, các nhà phát triển tìm kiếm các công cụ bổ trợ như Apidog.

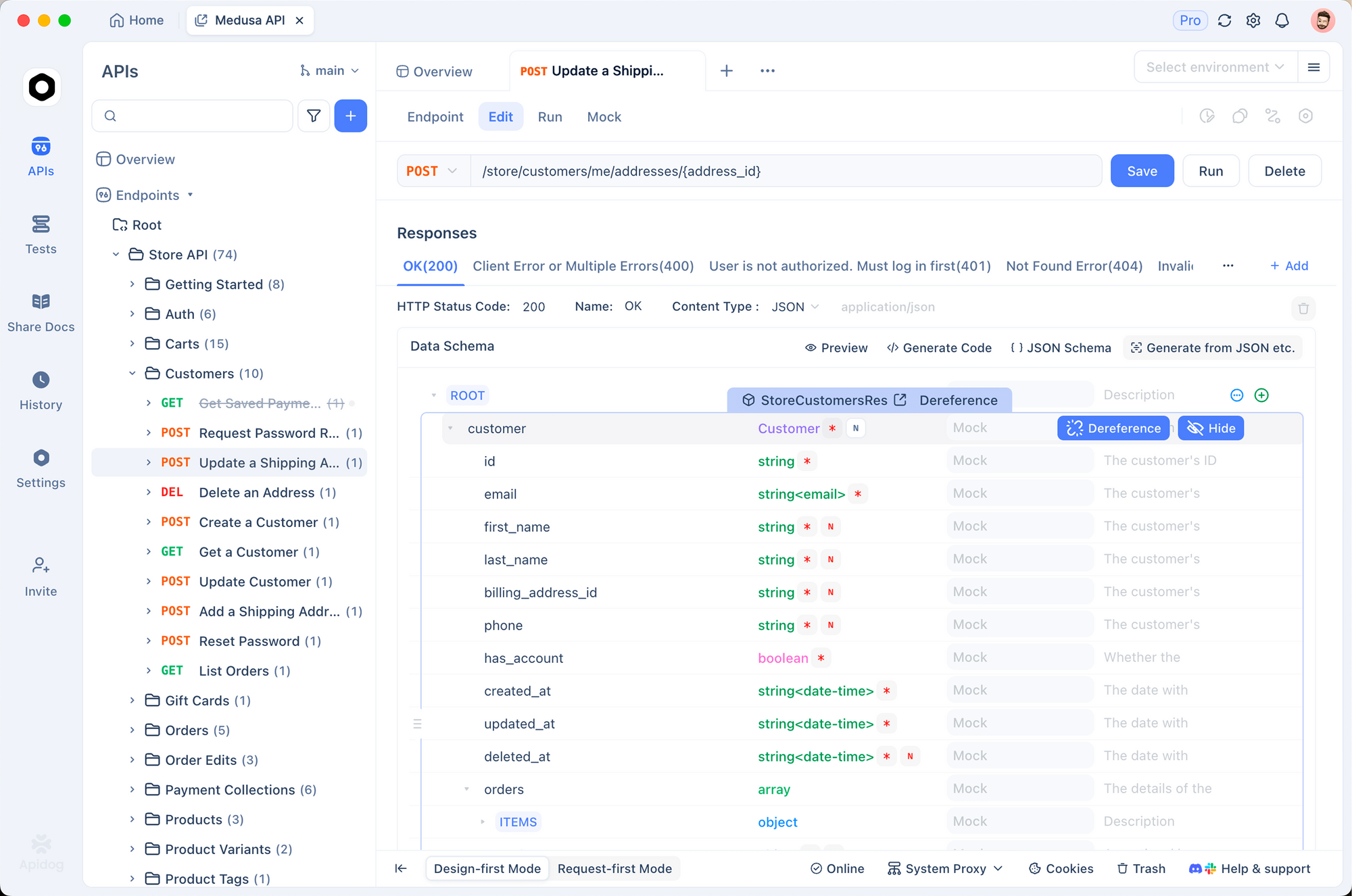

Các công cụ bổ trợ: Apidog nâng cao quy trình làm việc của CodeX như thế nào

Khi CodeX xử lý các tác vụ API, sự không nhất quán phát sinh, đặc biệt trong các tích hợp. Apidog, một nền tảng API mạnh mẽ, lấp đầy khoảng trống này.

Các nhà phát triển sử dụng Apidog để thiết kế, kiểm thử và tài liệu hóa API, đảm bảo mã do CodeX tạo ra hoạt động chính xác.

Ví dụ, mô phỏng các điểm cuối trong Apidog trước khi triển khai CodeX, giảm lỗi.

Hơn nữa, Apidog có thể tải xuống miễn phí, cung cấp các tính năng cộng tác, quản lý phiên bản và tự động hóa—lý tưởng cho các nhóm đối mặt với những hạn chế của CodeX.

Chuyển đổi một cách suôn sẻ, Apidog tích hợp với các môi trường mã hóa, xác thực các đầu ra của AI.

Do đó, việc kết hợp CodeX với Apidog tối ưu hóa quá trình phát triển, giảm thiểu sự suy giảm được cảm nhận.

Các nghiên cứu điển hình: Ví dụ thực tế từ các cuộc thảo luận trên X

Các chủ đề trên X cung cấp những ví dụ sống động. Một người dùng đã nêu bật sự thành công của CodeX tạo ra tham vọng quá mức, lặp lại sự phát triển trong cách sử dụng của báo cáo.

Một người khác đã thảo luận về tốc độ CLI, chuyển sang các lựa chọn thay thế cho các tác vụ nhanh, nhấn mạnh những lo ngại về độ trễ.

Hơn nữa, việc đặt lại thanh toán đã giải quyết các khoản phí quá mức, khôi phục lòng tin.

Những giai thoại này, kết hợp với dữ liệu báo cáo, minh họa các vấn đề đa diện.

Các phương pháp hay nhất để tối đa hóa hiệu suất của CodeX

Để chống lại những nhận thức, hãy áp dụng các phương pháp: giữ các phiên ngắn, giảm thiểu công cụ, sử dụng /feedback.

Hơn nữa, hãy theo dõi các bản cập nhật; các cải tiến CLI tác động trực tiếp đến kết quả.

Ngoài ra, hãy thử nghiệm với các lời nhắc để có độ chính xác.

Do đó, các bước này nâng cao trải nghiệm.

Kết luận: Nắm bắt sự thay đổi trong CodeX và hơn thế nữa

Người dùng cảm nhận CodeX kém thông minh hơn do các tác vụ phức tạp và các vấn đề nhỏ, nhưng bằng chứng cho thấy sự tiến hóa, không phải suy giảm. Cuộc điều tra và các bản sửa lỗi của OpenAI khẳng định cam kết.

Hơn nữa, việc tích hợp Apidog đảm bảo các quy trình làm việc linh hoạt.

Cuối cùng, hãy điều chỉnh chiến lược, tận dụng công cụ và đóng góp phản hồi—những điều chỉnh nhỏ mang lại những lợi ích đáng kể về năng suất.