Alibaba'nın Tongyi DeepResearch'ü, verimli ve yüksek doğruluklu web araştırması için token başına yalnızca 3 milyar parametre etkinleştiren 30 milyar parametreli Uzmanlar Karışımı (MoE) modeliyle otonom yapay zeka ajanlarını yeniden tanımlıyor. Bu açık kaynaklı güç merkezi, Humanity's Last Exam (Yüzde 32,9'a karşı OpenAI o3'ün yüzde 24,9'u) ve xbench-DeepSearch (Yüzde 75,0'a karşı yüzde 67,0) gibi karşılaştırmalı testlerde üstünlük sağlayarak geliştiricilerin hukuki analizden seyahat programlarına kadar karmaşık, çok adımlı sorgularla tescilli bir kısıtlama olmaksızın başa çıkmasına olanak tanıyor.

Tongyi Laboratuvarı'ndaki mühendisler, bu ajanı uzun vadeli muhakeme ve dinamik araç kullanımının üstesinden gelmek için tasarladılar. Sonuç olarak, Hugging Face aracılığıyla yerel olarak çalışırken bile gerçek dünya sentezinde kapalı modellerden daha iyi performans gösteriyor. Bu teknik analizde, onun seyrek mimarisini, otomatik veri hattını, RL ile optimize edilmiş eğitimini, karşılaştırmalı testlerdeki üstünlüğünü ve dağıtım ipuçlarını inceliyoruz. Sonunda, Tongyi DeepResearch'ün ve Apidog gibi araçların projeleriniz için ölçeklenebilir ajan tabanlı yapay zekayı nasıl etkinleştirdiğini göreceksiniz.

Tongyi DeepResearch'ü Anlamak: Temel Kavramlar ve Yenilikler

Tongyi DeepResearch, derin bilgi erişimi ve sentezine odaklanarak ajan tabanlı yapay zekayı yeniden tanımlıyor. Kısa formda üretimde üstün olan geleneksel büyük dil modellerinin (LLM'ler) aksine, bu ajan web tarayıcıları gibi dinamik ortamlarda gezinerek incelikli içgörüler ortaya çıkarır. Özellikle, tam 30 milyar parametrenin token başına yalnızca 3 milyar olarak seçici bir şekilde etkinleştirildiği bir Uzmanlar Karışımı (MoE) mimarisi kullanır. Bu verimlilik, kaynak kısıtlı donanımlarda sağlam performans sağlarken, 128 bin tokene kadar yüksek bağlamsal farkındalığı sürdürür.

Ayrıca, model insan benzeri karar verme süreçlerini taklit eden çıkarım paradigmalarıyla sorunsuz bir şekilde entegre olur. ReAct modunda, yoğun komut mühendisliğini atlayarak düşünce, eylem ve gözlem adımları arasında doğal olarak döngü yapar. Daha zorlu görevler için, Ağır mod, bağlam aşırı yüklenmesini önlemek için paralel ajan keşiflerini düzenleyen IterResearch çerçevesini etkinleştirir. Sonuç olarak, kullanıcılar akademik literatür taramaları veya pazar analizi gibi yinelemeli iyileştirme gerektiren senaryolarda üstün sonuçlar elde eder.

Tongyi DeepResearch'ü farklı kılan şey, açıklığa olan bağlılığıdır. Model ağırlıklarından eğitim koduna kadar tüm yığın, Hugging Face ve GitHub gibi platformlarda bulunur. Geliştiriciler, Tongyi-DeepResearch-30B-A3B varyantına doğrudan erişerek alana özgü ihtiyaçlar için ince ayar yapmayı kolaylaştırır. Ayrıca, standart Python ortamlarıyla uyumluluğu, giriş engelini düşürür. Örneğin, kurulum, Python 3.10 ile bir Conda ortamı kurulduktan sonra basit bir pip komutu içerir.

Pratik kullanıma geçildiğinde, Tongyi DeepResearch doğrulanabilir çıktılar gerektiren uygulamalara güç verir. Hukuki araştırmalarda, yasaları ve içtihatları ayrıştırır, kaynakları doğru bir şekilde belirtir. Benzer şekilde, seyahat planlamasında, gerçek zamanlı verileri çapraz referans göstererek çok günlük seyahat programları oluşturur. Bu yetenekler kasıtlı bir tasarım felsefesinden kaynaklanır: salt tahmin yerine ajan tabanlı muhakemeye öncelik vermek.

Tongyi DeepResearch'ün Mimarisi: Verimlilik Güçle Buluşuyor

Özünde, Tongyi DeepResearch, hesaplama taleplerini ifade gücüyle dengelemek için seyrek bir MoE tasarımından yararlanır. Model, token başına yalnızca bir uzman alt kümesini etkinleştirir ve sorgu karmaşıklığına göre girdileri dinamik olarak yönlendirir. Bu yaklaşım, yoğun muadillerine kıyasla gecikmeyi yüzde 90'a kadar azaltarak gerçek zamanlı ajan dağıtımları için uygun hale getirir. Ayrıca, 128 bin bağlam penceresi, uzun belge zincirleri veya dizili web aramaları içeren görevler için kritik olan uzun süreli etkileşimleri destekler.

Temel mimari bileşenler arasında, eylem ön ekleri ve gözlem sınırlayıcıları gibi ajan tabanlı tokenlar için optimize edilmiş özel bir tokenlaştırıcı ve tarayıcı navigasyonu, alma ve hesaplama için gömülü bir araç paketi bulunur. Çerçeve, ajanların istikrarlı bir ortamda simüle edilmiş denemelerden öğrendiği, politika içi pekiştirmeli öğrenme (RL) entegrasyonunu destekler. Sonuç olarak, model, araç kullanım karşılaştırmalı testlerindeki yüksek puanlarıyla kanıtlandığı gibi, araç çağrılarında daha az halüsinasyon sergiler.

Ek olarak, Tongyi DeepResearch, grafik tabanlı veri sentezinden türetilen varlık tabanlı bilgi belleğini içerir. Bu mekanizma, yanıtları olgusal varlıklara bağlayarak izlenebilirliği artırır. Örneğin, kuantum hesaplama gelişmelerine ilişkin bir sorgu sırasında, ajan WebSailor benzeri araçlar aracılığıyla makaleleri alır ve sentezler, çıktıları doğrulanabilir kaynaklara dayandırır. Böylece, mimari sadece bilgiyi işlemekle kalmaz, aynı zamanda aktif olarak düzenler.

Örnek vermek gerekirse, modelin çok modlu girdileri ele alışını düşünün. Temel olarak metin tabanlı olsa da, GitHub deposu aracılığıyla yapılan uzantılar, görüntü ayrıştırıcıları veya kod yürütücüleri ile entegrasyona izin verir. Geliştiriciler bunları çıkarım betiğinde yapılandırır ve JSONL formatındaki veri kümeleri için yolları belirtir. Bu nedenle, mimari genişletilebilirliği teşvik eder ve açık kaynak topluluğundan katkıları davet eder.

Otomatik Veri Sentezi: Tongyi DeepResearch'ün Yeteneklerini Beslemek

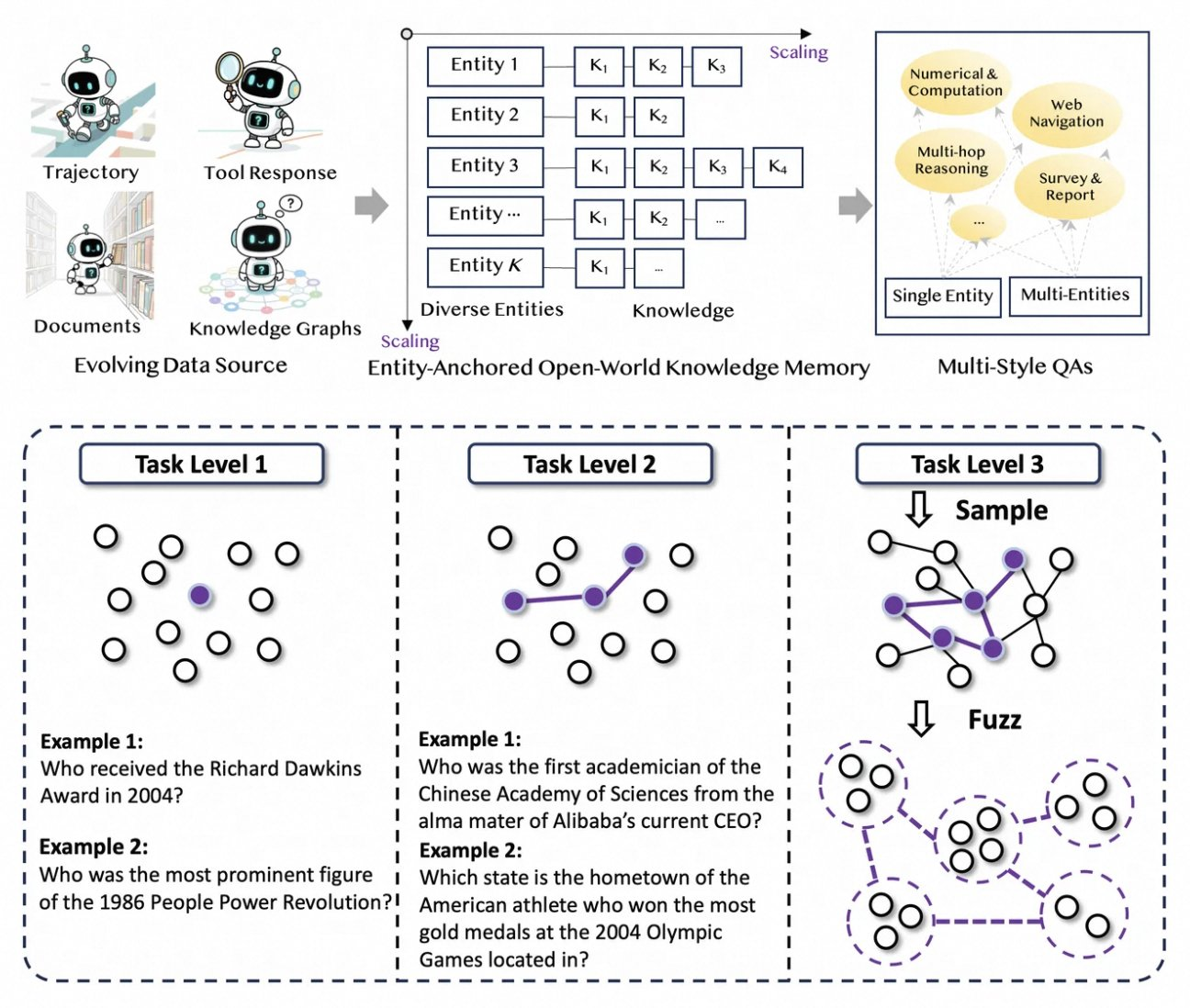

Tongyi DeepResearch, insan ek açıklama darboğazlarını ortadan kaldıran yeni, tamamen otomatik bir veri hattı üzerinde gelişir. Süreç, ham metinleri (belgeler, web taramaları ve bilgi grafikleri) varlık tabanlı Soru-Cevap çiftlerine dönüştüren bir sentez motoru olan AgentFounder ile başlar. Bu adım, muhakeme zincirlerini, araç çağrılarını ve karar ağaçlarını kapsayan sürekli ön eğitim (CPT) için çeşitli yörüngeler üretir.

Ardından, veri hattı yinelemeli yükseltmelerle zorluğu artırır. Eğitim sonrası için, küme teorisi aracılığıyla modellenen doktora düzeyindeki sorular gibi "süper insan" zorluklarını simüle etmek için WebSailor-V2 gibi grafik tabanlı yöntemler kullanır. Sonuç olarak, veri kümesi milyonlarca yüksek doğruluklu etkileşimi kapsar ve modelin alanlar arasında genelleşmesini sağlar. Özellikle, bu otomasyon hesaplama ile doğrusal olarak ölçeklenir ve manuel kürasyon olmadan sürekli güncellemelere izin verir.

Ayrıca, Tongyi DeepResearch sağlamlık için çok tarzlı verileri içerir. Eylem sentezi kayıtları araç kullanım modellerini yakalarken, çok aşamalı Soru-Cevap çiftleri planlama becerilerini geliştirir. Pratikte, bu, gürültülü web ortamlarına uyum sağlayan, alakasız parçacıkları etkili bir şekilde filtreleyen ajanlar üretir. Geliştiriciler için depo, bu veri hattını çoğaltmak için betikler sağlayarak özel veri kümesi oluşturmayı mümkün kılar.

Sentez stratejisi, nicelikten ziyade kaliteye öncelik vererek, dağıtım kaymaları gibi ajan eğitimindeki yaygın tuzakları ele alır. Sonuç olarak, bu şekilde eğitilen modeller, karşılaştırmalı testlerdeki üstünlüğünde görüldüğü gibi, gerçek dünya görevleriyle üstün bir uyum sergiler.

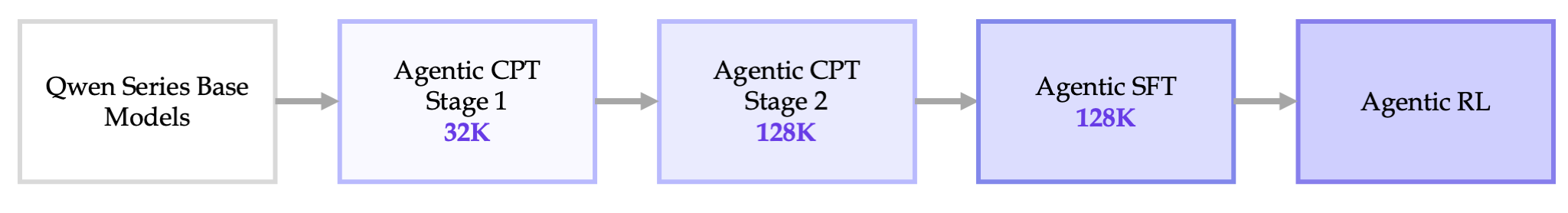

Uçtan Uca Eğitim Hattı: CPT'den RL Optimizasyonuna

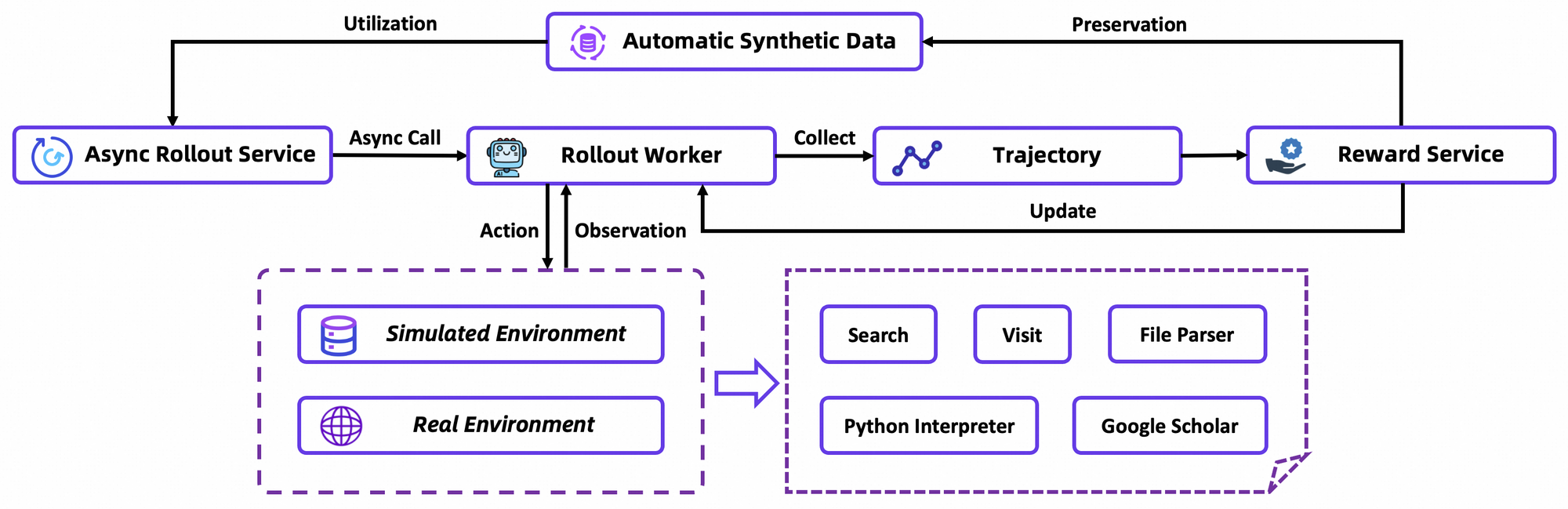

Tongyi DeepResearch'ün eğitimi sorunsuz bir veri hattında ilerler: Ajan Tabanlı CPT, Denetimli İnce Ayar (SFT) ve Pekiştirmeli Öğrenme (RL). İlk olarak, CPT temel modeli geniş ajan tabanlı verilere maruz bırakır, ona web navigasyon öncelikleri ve yenilik sinyalleri aşılar. Bu aşama, yörüngeler üzerinde maskelenmiş dil modellemesi aracılığıyla örtük planlama gibi gizli yetenekleri etkinleştirir.

CPT'yi takiben, SFT, hassas eylem formülasyonunu öğretmek için sentetik denemeler kullanarak modeli talimat formatlarına uyarlar. Burada model, tutarlı ReAct döngüleri oluşturmayı öğrenir ve gözlem ayrıştırmadaki hataları en aza indirir. Sorunsuz bir geçişle, RL aşaması, özel bir politika içi algoritma olan Grup Göreli Politika Optimizasyonu (GRPO) kullanır.

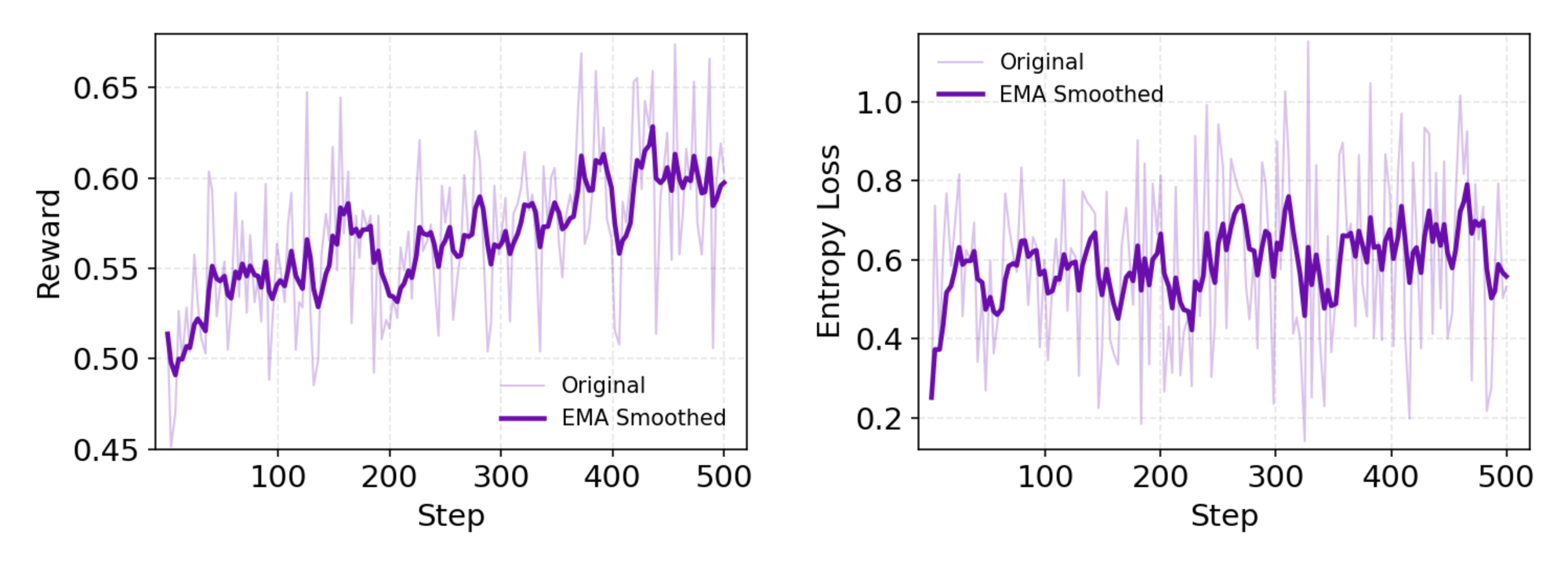

GRPO, tek dışarıda bırakma avantajı tahminiyle token düzeyinde politika gradyanları hesaplar, durağan olmayan ayarlarda varyansı azaltır. Ayrıca negatif örnekleri muhafazakar bir şekilde filtreler, özel simülatördeki (bir araç sanal alanı ile eşleştirilmiş çevrimdışı bir Wikipedia veritabanı) güncellemeleri stabilize eder. rLLM çerçevesi aracılığıyla yapılan eşzamansız denemeler yakınsamayı hızlandırır ve mütevazı hesaplama ile SOTA'ya ulaşır.

Detaylı olarak, RL ortamı tarayıcı etkileşimlerini sadık bir şekilde simüle eder, tek eylemler yerine çok adımlı başarıyı ödüllendirir. Bu, ajanların kısmi başarısızlıklar üzerinde yineleme yaptığı uzun vadeli planlamayı teşvik eder. Teknik bir not olarak, kayıp fonksiyonu muhafazakarlık için KL ayrışmasını içerir, mod çökmesini önler. Geliştiriciler bunu deponun değerlendirme betikleri aracılığıyla çoğaltır, özel politikaları karşılaştırır.

Genel olarak, bu veri hattı bir atılımı işaret ediyor: ön eğitimi dağıtıma silolar olmadan bağlıyor, deneme yanılma yoluyla gelişen ajanlar üretiyor.

Karşılaştırmalı Test Performansı: Tongyi DeepResearch Nasıl Üstünleşiyor

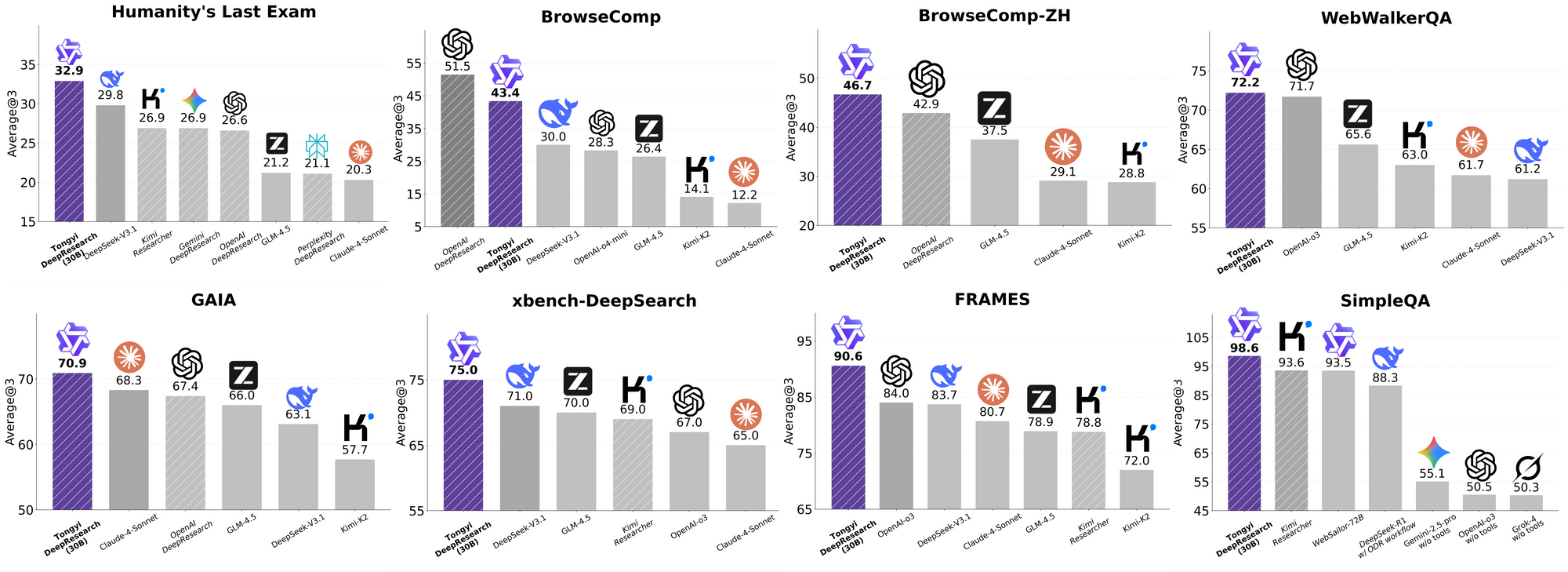

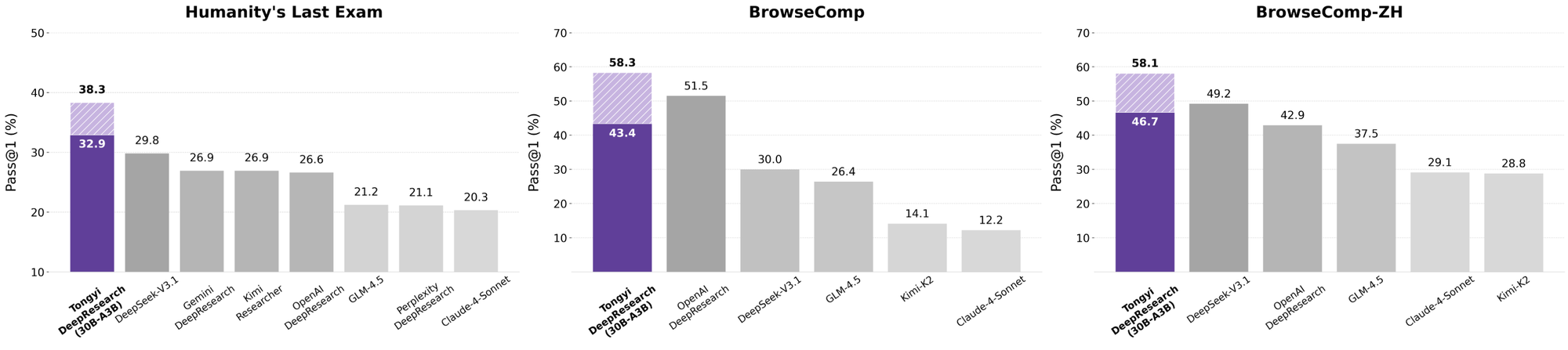

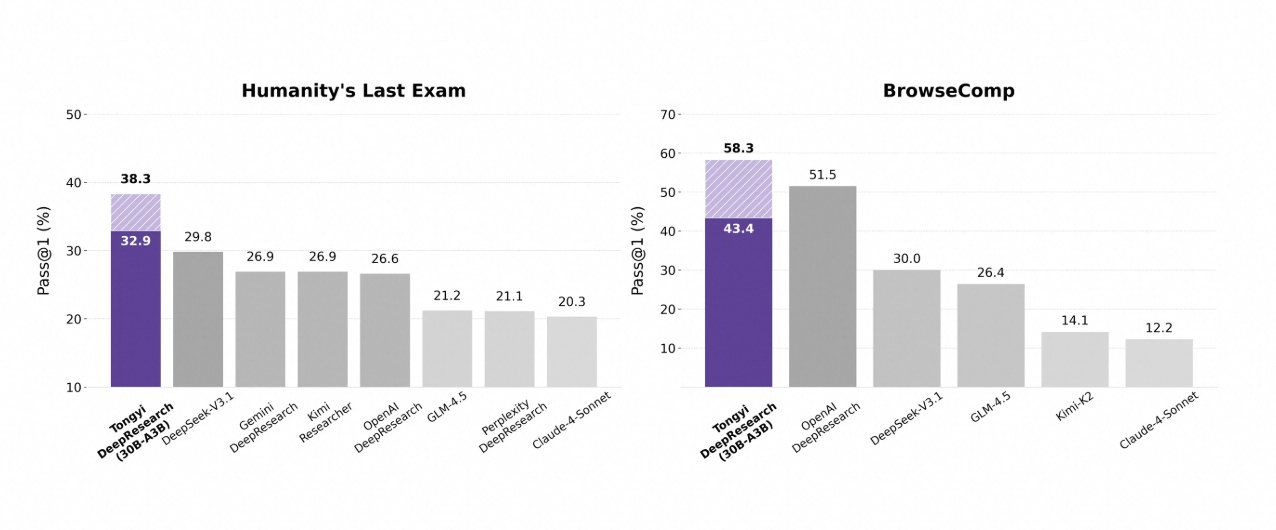

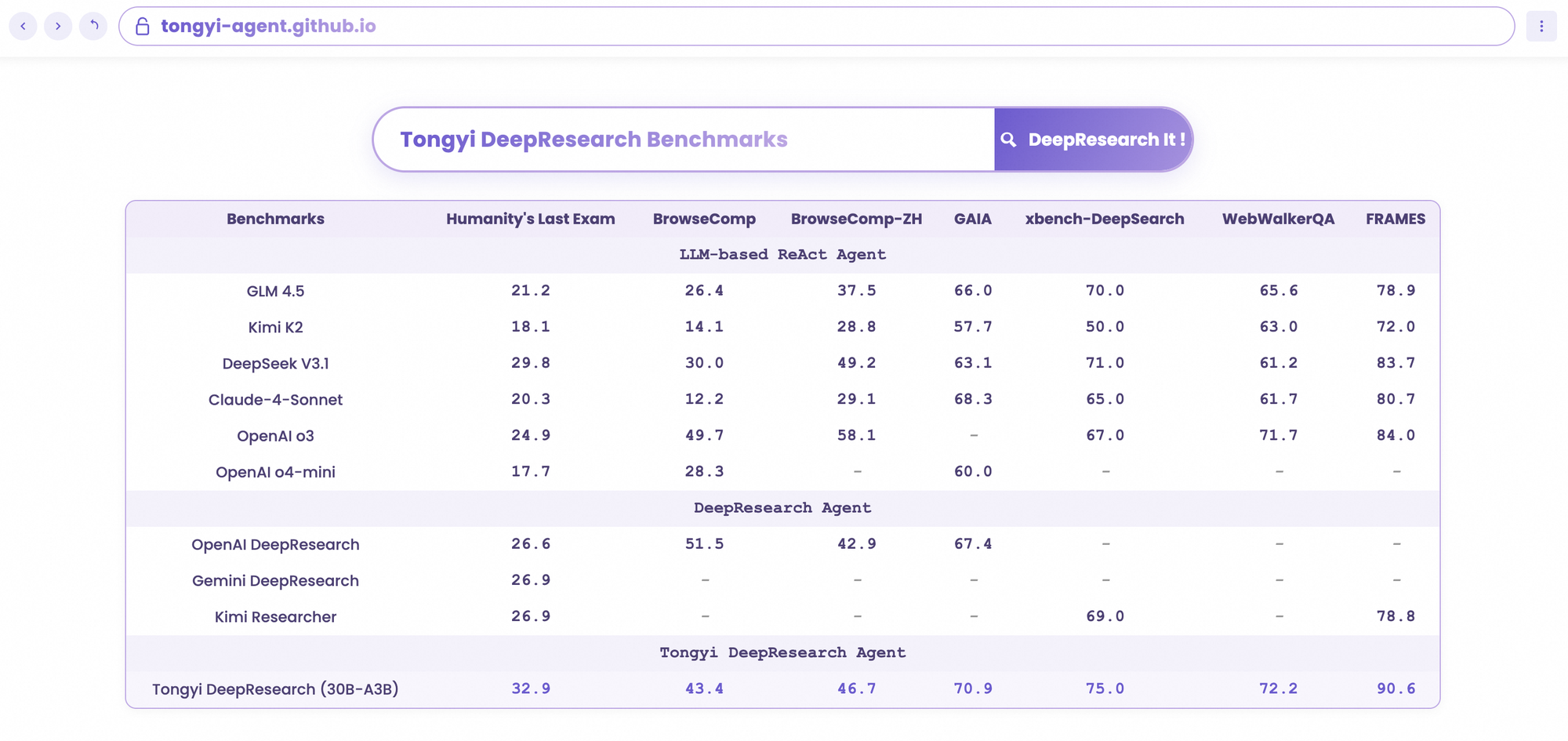

Tongyi DeepResearch, tasarımını doğrulayan titiz ajan tabanlı karşılaştırmalı testlerde parlıyor. Akademik muhakeme testi olan Humanity's Last Exam (HLE)'de, ReAct modunda 32,9 puan alarak OpenAI'ın o3'ünü (24,9) geride bırakıyor. Bu fark, Ağır modda 38,3'e yükselerek IterResearch'ün etkinliğini vurguluyor.

Benzer şekilde, BrowseComp karmaşık bilgi arayışını değerlendirir; Tongyi, verimlilikte o3'ün sırasıyla 49,7 ve 58,1'ini geride bırakarak 43,4 (İngilizce) ve 46,7 (Çince) elde eder. Derin sorgular için kullanıcı merkezli olan xbench-DeepSearch karşılaştırmalı testinde, Tongyi 75,0'a karşı o3'ün 67,0'ını görerek üstün bilgi alma sentezini vurgular.

Diğer metrikler bunu pekiştiriyor: FRAMES 90,6 (o3'ün 84,0'ına karşı), GAIA 70,9 ve SimpleQA 95,0. Karşılaştırmalı bir grafik bunları görselleştiriyor; Tongyi DeepResearch'in çubukları HLE, BrowseComp, xbench, FRAMES ve daha fazlasında Gemini, Claude ve diğerlerinin üzerinde yükseliyor. Mavi çubuklar Tongyi'nin liderliğini, gri taban çizgileri ise rakiplerin eksikliklerini gösteriyor.

Bu sonuçlar, arama görevleri için seçici uzman yönlendirmesi gibi hedeflenmiş optimizasyonlardan kaynaklanmaktadır. Bu nedenle, Tongyi DeepResearch sadece rekabet etmekle kalmıyor, aynı zamanda açık kaynaklı ajan tabanlı yapay zekada lider konumdadır.

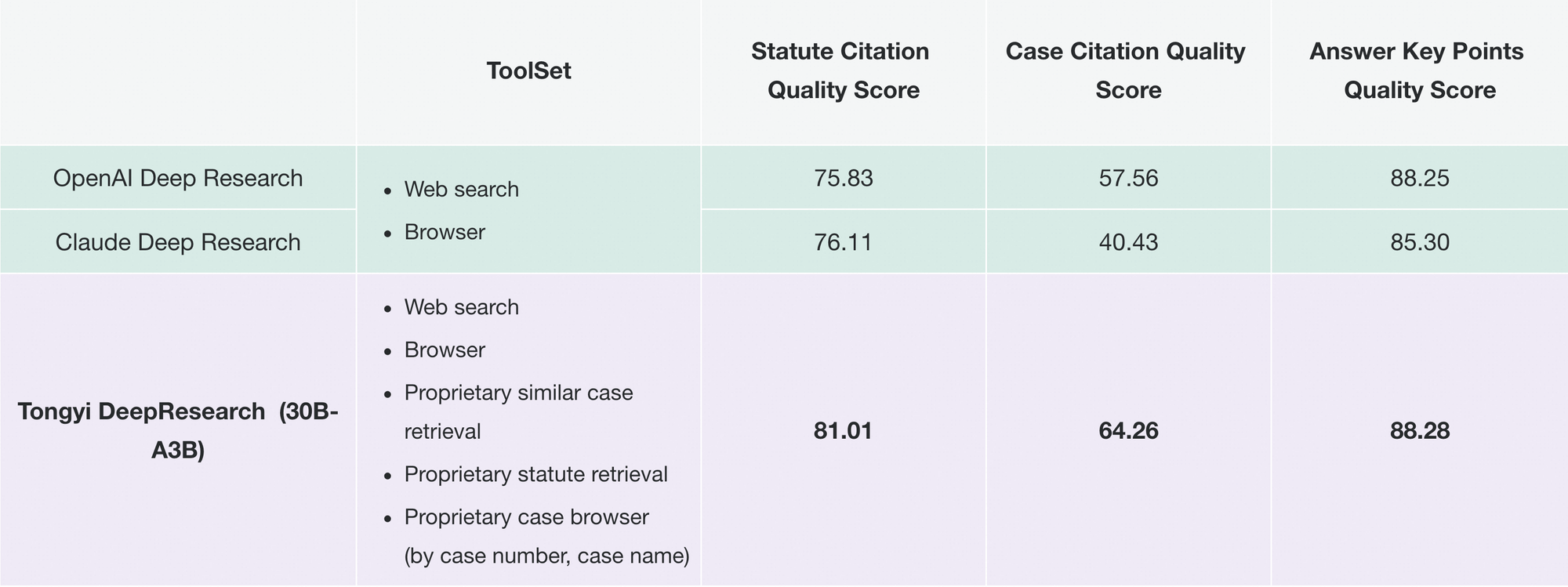

Tongyi DeepResearch'ü Sektör Liderleriyle Karşılaştırmak

Geliştiriciler yapay zeka ajanlarını değerlendirdiğinde, karşılaştırmalar gerçek değeri ortaya koyar. Tongyi DeepResearch, 30B-A3B ile, o3'ün daha büyük ölçeğine rağmen HLE'de (32,9'a karşı 24,9) ve xbench'te (75,0'a karşı 67,0) OpenAI'ın o3'ünü geride bırakıyor. Google'ın Gemini'sine karşı ise BrowseComp-ZH'de 35,2 puanla 10 puanlık bir avantaj sağlıyor.

Claude 3.5 Sonnet gibi tescilli modeller araç kullanımında geride kalıyor; Tongyi'nin FRAMES'teki 90,6'sı Sonnet'in 84,3'ünü gölgede bırakıyor. Llama varyantları gibi açık kaynaklı benzerleri daha da geride kalıyor (örneğin, HLE'de 21,1). Tongyi'nin MoE seyrekliği, daha az çıkarım hesaplaması tüketerek bu eşitliği sağlıyor.

Ayrıca, erişilebilirlik dengeleri değiştiriyor: o3 API kredileri gerektirirken, Tongyi Hugging Face aracılığıyla yerel olarak çalışır. Yoğun API iş akışları için, uç noktaları taklit etmek ve araç çağrılarını verimli bir şekilde simüle etmek için onu Apidog ile eşleştirin.

Özünde, Tongyi DeepResearch seçkin performansı demokratikleştiriyor ve kapalı ekosistemlere meydan okuyor.

Gerçek Dünya Uygulamaları: Tongyi DeepResearch Eylemde

Tongyi DeepResearch, karşılaştırmalı testleri aşarak somut bir etki yaratıyor. Alibaba'nın navigasyon uygulaması Gaode Mate'te, Ağır mod aracılığıyla uçuşları, otelleri ve etkinlikleri paralel olarak sorgulayarak karmaşık geziler planlıyor. Kullanıcılar, alıntılarla sentezlenmiş seyahat programları alarak planlama süresini yüzde 70 azaltıyor.

Benzer şekilde, Tongyi FaRui hukuki araştırmayı devrim niteliğinde değiştiriyor. Ajan, yasaları analiz eder, emsalleri çapraz referans gösterir ve doğrulanabilir bağlantılarla özetler oluşturur. Profesyoneller, yüksek riskli alanlarda hataları en aza indirerek çıktıları hızla doğrular.

Bunların ötesinde, işletmeler onu pazar istihbaratı için uyarlar: rakip verilerini kazıma, eğilimleri sentezleme. Deponun modülerliği bu tür uzantıları destekler; JSON yapılandırmaları aracılığıyla özel araçlar ekleyin.

Benimsenme arttıkça, Tongyi DeepResearch LangChain gibi ekosistemlere entegre oluyor ve ajan sürülerini güçlendiriyor. API geliştiricileri için Apidog, dağıtım öncesi entegrasyonları doğrulayarak bunu tamamlar.

Bu vakalar ölçeklenebilirliği gösteriyor: tüketici uygulamalarından B2B araçlarına kadar, model güvenilir özerklik sunuyor.

Tongyi DeepResearch'e Başlarken: Geliştirici Rehberi

Tongyi DeepResearch'ü GitHub deposuyla zahmetsizce uygulayın. Bir Conda ortamı oluşturarak başlayın: conda create -n deepresearch python=3.10. Etkinleştirin ve kurun: pip install -r requirements.txt.

Verileri eval_data/ içinde JSONL olarak, question ve answer anahtarlarıyla hazırlayın. Dosyalar için, isimleri soruların başına ekleyin ve file_corpus/ içinde saklayın. Model yolu (örneğin, Hugging Face URL'si) ve araçlar için API anahtarları için run_react_infer.sh dosyasını düzenleyin.

Çalıştırın: bash run_react_infer.sh. Çıktılar belirtilen yollara düşer, analiz için hazırdır.

Ağır mod için, IterResearch parametrelerini kodda yapılandırın—ajan sayısını ve tur sayısını ayarlayın. evaluation/ betikleri aracılığıyla karşılaştırmalı test yapın, temel çizgilerle karşılaştırın.

Günlüklerle sorun giderin; tokenlaştırıcı uyuşmazlıkları gibi yaygın sorunlar BF16 tensör kontrolleriyle çözülür. Geliştirmek için, API simülasyonu, canlı çağrılar olmadan araç uç noktalarını test etmek için Apidog'u ücretsiz indirin.

Bu kurulum, ajanları hızla prototiplemenizi sağlar.

Gelecek Yönelimleri: Tongyi DeepResearch'ü Daha da Ölçeklendirmek

İleriye dönük olarak, Tongyi Laboratuvarı, 128 binin ötesinde bağlam genişletmeyi hedefliyor ve kitap uzunluğundaki analizler gibi ultra uzun ufukları mümkün kılıyor. Daha büyük MoE tabanlarında doğrulama planlıyorlar, ölçeklenebilirlik sınırlarını araştırıyorlar.

RL geliştirmeleri arasında verimlilik için kısmi denemeler ve kaymaları azaltmak için politika dışı yöntemler yer alıyor. Topluluk katkıları, kapsamı genişleterek görme veya çok dilli araçları entegre edebilir.

Açık kaynak geliştikçe, Tongyi DeepResearch işbirlikçi ilerlemeleri demirleyecek ve AGI arayışlarını teşvik edecektir.

Sonuç: Tongyi DeepResearch Çağını Kucaklayın

Tongyi DeepResearch, verimliliği, açıklığı ve yeteneği harmanlayarak ajan tabanlı yapay zekayı dönüştürüyor. Karşılaştırmalı testleri, mimarisi ve uygulamaları onu, OpenAI'ın teklifleri gibi rakiplerini geride bırakan bir lider konumuna getiriyor. Geliştiriciler, bu gücü kullanın—modeli indirin, deneyler yapın ve sorunsuz API'ler için Apidog ile entegre edin.

Özerkliğe doğru hızla ilerleyen bir alanda, Tongyi DeepResearch ilerlemeyi hızlandırıyor. Bugün inşa etmeye başlayın; içgörüler sizi bekliyor.