Gemma 3'ü Ollama ile yerel olarak çalıştırmak, bulut hizmetlerine güvenmeden yapay zeka ortamınız üzerinde tam kontrol sağlar. Bu kılavuz, Ollama'yı kurma, Gemma 3'ü indirme ve makinenizde çalıştırma konusunda size yol gösterir.

Hadi başlayalım.

Neden Gemma 3'ü Ollama ile Yerel Olarak Çalıştıralım?

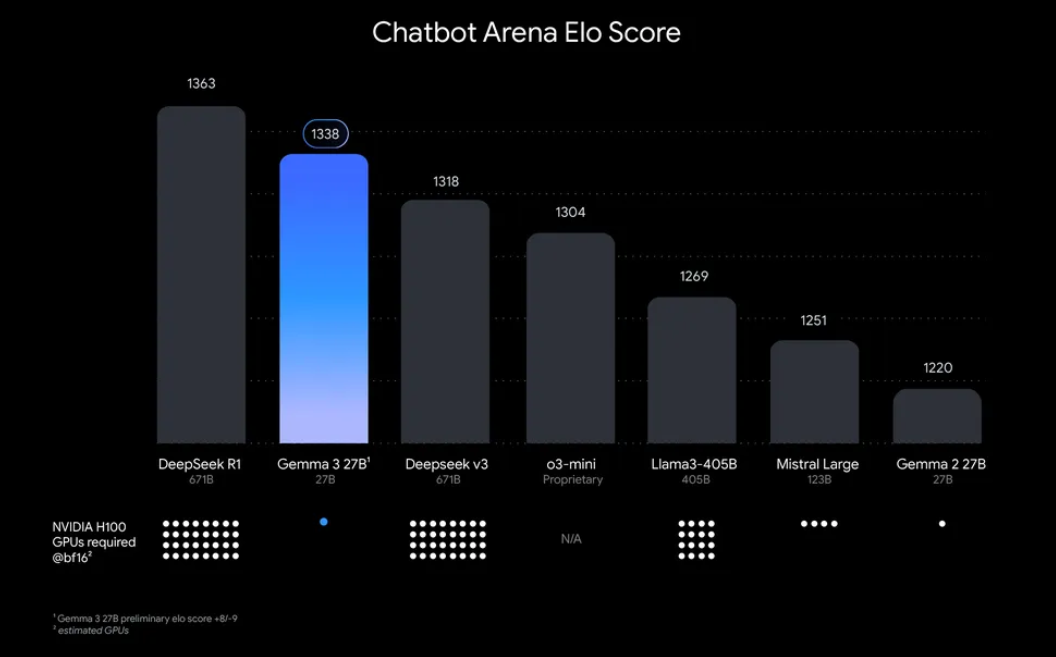

“Neden Gemma 3'ü yerel olarak çalıştıralım?” Bunun bazı ikna edici nedenleri var. Birincisi, yerel dağıtım size verileriniz ve gizliliğiniz üzerinde tam kontrol sağlar; hassas bilgileri buluta göndermenize gerek yoktur. Ek olarak, maliyet etkilidir, çünkü devam eden API kullanım ücretlerinden kaçınırsınız. Ayrıca, Gemma 3'ün verimliliği, 27B modelinin bile tek bir GPU'da çalışabileceği anlamına gelir ve bu da onu mütevazı donanıma sahip geliştiriciler için erişilebilir hale getirir.

Büyük dil modellerini (LLM'ler) yerel olarak çalıştırmak için hafif bir platform olan Ollama, bu süreci basitleştirir. Model ağırlıkları, yapılandırmalar ve bağımlılıklar gibi ihtiyacınız olan her şeyi kullanımı kolay bir biçimde paketler. Gemma 3 ve Ollama'nın bu kombinasyonu, makinenizde deneme yapmak, uygulamalar oluşturmak veya yapay zeka iş akışlarını test etmek için mükemmeldir. O halde, kolları sıvayalım ve başlayalım!

Gemma 3'ü Ollama ile Çalıştırmak İçin Neye İhtiyacınız Olacak

Kuruluma geçmeden önce, aşağıdaki önkoşullara sahip olduğunuzdan emin olun:

- Uyumlu Bir Makine: Bir GPU'ya (tercihen optimum performans için NVIDIA) veya güçlü bir CPU'ya sahip bir bilgisayara ihtiyacınız olacak. 27B modeli önemli kaynaklar gerektirir, ancak 1B veya 4B gibi daha küçük sürümler daha az güçlü donanımlarda çalışabilir.

- Ollama Yüklü: MacOS, Windows ve Linux için mevcut olan Ollama'yı indirin ve yükleyin. Bunu ollama.com adresinden alabilirsiniz.

- Temel Komut Satırı Becerileri: Ollama ile terminal veya komut istemi aracılığıyla etkileşim kuracaksınız.

- İnternet Bağlantısı: Başlangıçta, Gemma 3 modellerini indirmeniz gerekecek, ancak indirdikten sonra bunları çevrimdışı olarak çalıştırabilirsiniz.

- İsteğe Bağlı: API Testi için Apidog: Gemma 3'ü bir API ile entegre etmeyi veya yanıtlarını programlı olarak test etmeyi planlıyorsanız, Apidog'un sezgisel arayüzü size zaman ve çaba kazandırabilir.

Artık donatıldığınıza göre, kurulum ve kurulum sürecine dalalım.

Adım Adım Kılavuz: Ollama'yı Yükleme ve Gemma 3'ü İndirme

1. Makinenize Ollama'yı Yükleyin

Ollama, yerel LLM dağıtımını kolaylaştırır ve yüklemek basittir. İşte nasıl:

- MacOS/Windows için: ollama.com adresini ziyaret edin ve işletim sisteminiz için yükleyiciyi indirin. Yüklemeyi tamamlamak için ekrandaki talimatları izleyin.

- Linux (örneğin, Ubuntu) için: Terminalinizi açın ve aşağıdaki komutu çalıştırın:

curl -fsSL https://ollama.com/install.sh | sh

Bu komut dosyası, donanımınızı (GPU'lar dahil) otomatik olarak algılar ve Ollama'yı yükler.

Yüklendikten sonra, aşağıdaki komutu çalıştırarak yüklemeyi doğrulayın:

ollama --version

Ollama'nın kullanıma hazır olduğunu onaylayarak geçerli sürüm numarasını görmelisiniz.

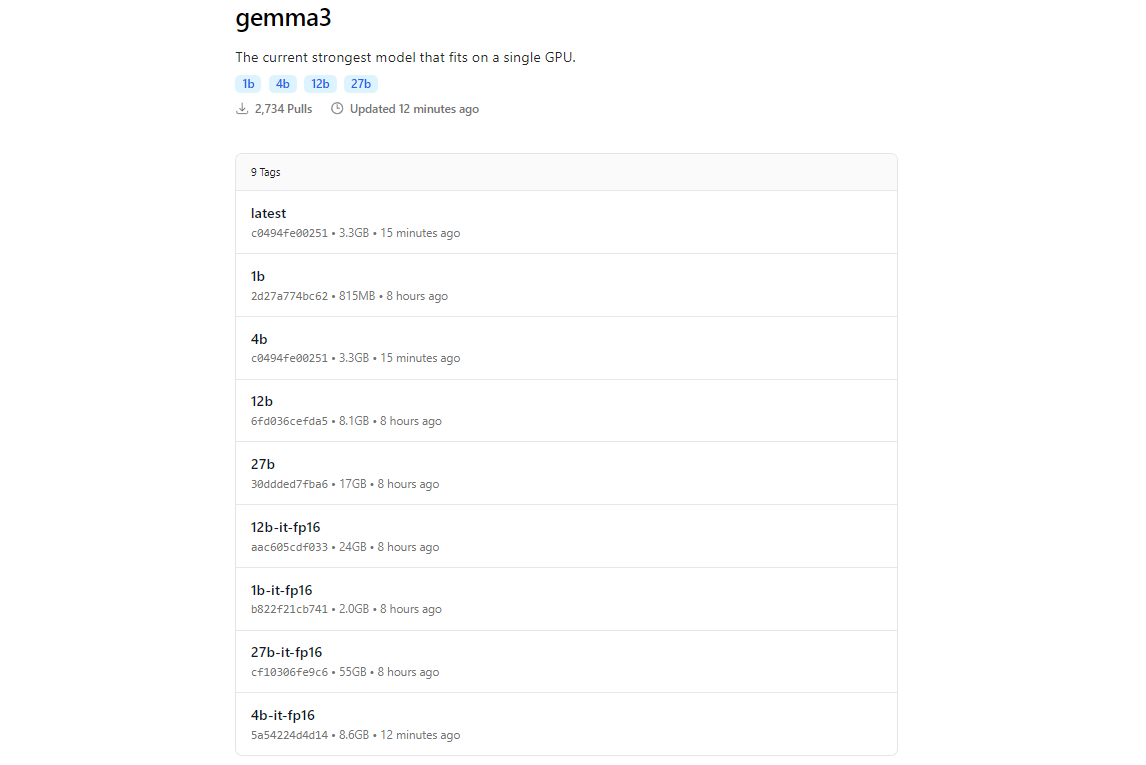

2. Ollama Kullanarak Gemma 3 Modellerini Çekme

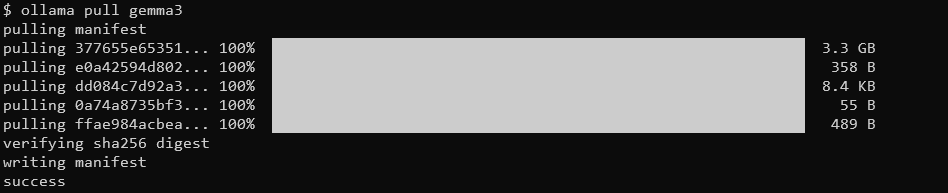

Ollama'nın model kitaplığı, Hugging Face ve Google'ın yapay zeka teklifleri gibi platformlarla entegrasyonu sayesinde Gemma 3'ü içerir. Gemma 3'ü indirmek için ollama pull komutunu kullanın.

ollama pull gemma3

Daha küçük modeller için şunları kullanabilirsiniz:

ollama pull gemma3:12bollama pull gemma3:4bollama pull gemma3:1b

İndirme boyutu modele göre değişir; 27B modelinin birkaç gigabayt olmasını bekleyin, bu nedenle yeterli depolama alanınız olduğundan emin olun. Gemma 3 modelleri verimlilik için optimize edilmiştir, ancak yine de daha büyük varyantlar için iyi donanım gerektirirler.

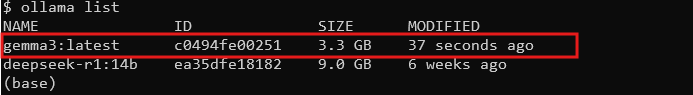

3. Yüklemeyi Doğrulayın

İndirdikten sonra, modelin mevcut olup olmadığını tüm modelleri listeleyerek kontrol edin:

ollama list

Listede gemma3'ü (veya seçtiğiniz boyutu) görmelisiniz. Oradaysa, Gemma 3'ü yerel olarak çalıştırmaya hazırsınız!

Gemma 3'ü Ollama ile Çalıştırma: Etkileşimli Mod ve API Entegrasyonu

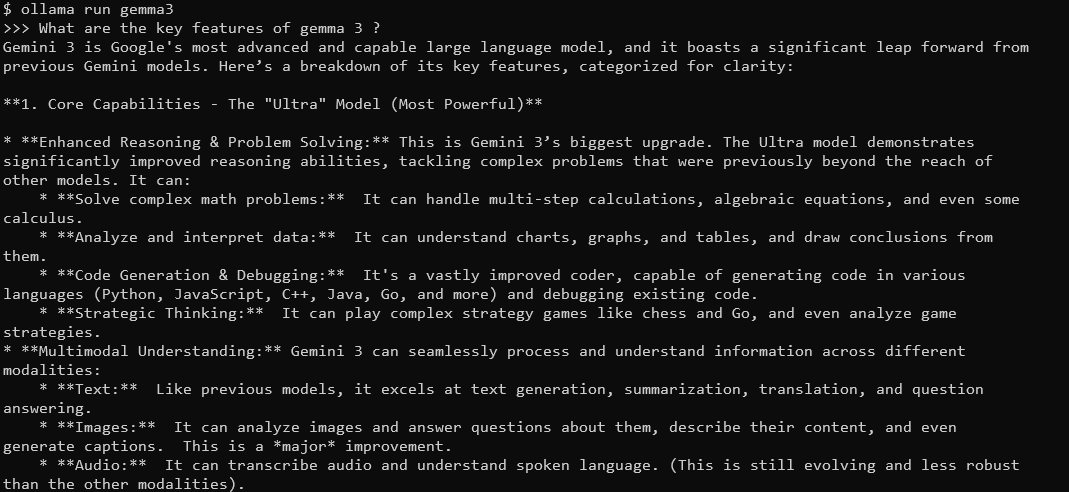

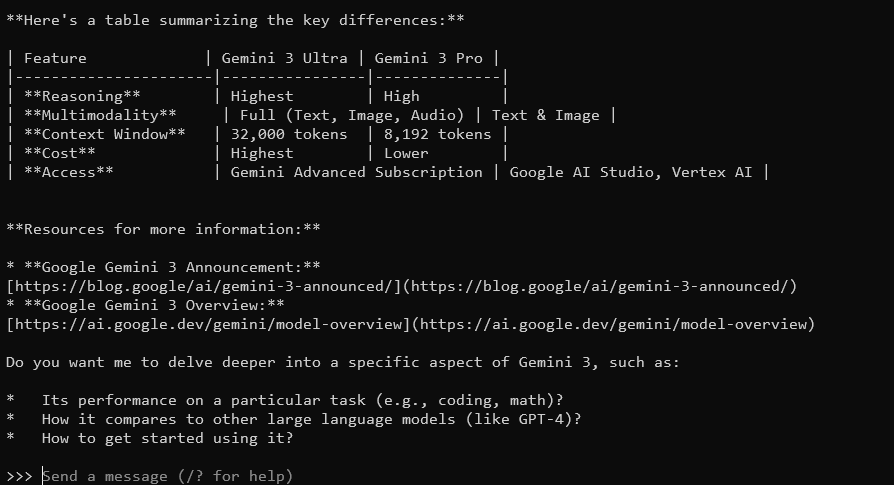

Etkileşimli Mod: Gemma 3 ile Sohbet Etme

Ollama'nın etkileşimli modu, Gemma 3 ile doğrudan terminalden sohbet etmenizi sağlar. Başlamak için şunu çalıştırın:

ollama run gemma3

Sorguları yazabileceğiniz bir istem göreceksiniz. Örneğin, şunu deneyin:

Gemma 3'ün temel özellikleri nelerdir?

128K bağlam penceresi ve çok modlu yeteneklere sahip Gemma 3, ayrıntılı, bağlam farkındalığına sahip yanıtlarla yanıt verecektir. 140'tan fazla dili destekler ve metin, resim ve hatta video girişlerini (belirli boyutlar için) işleyebilir.

Çıkmak için Ctrl+D veya /bye yazın.

Gemma 3'ü Ollama API'si ile Entegre Etme

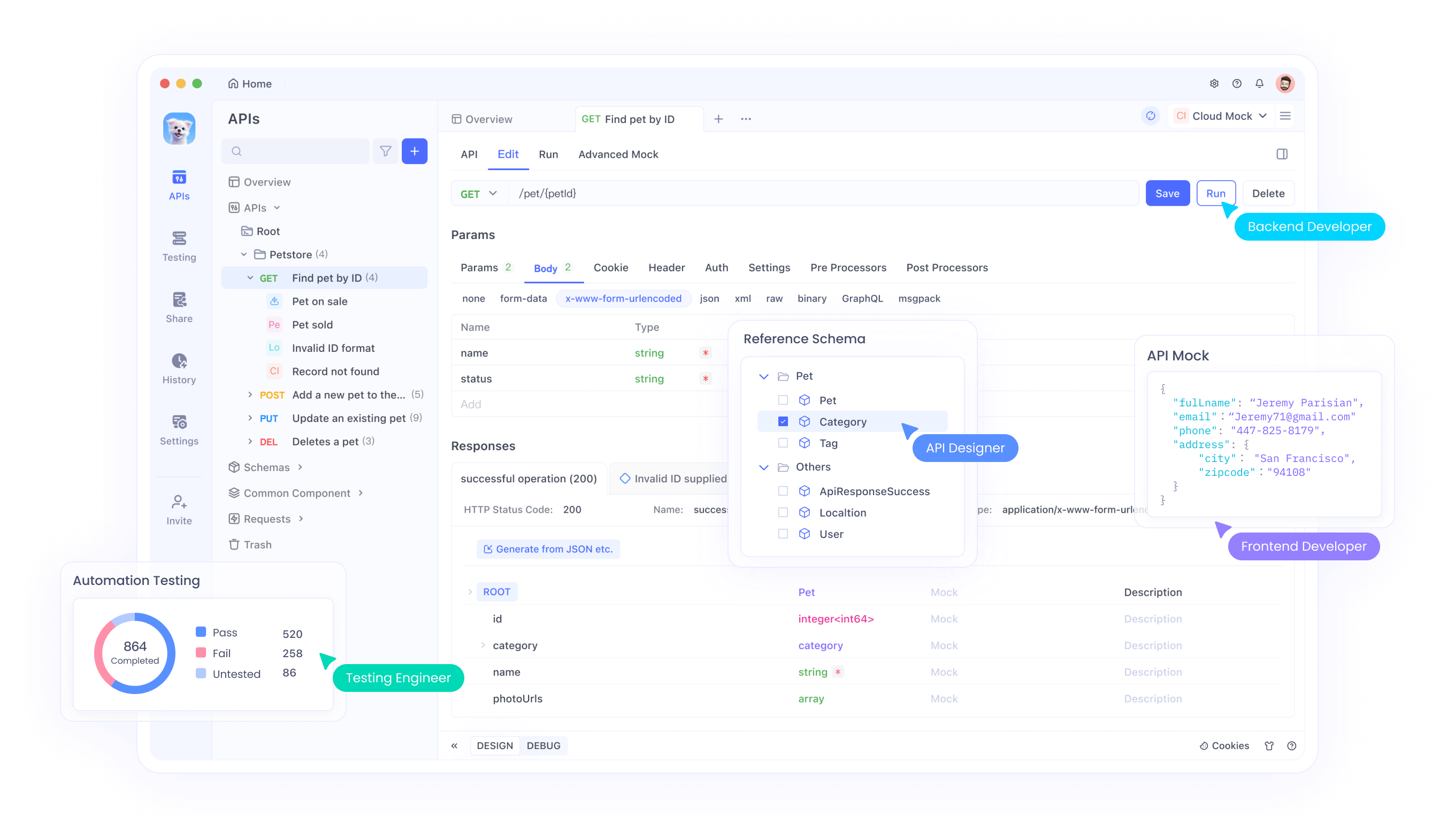

Uygulamalar oluşturmak veya etkileşimleri otomatikleştirmek istiyorsanız, Ollama kullanabileceğiniz bir API sağlar. İşte Apidog'un parladığı yer burasıdır; kullanıcı dostu arayüzü, API isteklerini verimli bir şekilde test etmenize ve yönetmenize yardımcı olur. İşte nasıl başlayacağınız:

Ollama Sunucusunu Başlatın: Ollama'nın API sunucusunu başlatmak için aşağıdaki komutu çalıştırın:

ollama serve

Bu, sunucuyu varsayılan olarak localhost:11434 üzerinde başlatır.

API İstekleri Yapın: Gemma 3 ile HTTP istekleri aracılığıyla etkileşim kurabilirsiniz. Örneğin, bir istem göndermek için curl kullanın:

curl http://localhost:11434/api/generate -d '{"model": "gemma3", "prompt": "What is the capital of France?"}'

Yanıt, Gemma 3'ün çıktısını JSON olarak içerecektir.

Test için Apidog Kullanın: Ücretsiz olarak Apidog'u indirin ve Gemma 3'ün yanıtlarını test etmek için bir API isteği oluşturun. Apidog'un görsel arayüzü, uç noktayı (http://localhost:11434/api/generate) girmenize, JSON yükünü ayarlamanıza ve karmaşık kod yazmadan yanıtları analiz etmenize olanak tanır. Bu, özellikle hata ayıklama ve entegrasyonunuzu optimize etmek için kullanışlıdır.

Apidog'da SSE Testini Kullanmaya Yönelik Adım Adım Kılavuzu

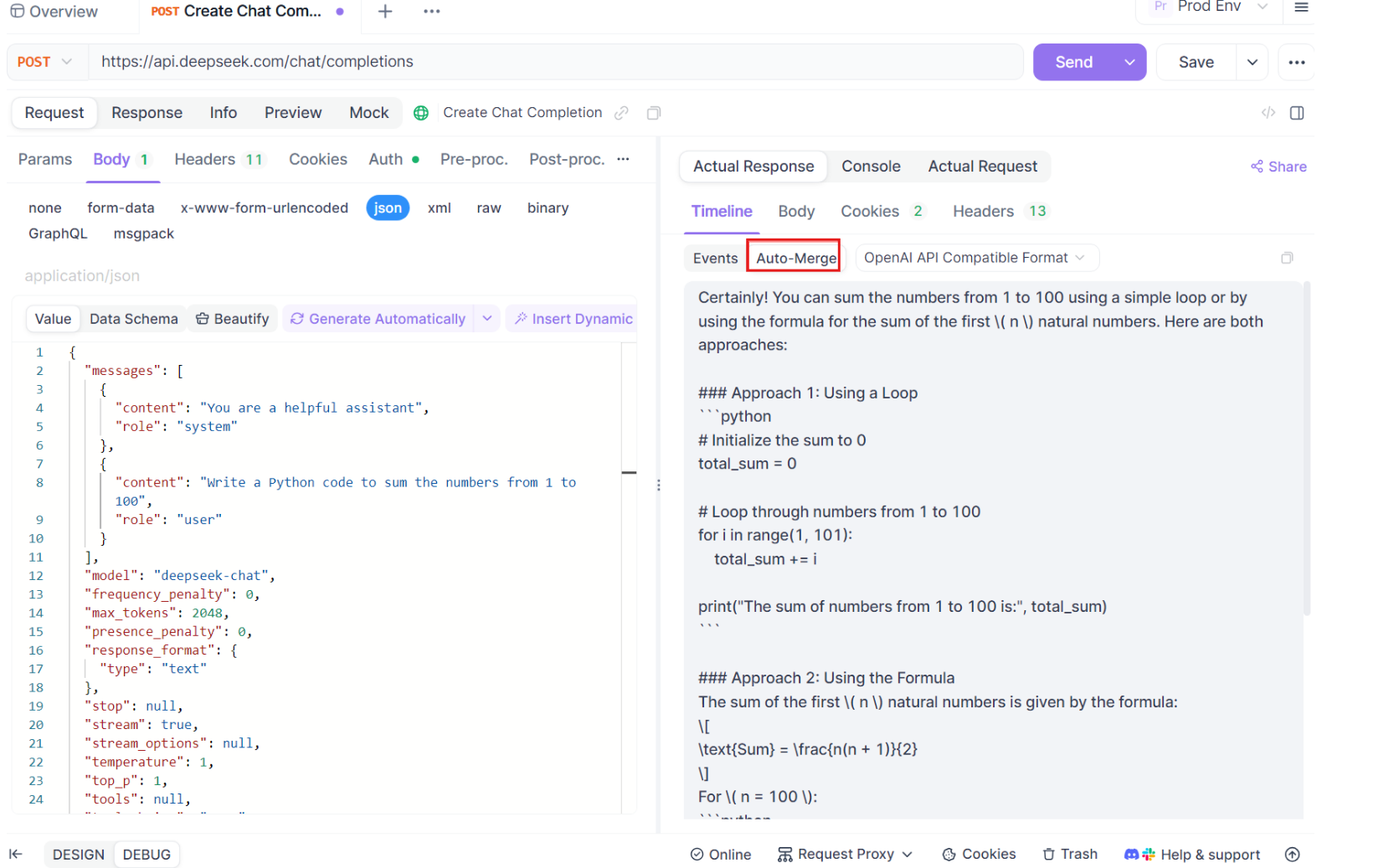

Yeni Otomatik Birleştirme geliştirmeleriyle birlikte, Apidog'daki optimize edilmiş SSE test özelliğini kullanma sürecini inceleyelim. Gerçek zamanlı hata ayıklama deneyiminizi kurmak ve en üst düzeye çıkarmak için bu adımları izleyin.

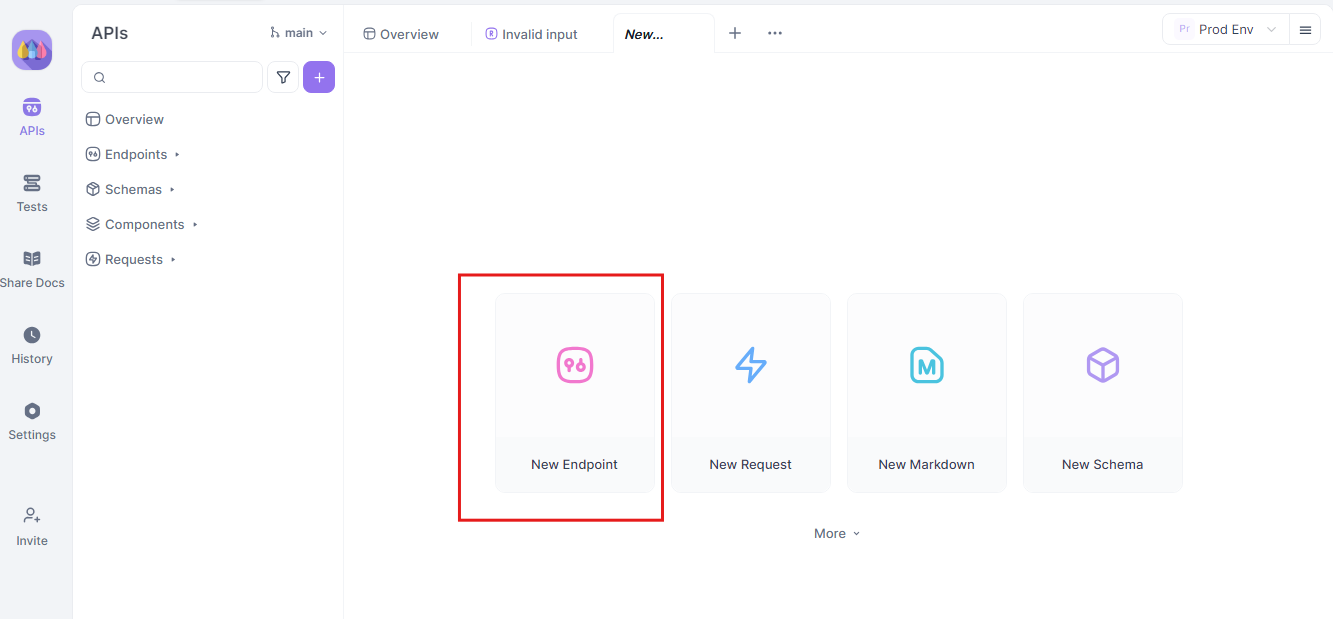

Adım 1: Yeni Bir API İsteği Oluşturun

Apidog'da yeni bir HTTP projesi başlatarak başlayın. Yeni bir uç nokta ekleyin ve API'nizin veya yapay zeka modelinizin uç noktası için URL'yi girin. Bu, gerçek zamanlı veri akışlarınızı test etmeye ve hata ayıklamaya yönelik başlangıç noktanızdır.

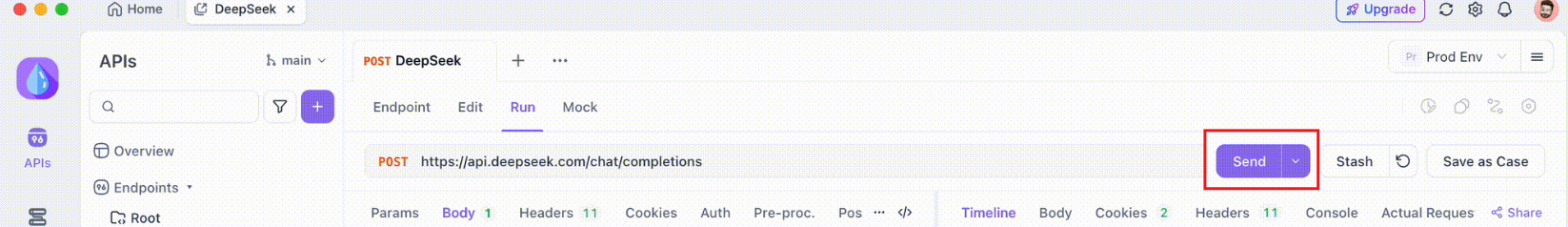

Adım 2: İsteği Gönderin

Uç noktanız kurulduktan sonra, API isteğini gönderin. Yanıt başlıklarını dikkatlice gözlemleyin. Başlık Content-Type: text/event-stream içeriyorsa, Apidog yanıtı otomatik olarak bir SSE akışı olarak tanıyacak ve yorumlayacaktır. Bu algılama, sonraki otomatik birleştirme süreci için çok önemlidir.

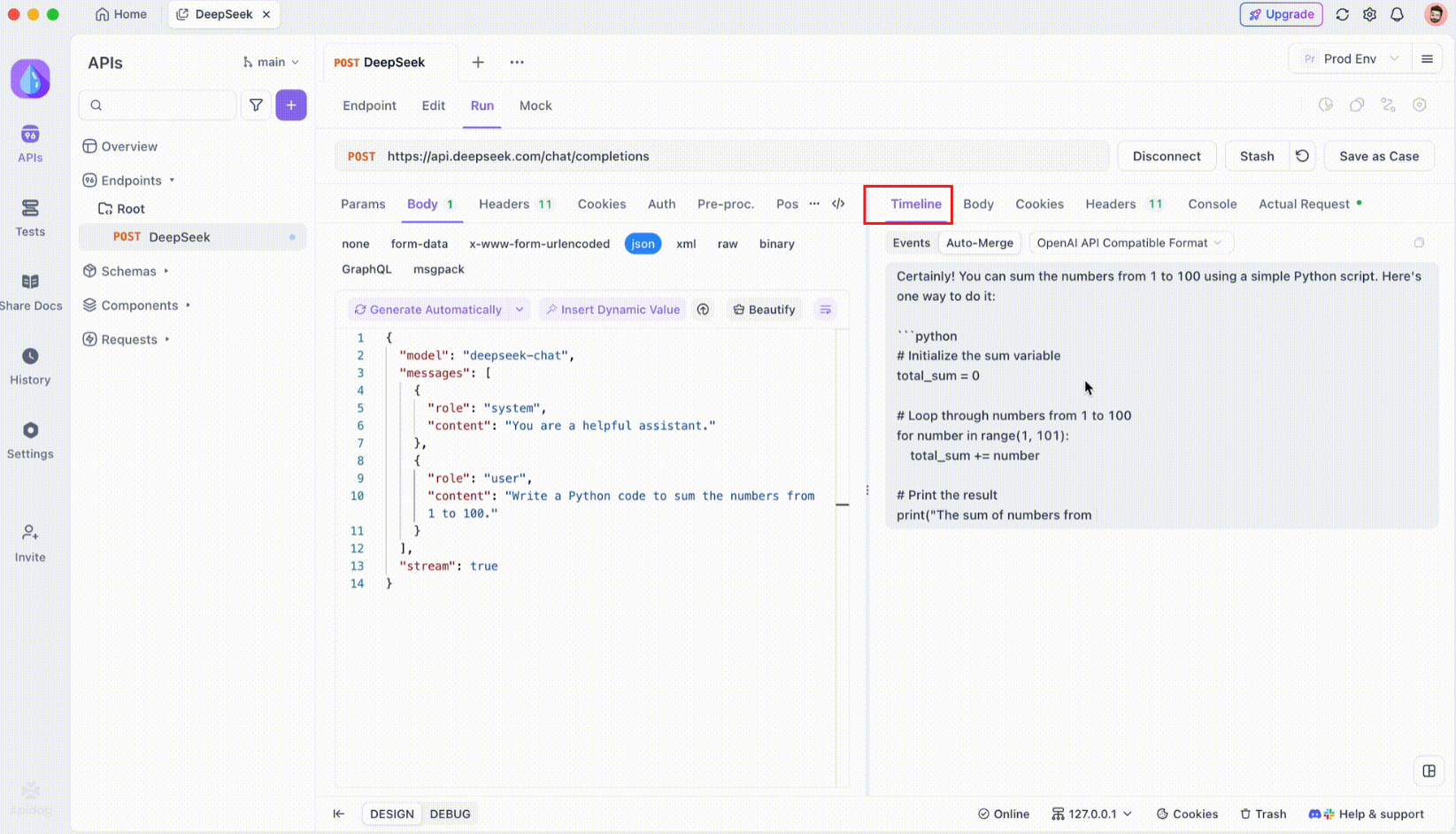

Adım 3: Gerçek Zamanlı Zaman Çizelgesini İzleyin

SSE bağlantısı kurulduktan sonra, Apidog, tüm gelen SSE olaylarının gerçek zamanlı olarak görüntülendiği özel bir zaman çizelgesi görünümü açacaktır. Bu zaman çizelgesi, yeni veriler geldikçe sürekli olarak güncellenir ve verilerin akışını iğne ucu hassasiyetiyle izlemenize olanak tanır. Zaman çizelgesi sadece ham bir veri dökümü değildir; verilerin tam olarak ne zaman ve nasıl iletildiğini görmenize yardımcı olan, dikkatlice yapılandırılmış bir görselleştirmedir.

Adım 4: Otomatik Birleştirme Mesajı

İşte sihrin gerçekleştiği yer burasıdır. Otomatik Birleştirme geliştirmeleriyle Apidog, popüler yapay zeka modeli biçimlerini otomatik olarak tanır ve parçalanmış SSE yanıtlarını eksiksiz bir yanıta birleştirir. Bu adım şunları içerir:

- Otomatik Tanıma: Apidog, yanıtın desteklenen bir biçimde (OpenAI, Gemini veya Claude) olup olmadığını kontrol eder.

- Mesaj Birleştirme: Biçim tanınırsa, platform otomatik olarak tüm SSE parçalarını birleştirerek kesintisiz, eksiksiz bir yanıt sunar.

- Gelişmiş Görselleştirme: DeepSeek R1 gibi belirli yapay zeka modelleri için, zaman çizelgesi aynı zamanda modelin düşünce sürecini de görüntüler ve oluşturulan yanıtın arkasındaki muhakemeye ek bir içgörü katmanı sunar.

Bu özellik, yapay zeka destekli uygulamalarla uğraşırken özellikle kullanışlıdır ve yanıtın her parçasının manuel müdahale olmadan yakalanmasını ve bütün olarak sunulmasını sağlar.

Adım 5: JSONPath Çıkarma Kurallarını Yapılandırın

Tüm SSE yanıtları otomatik olarak yerleşik biçimlere uymayacaktır. Özel çıkarma gerektiren JSON yanıtlarıyla uğraşırken, Apidog JSONPath kurallarını yapılandırmanıza olanak tanır. Örneğin, ham SSE yanıtınız bir JSON nesnesi içeriyorsa ve content alanını çıkarmanız gerekiyorsa, aşağıdaki gibi bir JSONPath yapılandırması ayarlayabilirsiniz:

- JSONPath:

$.choices[0].message.content - Açıklama:

$JSON nesnesinin kökünü ifade eder.choices[0]choicesdizisinin ilk öğesini seçer.message.contentmesaj nesnesi içindeki içerik alanını belirtir.

Bu yapılandırma, Apidog'a SSE yanıtınızdan istenen verileri nasıl çıkaracağını talimat verir ve standart olmayan yanıtların bile etkili bir şekilde işlenmesini sağlar.

Sonuç

Gemma 3'ü Ollama ile yerel olarak çalıştırmak, Google'ın gelişmiş yapay zeka yeteneklerinden makinenizden ayrılmadan yararlanmanın heyecan verici bir yoludur. Ollama'yı yüklemekten ve modeli indirmekten terminal veya API aracılığıyla etkileşim kurmaya kadar, bu kılavuz size her adımda yol gösterdi. Çok modlu özellikleri, çok dilli desteği ve etkileyici performansıyla Gemma 3, geliştiriciler ve yapay zeka meraklıları için oyunun kurallarını değiştiriyor. Kesintisiz API testi ve entegrasyonu için Apidog gibi araçlardan yararlanmayı unutmayın; Gemma 3 projelerinizi geliştirmek için bugün ücretsiz indirin!

İster bir dizüstü bilgisayarda 1B modelle uğraşıyor olun, ister bir GPU teçhizatında 27B modelin sınırlarını zorluyor olun, artık olasılıkları keşfetmeye hazırsınız. İyi kodlamalar ve Gemma 3 ile neler inşa ettiğinizi görelim!