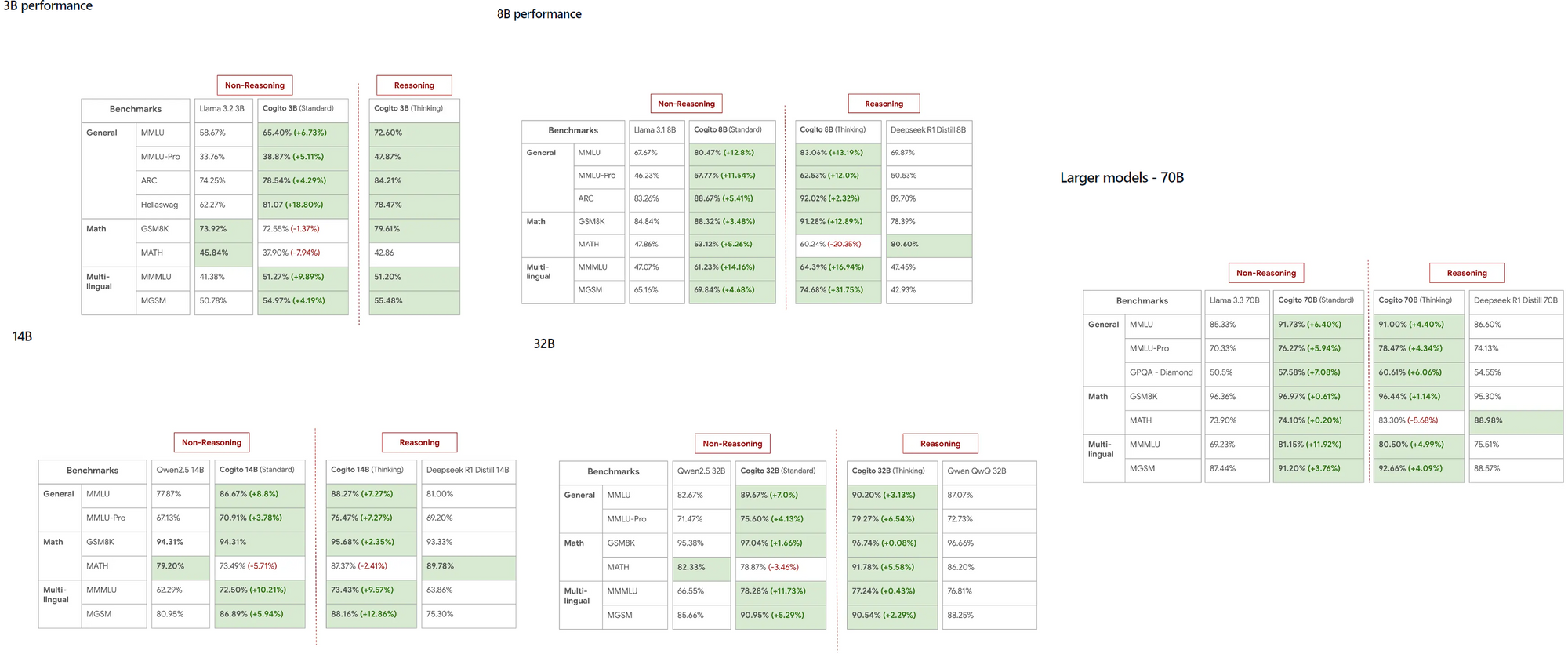

DeepCogito tarafından başlatılan Cogito modelleri, çeşitli ölçeklerde LLaMA ve DeepSeek gibi yerleşik modellerden daha iyi performans gösterme yetenekleriyle yapay zeka topluluğunda hızla dikkat çekti. 3B'den 70B parametreye kadar değişen bu açık kaynaklı modeller, geliştiricilere genel süper zekayı doğrudan yerel makinelerinde keşfetmeleri için güçlü bir araç sunuyor.

Cogito ve Ollama Hakkında Bilmeniz Gerekenler

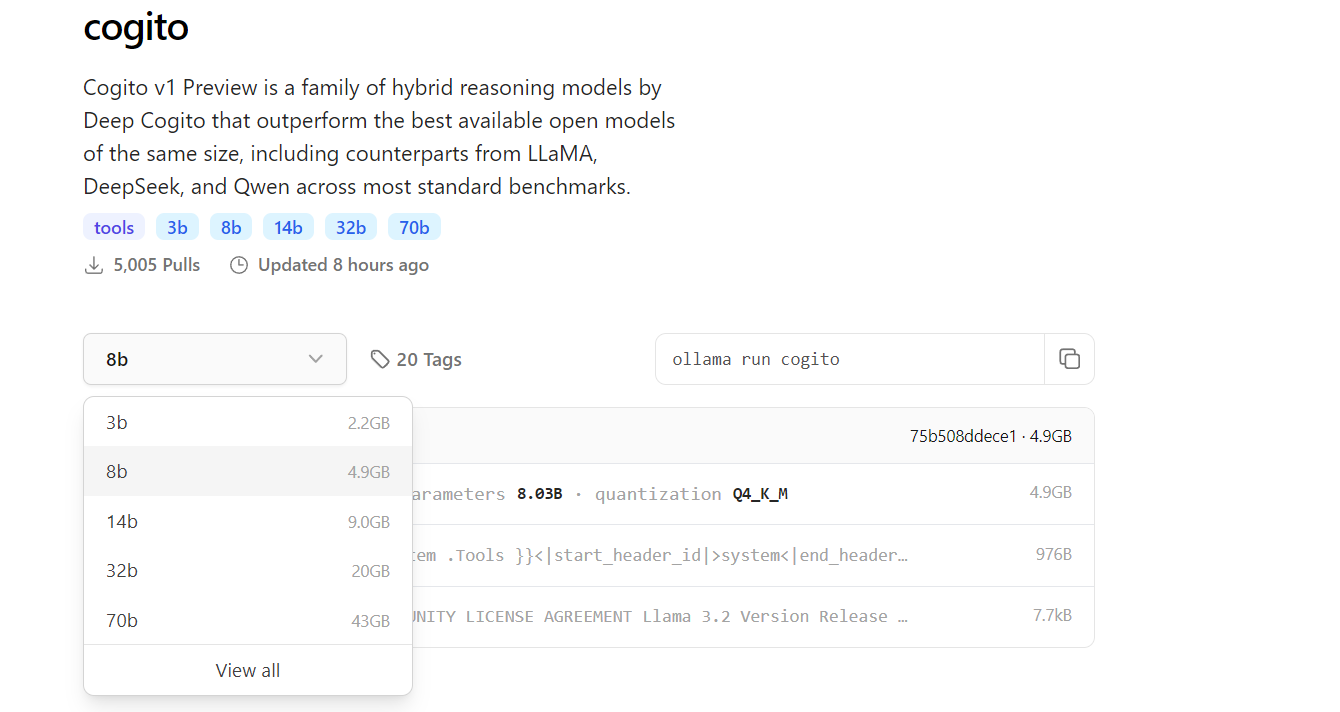

Cogito , genel süper zekayı elde etmeye odaklanan, DeepCogito ekibi tarafından geliştirilen bir dizi açık kaynaklı yapay zeka modelini temsil eder. Bu modeller, daha iyi çözümlere ulaşmak için daha fazla hesaplama kullanan ve ardından bu süreci modelin parametrelerine damıtan, yinelemeli damıtma ve amplifikasyon (IDA) adı verilen bir teknikten yararlanır. 3B, 8B, 14B, 32B ve 70B gibi boyutlarda mevcut olan Cogito modelleri, 109B ve 400B parametre modellerinin yaklaşan sürümleriyle daha da genişlemeye hazırlanıyor.

Öte yandan, Ollama, geliştiricilerin LLM'leri yerel makinelerinde çalıştırmalarını sağlayarak bulut tabanlı API'lere olan ihtiyacı ortadan kaldıran çok yönlü bir çerçevedir. MacOS, Windows ve Linux gibi birden fazla platformu destekleyen Ollama, çok çeşitli kullanıcılar için erişilebilirlik sağlar. Cogito'yu Ollama ile yerel olarak çalıştırarak, gelişmiş yapay zeka modellerini cihaz üzerinde deneyebilirsiniz; bu sadece maliyet tasarrufu sağlamakla kalmaz, aynı zamanda hassas uygulamalar için veri gizliliğini de artırır.

Cogito'yu Neden Yerel Olarak Çalıştırmalısınız?

Cogito'yu yerel olarak çalıştırmak, geliştiriciler için çeşitli avantajlar sunar. İlk olarak, harici API'lere olan bağımlılığı ortadan kaldırır, bu da gecikmeyi azaltır ve verilerinizin gizli kalmasını sağlar. Bu, veri güvenliğinin öncelikli olduğu uygulamalar için özellikle önemlidir. Ayrıca, Cogito modelleri, daha küçük ölçeklerde bile LLaMA 4 Scout gibi rakiplerine kıyasla üstün performans sergilemiştir ve bu da onları yüksek performanslı görevler için mükemmel bir seçim haline getirmektedir.

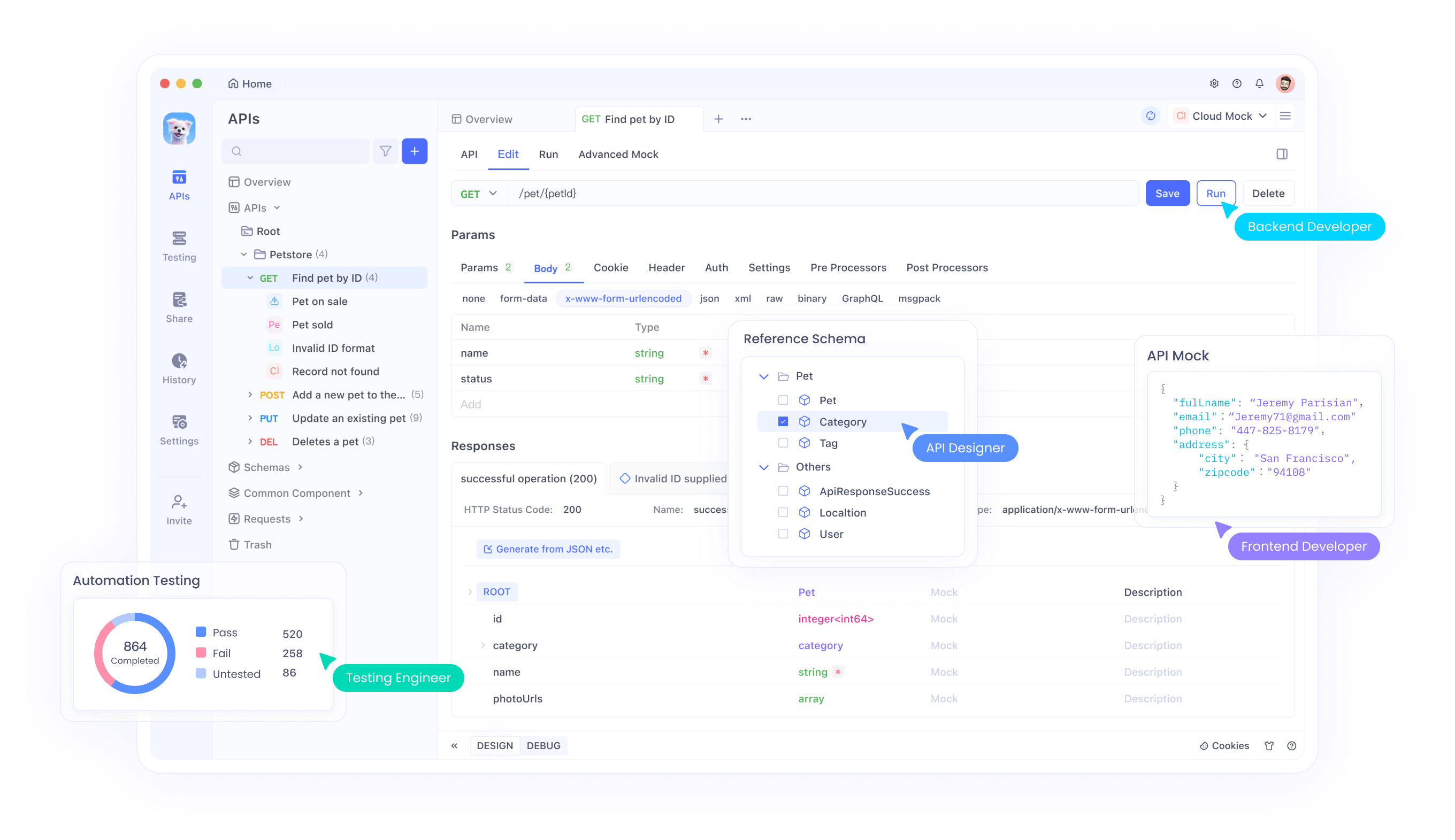

Yerel yürütme, aynı zamanda kaynakları kısıtlı ortamlarda veya sınırlı internet erişimi olan alanlarda çalışan geliştiriciler için de idealdir, çünkü bağlantı olmadan sorunsuz çalışmaya izin verir. Ek olarak, Ollama'nın basit komut satırı arayüzü, Cogito dahil olmak üzere birden fazla modeli yönetme ve çalıştırma sürecini basitleştirir. Son olarak, yerel bir kurulum, özellikle API entegrasyonlarını test ederken, geliştirme sırasında daha hızlı yinelemeyi sağlar; bu, uç noktalarınızı tasarlamak ve hata ayıklamak için Apidog gibi araçlar kullanılarak verimli bir şekilde yönetilebilir.

Ollama ile Cogito'yu Çalıştırmanın Ön Koşulları

Kurulum sürecine dalmadan önce, sisteminizin gerekli gereksinimleri karşıladığından emin olun. 3B veya 8B parametre sürümleri gibi daha küçük modeller için, makinenizin en az 16 GB RAM'e sahip olması gerekirken, 70B gibi daha büyük modellerin sorunsuz çalışması için 64 GB veya daha fazlasına ihtiyacı olabilir. CUDA desteği olan bir NVIDIA kartı gibi uyumlu bir GPU, model çıkarımını önemli ölçüde hızlandırdığı için şiddetle tavsiye edilir.

Ayrıca, Ollama'nın Python kitaplığı ve diğer ilgili araçlar için bir bağımlılık olduğundan, Python 3.8 veya daha yüksek bir sürümünü yüklemeniz gerekir.

Ardından, Ollama'yı resmi web sitesinden veya GitHub deposundan indirin ve işletim sisteminize özel talimatları izleyerek yükleyin. Depolama, bir diğer kritik faktördür; Cogito modelleri, 3B modeli için birkaç gigabayttan 70B modeli için 100 GB'tan fazlasına kadar değişebilir, bu nedenle sisteminizin yeterli alana sahip olduğundan emin olun. Son olarak, Cogito'yu API'lerle entegre etmeyi planlıyorsanız, Apidog'un yüklü olması, API uç noktalarınızı verimli bir şekilde tasarlamanıza ve test etmenize yardımcı olacak ve sorunsuz bir geliştirme deneyimi sağlayacaktır.

Adım 1: Ollama'yı Makinenize Yükleyin

Cogito'yu yerel olarak çalıştırmanın ilk adımı, Ollama'yı makinenize yüklemektir. İşletim sisteminiz için yükleyiciyi indirmek için Ollama web sitesini veya GitHub sayfasını ziyaret ederek başlayın. MacOS ve Windows kullanıcıları için, kurulumu tamamlamak için yükleyiciyi çalıştırın ve ekrandaki istemleri izleyin. Linux kullanıyorsanız, Ollama'yı doğrudan terminalinizde şu komutu çalıştırarak yükleyebilirsiniz:

curl -fsSL https://ollama.com/install.sh | sh

Yükleme tamamlandıktan sonra, bir terminal açın ve Ollama'nın doğru şekilde yüklenip yüklenmediğini doğrulamak için ollama --version yazın.

Ollama'nın çalıştığından emin olmak için, model yönetimi için yerel sunucuyu başlatan ollama serve komutunu çalıştırın. Bu adım aynı zamanda, sonraki adımlarda Cogito gibi modelleri çekmek ve çalıştırmak için kullanacağınız Ollama'nın komut satırı arayüzünü de kurar.

Adım 2: Cogito Modelini Ollama Kütüphanesinden Çekin

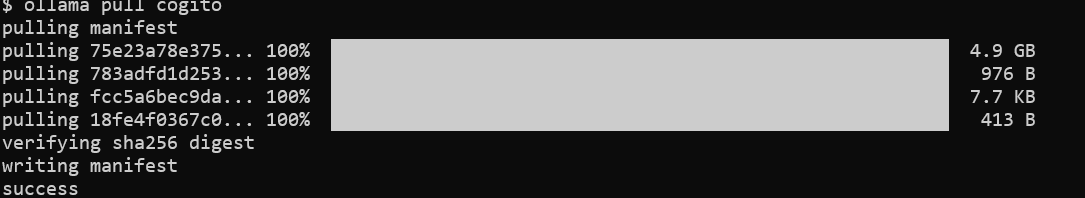

Ollama yüklendikten sonra, bir sonraki adım Cogito modelini indirmektir. Terminalinizi açın ve Cogito modelini Ollama kütüphanesinden getirmek için ollama pull cogito komutunu çalıştırın.

Varsayılan olarak, bu komut Cogito modelinin en son sürümünü çeker, ancak 3B parametre modeli için ollama pull cogito:3b gibi bir etiket kullanarak belirli bir boyutu belirtebilirsiniz. Mevcut model boyutlarını https://ollama.com/library/cogito adresinde keşfedebilirsiniz.

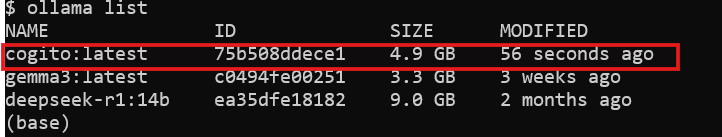

İnternet hızınıza ve model boyutuna bağlı olarak, indirme işlemi biraz zaman alabilir; 3B modeli için yaklaşık 2,2 GB ve 70B modeli için 43 GB'a kadar bekleyin. İndirme tamamlandıktan sonra, ollama list komutunu çalıştırarak modelin sisteminizde mevcut olduğunu doğrulayın; bu, yüklenen tüm modelleri görüntüler. Bu noktada, Cogito yerel olarak çalıştırılmaya hazırdır ve bir sonraki adıma geçebilirsiniz.

Adım 3: Cogito'yu Ollama ile Yerel Olarak Çalıştırın

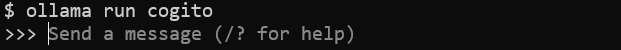

Model indirildikten sonra, Cogito'yu makinenizde çalıştırmaya başlayabilirsiniz. Terminalinizde, Cogito modelini başlatmak için ollama run cogito komutunu çalıştırın.

Adım 4: Apidog ile API Testini Geliştirin

Cogito, API kodu oluşturmada mükemmeldir, ancak bu API'leri test etmek çok önemlidir. Apidog bu süreci basitleştirir:

Apidog'u Yükleyin:

Apidog'u resmi sitesinden indirin ve yükleyin.

Oluşturulan API'yi Test Edin:

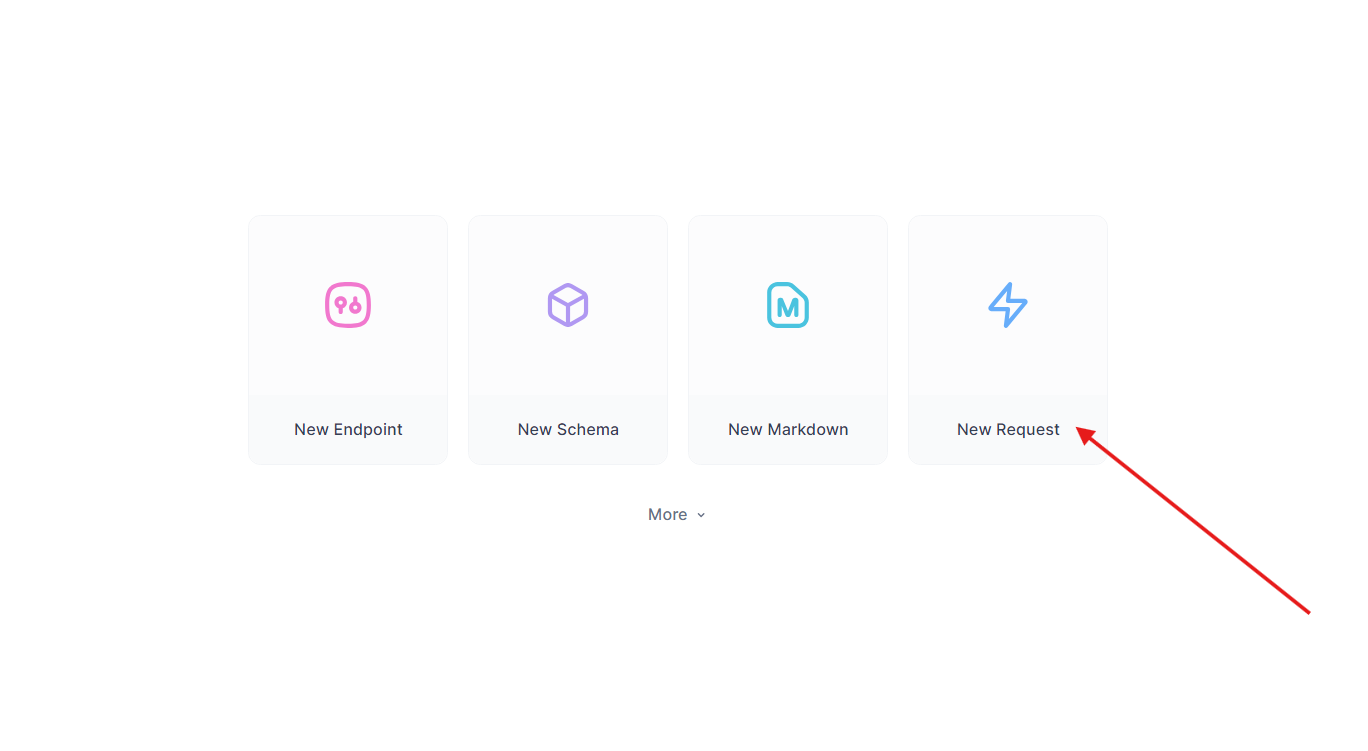

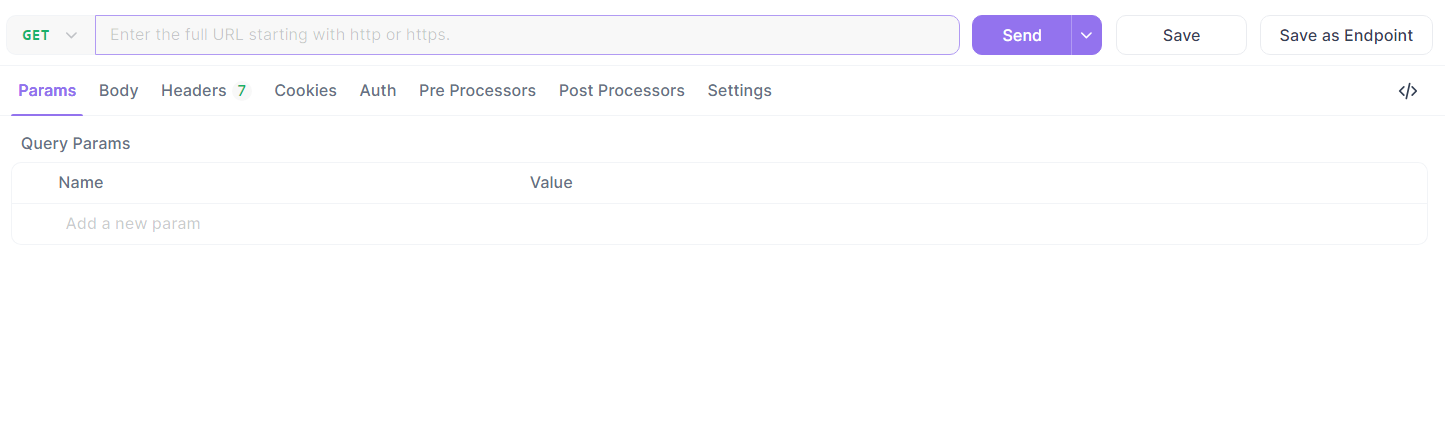

Daha önceki Flask uç noktasını alın. Apidog'da:

- Yeni bir istek oluşturun.

- URL'yi

http://localhost:5000/api/dataolarak ayarlayın ve bir GET isteği gönderin.

- Yanıtı doğrulayın:

{"message": "Hello, World!"}.

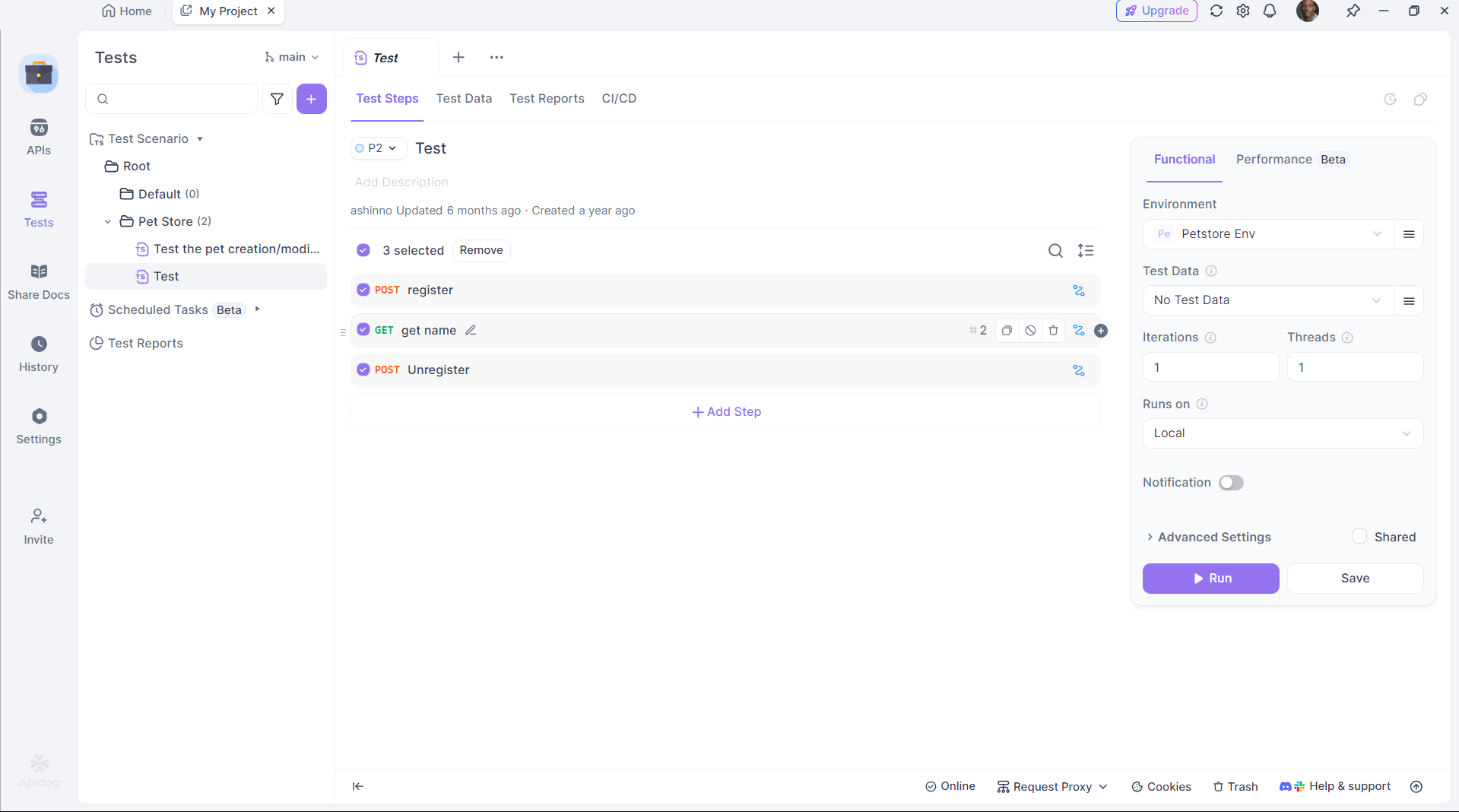

Testi Otomatikleştirin:

DeepCoder'ın çıktısının beklentileri karşıladığından emin olmak için doğrulamayı otomatikleştirmek için Apidog'un komut dosyalarını kullanın.

Apidog, kod oluşturma ve dağıtım arasındaki boşluğu doldurarak üretkenliği artırır.

Yaygın Sorunları Giderme

Cogito'yu yerel olarak çalıştırmak bazen zorluklar yaratabilir, ancak çoğu sorun birkaç kontrolle çözülebilir. Ollama başlamazsa, başka hiçbir işlemin 11434 numaralı bağlantı noktasını kullanmadığını doğrulayın; çakışan işlemi öldürebilir veya Ollama'nın yapılandırmasında bağlantı noktasını değiştirebilirsiniz. "Bellek yetersiz" hataları için, daha büyük modellere uyum sağlamak üzere model boyutunu azaltmayı veya sisteminizin takas alanını artırmayı düşünebilirsiniz. Model yanıt vermezse, ollama pull cogito kullanarak doğru şekilde çektiğinizden ve ollama list çıktısında göründüğünden emin olun. Yavaş çıkarım süreleri genellikle yalnızca CPU üzerinde çalıştığınızı gösterir; CUDA'nın etkin olduğunu doğrulamak için nvidia-smi komutunu çalıştırarak GPU desteğini kontrol edin.

API entegrasyonu için Apidog kullanırken, hatalar hatalı JSON yüklerinden kaynaklanabilir, bu nedenle Apidog'un düzenleyicisinde şemanızı iki kez kontrol edin. Daha ayrıntılı tanılama için, sorunları hızlı bir şekilde belirlemek ve çözmek için Ollama'nın günlüklerini ~/.ollama/logs adresinde inceleyin.

Sonuç

Cogito'yu Ollama ile yerel olarak çalıştırmak, genel süper zekayı keşfetmek isteyen geliştiriciler için bir olasılıklar dünyası açar. Bu kılavuzda özetlenen adımları izleyerek, Cogito'yu makinenizde kurabilir, performansını optimize edebilir ve hatta Apidog ile yönetilen API'leri kullanarak daha büyük uygulamalara entegre edebilirsiniz. İster bir RAG sistemi, ister bir kodlama asistanı veya bir web uygulaması oluşturuyor olun, Cogito'nun gelişmiş yetenekleri onu inovasyon için güçlü bir araç haline getirir. DeepCogito ekibi daha büyük modeller yayınlamaya ve tekniklerini geliştirmeye devam ettikçe, yerel yapay zeka geliştirme potansiyeli yalnızca artacak ve geliştiricilerin çığır açan çözümler oluşturmasını sağlayacaktır.