Alibaba Cloud'daki Qwen ekibi, büyük dil modeli (LLM) serilerine iki güçlü ekleme yayınladı: Qwen3-4B-Instruct-2507 ve Qwen3-4B-Thinking-2507. Bu modeller, 256K belirteç bağlam uzunluğu için yerel destekle birlikte muhakeme, talimat takibi ve uzun bağlam anlama konularında önemli ilerlemeler sağlıyor. Geliştiriciler, araştırmacılar ve yapay zeka meraklıları için tasarlanan bu modeller, kodlamadan karmaşık problem çözmeye kadar çeşitli görevler için güçlü yetenekler sunuyor. Ayrıca, ücretsiz bir API yönetim platformu olan Apidog gibi araçlar, bu modellerin uygulamalarınıza test edilmesini ve entegrasyonunu kolaylaştırabilir.

Qwen3-4B Modellerini Anlamak

Qwen3 serisi, Alibaba Cloud'un büyük dil modeli ailesindeki en son evrimi temsil ediyor ve Qwen2.5 serisinin devamı niteliğindedir. Özellikle, Qwen3-4B-Instruct-2507 ve Qwen3-4B-Thinking-2507 farklı kullanım durumları için özel olarak tasarlanmıştır: ilki genel amaçlı diyalog ve talimat takibinde üstünken, ikincisi karmaşık muhakeme görevleri için optimize edilmiştir. Her iki model de 262.144 belirteçlik yerel bir bağlam uzunluğunu destekleyerek kapsamlı veri kümelerini, uzun belgeleri veya çok turlu konuşmaları kolaylıkla işlemelerine olanak tanır. Ayrıca, Hugging Face Transformers gibi çerçeveler ve Apidog gibi dağıtım araçlarıyla uyumlulukları, onları hem yerel hem de bulut tabanlı uygulamalar için erişilebilir kılar.

Qwen3-4B-Instruct-2507: Verimlilik İçin Optimize Edildi

Qwen3-4B-Instruct-2507 modeli, genel amaçlı görevler için verimli, yüksek kaliteli yanıtlara odaklanarak düşünme dışı modda çalışır. Bu model, talimat takibi, mantıksal muhakeme, metin anlama ve çok dilli yetenekleri geliştirmek için ince ayar yapılmıştır. Özellikle, <think></think> blokları oluşturmaz, bu da adım adım muhakemeye kıyasla hızlı, doğrudan yanıtların tercih edildiği senaryolar için idealdir.

Temel geliştirmeler şunları içerir:

- Geliştirilmiş Genel Yetenekler: Model, matematik, bilim, kodlama ve araç kullanımında üstün performans sergileyerek teknik uygulamalar için çok yönlü hale gelmiştir.

- Çok Dilli Destek: 100'den fazla dil ve lehçeyi kapsar, küresel uygulamalarda sağlam performans sağlar.

- Uzun Bağlam Anlama: 256K belirteç bağlam uzunluğu ile, yasal belgeler veya uzun kod tabanları gibi genişletilmiş girdileri kesme yapmadan işler.

- Kullanıcı Tercihleriyle Uyum: Model, yaratıcı yazım ve çok turlu diyaloglarda üstün başarı göstererek daha doğal ve ilgi çekici yanıtlar sunar.

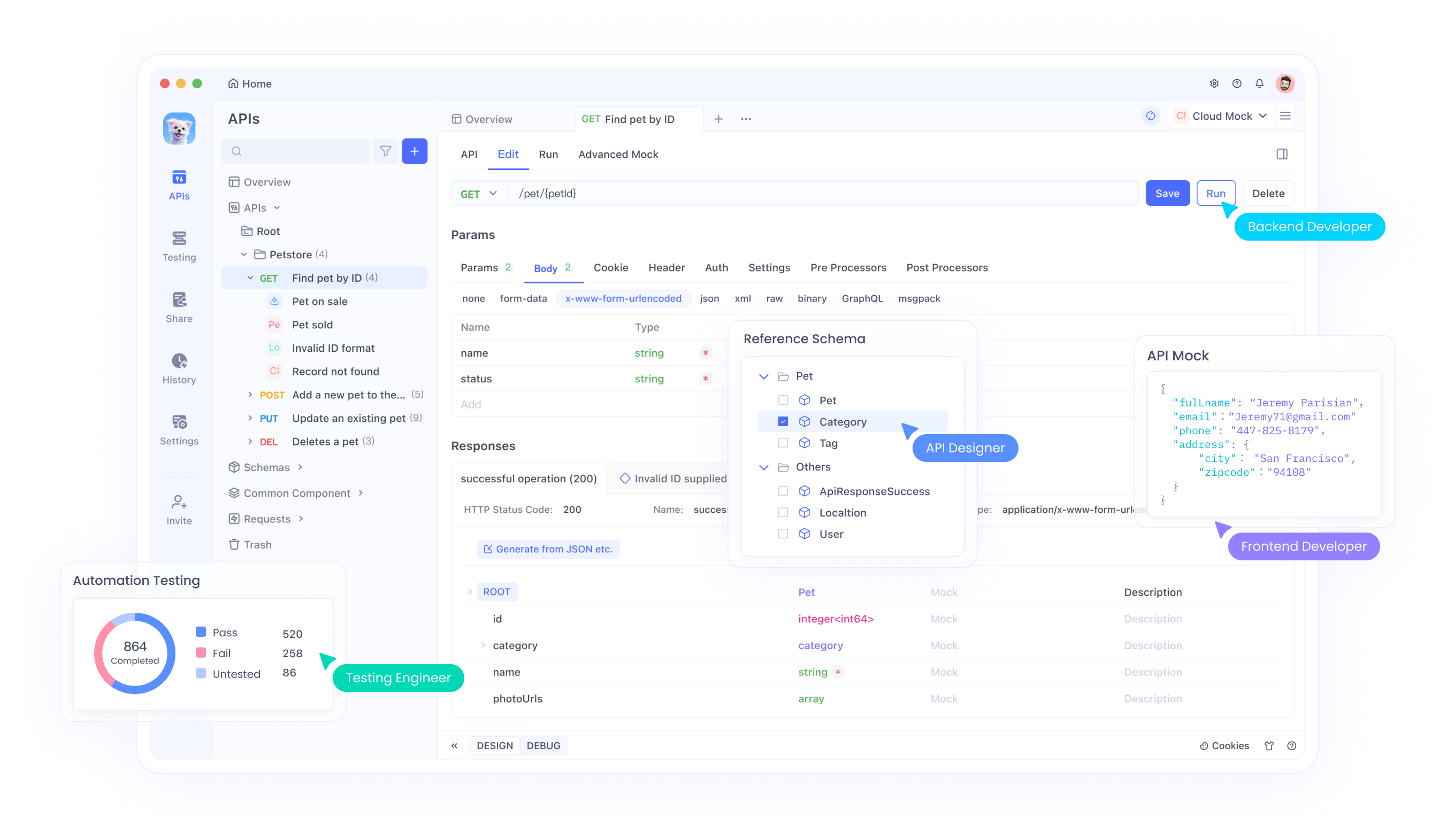

Bu modeli API'lere entegre eden geliştiriciler için Apidog, API uç noktalarını test etmek ve yönetmek için kullanıcı dostu bir arayüz sağlayarak sorunsuz dağıtım sağlar. Bu verimlilik, Qwen3-4B-Instruct-2507'yi hızlı ve doğru yanıtlar gerektiren uygulamalar için tercih edilen bir seçenek haline getirir.

Qwen3-4B-Thinking-2507: Derin Muhakeme İçin Oluşturuldu

Buna karşılık, Qwen3-4B-Thinking-2507, mantıksal problem çözme, matematik ve akademik kıyaslamalar gibi yoğun muhakeme gerektiren görevler için tasarlanmıştır. Bu model, karmaşık problemleri parçalara ayırmak için düşünce zinciri (CoT) süreçlerini otomatik olarak dahil ederek yalnızca düşünme modunda çalışır. Varsayılan sohbet şablonu düşünme davranışını içerdiğinden, çıktısı açılış <think> etiketi olmadan kapanış </think> etiketini içerebilir.

Temel geliştirmeler şunları içerir:

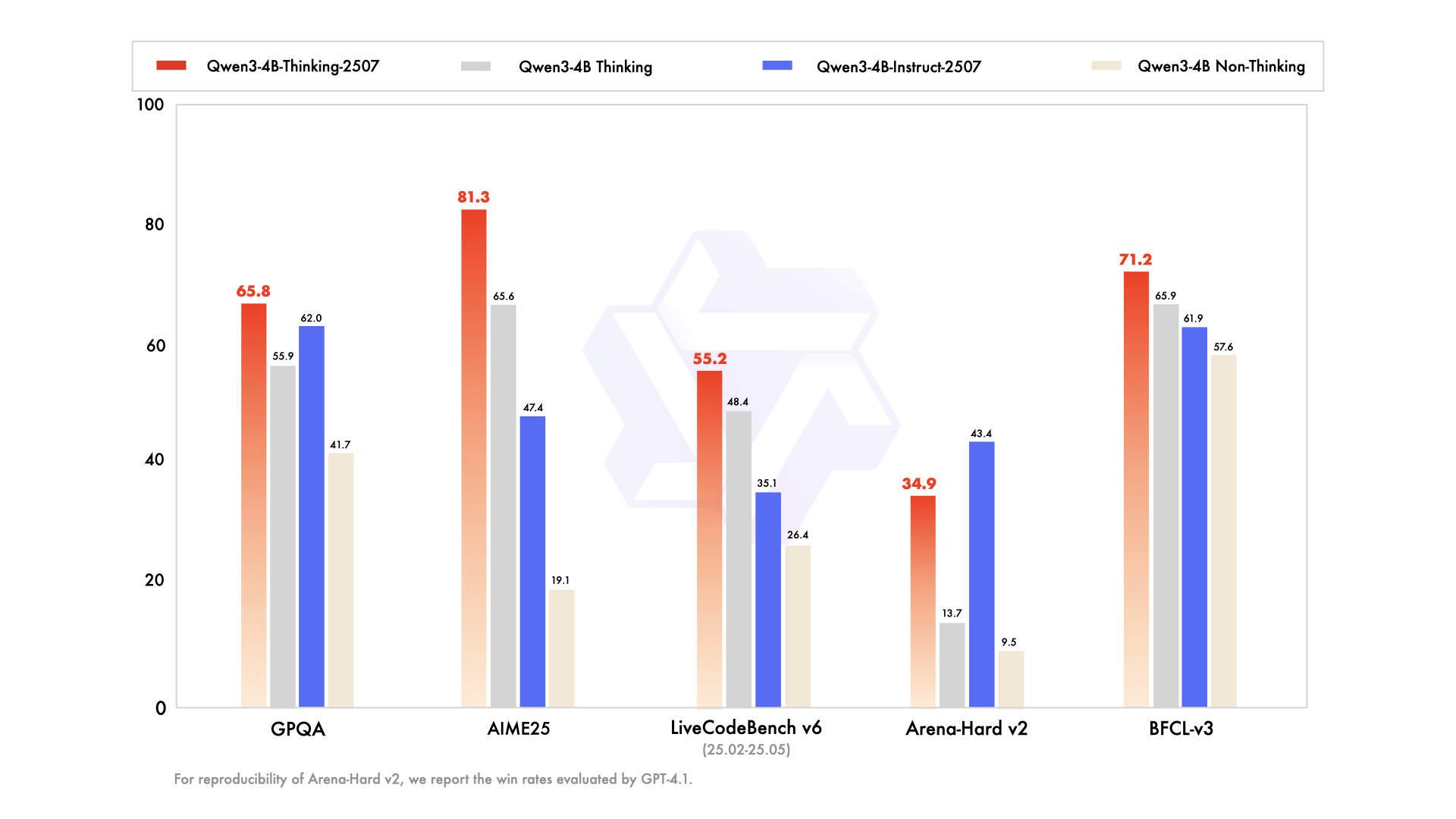

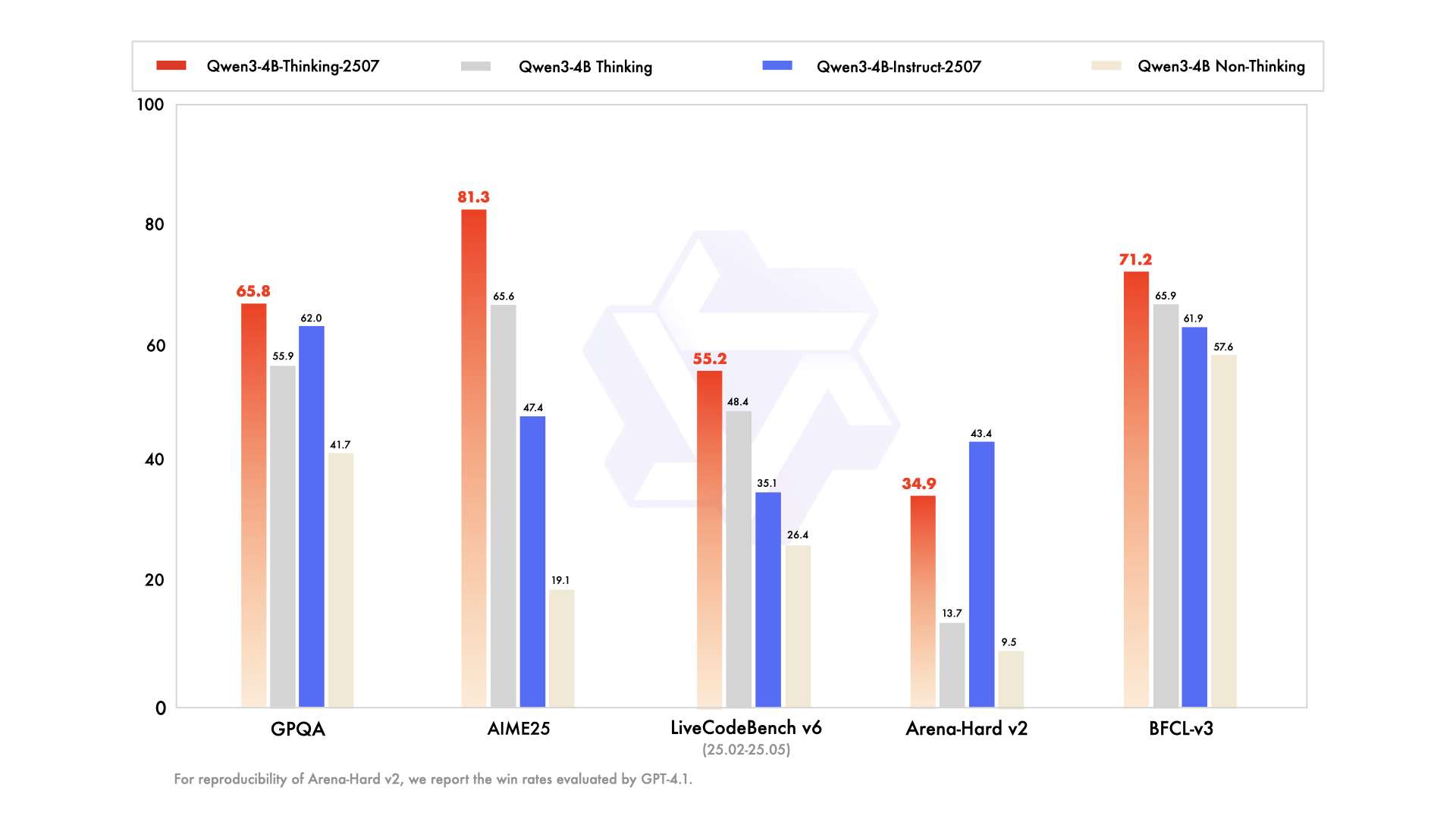

- Gelişmiş Muhakeme Yetenekleri: Model, özellikle STEM alanlarında ve kodlamada açık kaynaklı düşünme modelleri arasında son teknoloji sonuçlar elde etmektedir.

- Artırılmış Düşünme Derinliği: Kapsamlı analiz için uzatılmış düşünme uzunluğu ile insan uzmanı düzeyinde muhakeme gerektiren görevlerde üstün başarı gösterir.

- 256K Bağlam Uzunluğu: Instruct muadili gibi, büyük veri kümelerini veya karmaşık sorguları işlemek için ideal olan büyük bağlam pencerelerini destekler.

- Araç Entegrasyonu: Model, otomatik sistemlerdeki faydasını artırarak kolaylaştırılmış ajanik iş akışları için Qwen-Agent gibi araçlardan yararlanır.

Muhakeme yoğun uygulamalarla çalışan geliştiriciler için Apidog, API testini kolaylaştırarak modelin çıktılarının beklenen sonuçlarla uyumlu olmasını sağlayabilir. Bu model, özellikle araştırma ortamları ve karmaşık problem çözme senaryoları için uygundur.

Teknik Özellikler ve Mimari

Her iki Qwen3-4B modeli de, yoğun ve uzman karışımı (MoE) mimarilerini içeren Qwen3 ailesinin bir parçasıdır. 4B tanımı, hesaplama verimliliği ve performans arasında bir denge sağlayan 4 milyar parametrelerini ifade eder. Sonuç olarak, bu modeller, önemli kaynaklar gerektiren Qwen3-235B-A22B gibi daha büyük modellerin aksine, tüketici sınıfı donanımlarda erişilebilirdir.

Mimari Önemli Noktalar

- Yoğun Model Tasarımı: MoE modellerinin aksine, Qwen3-4B modelleri yoğun bir mimari kullanır ve seçici parametre aktivasyonuna gerek kalmadan görevler arasında tutarlı performans sağlar.

- Bağlam Uzantısı için YaRN: Modeller, bağlam uzunluklarını 32.768'den 262.144 belirtece uzatmak için YaRN'den yararlanır ve önemli performans düşüşü olmadan uzun bağlam işlemesine olanak tanır.

- Eğitim Hattı: Qwen ekibi, uzun düşünce zinciri soğuk başlangıcı, muhakeme tabanlı pekiştirmeli öğrenme, düşünme modu füzyonu ve genel pekiştirmeli öğrenme dahil olmak üzere dört aşamalı bir eğitim süreci kullandı. Bu yaklaşım hem muhakeme hem de diyalog yeteneklerini geliştirir.

- Kuantizasyon Desteği: Her iki model de FP8 kuantizasyonunu destekler, bellek gereksinimlerini azaltırken doğruluğu korur. Örneğin, Qwen3-4B-Thinking-2507-FP8, kaynak kısıtlı ortamlar için mevcuttur.

Donanım Gereksinimleri

Bu modelleri verimli bir şekilde çalıştırmak için aşağıdaki önerileri göz önünde bulundurun:

- GPU Belleği: FP8 kuantize edilmiş modeller için minimum 8GB VRAM önerilirken, bfloat16 modelleri 16GB veya daha fazlasını gerektirebilir.

- RAM: Optimal performans için, 16GB birleşik bellek (VRAM + RAM) çoğu görev için yeterlidir.

- Çıkarım Çerçeveleri: Her iki model de Hugging Face Transformers (sürüm ≥4.51.0), vLLM (≥0.8.5) ve SGLang (≥0.4.6.post1) ile uyumludur. Ollama ve LMStudio gibi yerel araçlar da Qwen3'ü destekler.

Bu modelleri dağıtan geliştiriciler için Apidog, API performansını izlemek ve test etmek için araçlar sağlayarak çıkarım çerçeveleriyle verimli entegrasyonu garanti ederek süreci basitleştirir.

Hugging Face ve ModelScope ile Entegrasyon

Qwen3-4B modelleri hem Hugging Face hem de ModelScope'ta mevcuttur ve geliştiriciler için esneklik sunar. Aşağıda, Qwen3-4B-Instruct-2507'yi Hugging Face Transformers ile nasıl kullanacağınızı gösteren bir kod parçacığı sunuyoruz.

from transformers import AutoModelForCausalLM, AutoTokenizer

model_name = "Qwen/Qwen3-4B-Instruct-2507"tokenizer = AutoTokenizer.from_pretrained(model_name)model = AutoModelForCausalLM.from_pretrained(model_name, torch_dtype="auto", device_map="auto")

prompt = "Write a Python function to calculate Fibonacci numbers."messages = [{"role": "user", "content": prompt}]text = tokenizer.apply_chat_template(messages, tokenize=False, add_generation_prompt=True)model_inputs = tokenizer([text], return_tensors="pt").to(model.device)

generated_ids = model.generate(**model_inputs, max_new_tokens=16384)output_ids = generated_ids[0][len(model_inputs.input_ids[0]):].tolist()content = tokenizer.decode(output_ids, skip_special_tokens=True)print("Generated Code:\n", content)Qwen3-4B-Thinking-2507 için, düşünme içeriğini işlemek üzere ek ayrıştırma gereklidir:

from transformers import AutoModelForCausalLM, AutoTokenizer

model_name = "Qwen/Qwen3-4B-Thinking-2507"tokenizer = AutoTokenizer.from_pretrained(model_name)model = AutoModelForCausalLM.from_pretrained(model_name, torch_dtype="auto", device_map="auto")

prompt = "Solve the equation 2x^2 + 3x - 5 = 0."messages = [{"role": "user", "content": prompt}]text = tokenizer.apply_chat_template(messages, tokenize=False, add_generation_prompt=True)model_inputs = tokenizer([text], return_tensors="pt").to(model.device)

generated_ids = model.generate(**model_inputs, max_new_tokens=32768)output_ids = generated_ids[0][len(model_inputs.input_ids[0]):].tolist()

try:index = len(output_ids) - output_ids[::-1].index(151668) # tokenexcept ValueError:index = 0thinking_content = tokenizer.decode(output_ids[:index], skip_special_tokens=True).strip("\n")content = tokenizer.decode(output_ids[index:], skip_special_tokens=True).strip("\n")print("Thinking Process:\n", thinking_content)print("Solution:\n", content)Bu kod parçacıkları, Qwen modellerini Python iş akışlarına entegre etmenin kolaylığını göstermektedir. API tabanlı dağıtımlar için Apidog, bu uç noktaları test etmeye yardımcı olarak güvenilir performans sağlar.

Performans Optimizasyonu ve En İyi Uygulamalar

Qwen3-4B modellerinin performansını en üst düzeye çıkarmak için aşağıdaki önerileri göz önünde bulundurun:

- Örnekleme Parametreleri: Qwen3-4B-Instruct-2507 için

temperature=0.7,top_p=0.8,top_k=20vemin_p=0kullanın. Qwen3-4B-Thinking-2507 içintemperature=0.6,top_p=0.95,top_k=20vemin_p=0kullanın. Performans düşüşünü önlemek için açgözlü kod çözmeden kaçının. - Bağlam Uzunluğu Yönetimi: Bellek yetersizliği sorunlarıyla karşılaşırsanız, bağlam uzunluğunu 32.768 belirtece düşürün. Ancak, muhakeme görevleri için bağlam uzunluğunu 131.072 belirtecin üzerinde tutun.

- Varlık Cezası: Tekrarları azaltmak için

presence_penaltydeğerini 0 ile 2 arasında ayarlayın, ancak dil karışımını önlemek için yüksek değerlerden kaçının. - Çıkarım Çerçeveleri: Yüksek verimli çıkarım için vLLM veya SGLang kullanın ve API performansını izlemek için Apidog'dan yararlanın.

Qwen3-4B-Instruct-2507 ve Qwen3-4B-Thinking-2507'yi Karşılaştırma

Her iki model de aynı 4 milyar parametreli mimariyi paylaşsa da, tasarım felsefeleri farklıdır:

- Qwen3-4B-Instruct-2507: Hız ve verimliliği önceliklendirir, bu da onu sohbet botları, müşteri desteği ve genel amaçlı uygulamalar için uygun hale getirir.

- Qwen3-4B-Thinking-2507: Derin muhakemeye odaklanır, akademik araştırma, karmaşık problem çözme ve düşünce zinciri süreçleri gerektiren görevler için idealdir.

Geliştiriciler, görev gereksinimlerine göre esneklik sağlayarak /think ve /no_think komutlarını kullanarak modlar arasında geçiş yapabilirler. Apidog, API odaklı uygulamalarda bu mod geçişlerini test etmeye yardımcı olabilir.

Topluluk ve Ekosistem Desteği

Qwen3-4B modelleri, Hugging Face, ModelScope ve Ollama, LMStudio ve llama.cpp gibi araçların desteğiyle sağlam bir ekosistemden faydalanır. Apache 2.0 lisansı altında açık kaynaklı olan bu modellerin yapısı, topluluk katkılarını ve ince ayarı teşvik eder. Örneğin, Unsloth, %70 daha az VRAM ile 2 kat daha hızlı ince ayar için araçlar sağlayarak bu modelleri daha geniş bir kitleye erişilebilir kılar.

Sonuç

Qwen3-4B-Instruct-2507 ve Qwen3-4B-Thinking-2507 modelleri, Alibaba Cloud'un Qwen serisinde talimat takibi, muhakeme ve uzun bağlam işleme konularında eşsiz yetenekler sunarak önemli bir sıçrama yapmıştır. 256K belirteç bağlam uzunluğu, çok dilli destek ve Apidog gibi araçlarla uyumluluk sayesinde bu modeller, geliştiricilere akıllı, ölçeklenebilir uygulamalar oluşturma gücü vermektedir. İster kod üretiyor, ister denklemleri çözüyor, ister çok dilli sohbet botları oluşturuyor olun, bu modeller olağanüstü performans sunar. Potansiyellerini bugün keşfetmeye başlayın ve sorunsuz bir geliştirme deneyimi için API entegrasyonlarınızı kolaylaştırmak için Apidog'u kullanın.