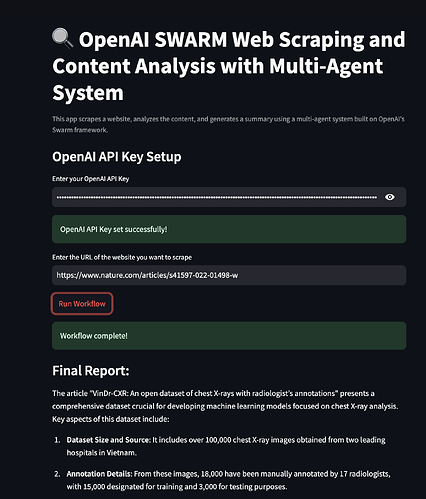

Hoş geldiniz! Web kazıma ve içerik analizi için en son yapay zeka araçlarından nasıl yararlanacağınızı merak ettiyseniz, doğru yerdesiniz. Bugün, OpenAI SWARM, Streamlit ve çoklu ajan sistemlerini birleştiren ve web kazımayı daha akıllı, içerik analizini daha anlayışlı hale getiren heyecan verici bir projeye derinlemesine dalacağız. Ayrıca, Apidog'un API testini nasıl basitleştirebileceğini ve API ihtiyaçlarınız için daha uygun fiyatlı bir alternatif olarak nasıl hizmet verebileceğini de inceleyeceğiz.

Şimdi, tamamen işlevsel bir web kazıma ve içerik analizi sistemi oluşturmaya başlayalım!

1. OpenAI SWARM Nedir?

OpenAI SWARM, web kazıma ve içerik analizi dahil olmak üzere çeşitli görevleri otomatikleştirmek için yapay zeka ve çoklu ajan sistemlerinden yararlanmaya yönelik gelişmekte olan bir yaklaşımdır. Temelinde SWARM, ortak bir hedefe ulaşmak için bağımsız olarak çalışabilen veya belirli görevler üzerinde işbirliği yapabilen birden fazla ajan kullanmaya odaklanır.

SWARM Nasıl Çalışır?

Analiz için veri toplamak üzere birden fazla web sitesini kazımak istediğinizi hayal edin. Tek bir kazıyıcı bot kullanmak işe yarayabilir, ancak darboğazlara, hatalara veya hatta web sitesi tarafından engellenmeye eğilimlidir. Ancak, SWARM, görevin farklı yönlerini ele almak için birkaç ajan dağıtmanıza olanak tanır; bazı ajanlar veri çıkarma, diğerleri veri temizleme ve diğerleri de verileri analiz için dönüştürmeye odaklanır. Bu ajanlar birbirleriyle iletişim kurabilir ve görevlerin verimli bir şekilde ele alınmasını sağlar.

OpenAI'nin güçlü dil modellerini ve SWARM metodolojilerini birleştirerek, insan problem çözmeyi taklit eden akıllı, uyarlanabilir sistemler oluşturabilirsiniz. Bu eğitimde daha akıllı web kazıma ve veri işleme için SWARM tekniklerini kullanacağız.

2. Çoklu Ajan Sistemlerine Giriş

Bir çoklu ajan sistemi (MAS), karmaşık sorunları çözmek için paylaşılan bir ortamda etkileşimde bulunan özerk ajanların bir koleksiyonudur. Ajanlar görevleri paralel olarak gerçekleştirebilir, bu da MAS'ı verilerin çeşitli kaynaklardan toplanması veya farklı işleme aşamalarına ihtiyaç duyulması gereken durumlar için ideal hale getirir.

Web kazıma bağlamında, çoklu bir ajan sistemi şunlar için ajanlar içerebilir:

- Veri Çıkarma: İlgili verileri toplamak için farklı web sayfalarını tarama.

- İçerik Ayrıştırma: Analiz için verileri temizleme ve düzenleme.

- Veri Analizi: Toplanan verilerden içgörüler elde etmek için algoritmalar uygulama.

- Raporlama: Sonuçları kullanıcı dostu bir formatta sunma.

Web Kazıma için Neden Çoklu Ajan Sistemleri Kullanmalı?

Çoklu ajan sistemleri, arızalara karşı sağlamdır ve eşzamansız olarak çalışabilir. Bu, bir ajan başarısız olsa veya bir sorunla karşılaşsa bile, diğerlerinin görevlerine devam edebileceği anlamına gelir. Bu nedenle SWARM yaklaşımı, web kazıma projelerinde daha yüksek verimlilik, ölçeklenebilirlik ve hata toleransı sağlar.

3. Streamlit: Genel Bakış

Streamlit , veri analizi, makine öğrenimi ve otomasyon projeleri için özel web uygulamaları oluşturmayı ve paylaşmayı kolaylaştıran popüler bir açık kaynaklı Python kütüphanesidir. Herhangi bir ön uç deneyimi olmadan etkileşimli UI'ler oluşturabileceğiniz bir çerçeve sağlar.

Neden Streamlit?

- Kullanım Kolaylığı: Python kodu yazın ve Streamlit bunu kullanıcı dostu bir web arayüzüne dönüştürür.

- Hızlı Prototipleme: Yeni fikirlerin hızlı bir şekilde test edilmesini ve dağıtılmasını sağlar.

- Yapay Zeka Modelleriyle Entegrasyon: Makine öğrenimi kütüphaneleri ve API'lerle sorunsuz bir şekilde entegre olur.

- Özelleştirme: Farklı kullanım durumları için sofistike uygulamalar oluşturmak için yeterince esnek.

Projemizde, web kazıma sonuçlarını görselleştirmek, içerik analizi metriklerini görüntülemek ve çoklu ajan sistemimizi kontrol etmek için etkileşimli bir arayüz oluşturmak için Streamlit'i kullanacağız.

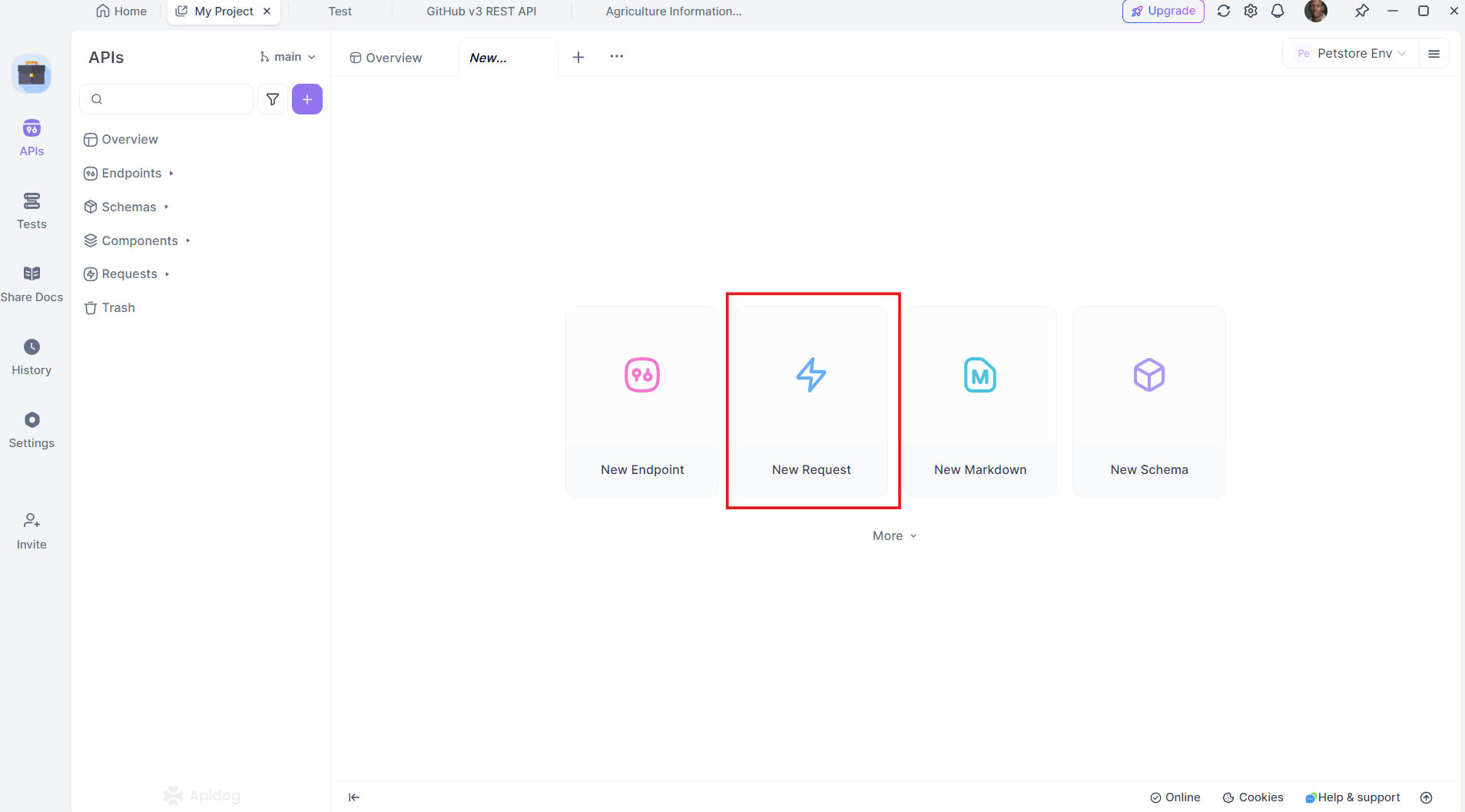

4. Neden Apidog Bir Oyun Değiştirici?

Apidog , geleneksel API geliştirme ve test araçlarına güçlü bir alternatiftir. Tasarımdan test etmeye ve dağıtıma kadar tüm API yaşam döngüsünü tek bir birleşik platformda destekler.

Apidog'un Temel Özellikleri:

- Kullanıcı Dostu Arayüz: Kullanımı kolay sürükle ve bırak API tasarımı.

- Otomatik Test: Ek komut dosyaları yazmadan kapsamlı API testi gerçekleştirin.

- Yerleşik Dokümantasyon: Ayrıntılı API dokümantasyonunu otomatik olarak oluşturun.

- Daha Ucuz Fiyatlandırma Planları: Rakiplerine kıyasla daha uygun fiyatlı bir seçenek sunar.

Apidog, API entegrasyonu ve testinin temel olduğu projeler için mükemmel bir eşleşmedir ve onu uygun maliyetli ve kapsamlı bir çözüm haline getirir.

Apidog'u ücretsiz indirin ve bu avantajları ilk elden deneyimleyin.

5. Geliştirme Ortamınızı Kurma

Koda dalmadan önce, ortamımızın hazır olduğundan emin olalım. İhtiyacınız olacak:

- Python 3.7+

- Streamlit:

pip install streamlitile yükleyin - Web kazıma için BeautifulSoup:

pip install beautifulsoup4ile yükleyin - Requests:

pip install requestsile yükleyin - Apidog: API testi için, Apidog'un resmi web sitesinden indirebilirsiniz

Yukarıdakilerin tümünün yüklü olduğundan emin olun. Şimdi, ortamı yapılandıralım.

6. Web Kazıma için Çoklu Ajan Sistemi Oluşturma

OpenAI SWARM ve Python kütüphanelerini kullanarak web kazıma için çoklu bir ajan sistemi oluşturalım. Buradaki amaç, çeşitli web sitelerinden veri tarama, ayrıştırma ve analiz etme gibi görevleri gerçekleştirmek için birden fazla ajan oluşturmaktır.

Adım 1: Ajanları Tanımlama

Farklı görevler için ajanlar oluşturacağız:

- Tarayıcı Ajanı: Web sayfalarından ham HTML toplar.

- Ayrıştırıcı Ajanı: Anlamlı bilgileri çıkarır.

- Analizci Ajanı: İçgörüler için verileri işler.

İşte Python'da basit bir CrawlerAgent'ı nasıl tanımlayabileceğiniz:

import requests

from bs4 import BeautifulSoup

class CrawlerAgent:

def __init__(self, url):

self.url = url

def fetch_content(self):

try:

response = requests.get(self.url)

if response.status_code == 200:

return response.text

else:

print(f"Failed to fetch content from {self.url}")

except Exception as e:

print(f"Error: {str(e)}")

return None

crawler = CrawlerAgent("https://example.com")

html_content = crawler.fetch_content()

Adım 2: Bir Ayrıştırıcı Ajan Ekleme

ParserAgent ham HTML'i temizleyecek ve yapılandıracaktır:

class ParserAgent:

def __init__(self, html_content):

self.html_content = html_content

def parse(self):

soup = BeautifulSoup(self.html_content, 'html.parser')

parsed_data = soup.find_all('p') # Example: Extracting all paragraphs

return [p.get_text() for p in parsed_data]

parser = ParserAgent(html_content)

parsed_data = parser.parse()

Adım 3: Bir Analizci Ajan Ekleme

Bu ajan, içeriği analiz etmek için doğal dil işleme (NLP) tekniklerini uygulayacaktır.

from collections import Counter

class AnalyzerAgent:

def __init__(self, text_data):

self.text_data = text_data

def analyze(self):

word_count = Counter(" ".join(self.text_data).split())

return word_count.most_common(10) # Example: Top 10 most common words

analyzer = AnalyzerAgent(parsed_data)

analysis_result = analyzer.analyze()

print(analysis_result)

7. SWARM ve Streamlit ile İçerik Analizi

Artık ajanlarımız birlikte çalıştığına göre, sonuçları Streamlit kullanarak görselleştirelim.

Adım 1: Bir Streamlit Uygulaması Oluşturma

Streamlit'i içe aktararak ve temel uygulama yapısını ayarlayarak başlayın:

import streamlit as st

st.title("Web Kazıma ve Çoklu Ajan Sistemleri ile İçerik Analizi")

st.write("Daha akıllı veri çıkarma için OpenAI SWARM ve Streamlit kullanma.")

Adım 2: Ajanları Entegre Etme

Ajanlarımızı Streamlit uygulamasına entegre edeceğiz, böylece kullanıcıların bir URL girmesine ve kazıma ve analiz sonuçlarını görmesine olanak tanıyacağız.

url = st.text_input("Kazımak için bir URL girin:")

if st.button("Kazı ve Analiz Et"):

if url:

crawler = CrawlerAgent(url)

html_content = crawler.fetch_content()

if html_content:

parser = ParserAgent(html_content)

parsed_data = parser.parse()

analyzer = AnalyzerAgent(parsed_data)

analysis_result = analyzer.analyze()

st.subheader("En Çok Kullanılan 10 Kelime")

st.write(analysis_result)

else:

st.error("İçerik alınamadı. Lütfen farklı bir URL deneyin.")

else:

st.warning("Lütfen geçerli bir URL girin.")

Adım 3: Uygulamayı Dağıtma

Uygulamayı şu komutu kullanarak dağıtabilirsiniz:

streamlit run your_script_name.py

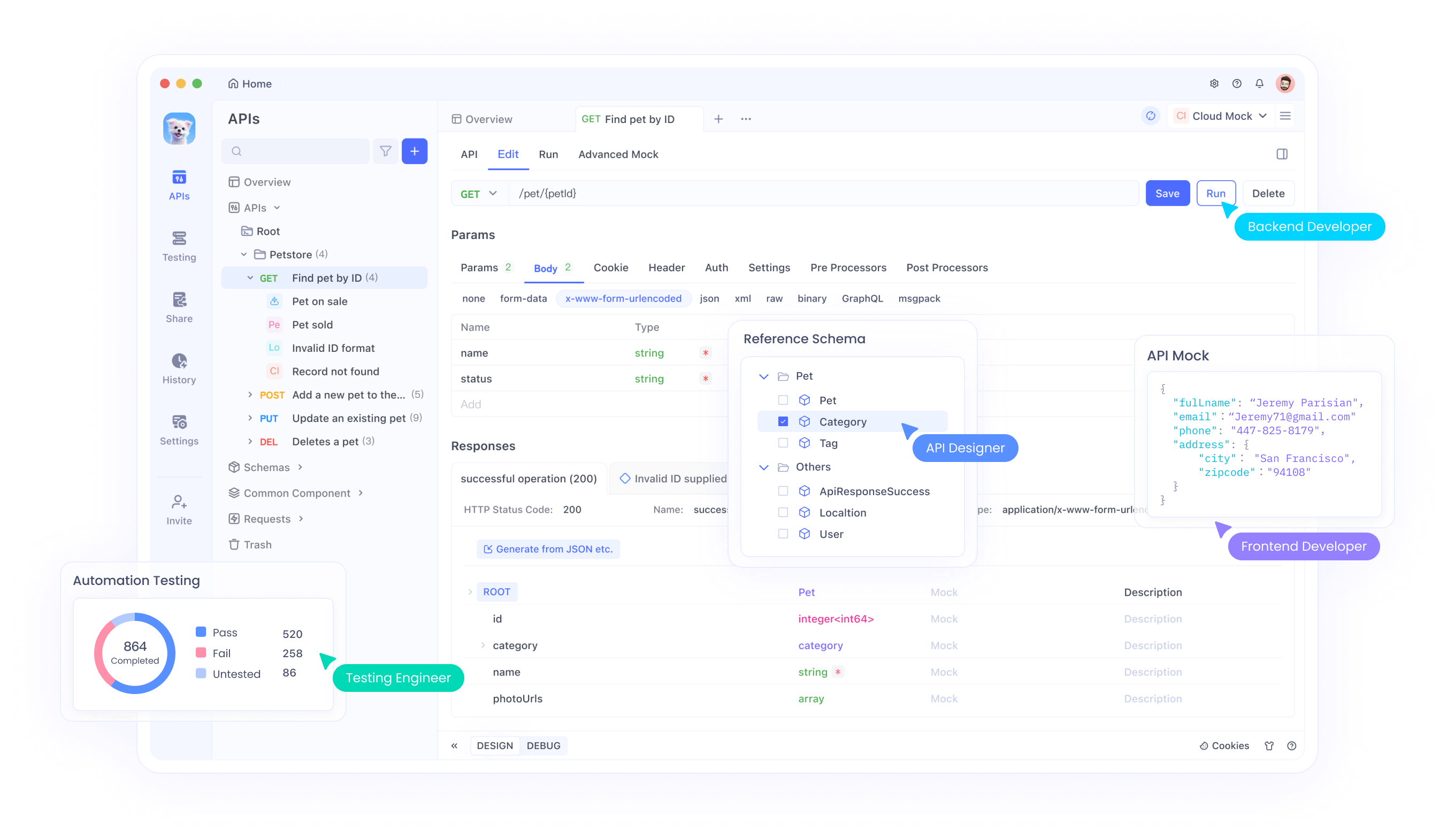

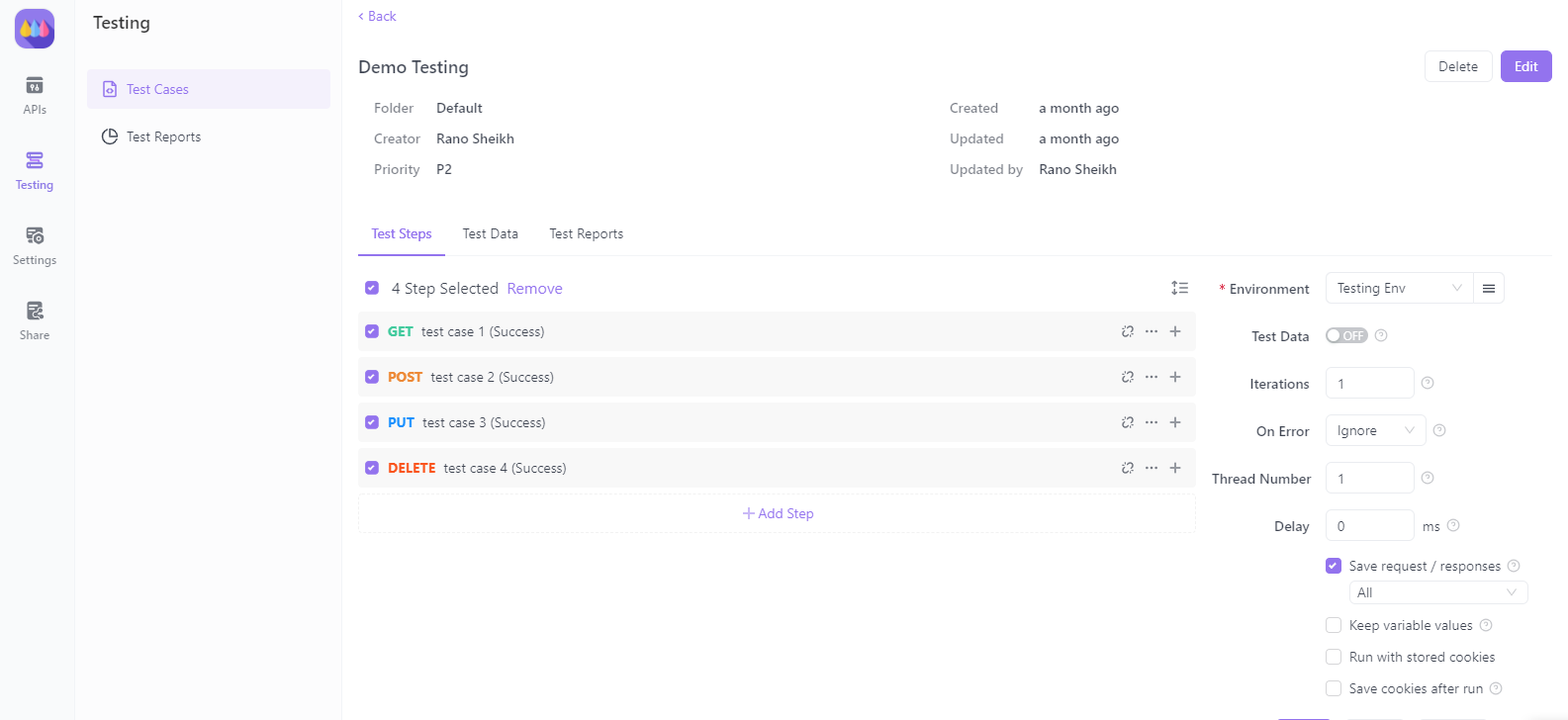

8. Apidog ile API'leri Test Etme

Şimdi, Apidog'un web kazıma uygulamamızda API'leri test etmeye nasıl yardımcı olabileceğine bir göz atalım.

Adım 1: Apidog'u Kurma

Apidog'u Apidog'un resmi web sitesinden indirin ve yükleyin. Ortamı kurmak için kurulum kılavuzunu izleyin.

Adım 2: API İstekleri Oluşturma

API isteklerinizi doğrudan Apidog içinde oluşturabilir ve test edebilirsiniz. GET, POST, PUT ve DELETE gibi çeşitli istek türlerini destekler ve bu da onu herhangi bir web kazıma senaryosu için çok yönlü hale getirir.

Adım 3: API Testini Otomatikleştirme

Apidog ile, harici hizmetlere bağlanırken çoklu ajan sisteminizin yanıtını doğrulamak için test komut dosyalarını otomatikleştirin. Bu, sisteminizin zaman içinde sağlam ve tutarlı kalmasını sağlar.

9. Streamlit Uygulamanızı Dağıtma

Uygulamanız tamamlandıktan sonra, genel erişim için dağıtın. Streamlit, Streamlit Sharing hizmetiyle bunu kolaylaştırır.

- Kodunuzu GitHub'da barındırın.

- Streamlit Sharing'e gidin ve GitHub deponuzu bağlayın.

- Uygulamanızı tek bir tıklamayla dağıtın.

10. Sonuç

Tebrikler! OpenAI SWARM, Streamlit ve çoklu ajan sistemlerini kullanarak güçlü bir web kazıma ve içerik analizi sistemi oluşturmayı öğrendiniz. SWARM tekniklerinin kazımayı nasıl daha akıllı ve içerik analizini nasıl daha doğru hale getirebileceğini inceledik. Apidog'u entegre ederek, sisteminizin güvenilirliğini sağlamak için API testi ve doğrulama hakkında da bilgi edindiniz.

Şimdi, projelerinizi güçlü API test özellikleriyle daha da geliştirmek için Apidog'u ücretsiz indirin. Apidog, diğer çözümlere kıyasla daha uygun fiyatlı ve verimli bir alternatif olarak öne çıkıyor ve geliştiriciler için sorunsuz bir deneyim sunuyor.

Bu eğitimle, karmaşık veri kazıma ve analiz görevlerini daha etkili bir şekilde ele almaya hazırsınız. İyi şanslar ve mutlu kodlamalar!