```html

Llama 3.1 veya Mistral gibi güçlü dil modelleriyle bir terminale takılmadan sohbet etmek ister misiniz? Open WebUI, Ollama'nın LLM'leriyle etkileşimi eğlenceli ve sezgisel hale getiren şık, ChatGPT benzeri bir arayüze giden biletinizdir. Sohbet geçmişlerini kaydetmenize, istemleri saklamanıza ve hatta daha akıllı yanıtlar için belgeler yüklemenize olanak tanır; hepsi tarayıcınızda. Bu yeni başlayanlara yönelik kılavuzda, Ollama'yı kurma, terminalde bir modeli test etme ve ardından daha kullanıcı dostu bir deneyim için Open WebUI ile seviye atlama konusunda size yol göstereceğim. Hızlı bir kurulum için Docker kullanacağız ve eğlenceli bir istemle test edeceğiz. Yapay zeka sohbetlerini kolaylaştırmaya hazır mısınız? Hadi başlayalım!

Open WebUI Nedir? LLM Komuta Merkeziniz

Open WebUI, Ollama'ya bağlanan, Llama 3.1 veya Mistral gibi büyük dil modelleri (LLM'ler) ile bir tarayıcı tabanlı panoda etkileşim kurmanıza olanak tanıyan, açık kaynaklı, kendi kendine barındırılan bir web arayüzüdür. Ollama'nın komut satırı arayüzünden farklı olarak, Open WebUI ChatGPT gibi hissettirir ve şunları sunar:

- Sohbet Geçmişi: Konuşmalarınızı kaydedin ve tekrar ziyaret edin.

- İstem Depolama: Gitmek istediğiniz istemleri saklayın ve yeniden kullanın.

- Belge Yüklemeleri: Bağlam farkındalıklı yanıtlar için dosyalar ekleyin (Alma Destekli Üretim veya RAG).

- Model Değiştirme: Tek bir tıklamayla modeller arasında kolayca geçiş yapın.

50K'dan fazla GitHub yıldızıyla, Open WebUI, LLM'lerle yerel olarak çalışmak için işbirlikçi, grafiksel bir yol isteyen geliştiriciler ve yapay zeka meraklıları için bir hit. İlk olarak, Open WebUI'nin eklemeye değer olduğunu görmek için Ollama'yı çalıştıralım!

Ollama'yı Kurma ve Test Etme

Open WebUI'ye dalmadan önce, Ollama'yı ayarlayalım ve terminalde Llama 3.1 veya Mistral gibi bir modeli test edelim. Bu, Open WebUI'nin sezgisel arayüzünü takdir etmek için bir temel sağlar.

1. Sistem Gereksinimlerini Kontrol Edin:

- OS: Windows, macOS veya Linux (Ubuntu 24.04 veya benzeri).

- Donanım: Modeller için en az 16GB RAM ve 10GB boş depolama alanı (Llama 3.1 8B ~5GB'a ihtiyaç duyar). Daha hızlı performans için bir GPU (örneğin, NVIDIA 1060 4GB) isteğe bağlıdır.

- Yazılım: ollama.com'dan indirilebilen Ollama.

2. Ollama'yı Kurun: İşletim sisteminiz için Ollama'yı ollama.com'dan indirin ve kurun. Yükleyici istemlerini izleyin; hızlı bir kurulumdur. Kurulumu şununla doğrulayın:

ollama --version

0.1.44 (Nisan 2025) gibi bir sürüm bekleyin. Başarısız olursa, Ollama'nın PATH'inizde olduğundan emin olun.

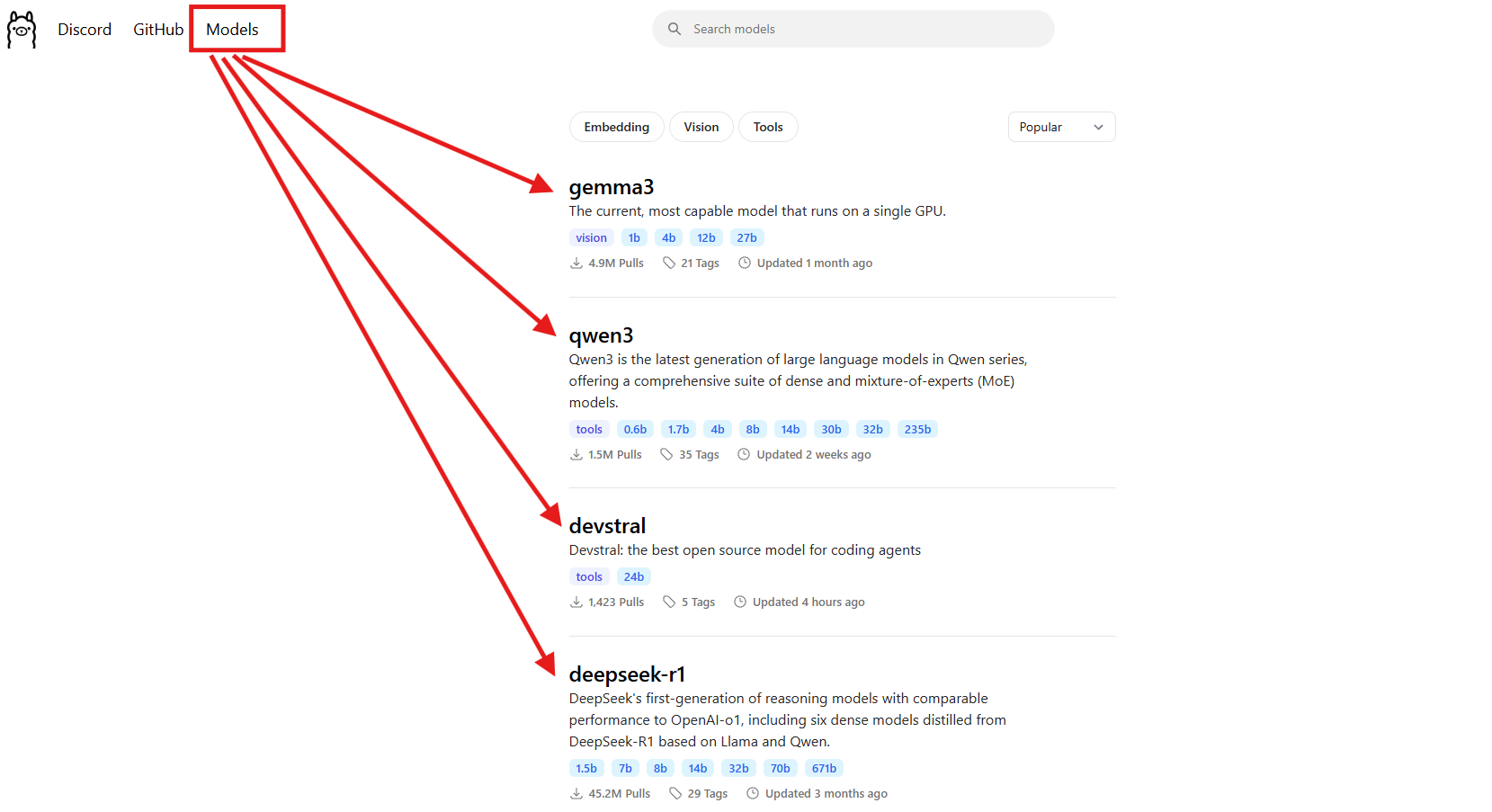

3. Bir Model İndirin: Llama 3.1 (8B) veya Mistral (7B) gibi bir model seçin. Bu kılavuz için Llama 3.1 kullanacağız:

ollama pull llama3.1

Bu, ~5GB indirir, bu yüzden internetiniz yavaşsa bir kahve alın. Kurulduğunu kontrol edin:

ollama list

llama3.1:latest'i arayın. Daha hafif bir model istiyorsanız Mistral (ollama pull mistral) başka harika bir seçenektir (~4GB).

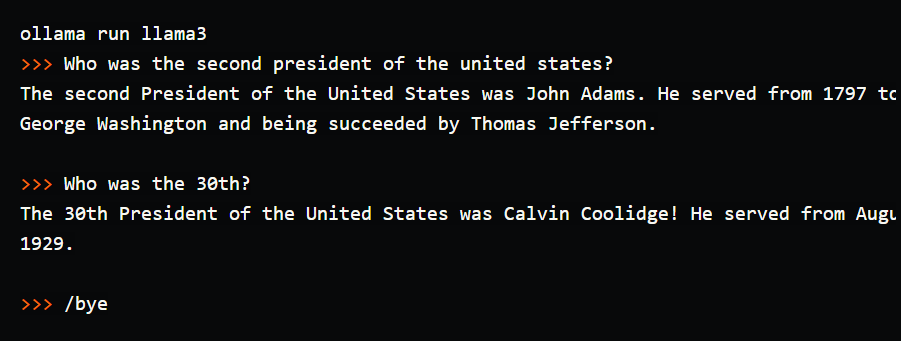

4. Modeli Terminalde Test Edin: Ollama'yı çalışırken görmek için basit bir istem deneyin:

ollama run llama3.1

İstemde (>>>), şunu yazın: “Bana bilgisayarlarla ilgili bir baba şakası anlat.” Enter'a basın. Şunu alabilirsiniz: “Bilgisayar neden doktora gitti? Virüsü vardı!” /bye ile çıkın. Bunu çalıştırdım ve kahkahaya boğan bir şaka aldım, ancak terminalde yazmak hantal hissettirdi; sohbet geçmişi yok, kaydedilmiş istemler yok. İşte Open WebUI'nin parladığı yer burasıdır; konuşmaları kaydetmek, istemleri yeniden kullanmak ve daha zengin yanıtlar için belgeler yüklemek için görsel bir arayüz sunar. Hadi kuralım!

Open WebUI için Ortamınızı Kurma

Ollama'nın terminal arayüzünü gördüğünüz için, LLM deneyiminizi daha sezgisel hale getirmek için Open WebUI'ye hazırlanalım. Open WebUI kurulumu için gerekli olduğundan, Docker'ın kurulu olduğunu varsayacağız.

1. Docker'ı Doğrulayın: Docker'ın kurulu ve çalışır durumda olduğundan emin olun:

docker --version

Docker 27.4.0 gibi bir şey bekleyin. Docker'ınız yoksa, Docker Desktop'ı resmi web sitelerinden indirin ve kurun; Windows, macOS veya Linux için hızlı bir kurulumdur.

2. Bir Proje Klasörü Oluşturun: İşleri düzenli tutun:

mkdir ollama-webui

cd ollama-webui

Bu klasör, Open WebUI'yi çalıştırmak için temeliniz olacaktır.

3. Ollama'nın Çalıştığından Emin Olun: Ollama'yı ayrı bir terminalde başlatın:

ollama serve

Bu, Ollama'nın API'sini http://localhost:11434 adresinde çalıştırır. Open WebUI'nin modellerinize bağlanması için buna ihtiyacı olduğundan, bu terminali açık tutun.

Docker ile Open WebUI'yi Kurma

Ollama ve Llama 3.1 hazır olduğuna göre, hızlı ve güvenilir bir kurulum için tek bir Docker komutu kullanarak Open WebUI'yi kuralım.

1. Open WebUI'yi Çalıştırın: ollama-webui klasörünüzde, şunu yürütün:

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

Bu komut:

- Open WebUI görüntüsünü çeker (

ghcr.io/open-webui/open-webui:main, ~3.77GB). - Tarayıcı erişimi için 3000 (yerel) numaralı bağlantı noktasını 8080 (kapsayıcı) numaralı bağlantı noktasına eşler.

- Ollama'nın API'sine

localhost:11434adresinde bağlanmak içinhost.docker.internalekler. - Sohbet geçmişini ve ayarları korumak için bir birim (

open-webui) kullanır. - Kapsayıcıyı

open-webuiolarak adlandırır ve otomatik olarak yeniden başlatılacak şekilde ayarlar.

İndirilmesi bir dakika sürer. docker ps ile çalıştığını kontrol edin; open-webui kapsayıcısını arayın.

2. Open WebUI'ye Erişim: Tarayıcınızı açın ve http://localhost:3000 adresine gidin. Open WebUI'nin karşılama sayfasını göreceksiniz. Bir hesap oluşturmak için “Kaydol”a tıklayın (ilk kullanıcı yönetici ayrıcalıklarını alır). Güçlü bir parola kullanın ve güvenli bir şekilde kaydedin. Artık sohbet etmeye hazırsınız! Sayfa yüklenmezse, kapsayıcının çalıştığından (docker logs open-webui) ve 3000 numaralı bağlantı noktasının boş olduğundan emin olun.

Open WebUI'yi Kullanma: Sohbet Etme ve Özellikleri Keşfetme

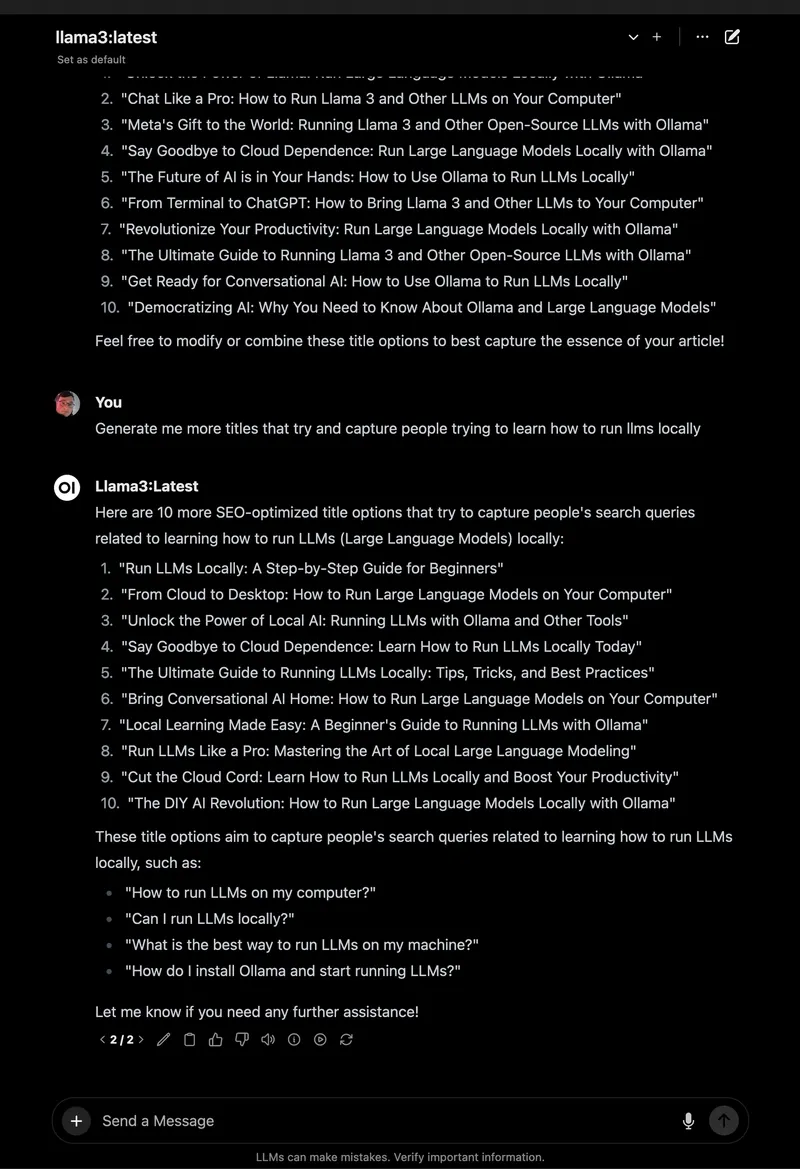

Open WebUI çalışırken, Llama 3.1 ile sohbete dalalım ve onu terminalden çok daha iyi yapan harika özelliklerini keşfedelim.

1. Sohbet Etmeye Başlayın:

- Open WebUI'de, sol üstteki model seçiciden

llama3.1:8b'yi seçin (çünkü onu çektiğiniz için görünmelidir). - Kenar çubuğunda “Yeni Sohbet”e tıklayın.

- Aynı istemi girin: “Bana bilgisayarlarla ilgili bir baba şakası anlat.”

- Enter'a basın. Şöyle bir yanıt alacaksınız: “Bilgisayar neden sanat okuluna gitti? Çünkü daha iyi bir bayt çizmeyi öğrenmek istedi!”

Arayüz temizdir, isteminiz ve yanıtınız sohbet geçmişine otomatik olarak kaydedilir.

2. Sohbetleri Kaydedin ve Düzenleyin: Sol kenar çubuğunda, sohbeti kaydetmek için iğne simgesine tıklayın. Kolay erişim için yeniden adlandırın (örneğin, “Baba Şakaları”). Deneylerinizi düzenli tutarak, kenar çubuğu aracılığıyla sohbetleri arşivleyebilir veya silebilirsiniz; terminal kaydırmasından çok daha iyi!

3. İstemleri Saklayın: Baba şakası istemini yeniden kullanım için kaydedin:

- Ayarlar > İstemler'e gidin.

- “Yeni İstem”e tıklayın, “Baba Şakası” olarak adlandırın ve yapıştırın: “Bana bilgisayarlarla ilgili bir baba şakası anlat.”

- Kaydet. Artık tek bir tıklamayla herhangi bir sohbette uygulayabilirsiniz.

4. RAG için Bir Belge Yükleyin: Sohbetlerinize bağlam ekleyin:

- Belge kitaplığını açmak için sohbet girişindeki “#” simgesine tıklayın.

- Bir metin dosyası yükleyin (örneğin, bir Spring Boot 3.2 kılavuzu).

- Şunu sorun: “Spring Boot 3.2'de REST İstemcisini nasıl kullanırım?” Llama 3.1, belgeye atıfta bulunacak ve

RestClient.create().get().uri("/users").retrieve()gibi bir kod parçacığı verecektir.

Bunu bir Python öğretici PDF'si ile test ettim ve Open WebUI, terminalin temel yanıtlarından farklı olarak, bağlam farkındalıklı yanıtları çiviledi.

5. Daha Fazla Özelliği Keşfedin:

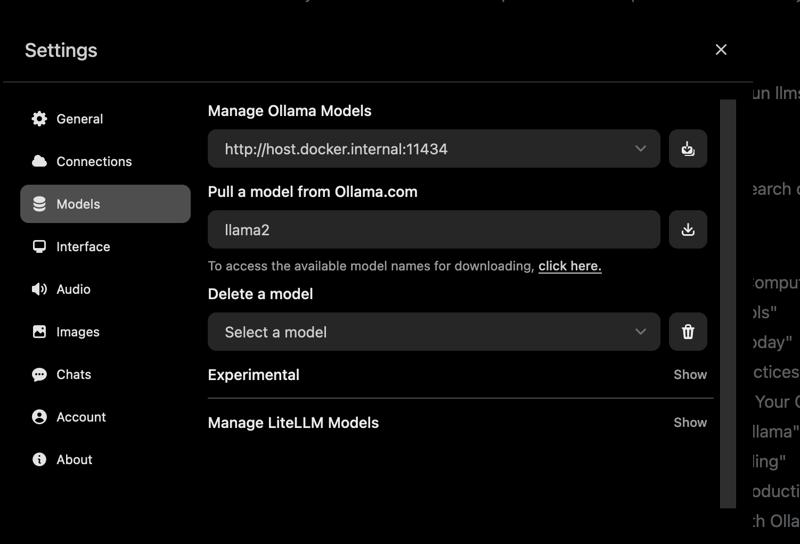

- Modelleri Değiştirin: Çektiğiniz Mistral veya diğer modelleri denemek için model seçiciyi kullanın (

ollama pull mistral). - Yanıtları Özelleştirin: Tonu (örneğin, “komik”) veya uzunluğu ayarlamak için “Sohbet Kontrolü”ne tıklayın.

- Yönetici Araçları: Ayarlar > Yönetici'de, kullanıcıları yönetin veya model erişimini kısıtlayın (ekipler için harika).

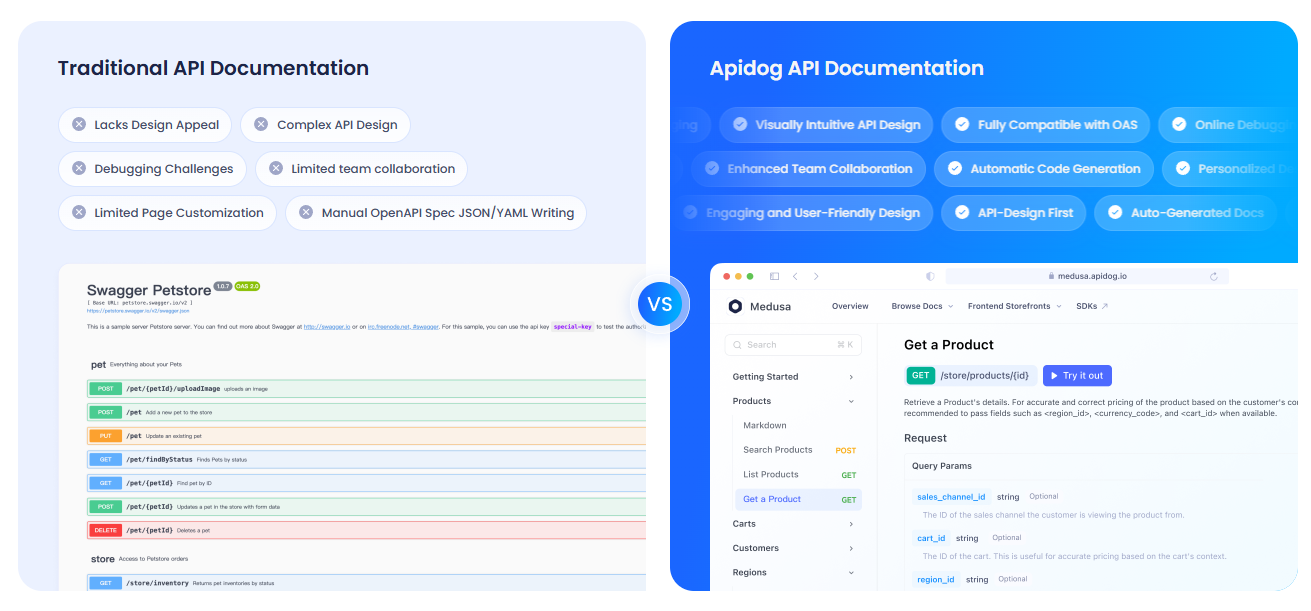

API'lerinizi APIdog ile Belgeleme

Ollama'nın API'si ile etkileşim kurmak için Open WebUI'yi kullanıyor ve kurulumunuzu belgelemek mi istiyorsunuz? APIdog, etkileşimli API belgeleri oluşturmak için harika bir araçtır. Şık arayüzü ve kendi kendine barındırma seçenekleri, yapay zeka projelerinizi paylaşmak için idealdir; göz atın!

Sorun Giderme ve İpuçları

- Bağlantı Sorunları: Open WebUI Ollama'yı bulamazsa,

ollama serve'ün çalıştığından ve 11434 numaralı bağlantı noktasının açık olduğundan emin olun. Docker günlüklerini kontrol edin:docker logs open-webui. - Bağlantı Noktası Çakışmaları: 3000 numaralı bağlantı noktası alınmışsa, kapsayıcıyı durdurun (

docker stop open-webui), kaldırın (docker rm open-webui) ve yeni bir bağlantı noktasıyla (örneğin,-p 3001:8080)docker runkomutunu yeniden çalıştırın. - Yavaş Yanıtlar: Hız için Ollama'nın

:cudaetiketlerini veya Mistral gibi daha küçük modelleri olan bir GPU kullanın. - Topluluk: Destek ve fikirler için Open WebUI'nin GitHub Tartışmalarına veya Discord'una katılın.

Neden Open WebUI'yi Seçmelisiniz?

Open WebUI, Ollama'yı hantal bir terminal aracından güçlü, kullanıcı dostu bir platforma dönüştürür:

- Sezgisel Arayüz: Tarayıcı tabanlı pano, yeni başlayanlar ve profesyoneller için mükemmeldir.

- Organizasyon: Kaydedilmiş sohbetler ve istemler, çalışmanızı düzenli tutar, terminal günlüklerinin aksine.

- Bağlam Farkındalığı: Belge yüklemeleri, daha akıllı yanıtlar için RAG'yi etkinleştirir.

- Gizlilik: Yerel olarak çalışır, verilerinizi güvende tutar.

Hem terminali hem de Open WebUI'yi test ettikten sonra, GUI'nin kolaylığına ve özelliklerine hayran kaldım. Bir çevirmeli telefondan bir akıllı telefona yükseltmek gibi!

Özet: Open WebUI Maceranız Sizi Bekliyor

Terminal sohbetlerinden Ollama ile tam teşekküllü bir Open WebUI kurulumuna geçtiniz, LLM etkileşimlerini sorunsuz ve eğlenceli hale getirdiniz! Llama 3.1, kaydedilmiş sohbetler ve belge yüklemeleri ile yapay zekayı daha önce hiç olmadığı gibi keşfetmeye hazırsınız. Yeni modeller deneyin, daha fazla istem saklayın veya API'lerinizi APIdog ile belgeleyin. Open WebUI kazançlarınızı Open WebUI GitHub'da paylaşın; neler yarattığınızı görmek için heyecanlıyım! Mutlu yapay zeka tamiri!

```