Büyük dil modellerini (LLM'ler) yerel olarak çalıştırmak, eskiden sıkı CLI kullanıcılarının ve sistem kurcalayıcılarının alanıydı. Ancak bu hızla değişiyor. Yerel makinelerde açık kaynaklı LLM'leri çalıştırmak için basit komut satırı arayüzüyle tanınan Ollama, macOS ve Windows için yerel masaüstü uygulamalarını yeni yayınladı.

Ve bunlar sadece basit sarmalayıcılar değil. Bu uygulamalar, modellerle sohbet etmeyi, belgeleri analiz etmeyi, dokümantasyon yazmayı ve hatta görüntülerle çalışmayı geliştiriciler için önemli ölçüde kolaylaştıran güçlü özellikler sunuyor.

Bu makalede, yeni masaüstü deneyiminin geliştirici iş akışını nasıl iyileştirdiğini, öne çıkan özelliklerini ve bu araçların günlük kodlama yaşamında nerede gerçekten parladığını keşfedeceğiz.

düğme

Yerel LLM'ler Neden Hala Önemli?

ChatGPT, Claude ve Gemini gibi bulut tabanlı araçlar manşetlere hakim olsa da, yerel öncelikli yapay zeka geliştirmeye yönelik büyüyen bir hareket var. Geliştiriciler şu özellikleri sunan araçlar istiyor:

- Gizli - Kodunuz ve belgeleriniz makinenizde kalır.

- Özelleştirilebilir - Modelleri, bellek sınırlarını ve donanımı siz seçersiniz.

- Çevrimdışı dostu - Harici API'lere veya çalışma süresine bağımlılık yok.

- Hızlı - Ağ gecikmesi veya sunucu darboğazları yok.

Ollama, LLaMA, Mistral, Gemma, Codellama, Mixtral ve diğer modelleri doğrudan makinenizde yerel olarak çalıştırmanıza olanak tanıyarak bu eğilime doğrudan uyuyor - şimdi çok daha sorunsuz bir deneyimle.

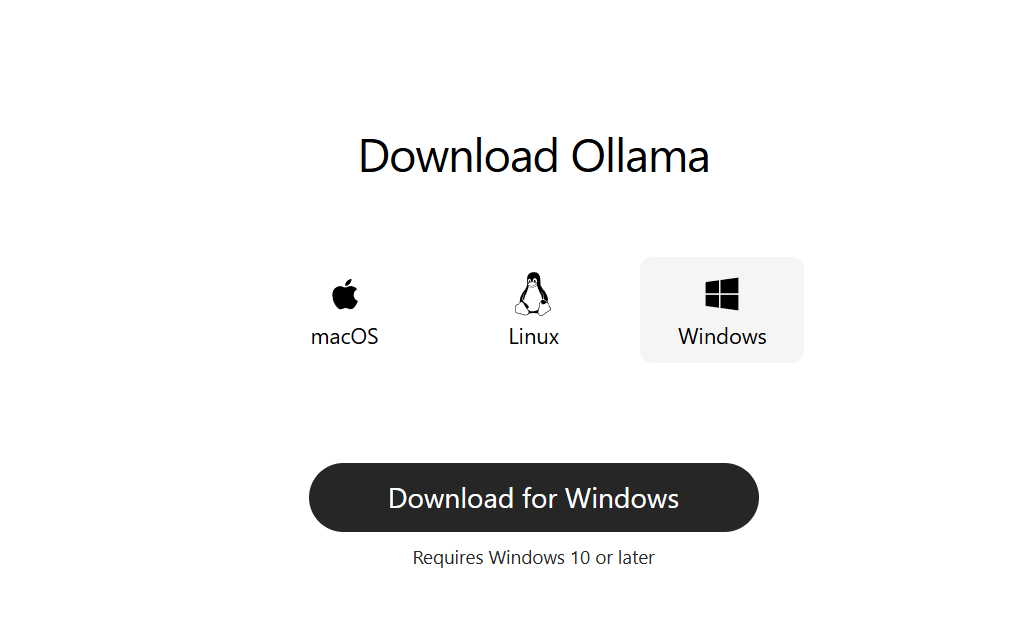

Adım 1: Masaüstü için Ollama'yı İndirin

ollama.com adresine gidin ve sisteminiz için en son sürümü indirin:

- macOS (Apple Silicon veya Intel)

- Windows 10/11 (x64)

Normal bir masaüstü uygulaması gibi kurun. Başlamak için komut satırı kurulumu gerekmez.

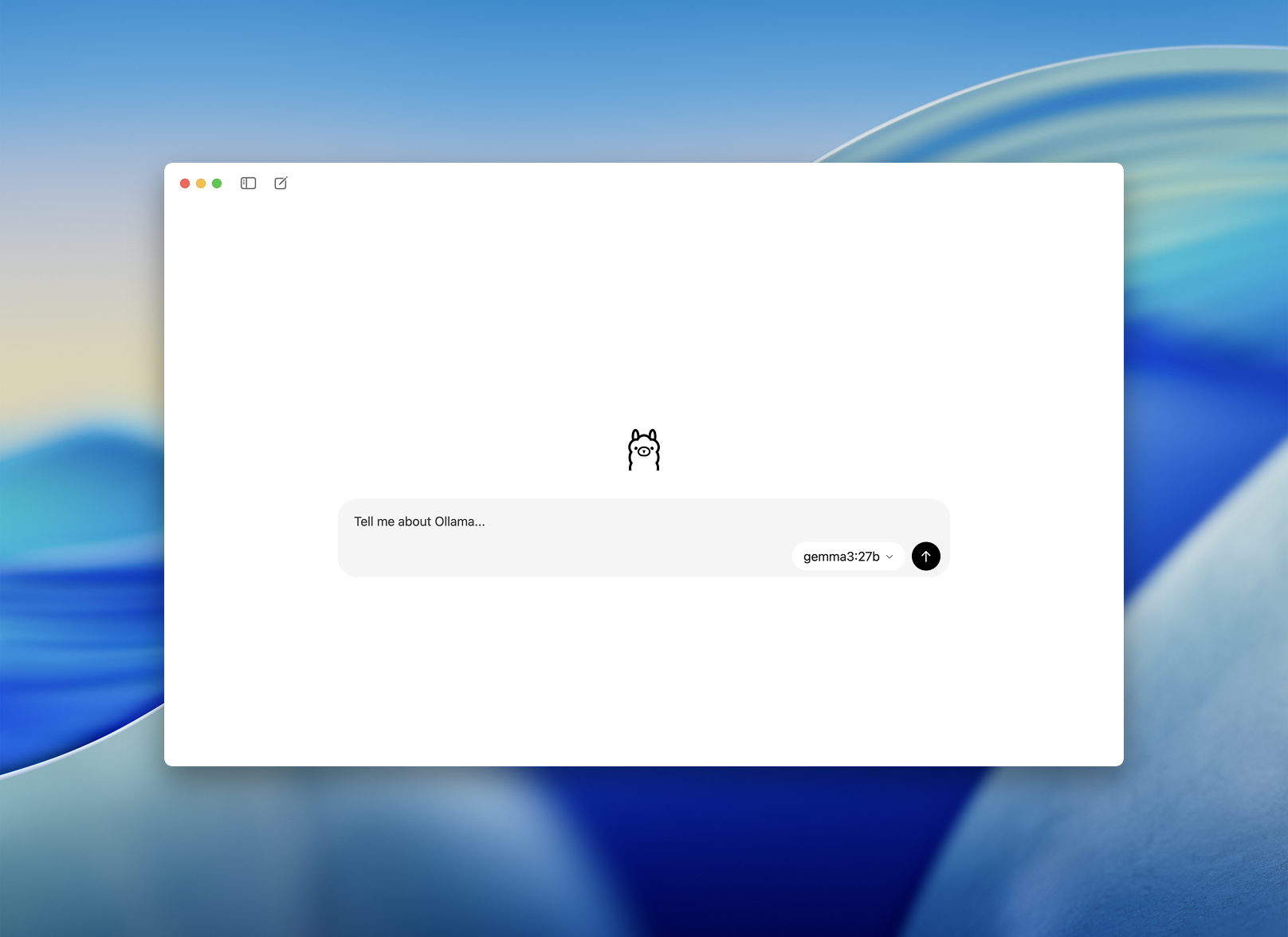

Adım 2: Başlatın ve Bir Model Seçin

Kurulduktan sonra Ollama masaüstü uygulamasını açın. Arayüz temizdir ve basit bir sohbet penceresine benzer.

İndirmek ve çalıştırmak için bir model seçmeniz istenecektir. Bazı seçenekler şunlardır:

llama3– genel amaçlı asistancodellama– kod üretimi ve yeniden düzenleme için harikamistral– hızlı, küçük ve doğrugemma– Google destekli, açık ağırlıklı model

Birini seçin ve uygulama otomatik olarak indirecek ve yükleyecektir.

Geliştiriciler İçin Daha Sorunsuz Bir Başlangıç - Modellerle Sohbet Etmenin Daha Kolay Bir Yolu

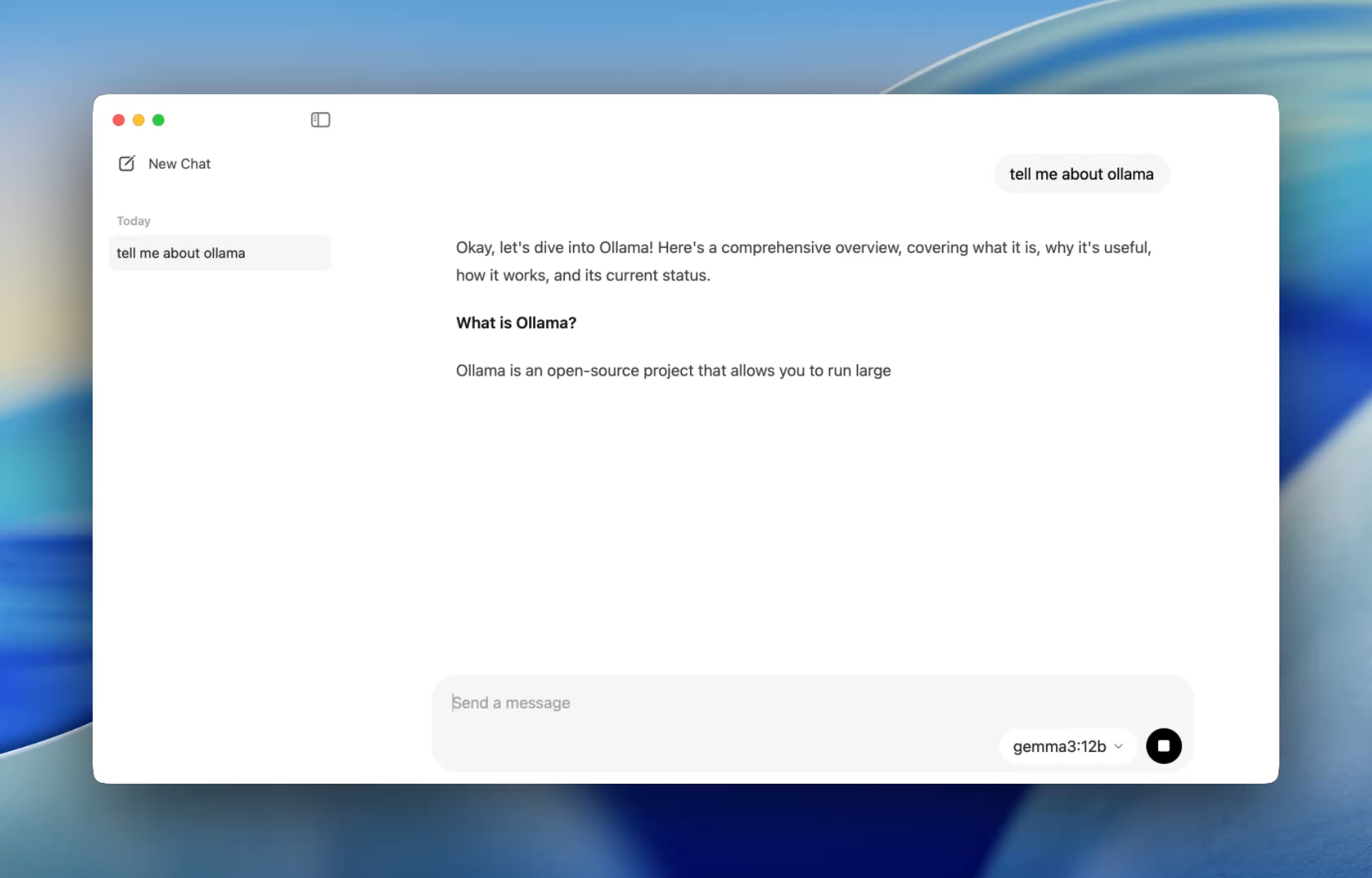

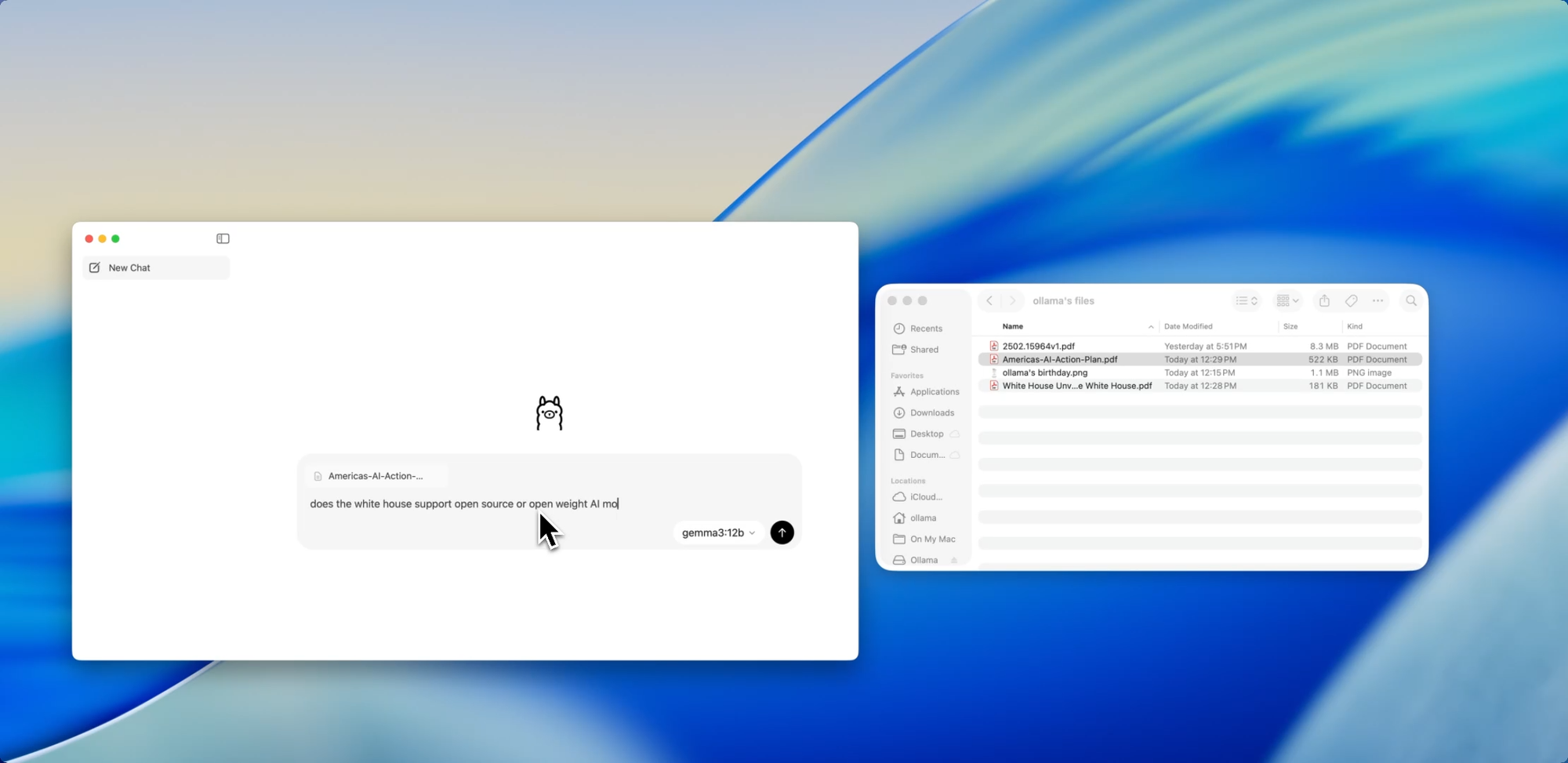

Daha önce, Ollama kullanmak bir terminal açıp bir model oturumu başlatmak için ollama run komutlarını vermek anlamına geliyordu. Şimdi, masaüstü uygulaması herhangi bir yerel uygulama gibi açılıyor ve basit ve temiz bir sohbet arayüzü sunuyor.

Artık modellerle ChatGPT'de yaptığınız gibi konuşabilirsiniz - ancak tamamen çevrimdışı. Bu, aşağıdakiler için mükemmeldir:

- Kod inceleme yardımı

- Test üretimi

- Yeniden düzenleme ipuçları

- Yeni API'leri veya dilleri öğrenme

Uygulama, basit bir kurulumun ötesinde hiçbir ayar gerektirmeden codellama veya mistral gibi yerel modellere anında erişim sağlar.

Ve özelleştirmeyi seven geliştiriciler için, CLI hala arka planda çalışarak bağlam uzunluğunu, sistem istemlerini ve model sürümlerini gerektiğinde terminal aracılığıyla değiştirmelerine olanak tanır.

Sürükle. Bırak. Soru Sor.

Dosyalarla Sohbet Edin

Yeni uygulamadaki en geliştirici dostu özelliklerden biri dosya alımıdır. Bir dosyayı sohbet penceresine sürüklemeniz yeterlidir — ister .pdf, .md veya .txt olsun — ve model içeriğini okuyacaktır.

60 sayfalık bir tasarım belgesini anlamanız mı gerekiyor? Dağınık bir README'den YAPILACAKLAR'ı çıkarmak mı istiyorsunuz? Yoksa bir müşterinin ürün özetini mi özetleyeceksiniz? İçine bırakın ve doğal dilde sorular sorun:

- "Bu belgede tartışılan ana özellikler nelerdir?"

- "Bunu tek bir paragrafta özetle."

- "Eksik bölümler veya tutarsızlıklar var mı?"

Bu özellik, dokümantasyonu taramak, teknik özellikleri incelemek veya yeni projelere dahil olmak için harcanan süreyi önemli ölçüde azaltabilir.

Metnin Ötesine Geçin

Çok Modlu Destek

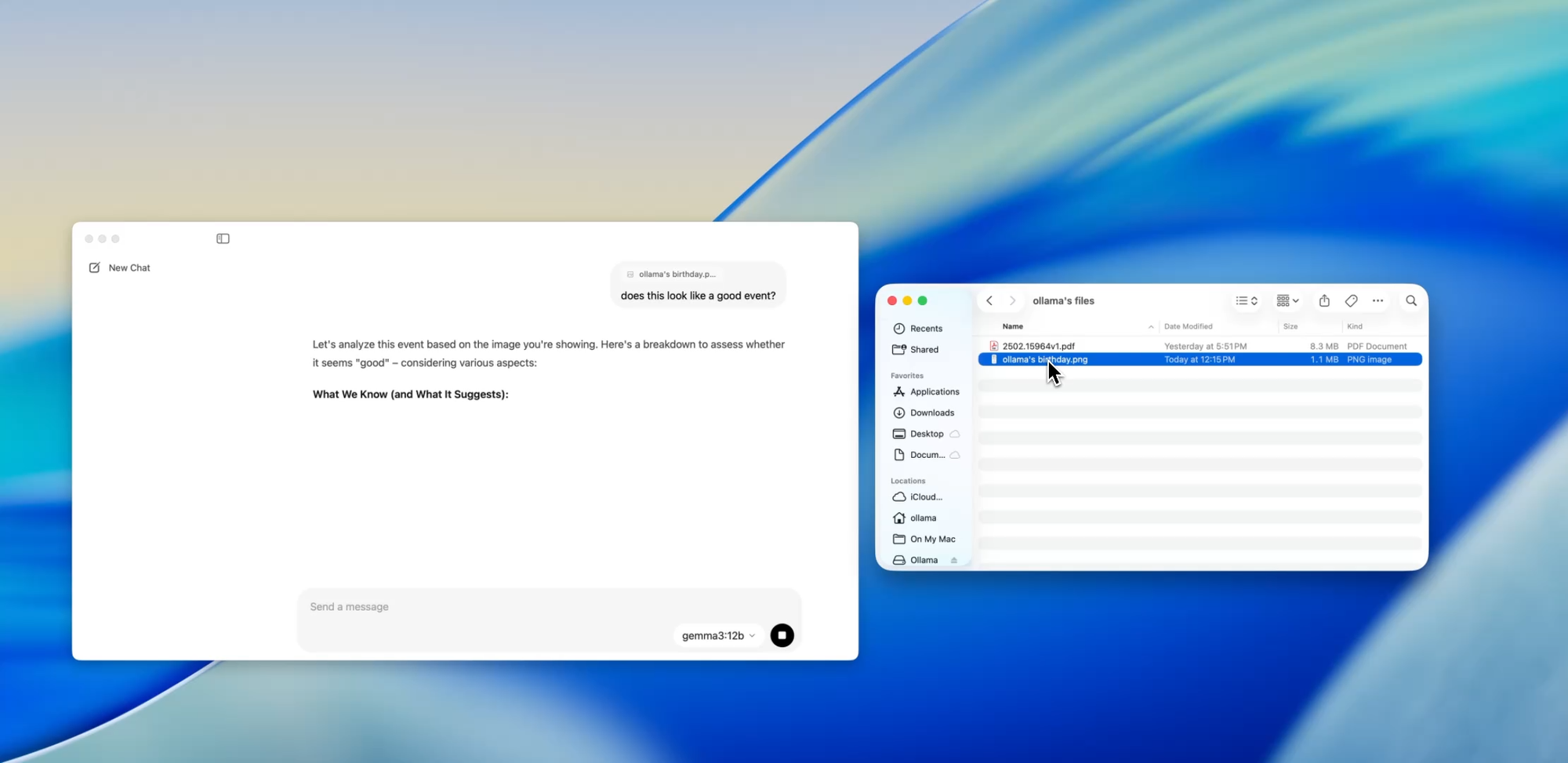

Ollama içindeki belirli modeller (Llava tabanlı olanlar gibi) artık görüntü girişini destekliyor. Bu, bir görüntü yükleyebileceğiniz ve modelin onu yorumlayıp yanıtlayacağı anlamına gelir.

Bazı kullanım durumları şunları içerir:

- Bir ekran görüntüsündeki diyagramları veya grafikleri okuma

- UI maketlerini tanımlama

- Taranmış el yazısı notları inceleme

- Basit infografikleri analiz etme

Bu, GPT-4 Vision gibi araçlarla karşılaştırıldığında hala erken bir aşamada olsa da, yerel öncelikli bir uygulamaya çok modlu desteğin entegre edilmesi, çok girişli sistemler oluşturan veya yapay zeka arayüzlerini test eden geliştiriciler için büyük bir adımdır.

Özel, Yerel Belgeler — Emrinizde

Dokümantasyon Yazımı

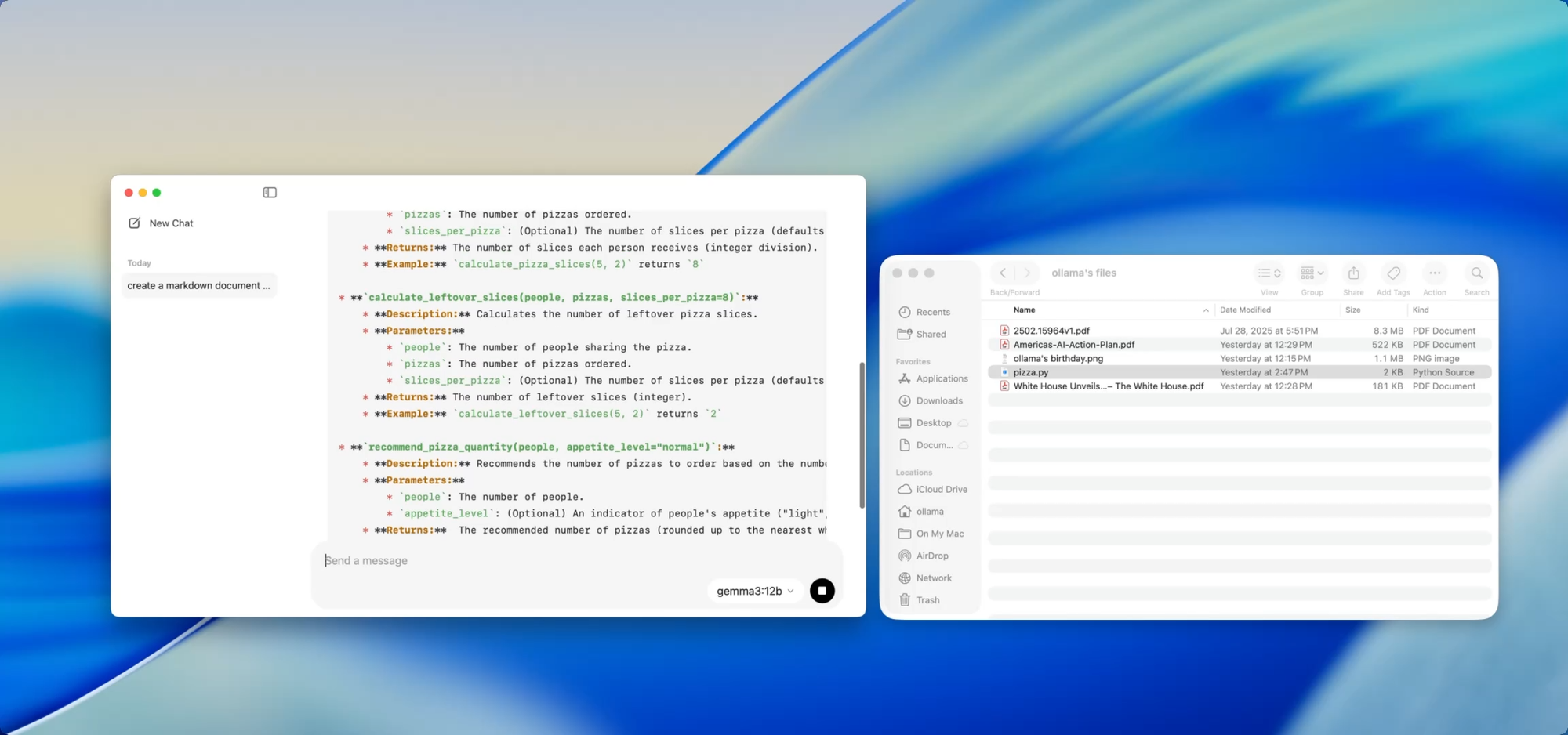

Büyüyen bir kod tabanını sürdürüyorsanız, dokümantasyon kaymasının acısını bilirsiniz. Ollama ile, hassas kodu buluta itmeden dokümantasyon oluşturmaya veya güncellemeye yardımcı olmak için yerel modelleri kullanabilirsiniz.

Sadece bir dosyayı — örneğin utils.py — uygulamaya sürükleyin ve sorun:

- "Bu fonksiyonlar için docstring'ler yaz."

- "Bu dosyanın ne yaptığını gösteren bir Markdown genel bakışı oluştur."

- "Bu modül hangi bağımlılıkları kullanıyor?"

Bu, yapay zeka kullanarak dokümantasyon iş akışlarını otomatikleştiren [Deepdocs] gibi araçlarla birleştirildiğinde daha da güçlü hale gelir. Projenizin README veya şema dosyalarını önceden yükleyebilir, ardından takip soruları sorabilir veya değişiklik günlükleri, geçiş notları veya güncelleme kılavuzları oluşturabilirsiniz — hepsi yerel olarak.

Kapsamlı Performans Ayarı

Bu yeni sürümle Ollama, genel performansı da iyileştirdi:

- GPU hızlandırma, Apple Silicon ve modern Nvidia/AMD kartları için daha iyi optimize edildi.

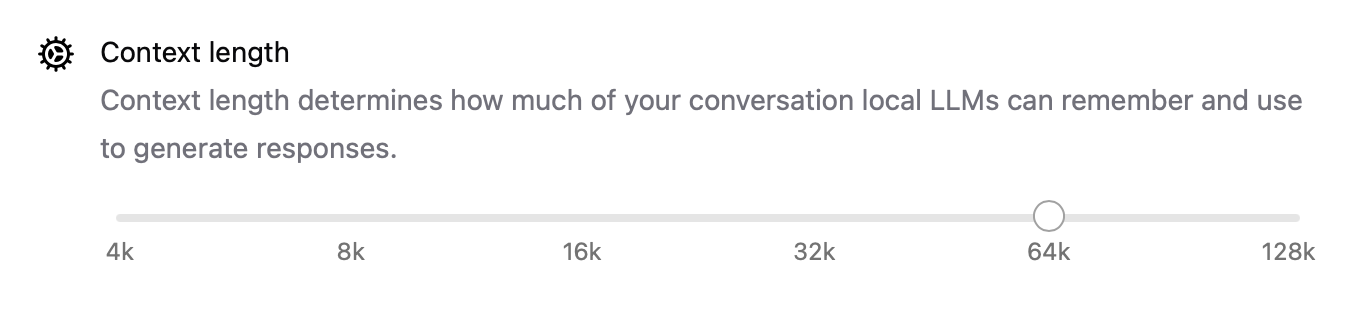

- Bağlam uzunluğu artık

num_ctx=8192gibi ayarlarla yapılandırılabilir, böylece daha uzun girişleri işleyebilirsiniz. - Ağ modu, Ollama'nın LAN'ınızdaki diğer uygulamalardan veya cihazlardan çağırabileceğiniz bir yerel API sunucusu olarak çalışmasına olanak tanır.

- Artık indirilen modeller için depolama konumunu değiştirebilirsiniz — harici bir sürücüden çalışıyorsanız veya modelleri proje bazında izole etmek istiyorsanız mükemmeldir.

Bu yükseltmeler, uygulamayı yerel aracılardan geliştirme araçlarına ve kişisel araştırma asistanlarına kadar her şey için esnek hale getiriyor.

CLI ve GUI: İki Dünyanın En İyisi

En iyi yanı ne mi? Yeni masaüstü uygulaması terminalin yerini almıyor — onu tamamlıyor.

Hala şunları yapabilirsiniz:

ollama pull codellama

ollama run codellama

Veya model sunucusunu açığa çıkarın:

ollama serve --host 0.0.0.0

Yani, yerel bir LLM'ye dayanan özel bir yapay zeka arayüzü, aracı veya eklentisi oluşturuyorsanız, artık Ollama'nın API'sinin üzerine inşa edebilir ve doğrudan etkileşim veya test için GUI'yi kullanabilirsiniz.

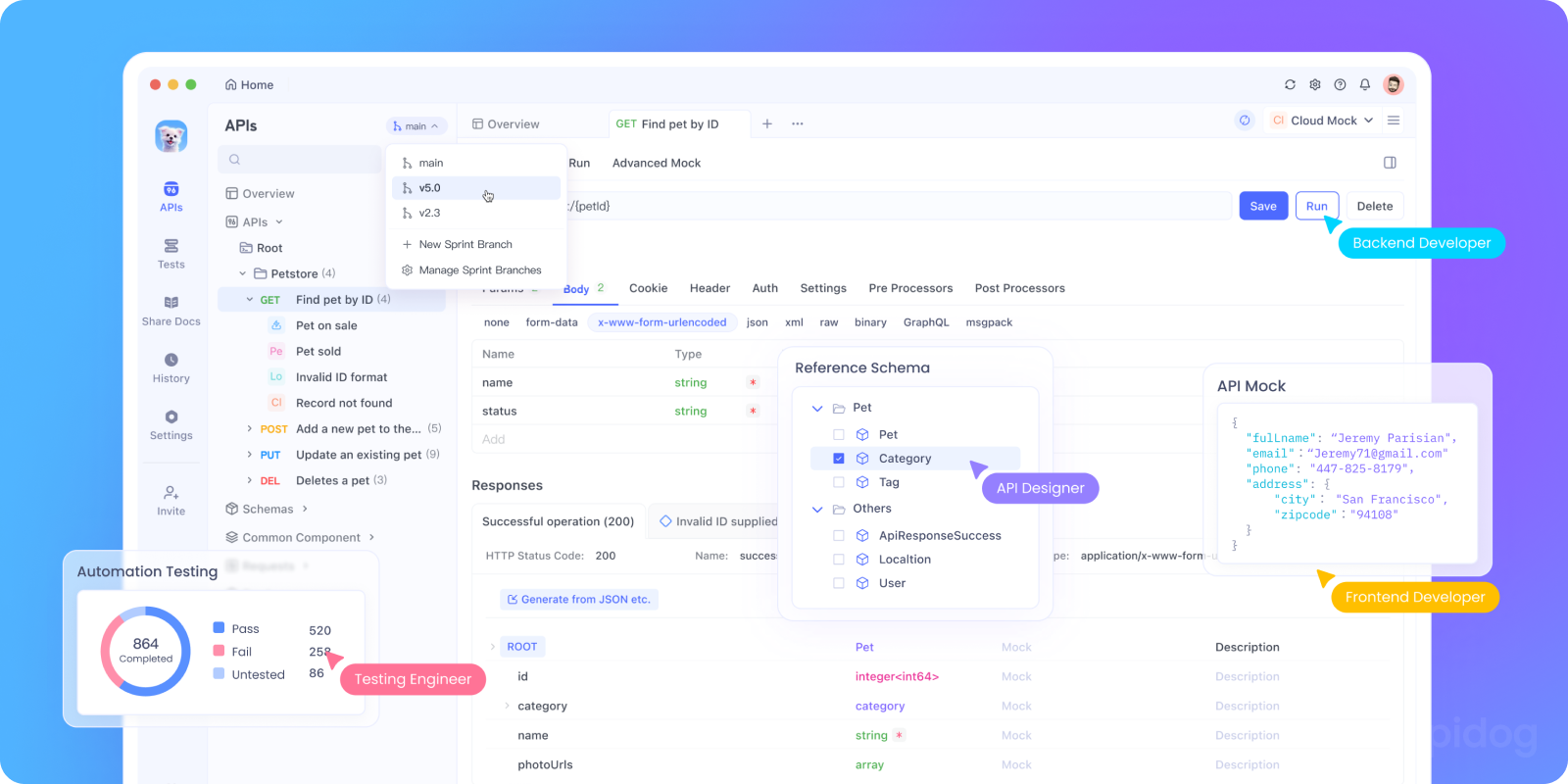

Ollama'nın API'sini Apidog ile Yerel Olarak Test Edin

Ollama'yı yapay zeka uygulamanıza entegre etmek veya yerel API uç noktalarını test etmek mi istiyorsunuz? Ollama'nın REST API'sini şunları kullanarak çalıştırabilirsiniz:

bash tollama serve

Ardından, yerel LLM uç noktalarınızı test etmek, hata ayıklamak ve belgelemek için Apidog'u kullanın.

düğme

Apidog'u Ollama ile neden kullanmalısınız:

- Yerel

http://localhost:11434sunucunuza POST istekleri göndermek için görsel arayüz - Yapay zeka destekli istek üretimi ve yanıt doğrulamasını destekler

- Kendi kendine barındırılan yapay zeka uygulamaları, aracı çerçeveleri veya dahili araçlar için mükemmeldir

- Yerel LLM iş akışları ve özel model sunucularıyla sorunsuz çalışır

Gerçekten Çalışan Geliştirici Kullanım Durumları

Yeni Ollama uygulamasının gerçek geliştirici iş akışlarında parladığı yerler şunlardır:

| Kullanım Durumu | Ollama Nasıl Yardımcı Olur |

|---|---|

| Kod İnceleme Asistanı | Yeniden düzenleme geri bildirimi için codellama'yı yerel olarak çalıştırın |

| Dokümantasyon Güncellemeleri | Modellerden doküman dosyalarını yeniden yazmalarını, özetlemelerini veya düzeltmelerini isteyin |

| Yerel Geliştirici Sohbet Botu | Uygulamanıza bağlama duyarlı bir asistan olarak yerleştirin |

| Çevrimdışı Araştırma Aracı | PDF'leri veya teknik incelemeleri yükleyin ve önemli sorular sorun |

| Kişisel LLM Oyun Alanı | İstem mühendisliği ve ince ayar ile deney yapın |

Veri gizliliği veya model halüsinasyonları konusunda endişeli ekipler için, yerel öncelikli LLM iş akışları giderek daha cazip bir alternatif sunuyor.

Son Düşünceler

Ollama'nın masaüstü sürümü, yerel LLM'leri hacklenmiş bir bilim deneyi gibi değil, daha çok cilalı bir geliştirici aracı gibi hissettiriyor.

Dosya etkileşimi, çok modlu girişler, belge yazımı ve yerel performans desteğiyle, hız, esneklik ve kontrolü önemseyen geliştiriciler için ciddi bir seçenektir.

Bulut API anahtarı yok. Arka plan takibi yok. Token başına faturalandırma yok. Sadece ihtiyaçlarınıza uygun açık model seçeneğiyle hızlı, yerel çıkarım.

LLM'leri makinenizde çalıştırmayı merak ettiyseniz veya zaten Ollama kullanıyorsanız ve daha sorunsuz bir deneyim istiyorsanız, şimdi tekrar denemenin tam zamanı.