Büyük dil modelleri (LLM'ler) dünyası baş döndürücü bir hızla ilerliyor, ancak verimlilik ve gerçek zamanlı uyarlanabilirlik konularındaki zorluklar devam ediyor. 10 Eylül 2025'te, Kimi serisinin arkasındaki yenilikçi güç Moonshot AI, LLM çıkarım motorlarındaki ağırlık güncellemelerini yeniden tanımlayan açık kaynaklı bir ara katman yazılımı olan checkpoint-engine'i piyasaya sürdü. Pekiştirmeli öğrenme (RL) için özel olarak tasarlanan bu hafif araç, Kimi-K2 gibi 1 trilyon parametreli bir devi binlerce GPU'da sadece 20 saniyede yenileyerek kesinti süresini azaltıyor ve ölçeklenebilirliği artırıyor.

Bu yazı, checkpoint-engine'in mimarisinden kıyaslama testlerine kadar mekaniklerini incelerken, RL üzerindeki etkilerini ve daha geniş ekosistem uyumunu vurgulamaktadır. Bu değerli aracı açık kaynak yaparak Moonshot AI, LLM sınırlarını daha da zorlamak için topluluğu güçlendiriyor. Bu yeniliği katman katman inceleyelim.

Checkpoint-Engine'i Anlamak: Temel Kavramlar ve Mimari

Checkpoint-Engine Nedir?

Özünde, checkpoint-engine, çıkarım sırasında LLM'ler için sorunsuz, yerinde ağırlık güncellemelerini kolaylaştıran bir ara katman yazılımıdır. Bu, modellerin tam yeniden eğitim olmadan yinelemeli geri bildirimlerle geliştiği RL'de çok önemlidir. Geleneksel yöntemler, uzun süreli yeniden yüklemelerle sistemleri yavaşlatırken; checkpoint-engine, akıcı, düşük ek yüklü bir yaklaşımla buna karşı koyar.

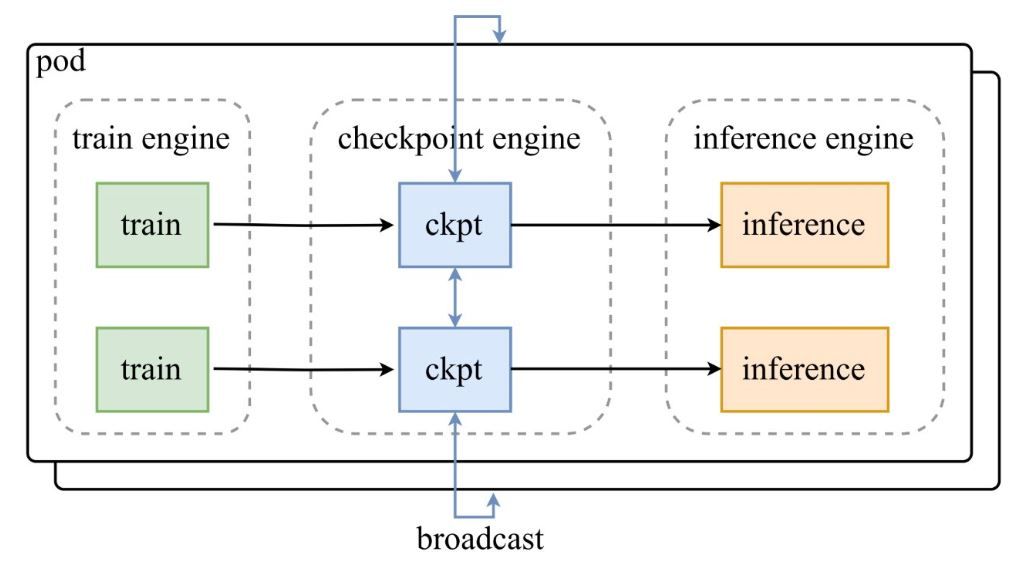

Moonshot AI'nin duyuru tweet'indeki mimari şemada gösterildiği gibi, bir eğitim motorları grubu, kontrol noktalarını merkezi checkpoint-engine'e besler, bu da güncellemeleri çıkarım motorlarına yayınlar. GitHub deposu, ParameterServer sınıfını güncelleme orkestratörü olarak öne çıkararak kodu derinlemesine inceler.

Mimari Bileşenler

- Eğitim Motoru (Train Engine): Devam eden RL eğitiminden yeni ağırlıklar üretir, dinamik ortamlardaki politika iyileştirmelerini yakalar.

- Checkpoint Motoru (Checkpoint Engine): Ara katman yazılımının çekirdeği, minimum gecikme için çıkarım ile birlikte yerleştirilmiştir. Meta veri toplama işlemlerini yönetir ve güncellemeleri Yayın (Broadcast) veya P2P modları aracılığıyla yürütür.

- Çıkarım Motoru (Inference Engine): Dağıtılmış GPU kümelerinde hizmet sürekliliğini koruyarak güncellemeleri anında entegre eder.

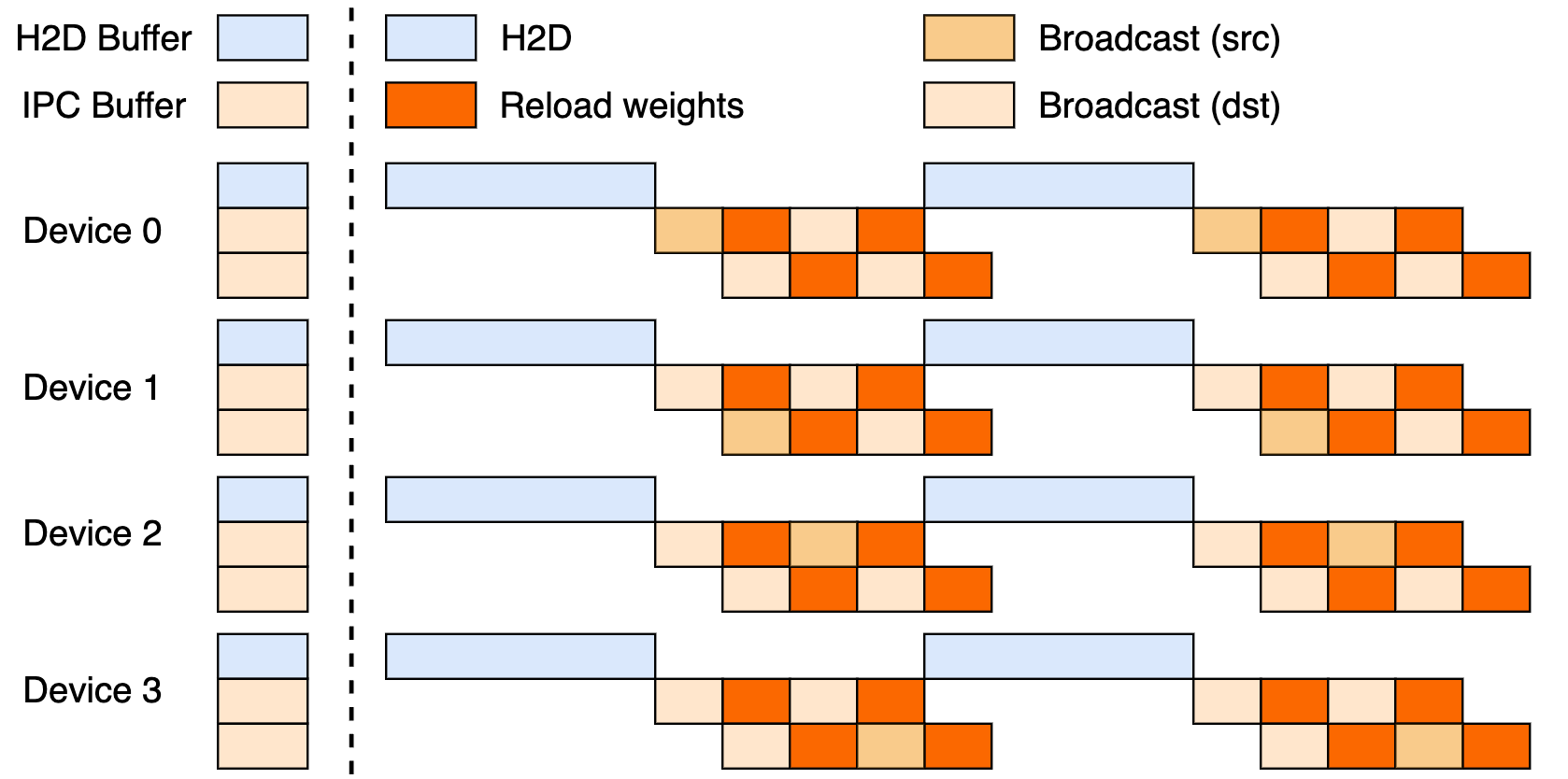

Bu kurulum, üç aşamalı bir boru hattından yararlanır: Ana Bilgisayardan Aygıta (H2D) aktarımları, CUDA IPC kullanarak işçiler arası yayınlar ve hedeflenen yeniden yüklemeler. Bunları çakıştırarak, GPU kullanımını en üst düzeye çıkarır ve aktarım darboğazlarını azaltır.

Yayın (Broadcast) vs. P2P Güncellemeleri

Yayın, eşzamanlı, küme çapında güncellemelerde parlar – en yüksek hız için varsayılan modudur, verileri optimal akış için paketler. P2P ise, kesintileri atlamak için mooncake-transfer-engine aracılığıyla RDMA kullanarak, zirvelerde ölçeklendirme gibi esnek senaryolarda üstündür. Bu ikilik, checkpoint-engine'i hem kararlı hem de akışkan dağıtımlar için çok yönlü kılar.

Performans Kıyaslamaları: Yeterince Hızlı Ne Kadar Hızlıdır?

Bir Trilyon Parametreli Modeli 20 Saniyede Güncelleme

Checkpoint-engine'in manşet başarısı? Kimi-K2'nin 1T parametresini binlerce GPU üzerinde ~20 saniyede güncellemek. Bu, akıllı boru hattından kaynaklanmaktadır: meta veri planlaması verimli paket boyutları ayarlar, ZeroMQ soketleri aktarımları koordine eder ve çakışan H2D/yayın aşamaları gecikmeleri gizler.

Bunu, büyük veri aktarımları sırasında sistemleri dakikalarca boşta bırakabilen eski tekniklerle karşılaştırın. Checkpoint-engine'in yerinde çalışma felsefesi, çıkarımın sorunsuz çalışmasını sağlar, bu da RL'nin hızlı adaptasyon ihtiyaçları için idealdir.

Kıyaslama Analizi

Kıyaslama tablosu, vLLM v0.10.2rc1 ile test edilen modeller ve kurulumlar arasında olağanüstü sonuçlar ortaya koymaktadır:

| Model | Cihaz Bilgisi | Meta Veri Toplama | Güncelleme (Yayın) | Güncelleme (P2P) |

|---|---|---|---|---|

| GLM-4.5-Air (BF16) | 8xH800 TP8 | 0.17s | 3.94s (1.42GiB) | 8.83s (4.77GiB) |

| Qwen3-235B-A22B-Instruct-2507 (BF16) | 8xH800 TP8 | 0.46s | 6.75s (2.69GiB) | 16.47s (4.05GiB) |

| DeepSeek-V3.1 (FP8) | 16xH20 TP16 | 1.44s | 12.22s (2.38GiB) | 25.77s (3.61GiB) |

| Kimi-K2-Instruct (FP8) | 16xH20 TP16 | 1.81s | 15.45s (2.93GiB) | 36.24s (4.46GiB) |

| DeepSeek-V3.1 (FP8) | 256xH20 TP16 | 1.40s | 13.88s (2.54GiB) | 33.30s (3.86GiB) |

| Kimi-K2-Instruct (FP8) | 256xH20 TP16 | 1.88s | 21.50s (2.99GiB) | 34.49s (4.57GiB) |

Bunları deponun examples/update.py aracılığıyla çoğaltın. FP8 çalıştırmaları vLLM yamalarına ihtiyaç duyar, bu da ölçekte verimliliğin altını çizer.

Pekiştirmeli Öğrenme İçin Çıkarımlar

RL, hızlı yinelemelerle gelişir; checkpoint-engine'in 20 saniyenin altındaki döngüleri, sürekli öğrenme döngülerini mümkün kılarak toplu yöntemleri geride bırakır. Bu, adaptif ajanlardan gelişen sohbet robotlarına kadar, politika ayarlamasında her saniyenin önemli olduğu duyarlı uygulamaların kilidini açar.

Teknik Uygulama: Kod Tabanına Dalış

Açık Kaynak Erişilebilirliği

Moonshot AI'nin GitHub'a bırakması, seçkin RL araçlarını demokratikleştiriyor. ParameterServer, güncellemeleri demirler, Yayın (hızlı CUDA IPC paylaşımı) ve P2P (yeni gelenler için RDMA) sunar. update.py ve testler (test_update.py) gibi örnekler, kullanıma başlamayı kolaylaştırır.

Uyumluluk vLLM (işçi uzantıları aracılığıyla) ile başlar, SGLang için kancalar sonraki aşamada düşünülmektedir. Kısmi üç aşamalı boru hattı, kullanılmayan potansiyele işaret ediyor.

Optimizasyon Teknikleri

Temel zekalar şunları içerir:

- Boru Hattı Çakışmaları (Pipelined Overlaps): İletişim ve kopyalar eşzamanlı olarak çalışır, etkili süreyi kısaltır.

- Kova Optimizasyonu (Bucket Optimization): Meta veri odaklı boyutlandırma, parçalamaya ve ağlara uyum sağlar.

- ZeroMQ Kontrolü: Çıkarım motorlarına düşük gecikmeli sinyalizasyon.

Bunlar, PCIe çakışmalarından bellek sıkışmalarına (gerekirse seri moda geri dönme) kadar trilyon parametre engellerini ele alır.

Mevcut Sınırlamalar

P2P'nin sıfırıncı sıra hunisi, ölçekte tıkanabilir ve tam boru hattı cilalanmayı beklemektedir. vLLM odağı genişliği sınırlar, ancak yamalar DeepSeek-V3.1 gibi modeller için FP8 boşluklarını kapatır. Gelişmeler için depoyu takip edin.

Mevcut Çerçevelerle Entegrasyon: vLLM ve Ötesi

vLLM ile İşbirliği

Checkpoint-engine, vLLM'nin PagedAttention'ı ile yerel olarak eşleşerek pürüzsüz RL çıkarımı sağlar. Bu ikili, vLLM'nin güncellemelerinde belirtildiği gibi 1T modellerde 20 saniyelik senkronizasyonlar elde eder – açık işbirliğinin verimi artırdığının bir göstergesi.

Claude ve Apidog'a Potansiyel Uzantılar

Anthropic'in Claude'una uzatmak, güvenlik odaklı sohbetlerine RL dinamizmi katabilir, canlı ince ayarları mümkün kılabilir. Apidog, ZeroMQ ayarlamaları sırasında uç nokta sahteciliği için mükemmel bir şekilde uyar – bu köprüleri zahmetsizce prototiplemek için Apidog'u ücretsiz indirin.

Daha Geniş Ekosistem Etkisi

Ollama veya LM Studio'ya bağlanmak, trilyon parametre gücünü yerelleştirebilir, bağımsız geliştiriciler için alanı eşitleyebilir. Bu dalgalanma etkisi, daha kapsayıcı bir yapay zeka ortamını teşvik eder.

Gelecek Beklentileri: Checkpoint-Engine İçin Neler Var?

Ölçeklenebilirlik ve Performans Geliştirmeleri

Tam boru hattının devreye alınması saniyeler kazandırabilirken, P2P merkeziyetsizliği gerçek esneklik için darboğazları ortadan kaldırır. RDMA ayarlamaları, bulut tabanlı yetenek vaat ediyor.

Topluluk Katkıları

Açık kaynak, düzeltmeleri ve portları davet eder – SGLang birleştirmeleri veya PCIe'den bağımsız modlar düşünün. Tweet'teki ilk yanıtlar heyecanla dolup taşıyor, ivmeyi artırıyor.

Endüstri Uygulamaları

Gerçek zamanlı çeviriden kendi kendine sürüş RL'sine kadar, checkpoint-engine akış yoğun alanlara uygundur. Hızı, modelleri güncel tutar, çeviklikte rakiplerini geride bırakır.

LLM Çıkarımı İçin Yeni Bir Çağ mı?

Checkpoint-engine, ağırlık sorunlarını açık kaynak zarafetiyle ele alarak çevik LLM geleceklerinin habercisidir. Akıllı mimari ve kıyaslamalarla desteklenen 20 saniyelik 1T yenileme, sınırlamalarına rağmen RL tahtını sağlamlaştırıyor.

Geliştirme akışları için Apidog ile veya hibrit zekalar için Claude ile eşleştirin, inovasyon yükselir. GitHub'ı takip edin, Apidog'u ücretsiz edinin ve çıkarımı yeniden şekillendiren devrime bugün katılın!