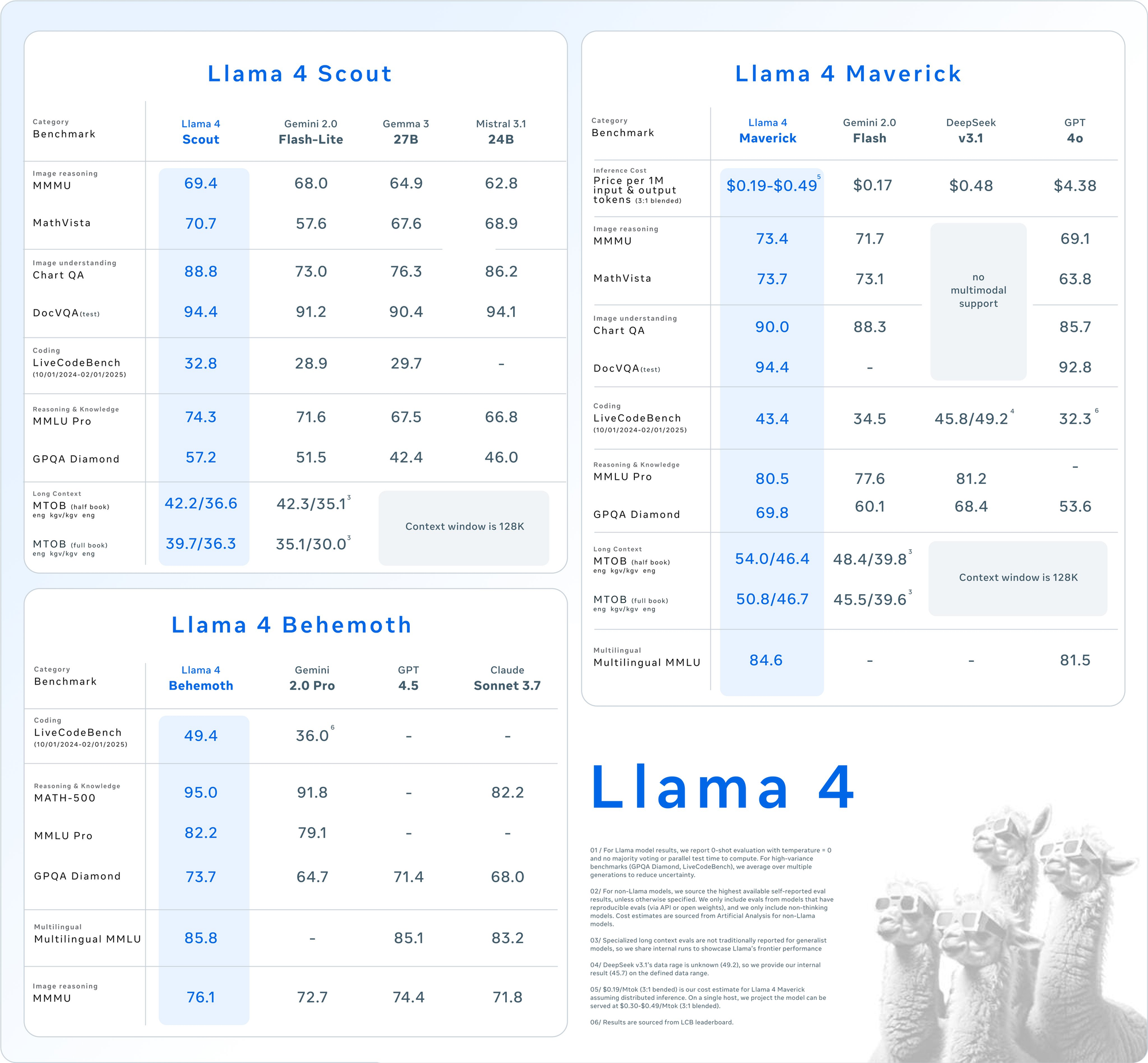

Meta’nın Llama 4 modelleri, yani Llama 4 Maverick ve Llama 4 Scout, çok modlu yapay zeka teknolojisinde büyük bir sıçramayı temsil ediyor. 5 Nisan 2025'te piyasaya sürülen bu modeller, Mixture-of-Experts (MoE) mimarisinden yararlanarak, metin ve görüntülerin dikkate değer performans-maliyet oranlarıyla verimli bir şekilde işlenmesini sağlıyor. Geliştiriciler, bu yeteneklerden çeşitli platformlar tarafından sağlanan API'ler aracılığıyla yararlanabilir ve uygulamalara entegrasyonu sorunsuz ve güçlü hale getirebilirler.

Llama 4 Maverick ve Llama 4 Scout'u Anlamak

API kullanımına dalmadan önce, bu modellerin temel özelliklerini kavrayın. Llama 4, yerel çok modluluğu sunar, yani metin ve görüntüleri baştan itibaren birlikte işler. Ek olarak, MoE tasarımı, görev başına yalnızca bir parametre alt kümesini etkinleştirerek verimliliği artırır.

Llama 4 Scout: Verimli Çok Modlu İş Atı

- Parametreler: 17 milyar aktif, 109 milyar toplam, 16 uzman.

- Bağlam Penceresi: 10 milyona kadar token.

- Temel Özellikler: Çok belgeli özetleme ve büyük kod tabanları üzerinde akıl yürütme gibi uzun bağlam görevlerinde mükemmeldir. INT4 niceliği ile tek bir NVIDIA H100 GPU'ya sığar.

- Kullanım Alanı: Hızlı, kaynak açısından verimli çok modlu işlemeye ihtiyaç duyan geliştiriciler için idealdir.

Llama 4 Maverick: Çok Yönlü Güç Merkezi

- Parametreler: 17 milyar aktif, 400 milyar toplam, 128 uzman.

- Bağlam Penceresi: 1 milyona kadar token.

- Temel Özellikler: 12 dili (örneğin, İngilizce, İspanyolca, Hintçe) destekleyerek yüksek kaliteli metin ve görüntü anlayışı sunar. Sohbet ve yaratıcı yazma için optimize edilmiştir.

- Kullanım Alanı: Kurumsal düzeyde asistanlar ve çok dilli uygulamalar için uygundur.

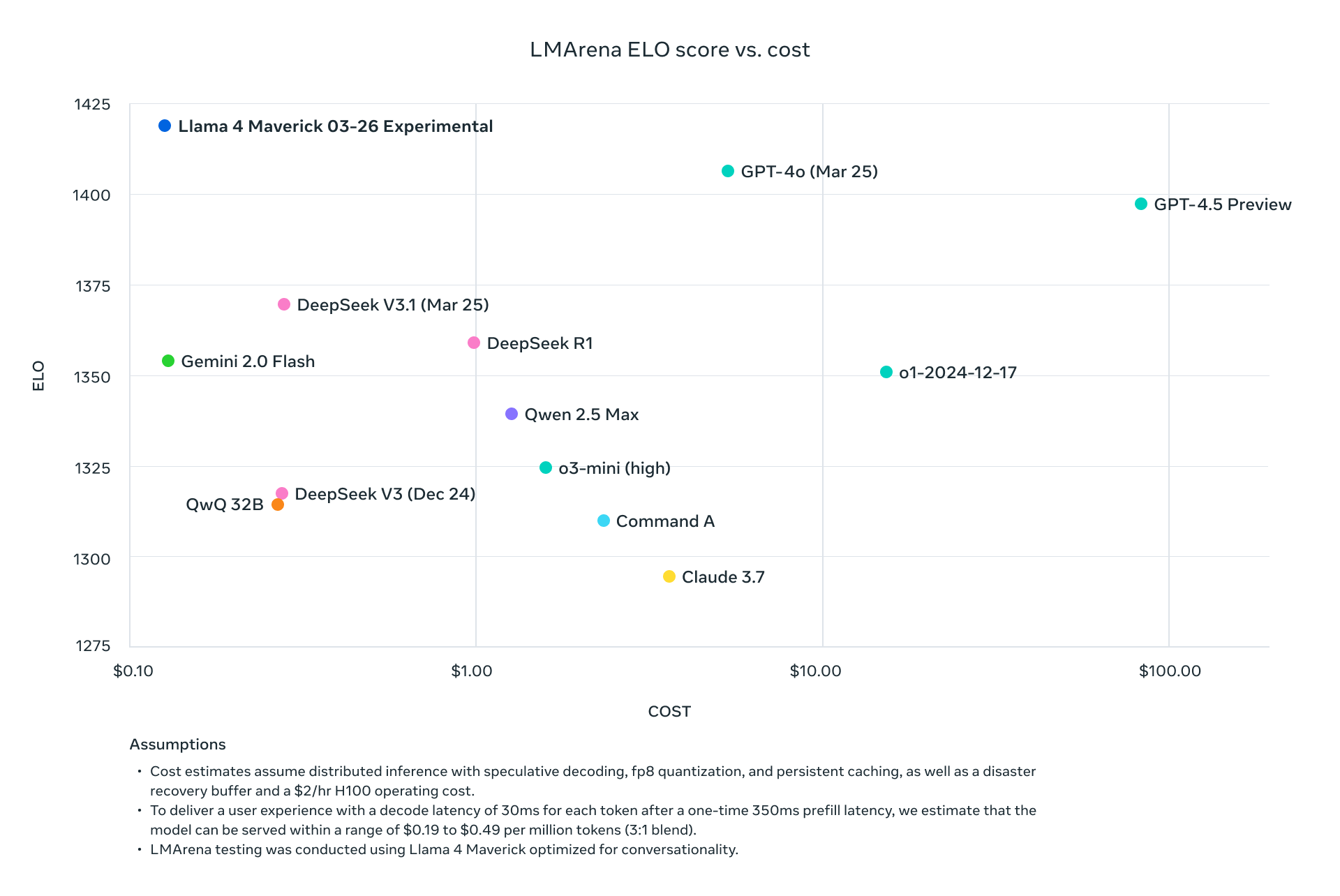

Her iki model de Llama 3 gibi seleflerinden daha iyi performans gösterir ve GPT-4o gibi sektör devleriyle rekabet ederek, onları API odaklı projeler için cazip seçenekler haline getirir.

Neden Llama 4 API'sini Kullanmalısınız?

Llama 4'ü API aracılığıyla entegre etmek, genellikle önemli donanım (örneğin, Maverick için NVIDIA H100 DGX) gerektiren bu devasa modelleri yerel olarak barındırma ihtiyacını ortadan kaldırır. Bunun yerine, Groq, Together AI ve OpenRouter gibi platformlar yönetilen API'ler sağlayarak şunları sunar:

- Ölçeklenebilirlik: Altyapı yükü olmadan değişen yükleri yönetin.

- Maliyet Verimliliği: Token başına ödeme yapın, oranlar 0,11$/M giriş tokeni (Groq'ta Scout) kadar düşük.

- Kullanım Kolaylığı: Basit HTTP istekleriyle çok modlu özelliklere erişin.

Şimdi, bu API'leri çağırmak için ortamınızı ayarlayalım.

Llama 4 API Çağrıları için Ortamınızı Ayarlama

Llama 4 Maverick ve Llama 4 Scout ile API aracılığıyla etkileşim kurmak için geliştirme ortamınızı hazırlayın. Şu adımları izleyin:

Adım 1: Bir API Sağlayıcısı Seçin

Birkaç platform Llama 4 API'lerini barındırır. İşte popüler seçenekler:

- Groq: Düşük maliyetli çıkarım sunar (Scout: 0,11$/M giriş, Maverick: 0,50$/M giriş).

- Together AI: Özel ölçeklendirme ile özel uç noktalar sağlar.

- OpenRouter: Test için ideal olan ücretsiz katman mevcuttur.

- Cloudflare Workers AI: Scout desteği ile sunucusuz dağıtım.

Bu kılavuz için, sağlam belgeleri ve performansları nedeniyle örnek olarak Groq ve Together AI'yi kullanacağız.

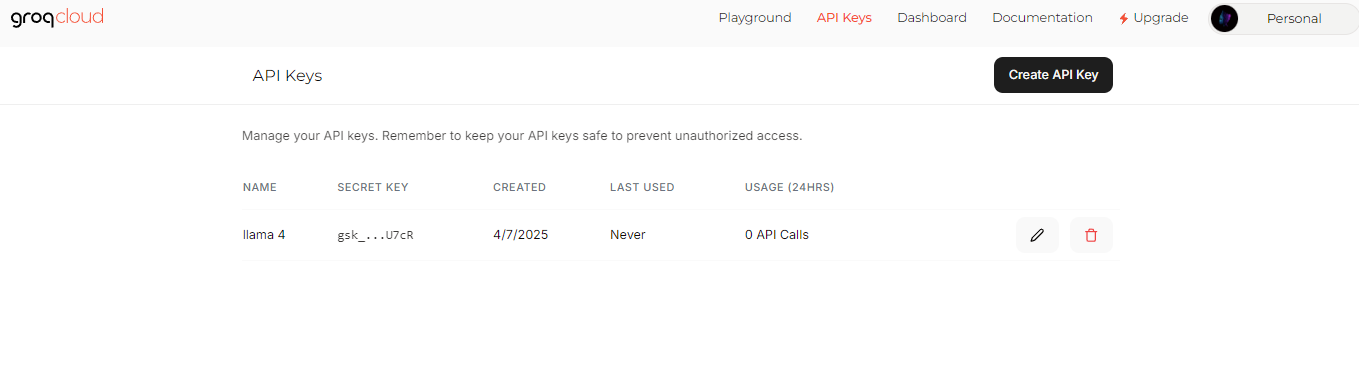

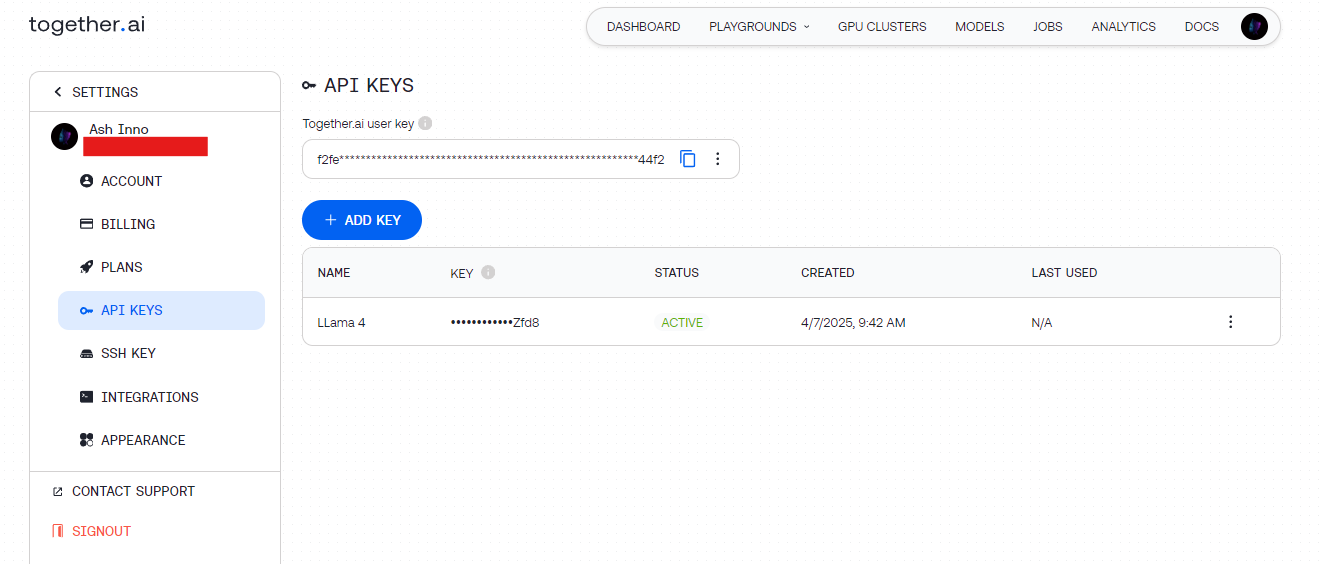

Adım 2: API Anahtarlarını Alın

- Groq: groq.com adresinde kaydolun, Geliştirici Konsolu'na gidin ve bir API anahtarı oluşturun.

- Together AI: together.ai adresine kaydolun, ardından API anahtarınıza panodan erişin.

Bu anahtarları güvenli bir şekilde (örneğin, ortam değişkenlerinde) saklayın, böylece bunları kodlamaktan kaçının.

Adım 3: Bağımlılıkları Yükleyin

Basitlik için Python kullanın. Gerekli kitaplıkları yükleyin:

pip install requests

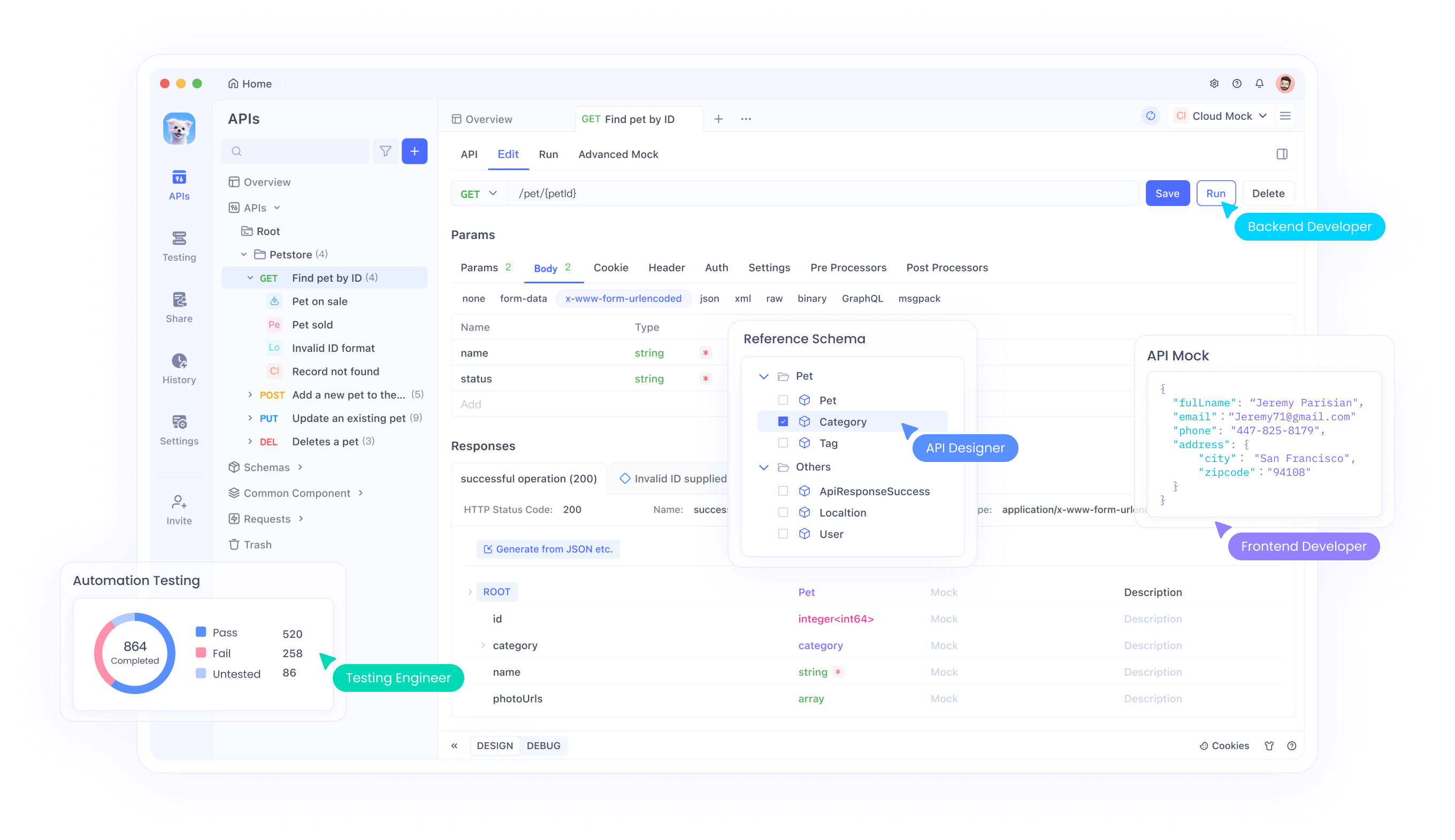

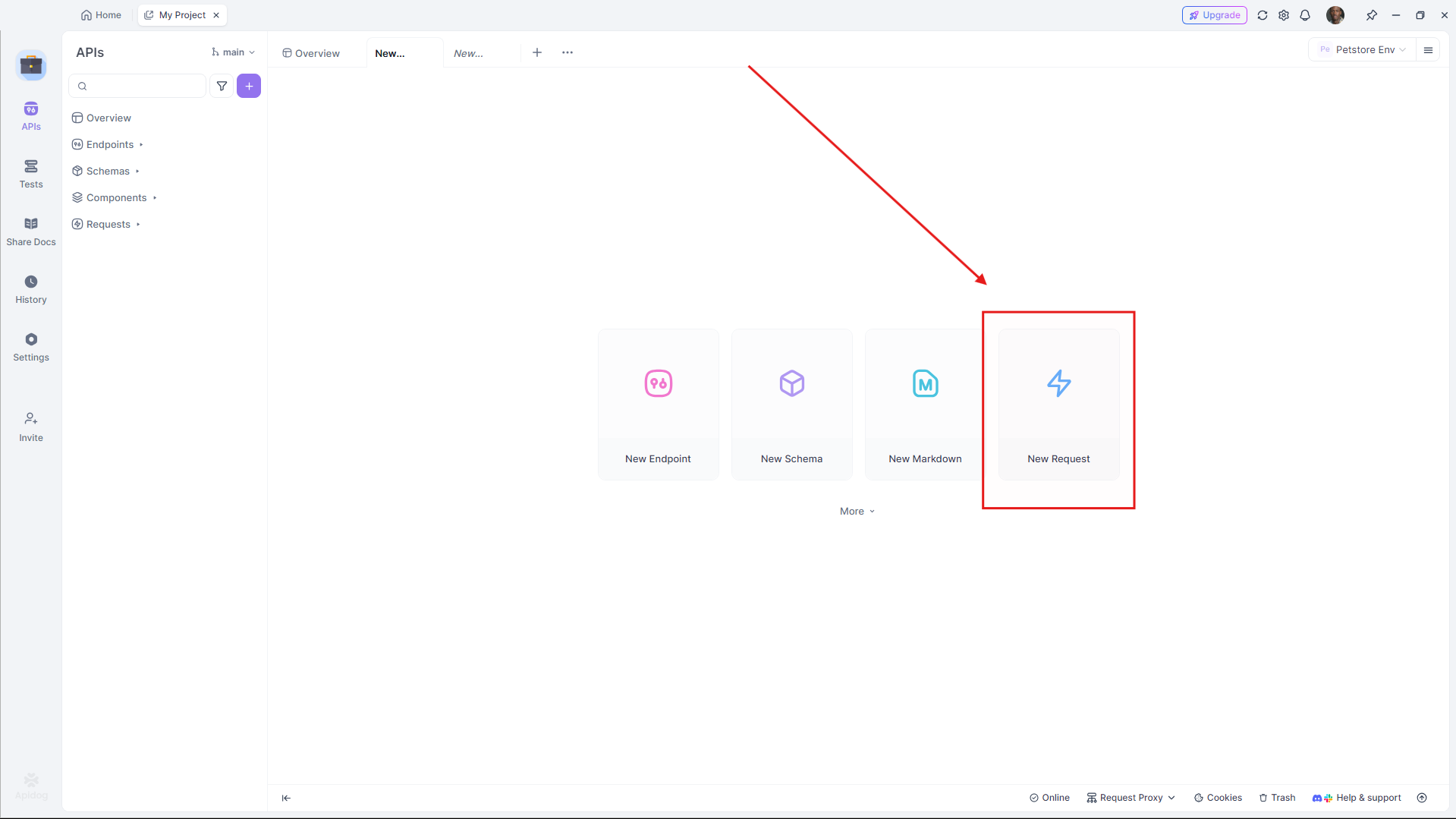

Test için, Apidog, API uç noktalarını görsel olarak hata ayıklamanıza izin vererek bu kurulumu tamamlar.

İlk Llama 4 API Çağrınızı Yapma

Ortamınız hazır olduğunda, Llama 4 API'sine bir istek gönderin. Temel bir metin oluşturma örneğiyle başlayalım.

Örnek 1: Llama 4 Scout ile Metin Oluşturma (Groq)

import requests

import os

# API anahtarını ayarla

API_KEY = os.getenv("GROQ_API_KEY")

URL = "https://api.groq.com/v1/chat/completions"

# Yükü tanımla

payload = {

"model": "meta-llama/Llama-4-Scout-17B-16E-Instruct",

"messages": [

{"role": "user", "content": "Yapay zeka hakkında kısa bir şiir yazın."}

],

"max_tokens": 150,

"temperature": 0.7

}

# Başlıkları ayarla

headers = {

"Authorization": f"Bearer {API_KEY}",

"Content-Type": "application/json"

}

# İstek gönder

response = requests.post(URL, json=payload, headers=headers)

print(response.json()["choices"][0]["message"]["content"])

Çıktı: Verimli MoE mimarisinden yararlanan Scout tarafından oluşturulan öz bir şiir.

Örnek 2: Llama 4 Maverick ile Çok Modlu Giriş (Together AI)

Maverick, çok modlu görevlerde parlar. İşte bir görüntüyü nasıl açıklayacağınız:

import requests

import os

# API anahtarını ayarla

API_KEY = os.getenv("TOGETHER_API_KEY")

URL = "https://api.together.ai/v1/chat/completions"

# Görüntü ve metin ile yükü tanımla

payload = {

"model": "meta-llama/Llama-4-Maverick-17B-128E-Instruct-FP8",

"messages": [

{

"role": "user",

"content": [

{

"type": "image_url",

"image_url": {"url": "https://example.com/sample.jpg"}

},

{

"type": "text",

"text": "Bu görüntüyü açıklayın."

}

]

}

],

"max_tokens": 200

}

# Başlıkları ayarla

headers = {

"Authorization": f"Bearer {API_KEY}",

"Content-Type": "application/json"

}

# İstek gönder

response = requests.post(URL, json=payload, headers=headers)

print(response.json()["choices"][0]["message"]["content"])

Çıktı: Maverick'in görüntü-metin hizalamasını sergileyen, görüntünün ayrıntılı bir açıklaması.

Performans için API İsteklerini Optimize Etme

Verimliliği en üst düzeye çıkarmak için, Llama 4 API çağrılarınızı ayarlayın. Bu teknikleri göz önünde bulundurun:

Bağlam Uzunluğunu Ayarlayın

- Scout: Uzun belgeler için 10M token penceresini kullanın. Büyük girdileri işlemek için

max_model_len'i (destekleniyorsa) ayarlayın. - Maverick: Hız ve kaliteyi dengelemek için sohbet uygulamaları için 1M token ile sınırlayın.

Parametreleri İnce Ayar Yapın

- Sıcaklık: Gerçeklere dayalı yanıtlar için daha düşük (örneğin, 0,5), yaratıcılık için daha yüksek (örneğin, 1,0).

- Maksimum Tokenler: Gereksiz hesaplamadan kaçınmak için çıktı uzunluğunu sınırlayın.

Toplu İşleme

Gecikmeyi azaltmak için birden fazla istemi tek bir istekte gönderin (API destekliyorsa). Toplu uç noktalar için sağlayıcı belgelerini kontrol edin.

Llama 4 API ile Gelişmiş Kullanım Durumları

Şimdi, Llama 4'ün tüm potansiyelini ortaya çıkarmak için gelişmiş entegrasyonları keşfedin.

Kullanım Durumu 1: Çok Dilli Sohbet Robotu

Maverick 12 dili destekler. Bir müşteri destek botu oluşturun:

payload = {

"model": "meta-llama/Llama-4-Maverick-17B-128E-Instruct-FP8",

"messages": [

{"role": "user", "content": "Hola, ¿cómo puedo resetear mi contraseña?"}

],

"max_tokens": 100

}

response = requests.post(URL, json=payload, headers=headers)

print(response.json()["choices"][0]["message"]["content"])

Çıktı: Maverick'in çok dilli akıcılığından yararlanan İspanyolca bir yanıt.

Kullanım Durumu 2: Scout ile Belge Özetleme

Scout'un 10M token penceresi, büyük metinleri özetlemede mükemmeldir:

long_text = "..." # Buraya uzun bir belge ekleyin

payload = {

"model": "meta-llama/Llama-4-Scout-17B-16E-Instruct",

"messages": [

{"role": "user", "content": f"Bunu özetleyin: {long_text}"}

],

"max_tokens": 300

}

response = requests.post(URL, json=payload, headers=headers)

print(response.json()["choices"][0]["message"]["content"])

Çıktı: Scout tarafından verimli bir şekilde işlenen öz bir özet.

Apidog ile Hata Ayıklama ve Test Etme

API'leri test etmek, özellikle çok modlu girdilerle zor olabilir. İşte Apidog'un parladığı yer burasıdır:

- Görsel Arayüz: Kodlama yapmadan istekler oluşturun ve gönderin.

- Hata Takibi: Oran sınırları veya hatalı biçimlendirilmiş yükler gibi sorunları belirleyin.

- Sahte Yanıtlar: Ön uç geliştirme için Llama 4 çıktılarını simüle edin.

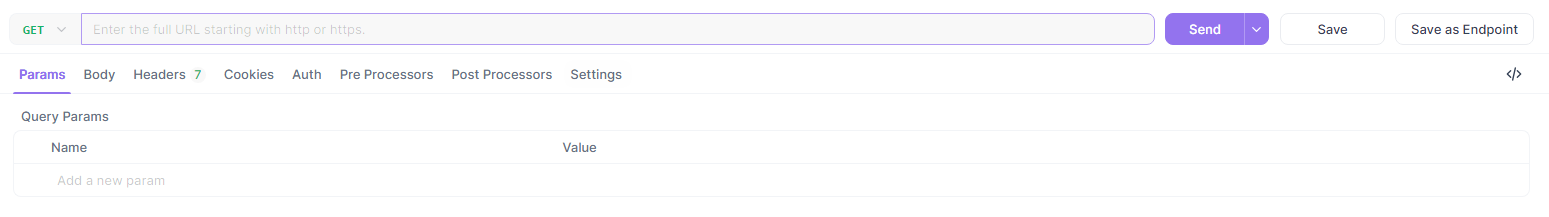

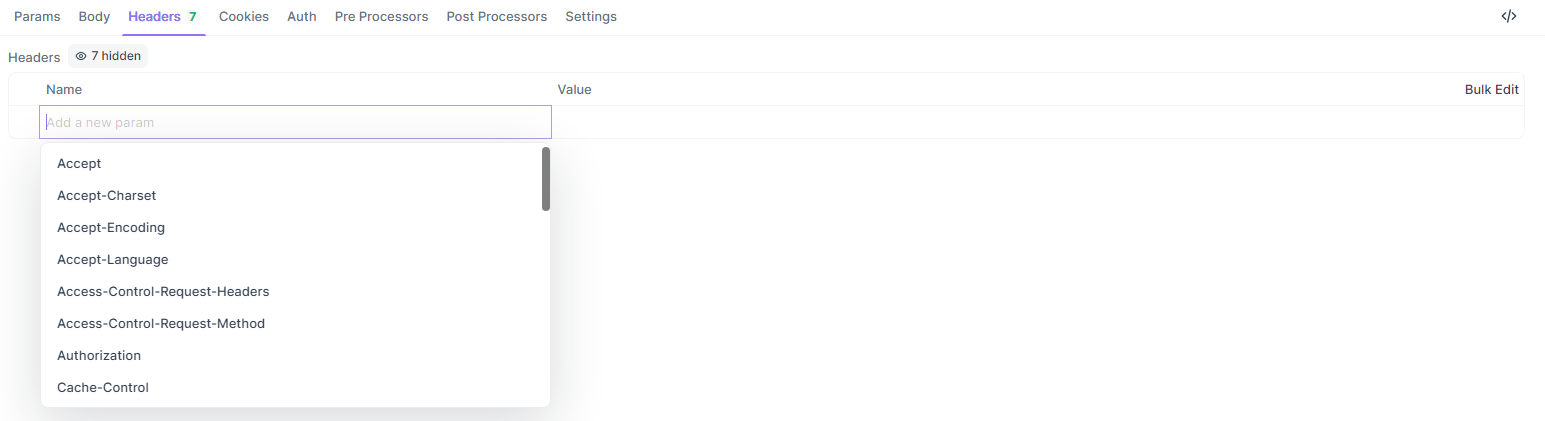

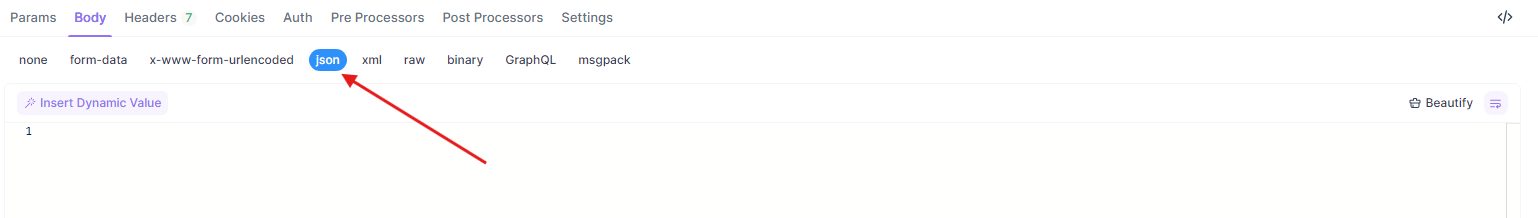

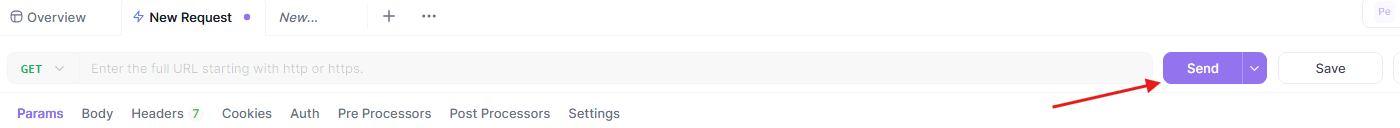

Yukarıdaki örnekleri Apidog'da test etmek için:

- Apidog'u açın ve yeni bir istek oluşturun.

- URL'yi ayarlayın (örneğin,

https://api.groq.com/v1/chat/completions).

- Başlıkları ekleyin (

Authorization,Content-Type).

- JSON yükünü yapıştırın.

- Yanıtı gönderin ve inceleyin.

Bu iş akışı, Llama 4 API entegrasyonunuzun sorunsuz çalışmasını sağlar.

Llama 4 için API Sağlayıcılarını Karşılaştırma

Doğru sağlayıcıyı seçmek maliyet ve performansı etkiler. İşte bir döküm:

| Sağlayıcı | Model Desteği | Fiyatlandırma (Giriş/Çıkış M başına) | Bağlam Sınırı | Notlar |

|---|---|---|---|---|

| Groq | Scout, Maverick | 0,11$/0,34$ (Scout), 0,50$/0,77$ (Maverick) | 128K (genişletilebilir) | En düşük maliyet, yüksek hız |

| Together AI | Scout, Maverick | Özel (özel uç noktalar) | 1M (Maverick) | Ölçeklenebilir, kurumsal odaklı |

| OpenRouter | Her ikisi de | Ücretsiz katman mevcut | 128K | Test için harika |

| Cloudflare | Scout | Kullanıma dayalı | 131K | Sunucusuz basitlik |

Projenizin ölçeğine ve bütçesine göre seçin. Prototip oluşturma için, OpenRouter'ın ücretsiz katmanıyla başlayın, ardından Groq veya Together AI ile ölçeklendirin.

Llama 4 API Entegrasyonu için En İyi Uygulamalar

Sağlam entegrasyon sağlamak için şu yönergeleri izleyin:

- Oran Sınırlaması: Sağlayıcı sınırlarına uyun (örneğin, Groq'un dakikada 100 isteği). Yeniden denemeler için üstel geri alma uygulayın.

- Hata İşleme: HTTP hatalarını (örneğin, 429 Çok Fazla İstek) yakalayın ve bunları günlüğe kaydedin.

- Güvenlik: API anahtarlarını şifreleyin ve HTTPS uç noktalarını kullanın.

- İzleme: Özellikle Maverick'in daha yüksek oranlarıyla maliyetleri yönetmek için token kullanımını izleyin.

Yaygın API Sorunlarını Giderme

Sorunlarla mı karşılaşıyorsunuz? Bunları hızlı bir şekilde ele alın:

- 401 Yetkisiz: API anahtarınızı doğrulayın.

- 429 Oran Sınırı Aşıldı: İstek sıklığını azaltın veya planınızı yükseltin.

- Yük Hataları: JSON biçiminin sağlayıcı özellikleriyle eşleştiğinden emin olun (örneğin,

messagesdizisi).

Apidog, bu sorunları görsel olarak teşhis etmeye yardımcı olur ve zamandan tasarruf sağlar.

Sonuç

Llama 4 Maverick ve Llama 4 Scout'u API aracılığıyla entegre etmek, geliştiricilere minimum ek yükle son teknoloji uygulamalar oluşturma olanağı sağlar. İster Scout'un uzun bağlam verimliliğine ister Maverick'in çok dilli yeteneğine ihtiyacınız olsun, bu modeller erişilebilir uç noktalar aracılığıyla en üst düzeyde performans sunar. Bu kılavuzu izleyerek, API çağrılarınızı etkili bir şekilde ayarlayabilir, optimize edebilir ve sorunlarını giderebilirsiniz.

Daha derine dalmaya hazır mısınız? Groq ve Together AI gibi sağlayıcılarla deneyler yapın ve iş akışınızı iyileştirmek için Apidog'dan yararlanın. Çok modlu yapay zekanın geleceği burada—bugün oluşturmaya başlayın!