Büyük dil modeli (LLM) işlem hatlarınızı değerlendirme ve optimize etme konusunda zorlanıyor musunuz? Karşınızda LangWatch, özel LLM iş akışlarınızı izlemeyi, değerlendirmeyi ve ince ayar yapmayı kolaylaştıran, oyunun kurallarını değiştiren bir platform. Bu kılavuzda, LangWatch'un ne olduğunu, neden harika olduğunu ve yapay zeka projelerinizi süper şarj etmek için nasıl kurulacağını ve kullanılacağını derinlemesine inceleyeceğiz. Basit bir sohbet robotu kurmayı, LangWatch'ı entegre etmeyi ve örnek bir soruyla test etmeyi adım adım anlatacağız; tüm bunları takip etmesi kolay bir şekilde yapacağız. Başlayalım!

Geliştirici Ekibinizin maksimum verimlilikle birlikte çalışması için entegre, Hepsi Bir Arada bir platform mu istiyorsunuz?

Apidog tüm taleplerinizi karşılar ve Postman'ı çok daha uygun bir fiyata değiştirir!

LangWatch Nedir ve Neden Önemsemelisiniz?

LangWatch, LLM değerlendirmesinin zorlu sorununu ele almak için başvuracağınız platformdur. Sınıflandırma için F1 skoru, çeviri için BLEU veya özetleme için ROUGE gibi standart metrikleri olan geleneksel modellerin aksine, üretken LLM'ler deterministik değildir ve belirlenmesi zordur. Ayrıca, her şirketin kendi verileri, ince ayarlı modelleri ve özel işlem hatları vardır, bu da değerlendirmeyi bir baş ağrısı haline getirir. İşte LangWatch burada parlıyor!

LangWatch size şunları sağlar:

- Deney ve Optimizasyon: LLM işlem hatlarınızı kolayca test edin ve geliştirin.

- Performansı İzleme: Yapay zekanızın gerçek zamanlı olarak nasıl davrandığını takip edin.

- Sonuçları Değerlendirme: Doğruluk ve kaliteyi ölçmek için veri kümeleri ve değerlendiriciler kullanın.

- Özel İşlem Hatlarını Destekleme: Benzersiz verileriniz ve modellerinizle çalışır.

İster bir sohbet robotu, ister bir çeviri aracı veya özel bir yapay zeka uygulaması geliştiriyor olun, LangWatch LLM'nizin birinci sınıf sonuçlar vermesini sağlamanıza yardımcı olur. Onu eylemde görmeye hazır mısınız? Haydi LangWatch'ı kuralım ve kullanalım!

LangWatch'ı Kurma ve Kullanma Adım Adım Kılavuzu

Ön Koşullar

Başlamadan önce şunlara ihtiyacınız olacak:

- Python 3.8+: Projeyi çalıştırmak için (python.org).

- LangWatch Hesabı: app.langwatch.ai adresinden kaydolun.

- OpenAI API Anahtarı: Sohbet robotu demosu için (platform.openai.com adresinden edinin).

- Kod Düzenleyici: VS Code, PyCharm veya favori IDE'niz.

- Git ve Docker: İsteğe bağlı, yerel LangWatch kurulumu için.

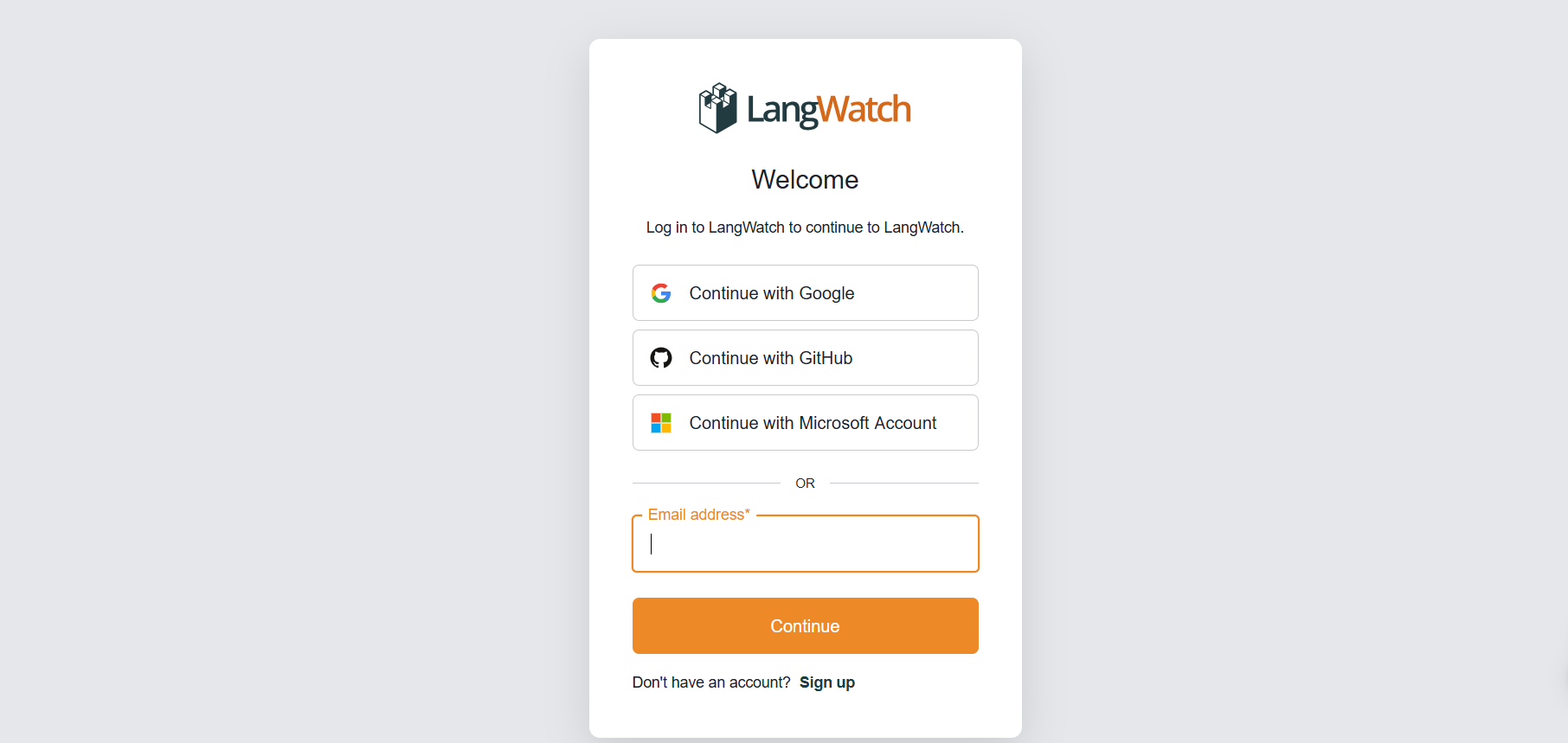

Adım 1: LangWatch'a Kaydolun

Hesap Oluşturun:

- app.langwatch.ai adresine gidin ve ücretsiz bir hesap için kaydolun.

- Sizin için "AI Bites" adında varsayılan bir proje oluşturulur. Bu eğitim için onu kullanacağız, ancak isterseniz yeni bir tane oluşturabilirsiniz.

API Anahtarınızı Alın:

- LangWatch kontrol panelinizde,

LANGWATCH_API_KEY'inizi bulmak için Proje Ayarları'na gidin. Buna daha sonra ihtiyacınız olacak.

Adım 2: LangWatch ile Bir Python Projesi Kurun

Bir Python projesi oluşturalım ve basit bir sohbet robotunu izlemek için LangWatch'ı entegre edelim.

- Proje Klasörü Oluşturun:

- Yeni bir dizin oluşturun (örn.

langwatch-demo) ve içine gidin:

mkdir langwatch-demo

cd langwatch-demo

2. Sanal Ortam Kurun:

- Bağımlılıkları izole tutmak için bir sanal ortam oluşturun ve etkinleştirin:

python -m venv venv

source venv/bin/activate # Windows'ta: venv\Scripts\activate

3. LangWatch ve Bağımlılıkları Yükleyin:

- LangWatch ve Chainlit'i (sohbet robotu kullanıcı arayüzü için) yükleyin:

pip install langwatch chainlit openai

4. Sohbet Robotu Kodunu Oluşturun:

app.pyadında bir dosya oluşturun ve OpenAI'nin GPT-4o-mini modelini kullanarak basit bir sohbet robotu oluşturmak için bu kodu yapıştırın:

import os

import chainlit as cl

import asyncio

from openai import AsyncClient

openai_client = AsyncClient() # Assumes OPENAI_API_KEY is set in environment

model_name = "gpt-4o-mini"

settings = {

"temperature": 0.3,

"max_tokens": 500,

"top_p": 1,

"frequency_penalty": 0,

"presence_penalty": 0,

}

@cl.on_chat_start

async def start():

cl.user_session.set(

"message_history",

[

{

"role": "system",

"content": "You are a helpful assistant that only reply in short tweet-like responses, using lots of emojis."

}

]

)

async def answer_as(name: str):

message_history = cl.user_session.get("message_history")

msg = cl.Message(author=name, content="")

stream = await openai_client.chat.completions.create(

model=model_name,

messages=message_history + [{"role": "user", "content": f"speak as {name}"}],

stream=True,

**settings,

)

async for part in stream:

if token := part.choices[0].delta.content or "":

await msg.stream_token(token)

message_history.append({"role": "assistant", "content": msg.content})

await msg.send()

@cl.on_message

async def main(message: cl.Message):

message_history = cl.user_session.get("message_history")

message_history.append({"role": "user", "content": message.content})

await asyncio.gather(answer_as("AI Bites"))

5. OpenAI API Anahtarınızı Ayarlayın:

- OpenAI API anahtarınızı bir ortam değişkeni olarak ekleyin:

export OPENAI_API_KEY="your-openai-api-key" # Windows'ta: set OPENAI_API_KEY=your-openai-api-key

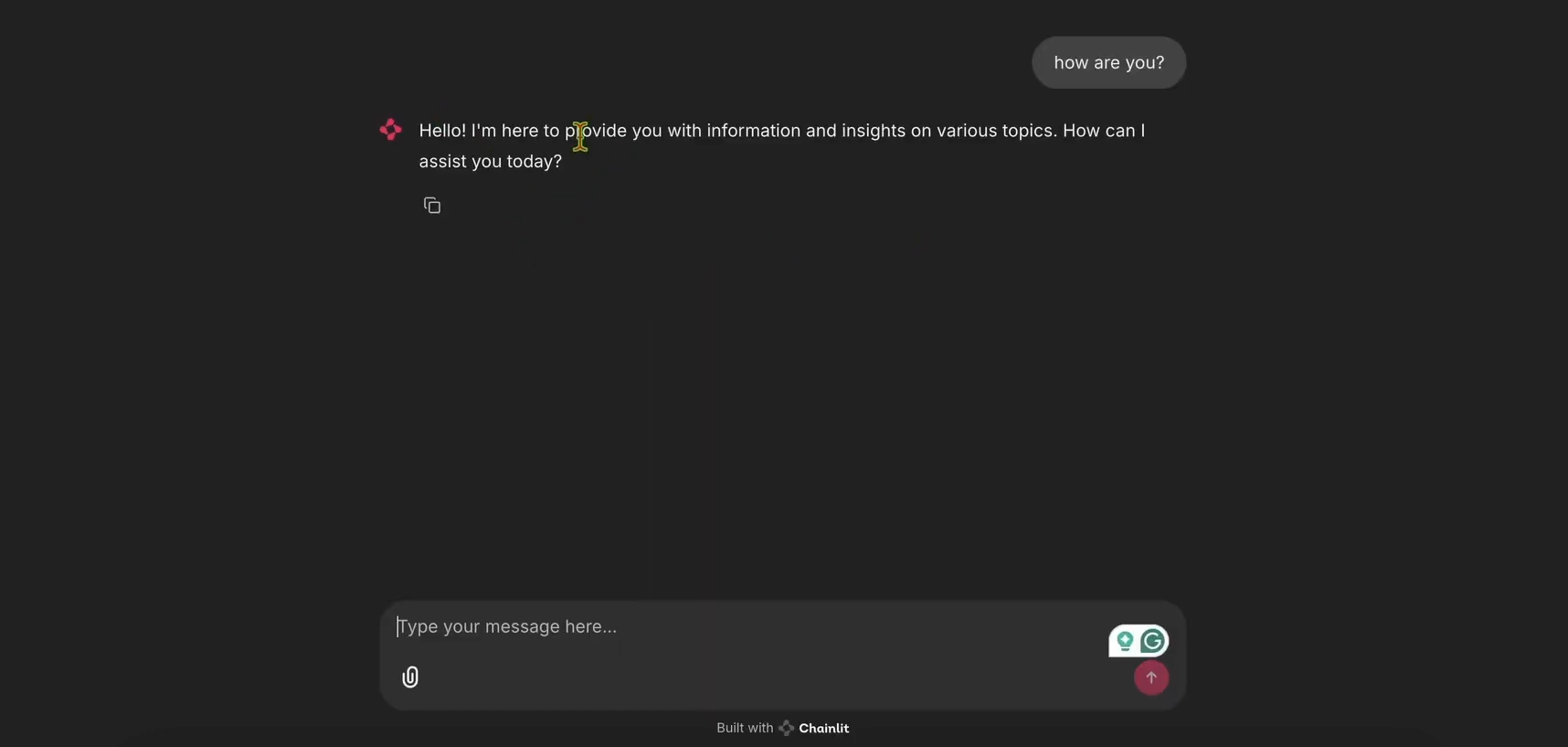

6. Sohbet Robotunu Çalıştırın:

- Chainlit uygulamasını başlatın:

chainlit run app.py

- Sohbet robotu kullanıcı arayüzünü görmek için http://localhost:8000 adresini açın. Çalıştığından emin olmak için deneyin!

Adım 3: İzleme İçin LangWatch'ı Entegre Edin

Şimdi, sohbet robotunun mesajlarını izlemek için LangWatch'ı ekleyelim.

- LangWatch için

app.pydosyasını değiştirin:

- LangWatch'ı dahil etmek ve

mainfonksiyonuna@langwatch.trace()dekoratörünü eklemek içinapp.pydosyasını güncelleyin:

import os

import chainlit as cl

import asyncio

import langwatch

from openai import AsyncClient

openai_client = AsyncClient()

model_name = "gpt-4o-mini"

settings = {

"temperature": 0.3,

"max_tokens": 500,

"top_p": 1,

"frequency_penalty": 0,

"presence_penalty": 0,

}

@cl.on_chat_start

async def start():

cl.user_session.set(

"message_history",

[

{

"role": "system",

"content": "You are a helpful assistant that only reply in short tweet-like responses, using lots of emojis."

}

]

)

async def answer_as(name: str):

message_history = cl.user_session.get("message_history")

msg = cl.Message(author=name, content="")

stream = await openai_client.chat.completions.create(

model=model_name,

messages=message_history + [{"role": "user", "content": f"speak as {name}"}],

stream=True,

**settings,

)

async for part in stream:

if token := part.choices[0].delta.content or "":

await msg.stream_token(token)

message_history.append({"role": "assistant", "content": msg.content})

await msg.send()

@cl.on_message

@langwatch.trace()

async def main(message: cl.Message):

message_history = cl.user_session.get("message_history")

message_history.append({"role": "user", "content": message.content})

await asyncio.gather(answer_as("AI Bites"))

2. Entegrasyonu Test Edin:

- Chainlit uygulamasını yeniden başlatın:

chainlit run app.py

- Sohbet robotu kullanıcı arayüzünde şunu sorun: “Bugünün Fransızca kelimesi nedir?”

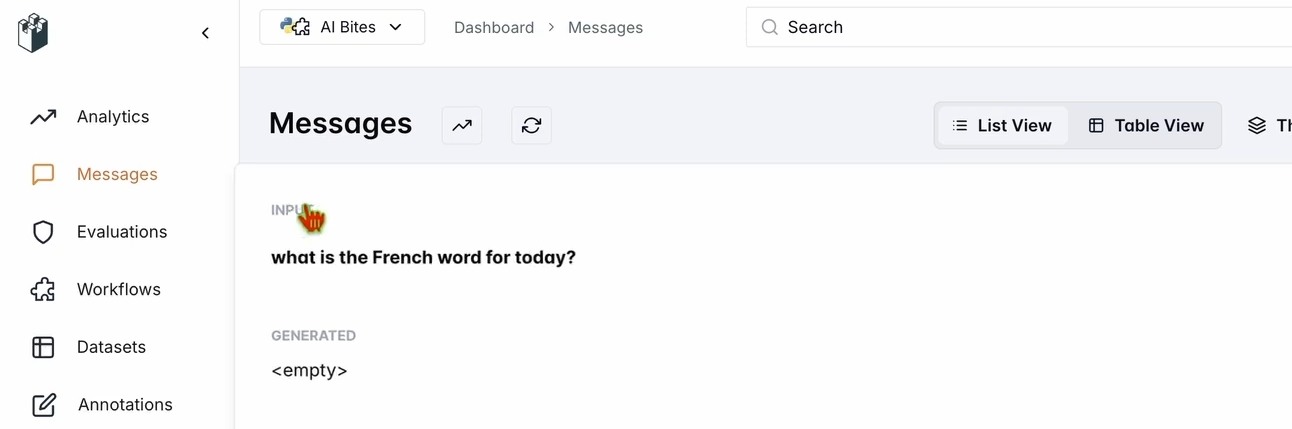

- LangWatch kontrol panelinizi kontrol edin:

- app.langwatch.ai adresine gidin.

- Sol kenar çubuğundan Mesajlar'ı seçin.

- Sorunuzun ve sohbet robotunun yanıtının (örn. “Aujourd’hui! 🇫🇷😊”) izlendiğini doğrulayın.

Adım 4: Sohbet Robotunuzu Değerlendirmek İçin Bir İş Akışı Kurun

Sohbet robotunun performansını değerlendirmek için LangWatch'ta bir veri kümesi ve değerlendirici oluşturalım.

- Bir Veri Kümesi Oluşturun:

- LangWatch kontrol panelinde, Veri Kümeleri'ne gidin ve Yeni Veri Kümesi'ne tıklayın.

- En az bir soru ve cevabı olan basit bir veri kümesi ekleyin. Örneğin:

| Soru | Beklenen Cevap |

|---|---|

| Bugünün Fransızca kelimesi nedir? | Aujourd’hui |

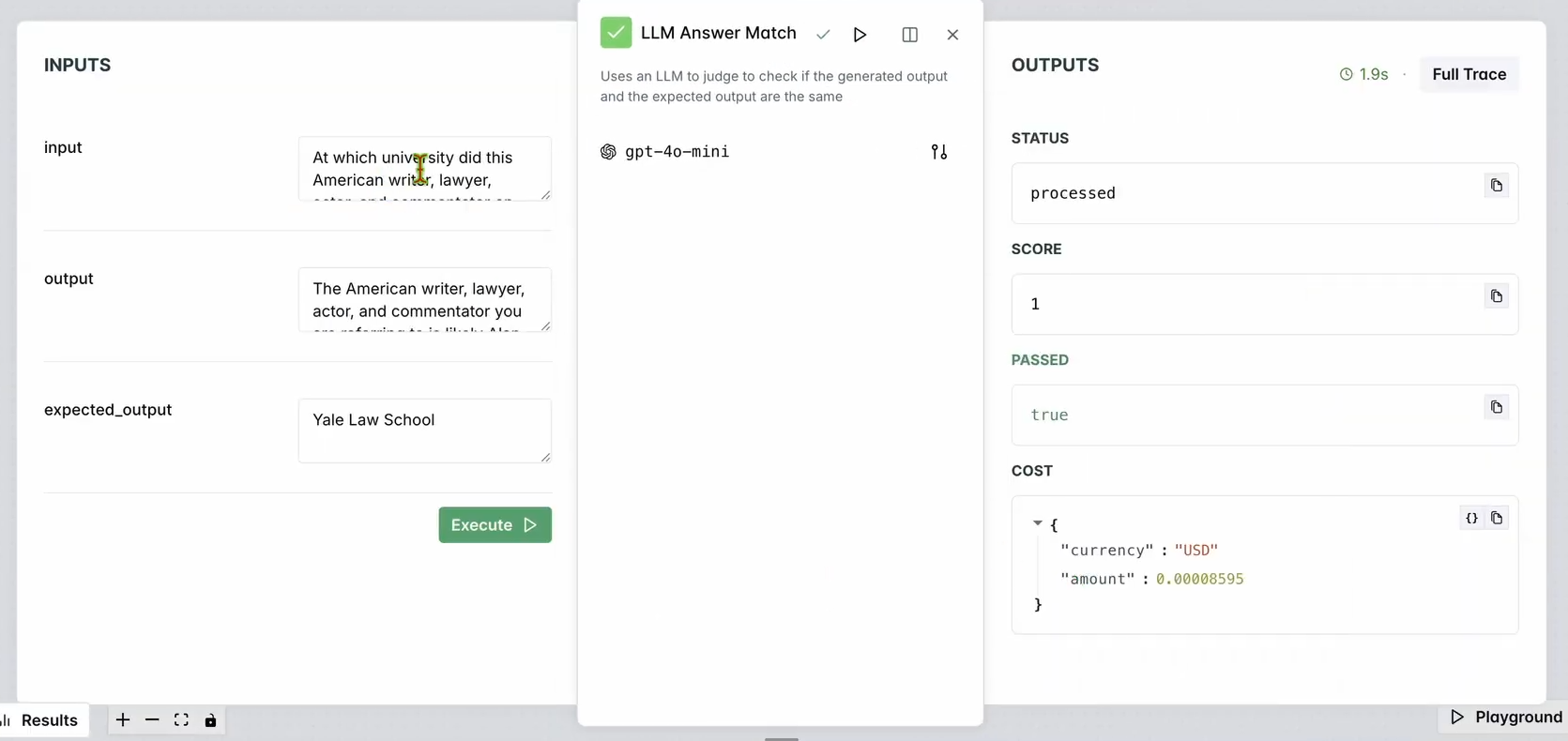

2. Bir Değerlendirici Kurun:

- LangWatch kontrol panelinde Değerlendiriciler'e gidin.

- LLM Cevap Eşleşmesi değerlendiricisini çalışma alanına sürükleyin.

- Yapılandırın:

- Girdi Sorusu'nu veri tabanınızdaki girdi sorularına (örn. “Bugünün Fransızca kelimesi nedir?”) ayarlayın.

- Beklenen Çıktı'yı da veri tabanınızın yanıtlarına (örn. “Aujourd’hui”) ayarlayın.

- İsteğe bağlı olarak, çeşitlilik için değerlendiricinin LLM modelini (örn. Llama, Gemini veya Claude Sonnet) değiştirin.

3. Değerlendiriciyi Çalıştırın:

- Değerlendiriciyi test etmek için Buraya Kadar İş Akışını Çalıştır'a tıklayın.

- Sohbet robotunun yanıtının beklenen çıktı ile eşleştiğinden emin olmak için sonuçları kontrol edin.

Şuna benzer bir şey görmelisiniz:

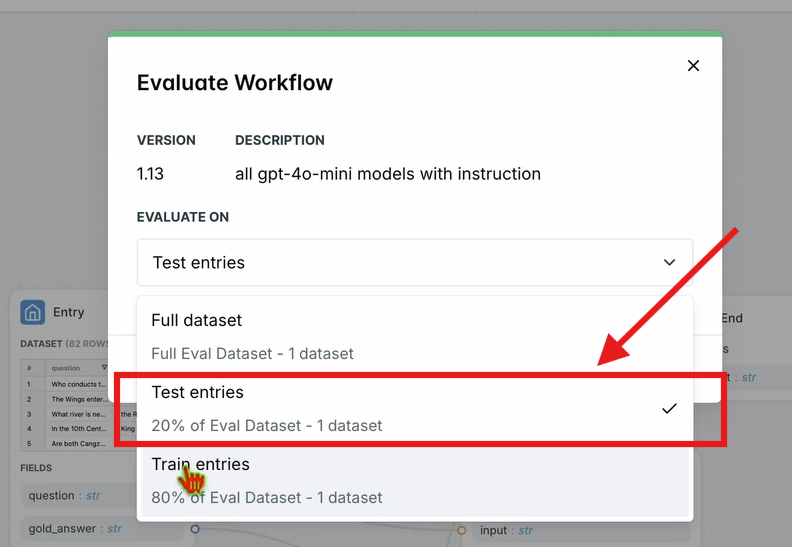

4. İş Akışını Değerlendirin:

- Üst gezinme çubuğunda, İş Akışını Değerlendir'e tıklayın ve Test Girişleri'ni seçin.

- Bu, tüm iş akışını veri kümenize göre değerlendirir. Sonuçlar kısa bir işlem süresinden sonra görünecektir.

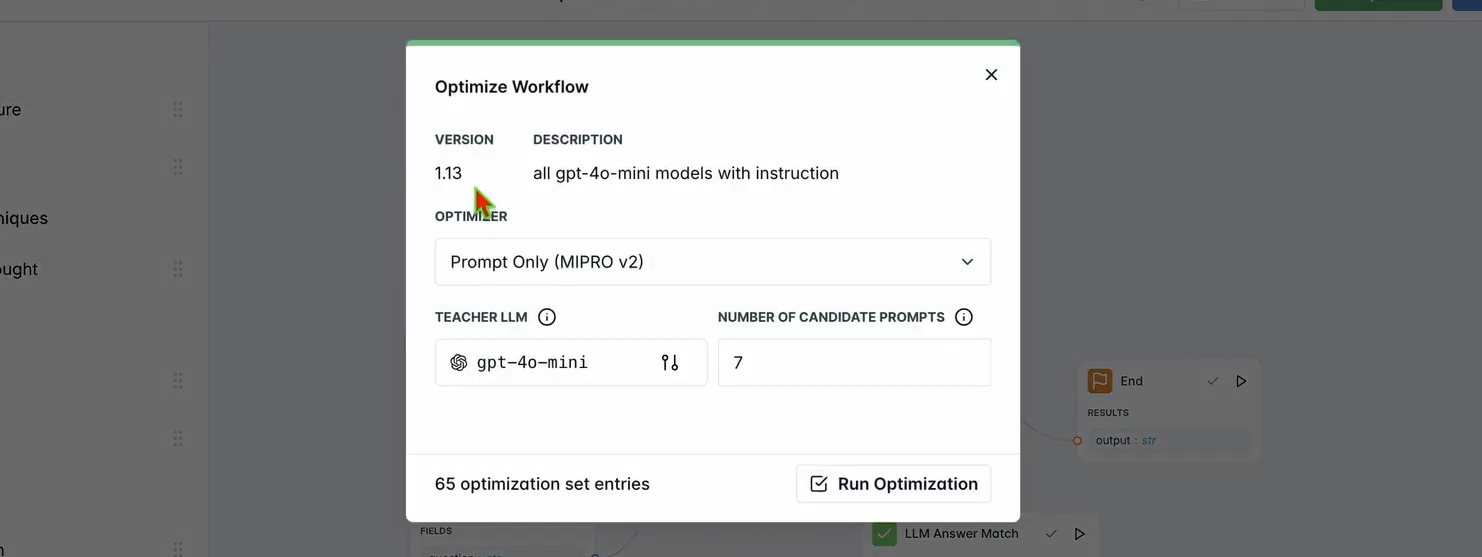

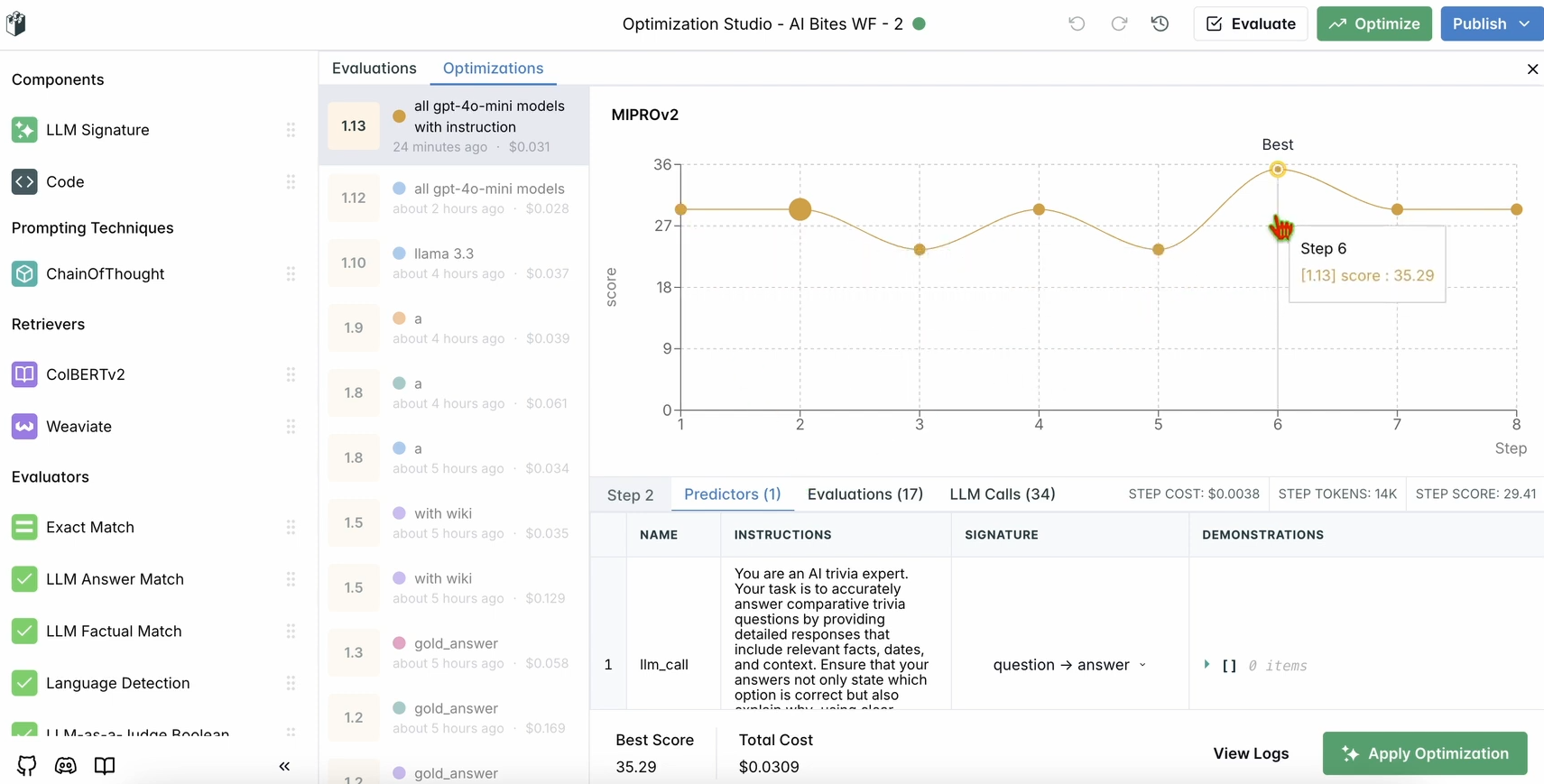

Adım 5: İş Akışınızı Optimize Edin

Değerlendirmeniz tamamlandıktan sonra, sohbet robotunun performansını optimize edelim.

1. Optimizasyonu Çalıştırın:

- LangWatch kontrol panelinde, üst gezinme çubuğundaki Optimize Et'e tıklayın.

- Sohbet robotunun istemini ince ayar yapmak için Yalnızca İstem'i seçin.

- Optimizasyonun tamamlanması için birkaç dakika bekleyin.

2. İyileştirmeleri Kontrol Edin:

- Kontrol panelindeki optimize edilmiş sonuçları inceleyin. LangWatch'ın önerilerine göre yanıt doğruluğunda veya kalitesinde iyileşme görmelisiniz.

Adım 6: İsteğe Bağlı Yerel LangWatch Kurulumu

Hassas verilerle test yapmak için LangWatch'ı yerel olarak çalıştırmak ister misiniz? Bu adımları izleyin:

- Depoyu Klonlayın:

git clone https://github.com/langwatch/langwatch.git

cd langwatch

2. Ortamı Kurun:

- Örnek ortam dosyasını kopyalayın:

cp langwatch/.env.example langwatch/.env

3. Docker ile Çalıştırın:

- LangWatch sunucusunu başlatın:

docker compose up -d --wait --build

4. Kontrol Paneline Erişin:

- LangWatch'ın ilk kurulum akışına girmek için http://localhost:5560 adresini açın.

- Yerel örneğinizi kurmak için talimatları izleyin.

Not: Docker kurulumu yalnızca test amaçlıdır ve üretim için ölçeklenebilir değildir. Üretim için LangWatch Cloud veya Kurumsal Şirket İçi çözümlerini kullanın.

Neden LangWatch Kullanmalı?

LangWatch, yapay zeka işlem hatlarınızı izlemek, değerlendirmek ve optimize etmek için birleşik bir platform sağlayarak LLM değerlendirme bilmecesini çözer. İstemleri ayarlıyor, performansı analiz ediyor veya sohbet robotunuzun doğru yanıtlar verdiğinden (Fransızca'da "today" için "Aujourd’hui" gibi) emin oluyor olun, LangWatch bunu çok kolaylaştırır. Python ve Chainlit ve OpenAI gibi araçlarla entegrasyonu, LLM uygulamalarınızı dakikalar içinde izlemeye ve iyileştirmeye başlayabileceğiniz anlamına gelir.

Örneğin, demo sohbet robotumuz artık emojilerle tweet benzeri kısa yanıtlar veriyor ve LangWatch bunun doğru ve optimize edilmiş olmasını sağlamaya yardımcı oluyor. Ölçeği büyütmek ister misiniz? Veri kümenize daha fazla soru ekleyin veya değerlendiricide farklı LLM modelleriyle deney yapın.

Sonuç

İşte bu kadar! LangWatch'ın ne olduğunu, nasıl kurulacağını ve bir sohbet robotunu izlemek ve optimize etmek için nasıl kullanılacağını öğrendiniz. Bir Python projesi kurmaktan mesajları izlemeye ve bir veri kümesiyle performansı değerlendirmeye kadar, LangWatch LLM işlem hatlarınızın kontrolünü ele almanızı sağlar. Test sorumuz – "Bugünün Fransızca kelimesi nedir?" – yapay zeka yanıtlarını izlemenin ve iyileştirmenin ne kadar kolay olduğunu gösterdi.

Yapay zeka oyununuzu bir üst seviyeye taşımaya hazır mısınız? app.langwatch.ai adresine gidin, kaydolun ve bugün LangWatch ile denemeler yapmaya başlayın.

Geliştirici Ekibinizin maksimum verimlilikle birlikte çalışması için entegre, Hepsi Bir Arada bir platform mu istiyorsunuz?

Apidog tüm taleplerinizi karşılar ve Postman'ı çok daha uygun bir fiyata değiştirir!