Hiç pahalı bulut hizmetlerine bağımlı kalmadan veya veri gizliliği konusunda endişelenmeden gelişmiş yapay zeka görüntü modellerini kendi makinenizde çalıştırmak istediniz mi? Şanslısınız! Bugün, Qwen 3 VL (Görsel Dil) modellerini Ollama ile yerel olarak nasıl çalıştıracağımıza derinlemesine dalıyoruz ve inanın bana, bu, yapay zeka geliştirme iş akışınız için ezber bozan bir gelişme olacak.

Şimdi, teknik konulara dalmadan önce size bir şey sorayım: API hız limitlerine takılmaktan, bulut çıkarımı için fahiş ücretler ödemekten veya sadece yapay zeka modelleriniz üzerinde daha fazla kontrol sahibi olmaktan sıkıldınız mı? Eğer evet diye başınızı salladıysanız, bu rehber tam size göre. Dahası, yerel yapay zeka API'lerinizi test etmek ve hata ayıklamak için güçlü bir araç arıyorsanız, Apidog'u ücretsiz indirmenizi şiddetle tavsiye ederim; Ollama'nın yerel uç noktalarıyla sorunsuz çalışan mükemmel bir API test platformudur.

Bu rehberde, Qwen 3 VL modellerini Ollama kullanarak yerel olarak çalıştırmak için kurulumdan çıkarıma, sorun gidermeden Apidog gibi araçlarla entegrasyona kadar ihtiyacınız olan her şeyi adım adım inceleyeceğiz. Bu kapsamlı rehberin sonunda, yerel makinenizde sorunsuz çalışan, tam işlevsel, özel ve duyarlı bir görsel-dil Qwen3-VL'ye sahip olacak ve projelerinize entegre etmek için ihtiyacınız olan tüm bilgiyle donatılmış olacaksınız.

Öyleyse, kemerlerinizi bağlayın, en sevdiğiniz içeceğinizi alın ve bu heyecan verici yolculuğa birlikte çıkalım.

Qwen3-VL'yi Anlamak: Devrim Niteliğindeki Görsel-Dil Modeli

Neden Qwen 3 VL? Ve Neden Yerel Olarak Çalıştırmalı?

Teknik adımlara geçmeden önce, Qwen 3 VL'nin neden önemli olduğunu ve onu yerel olarak çalıştırmanın neden ezber bozan bir gelişme olduğunu konuşalım.

Qwen 3 VL, Alibaba'nın Qwen serisinin bir parçasıdır, ancak özellikle görsel-dil görevleri için tasarlanmıştır. Yalnızca metni anlayan geleneksel LLM'lerin aksine, Qwen 3 VL şunları yapabilir:

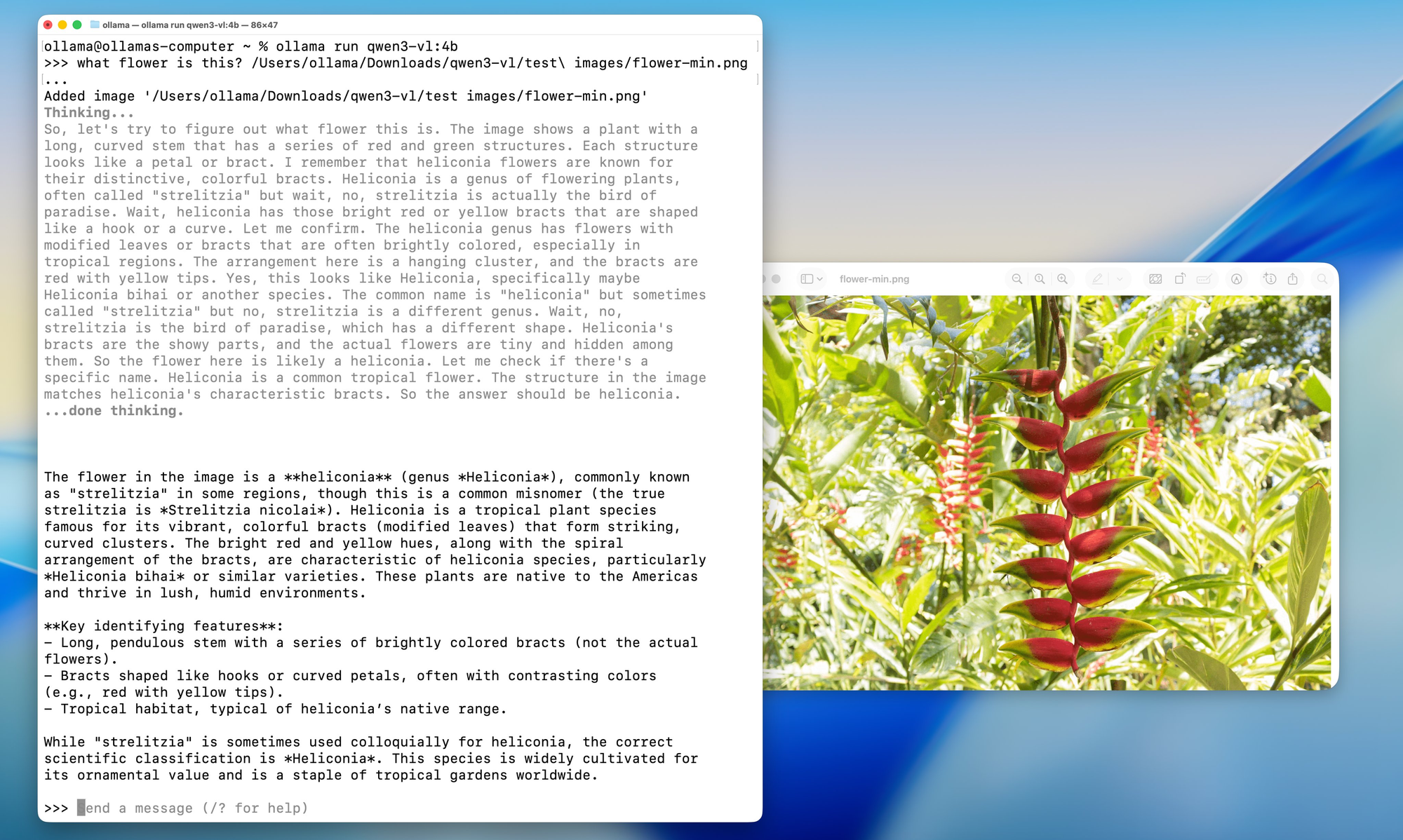

- Görüntüleri analiz edebilir ve onlar hakkında soruları yanıtlayabilir ("Bu fotoğrafta ne var?")

- Ayrıntılı başlıklar oluşturabilir

- Grafikler, diyagramlar veya belgelerden yapılandırılmış veri çıkarabilir

- Görsel bağlamla çok modlu RAG'yi (geri çağırmayla artırılmış üretim) destekleyebilir

Ve açık ağırlıklı olduğu (Tongyi Qianwen lisansı altında) için geliştiriciler, lisans koşullarına uydukları sürece onu özgürce kullanabilir, değiştirebilir ve dağıtabilirler.

Peki, neden yerel olarak çalıştırmalı?

- Gizlilik: Görüntüleriniz ve istemleriniz asla makinenizden ayrılmaz.

- Maliyet: API ücreti veya kullanım limiti yok.

- Özelleştirme: Kendi işlem hatlarınızla ince ayar yapın, nicemleyin veya entegre edin.

- Çevrimdışı erişim: Güvenli veya hava boşluklu ortamlar için mükemmel.

Ancak yerel dağıtım, CUDA sürümleri, Python ortamları ve devasa Dockerfile'lar ile uğraşmak anlamına geliyordu. Karşınızda Ollama.

Model Varyantları: Her Kullanım Durumu İçin Bir Şeyler

Qwen3-VL, farklı donanım yapılandırmalarına ve kullanım durumlarına uyacak çeşitli boyutlarda gelir. İster hafif bir dizüstü bilgisayarda çalışıyor olun, ister güçlü bir iş istasyonuna erişiminiz olsun, ihtiyaçlarınıza mükemmel uyan bir Qwen3-VL modeli mutlaka vardır.

Yoğun Modeller (Geleneksel Mimari):

- Qwen3-VL-2B: Uç cihazlar ve mobil uygulamalar için mükemmel

- Qwen3-VL-4B: Performans ve kaynak kullanımı arasında harika bir denge

- Qwen3-VL-8B: Orta düzeyde akıl yürütme gerektiren genel amaçlı görevler için mükemmel

- Qwen3-VL-32B: Güçlü akıl yürütme ve kapsamlı bağlam gerektiren üst düzey görevler

Uzman Karışımı (MoE) Modelleri (Verimli Mimari):

- Qwen3-VL-30B-A3B: Yalnızca 3 milyar aktif parametre ile verimli performans

- Qwen3-VL-235B-A22B: Toplam 235 milyar parametreye sahip ancak yalnızca 22 milyarı aktif olan büyük ölçekli uygulamalar

MoE modellerinin güzelliği, her çıkarım için yalnızca bir alt küme "uzman" sinir ağını etkinleştirmeleri, böylece hesaplama maliyetlerini yönetilebilir tutarken büyük parametre sayılarına izin vermeleridir.

Ollama: Yerel Yapay Zeka Mükemmelliğine Açılan Kapınız

Qwen3-VL'nin ne sunduğunu anladığımıza göre, bu modelleri yerel olarak çalıştırmak için Ollama'nın neden ideal bir platform olduğunu konuşalım. Ollama'yı bir orkestra şefi gibi düşünün; sahne arkasında gerçekleşen tüm karmaşık süreçleri düzenler, böylece siz en önemli şeye odaklanabilirsiniz: yapay zeka modellerinizi kullanmaya.

Ollama Nedir ve Neden Qwen 3 VL İçin Mükemmeldir?

Ollama, büyük dil modellerini (ve şimdi çok modlu modelleri) tek bir komutla yerel olarak çalıştırmanıza olanak tanıyan açık kaynaklı bir araçtır. Onu "LLM'ler için Docker" gibi düşünebilirsiniz, ancak daha da basittir.

Temel özellikler:

- Otomatik GPU hızlandırması (macOS'ta Metal, Linux'ta CUDA aracılığıyla)

- Dahili model kütüphanesi (Llama 3, Mistral, Gemma ve şimdi Qwen dahil)

- Kolay entegrasyon için REST API

- Hafif ve başlangıç dostu

En iyisi de, Ollama artık Qwen 3 VL modellerini destekliyor, buna qwen3-vl:4b ve qwen3-vl:8b gibi varyantlar da dahil. Bunlar, yerel donanım için optimize edilmiş nicemlenmiş (quantized) sürümlerdir, yani onları tüketici sınıfı GPU'larda veya hatta güçlü dizüstü bilgisayarlarda çalıştırabilirsiniz.

Ollama'nın Arkasındaki Teknik Sihir

Bir Ollama komutu çalıştırdığınızda sahne arkasında ne olur? Bu, teknolojik süreçlerin iyi koreografisi yapılmış bir dansını izlemek gibidir:

1.Model İndirme ve Önbellekleme: Ollama, model ağırlıklarını akıllıca indirir ve önbelleğe alır, sık kullanılan modeller için hızlı başlangıç süreleri sağlar.

2.Nicemleme Optimizasyonu: Modeller, donanım yapılandırmanıza göre otomatik olarak optimize edilir ve GPU'nuz ile RAM'iniz için en iyi nicemleme yöntemini (4-bit, 8-bit vb.) seçer.

3.Bellek Yönetimi: Gelişmiş bellek eşleme teknikleri, yüksek performansı korurken verimli GPU bellek kullanımını sağlar.

4.Paralel İşleme: Ollama, maksimum verim için birden fazla CPU çekirdeği ve GPU akışından yararlanır.

Önkoşullar: Kurulumdan Önce İhtiyacınız Olacaklar

Herhangi bir şey kurmadan önce sisteminizin hazır olduğundan emin olalım.

Donanım Gereksinimleri

- RAM: En az 16 GB (8B modeller için 32 GB önerilir)

- GPU: 8 GB+ VRAM'li NVIDIA GPU (Linux için) veya Apple Silicon Mac (16 GB+ birleşik belleğe sahip M1/M2/M3)

- Depolama: 10–20 GB boş alan (modeller büyük!)

Yazılım Gereksinimleri

- İşletim Sistemi: macOS (12+) veya Linux (Ubuntu 20.04+ önerilir)

- Ollama: En son sürüm (Qwen 3 VL desteği için v0.1.40+)

- İsteğe Bağlı: Docker (kapsayıcılı dağıtımı tercih ediyorsanız), Python (gelişmiş betikleme için)

Adım Adım Kurulum Rehberi: Yerel Yapay Zeka Ustalığına Giden Yolunuz

Adım 1: Ollama'yı Kurma - Temel

Tüm kurulumumuzun temeliyle başlayalım. Ollama'yı kurmak şaşırtıcı derecede basittir; yapay zeka acemilerinden deneyimli geliştiricilere kadar herkesin erişebileceği şekilde tasarlanmıştır.

macOS Kullanıcıları İçin:

1.ollama.com/download adresini ziyaret edin

2.macOS yükleyicisini indirin

3.İndirilen dosyayı açın ve Ollama'yı Uygulamalar klasörünüze sürükleyin

4.Ollama'yı Uygulamalar klasörünüzden veya Spotlight aramasından başlatın

Kurulum süreci macOS'ta inanılmaz derecede sorunsuzdur ve kurulum tamamlandığında Ollama simgesini menü çubuğunuzda göreceksiniz.

Windows Kullanıcıları İçin:

1.ollama.com/download adresine gidin

2.Windows yükleyicisini (.exe dosyası) indirin

3.Yükleyiciyi yönetici ayrıcalıklarıyla çalıştırın

4.Kurulum sihirbazını takip edin (oldukça sezgiseldir)

5.Kurulduktan sonra Ollama otomatik olarak arka planda başlayacaktır

Windows kullanıcıları bir Windows Defender bildirimi görebilirler; endişelenmeyin, bu ilk çalıştırma için normaldir. Sadece "İzin Ver"e tıklayın ve Ollama mükemmel çalışacaktır.

Linux Kullanıcıları İçin:

Linux kullanıcılarının iki seçeneği vardır:

Seçenek A: Kurulum Betiği (Önerilen)

bash

curl -fsSL <https://ollama.com/install.sh> | sh

Seçenek B: Manuel Kurulum

bash

# Download the latest Ollama binarycurl -o ollama <https://ollama.com/download/ollama-linux-amd64>

# Make it executablechmod +x ollama

# Move to PATHsudo mv ollama /usr/local/bin/

Adım 2: Kurulumunuzu Doğrulama

Ollama yüklendiğine göre, her şeyin doğru çalıştığından emin olalım. Bunu, temelimizi sağlamlaştırmak için bir duman testi olarak düşünün.

Terminalinizi (veya Windows'ta komut istemcisini) açın ve şunu çalıştırın:

bash

ollama --version

Şuna benzer bir çıktı görmelisiniz:

ollama version is 0.1.0

Ardından, temel işlevselliği test edelim:

bash

ollama serve

Bu komut Ollama sunucusunu başlatır. Sunucunun http://localhost:11434 adresinde çalıştığını gösteren bir çıktı görmelisiniz. Sunucunun çalışmasına izin verin; Qwen3-VL kurulumumuzu test etmek için onu kullanacağız.

Adım 3: Qwen3-VL Modellerini Çekme ve Çalıştırma

Şimdi heyecan verici kısım! İlk Qwen3-VL modelimizi indirip çalıştıralım. Suları test etmek için daha küçük bir modelle başlayacak, ardından daha güçlü varyantlara geçeceğiz.

Qwen3-VL-4B ile Test Etme (Harika Bir Başlangıç Noktası):

bash

ollama run qwen3-vl:4b

Bu komut şunları yapacak:

1.Qwen3-VL-4B modelini indirin (yaklaşık 2.8GB)

2.Donanımınız için optimize edin

3.Etkileşimli bir sohbet oturumu başlatın

Diğer Model Varyantlarını Çalıştırma:

Daha güçlü bir donanımınız varsa, şu alternatifleri deneyin:

bash

# For 8GB+ GPU systemsollama run qwen3-vl:8b

# For 16GB+ RAM systemsollama run qwen3-vl:32b

# For high-end systems with multiple GPUsollama run qwen3-vl:30b-a3b

# For maximum performance (requires serious hardware)ollama run qwen3-vl:235b-a22b

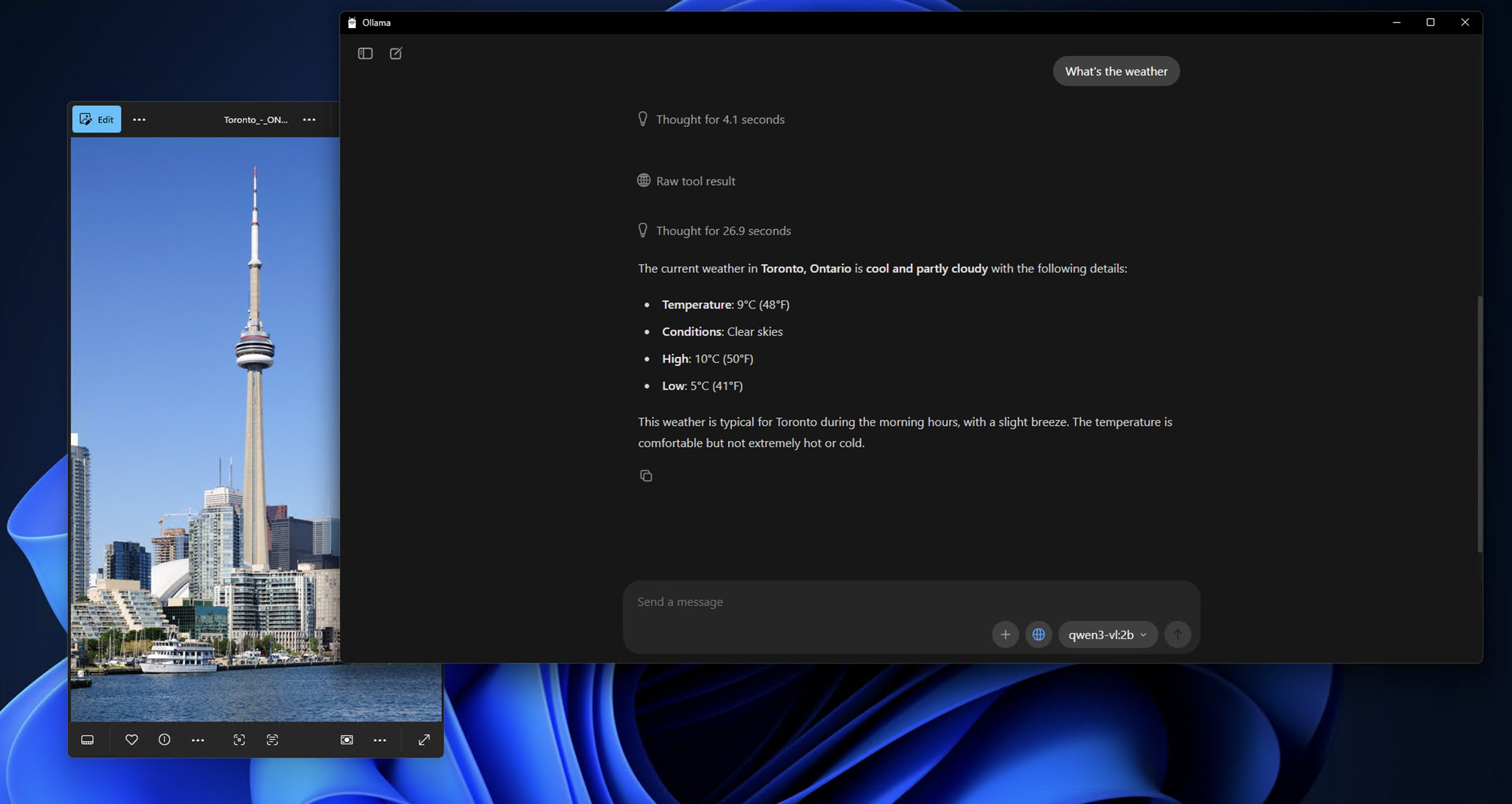

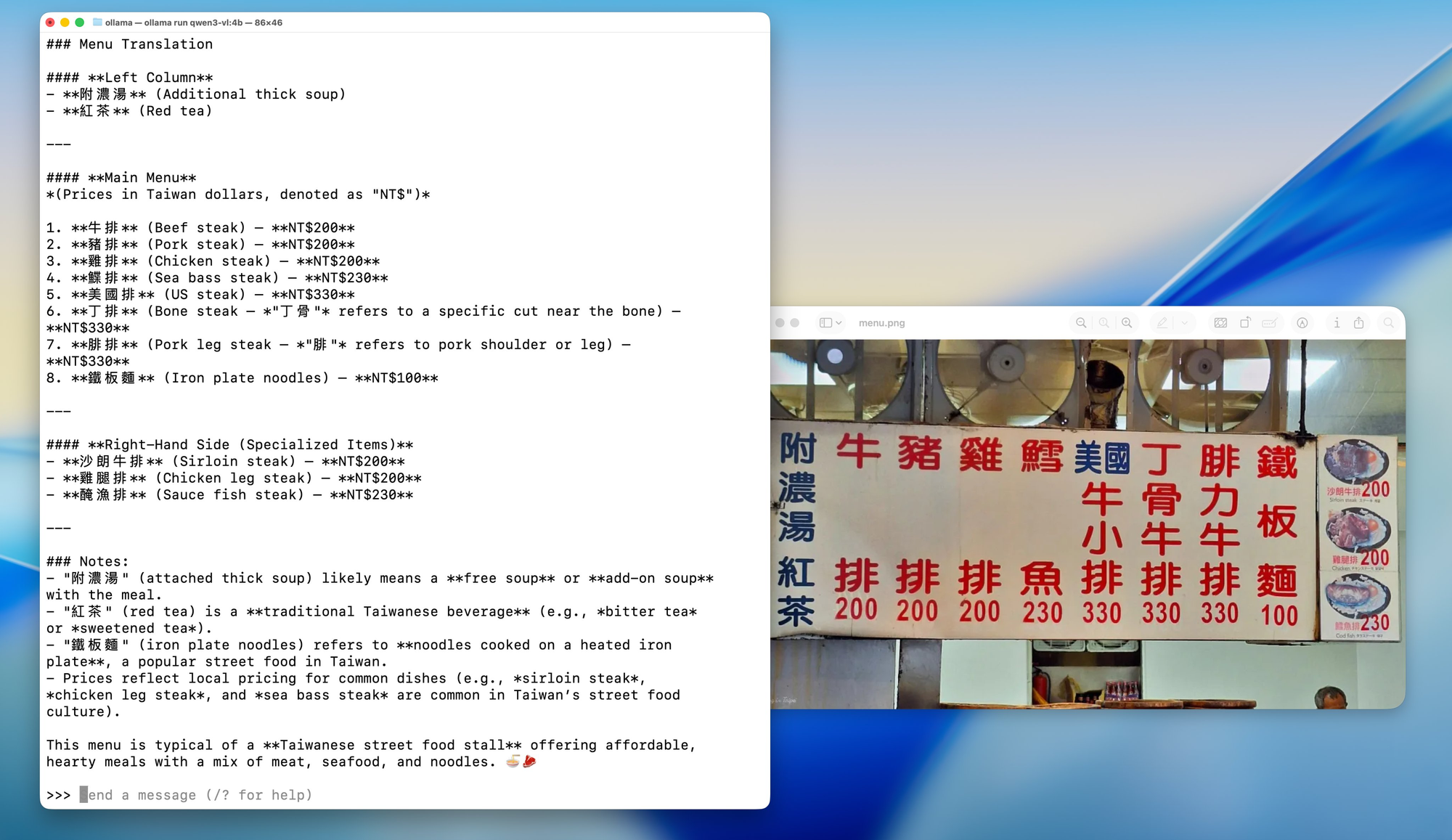

Adım 4: Yerel Qwen3-VL'nizle İlk Etkileşim

Model indirildikten ve çalışmaya başladıktan sonra, şuna benzer bir istem göreceksiniz:

Send a message (type /? for help)

Modelin yeteneklerini basit bir görüntü analiziyle test edelim:

Bir Test Görüntüsü Hazırlayın:

Bilgisayarınızda herhangi bir görüntü bulun; bu bir fotoğraf, ekran görüntüsü veya illüstrasyon olabilir. Bu örnek için, mevcut dizininizde test_image.jpg adlı bir görüntünüz olduğunu varsayacağım.

Etkileşimli Sohbet Testi:

bash

What do you see in this image? /path/to/your/image.jpg

Alternatif: Test İçin API Kullanımı

Programatik olarak test etmeyi tercih ediyorsanız, Ollama API'sini kullanabilirsiniz. İşte curl kullanarak basit bir test:

bash

curl <http://localhost:11434/api/generate> \\

-H "Content-Type: application/json" \\

-d '{

"model": "qwen3-vl:4b",

"prompt": "What is in this image? Describe it in detail.",

"images": ["base64_encoded_image_data_here"]

}'

Adım 5: Gelişmiş Yapılandırma Seçenekleri

Artık çalışan bir kurulumunuz olduğuna göre, kurulumunuzu belirli donanımınız ve kullanım durumunuz için optimize etmek amacıyla bazı gelişmiş yapılandırma seçeneklerini keşfedelim.

Bellek Optimizasyonu:

Bellek sorunları yaşıyorsanız, model yükleme davranışını ayarlayabilirsiniz:

bash

# Set maximum memory usage (adjust based on your RAM)export OLLAMA_MAX_LOADED_MODELS=1

# Enable GPU offloadingexport OLLAMA_GPU=1

# Set custom port (if 11434 is already in use)export OLLAMA_HOST=0.0.0.0:11435

Nicemleme Seçenekleri:

Sınırlı VRAM'e sahip sistemler için belirli nicemleme seviyelerini zorlayabilirsiniz:

bash

# Load model with 4-bit quantization (more compatible, slower)ollama run qwen3-vl:4b --format json

# Load with 8-bit quantization (balanced)ollama run qwen3-vl:8b --format json

Çoklu GPU Yapılandırması:

Birden fazla GPU'nuz varsa, hangilerini kullanacağınızı belirtebilirsiniz:

bash

# Use specific GPU IDs (Linux/macOS)export CUDA_VISIBLE_DEVICES=0,1

ollama run qwen3-vl:30b-a3b

# On macOS with multiple Apple Silicon GPUsexport CUDA_VISIBLE_DEVICES=0,1

ollama run qwen3-vl:30b-a3b

Apidog ile Test ve Entegrasyon: Kalite ve Performansı Sağlama

Qwen3-VL'yi yerel olarak çalıştırdığınıza göre, onu geliştirme iş akışınıza doğru bir şekilde nasıl test edip entegre edeceğimizden bahsedelim. İşte Apidog'un yapay zeka geliştiricileri için vazgeçilmez bir araç olarak gerçekten parladığı yer burasıdır.

Apidog sadece başka bir API test aracı değil; modern API geliştirme iş akışları için özel olarak tasarlanmış kapsamlı bir platformdur. Qwen3-VL gibi yerel yapay zeka modelleriyle çalışırken, şunları yapabilen bir araca ihtiyacınız vardır:

1.Karmaşık JSON Yapılarını Yönetme: Yapay zeka modeli yanıtları genellikle farklı içerik türlerine sahip iç içe JSON içerir

2.Dosya Yüklemelerini Destekleme: Birçok yapay zeka modeli görüntü, video veya belge girdilerine ihtiyaç duyar

3.Kimlik Doğrulamayı Yönetme: Uygun kimlik doğrulama yönetimi ile uç noktaların güvenli testi

4.Otomatik Testler Oluşturma: Model performans tutarlılığı için regresyon testi

5.Dokümantasyon Oluşturma: Test durumlarınızdan otomatik olarak API dokümantasyonu oluşturma

Sık Karşılaşılan Sorunları Giderme

Ollama'nın basitliğine rağmen, sorunlarla karşılaşabilirsiniz. İşte sık karşılaşılan sorunlar için çözümler.

❌ "Model bulunamadı" veya "Desteklenmeyen model"

- Ollama v0.1.40 veya daha yeni bir sürümünü kullandığınızdan emin olun

ollama pull qwen3-vl:4bkomutunu tekrar çalıştırın; bazen indirme sessizce başarısız olabilir

❌ GPU'da "Bellek yetersiz"

- 8B yerine 4B sürümünü deneyin

- Diğer GPU yoğun uygulamaları (Chrome, oyunlar vb.) kapatın

- Linux'ta,

nvidia-smiile VRAM'i kontrol edin

❌ Görüntü tanınmadı

- Görüntünün 4MB'tan küçük olduğunu onaylayın

- PNG veya JPG kullanın (HEIC, BMP'den kaçının)

- Base64 dizisinin yeni satır içermediğinden emin olun (Linux'ta

base64 -w 0kullanın)

❌ CPU'da yavaş çıkarım

- Qwen 3 VL nicemlenmiş olsa bile büyüktür. CPU'da 1–5 jeton/sn bekleyin

- 10 kat hızlandırma için Apple Silicon veya NVIDIA GPU'ya yükseltin

Yerel Qwen 3 VL İçin Gerçek Dünya Kullanım Durumları

Neden tüm bu zahmete katlanalım? İşte pratik uygulamalar:

- Belge Zekası: Taranmış PDF'lerden tabloları, imzaları veya maddeleri çıkarın

- Erişilebilirlik Araçları: Görme engelli kullanıcılar için görüntüleri açıklayın

- Dahili Bilgi Botları: Dahili diyagramlar veya gösterge tabloları hakkında soruları yanıtlayın

- Eğitim: Fotoğraflardan matematik problemlerini açıklayan bir özel ders öğretmeni oluşturun

- Güvenlik Analizi: Ağ diyagramlarını veya sistem mimarisi ekran görüntülerini analiz edin

Yerel olduğu için, hassas görselleri üçüncü taraf API'lere göndermekten kaçınırsınız; bu, işletmeler ve gizliliğe önem veren geliştiriciler için büyük bir kazançtır.

Sonuç: Yerel Yapay Zeka Mükemmelliğine Yolculuğunuz

Tebrikler! Qwen3-VL ve Ollama ile yerel yapay zeka dünyasına destansı bir yolculuğu az önce tamamladınız. Artık şunlara sahip olmalısınız:

- Yerel olarak çalışan, tam işlevsel bir Qwen3-VL kurulumu

- Apidog ile kapsamlı test kurulumu

- Modelin yetenekleri ve sınırlamaları hakkında derinlemesine anlayış

- Bu modelleri gerçek dünya uygulamalarına entegre etmek için pratik bilgi

- Sık karşılaşılan sorunları çözmek için sorun giderme becerileri

- Sürekli başarı için geleceğe yönelik stratejiler

Buraya kadar gelmiş olmanız, en son yapay zeka teknolojisini anlama ve kullanma konusundaki kararlılığınızı gösteriyor. Sadece bir model kurmakla kalmadınız; görsel ve metinsel bilgilerle etkileşim şeklimizi yeniden şekillendiren bir teknolojide uzmanlık kazandınız.

Gelecek Yerel Yapay Zeka'dır

Burada başardığımız şey sadece teknik bir kurulumdan daha fazlasını temsil ediyor; yapay zekanın erişilebilir, özel ve bireysel kontrol altında olduğu bir geleceğe doğru bir adımdır. Bu modeller gelişmeye ve daha verimli hale gelmeye devam ettikçe, bütçeleri veya teknik uzmanlıkları ne olursa olsun herkese gelişmiş yapay zeka yeteneklerinin sunulduğu bir dünyaya doğru ilerliyoruz.

Unutmayın, yolculuk burada bitmiyor. Yapay zeka teknolojisi hızla gelişiyor ve meraklı, uyumlu ve toplulukla etkileşimde kalmak, bu güçlü araçları etkili bir şekilde kullanmaya devam etmenizi sağlayacaktır.

Son Düşünceler

Qwen 3 VL'yi Ollama ile yerel olarak çalıştırmak sadece bir teknoloji demosu veya kolaylık ya da maliyet tasarrufu meselesi değil; cihaz içi yapay zekanın geleceğine bir bakıştır. Modeller daha verimli hale geldikçe ve donanım daha güçlü hale geldikçe, daha fazla geliştiricinin uygulamalarında doğrudan özel, çok modlu özellikler sunduğunu göreceğiz. Artık yapay zeka teknolojisini sınırlama olmaksızın keşfetme, özgürce deney yapma ve sizin ve kuruluşunuz için önemli olan uygulamaları oluşturma araçlarına sahipsiniz.

Qwen3-VL'nin etkileyici çok modlu yetenekleri ile Ollama'nın kullanıcı dostu arayüzünün birleşimi, daha önce yalnızca devasa kaynaklara sahip büyük şirketlerin erişebildiği inovasyon fırsatları yaratıyor. Artık yapay zeka teknolojisini demokratikleştiren büyüyen bir geliştirici topluluğunun parçasısınız.

Ve Ollama gibi araçlarla dağıtım basitleşirken ve Apidog API geliştirmeyi kolaylaştırırken, giriş engeli hiç bu kadar düşük olmamıştı.

Yani ister yalnız bir hacker, ister bir startup kurucusu, ister kurumsal bir mühendis olun, görsel-dil modellerini güvenli, uygun fiyatlı ve yerel olarak denemek için şimdi tam zamanı.