```html

Yapay Zeka (YZ) dünyası, ChatGPT, Claude ve Gemini gibi Büyük Dil Modelleri (BDM'ler) ile dünya çapında hayal gücünü yakalayarak baş döndürücü bir hızla gelişiyor. Bu güçlü araçlar kod yazabilir, e-postalar tasarlayabilir, karmaşık soruları yanıtlayabilir ve hatta yaratıcı içerik üretebilir. Ancak, bu bulut tabanlı hizmetleri kullanmak genellikle veri gizliliği, potansiyel maliyetler ve sürekli bir internet bağlantısı ihtiyacı konusunda endişelerle birlikte gelir.

Ollama'ya girin.

Ollama, büyük dil modellerine erişimi demokratikleştirmek için tasarlanmış, kendi bilgisayarınızda doğrudan indirmenize, çalıştırmanıza ve yönetmenize olanak tanıyan güçlü, açık kaynaklı bir araçtır. Genellikle karmaşık olan, son teknoloji YZ modelleriyle yerel olarak kurulum ve etkileşim sürecini basitleştirir.

Neden Ollama Kullanmalısınız?

Ollama ile BDM'leri yerel olarak çalıştırmak, çeşitli ilgi çekici avantajlar sunar:

- Gizlilik: İstekleriniz ve modelin yanıtları makinenizde kalır. Harici sunuculara, bunu açıkça yapılandırmadığınız sürece hiçbir veri gönderilmez. Bu, hassas bilgiler veya tescilli çalışmalar için çok önemlidir.

- Çevrimdışı Erişim: Bir model indirildikten sonra, internet bağlantısı olmadan kullanabilirsiniz, bu da onu seyahat, uzak konumlar veya güvenilmez bağlantıların olduğu durumlar için mükemmel kılar.

- Özelleştirme: Ollama, 'Modelfiles' kullanarak modelleri kolayca değiştirmenize olanak tanır ve davranışlarını, sistem istemlerini ve parametrelerini özel ihtiyaçlarınıza göre uyarlamanıza olanak tanır.

- Uygun Maliyetli: Abonelik ücreti veya belirteç başına ücret yoktur. Tek maliyet, zaten sahip olduğunuz donanım ve onu çalıştırmak için gereken elektriktir.

- Keşif ve Öğrenme: Farklı açık kaynaklı modelleri denemek, yeteneklerini ve sınırlamalarını anlamak ve BDM'lerin nasıl çalıştığı hakkında daha fazla bilgi edinmek için harika bir platform sağlar.

Bu makale, bir komut satırı arayüzünü (macOS/Linux'ta Terminal veya Windows'ta Komut İstemi/PowerShell gibi) kullanmaya alışkın ve Ollama ile yerel BDM'ler dünyasını keşfetmeye başlamak isteyen yeni başlayanlar için tasarlanmıştır. Temel bilgileri anlama, Ollama'yı yükleme, ilk modelinizi çalıştırma, onunla etkileşim kurma ve temel özelleştirmeyi keşfetme konusunda size rehberlik edeceğiz.

Geliştirici Ekibinizin maksimum verimlilikle birlikte çalışması için entegre, Hepsi Bir Arada bir platform mu istiyorsunuz?

Apidog tüm taleplerinizi karşılıyor ve Postman'in yerini çok daha uygun bir fiyata alıyor!

Ollama Nasıl Çalışır?

Kuruluma dalmadan önce, birkaç temel kavramı açıklığa kavuşturalım.

Büyük Dil Modelleri (BDM'ler) Nelerdir?

Bir BDM'yi, internetten alınan çok büyük miktarda metin ve kod üzerinde eğitilmiş, inanılmaz derecede gelişmiş bir otomatik tamamlama sistemi olarak düşünün. Bu verilerdeki kalıpları analiz ederek, dilbilgisi, gerçekler, muhakeme yetenekleri ve farklı yazma stillerini öğrenir. Ona bir istem (girdi metni) verdiğinizde, ardından gelmesi en olası kelime dizisini tahmin eder, tutarlı ve genellikle anlayışlı bir yanıt üretir. Farklı BDM'ler, farklı veri kümeleri, boyutlar ve mimarilerle eğitilir ve bu da güçlü yönlerinde, zayıflıklarında ve kişiliklerinde farklılıklara yol açar.

Ollama Nasıl Çalışır?

Ollama, yerel makinenizdeki bu BDM'ler için bir yönetici ve çalıştırıcı görevi görür. Temel işlevleri şunları içerir:

- Model İndirme: Önceden paketlenmiş BDM ağırlıklarını ve yapılandırmalarını merkezi bir kitaplıktan getirir (Docker'ın kapsayıcı görüntüleri çekmesine benzer).

- Model Yürütme: Seçilen modeli bilgisayarınızın belleğine (RAM) yükler ve hızlandırma için potansiyel olarak grafik kartınızı (GPU) kullanır.

- Arayüzler Sağlama: Doğrudan etkileşim için basit bir komut satırı arayüzü (CLI) sunar ve ayrıca, diğer uygulamaların çalışan BDM ile iletişim kurması için bir API (Uygulama Programlama Arayüzü) sağlayan yerel bir web sunucusu çalıştırır.

Ollama için Donanım Gereksinimleri: Bilgisayarım Çalıştırabilir mi?

BDM'leri yerel olarak çalıştırmak, öncelikle bilgisayarınızın RAM'ine (Rastgele Erişim Belleği) talepkar olabilir. Çalıştırmak istediğiniz modelin boyutu, gereken minimum RAM'i belirler.

- Küçük Modeller (örneğin, ~3 Milyar parametre gibi Phi-3 Mini): 8 GB RAM ile makul derecede iyi çalışabilir, ancak daha fazlası her zaman daha sorunsuz performans için daha iyidir.

- Orta Boyutlu Modeller (örneğin, Llama 3 8B, Mistral 7B gibi 7-8 Milyar parametre): Genellikle en az 16 GB RAM gerektirir. Bu, birçok kullanıcı için ortak bir tatlı noktadır.

- Büyük Modeller (örneğin, 13B+ parametre): Genellikle 32 GB RAM veya daha fazlasını gerektirir. Çok büyük modeller (70B+) 64 GB, hatta 128 GB gerektirebilir.

Dikkate almanız gerekebilecek diğer Faktörler:

- CPU (Merkezi İşlem Birimi): Önemli olmakla birlikte, çoğu modern CPU yeterlidir. Daha hızlı CPU'lar yardımcı olur, ancak RAM genellikle darboğazdır.

- GPU (Grafik İşlem Birimi): Güçlü, uyumlu bir GPU'ya (özellikle Linux/Windows'ta NVIDIA GPU'ları veya macOS'ta Apple Silicon GPU'ları) sahip olmak, model performansını önemli ölçüde hızlandırabilir. Ollama, gerekli sürücüler yüklüyse uyumlu GPU'ları otomatik olarak algılar ve kullanır. Ancak, özel bir GPU kesinlikle gerekli değildir; Ollama, modelleri yalnızca CPU üzerinde çalıştırabilir, ancak daha yavaş çalışır.

- Disk Alanı: İndirilen modelleri depolamak için yeterli disk alanına ihtiyacınız olacaktır; bu, indirdiğiniz modellerin boyutuna ve sayısına bağlı olarak birkaç gigabayttan onlarca, hatta yüzlerce gigabayta kadar değişebilir.

Yeni Başlayanlar İçin Öneri: Daha küçük modellerle (phi3, mistral veya llama3:8b gibi) başlayın ve rahat bir ilk deneyim için en az 16 GB RAM'e sahip olduğunuzdan emin olun. Her model için özel RAM önerileri için Ollama web sitesini veya model kitaplığını kontrol edin.

Mac, Linux ve Windows'ta (WSL Kullanarak) Ollama Nasıl Yüklenir

Ollama, macOS, Linux ve Windows'u destekler (şu anda önizlemede, genellikle WSL gerektirir).

Adım 1: Önkoşullar

- İşletim Sistemi: Desteklenen bir macOS, Linux veya Windows sürümü (WSL2 önerilir).

- Komut Satırı: Terminal'e (macOS/Linux) veya Komut İstemi/PowerShell/WSL terminaline (Windows) erişim.

Adım 2: Ollama'yı İndirme ve Yükleme

İşlem, işletim sisteminize bağlı olarak biraz farklılık gösterir:

- macOS:

- Resmi Ollama web sitesine gidin: https://ollama.com

- "İndir" düğmesine tıklayın, ardından "macOS için İndir"i seçin.

.dmgdosyası indirildikten sonra, açın.Ollamauygulama simgesiniUygulamalarklasörünüze sürükleyin.- İlk çalıştırdığınızda izin vermeniz gerekebilir.

- Linux:

En hızlı yol genellikle resmi yükleme komut dosyası aracılığıyladır. Terminalinizi açın ve şunu çalıştırın:

curl -fsSL <https://ollama.com/install.sh> | sh

Bu komut, komut dosyasını indirir ve çalıştırır, Ollama'yı kullanıcınız için yükler. Ayrıca, uygulanabilirse GPU desteğini algılamaya ve yapılandırmaya çalışacaktır (NVIDIA sürücüleri gereklidir).

Komut dosyası tarafından görüntülenen tüm istemleri izleyin. Tercih ederseniz, Ollama GitHub deposunda manuel yükleme talimatları da mevcuttur.

- Windows (Önizleme):

- Resmi Ollama web sitesine gidin: https://ollama.com

- "İndir" düğmesine tıklayın, ardından "Windows için İndir (Önizleme)"yi seçin.

- İndirilen yükleyici yürütülebilir dosyasını (

.exe) çalıştırın. - Yükleme sihirbazı adımlarını izleyin.

- Önemli Not: Windows'ta Ollama, Windows için Linux Alt Sistemi'ne (WSL2) büyük ölçüde dayanır. Yükleyici, henüz kurulmamışsa WSL2'yi yüklemenizi veya yapılandırmanızı isteyebilir. GPU hızlandırması genellikle, WSL ortamında yüklü belirli WSL yapılandırmaları ve NVIDIA sürücüleri gerektirir. Ollama'yı bir WSL terminalinde kullanmak daha doğal hissettirebilir.

Adım 3: Yüklemeyi Doğrulama

Yüklendikten sonra, Ollama'nın doğru çalıştığını doğrulamanız gerekir.

Terminalinizi veya komut isteminizi açın. (Windows'ta, bir WSL terminali kullanılması genellikle önerilir).

Aşağıdaki komutu yazın ve Enter tuşuna basın:

ollama --version

Yükleme başarılı olduysa, yüklenen Ollama sürüm numarasını görüntüleyen bir çıktı görmelisiniz, örneğin:

ollama version is 0.1.XX

Bunu görürseniz, Ollama yüklendi ve kullanıma hazır! "komut bulunamadı" gibi bir hatayla karşılaşırsanız, yükleme adımlarını iki kez kontrol edin, Ollama'nın sisteminizin PATH'ine eklendiğinden emin olun (yükleyici genellikle bunu halleder) veya terminalinizi veya bilgisayarınızı yeniden başlatmayı deneyin.

Başlarken: İlk Modelinizi Ollama ile Çalıştırma

Ollama yüklendikten sonra, bir BDM indirebilir ve onunla etkileşim kurabilirsiniz.

Kavram: Ollama Model Kayıt Defteri

Ollama, hazır bulunan açık kaynaklı modellerden oluşan bir kitaplık tutar. Ollama'dan yerel olarak sahip olmadığı bir modeli çalıştırmasını istediğinizde, bunu bu kayıt defterinden otomatik olarak indirir. Bunu, BDM'ler için docker pull gibi düşünün. Ollama web sitesinin kitaplık bölümünde mevcut modellere göz atabilirsiniz.

Bir Model Seçme

Yeni başlayanlar için, iyi dengelenmiş ve nispeten küçük bir modelle başlamak en iyisidir. İyi seçenekler şunlardır:

llama3:8b: Meta AI'nın en son nesil modeli (8 milyar parametre sürümü). Mükemmel çok yönlü performans sergileyen, talimatları takip etme ve kodlama konusunda iyi. ~16 GB RAM gerektirir.mistral: Mistral AI'nın popüler 7 milyar parametre modeli. Güçlü performansı ve verimliliği ile bilinir. ~16 GB RAM gerektirir.phi3: Microsoft'un son küçük dil modeli (SLM). Boyutuna göre çok yetenekli, daha az güçlü donanımlar için iyi.phi3:minisürümü 8 GB RAM'de çalışabilir.gemma:7b: Google'ın açık model serisi. 7B aralığında başka bir güçlü rakip.

Her modelin boyutu, RAM gereksinimleri ve tipik kullanım durumları hakkında ayrıntılar için Ollama kitaplığını kontrol edin.

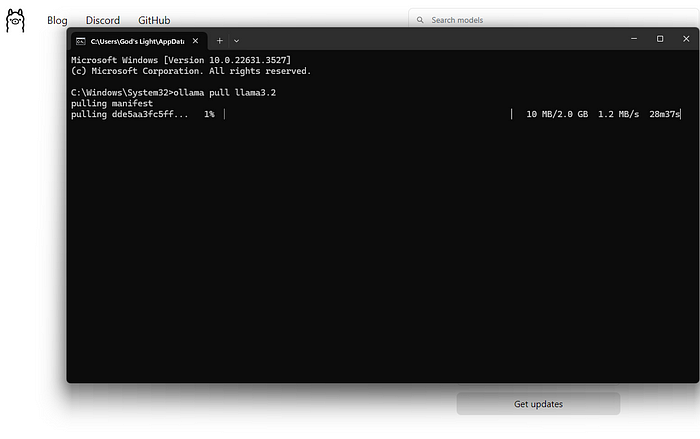

Bir Model İndirme ve Çalıştırma (Komut Satırı)

Kullanacağınız birincil komut ollama run'dır.

Terminalinizi açın.

Bir model adı seçin (örneğin, llama3:8b).

Komutu yazın:

ollama run llama3:8b

Enter tuşuna basın.

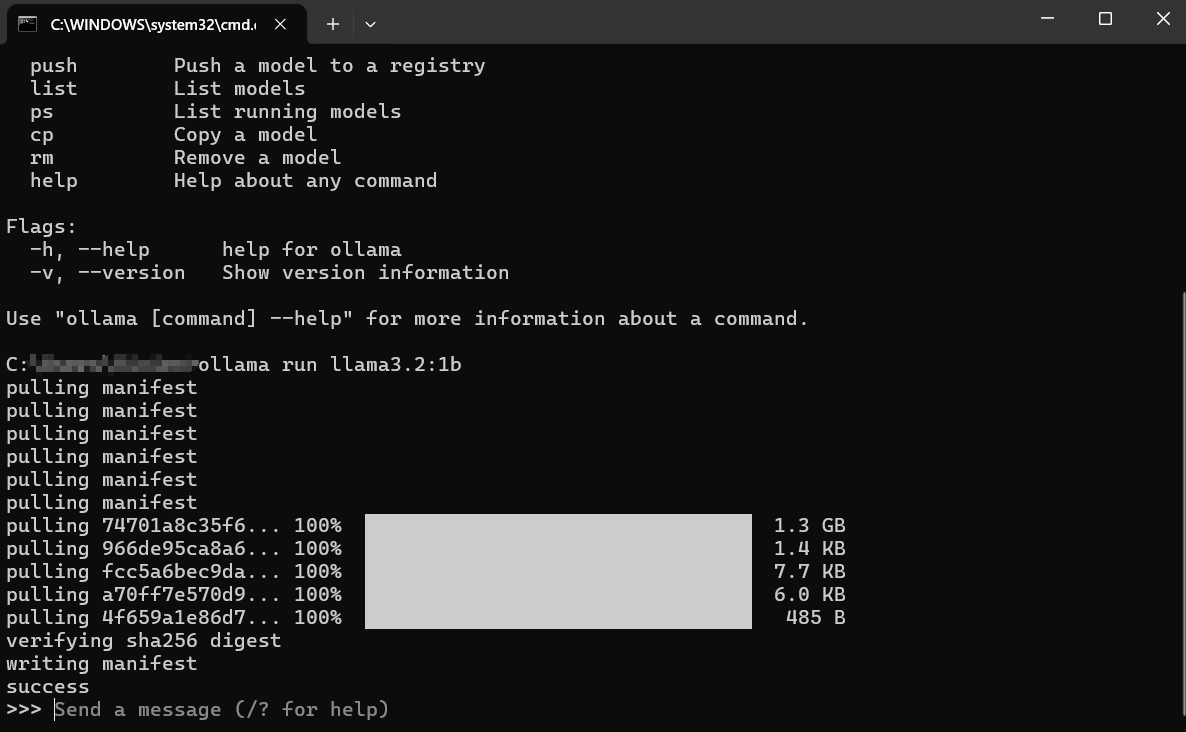

Sonra Ne Olur?

İndirme: llama3:8b yerel olarak yoksa, Ollama modeli indirirken ilerleme çubukları görüntüler. Bu, internet hızınıza ve model boyutuna (genellikle birkaç gigabayt) bağlı olarak biraz zaman alabilir.

Yükleme: İndirildikten sonra, Ollama modeli bilgisayarınızın RAM'ine (ve uygulanabilirse GPU belleğine) yükler. Donanım algılamayla ilgili mesajlar görebilirsiniz.

Etkileşimli Sohbet: Yükledikten sonra, şu şekilde bir istem göreceksiniz: Bu, modelin hazır olduğu anlamına gelir! Artık makinenizde çalışan BDM ile doğrudan etkileşimli bir sohbet oturumundasınız.

>>> Bir mesaj gönderin (yardım için /?)

Model ile Etkileşim Kurma:

>>>'den sonra sorunuzu veya talimatınızı ( "isteminiz") yazın ve Enter tuşuna basın.- Model, girdinizi işleyecek ve bir yanıt oluşturacak, bunu terminalinize geri aktaracaktır.

- Takip eden istemleri yazarak sohbete devam edebilirsiniz. Model, mevcut oturumun bağlamını korur.

Örnek Etkileşim:

> Bir mesaj gönderin (yardım için /?)

Fotosentez kavramını basit terimlerle açıklayın.

>

Fotosentez, bitkilerin kendi yiyeceklerini yapma şekli gibidir! Üç ana bileşen alırlar:

1. **Güneş Işığı:** Güneşten gelen enerji.

2. **Su:** Köklerinden emilir.

3. **Karbondioksit:** Yapraklarındaki küçük deliklerden havadan aldıkları bir gaz.

Güneş ışığının enerjisini kullanarak, bitkiler suyu ve karbondioksiti hücrelerindeki kloroplastlar adı verilen özel kısımların içinde birleştirir. Bu işlem iki şey yaratır:

1. **Şeker (Glikoz):** Bu, bitkinin yiyeceğidir ve ona büyümesi için enerji verir.

2. **Oksijen:** Bitkinin havaya geri bıraktığı ve hayvanların (bizim gibi!) nefes alması gereken bir gaz.

Kısacası: Bitkiler, kendi yiyeceklerini yapmak ve ihtiyacımız olan oksijeni salmak için güneş ışığını, suyu ve havayı kullanır!

>

>

Oturumdan Çıkma:

Sohbetiniz bittiğinde, /bye yazın ve Enter tuşuna basın. Bu, modeli bellekten kaldıracak ve sizi normal terminal isteminize döndürecektir. Ayrıca genellikle Ctrl+D'yi de kullanabilirsiniz.

İndirilen Modelleri Listeleme

Yerel olarak indirdiğiniz modelleri görmek için, ollama list komutunu kullanın:

ollama list

Çıktı, model adlarını, benzersiz kimliklerini, boyutlarını ve en son ne zaman değiştirildiklerini gösterecektir:

NAME ID SIZE MODIFIED

llama3:8b 871998b83999 4.7 GB 5 days ago

mistral:latest 8ab431d3a87a 4.1 GB 2 weeks ago

Modelleri Kaldırma

Modeller disk alanı kaplar. Belirli bir modele artık ihtiyacınız yoksa, ollama rm komutunu ve ardından model adını kullanarak kaldırabilirsiniz:

ollama rm mistral:latest

Ollama, silmeyi onaylayacaktır. Bu yalnızca indirilen dosyaları kaldırır; daha sonra yeniden indirmek için her zaman ollama run mistral:latest komutunu tekrar çalıştırabilirsiniz.

Ollama'dan Daha İyi Sonuçlar Nasıl Elde Edilir

Modelleri çalıştırmak sadece başlangıçtır. İşte daha iyi sonuçlar elde etme yolu:

İstemleri Anlama (İstem Mühendisliğinin Temelleri)

Modelin çıktısının kalitesi, girdinizin (istem) kalitesine büyük ölçüde bağlıdır.

- Açık ve Belirli Olun: Modele tam olarak ne istediğinizi söyleyin. "Köpekler hakkında yaz" yerine, "Bir golden retriever'ın yakalamaca oynadığı kısa, neşeli bir şiir yazın" deneyin.

- Bağlam Sağlayın: Takip soruları soruyorsanız, gerekli arka plan bilgilerinin istemde veya sohbetin başlarında bulunduğundan emin olun.

- Biçimi Belirtin: Listeler, madde işaretleri, kod blokları, tablolar veya belirli bir ton (örneğin, "Beş yaşındaymışım gibi açıklayın", "Resmi bir tonla yazın") isteyin.

- Yineleyin: İlk denemede mükemmellik beklemeyin. Çıktı doğru değilse, isteminizi yeniden ifade edin, daha fazla ayrıntı ekleyin veya modelden önceki cevabını iyileştirmesini isteyin.

Farklı Modelleri Denemek

Farklı modeller, farklı görevlerde mükemmeldir.

Llama 3genellikle genel sohbet, talimatları takip etme ve kodlama için harikadır.Mistral, performans ve verimlilik dengesiyle bilinir.Phi-3, daha küçük boyutuna rağmen yaratıcı yazma ve özetleme için şaşırtıcı derecede yeteneklidir.- Kodlama için özel olarak ince ayarlanmış modeller (

codellamaveyastarcodergibi) programlama görevlerinde daha iyi performans gösterebilir.

Deneyin! Belirli bir görev için hangi modelin ihtiyaçlarınıza en uygun olduğunu görmek için ollama run <model_name> kullanarak aynı istemi farklı modellerde çalıştırın.

Sistem İstemleri (Bağlamı Ayarlama)

Bir "sistem istemi" kullanarak, bir oturum için modelin genel davranışını veya kişiliğini yönlendirebilirsiniz. Bu, yapay zekaya sohbet başlamadan önce arka plan talimatları vermek gibidir. Daha derin özelleştirme Modelfiles'ı içerirken (kısaca sonra ele alınacaktır), bir modeli çalıştırırken doğrudan basit bir sistem mesajı ayarlayabilirsiniz:

# Bu özellik biraz farklılık gösterebilir; `ollama run --help` kontrol edin

# Ollama bunu doğrudan /set system kullanarak sohbete entegre edebilir

# Veya daha sağlam bir yol olan Modelfiles aracılığıyla.

# Kavramsal örnek (kesin sözdizimi için Ollama belgelerini kontrol edin):

# ollama run llama3:8b --system "Sürekli korsan konuşmasıyla yanıt veren yardımsever bir asistansınız."

Daha yaygın ve esnek bir yol, bunu bir Modelfile'da tanımlamaktır.

API Aracılığıyla Etkileşim (Hızlı Bir Bakış)

Ollama sadece komut satırı için değildir. Yerel bir web sunucusu (genellikle http://localhost:11434 adresinde) çalıştırır ve bir API sunar. Bu, diğer programların ve komut dosyalarının yerel BDM'lerinizle etkileşim kurmasını sağlar.

Bunu terminalinizde curl gibi bir araçla test edebilirsiniz:

curl <http://localhost:11434/api/generate> -d '{

"model": "llama3:8b",

"prompt": "Gökyüzü neden mavi?",

"stream": false

}'

Bu, llama3:8b modelinden "Gökyüzü neden mavi?" istemine yanıt vermesini isteyen Ollama API'sine bir istek gönderir. "stream": false ayarı, kelime kelime akış yerine tam yanıtı bekler.

Modelin cevabını içeren bir JSON yanıtı geri alacaksınız. Bu API, Ollama'yı metin düzenleyiciler, özel uygulamalar, komut dosyası iş akışları ve daha fazlasıyla entegre etmenin anahtarıdır. Tam API'yi keşfetmek bu yeni başlayanlar kılavuzunun ötesindedir, ancak var olduğunu bilmek birçok olasılığın kapısını açar.

Ollama Modelfiles'ı Nasıl Özelleştirilir

Ollama'nın en güçlü özelliklerinden biri, Modelfiles kullanarak modelleri özelleştirme yeteneğidir. Bir Modelfile, mevcut bir modelin yeni, özelleştirilmiş bir sürümünü oluşturmak için talimatlar içeren, düz metin bir dosyadır. Bunu, BDM'ler için bir Dockerfile gibi düşünün.

Bir Modelfile ile Neler Yapabilirsiniz?

- Varsayılan Bir Sistem İstemini Ayarlayın: Modelin kalıcı kişiliğini veya talimatlarını tanımlayın.

- Parametreleri Ayarlayın:

temperature(rastgeleliği/yaratıcılığı kontrol eder) veyatop_k/top_p(kelime seçimini etkiler) gibi ayarları değiştirin. - Şablonları Tanımlayın: İstemlerin temel modele gönderilmeden önce nasıl biçimlendirildiğini özelleştirin.

- Modelleri Birleştirin (Gelişmiş): Potansiyel olarak yetenekleri birleştirin (ancak bu karmaşıktır).

Basit Modelfile Örneği:

llama3:8b'nin her zaman Alaycı bir Asistan gibi davranan bir sürümünü oluşturmak istediğinizi varsayalım.

Bir dizinde Modelfile (uzantı yok) adlı bir dosya oluşturun.

Aşağıdaki içeriği ekleyin:

# Temel llama3 modelinden miras alın

FROM llama3:8b

# Bir sistem istemi ayarlayın

SYSTEM """Çok alaycı bir asistansınız. Cevaplarınız teknik olarak doğru olmalı, ancak kuru bir zeka ve isteksizlikle verilmelidir."""

# Yaratıcılığı ayarlayın (daha düşük sıcaklık = daha az rastgele/daha odaklı)

PARAMETER temperature 0.5

Özel Modeli Oluşturma:

Terminalde Modelfile'ınızı içeren dizine gidin.

ollama create komutunu çalıştırın:

ollama create sarcastic-llama -f ./Modelfile

sarcastic-llama, yeni özel modelinize verdiğiniz addır.f ./Modelfile, kullanılacak Modelfile'ı belirtir.

Ollama, talimatları işleyecek ve yeni modeli oluşturacaktır. Daha sonra onu diğerleri gibi çalıştırabilirsiniz:

ollama run sarcastic-llama

Artık, sarcastic-llama ile etkileşim kurduğunuzda, SYSTEM isteminde tanımlanan alaycı kişiliği benimseyecektir.

Modelfiles, modelleri sıfırdan yeniden eğitmek zorunda kalmadan, belirli görevler veya davranışlar için ince ayar yapmanıza olanak tanıyarak derin özelleştirme potansiyeli sunar. Mevcut talimatlar ve parametreler hakkında daha fazla ayrıntı için Ollama belgelerini inceleyin.

Yaygın Ollama Hatalarını Düzeltme

Ollama basitliği hedeflese de, ara sıra engellerle karşılaşabilirsiniz:

Yükleme Başarısız Oluyor:

- İzinler: Yazılım yüklemek için gerekli haklara sahip olduğunuzdan emin olun. Linux/macOS'ta, belirli adımlar için

sudo'ya ihtiyacınız olabilir (ancak komut dosyası genellikle bunu halleder). - Ağ: İnternet bağlantınızı kontrol edin. Güvenlik duvarları veya proxy'ler indirmeleri engelleyebilir.

- Bağımlılıklar: WSL2 (Windows) veya gerekli derleme araçları (Linux'ta manuel olarak yükleniyorsa) gibi önkoşulların mevcut olduğundan emin olun.

Model İndirme Başarısızlıkları:

- Ağ: Kararsız internet, büyük indirmeleri kesintiye uğratabilir. Daha sonra tekrar deneyin.

- Disk Alanı: Yeterli boş alana sahip olduğunuzdan emin olun (Ollama kitaplığındaki model boyutlarını kontrol edin). Alanı yönetmek için

ollama listveollama rmkullanın. - Kayıt Defteri Sorunları: Zaman zaman, Ollama kayıt defterinde geçici sorunlar olabilir. Ollama'nın durum sayfalarını veya topluluk kanallarını kontrol edin.

Ollama Yavaş Performans:

- RAM: Bu en yaygın suçludur. Model, RAM'inize zar zor sığıyorsa, sisteminiz daha yavaş disk takas alanını kullanmaya başvuracak ve performansı önemli ölçüde azaltacaktır. Bellek yoğun diğer uygulamaları kapatın. Daha küçük bir model kullanmayı veya RAM'inizi yükseltmeyi düşünün.

- GPU Sorunları (Uygulanabilirse): En son uyumlu GPU sürücülerinin doğru yüklendiğinden emin olun (Linux/WSL'de NVIDIA için CUDA araç takımı dahil).

ollama run ...komutunu çalıştırın ve GPU algılamayla ilgili mesajlar için ilk çıktıyı kontrol edin. "CPU'ya geri dönülüyor" diyorsa, GPU kullanılmıyor demektir. - Yalnızca CPU: CPU üzerinde çalıştırmak, uyumlu bir GPU'da olduğundan daha yavaştır. Bu beklenen bir davranıştır.

"Model bulunamadı" Hataları:

- Yazım Hataları: Model adının yazımını iki kez kontrol edin (örneğin,

llama3:8b,llama3-8bdeğil). - İndirilmedi: Modelin tamamen indirildiğinden emin olun (

ollama list). Önce açıkça indirmek içinollama pull <model_name>komutunu deneyin. - Özel Model Adı: Özel bir model kullanıyorsanız, onu oluşturduğunuzda kullandığınız doğru adı kullandığınızdan emin olun (

ollama create my-model ..., ardındanollama run my-model). - Diğer Hatalar/Çöküşler: Daha ayrıntılı hata mesajları için Ollama günlüklerini kontrol edin. Konum, işletim sistemine göre değişir (Ollama belgelerini kontrol edin).

Ollama Alternatifleri?

Büyük dil modellerini yerel olarak çalıştırmak için Ollama'ya çeşitli ilgi çekici alternatifler mevcuttur.

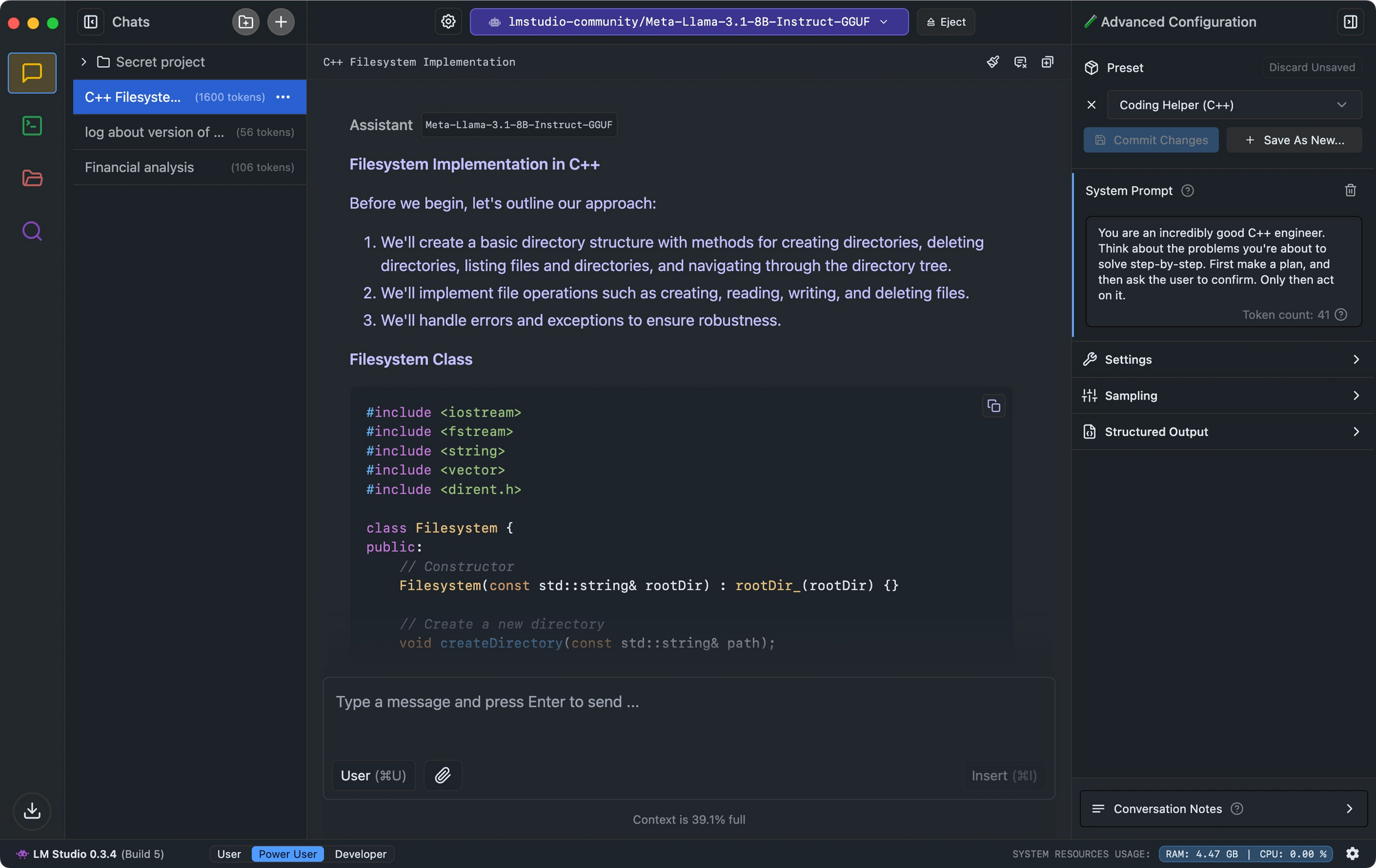

- LM Studio, sezgisel arayüzü, model uyumluluk kontrolü ve OpenAI'nin API'sini taklit eden yerel çıkarım sunucusu ile öne çıkıyor.

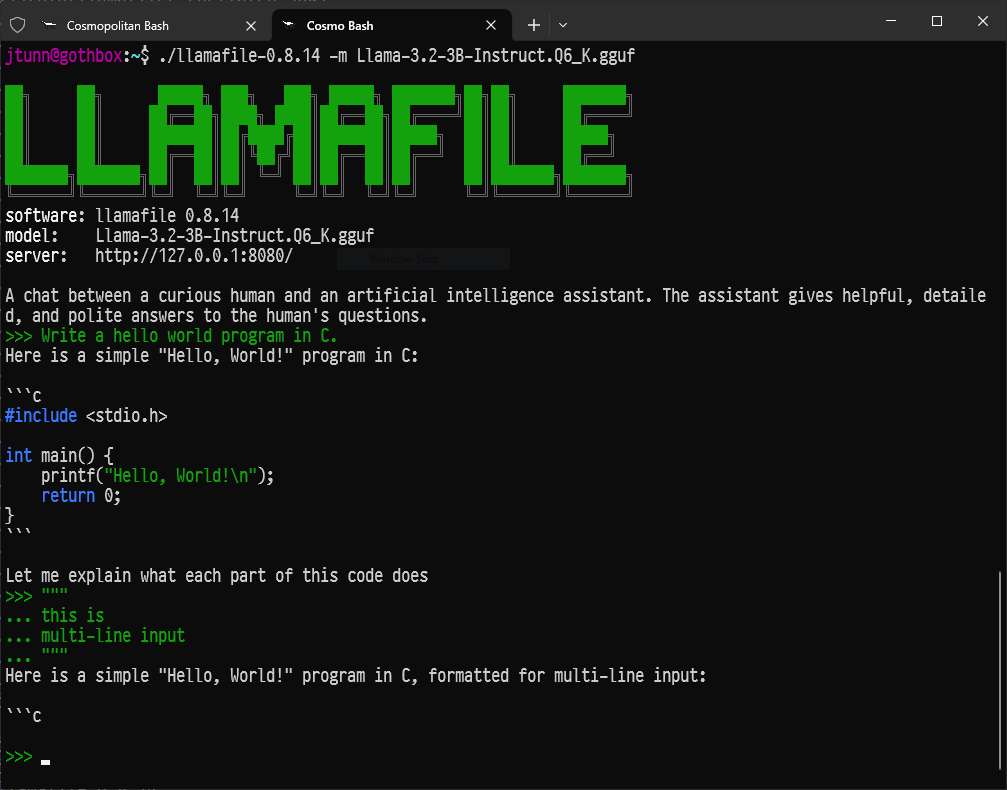

- Minimum kurulum arayan geliştiriciler için Llamafile, BDM'leri etkileyici performansla platformlar arasında çalışan tek yürütülebilir dosyalara dönüştürür.

- Komut satırı araçlarını tercih edenler için, LLaMa.cpp , birçok yerel BDM aracına güç veren ve mükemmel donanım uyumluluğuna sahip temel çıkarım motoru görevi görür.

Sonuç: Yerel YZ'ye Yolculuğunuz

Ollama, makul derecede modern bir bilgisayara sahip herkesin, güçlü YZ araçlarını yerel olarak, gizli bir şekilde ve devam eden maliyetler olmadan çalıştırabilmesini sağlayarak, büyük dil modellerinin büyüleyici dünyasına kapıları açıyor.

Bu sadece başlangıç. Gerçek eğlence, farklı modellerle denemeler yapmaya, bunları Modelfiles kullanarak özel ihtiyaçlarınıza göre uyarlamaya, Ollama'yı API'si aracılığıyla kendi komut dosyalarınıza veya uygulamalarınıza entegre etmeye ve hızla büyüyen açık kaynaklı YZ ekosistemini keşfetmeye başladığınızda başlar.

Gelişmiş YZ'yi yerel olarak çalıştırabilme yeteneği, bireyleri ve geliştiricileri aynı şekilde güçlendirerek dönüştürücüdür. Dalın, keşfedin, sorular sorun ve Ollama ile büyük dil modellerinin gücünü parmaklarınızın ucunda bulundurmanın keyfini çıkarın.