Yakın zamanda Meta'nın güçlü yapay zekası Llama 3.2 , hem metin hem de görüntü işleme için etkileyici yetenekler sunan, çığır açan bir dil modeli olarak piyasaya sürüldü. Bu gelişmiş modelin gücünü yerel makinelerinde kullanmak isteyen geliştiriciler ve yapay zeka meraklıları için LM Studio gibi araçlar öne çıkıyor. Bu kapsamlı rehber, Llama 3.2'yi bu güçlü platformları kullanarak yerel olarak çalıştırma sürecinde size yol gösterecek ve bulut hizmetlerine güvenmeden son teknoloji yapay zeka teknolojisinden yararlanmanızı sağlayacaktır.

Llama 3.2 ile Gelen Yenilikler: Yapay Zekada Son Gelişmeler

Kurulum sürecine dalmadan önce, Llama 3.2'yi özel kılan şeyleri kısaca inceleyelim:

- Çok Modlu Yetenekler: Llama 3.2 hem metin hem de görüntü işleyebilir ve yapay zeka uygulamaları için yeni olanakların kapılarını açar.

- Geliştirilmiş Verimlilik: Daha düşük gecikme süresiyle daha iyi performans için tasarlandı, bu da onu yerel dağıtım için ideal hale getiriyor.

- Çeşitli Model Boyutları: Kenar cihazları için uygun hafif 1B ve 3B modellerden, daha karmaşık görevler için güçlü 11B ve 90B sürümlerine kadar çeşitli boyutlarda mevcuttur.

- Genişletilmiş Bağlam: Daha kapsamlı bir içerik anlama ve oluşturma olanağı sağlayan 128K bağlam uzunluğunu destekler.

Llama 3.2'yi LM Studio ile Yerel Olarak Çalıştırın

LM Studio, grafik arayüzü ile daha kullanıcı dostu bir yaklaşım sunar. İşte LM Studio'yu kullanarak Llama 3.2'yi yerel olarak çalıştırma şekli:

Adım 1: LM Studio'yu İndirin ve Kurun

- LM Studio web sitesini ziyaret edin.

- İşletim sisteminizle uyumlu sürümü indirin.

- Sağlanan kurulum talimatlarını izleyin.

Adım 2: LM Studio'yu Başlatın

Kurulum tamamlandıktan sonra, LM Studio'yu açın. Sezgisel bir arayüzle karşılaşacaksınız.

Adım 3: Llama 3.2'yi Bulun ve İndirin

- Llama 3.2'yi bulmak için LM Studio'daki arama işlevini kullanın.

- İhtiyaçlarınız için uygun Llama 3.2 sürümünü seçin (örneğin, hafif uygulamalar için 3B veya daha karmaşık görevler için 11B).

- İndirme işlemini başlatmak için indirme düğmesine tıklayın.

Adım 4: Modeli Yapılandırın

İndirdikten sonra, çeşitli parametreleri yapılandırabilirsiniz:

- Gerekirse bağlam uzunluğunu ayarlayın (Llama 3.2 128K'ya kadar destekler).

- Çıktı rastgeleliğini kontrol etmek için sıcaklık ve top-p örnekleme değerlerini ayarlayın.

- Modelin davranışını ince ayar yapmak için diğer ayarları deneyin.

Adım 5: Llama 3.2 ile Etkileşime Geçin

Model yapılandırıldıktan sonra, artık şunları yapabilirsiniz:

- Llama 3.2 ile sohbet etmek için sohbet arayüzünü kullanın.

- Modelin yeteneklerini keşfetmek için farklı istemler deneyin.

- Daha gelişmiş istemler ve ayarlar denemek için Playground özelliğini kullanın.

Adım 6: Yerel Bir Sunucu Kurun (İsteğe Bağlı)

Geliştiriciler için, LM Studio yerel bir sunucu kurmanıza olanak tanır:

- LM Studio'daki Sunucu sekmesine gidin.

- Sunucu ayarlarını yapılandırın (port, API uç noktaları vb.).

- Uygulamalarınızda API çağrıları aracılığıyla Llama 3.2'yi kullanmak için sunucuyu başlatın.

Llama 3.2'yi Yerel Olarak Çalıştırmak İçin En İyi Uygulamalar

Yerel Llama 3.2 kurulumunuzdan en iyi şekilde yararlanmak için, bu en iyi uygulamaları göz önünde bulundurun:

- Donanım Hususları: Makinenizin minimum gereksinimleri karşıladığından emin olun. Özel bir GPU, özellikle daha büyük model boyutları için performansı önemli ölçüde artırabilir.

- İstem Mühendisliği: Llama 3.2'den en iyi sonuçları almak için net, özel istemler oluşturun. Çıktı kalitesini optimize etmek için farklı ifadeler deneyin.

- Düzenli Güncellemeler: En iyi performans ve en son özellikler için hem seçtiğiniz aracı (LM Studio) hem de Llama 3.2 modelini güncel tutun.

- Parametrelerle Deneyin: Kullanım durumunuz için doğru dengeyi bulmak için ayarları değiştirmekten çekinmeyin. Daha düşük değerler genellikle daha odaklanmış, deterministik çıktılar üretirken, daha yüksek değerler daha fazla yaratıcılık ve değişkenlik sunar.

- Etik Kullanım: Yapay zeka modellerini her zaman sorumlu bir şekilde kullanın ve çıktılardaki potansiyel önyargıların farkında olun. Üretim ortamlarında dağıtım yapıyorsanız ek koruma önlemleri veya filtreler uygulamayı düşünün.

- Veri Gizliliği: Llama 3.2'yi yerel olarak çalıştırmak veri gizliliğini artırır. Özellikle hassas bilgileri işlerken, girdiğiniz verilerin ve modelin çıktılarının nasıl kullanıldığının farkında olun.

- Kaynak Yönetimi: Özellikle uzun süreler veya daha büyük model boyutlarıyla çalışırken, Llama 3.2'yi çalıştırırken sistem kaynaklarınızı izleyin. Optimum performansı sağlamak için görev yöneticilerini veya kaynak izleme araçlarını kullanmayı düşünün.

Yaygın Sorunları Giderme

Llama 3.2'yi yerel olarak çalıştırırken bazı zorluklarla karşılaşabilirsiniz. İşte yaygın sorunlara çözümler:

- Yavaş Performans:

- Yeterli RAM ve CPU/GPU gücüne sahip olduğunuzdan emin olun.

- Mevcutsa daha küçük bir model boyutu kullanmayı deneyin (örneğin, 11B yerine 3B).

- Sistem kaynaklarını boşaltmak için gereksiz arka plan uygulamalarını kapatın.

2. Bellek Hatası:

- Model ayarlarındaki bağlam uzunluğunu azaltın.

- Mevcutsa daha küçük bir model varyantı kullanın.

- Mümkünse sisteminizin RAM'ini yükseltin.

3. Kurulum Sorunları:

- Sisteminizin LM Studio için minimum gereksinimleri karşılayıp karşılamadığını kontrol edin.

- Kullandığınız aracın en son sürümüne sahip olduğunuzdan emin olun.

- Kurulumu yönetici ayrıcalıklarıyla çalıştırmayı deneyin.

4. Model İndirme Başarısızlıkları:

- İnternet bağlantınızın kararlılığını kontrol edin.

- İndirmeye müdahale edebilecek güvenlik duvarlarını veya VPN'leri geçici olarak devre dışı bırakın.

- Daha iyi bant genişliği için yoğun olmayan saatlerde indirmeyi deneyin.

5. Beklenmedik Çıktılar:

- İstemlerinizi netlik ve özgüllük açısından gözden geçirin ve iyileştirin.

- Çıktı rastgeleliğini kontrol etmek için sıcaklığı ve diğer parametreleri ayarlayın.

- Doğru model sürümünü ve yapılandırmasını kullandığınızdan emin olun.

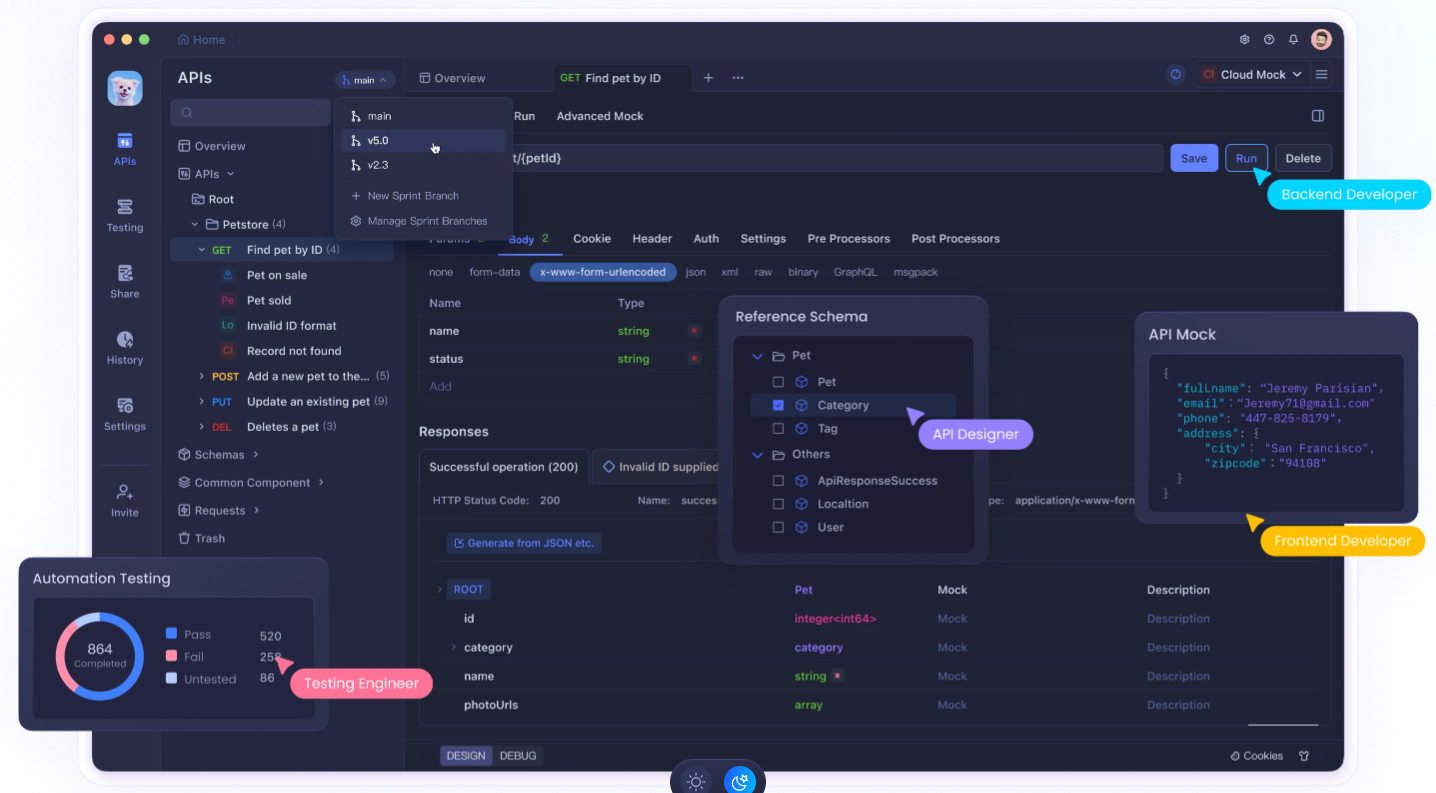

Apidog Kullanarak API Geliştirmenizi Geliştirin

Llama 3.2'yi yerel olarak çalıştırmak güçlüdür, bunu uygulamalarınıza entegre etmek genellikle sağlam API geliştirme ve test etme gerektirir. İşte Apidog'un devreye girdiği yer burasıdır. Apidog, Llama 3.2 gibi yerel LLM'lerle çalışırken iş akışınızı önemli ölçüde geliştirebilen kapsamlı bir API geliştirme platformudur.

Yerel LLM Entegrasyonu İçin Apidog'un Temel Özellikleri:

- API Tasarımı ve Dokümantasyonu: Yerel modeliniz ile uygulamanızın diğer bölümleri arasında net iletişim sağlayarak, Llama 3.2 entegrasyonlarınız için kolayca API'ler tasarlayın ve belgeleyin.

- Otomatik Test: Llama 3.2 API uç noktalarınız için otomatik testler oluşturun ve çalıştırın, modelinizin yanıtlarında güvenilirliği ve tutarlılığı sağlayın.

- Sahte Sunucular: Geliştirme sırasında Llama 3.2 yanıtlarını simüle etmek için Apidog'un sahte sunucu işlevini kullanın, yerel kurulumunuza hemen erişiminiz olmasa bile ilerlemenize olanak tanır.

- Ortam Yönetimi: Geliştirme ve test sırasında yapılandırmalar arasında geçiş yapmayı kolaylaştırarak, Apidog içinde farklı ortamları (örneğin, yerel Llama 3.2, üretim API'si) yönetin.

- İşbirliği Araçları: Llama 3.2 API tasarımlarınızı ve test sonuçlarınızı ekip üyelerinizle paylaşın, yapay zeka odaklı projelerde daha iyi işbirliğini teşvik edin.

- Performans İzleme: Llama 3.2 API uç noktalarınızın performansını izleyin, yanıt sürelerini ve kaynak kullanımını optimize etmenize yardımcı olun.

- Güvenlik Testi: Yerel model dağıtımınızın güvenlik açıkları oluşturmamasını sağlayarak, Llama 3.2 API entegrasyonlarınız için güvenlik testleri uygulayın.

Llama 3.2 Geliştirme İçin Apidog'a Başlarken:

- Bir Apidog hesabı için kaydolun.

- Llama 3.2 API entegrasyonunuz için yeni bir proje oluşturun.

- Yerel Llama 3.2 örneğinizle etkileşime girecek API uç noktalarınızı tasarlayın.

- Farklı yapılandırmaları (örneğin, LM Studio kurulumları) yönetmek için ortamlar ayarlayın.

- Llama 3.2 entegrasyonlarınızın doğru çalıştığından emin olmak için otomatik testler oluşturun.

- Erken geliştirme aşamalarında Llama 3.2 yanıtlarını simüle etmek için sahte sunucu özelliğini kullanın.

- API tasarımlarını ve test sonuçlarını paylaşarak ekibinizle işbirliği yapın.

Apidog'u yerel Llama 3.2 kurulumunuzla birlikte kullanarak, daha sağlam, iyi belgelenmiş ve kapsamlı bir şekilde test edilmiş yapay zeka destekli uygulamalar oluşturabilirsiniz.

Sonuç: Yerel Yapay Zekanın Gücünü Kucaklamak

Llama 3.2'yi yerel olarak çalıştırmak, yapay zeka teknolojisini demokratikleştirme yolunda önemli bir adımı temsil ediyor. İster LM Studio'nun kullanıcı dostu arayüzünü ister başka bir aracı seçin, artık gelişmiş dil modellerinin gücünü kendi makinenizde kullanma araçlarına sahipsiniz.

Llama 3.2 gibi büyük dil modellerinin yerel olarak dağıtımının sadece bir başlangıç olduğunu unutmayın. Yapay zeka geliştirmede gerçekten başarılı olmak için, Apidog gibi araçları iş akışınıza entegre etmeyi düşünün. Bu güçlü platform, yerel Llama 3.2 örneğinizle etkileşime giren API'leri tasarlamanıza, test etmenize ve belgelemenize yardımcı olabilir, geliştirme sürecinizi kolaylaştırır ve yapay zeka destekli uygulamalarınızın güvenilirliğini sağlar.

Llama 3.2 ile yolculuğunuza başlarken, denemeye devam edin, meraklı kalın ve her zaman yapay zekayı sorumlu bir şekilde kullanmaya çalışın. Yapay zekanın geleceği sadece bulutta değil; tam da burada, yerel makinenizde, keşfedilmeyi ve yenilikçi uygulamalar için kullanılmayı bekliyor. Doğru araçlar ve uygulamalarla, yerel yapay zekanın tüm potansiyelini ortaya çıkarabilir ve teknolojide mümkün olanın sınırlarını zorlayan çığır açan çözümler oluşturabilirsiniz.