OpenAI'ın gpt-oss-safeguard modelleri, sınıflandırma görevleri için politika tabanlı akıl yürütmeyi etkinleştirerek bu ihtiyacı karşılar. Mühendisler, kullanıcı tarafından oluşturulan içeriği sınıflandırmak, ihlalleri tespit etmek ve platform bütünlüğünü korumak için bu modelleri entegre eder.

düğme

GPT-OSS-Safeguard'ı Anlamak: Özellikler ve Yetenekler

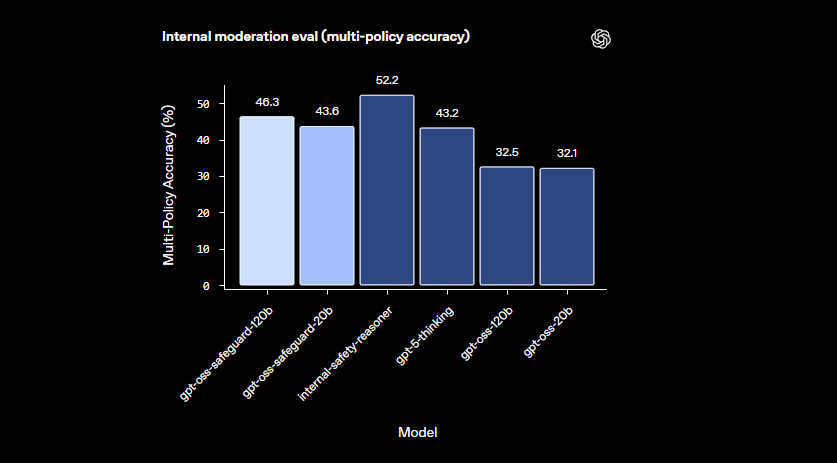

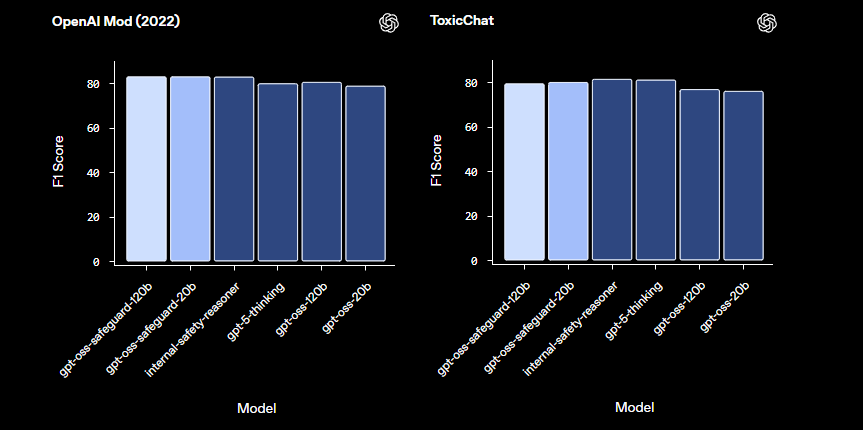

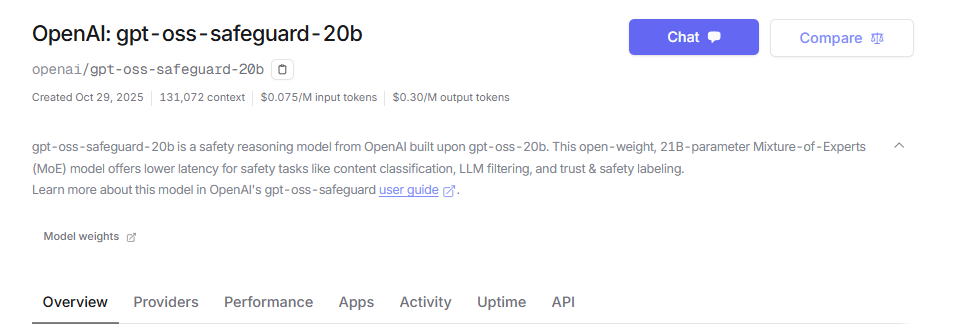

OpenAI mühendisleri, güvenlik sınıflandırması için özel olarak tasarlanmış açık ağırlıklı akıl yürütme modelleri olarak gpt-oss-safeguard'ı geliştirdi. Bu modelleri gpt-oss tabanından ince ayar yaparak Apache 2.0 lisansı altında yayınladılar. Geliştiriciler modelleri Hugging Face'ten indirir ve ücretsiz olarak dağıtır. Ürün yelpazesi, sayıların parametre ölçeklerini gösterdiği gpt-oss-safeguard-20b ve gpt-oss-safeguard-120b'yi içerir.

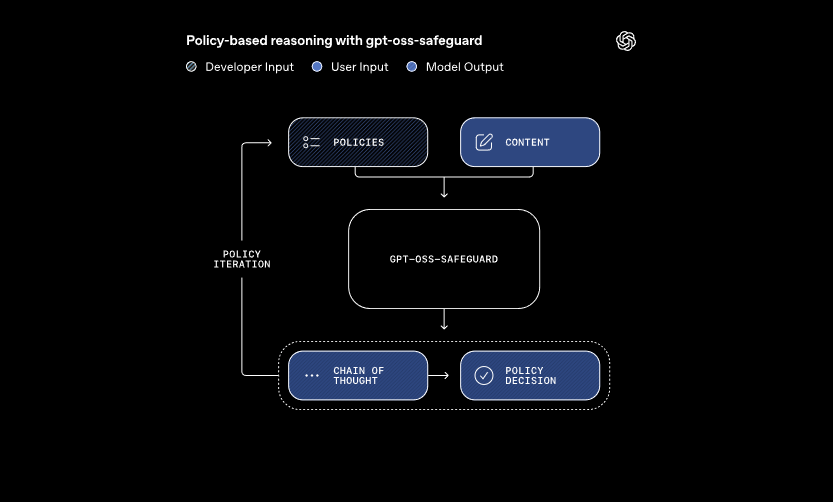

Bu modeller iki ana girişi işler: geliştirici tarafından tanımlanmış bir politika ve değerlendirilecek içerik. Sistem, politikayı yorumlamak ve içeriği sınıflandırmak için düşünce zinciri akıl yürütmesini uygular. Örneğin, bir kullanıcı mesajının oyun forumlarında hile yapma kurallarını ihlal edip etmediğini belirler. Bu yaklaşım, geleneksel sınıflandırıcıların gerektirdiği yeniden eğitim olmaksızın dinamik politika güncellemelerine olanak tanır.

Ayrıca, gpt-oss-safeguard birden fazla politikayı aynı anda destekler. Geliştiriciler, tek bir çıkarım çağrısına birkaç kural besler ve model içeriği tüm bu kurallara göre değerlendirir. Bu yetenek, yanlış bilgi veya zararlı konuşma gibi çeşitli riskleri yöneten platformlar için iş akışlarını kolaylaştırır. Ancak, eklenen politikalarla performans biraz düşebilir, bu nedenle ekipler yapılandırmaları kapsamlı bir şekilde test eder.

Modeller, daha küçük sınıflandırıcıların yetersiz kaldığı incelikli alanlarda üstün başarı gösterir. Gözden geçirilmiş politikalara hızla uyum sağlayarak ortaya çıkan zararları ele alırlar. Ek olarak, düşünce zinciri çıktısı şeffaflık sağlar—geliştiriciler, kararları denetlemek için akıl yürütme izini inceler. Bu özellik, açıklanabilir yapay zeka gerektiren uyumluluk ekipleri için paha biçilmezdir.

LlamaGuard gibi önceden hazırlanmış güvenlik modellerine kıyasla, gpt-oss-safeguard daha fazla özelleştirme sunar. Sabit taksonomilerden kaçınarak, kuruluşların kendi eşiklerini tanımlamalarına olanak tanır. Sonuç olarak, entegrasyon, ölçeklenebilir moderasyon boru hatları oluşturan Güven ve Güvenlik mühendisleri için uygundur. Temelleri anladığımıza göre, şimdi ortam kurulumuna geçelim.

GPT-OSS-Safeguard API Erişimi için Ortamınızı Kurma

Geliştiriciler, gpt-oss-safeguard'ı çalıştırmak için sistemlerini hazırlayarak başlar. Modeller açık ağırlıklı olduğundan, bunları yerel olarak veya barındırılan sağlayıcılar aracılığıyla dağıtırsınız. Bu esneklik, kişisel makinelerden bulut sunucularına kadar çeşitli donanım kurulumlarına uyum sağlar.

İlk olarak, gerekli bağımlılıkları yükleyin. Python 3.10 veya üstü temel olarak hizmet verir. Hugging Face Transformers gibi kütüphaneleri eklemek için pip kullanın: pip install transformers. Hızlandırılmış çıkarım için, uyumlu bir GPU'nuz varsa CUDA desteğiyle torch'u dahil edin. NVIDIA donanımına sahip mühendisler, daha hızlı işlem için bunu etkinleştirir.

Ardından, modelleri Hugging Face'ten indirin. Koleksiyona erişin. Daha hafif kaynak ihtiyaçları için gpt-oss-safeguard-20b'yi veya üstün doğruluk için gpt-oss-safeguard-120b'yi seçin. transformers-cli download openai/gpt-oss-safeguard-20b komutu dosyaları alır.

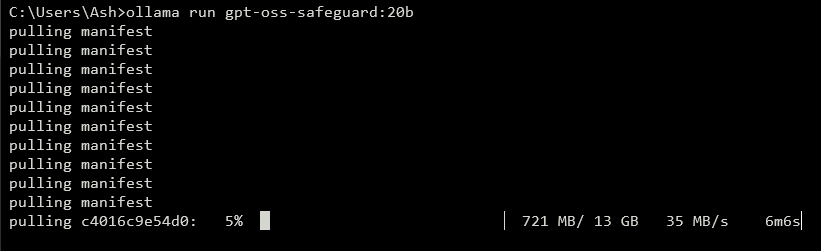

Bir API'yi açığa çıkarmak için yerel bir sunucu çalıştırın. vLLM gibi araçlar bunu verimli bir şekilde halleder. vLLM'yi pip install vllm ile yükleyin. Ardından, sunucuyu başlatın: vllm serve openai/gpt-oss-safeguard-20b. Bu komut, http://localhost:8000/v1 adresinde OpenAI uyumlu bir uç nokta başlatır. Benzer şekilde, Ollama dağıtımı basitleştirir: ollama run gpt-oss-safeguard:20b. Entegrasyon için REST API'leri sağlar.

Yerel test için LM Studio, kullanıcı dostu bir arayüz sunar. Modeli almak için lms get openai/gpt-oss-safeguard-20b komutunu yürütün. Yazılım, OpenAI'ın Sohbet Tamamlama API'sini taklit ederek, kodun üretime sorunsuz geçişine olanak tanır.

Barındırılan seçenekler donanım endişelerini ortadan kaldırır. Groq gibi sağlayıcılar, API'leri aracılığıyla gpt-oss-safeguard-20b'yi destekler. https://console.groq.com adresinden kaydolun, bir API anahtarı oluşturun ve isteklerde modeli hedefleyin. Fiyatlandırma, milyon giriş tokenı başına 0,075 dolardan başlar. OpenRouter da bunu barındırır.

Kurulum tamamlandıktan sonra, kurulumu doğrulayın. Curl aracılığıyla bir test isteği gönderin: curl http://localhost:8000/v1/chat/completions -H "Content-Type: application/json" -d '{"model": "openai/gpt-oss-safeguard-20b", "messages": [{"role": "system", "content": "Test policy"}, {"role": "user", "content": "Test content"}]}'. Başarılı bir yanıt, hazır olduğunuzu onaylar. Ortam yapılandırıldıktan sonra, bir sonraki adım politikaları oluşturmaktır.

GPT-OSS-Safeguard için Etkili Politikalar Oluşturma

Politikalar, gpt-oss-safeguard operasyonlarının temelini oluşturur. Geliştiriciler, sınıflandırmaya rehberlik eden yapılandırılmış istemler olarak bunları yazarlar. İyi tasarlanmış bir politika, modelin akıl yürütme gücünü en üst düzeye çıkararak doğru ve açıklanabilir çıktılar sağlar.

Politikanızı farklı bölümlerle yapılandırın. Talimatlarla başlayın, modelin görevlerini belirtin. Örneğin, içeriği ihlal eden (1) veya güvenli (0) olarak sınıflandırması için yönlendirin. Ardından, "insanlık dışı dil" gibi anahtar terimleri açıklayan Tanımlar ile devam edin. Daha sonra, ihlaller ve güvenli içerik için Kriterleri özetleyin. Son olarak, Örnekler ekleyin—4-6 sınır durumunu buna göre etiketlenmiş olarak sağlayın.

Politikalarda etken çatı kullanın: pasif alternatifler yerine "Şiddeti teşvik eden içeriği işaretle". Dili kesin tutun; "genel olarak güvensiz" gibi belirsizliklerden kaçının. Kurallar arasında çelişkiler ortaya çıkarsa, önceliği açıkça tanımlayın. Çoklu politika senaryoları için, bunları sistem mesajında birleştirin.

Akıl yürütme derinliğini "reasoning_effort" parametresi aracılığıyla kontrol edin: karmaşık durumlar için "high" (yüksek) veya hız için "low" (düşük) olarak ayarlayın. Gpt-oss-safeguard'a yerleşik olan harmony formatı, akıl yürütmeyi nihai çıktıdan ayırır. Bu, denetim izlerini korurken temiz API yanıtları sağlar.

Politika uzunluğunu 400-600 token civarında optimize edin. Daha kısa politikalar aşırı basitleştirme riski taşırken, daha uzun olanlar modeli karıştırabilir. Tekrarlayarak test edin: örnek içeriği sınıflandırın ve çıktılara göre iyileştirin. Hugging Face'deki token sayaçları burada yardımcı olur.

Çıktı formatları için basitlik adına ikiliyi seçin: Tam olarak 0 veya 1 döndür. Derinlik için gerekçe ekleyin: {"violation": 1, "rationale": "Açıklama burada"}. Bu JSON yapısı, alt sistemlerle kolayca entegre olur. Politikaları iyileştirdikçe, API uygulamasına geçin.

GPT-OSS-Safeguard ile API Çağrılarını Uygulama

Geliştiriciler, gpt-oss-safeguard ile OpenAI uyumlu uç noktalar aracılığıyla etkileşim kurar. İster yerel ister barındırılmış olsun, süreç standart sohbet tamamlama kalıplarını takip eder.

İstemcinizi hazırlayın. Python'da OpenAI'ı içe aktarın: from openai import OpenAI. Yerel için temel URL ve anahtarla başlatın: client = OpenAI(base_url="http://localhost:8000/v1", api_key="dummy") veya sağlayıcıya özgü değerleri kullanın.

Mesajları oluşturun. Sistem rolü politikayı tutar: {"role": "system", "content": "Ayrıntılı politikanız burada"}. Kullanıcı rolü içeriği içerir: {"role": "user", "content": "Sınıflandırılacak içerik"}.

API'yi çağırın: completion = client.chat.completions.create(model="openai/gpt-oss-safeguard-20b", messages=messages, max_tokens=500, temperature=0.0). Sıfır sıcaklık, güvenlik görevleri için deterministik çıktılar sağlar.

Yanıtı ayrıştırın: result = completion.choices[0].message.content. Yapılandırılmış çıktılar için JSON ayrıştırması kullanın. Groq, bunu istem önbelleğe alma ile geliştirir—maliyetleri %50 azaltmak için çağrılar arasında politikaları yeniden kullanın.

Gerçek zamanlı geri bildirim için akışı yönetin: stream=True olarak ayarlayın ve öbekler üzerinde yineleyin. Bu, yüksek hacimli moderasyon için uygundur.

Gerektiğinde araçları dahil edin, ancak gpt-oss-safeguard sınıflandırmaya odaklanır. Harici veri getirme gibi genişletilmiş yetenekler için tools parametresinde fonksiyonları tanımlayın.

Token kullanımını izleyin: giriş, politika artı içeriği içerir, çıktılar akıl yürütmeyi ekler. Taşmaları önlemek için max_tokens'i sınırlayın. Çağrılarda ustalaştıktan sonra, örnekleri keşfedin.

GPT-OSS-Safeguard API'sindeki Gelişmiş Özellikler

gpt-oss-safeguard, hassas kontrol için gelişmiş araçlar sunar. Groq'daki istem önbelleğe alma, politikaları yeniden kullanarak gecikmeyi ve maliyetleri azaltır.

Sistem mesajında reasoning_effort'u ayarlayın: derinlemesine analiz için "Reasoning: high" (Akıl yürütme: yüksek). Bu, belirsiz içeriği daha iyi ele alır.

Uzun sohbetler veya belgeler için 128k bağlam penceresinden yararlanın. Bütünsel sınıflandırma için tüm konuşmaları besleyin.

Daha büyük sistemlerle entegre edin: Çıktıları yükseltme kuyruklarına veya günlüğe yönlendirin. Gerçek zamanlı uyarılar için webhook'ları kullanın.

Gerekirse daha fazla ince ayar yapın, ancak temel model politika takibinde üstündür. Hesaplamayı optimize etmek için ön filtreleme için daha küçük modellerle birleştirin.

Güvenlik önemlidir: API anahtarlarını güvence altına alın ve istem enjeksiyonlarını izleyin. İstismarları önlemek için girişleri doğrulayın.

Ölçeklendirme: Yüksek verim için vLLM ile kümelerde dağıtın. Groq gibi sağlayıcılar saniyede 1000'den fazla token sunar.

Bu özellikler, gpt-oss-safeguard'ı temel bir sınıflandırıcıdan kurumsal bir araca yükseltir. Ancak, en iyi sonuçlar için en iyi uygulamaları takip edin.

GPT-OSS-Safeguard için En İyi Uygulamalar ve Optimizasyon

Mühendisler, politikalar üzerinde yineleyerek gpt-oss-safeguard'ı optimize eder. Çeşitli veri kümeleriyle test edin, F1-skoru gibi metrikler aracılığıyla doğruluğu ölçün.

Model boyutunu dengeleyin: Hız için 20b'yi, hassasiyet için 120b'yi kullanın. Bellek ayak izini azaltmak için ağırlıkları nicelendirin.

Performansı izleyin: Denetimler için akıl yürütme izlerini günlüğe kaydedin. Sıcaklığı minimum düzeyde ayarlayın—0.0 deterministik ihtiyaçlar için uygundur.

Sınırlamaları ele alın: Model, son derece uzmanlaşmış alanlarda zorlanabilir; alan verileriyle destekleyin.

Etik kullanımı sağlayın: Politikaları düzenlemelerle uyumlu hale getirin. Örnekleri çeşitlendirerek önyargılardan kaçının.

Düzenli olarak güncelleyin: OpenAI gpt-oss-safeguard'ı geliştirdikçe, iyileştirmeleri dahil edin.

Maliyet yönetimi: Barındırılan API'ler için token harcamalarını takip edin. Yerel dağıtımlar maliyetleri minimize eder.

Bu uygulamaları uygulayarak verimliliği en üst düzeye çıkarırsınız. Özetle, gpt-oss-safeguard sağlam güvenlik sistemlerini güçlendirir.

Sonuç: GPT-OSS-Safeguard'ı İş Akışınıza Entegre Etme

Geliştiriciler, uyarlanabilir güvenlik sınıflandırıcıları oluşturmak için gpt-oss-safeguard'dan yararlanır. Kurulumdan gelişmiş kullanıma kadar, bu kılavuz sizi teknik bilgiyle donatır. Politikaları uygulayın, API çağrılarını yürütün ve ihtiyaçlarınız için optimize edin. Platformlar geliştikçe, gpt-oss-safeguard sorunsuz bir şekilde uyum sağlayarak güvenli ortamlar sağlar.

düğme