Kodlama iş akışınızı GPT-OSS, Open AI’ın açık ağırlıklı modeli ile doğrudan Claude Code içinde süper şarj etmek ister misiniz? Harika bir deneyim sizi bekliyor! Ağustos 2025’te piyasaya sürülen GPT-OSS (20B veya 120B varyantları) kodlama ve muhakeme için bir güç merkezidir ve onu Claude Code’un şık CLI arayüzü ile ücretsiz veya düşük maliyetli kurulumlar için eşleştirebilirsiniz. Bu sohbet tarzı rehberde, GPT-OSS’i Claude Code ile Hugging Face, OpenRouter veya LiteLLM kullanarak entegre etmenin üç yolunu size göstereceğiz. Hadi dalalım ve yapay zeka kodlama yardımcınızı çalıştıralım!

Geliştirici Ekibinizin maksimum verimlilikle birlikte çalışması için entegre, Hepsi Bir Arada bir platform mu istiyorsunuz?

Apidog tüm taleplerinizi karşılar ve Postman'ı çok daha uygun bir fiyata değiştirir!

GPT-OSS Nedir ve Neden Claude Code ile Kullanılmalı?

GPT-OSS, Open AI’ın açık ağırlıklı model ailesidir; 20B ve 120B varyantları kodlama, muhakeme ve ajans görevleri için olağanüstü performans sunar. 128K token bağlam penceresi ve Apache 2.0 lisansı ile esneklik ve kontrol isteyen geliştiriciler için mükemmeldir. Anthropic’in CLI aracı (sürüm 0.5.3+) olan Claude Code, sohbet tabanlı kodlama yetenekleri sayesinde geliştiricilerin favorisidir. Claude Code’u OpenAI uyumlu API’ler aracılığıyla GPT-OSS’e yönlendirerek, Anthropic’in abonelik maliyetleri olmadan Claude’un tanıdık arayüzünün keyfini çıkarırken GPT-OSS’in açık kaynak gücünden yararlanabilirsiniz. Gerçekleştirmeye hazır mısınız? Kurulum seçeneklerini keşfedelim!

GPT-OSS'i Claude Code ile Kullanmak İçin Ön Koşullar

Başlamadan önce şunlara sahip olduğunuzdan emin olun:

- Claude Code ≥ 0.5.3:

claude --versionile kontrol edin.pip install claude-codeile yükleyin veyapip install --upgrade claude-codeile güncelleyin. - Hugging Face Hesabı: huggingface.co adresinden kaydolun ve bir okuma/yazma tokenı oluşturun (Ayarlar > Erişim Tokenları).

- OpenRouter API Anahtarı: İsteğe bağlı, Yol B için. openrouter.ai adresinden edinin.

- Python 3.10+ ve Docker: Yerel kurulumlar veya LiteLLM (Yol C) için.

- Temel CLI Bilgisi: Ortam değişkenleri ve terminal komutlarına aşinalık yardımcı olur.

Yol A: GPT-OSS'i Hugging Face'te Kendi Kendine Barındırma

Tam kontrol mü istiyorsunuz? Özel, ölçeklenebilir bir kurulum için GPT-OSS'i Hugging Face'in Çıkarım Uç Noktalarında barındırın. İşte nasıl yapacağınız:

Adım 1: Modeli Edinin

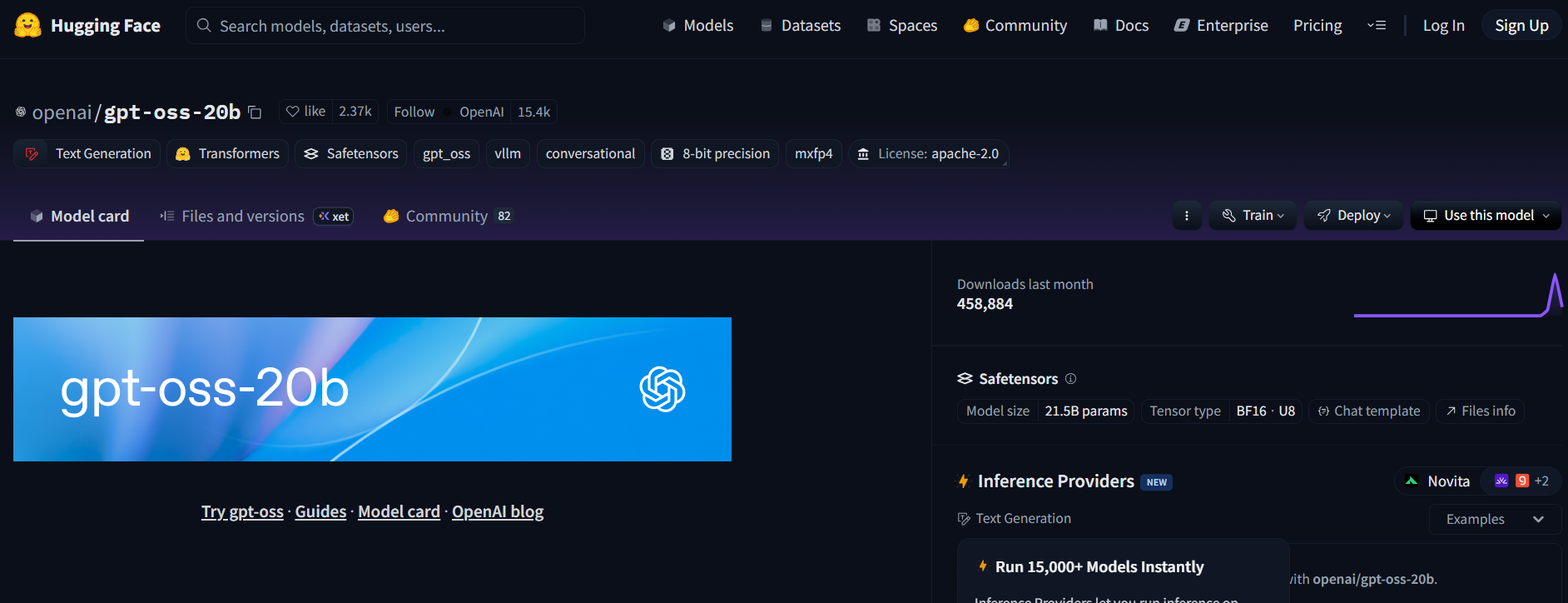

- Hugging Face'teki GPT-OSS deposunu ziyaret edin (openai/gpt-oss-20b veya openai/gpt-oss-120b).

- Modele erişmek için Apache 2.0 lisansını kabul edin.

- Alternatif olarak, kodlama odaklı bir model için Qwen3-Coder-480B-A35B-Instruct'ı deneyin (Qwen/Qwen3-Coder-480B-A35B-Instruct) (daha hafif donanım için GGUF sürümünü kullanın).

Adım 2: Bir Metin Üretimi Çıkarım Uç Noktası Dağıtın

- Model sayfasında, Dağıt > Çıkarım Uç Noktası'na tıklayın.

- Metin Üretimi Çıkarımı (TGI) şablonunu (≥ v1.4.0) seçin.

- Gelişmiş ayarlarda OpenAI uyumluluğunu etkinleştir seçeneğini işaretleyerek veya

--enable-openaiekleyerek OpenAI uyumluluğunu etkinleştirin. - Donanım seçin: 20B için A10G veya CPU, 120B için A100. Uç noktayı oluşturun.

Adım 3: Kimlik Bilgilerini Toplayın

- Uç nokta durumu Çalışıyor olduğunda, şunları kopyalayın:

- ENDPOINT_URL:

https://<uç-noktanız>.us-east-1.aws.endpoints.huggingface.cloudgibi görünür. - HF_API_TOKEN: Ayarlar > Erişim Tokenları'ndan Hugging Face tokenınız.

2. Model ID'sini not alın (örn. gpt-oss-20b veya gpt-oss-120b).

Adım 4: Claude Code'u Yapılandırın

- Terminalinizde ortam değişkenlerini ayarlayın:

export ANTHROPIC_BASE_URL="https://<your-endpoint>.us-east-1.aws.endpoints.huggingface.cloud"

export ANTHROPIC_AUTH_TOKEN="hf_xxxxxxxxxxxxxxxxx"

export ANTHROPIC_MODEL="gpt-oss-20b" # or gpt-oss-120b

<your-endpoint> ve hf_xxxxxxxxxxxxxxxxx değerlerini kendi değerlerinizle değiştirin.

2. Kurulumu test edin:

claude --model gpt-oss-20b

Claude Code, TGI’nin /v1/chat/completions API’si aracılığıyla OpenAI şemasını taklit ederek yanıtları akış halinde yayınlayarak GPT-OSS uç noktanıza yönlendirir.

Adım 5: Maliyet ve Ölçeklendirme Notları

- Hugging Face Maliyetleri: Çıkarım Uç Noktaları otomatik ölçeklenir, bu nedenle kredi tükenmesini önlemek için kullanımı izleyin. A10G saatte yaklaşık 0.60$, A100 saatte yaklaşık 3$ maliyetlidir.

- Yerel Seçenek: Sıfır bulut maliyeti için, TGI'yı Docker ile yerel olarak çalıştırın:

docker run --name tgi -p 8080:80 -e HF_TOKEN=hf_xxxxxxxxxxxxxxxxx ghcr.io/huggingface/text-generation-inference:latest --model-id openai/gpt-oss-20b --enable-openai

Ardından ANTHROPIC_BASE_URL="http://localhost:8080" olarak ayarlayın.

Yol B: GPT-OSS'i OpenRouter Üzerinden Proxy Olarak Kullanma

DevOps'a gerek yok mu? Sorun değil! Minimal kurulumla GPT-OSS'e erişmek için OpenRouter'ı kullanın. Hızlıdır ve faturalandırmayı sizin için halleder.

Adım 1: Kaydolun ve Bir Model Seçin

- openrouter.ai adresinden kaydolun ve API anahtarınızı Anahtarlar bölümünden kopyalayın.

- Bir model slug'ı seçin:

openai/gpt-oss-20bopenai/gpt-oss-120bqwen/qwen3-coder-480b(Qwen’in kodlayıcı modeli için)

Adım 2: Claude Code'u Yapılandırın

- Ortam değişkenlerini ayarlayın:

export ANTHROPIC_BASE_URL="https://openrouter.ai/api/v1"

export ANTHROPIC_AUTH_TOKEN="or_xxxxxxxxx"

export ANTHROPIC_MODEL="openai/gpt-oss-20b"

or_xxxxxxxxx değerini OpenRouter API anahtarınızla değiştirin.

2. Test edin:

claude --model openai/gpt-oss-20b

Claude Code, OpenRouter’ın birleşik API’si aracılığıyla GPT-OSS’e bağlanır, akış ve yedekleme desteğiyle.

Adım 3: Maliyet Notları

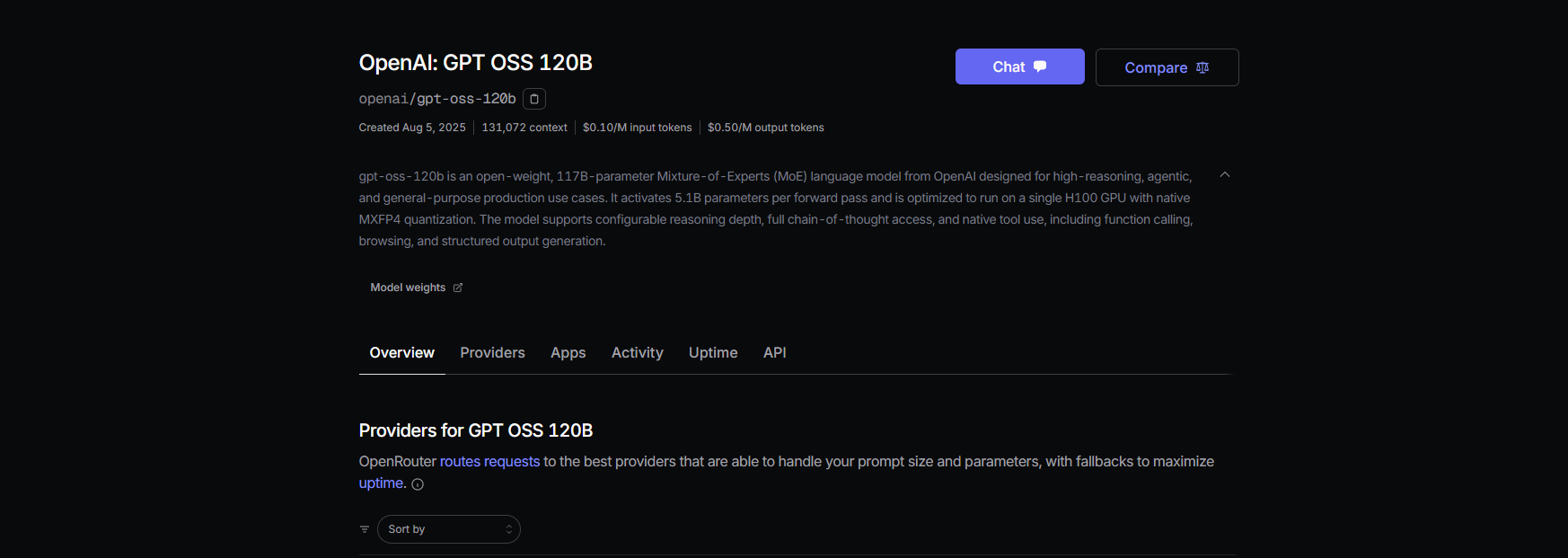

- OpenRouter Fiyatlandırması: GPT-OSS-120B için yaklaşık 0.50$/M giriş tokenı, yaklaşık 2.00$/M çıkış tokenı, GPT-4 gibi tescilli modellerden (yaklaşık 20.00$/M) önemli ölçüde daha ucuzdur.

- Faturalandırma: OpenRouter kullanımı yönetir, bu nedenle yalnızca kullandığınız kadar ödersiniz.

Yol C: Karma Model Filoları İçin LiteLLM Kullanımı

GPT-OSS, Qwen ve Anthropic modellerini tek bir iş akışında bir arada kullanmak mı istiyorsunuz? LiteLLM, modelleri sorunsuz bir şekilde hızlıca değiştirmek için bir proxy görevi görür.

Adım 1: LiteLLM'yi Kurun ve Yapılandırın

- LiteLLM'yi kurun:

pip install litellm

2. Bir yapılandırma dosyası (litellm.yaml) oluşturun:

model_list:

- model_name: gpt-oss-20b

litellm_params:

model: openai/gpt-oss-20b

api_key: or_xxxxxxxxx # OpenRouter key

api_base: https://openrouter.ai/api/v1

- model_name: qwen3-coder

litellm_params:

model: openrouter/qwen/qwen3-coder

api_key: or_xxxxxxxxx

api_base: https://openrouter.ai/api/v1

or_xxxxxxxxx değerini OpenRouter anahtarınızla değiştirin.

3. Proxy'yi başlatın:

litellm --config litellm.yaml

Adım 2: Claude Code'u LiteLLM'ye Yönlendirin

- Ortam değişkenlerini ayarlayın:

export ANTHROPIC_BASE_URL="http://localhost:4000"

export ANTHROPIC_AUTH_TOKEN="litellm_master"

export ANTHROPIC_MODEL="gpt-oss-20b"

2. Test edin:

claude --model gpt-oss-20b

LiteLLM, maliyet kaydı ve güvenilirlik için basit karıştırma yönlendirmesi ile istekleri OpenRouter aracılığıyla GPT-OSS'e yönlendirir.

Adım 3: Notlar

- Gecikme Yönlendirmesinden Kaçının: Anthropic modelleriyle sorunları önlemek için LiteLLM'de basit karıştırma modunu kullanın.

- Maliyet Takibi: LiteLLM şeffaflık için kullanımı kaydeder.

GPT-OSS'i Claude Code ile Test Etme

GPT-OSS'in çalıştığından emin olalım! Claude Code'u açın ve şu komutları deneyin:

Kod Üretimi:

claude --model gpt-oss-20b "Flask ile bir Python REST API yaz"

Şuna benzer bir yanıt bekleyin:

from flask import Flask, jsonify

app = Flask(__name__)

@app.route('/api', methods=['GET'])

def get_data():

return jsonify({"message": "Hello from GPT-OSS!"})

if __name__ == '__main__':

app.run(debug=True)

Kod Tabanı Analizi:

claude --model gpt-oss-20b "src/server.js dosyasını özetle"

GPT-OSS, JavaScript dosyanızı analiz etmek ve bir özet döndürmek için 128K bağlam penceresini kullanır.

Hata Ayıklama:

claude --model gpt-oss-20b "Bu hatalı Python kodunda hata ayıklama yap: [kodu yapıştır]"

HumanEval geçiş oranı %87.3 ile GPT-OSS, sorunları doğru bir şekilde tespit edip düzeltmelidir.

Sorun Giderme İpuçları

- /v1/chat/completions'ta 404 mü? TGI'da (Yol A)

--enable-openai'ın etkin olduğundan emin olun veya OpenRouter'ın model kullanılabilirliğini (Yol B) kontrol edin. - Boş Yanıtlar mı?

ANTHROPIC_MODEL'in slug ile eşleştiğini doğrulayın (örn.gpt-oss-20b). - Model Değişiminden Sonra 400 Hatası mı? LiteLLM'de (Yol C) basit karıştırma yönlendirmesini kullanın.

- Yavaş İlk Token mı? Sıfıra ölçeklendirdikten sonra Hugging Face uç noktalarını küçük bir istemle ısıtın.

- Claude Code Çöküyor mu? ≥ 0.5.3 sürümüne güncelleyin ve ortam değişkenlerinin doğru ayarlandığından emin olun.

Neden GPT-OSS'i Claude Code ile Kullanmalısınız?

GPT-OSS'i Claude Code ile eşleştirmek bir geliştiricinin hayalidir. Şunları elde edersiniz:

- Maliyet Tasarrufu: OpenRouter’ın 0.50$/M giriş tokenları tescilli modelleri geride bırakır ve yerel TGI kurulumları donanım maliyetlerinden sonra ücretsizdir.

- Açık Kaynak Gücü: GPT-OSS’in Apache 2.0 lisansı, özelleştirmenize veya özel olarak dağıtmanıza olanak tanır.

- Sorunsuz İş Akışı: Claude Code’un CLI’sı bir kodlama arkadaşıyla sohbet ediyormuş gibi hissettirirken, GPT-OSS %94.2 MMLU ve %96.6 AIME puanlarıyla ağır işleri halleder.

- Esneklik: LiteLLM veya OpenRouter ile GPT-OSS, Qwen veya Anthropic modelleri arasında geçiş yapın.

Kullanıcılar GPT-OSS’in kodlama yeteneğinden övgüyle bahsediyor ve onu “çok dosyalı projeler için bütçe dostu bir canavar” olarak adlandırıyor. İster kendi kendinize barındırın ister OpenRouter üzerinden proxy kullanın, bu kurulum maliyetleri düşük ve üretkenliği yüksek tutar.

Sonuç

Artık GPT-OSS'i Claude Code ile kullanmaya hazırsınız! İster Hugging Face'te kendi kendinize barındırın, ister OpenRouter üzerinden proxy kullanın, ister modelleri yönetmek için LiteLLM kullanın, güçlü ve uygun maliyetli bir kodlama kurulumuna sahipsiniz. REST API'leri oluşturmaktan kodda hata ayıklamaya kadar, GPT-OSS işini yapar ve Claude Code bunu zahmetsiz hissettirir. Deneyin, favori istemlerinizi yorumlarda paylaşın ve yapay zeka kodlaması hakkında konuşalım!

Geliştirici Ekibinizin maksimum verimlilikle birlikte çalışması için entegre, Hepsi Bir Arada bir platform mu istiyorsunuz?

Apidog tüm taleplerinizi karşılar ve Postman'ı çok daha uygun bir fiyata değiştirir!