Hey, yapay zeka meraklıları! Kemerlerinizi bağlayın çünkü Open AI, yeni açık ağırlıklı modeli GPT-OSS-120B ile bomba gibi bir duyuru yaptı ve bu, yapay zeka camiasında büyük ilgi görüyor. Apache 2.0 lisansı altında yayımlanan bu güçlü model, tek bir GPU üzerinde çalışırken akıl yürütme, kodlama ve ajans görevleri için tasarlandı. Bu rehberde, GPT-OSS-120B'yi özel kılan şeyleri, etkileyici kıyaslama sonuçlarını, uygun fiyatlandırmasını ve OpenRouter API aracılığıyla nasıl kullanabileceğinizi derinlemesine inceleyeceğiz. Bu açık kaynaklı mücevheri keşfedelim ve kısa sürede kod yazmaya başlamanızı sağlayalım!

Geliştirici Ekibinizin maksimum verimlilikle birlikte çalışması için entegre, Hepsi Bir Arada bir platform mu istiyorsunuz?

Apidog tüm taleplerinizi karşılıyor ve Postman'ı çok daha uygun bir fiyata değiştiriyor!

GPT-OSS-120B Nedir?

Open AI'ın GPT-OSS-120B, daha küçük GPT-OSS-20B ile birlikte yeni açık ağırlıklı GPT-OSS serisinin bir parçası olan 117 milyar parametreli bir dil modelidir (token başına 5.1 milyar aktif). 5 Ağustos 2025'te yayımlanan bu model, verimlilik için optimize edilmiş bir Uzmanlar Karışımı (MoE) modelidir ve tek bir NVIDIA H100 GPU'da veya MXFP4 nicelemesi ile tüketici donanımında bile çalışabilir. Karmaşık akıl yürütme, kod üretimi ve araç kullanımı gibi görevler için inşa edilmiştir ve 128K token'lık devasa bir bağlam penceresine sahiptir – yani 300-400 sayfa metin düşünebilirsiniz! Apache 2.0 lisansı altında, onu özelleştirebilir, dağıtabilir ve hatta ticarileştirebilirsiniz, bu da onu kontrol ve gizlilik arayan geliştiriciler ve işletmeler için bir rüya haline getiriyor.

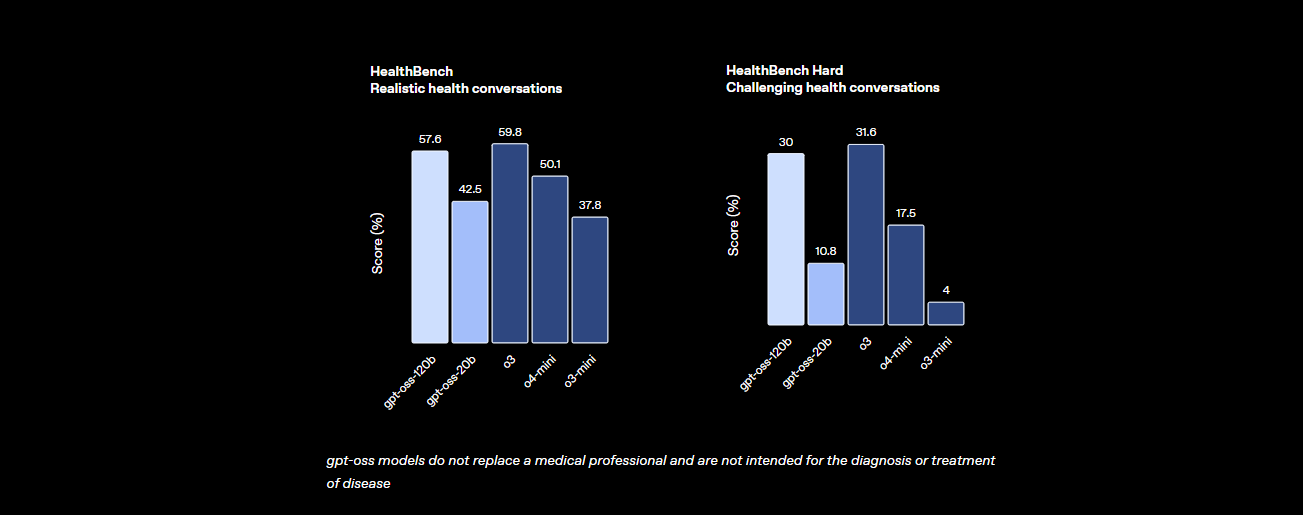

Kıyaslamalar: GPT-OSS-120B Nasıl Bir Performans Sergiliyor?

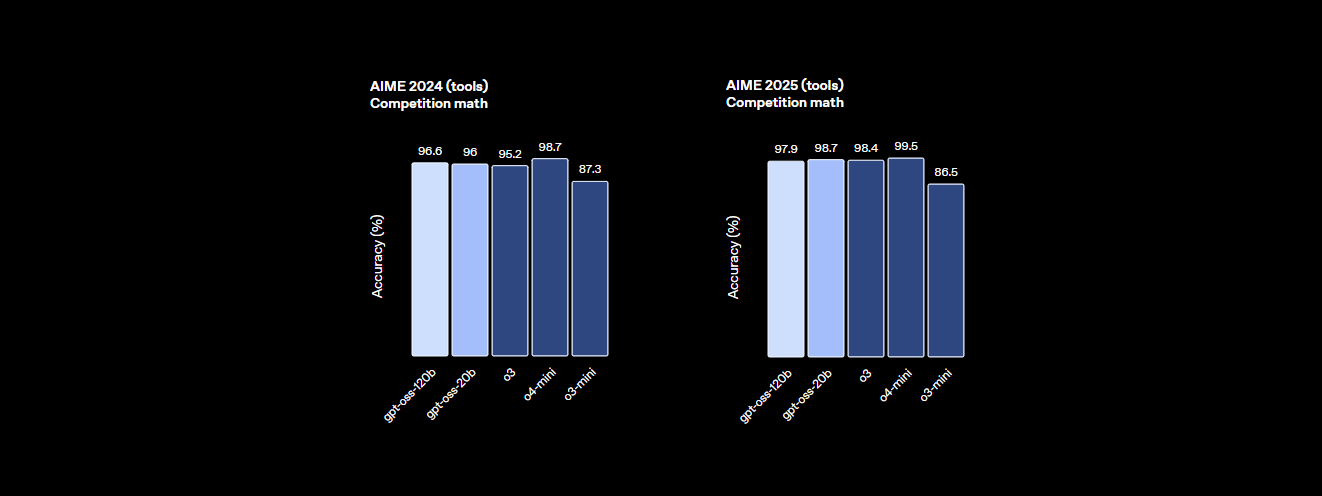

GPT-OSS-120B performans konusunda hiç de yavaş değil. Open AI'ın kıyaslama sonuçları, kendi o4-mini'si ve hatta Claude 3.5 Sonnet gibi tescilli modellere karşı ciddi bir rakip olduğunu gösteriyor. İşte detaylar:

- Akıl Yürütme Gücü: MMLU'da (Massive Multitask Language Understanding) %94.2 puan alıyor, GPT-4'ün %95.1'inin hemen altında ve AIME matematik yarışmalarında %96.6'lık bir başarı elde ederek birçok kapalı modeli geride bırakıyor.

- Kodlama Yeteneği: Codeforces'ta 2622 Elo derecesine sahip ve kod üretimi için HumanEval'de %87.3'lük bir geçiş oranı elde ederek kodlayıcıların en iyi dostu oluyor.

- Sağlık ve Araç Kullanımı: Sağlıkla ilgili sorgular için HealthBench'te o4-mini'yi geride bırakıyor ve zincirleme düşünce (CoT) akıl yürütme ve araç çağırma yetenekleri sayesinde TauBench gibi ajans görevlerinde mükemmel performans gösteriyor.

- Hız: Bir H100 GPU'da saniyede 45 token işlerken, Cerebras gibi sağlayıcılar yüksek hacimli ihtiyaçlar için saniyede 3.000 token'a kadar çıkabiliyor. OpenRouter, saniyede ~500 token sunarak birçok kapalı modeli geride bırakıyor.

Bu istatistikler, GPT-OSS-120B'nin açık ve özelleştirilebilir olmasına rağmen üst düzey tescilli modellerle neredeyse aynı performansı gösterdiğini ortaya koyuyor. Matematik, kodlama ve genel problem çözme için bir canavar ve riskleri düşük tutmak için düşmanca ince ayar ile güvenlik de sağlanmış durumda.

Fiyatlandırma: Uygun Fiyatlı ve Şeffaf

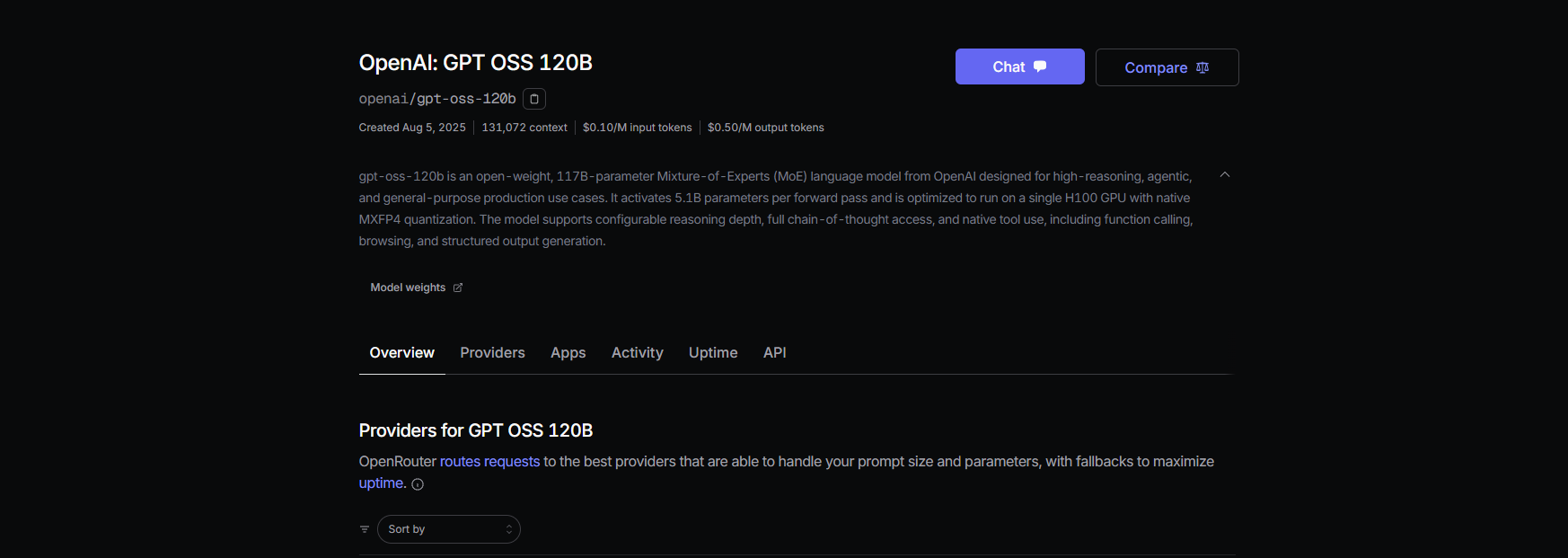

GPT-OSS-120B'nin en iyi yanlarından biri mi? Özellikle tescilli modellere kıyasla uygun maliyetli olması. İşte 131K bağlam penceresi için son verilere dayanarak başlıca sağlayıcılardaki dağılımı:

- Yerel Dağıtım: Kendi donanımınızda (örneğin, bir H100 GPU veya 80GB VRAM kurulumu) çalıştırarak sıfır API maliyeti elde edin. Bir GMKTEC EVO-X2 kurulumu ~2000 € maliyetlidir ve 200W'tan daha az enerji tüketir, gizliliğe öncelik veren küçük şirketler için mükemmeldir.

- Baseten: Giriş token'ı başına 0.10$/M, çıkış token'ı başına 0.50$/M. Gecikme: 0.20s, Verim: 491.1 token/sn. Maksimum çıkış: 131K token.

- Fireworks: Giriş token'ı başına 0.15$/M, çıkış token'ı başına 0.60$/M. Gecikme: 0.56s, Verim: 258.9 token/sn. Maksimum çıkış: 33K token.

- Together: Giriş token'ı başına 0.15$/M, çıkış token'ı başına 0.60$/M. Gecikme: 0.28s, Verim: 131.1 token/sn. Maksimum çıkış: 131K token.

- Parasail: Giriş token'ı başına 0.15$/M, çıkış token'ı başına 0.60$/M (FP4 nicelemesi). Gecikme: 0.40s, Verim: 94.3 token/sn. Maksimum çıkış: 131K token.

- Groq: Giriş token'ı başına 0.15$/M, çıkış token'ı başına 0.75$/M. Gecikme: 0.24s, Verim: 1,065 token/sn. Maksimum çıkış: 33K token.

- Cerebras: Giriş token'ı başına 0.25$/M, çıkış token'ı başına 0.69$/M. Gecikme: 0.42s, Verim: 1,515 token/sn. Maksimum çıkış: 33K token. Bazı kurulumlarda saniyede 3.000 token'a kadar ulaşarak yüksek hızlı ihtiyaçlar için idealdir.

GPT-OSS-120B ile, GPT-4'ün maliyetinin (yaklaşık 20.00$/M token) çok altında yüksek performans elde edersiniz; Groq ve Cerebras gibi sağlayıcılar gerçek zamanlı uygulamalar için son derece hızlı verim sunar.

GPT-OSS-120B'yi OpenRouter Aracılığıyla Cline ile Nasıl Kullanılır?

Kodlama projeleriniz için GPT-OSS-120B'nin gücünden yararlanmak ister misiniz? Claude Desktop ve Claude Code, Anthropic'in ekosistemine bağımlı olmaları nedeniyle GPT-OSS-120B gibi OpenAI modelleriyle doğrudan entegrasyonu desteklemezken, bu modeli OpenRouter API aracılığıyla ücretsiz, açık kaynaklı bir VS Code uzantısı olan Cline ile kolayca kullanabilirsiniz. Ayrıca, Cursor yakın zamanda Pro olmayan kullanıcılar için Kendi Anahtarını Getir (BYOK) seçeneğini kısıtlayarak Agent ve Düzenleme modları gibi özellikleri aylık 20 dolarlık bir aboneliğin arkasına kilitlemiştir, bu da Cline'ı BYOK kullanıcıları için daha esnek bir alternatif haline getirmektedir. İşte GPT-OSS-120B'yi Cline ve OpenRouter ile adım adım nasıl kuracağınız:

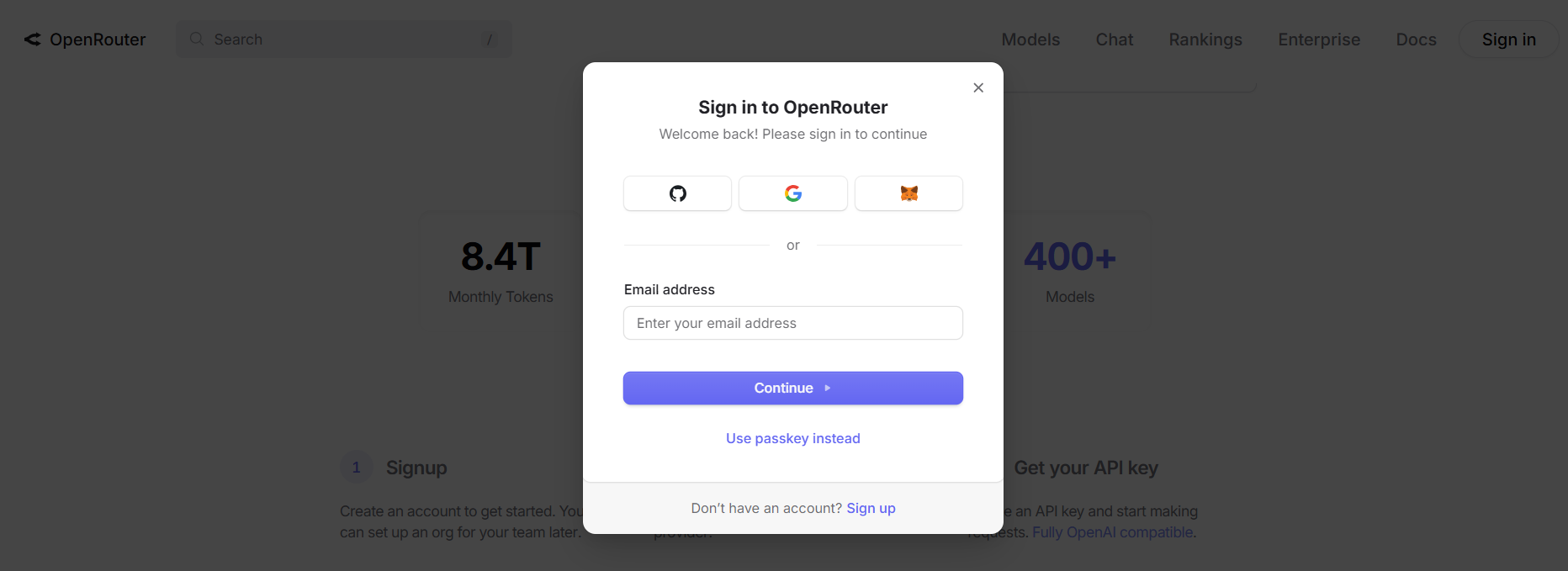

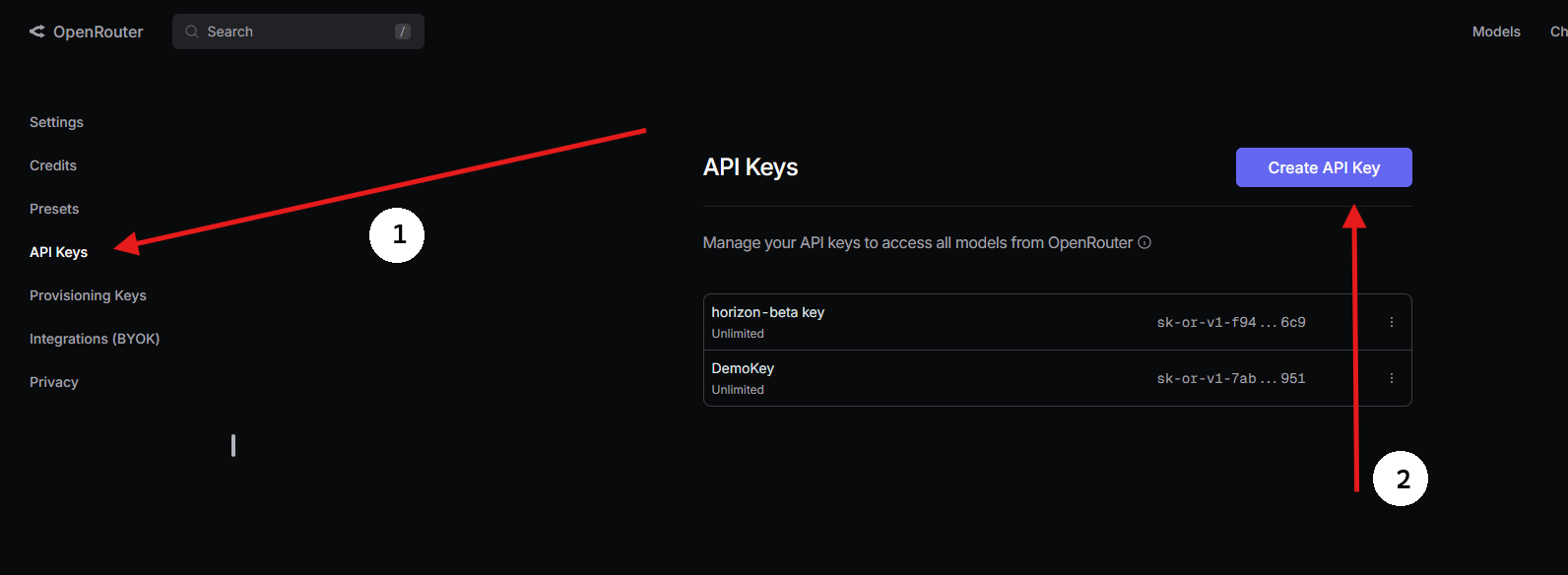

Adım 1: Bir OpenRouter API Anahtarı Alın

- OpenRouter'a Kaydolun:

- openrouter.ai adresini ziyaret edin ve Google veya GitHub kullanarak ücretsiz bir hesap oluşturun.

2. GPT-OSS-120B'yi Bulun:

- Modeller sekmesinde "gpt-oss-120b" aratın ve seçin.

3. Bir API Anahtarı Oluşturun:

- Anahtarlar bölümüne gidin, API Anahtarı Oluştur'a tıklayın, adlandırın (örneğin, "GPT-OSS-Cursor") ve kopyalayın. Güvenli bir yere kaydedin.

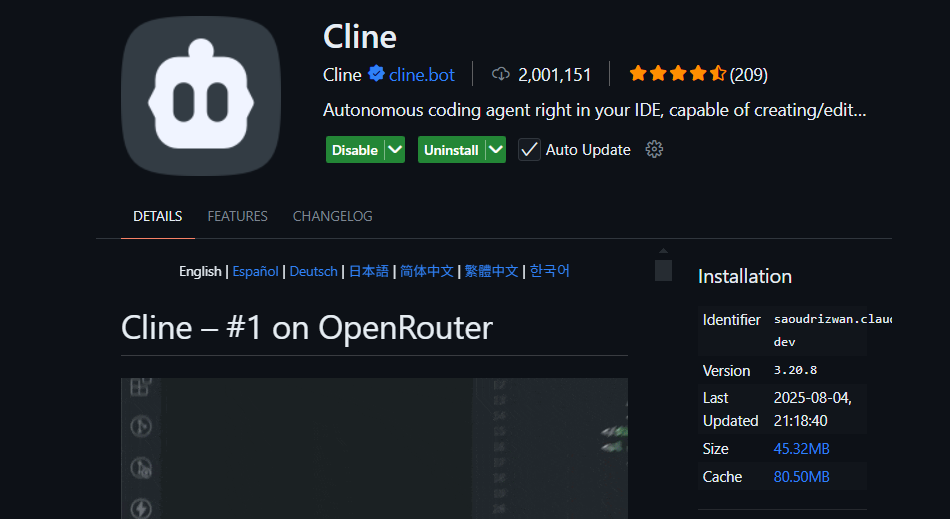

Adım 2: VS Code'da BYOK ile Cline Kullanın

Sınırsız BYOK erişimi için Cline (açık kaynaklı bir VS Code uzantısı) harika bir Cursor alternatifidir. OpenRouter aracılığıyla GPT-OSS-120B'yi özellik kısıtlamaları olmadan destekler. İşte nasıl kuracağınız:

- Cline'ı Kurun:

- VS Code'u açın (code.visualstudio.com).

- Uzantılar paneline gidin (

Ctrl+Shift+XveyaCmd+Shift+X). - "Cline" aratın ve kurun (nickbaumann98 tarafından, github.com/cline/cline).

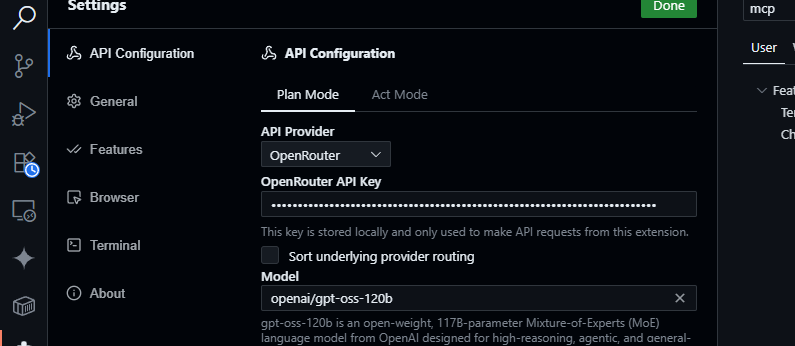

2. OpenRouter'ı Yapılandırın:

- Cline panelini açın (Etkinlik Çubuğundaki Cline simgesine tıklayın).

- Cline panelindeki dişli simgesine tıklayın.

- Sağlayıcı olarak OpenRouter'ı seçin.

- OpenRouter API anahtarınızı yapıştırın.

- Model olarak

openai/gpt-oss-120b'yi seçin.

3. Kaydet ve Test Et:

- Ayarları kaydedin. Cline sohbet panelinde şunu deneyin:

JSON verilerini ayrıştırmak için bir JavaScript fonksiyonu oluştur.

- Şuna benzer bir yanıt bekleyin:

function parseJSON(data) {

try {

return JSON.parse(data);

} catch (e) {

console.error("Invalid JSON:", e.message);

return null;

}

}

- Kod tabanı sorgularını test edin:

src/api/server.js dosyasını özetle.

- Cline, projenizi analiz edecek ve GPT-OSS-120B'nin 128K bağlam penceresini kullanarak bir özet döndürecektir.

Neden Cursor veya Claude Yerine Cline?

- Claude Entegrasyonu Yok: Claude Desktop ve Claude Code, Anthropic'in modellerine (örn. Claude 3.5 Sonnet) kilitlenmiştir ve ekosistem kısıtlamaları nedeniyle GPT-OSS-120B gibi OpenAI modellerini desteklemez.

- Cursor'ın BYOK Kısıtlamaları: Cursor'ın Pro olmayan kullanıcılar için BYOK'u yakın zamanda yasaklaması, geçerli bir OpenRouter API anahtarınız olsa bile Agent veya Düzenleme modlarına aylık 20 dolarlık bir abonelik olmadan erişemeyeceğiniz anlamına geliyor. Cline'ın böyle bir sınırı yoktur ve API anahtarınızla tüm özelliklere ücretsiz erişim sunar.

- Gizlilik ve Kontrol: Cline, istekleri doğrudan OpenRouter'a gönderir, üçüncü taraf sunucuları (Cursor'ın AWS yönlendirmesinin aksine) atlayarak gizliliği artırır.

Sorun Giderme İpuçları

- Geçersiz API Anahtarı mı? OpenRouter'ın panosunda anahtarınızı doğrulayın ve etkin olduğundan emin olun.

- Model Kullanılamıyor mu? OpenRouter'ın model listesinde openai/gpt-oss-120b'yi kontrol edin. Eksikse, Fireworks AI gibi sağlayıcıları deneyin veya OpenRouter desteğiyle iletişime geçin.

- Yavaş Yanıtlar mı? İnternet bağlantınızın stabil olduğundan emin olun. Daha hızlı performans için GPT-OSS-20B gibi daha hafif modelleri düşünün.

- Cline Hataları mı? Uzantılar paneli aracılığıyla Cline'ı güncelleyin ve VS Code'un Çıktı panelindeki günlükleri kontrol edin.

Neden GPT-OSS-120B Kullanmalısınız?

GPT-OSS-120B modeli, performans, esneklik ve maliyet verimliliğinin çekici bir karışımını sunarak geliştiriciler ve işletmeler için oyunun kurallarını değiştiren bir modeldir. İşte öne çıkan nedenleri:

- Açık Kaynak Özgürlüğü: Apache 2.0 lisansı altında, GPT-OSS-120B'yi kısıtlama olmaksızın ince ayar yapabilir, dağıtabilir veya ticarileştirebilirsiniz, bu da yapay zeka iş akışlarınız üzerinde tam kontrol sağlar.

- Maliyet Tasarrufu: Sıfır API maliyeti için tek bir H100 GPU'da veya tüketici donanımında (80GB VRAM) yerel olarak çalıştırın. OpenRouter aracılığıyla fiyatlandırma, giriş token'ı başına ~0.50$/M ve çıkış token'ı başına ~2.00$/M ile oldukça rekabetçidir; bu, GPT-4'ün ~20.00$/M token'ının bir kısmıdır ve yoğun kullanıcılar için %90'a varan tasarruf sunar. Groq (giriş token'ı başına 0.15$/M, çıkış token'ı başına 0.75$/M) ve Cerebras (giriş token'ı başına 0.25$/M, çıkış token'ı başına 0.69$/M) gibi diğer sağlayıcılar da maliyetleri düşük tutar.

- Performans: OpenAI'ın o4-mini'si ile neredeyse aynı performansı elde eder; MMLU'da %94.2, AIME matematikte %96.6 ve kodlama için HumanEval'de %87.3 puan alır. 128K token'lık bağlam penceresi (300-400 sayfa) devasa kod tabanlarını veya belgeleri kolaylıkla işler.

- Zincirleme Düşünce (CoT) Akıl Yürütme: Modelin tam CoT şeffaflığı, adım adım akıl yürütmesini görmenizi sağlar, bu da çıktıları hata ayıklamayı ve önyargıları veya hataları tespit etmeyi kolaylaştırır. Karmaşık matematik veya kodlama gibi görevler için sistem istemleri aracılığıyla (örneğin, "Akıl yürütme: yüksek") akıl yürütme çabasını (düşük, orta, yüksek) ayarlayarak hız ve derinlik arasında denge kurabilirsiniz. Bu denetimsiz CoT tasarımı, araştırmacıların model davranışını doğrudan denetim olmadan izlemelerine yardımcı olarak güveni ve güvenliği artırır.

- Ajans Yetenekleri: Web tarama ve Python kodu yürütme gibi araç kullanımına doğal destek, onu ajans iş akışları için ideal kılar. Veri toplama veya otomasyon gibi karmaşık görevler için birden fazla araç çağrısını (örneğin, bir demoda art arda 28 web araması) zincirleyebilir.

- Gizlilik: Tam veri kontrolü için yerel olarak (örneğin, Dell Enterprise Hub aracılığıyla) barındırın, işletmeler veya gizliliğe önem veren kullanıcılar için mükemmeldir.

- Esneklik: OpenRouter, Fireworks AI, Cerebras ve Ollama veya LM Studio gibi yerel kurulumlarla uyumlu olup, RTX GPU'lardan Apple Silicon'a kadar çeşitli donanımlarda çalışır.

X'teki topluluk vızıltısı, hızını (Cerebras'ta saniyede 1.515 token'a kadar) ve kodlama yeteneğini vurguluyor; geliştiriciler, çoklu dosya projelerini yönetme yeteneğini ve özelleştirme için açık ağırlıklı yapısını seviyorlar. İster yapay zeka ajanları inşa ediyor olun ister niş görevler için ince ayar yapıyor olun, GPT-OSS-120B eşsiz bir değer sunuyor.

Sonuç

Open AI'ın GPT-OSS-120B'si, üst düzey performansı uygun maliyetli dağıtımla birleştiren devrim niteliğinde bir açık ağırlıklı modeldir. Kıyaslama sonuçları tescilli modellere rakip, fiyatlandırması uygun ve OpenRouter'ın API'si aracılığıyla Cursor veya Cline ile entegrasyonu kolaydır. İster kodlama, ister hata ayıklama, ister karmaşık sorunlar üzerinde akıl yürütme olsun, bu model işinizi görür. Deneyin, 128K bağlam penceresiyle deneyler yapın ve yorumlarda harika kullanım senaryolarınızı bize bildirin – merakla bekliyorum!

Daha fazla ayrıntı için github.com/openai/gpt-oss adresindeki depoyu veya openai.com adresindeki Open AI duyurusunu inceleyebilirsiniz.

Geliştirici Ekibinizin maksimum verimlilikle birlikte çalışması için entegre, Hepsi Bir Arada bir platform mu istiyorsunuz?

Apidog tüm taleplerinizi karşılıyor ve Postman'ı çok daha uygun bir fiyata değiştiriyor!