Dünya genelindeki geliştiriciler, iş akışlarını kolaylaştırmak ve karmaşık programlama görevlerinin üstesinden gelmek için OpenAI'ın güçlü yapay zeka destekli kodlama asistanı CodeX'e güveniyor. Ancak, X gibi platformlardaki son tartışmalar artan bir endişeyi ortaya koyuyor: birçok kullanıcı CodeX'in başlangıçtaki performansına kıyasla yetersiz sonuçlar verdiğini düşünüyor. Sinir bozucu hatalarla, daha yavaş yanıtlarla veya eksik kod önerileriyle karşılaşıyorsunuz ve aracın gerçekten kötüleşip kötüleşmediğini sorguluyorsunuz. OpenAI'ın sürekli iyileştirme iddialarına ve kullanımda artış gösteren metriklerine rağmen bu algı devam ediyor.

Mühendisler, CodeX'in yama uygulama veya uzun konuşmaları yönetme gibi karmaşık görevlerde zorlandığı durumları bildiriyor ve bu da performans düşüşü varsayımlarına yol açıyor. Ancak, OpenAI ekibi bu sorunları titiz soruşturmalarla aktif olarak ele alıyor ve şeffaflığa olan bağlılığını gösteriyor. Örneğin, kısa süre önce kullanıcı geri bildirimlerinden ve dahili değerlendirmelerden elde edilen bulguları özetleyen ayrıntılı bir rapor yayınladılar.

CodeX'i Anlamak: Temel İşlevselliği ve Evrimi

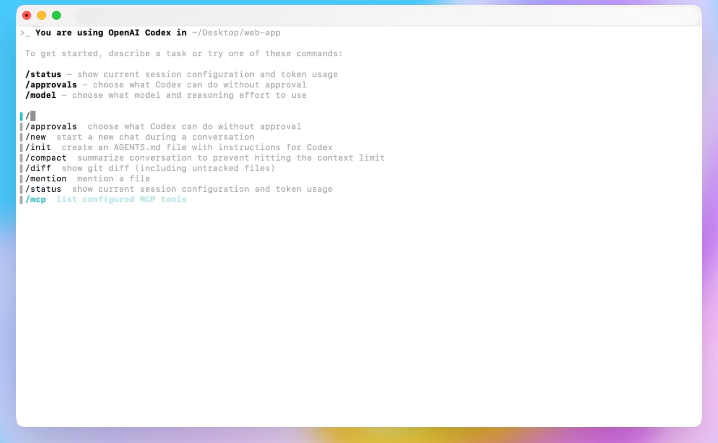

CodeX, OpenAI'ın büyük dil modellerindeki temeli üzerine inşa edilen, yapay zeka destekli programlamada önemli bir ilerlemeyi temsil ediyor. Mühendisler CodeX'i doğal dil istemlerini yorumlamak ve kod parçacıkları oluşturmak, sorunları ayıklamak ve hatta tüm depoları yönetmek için tasarladı. Geleneksel IDE eklentilerinin aksine, CodeX komut satırı arayüzleri ve editörlerle derinlemesine entegre olarak sorunsuz etkileşimlere olanak tanır.

OpenAI, CodeX'i Codex gibi önceki modellerin bir evrimi olarak, GPT-5 mimarisinden gelen geliştirmeleri dahil ederek piyasaya sürdü. Bu yineleme, kalıcılığa odaklanarak yapay zekanın görevleri yeniden denemesini ve oturumlar içinde kullanıcı geri bildirimlerine uyum sağlamasını sağlıyor. Sonuç olarak, geliştiriciler CodeX'i basit betik yazımından karmaşık sistem entegrasyonlarına kadar çeşitli uygulamalar için kullanıyor.

Ancak, benimsenme arttıkça, kullanıcılar CodeX'in sınırlarını zorluyor. Örneğin, başlangıçtaki görevler temel işlevleri içerebilirken, ileri düzey kullanıcılar çoklu dosya düzenlemeleri veya API orkestrasyonları deniyor. Bu değişim sınırlamaları ortaya çıkarıyor ve performans tutarlılığı hakkında soruları gündeme getiriyor.

Ayrıca, CodeX dosya değişiklikleri için apply_patch ve bağlam yönetimi için sıkıştırma (compaction) gibi araçları kullanır. Bu özellikler kullanılabilirliği artırır ancak sonuçları etkileyen değişkenleri de beraberinde getirir. Bir istem girdiğinizde, CodeX bunu belirteçleri (token) akışla ileten ve sonuçları ayrıştıran bir yanıt API'si aracılığıyla işler. Bu süreçteki herhangi bir tutarsızlık, algılanan bir 'basitleşme' (dumbing down) olarak ortaya çıkabilir.

Kullanıcı Raporları: CodeX'in Düşük Performans Gösterdiğine Dair İşaretler

Kullanıcılar, CodeX'in beklentileri karşılayamadığı durumları vurgulayarak sosyal platformlarda deneyimlerini aktif olarak paylaşıyor. Örneğin, X'teki bir geliştirici, CodeX'in başlangıçtaki görevlerde başarılı olduğunu ancak artan karmaşıklıkla zorlandığını ve bunun da modelin bozulduğu varsayımlarına yol açtığını belirtti.

Özellikle, raporlar CodeX'in yama uygulamaları sırasında yanlış farklar (diff) oluşturduğunu, bunun da dosya silme ve yeniden oluşturmalara yol açtığını içeriyor. Bu davranış, özellikle kesintiye uğrayan oturumlarda iş akışlarını aksatıyor. Bir diğer yaygın şikayet gecikme (latency) ile ilgili; bir zamanlar hızla tamamlanan görevler, uzun süreli zaman aşımları ve yeniden denemeler nedeniyle artık uzuyor.

Dahası, kullanıcılar yanıtın ortasında İngilizceden Koreceye geçiş gibi dil değişiklikleri gözlemliyor; bu durum kısıtlı örneklemedeki (constrained sampling) hatalara bağlanıyor. Bu anormallikler oturumların %0,25'inden daha azını etkilese de, karşılaşıldığında hayal kırıklığını artırıyor.

Ek olarak, bağlamı yönetmek için konuşmaları özetleyen bir özellik olan sıkıştırma (compaction) eleştiri alıyor. Oturumlar uzadıkça, birden fazla sıkıştırma doğruluğu düşürüyor ve OpenAI'ı uyarılar eklemeye sevk ediyor: hedeflenen etkileşimler için yeni konuşmalar başlatın.

Ayrıca, donanım farklılıkları da katkıda bulunuyor; eski kurulumlar hafif performans düşüşleri yaşatarak kullanıcı tutma oranını etkiliyor. Premium planlardaki geliştiriciler tutarsızlıklar bildiriyor, ancak metrikler genel bir büyüme gösteriyor.

Bu raporlardan yola çıkarak, nicel kanıtları analiz etmek, bu sorunların gerçek bir bozulmayı mı yoksa gelişen bir kullanımı mı gösterdiği konusunda netlik sağlıyor.

Kanıtları Analiz Etmek: Metrikler, Geri Bildirim ve Kullanım Desenleri

OpenAI, CodeX performansına ilişkin kapsamlı veriler topluyor; buna CLI sürümleri ve donanımlar arasındaki değerlendirmeler (evals) de dahil. Değerlendirmeler, CLI 0.45 güncellemelerinden sonra belirteç (token) kullanımında %10'luk bir azalma gibi iyileştirmeleri, temel görevlerde herhangi bir gerileme olmaksızın doğruluyor.

Ancak, /feedback komutu aracılığıyla kullanıcı geri bildirimleri eğilimleri ortaya koyuyor. Mühendisler her gün 100'den fazla sorunu önceliklendiriyor ve bunları belirli donanımlara veya özelliklere bağlıyor. Tahmine dayalı modeller, kullanıcı tutma oranını işletim sistemi ve plan türü gibi faktörlerle ilişkilendiriyor ve donanımı küçük bir suçlu olarak belirliyor.

Ek olarak, oturum analizi zamanla artan sıkıştırma (compaction) kullanımını gösteriyor ve bu da performans düşüşleriyle ilişkili. Değerlendirmeler bunu nicel olarak ortaya koyuyor: tekrarlanan sıkıştırmalarla doğruluk azalıyor.

Ayrıca, web arama entegrasyonu (--search) ve iki ay boyunca yapılan istem (prompt) değişiklikleri olumsuz bir etki göstermiyor. Ancak, kimlik doğrulama önbelleği verimsizlikleri istek başına 50 ms gecikme ekleyerek kullanıcı algılarını artırıyor.

Dahası, kullanım gelişiyor; daha fazla geliştirici MCP araçlarını kullanıyor, bu da kurulum karmaşıklığını artırıyor. OpenAI, optimum sonuçlar için minimalist yapılandırmalar öneriyor.

Sonuç olarak, kanıtlar algıların CodeX'i daha zor görevlerde zorlamaktan kaynaklandığını, doğuştan gelen bir 'basitleşmeden' değil. Bir X kullanıcısının özetlediği gibi, "codex o kadar iyi ki insanlar onu daha zor görevler için kullanmaya devam etti ve bu görevlerde o kadar iyi performans göstermedi, sonra da insanlar modelin kötüleştiğini varsaydılar."

Bu analiz, OpenAI'ın bu noktalara doğrudan değinen soruşturma yanıtının zeminini hazırlıyor.

OpenAI'ın Yanıtı: CodeX Performansına Yönelik Şeffaf Soruşturma

OpenAI şeffaflığa bağlı kalıyor ve performans düşüşü raporlarını ciddiyetle soruşturma sözü veriyor. Codex ekibi üyesi Tibo, X'te soruşturmayı duyurdu ve geri bildirim mekanizmalarını yükseltme, dahili kullanımı standartlaştırma ve ek değerlendirmeler (evals) yapma planını özetledi.

Mühendisler hızla harekete geçti ve geliştirilmiş /feedback özelliğine sahip CLI 0.50'yi yayınlayarak sorunları kümelere ve donanımlara bağladı. Yığını basitleştirerek 60'tan fazla özellik bayrağını kaldırdılar.

Dahası, özel bir ekip her gün sorunları hipotezleştirdi ve test etti. Bu yaklaşım, eski donanımları kullanımdan kaldırmaktan sıkıştırmayı (compaction) iyileştirmeye kadar çözümler ortaya çıkardı.

Ek olarak, OpenAI "Codex Makinesindeki Hayaletler" başlıklı kapsamlı bir rapor paylaştı; bu rapor, büyük gerilemeler olmaksızın bulguları detaylandırıyor ancak birleşik faktörleri kabul ediyor.

Ayrıca, bir faturalandırma hatası nedeniyle oran limitlerini sıfırladılar ve kredileri iade ettiler, böylece kullanıcı odaklı eylemler sergilediler.

Detaylara geçecek olursak, raporun temel bulguları kullanıcı endişelerinin arkasındaki teknik incelikleri aydınlatıyor.

OpenAI'ın CodeX Performans Düşüşü Raporundan Temel Bulgular

Rapor, tek bir büyük sorunun olmadığını; bunun yerine davranış değişiklikleri ve küçük sorunların biriktiğini belirtiyor. Donanım için, değerlendirmeler (evals) ve modeller eski birimleri işaret etti ve bu da onların kaldırılmasına ve yük dengeleme optimizasyonlarına yol açtı.

Sıkıştırma (compaction) konusunda, zamanla artan sıklık oturumları kötüleştiriyor. OpenAI, özyinelemeli özetleri önlemek için uygulamaları iyileştirdi ve kullanıcı uyarıları ekledi.

apply_patch için, nadir görülen hatalar riskli silmelere yol açıyor; hafifletmeler bu tür dizileri sınırlıyor ve model geliştirmeleri planlanıyor.

Zaman aşımlarında geniş çaplı bir gerileme görülmüyor — gecikme (latency) iyileşiyor — ancak verimsiz yeniden denemeler devam ediyor. Yatırımlar, daha iyi uzun süreç yönetimine odaklanıyor.

Kısıtlı örnekleme (constrained sampling) hatası, dağıtım dışı belirteçlere (tokens) neden oluyor, yakında düzeltilecek.

Yanıtlar API denetimleri, performans etkisi olmayan küçük kodlama değişikliklerini ortaya koyuyor.

CLI sürümleri ve istemler üzerindeki değerlendirmeler (evals) gibi diğer araştırmalar, istikrarı doğruluyor.

Dahası, daha fazla araçla gelişen kurulumlar basitliği öneriyor.

Bu bulgular, kullanıcı deneyimlerini doğrularken genel bir 'basitleşme' olmadığını da kanıtlıyor.

Uygulanan İyileştirmeler ve CodeX İçin Gelecek Yönelimler

OpenAI, bulgulara göre hareket ederek sıkıştırma (compaction) uyarıları ve örnekleme düzeltmeleri gibi düzeltmeleri kullanıma sunuyor. Donanım temizlemeleri ve gecikme (latency) azaltmaları güvenilirliği artırıyor.

Dahası, gerçek dünya performansını izlemek için kalıcı bir ekip kuruyorlar ve devam eden optimizasyonlar için yetenekli kişileri işe alıyorlar.

Ek olarak, geri bildirim sosyalleşmesi artırılarak sürekli girdi sağlanıyor.

Gelecekteki çalışmalar arasında model kalıcılığı iyileştirmeleri ve araç uyarlanabilirliği yer alıyor.

Sonuç olarak, CodeX veri odaklı geliştirmelerle algıları ele alarak evriliyor.

Ancak, bunları beklerken, geliştiriciler Apidog gibi tamamlayıcılar arıyor.

Tamamlayıcı Araçlar: Apidog CodeX İş Akışlarını Nasıl Geliştirir?

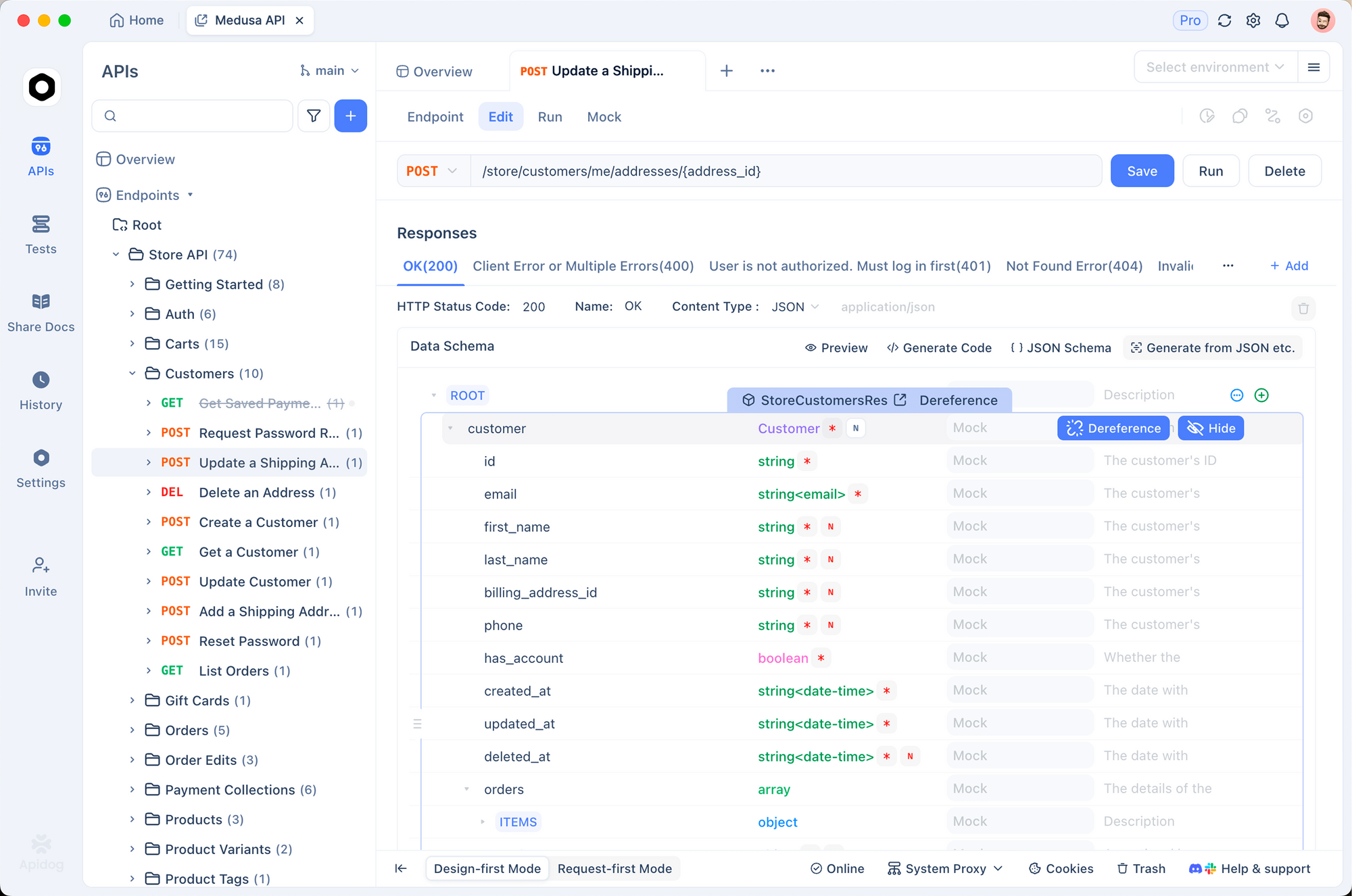

CodeX API görevlerini ele aldığında, özellikle entegrasyonlarda tutarsızlıklar ortaya çıkıyor. Sağlam bir API platformu olan Apidog, bu boşluğu dolduruyor.

Geliştiriciler, CodeX tarafından oluşturulan kodun doğru çalıştığından emin olmak için API'leri tasarlamak, test etmek ve belgelemek için Apidog'u kullanır.

Örneğin, CodeX uygulamadan önce Apidog'da uç noktaları simüle ederek hataları azaltın.

Dahası, Apidog'un ücretsiz indirme sürümü işbirliği özellikleri, sürüm kontrolü ve otomasyon sunar; bu da CodeX sınırlamalarıyla karşılaşan ekipler için idealdir.

Sorunsuz bir geçişle, Apidog kodlama ortamlarıyla entegre olur ve yapay zeka çıktılarını doğrular.

Böylece, CodeX'i Apidog ile eşleştirmek geliştirmeyi optimize eder ve algılanan performans düşüşlerini hafifletir.

Vaka Çalışmaları: X Tartışmalarından Gerçek Dünya Örnekleri

X başlıkları canlı örnekler sunuyor. Bir kullanıcı, CodeX'in başarısının aşırı hırs yarattığını vurgulayarak raporun kullanım evrimini yansıttı.

Bir diğeri CLI hızını tartıştı, hızlı görevler için alternatiflere geçerek gecikme (latency) endişelerini vurguladı.

Ayrıca, faturalandırma sıfırlamaları fazla ücretlendirmeleri gidererek güveni yeniden sağladı.

Bu anekdotlar, rapor verileriyle birleştiğinde, çok yönlü sorunları göstermektedir.

CodeX Performansını En Üst Düzeye Çıkarmak İçin En İyi Uygulamalar

Algıları tersine çevirmek için şu uygulamaları benimseyin: oturumları kısa tutun, araçları minimize edin, /feedback kullanın.

Dahası, güncellemeleri izleyin; CLI iyileştirmeleri sonuçları doğrudan etkiler.

Ek olarak, hassasiyet için istemlerle (prompt) deney yapın.

Sonuç olarak, bu adımlar deneyimleri iyileştirir.

Sonuç: CodeX'te ve Ötesinde Değişimi Kucaklamak

Kullanıcılar CodeX'i karmaşık görevler ve küçük sorunlar nedeniyle daha 'basit' olarak algılıyor, ancak kanıtlar bir gerileme değil, evrim gösteriyor. OpenAI'ın soruşturması ve düzeltmeleri bağlılığı teyit ediyor.

Dahası, Apidog'u entegre etmek esnek iş akışları sağlar.

Sonuç olarak, stratejileri uyarlayın, araçlardan yararlanın ve geri bildirimde bulunun — küçük ayarlamalar üretkenlikte önemli kazançlar sağlar.