การรันโมเดลภาษาขนาดใหญ่ (LLMs) บนเครื่องคอมพิวเตอร์ส่วนตัวเคยเป็นเรื่องเฉพาะทางสำหรับผู้ใช้ CLI (Command Line Interface) ระดับฮาร์ดคอร์และนักปรับแต่งระบบ แต่สิ่งนี้กำลังเปลี่ยนแปลงไปอย่างรวดเร็ว Ollama ซึ่งเป็นที่รู้จักจากอินเทอร์เฟซบรรทัดคำสั่งที่ใช้งานง่ายสำหรับการรัน LLMs แบบโอเพนซอร์สบนเครื่องคอมพิวเตอร์ส่วนตัว เพิ่งเปิดตัวแอปพลิเคชันเดสก์ท็อปแบบเนทีฟสำหรับ macOS และ Windows

และแอปเหล่านี้ไม่ใช่แค่ส่วนห่อหุ้มพื้นฐานเท่านั้น แอปเหล่านี้มาพร้อมกับฟีเจอร์อันทรงพลังที่ทำให้การสนทนากับโมเดล การวิเคราะห์เอกสาร การเขียนเอกสารประกอบ และแม้กระทั่งการทำงานกับรูปภาพ เป็นเรื่องที่ง่ายขึ้นอย่างมากสำหรับนักพัฒนา

ในบทความนี้ เราจะมาสำรวจว่าประสบการณ์เดสก์ท็อปใหม่นี้ช่วยปรับปรุงขั้นตอนการทำงานของนักพัฒนาได้อย่างไร ฟีเจอร์ใดที่โดดเด่น และเครื่องมือเหล่านี้มีประโยชน์อย่างแท้จริงในชีวิตการเขียนโค้ดประจำวันอย่างไร

ทำไม LLMs บนเครื่องส่วนตัวยังคงมีความสำคัญ

ในขณะที่เครื่องมือบนคลาวด์อย่าง ChatGPT, Claude และ Gemini ครองพื้นที่ข่าว มีการเคลื่อนไหวที่เพิ่มขึ้นไปสู่การพัฒนา AI แบบ Local-first (เน้นการทำงานบนเครื่องส่วนตัวก่อน) นักพัฒนาต้องการเครื่องมือที่:

- เป็นส่วนตัว - โค้ดและเอกสารของคุณยังคงอยู่ในเครื่องของคุณ

- ปรับแต่งได้ - คุณสามารถเลือกโมเดล, ข้อจำกัดหน่วยความจำ และฮาร์ดแวร์ได้เอง

- ทำงานแบบออฟไลน์ได้ - ไม่ต้องพึ่งพา API ภายนอกหรือความพร้อมใช้งานของเซิร์ฟเวอร์

- รวดเร็ว - ไม่มีปัญหาเรื่องความหน่วงของเครือข่ายหรือคอขวดของเซิร์ฟเวอร์

Ollama ตอบสนองเทรนด์นี้โดยตรง ช่วยให้คุณสามารถรันโมเดลอย่าง LLaMA, Mistral, Gemma, Codellama, Mixtral และอื่น ๆ ได้โดยตรงบนเครื่องของคุณ และตอนนี้มาพร้อมกับประสบการณ์ที่ราบรื่นยิ่งขึ้น

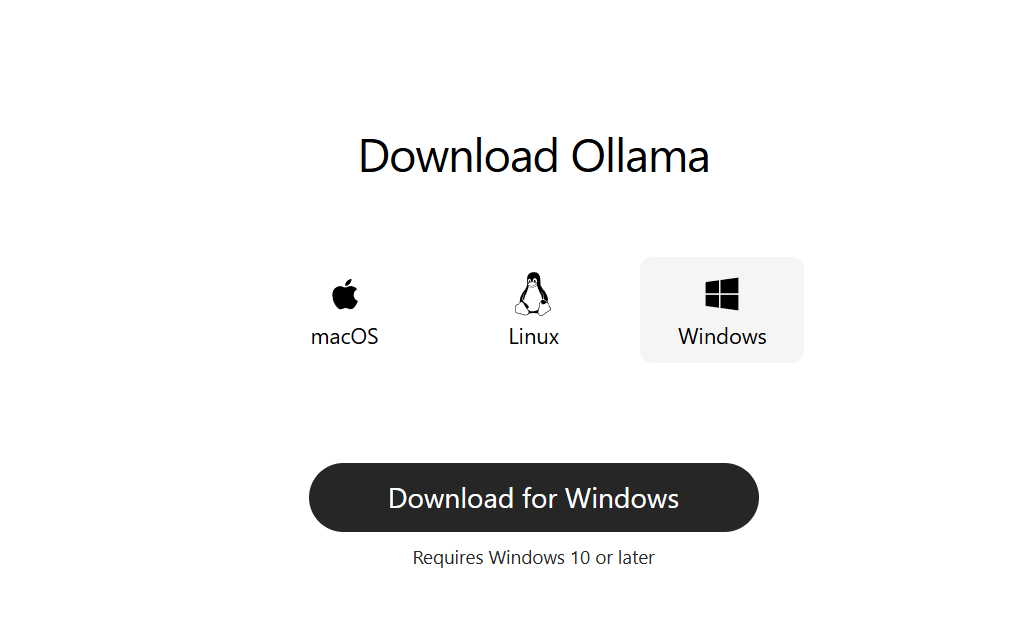

ขั้นตอนที่ 1: ดาวน์โหลด Ollama สำหรับเดสก์ท็อป

ไปที่ ollama.com และดาวน์โหลดเวอร์ชันล่าสุดสำหรับระบบของคุณ:

- macOS (Apple Silicon หรือ Intel)

- Windows 10/11 (x64)

ติดตั้งเหมือนแอปพลิเคชันเดสก์ท็อปทั่วไป ไม่จำเป็นต้องตั้งค่าผ่านบรรทัดคำสั่งเพื่อเริ่มต้นใช้งาน

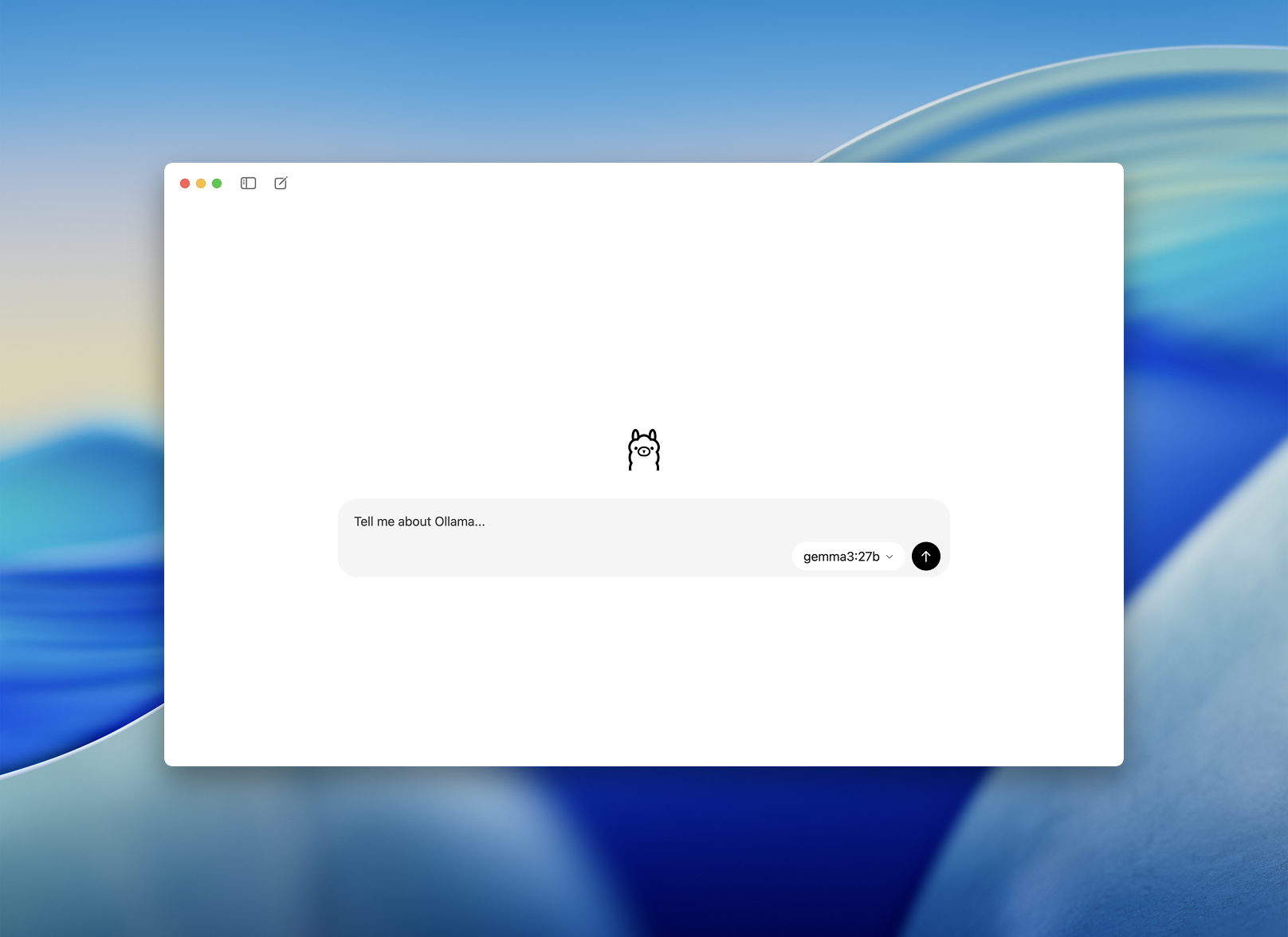

ขั้นตอนที่ 2: เปิดใช้งานและเลือกโมเดล

เมื่อติดตั้งแล้ว ให้เปิดแอป Ollama บนเดสก์ท็อป อินเทอร์เฟซดูสะอาดตาและเหมือนหน้าต่างแชททั่วไป

คุณจะได้รับข้อความแจ้งให้ เลือกโมเดล เพื่อดาวน์โหลดและรัน ตัวเลือกบางส่วนได้แก่:

llama3– ผู้ช่วยอเนกประสงค์codellama– ยอดเยี่ยมสำหรับการสร้างโค้ดและการปรับโครงสร้างโค้ด (refactoring)mistral– รวดเร็ว ขนาดเล็ก และแม่นยำgemma– โมเดลแบบ open-weight ที่ได้รับการสนับสนุนจาก Google

เลือกหนึ่งโมเดล แล้วแอปจะดาวน์โหลดและโหลดให้โดยอัตโนมัติ

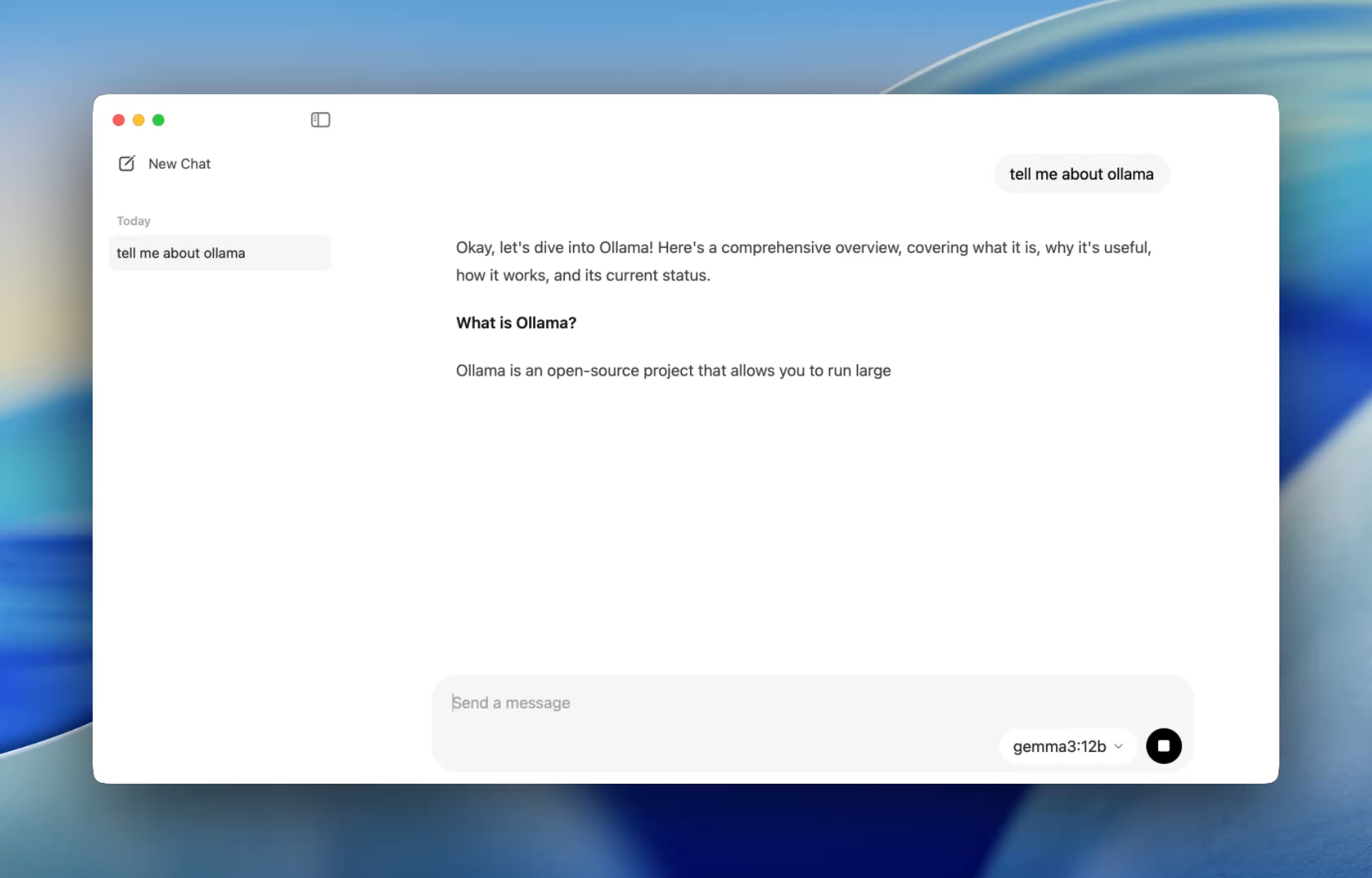

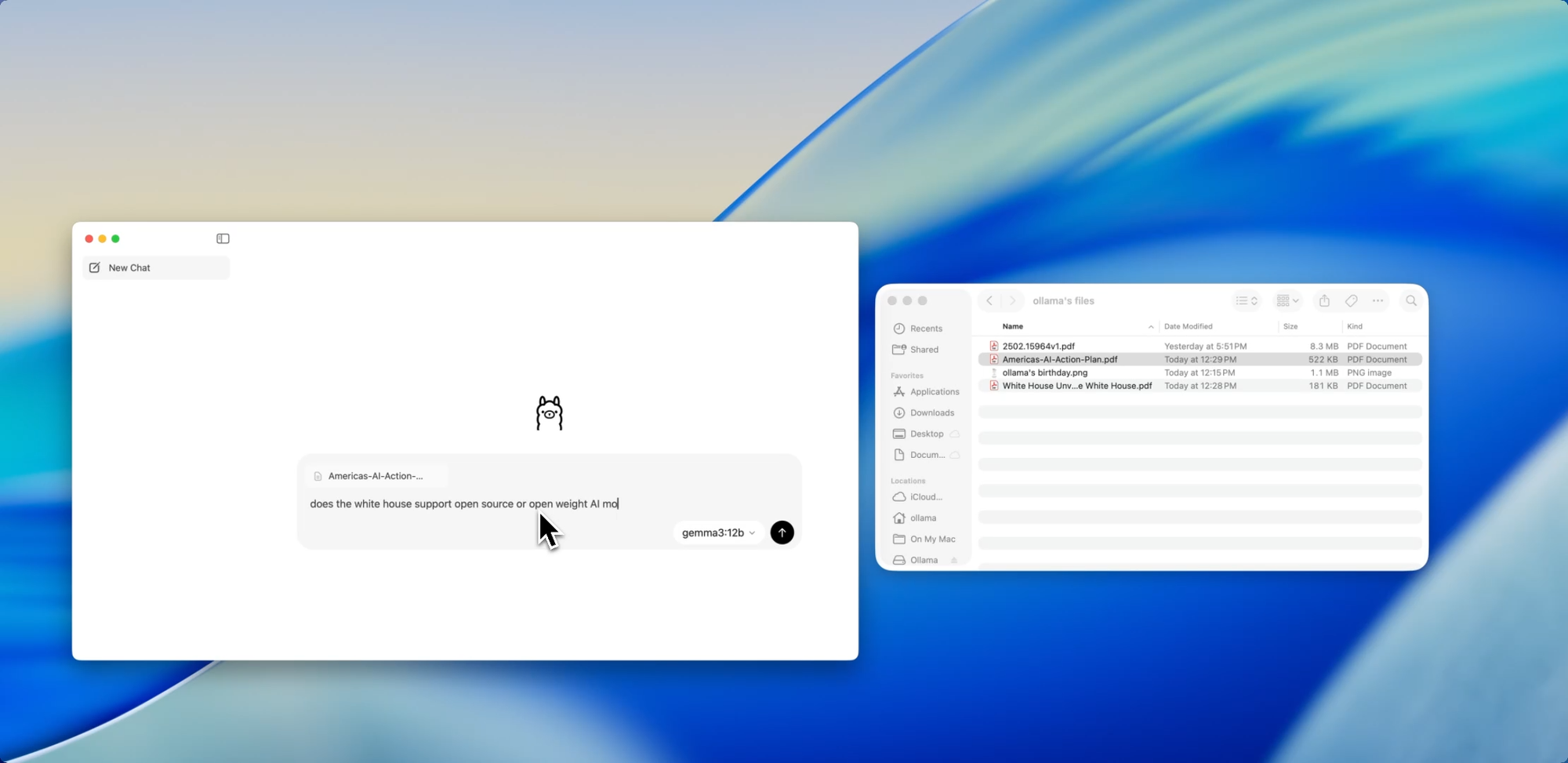

การเริ่มต้นใช้งานที่ราบรื่นขึ้นสำหรับนักพัฒนา - วิธีที่ง่ายขึ้นในการสนทนากับโมเดล

ก่อนหน้านี้ การใช้ Ollama หมายถึงการเปิดเทอร์มินัลและป้อนคำสั่ง ollama run เพื่อเริ่มเซสชันโมเดล แต่ตอนนี้ แอปเดสก์ท็อปสามารถเปิดใช้งานได้เหมือนแอปพลิเคชันเนทีฟทั่วไป พร้อมอินเทอร์เฟซการแชทที่เรียบง่ายและสะอาดตา

ตอนนี้คุณสามารถสนทนากับโมเดลได้เช่นเดียวกับที่คุณทำใน ChatGPT — แต่ทำงานแบบออฟไลน์ได้อย่างสมบูรณ์ เหมาะอย่างยิ่งสำหรับ:

- การช่วยเหลือในการรีวิวโค้ด

- การสร้างชุดทดสอบ

- เคล็ดลับการปรับโครงสร้างโค้ด

- การเรียนรู้ API หรือภาษาใหม่ ๆ

แอปนี้ช่วยให้คุณเข้าถึงโมเดลบนเครื่องส่วนตัวได้ทันที เช่น codellama หรือ mistral โดยไม่ต้องตั้งค่าอะไรเพิ่มเติม นอกจากการติดตั้งง่าย ๆ

และสำหรับนักพัฒนาที่ชื่นชอบการปรับแต่ง CLI ยังคงทำงานอยู่เบื้องหลัง ทำให้คุณสามารถปรับเปลี่ยนความยาวของบริบท (context length), system prompts และเวอร์ชันของโมเดลผ่านเทอร์มินัลได้หากจำเป็น

ลาก. วาง. ถามคำถาม.

สนทนากับไฟล์

หนึ่งในฟีเจอร์ที่นักพัฒนาชื่นชอบมากที่สุดในแอปใหม่นี้คือ การนำเข้าไฟล์ (file ingestion) เพียงแค่ลากไฟล์ ไม่ว่าจะเป็น .pdf, .md หรือ .txt ลงในหน้าต่างแชท โมเดลก็จะอ่านเนื้อหาของไฟล์นั้น

ต้องการทำความเข้าใจเอกสารการออกแบบ 60 หน้าหรือไม่? ต้องการดึงรายการสิ่งที่ต้องทำ (TODOs) ออกจากไฟล์ README ที่ยุ่งเหยิง? หรือสรุปข้อมูลสรุปผลิตภัณฑ์ของลูกค้า? เพียงลากไฟล์เข้ามาแล้วถามคำถามด้วยภาษาธรรมชาติ เช่น:

- “คุณสมบัติหลักที่กล่าวถึงในเอกสารนี้มีอะไรบ้าง?”

- “สรุปเอกสารนี้ในหนึ่งย่อหน้า”

- “มีส่วนใดขาดหายไปหรือมีความไม่สอดคล้องกันหรือไม่?”

ฟีเจอร์นี้สามารถช่วยลดเวลาในการอ่านเอกสาร, ตรวจสอบข้อกำหนด หรือการเริ่มต้นโปรเจกต์ใหม่ได้อย่างมาก

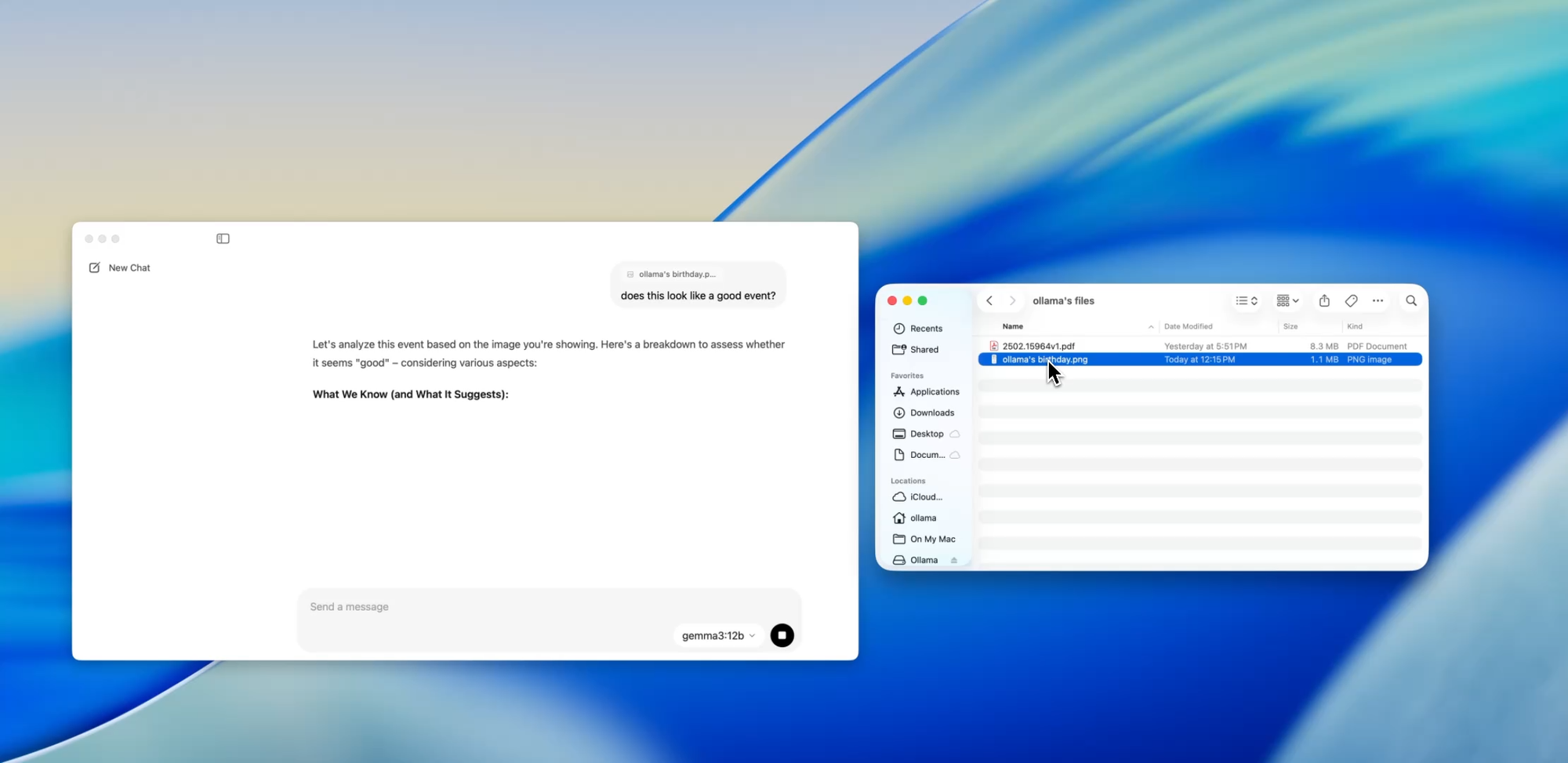

ก้าวข้ามข้อความ

การรองรับหลายรูปแบบ (Multimodal Support)

โมเดลบางตัวใน Ollama (เช่น โมเดลที่ใช้ Llava) ตอนนี้รองรับ การป้อนข้อมูลด้วยรูปภาพ ซึ่งหมายความว่าคุณสามารถอัปโหลดรูปภาพ แล้วโมเดลจะตีความและตอบสนองต่อรูปภาพนั้นได้

กรณีการใช้งานบางส่วนได้แก่:

- การอ่านแผนภาพหรือแผนภูมิจากภาพหน้าจอ

- การอธิบาย UI mockups

- การตรวจสอบบันทึกที่เขียนด้วยลายมือที่สแกน

- การวิเคราะห์อินโฟกราฟิกง่าย ๆ

แม้ว่าสิ่งนี้ยังคงอยู่ในช่วงเริ่มต้นเมื่อเทียบกับเครื่องมืออย่าง GPT-4 Vision แต่การมี Multimodal support ในแอปพลิเคชันแบบ Local-first ถือเป็นก้าวสำคัญสำหรับนักพัฒนาที่สร้างระบบป้อนข้อมูลหลายรูปแบบ หรือทดสอบอินเทอร์เฟซ AI

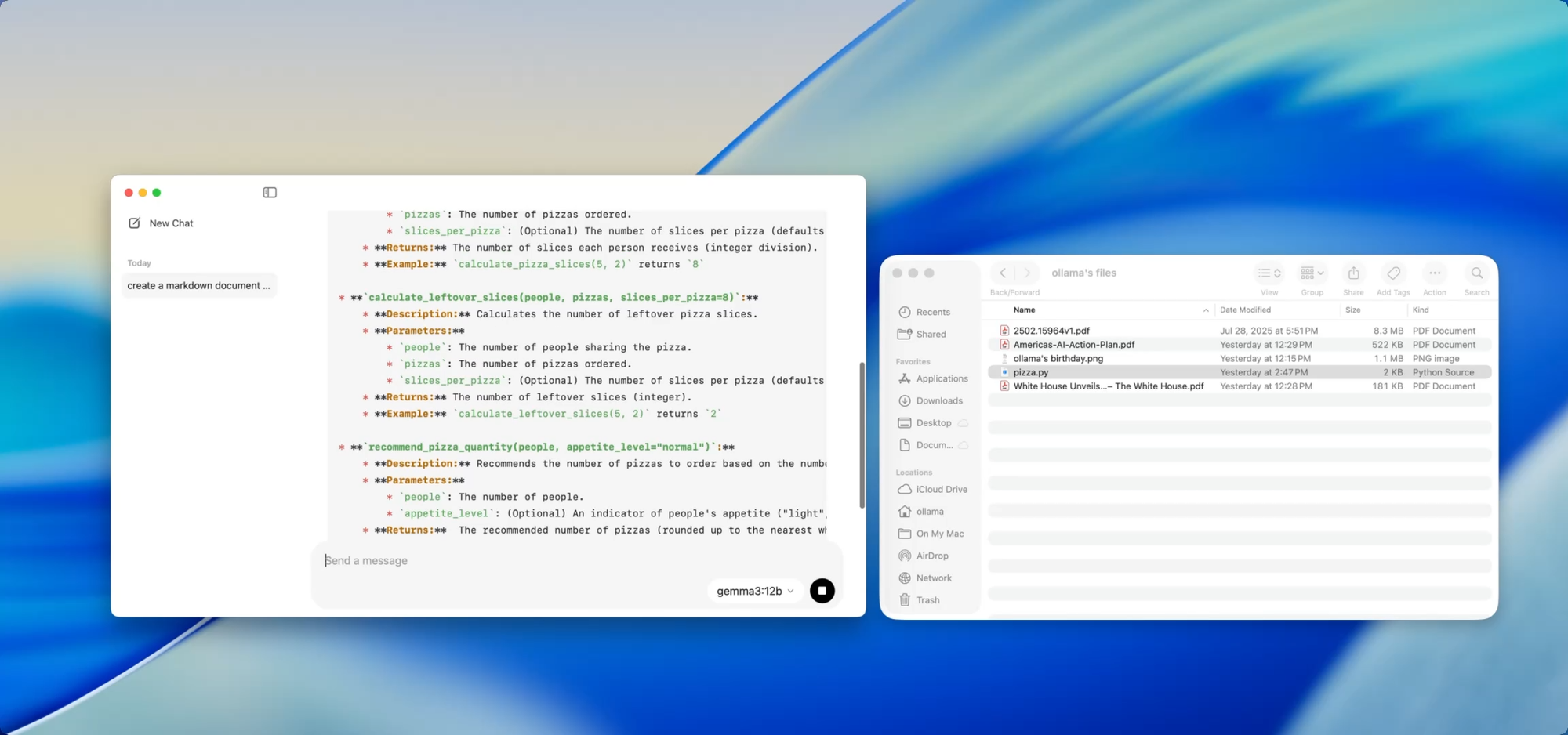

เอกสารส่วนตัวบนเครื่อง — ตามคำสั่งของคุณ

การเขียนเอกสารประกอบ

หากคุณกำลังดูแลโค้ดเบสที่เติบโตขึ้นเรื่อย ๆ คุณย่อมรู้ดีถึงความยุ่งยากของการที่เอกสารไม่ตรงกับโค้ด (documentation drift) ด้วย Ollama คุณสามารถใช้โมเดลบนเครื่องส่วนตัวเพื่อช่วย สร้างหรืออัปเดตเอกสารประกอบ โดยไม่ต้องอัปโหลดโค้ดที่ละเอียดอ่อนขึ้นคลาวด์เลย

เพียงแค่ลากไฟล์ — เช่น utils.py — เข้าไปในแอปแล้วถามว่า:

- “เขียน docstrings สำหรับฟังก์ชันเหล่านี้”

- “สร้างภาพรวม Markdown ว่าไฟล์นี้ทำอะไรบ้าง”

- “โมดูลนี้ใช้ dependencies อะไรบ้าง?”

สิ่งนี้จะยิ่งทรงพลังมากขึ้นเมื่อใช้ร่วมกับเครื่องมืออย่าง [Deepdocs] ที่ช่วยให้ขั้นตอนการทำงานด้านเอกสารเป็นไปโดยอัตโนมัติด้วย AI คุณสามารถโหลดไฟล์ README หรือ schema ของโปรเจกต์ของคุณล่วงหน้า จากนั้นถามคำถามเพิ่มเติม หรือสร้างบันทึกการเปลี่ยนแปลง (change logs), บันทึกการย้ายข้อมูล (migration notes) หรือคู่มือการอัปเดต — ทั้งหมดนี้ทำบนเครื่องส่วนตัว

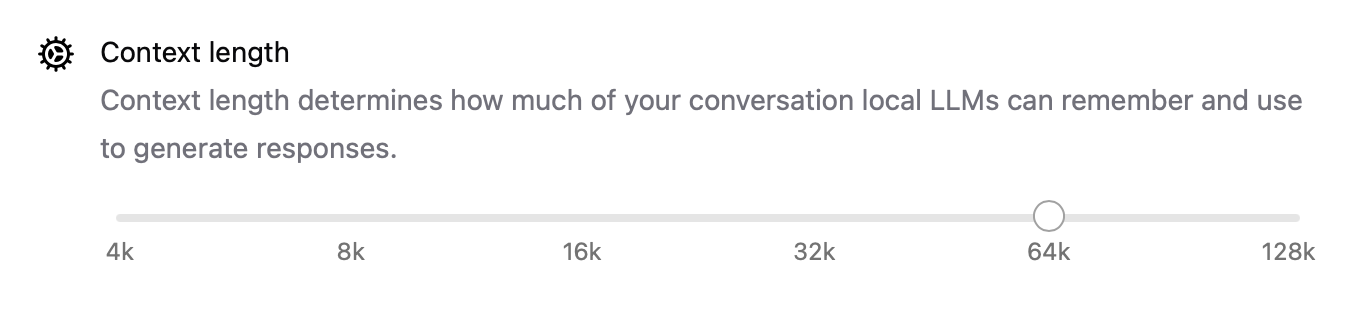

การปรับแต่งประสิทธิภาพภายใน

ด้วยการเปิดตัวเวอร์ชันใหม่นี้ Ollama ยังได้ปรับปรุงประสิทธิภาพโดยรวมให้ดีขึ้น:

- การเร่งความเร็ว GPU ได้รับการปรับแต่งให้เหมาะสมยิ่งขึ้นสำหรับ Apple Silicon และการ์ด Nvidia/AMD รุ่นใหม่

- ความยาวของบริบท (Context length) สามารถกำหนดค่าได้แล้วด้วยการตั้งค่าเช่น

num_ctx=8192ทำให้คุณสามารถจัดการกับข้อมูลนำเข้าที่ยาวขึ้นได้ - โหมดเครือข่าย ช่วยให้ Ollama ทำงานเป็น เซิร์ฟเวอร์ API ภายในเครื่อง ที่คุณสามารถเรียกใช้จากแอปพลิเคชันอื่น ๆ หรืออุปกรณ์บนเครือข่าย LAN ของคุณได้

- ตอนนี้คุณสามารถ เปลี่ยนตำแหน่งจัดเก็บ สำหรับโมเดลที่ดาวน์โหลดได้แล้ว — เหมาะอย่างยิ่งหากคุณทำงานจากไดรฟ์ภายนอก หรือต้องการแยกโมเดลตามแต่ละโปรเจกต์

การอัปเกรดเหล่านี้ทำให้แอปมีความยืดหยุ่นสำหรับทุกสิ่ง ตั้งแต่เอเจนต์ภายในเครื่อง ไปจนถึงเครื่องมือสำหรับนักพัฒนา และผู้ช่วยวิจัยส่วนตัว

CLI และ GUI: สิ่งที่ดีที่สุดจากทั้งสองโลก

ส่วนที่ดีที่สุดคืออะไร? แอปเดสก์ท็อปใหม่นี้ไม่ได้มาแทนที่เทอร์มินัล — แต่มันมาเสริมการทำงาน

คุณยังคงสามารถ:

ollama pull codellama

ollama run codellama

หรือเปิดเผยเซิร์ฟเวอร์โมเดล:

ollama serve --host 0.0.0.0

ดังนั้น หากคุณกำลังสร้างอินเทอร์เฟซ AI, เอเจนต์ หรือปลั๊กอินแบบกำหนดเองที่ต้องพึ่งพา LLM บนเครื่องส่วนตัว ตอนนี้คุณสามารถพัฒนาต่อยอดจาก Ollama’s API และ ใช้อินเทอร์เฟซ GUI สำหรับการโต้ตอบโดยตรงหรือการทดสอบได้

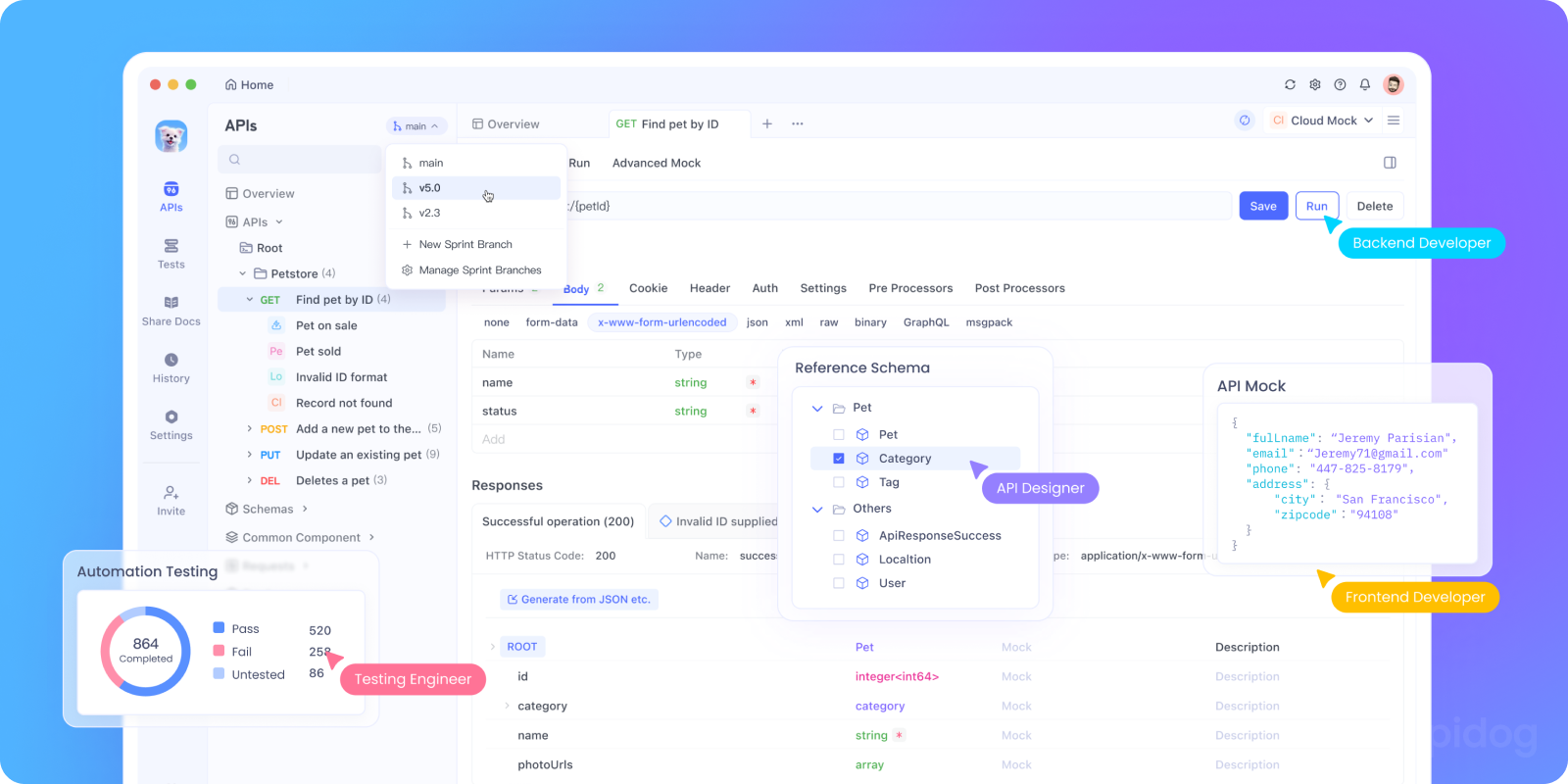

ทดสอบ Ollama’s API บนเครื่องส่วนตัวด้วย Apidog

ต้องการรวม Ollama เข้ากับแอป AI ของคุณ หรือทดสอบ API endpoints บนเครื่องส่วนตัวหรือไม่? คุณสามารถเปิดใช้งาน Ollama's REST API ได้โดยใช้:

bash tollama serve

จากนั้น ใช้ Apidog เพื่อทดสอบ, ดีบัก และจัดทำเอกสาร LLM endpoints บนเครื่องส่วนตัวของคุณ

ทำไมถึงควรใช้ Apidog ร่วมกับ Ollama:

- อินเทอร์เฟซแบบภาพ (Visual interface) สำหรับส่งคำขอ POST ไปยังเซิร์ฟเวอร์

http://localhost:11434บนเครื่องส่วนตัวของคุณ - รองรับการสร้างคำขอและการตรวจสอบการตอบกลับด้วย AI

- เหมาะอย่างยิ่งสำหรับแอป AI ที่โฮสต์ด้วยตนเอง, เฟรมเวิร์กเอเจนต์ หรือเครื่องมือภายในองค์กร

- ทำงานร่วมกับขั้นตอนการทำงานของ LLM บนเครื่องส่วนตัวและเซิร์ฟเวอร์โมเดลแบบกำหนดเองได้อย่างราบรื่น

กรณีการใช้งานสำหรับนักพัฒนาที่ใช้งานได้จริง

นี่คือจุดที่แอป Ollama ใหม่โดดเด่นในขั้นตอนการทำงานจริงของนักพัฒนา:

| กรณีการใช้งาน | Ollama ช่วยได้อย่างไร |

|---|---|

| ผู้ช่วยรีวิวโค้ด | รัน codellama บนเครื่องส่วนตัวเพื่อรับข้อเสนอแนะในการปรับโครงสร้างโค้ด |

| การอัปเดตเอกสารประกอบ | ขอให้โมเดลเขียนใหม่, สรุป หรือแก้ไขไฟล์เอกสาร |

| แชทบอทสำหรับนักพัฒนาบนเครื่องส่วนตัว | ฝังลงในแอปของคุณในฐานะผู้ช่วยที่เข้าใจบริบท |

| เครื่องมือวิจัยแบบออฟไลน์ | โหลดไฟล์ PDF หรือ whitepaper แล้วถามคำถามสำคัญ |

| สนามทดลอง LLM ส่วนตัว | ทดลองกับการทำ prompt engineering และ fine-tuning |

สำหรับทีมที่กังวลเกี่ยวกับความเป็นส่วนตัวของข้อมูล หรือปัญหาโมเดลหลอน (model hallucinations) ขั้นตอนการทำงานของ LLM แบบ Local-first นำเสนอทางเลือกที่น่าสนใจยิ่งขึ้นเรื่อย ๆ

ข้อคิดสุดท้าย

Ollama เวอร์ชันเดสก์ท็อปทำให้ LLMs บนเครื่องส่วนตัวดูไม่เหมือนการทดลองทางวิทยาศาสตร์ที่ยุ่งยากอีกต่อไป แต่ดูเหมือนเครื่องมือสำหรับนักพัฒนาที่ได้รับการขัดเกลาอย่างดี

ด้วยการรองรับการโต้ตอบกับไฟล์, การป้อนข้อมูลหลายรูปแบบ (multimodal inputs), การเขียนเอกสาร และประสิทธิภาพแบบเนทีฟ จึงเป็นตัวเลือกที่จริงจังสำหรับนักพัฒนาที่ให้ความสำคัญกับความเร็ว, ความยืดหยุ่น และการควบคุม

ไม่ต้องใช้ Cloud API keys ไม่มีการติดตามเบื้องหลัง ไม่มีการเรียกเก็บเงินตามจำนวนโทเค็น เพียงแค่การอนุมาน (inference) ที่รวดเร็วบนเครื่องส่วนตัว พร้อมทางเลือกโมเดลโอเพนซอร์สที่เหมาะกับความต้องการของคุณ

หากคุณเคยสงสัยเกี่ยวกับการรัน LLMs บนเครื่องของคุณ หรือหากคุณกำลังใช้ Ollama อยู่แล้วและต้องการประสบการณ์ที่ราบรื่นยิ่งขึ้น ตอนนี้เป็นเวลาที่จะลองใช้อีกครั้ง