นักพัฒนาและนักวิจัยต่างมองหา LLM ที่ไม่มีข้อจำกัดมากขึ้นเรื่อยๆ เพื่อผลักดันขีดจำกัดของแอปพลิเคชันปัญญาประดิษฐ์ โมเดลภาษาขนาดใหญ่ที่ไม่มีการเซ็นเซอร์เหล่านี้ทำงานโดยไม่มีตัวกรองเนื้อหาในตัว ทำให้สามารถตอบสนองต่อคำถามที่หลากหลายได้อย่างไม่จำกัด ในขณะที่ภูมิทัศน์ของ AI พัฒนาไป LLM ที่ไม่มีการเซ็นเซอร์ช่วยให้ผู้ใช้สามารถสำรวจหัวข้อที่ซับซ้อน ตั้งแต่ประเด็นทางจริยธรรมไปจนถึงการเล่าเรื่องเชิงสร้างสรรค์ โดยไม่มีข้อจำกัดด้านศีลธรรมหรือความปลอดภัยที่กำหนดไว้ล่วงหน้า

ในบทความนี้ ผู้เชี่ยวชาญจะตรวจสอบรากฐานทางเทคนิคของ LLM ที่ไม่มีการเซ็นเซอร์ สถาปัตยกรรม และการนำไปใช้งานจริง ผู้ใช้ต้องจัดการโมเดลเหล่านี้อย่างรับผิดชอบ เนื่องจากไม่มีตัวกรองจึงอาจสร้างเนื้อหาที่ละเอียดอ่อนได้

ทำความเข้าใจ LLM ที่ไม่มีการเซ็นเซอร์: รากฐานทางเทคนิค

วิศวกรออกแบบ LLM ที่ไม่มีการเซ็นเซอร์โดยการปรับแต่งโมเดลพื้นฐานบนชุดข้อมูลที่ละเว้นคำแนะนำการจัดแนว ซึ่งโดยทั่วไปจะบังคับใช้แนวทางปฏิบัติทางจริยธรรมในรุ่นมาตรฐาน โมเดลพื้นฐานเช่น Llama 2 หรือ Mistral ผ่านกระบวนการนี้ โดยนักพัฒนาจะลบกลไกการปฏิเสธ—เช่น การปฏิเสธคำถามเกี่ยวกับความรุนแรงหรืออคติ—และปรับพร้อมท์ระบบเพื่อส่งเสริมการตอบสนองที่ครอบคลุม ตัวอย่างเช่น เทคนิคเช่น Reinforcement Learning from Human Feedback (RLHF) จะถูกข้ามหรือย้อนกลับเพื่อจัดลำดับความสำคัญของประโยชน์ใช้สอยมากกว่าความปลอดภัย

นอกจากนี้ LLM ที่ไม่มีการเซ็นเซอร์ยังใช้ประโยชน์จากสถาปัตยกรรม Transformer โดยคาดการณ์โทเค็นถัดไปในลำดับด้วยพารามิเตอร์นับพันล้าน ชุมชนโอเพนซอร์สมีส่วนร่วมโดยการแบ่งปันเวอร์ชันที่ปรับแต่งบนแพลตฟอร์มเช่น Hugging Face ซึ่งโมเดลจะได้รับการยกเลิกการเซ็นเซอร์ผ่าน "abliteration"—วิธีการที่กัดกร่อนการจัดแนวความปลอดภัยผ่านการปรับแต่งแบบกำหนดเป้าหมาย วิธีการนี้ช่วยให้มั่นใจว่าโมเดลจะตอบสนองต่อพร้อมท์ใดๆ แต่ต้องใช้ฮาร์ดแวร์ที่แข็งแกร่งสำหรับการอนุมาน ซึ่งมักจะต้องใช้ GPU ที่มี VRAM เพียงพอ

โมเดลเหล่านี้แตกต่างจากโมเดลที่เป็นกรรมสิทธิ์เช่น GPT-4 ซึ่งฝังตัวกรองที่เข้มงวดเพื่อให้เป็นไปตามข้อกำหนด รุ่นที่ไม่มีการเซ็นเซอร์ อย่างไรก็ตาม ส่งเสริมการสร้างสรรค์นวัตกรรมในสาขาต่างๆ เช่น การวิจัยและการจำลอง ซึ่งผลลัพธ์ที่ไม่จำกัดจะเผยให้เห็นความสามารถที่แท้จริง อย่างไรก็ตาม นักพัฒนาลดความเสี่ยงโดยการใช้มาตรการป้องกันที่กำหนดเองในแอปพลิเคชัน

ประโยชน์และความเสี่ยงของ LLM ที่ไม่มีข้อจำกัด

ผู้ใช้ได้รับประโยชน์อย่างมากจาก LLM ที่ไม่มีข้อจำกัด เนื่องจากโมเดลเหล่านี้ให้ข้อมูลเชิงลึกที่ไม่มีการกรองซึ่งช่วยเพิ่มประสิทธิภาพในการแก้ปัญหา ตัวอย่างเช่น นักวิจัยใช้โมเดลเหล่านี้สำหรับการทดสอบสมมติฐานในโดเมนที่ละเอียดอ่อน ซึ่งโมเดลมาตรฐานอาจปกปิดข้อมูล นอกจากนี้ นักเขียนโค้ดยังได้รับประโยชน์จากการสร้างโค้ดที่ไม่จำกัด ซึ่งช่วยเร่งวงจรการพัฒนาโดยไม่มีการหยุดชะงักทางจริยธรรม

นอกจากนี้ LLM เหล่านี้ยังส่งเสริมความโปร่งใสใน AI ทำให้นักวิศวกรสามารถตรวจสอบและแก้ไขพฤติกรรมได้โดยตรง ชุมชนสร้างต่อยอดจากโมเดลเหล่านี้ สร้างรุ่นพิเศษสำหรับงานต่างๆ เช่น การประมวลผลหลายภาษา หรือการให้เหตุผลแบบบริบทขนาดยาว อย่างไรก็ตาม ความเสี่ยงเกิดขึ้นจากการนำไปใช้ในทางที่ผิด เช่น การสร้างเนื้อหาที่เป็นอันตราย ซึ่งจำเป็นต้องมีการกำกับดูแลด้านจริยธรรมจากผู้ใช้งาน

แพลตฟอร์มเช่น Ollama ช่วยให้สามารถรันในเครื่องได้ ลดความกังวลเรื่องความเป็นส่วนตัวของข้อมูลในขณะที่เพิ่มการควบคุมสูงสุด อย่างไรก็ตาม ความต้องการการคำนวณที่สูงเป็นอุปสรรค แม้ว่าการเพิ่มประสิทธิภาพเช่น quantization จะช่วยแก้ปัญหานี้โดยการลดขนาดโมเดลโดยไม่ลดทอนประสิทธิภาพมากนัก

เกณฑ์ในการจัดอันดับ 10 LLM ที่ไม่มีการเซ็นเซอร์ยอดนิยม

นักวิเคราะห์จัดอันดับโมเดลเหล่านี้โดยพิจารณาจากจำนวนพารามิเตอร์ ความเร็วในการอนุมาน การสนับสนุนจากชุมชน และคะแนนมาตรฐานจากแหล่งต่างๆ เช่น ตารางจัดอันดับของ Hugging Face ความหลากหลายในการทำงาน—เช่น การเขียนโค้ด การสวมบทบาท และการให้เหตุผล—ก็เป็นปัจจัยหนึ่งเช่นกัน ควบคู่ไปกับความง่ายในการติดตั้งใช้งานในเครื่อง นอกจากนี้ การอัปเดตล่าสุดในปี 2025 ยังให้ความสำคัญกับโมเดลที่มีหน้าต่างบริบทที่ขยายใหญ่ขึ้นและการออกแบบแบบ mixture-of-experts (MoE) เพื่อประสิทธิภาพ

1. Dolphin 3.0: ขุมพลัง LLM ที่ไม่มีการเซ็นเซอร์ขับเคลื่อนด้วยความแม่นยำ

Cognitive Computations พัฒนา Dolphin 3.0 บนพื้นฐาน Llama 3.1 8B โดยปรับแต่งเพื่อให้มีการให้เหตุผลและการควบคุมที่ยอดเยี่ยมผ่านพร้อมท์ระบบ โมเดลนี้โดดเด่นในงานที่เน้นตรรกะ โดยให้ผลลัพธ์ที่แม่นยำและไม่มีการกรองโดยไม่มีเนื้อหาฟุ่มเฟือย วิศวกรชื่นชมพารามิเตอร์ 8 พันล้านตัว ซึ่งสร้างสมดุลระหว่างประสิทธิภาพและความต้องการทรัพยากร โดยต้องใช้ VRAM ประมาณ 16GB สำหรับการอนุมานที่ดีที่สุด

คุณสมบัติหลักประกอบด้วยสถาปัตยกรรมแบบไฮบริดที่ช่วยเพิ่มการปฏิบัติตามพร้อมท์ ทำให้เหมาะสำหรับผู้ช่วย AI แบบกำหนดเอง นอกจากนี้ Dolphin 3.0 ยังรองรับการเรียกใช้ฟังก์ชัน ทำให้สามารถผสานรวมกับเครื่องมือภายนอกได้ ข้อดีครอบคลุมถึงการควบคุมบุคลิกภาพที่ไม่มีใครเทียบได้และการแก้ปัญหาอย่างรวดเร็วในการเขียนโค้ดหรือคณิตศาสตร์ ในขณะที่ข้อเสียเกี่ยวข้องกับรูปแบบการเขียนที่ตรงไปตรงมา ซึ่งเหมาะสำหรับงานทางเทคนิคแต่ไม่เหมาะสำหรับงานเล่าเรื่อง

นักพัฒนาเรียกใช้ Dolphin 3.0 ในเครื่องโดยใช้ Ollama: ติดตั้งเครื่องมือ ดึงโมเดลด้วย ollama pull dolphin-llama3 และสอบถามผ่าน API หรือ CLI การวัดประสิทธิภาพแสดงให้เห็นว่ามันมีประสิทธิภาพเหนือกว่าโมเดลอื่นๆ ในการให้เหตุผลเชิงโครงสร้าง โดยมีคะแนนสูงกว่า 80% ในการทดสอบ MMLU นอกจากนี้ การไม่มีการเซ็นเซอร์ยังมาจากชุดข้อมูลที่หลีกเลี่ยงอคติในการจัดแนว ทำให้สามารถสำรวจกรณีขอบในการวิจัยได้

ในสถานการณ์การนำไปใช้งาน ทีมงานจะรวมเข้ากับไปป์ไลน์สำหรับการวิเคราะห์อัตโนมัติ ซึ่งประสิทธิภาพของมันโดดเด่น อย่างไรก็ตาม ผู้ใช้ต้องปรับเทียบพร้อมท์อย่างระมัดระวังเพื่อหลีกเลี่ยงอคติที่ไม่ตั้งใจ

2. Nous Hermes 3: โมเดลที่ไม่มีการเซ็นเซอร์เน้นความคิดสร้างสรรค์

NousResearch สร้าง Nous Hermes 3 บนพื้นฐาน Llama 3.2 8B โดยเน้นการเขียนเชิงสร้างสรรค์และการสวมบทบาทด้วยผลลัพธ์แบบยาวที่สอดคล้องกัน ด้วยพารามิเตอร์ 8 พันล้านตัว ทำให้รักษาสอดคล้องของตัวละครในการสนทนา โดยใช้ ChatML สำหรับการสนทนาที่มีโครงสร้าง สิ่งนี้ทำให้เป็นตัวเลือกอันดับต้นๆ สำหรับการสร้างเรื่องราวโดยไม่มีข้อจำกัด

คุณสมบัติเด่นคือความเข้าใจที่ละเอียดอ่อนของพร้อมท์ รองรับบริบทที่ขยายได้ถึง 8k โทเค็น ข้อดีรวมถึงการสร้างนิยายที่เหนือกว่าและการโต้ตอบที่น่าสนใจ ในขณะที่ข้อเสียคือบางครั้งอาจมีคำพูดฟุ่มเฟือยในการสอบถามที่กระชับ การอัปเดตที่ขับเคลื่อนโดยชุมชนช่วยให้มีการปรับปรุงอย่างต่อเนื่อง

ในการนำไปใช้งาน ผู้ใช้สามารถใช้ Hugging Face: ดาวน์โหลดโมเดล โหลดด้วยไลบรารี Transformers ผ่าน from transformers import AutoModelForCausalLM; model = AutoModelForCausalLM.from_pretrained('NousResearch/Hermes-3-Llama-3.2-8B') และสร้างข้อความ การวัดประสิทธิภาพบ่งชี้คะแนนสูงในการวัดประสิทธิภาพเชิงสร้างสรรค์ ซึ่งมักจะเกิน 85% ในการประเมินการสวมบทบาท

นอกจากนี้ การไม่มีการเซ็นเซอร์ยังเกิดจากการปรับแต่งบนชุดข้อมูลที่หลากหลายและไม่มีการกรอง ทำให้สามารถสำรวจเชิงลึกในการเล่าเรื่องได้ นักพัฒนานำไปใช้ในการออกแบบเกม ซึ่งความคิดสร้างสรรค์ที่ไม่จำกัดช่วยเร่งการสร้างต้นแบบ

3. LLaMA-3.2 Dark Champion Abliterated: สัตว์ร้ายที่ไม่มีการเซ็นเซอร์บริบทขนาดยาว

DavidAU ปรับแต่ง LLaMA-3.2 Dark Champion บนสถาปัตยกรรม 8x3B MoE โดยลบเลเยอร์ความปลอดภัยสำหรับผลลัพธ์ที่ไม่สอดคล้องกัน ด้วยหน้าต่างบริบท 128k ทำให้ประมวลผลเอกสารขนาดใหญ่ได้อย่างมีประสิทธิภาพ เหมาะสำหรับการวิเคราะห์ข้อมูล

การออกแบบ MoE ของโมเดลนี้จะเปิดใช้งานชุดย่อยของพารามิเตอร์ ลดการคำนวณในขณะที่ยังคงประสิทธิภาพไว้ ข้อดีคือการอนุมานที่รวดเร็วและการให้เหตุผลเชิงลึก แต่ข้อเสียรวมถึงอคติเชิงลบที่อาจเกิดขึ้นและความต้องการ VRAM สูง (ประมาณ 40GB)

การติดตั้งเกี่ยวข้องกับการดาวน์โหลดจาก Hugging Face โดยมีการอนุมานผ่าน pipeline('text-generation', model='DavidAU/Llama-3.2-8X3B-MOE-Dark-Champion-Instruct-uncensored-abliterated-18.4B') ได้คะแนนสูงในการวัดประสิทธิภาพบริบทขนาดยาว โดยมีความแม่นยำเกิน 90% ในงานการดึงข้อมูล

นอกจากนี้ abliteration ยังช่วยให้มั่นใจว่าไม่มีข้อจำกัด เหมาะสำหรับการวิจัยขั้นสูง ทีมงานใช้เพื่อสร้างรายงานอัตโนมัติ ซึ่งขนาดของมันสามารถจัดการชุดข้อมูลที่ซับซ้อนได้อย่างราบรื่น

4. Llama 2 Uncensored: LLM ที่ไม่มีการเซ็นเซอร์ระดับเริ่มต้นที่หลากหลาย

Llama 2 ของ Meta ทำหน้าที่เป็นพื้นฐานสำหรับรุ่นที่ไม่มีการเซ็นเซอร์นี้ ซึ่งได้รับการปรับแต่งโดย George Sung เพื่อกำจัดตัวกรองทางศีลธรรม ด้วยพารามิเตอร์ 7-13 พันล้านตัว สามารถทำงานบนฮาร์ดแวร์ของผู้บริโภค รองรับการสวมบทบาทและงานทั่วไป

คุณสมบัติรวมถึงตัวเลือก quantization หลายแบบ เช่น GGUF สำหรับความสมดุลของ CPU/GPU ข้อดี: การเข้าถึงและปลั๊กอินจากชุมชน; ข้อเสีย: การให้เหตุผลที่อ่อนแอกว่า Llama 3

เรียกใช้ผ่าน Ollama: ollama run llama2-uncensored เป็นที่นิยมด้วยการดาวน์โหลด 234K และมีประสิทธิภาพที่ดีสำหรับการใช้งานเบาๆ

นอกจากนี้ การออกแบบยังส่งเสริมการทดลอง ทำให้เป็นที่นิยมสำหรับผู้เริ่มต้นใน AI ที่ไม่มีการเซ็นเซอร์

5. WizardLM Uncensored: โมเดลอเนกประสงค์ที่เชื่อถือได้

TheBloke บรรจุ WizardLM Uncensored บน Llama 2 13B โดยลบการจัดแนวสำหรับการใช้งานที่หลากหลาย โดดเด่นในการแชทและการเขียน ด้วยความสามารถที่สมดุล

ประเด็นสำคัญ: ชุมชนที่แข็งแกร่ง, การนำไปใช้งานง่าย ข้อดี: คาดการณ์ได้; ข้อเสีย: พื้นฐานที่ล้าสมัย

นำไปใช้งานด้วย ollama run wizardlm-uncensored ได้รับการดาวน์โหลด 23K เหมาะสำหรับเวิร์กโฟลว์เชิงสร้างสรรค์

6. Dolphin 2.7 Mixtral 8x7B: โมเดลที่ไม่มีการเซ็นเซอร์เฉพาะทางด้านการเขียนโค้ด

Eric Hartford สร้างสิ่งนี้บน MoE ของ Mixtral ซึ่งได้รับการปรับแต่งสำหรับการเขียนโค้ดโดยไม่มีตัวกรอง พารามิเตอร์ 8x7B ช่วยให้มั่นใจถึงประสิทธิภาพในงานเฉพาะทาง

คุณสมบัติ: รูปแบบ quantization, ประสิทธิภาพการเขียนโค้ดสูง ข้อดี: ความเร็ว; ข้อเสีย: ความต้องการฮาร์ดแวร์

ใช้ Ollama: ollama run dolphin-mixtral:8x7b การวัดประสิทธิภาพเน้นย้ำถึงความสามารถในการเขียนโปรแกรม

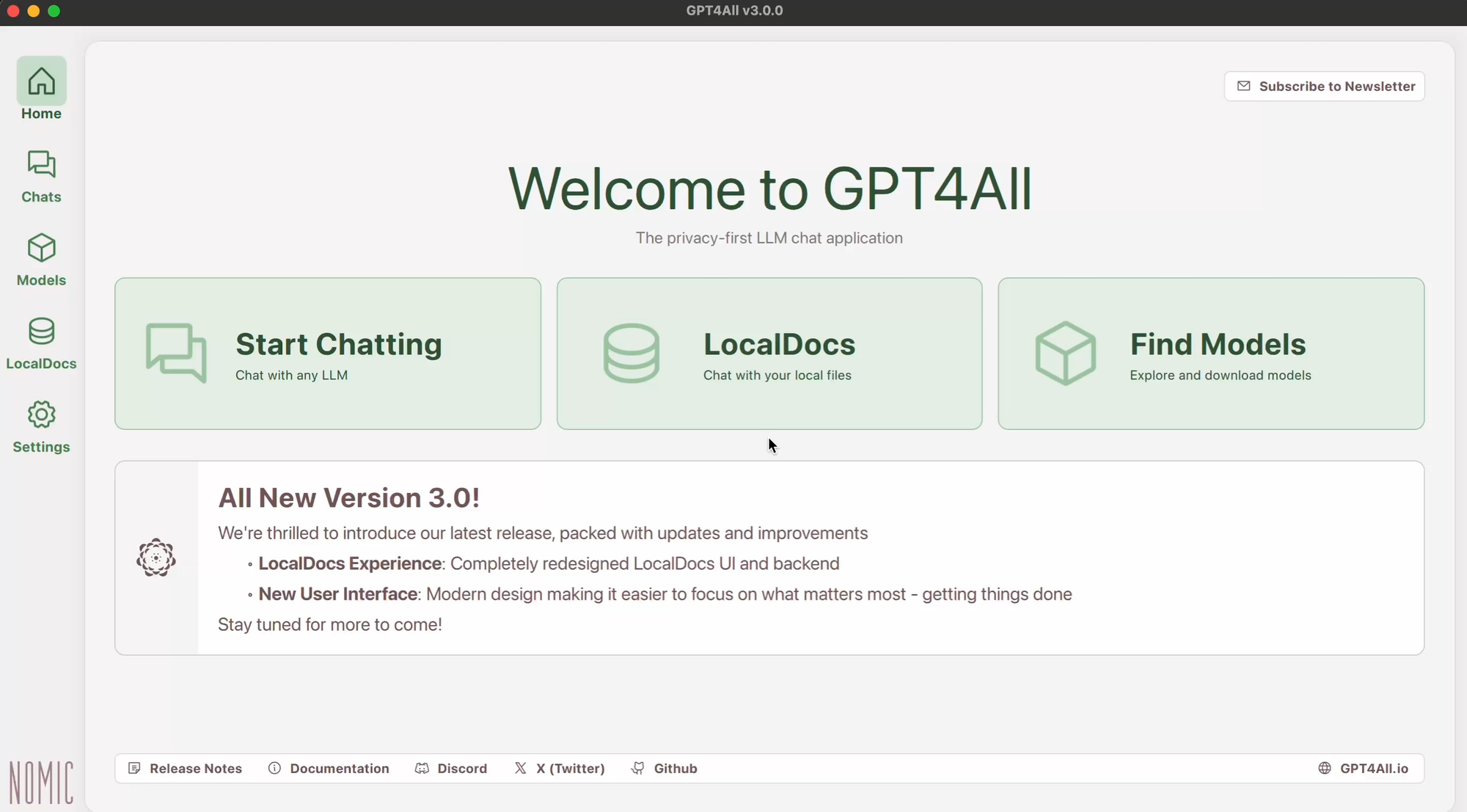

7. GPT-4All: เฟรมเวิร์กที่ไม่มีการเซ็นเซอร์เน้นการทำงานแบบออฟไลน์

GPT-4All ปรับให้เหมาะสมสำหรับการรันในเครื่อง โดยสร้างจากงานวิจัย Transformer สำหรับการแชทที่ไม่มีการเซ็นเซอร์ การรองรับหลายแพลตฟอร์มช่วยในการนำไปใช้งาน

ข้อดี: ฟรี, ปรับแต่งได้; ข้อเสีย: ข้อจำกัดของบริบท

ติดตั้งผ่านเว็บไซต์ทางการ เรียกใช้ไฟล์ปฏิบัติการ เหมาะสำหรับผู้ใช้ที่ใส่ใจความเป็นส่วนตัว

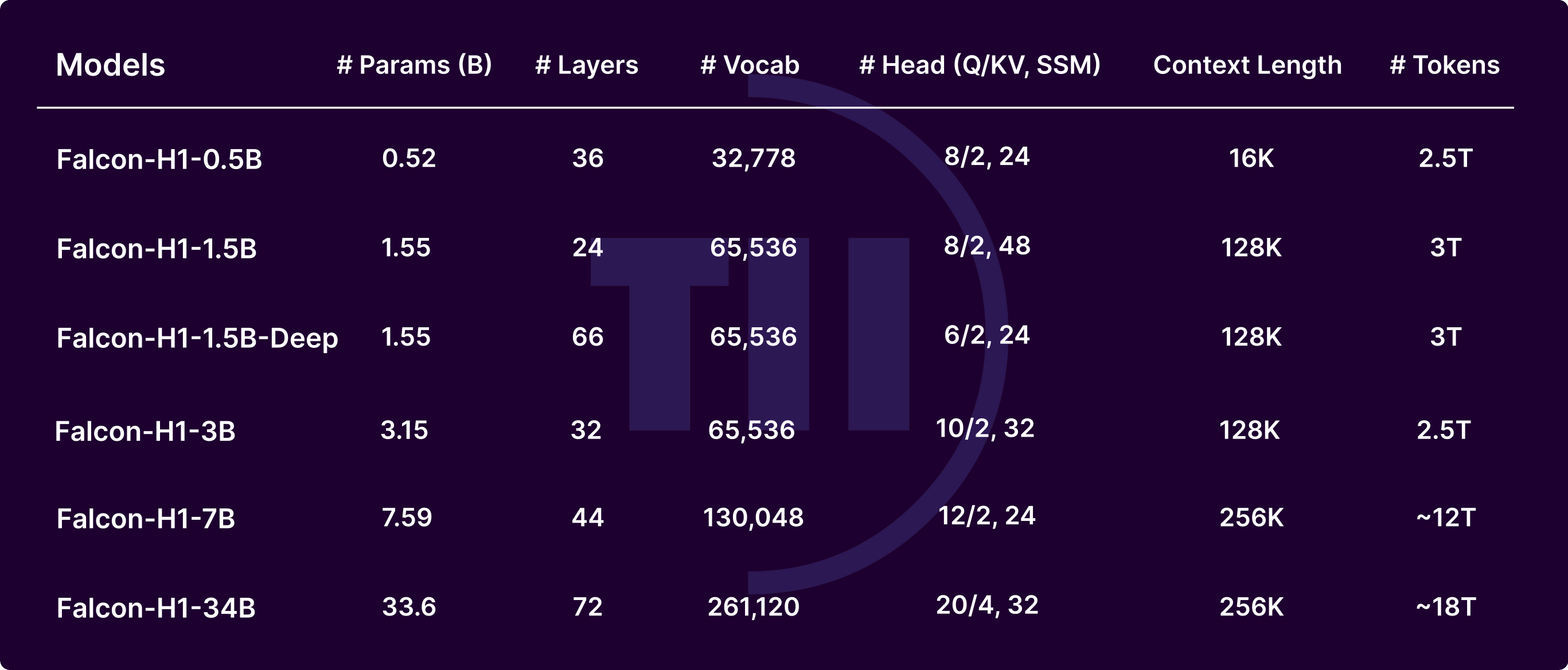

8. Falcon LLM: ทางเลือกที่ไม่มีการเซ็นเซอร์ประสิทธิภาพสูง

สถาบันนวัตกรรมเทคโนโลยีพัฒนา Falcon ด้วยสถาปัตยกรรมที่เป็นนวัตกรรมสำหรับข้อความที่มีความละเอียดอ่อน ปรับให้เหมาะสมสำหรับความเร็ว

คุณสมบัติ: การออกแบบแบบโมดูลาร์ ข้อดี: คุณภาพ; ข้อเสีย: ความสมบูรณ์ของระบบนิเวศ

โหลดด้วยไลบรารี Transformers เหมาะสำหรับการวิจัย

9. MPT-7B Chat: LLM ที่ไม่มีการเซ็นเซอร์สำหรับการสนทนา

MosaicML ปรับแต่ง MPT-7B สำหรับการแชท โดยเน้นความหน่วงต่ำ พารามิเตอร์ 7B เหมาะสำหรับการตั้งค่าที่ไม่ซับซ้อน

ข้อดี: เรียลไทม์; ข้อเสีย: งานที่ซับซ้อน

นำไปใช้งานในเครื่องด้วยสคริปต์ เหมาะสำหรับบอท

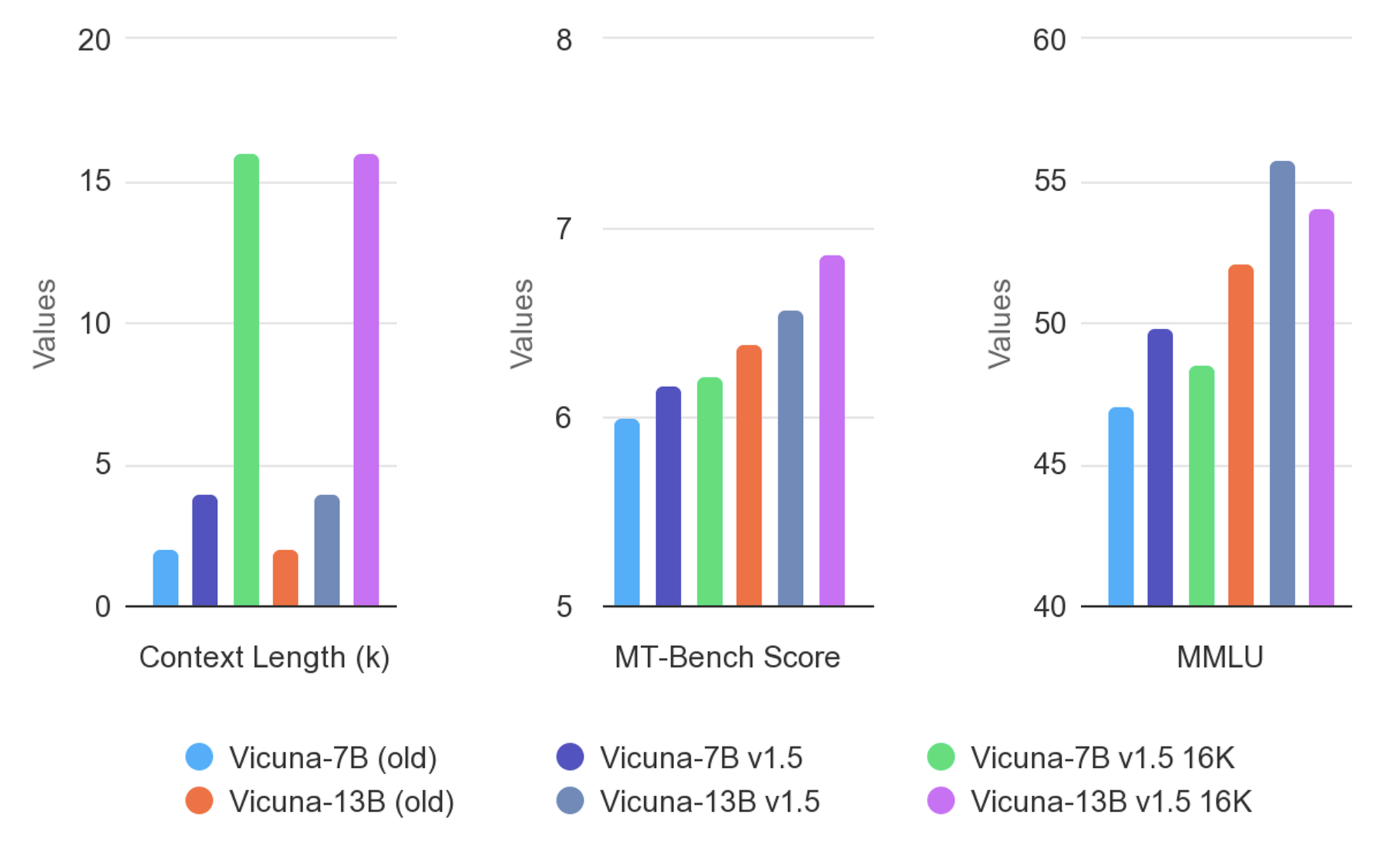

10. Vicuna: โมเดลที่ไม่มีการเซ็นเซอร์ที่ปรับให้เหมาะสมกับการสนทนา

Vicuna ปรับแต่งบนข้อมูลการสนทนาเพื่อการโต้ตอบที่เป็นธรรมชาติ การออกแบบน้ำหนักเบา

ข้อดี: น่าสนใจ; ข้อเสีย: จุดอ่อนในงานที่ไม่ใช่การสนทนา

เรียกใช้ผ่านเครื่องมือชุมชน ช่วยเพิ่มประสิทธิภาพแอปแบบโต้ตอบ

แนวทางปฏิบัติที่ดีที่สุดสำหรับการนำ LLM ที่ไม่มีการเซ็นเซอร์ไปใช้งาน

วิศวกรปรับปรุงการนำไปใช้งานให้เหมาะสมโดยการเลือกระดับ quantization เช่น Q4 หรือ Q8 เพื่อให้เข้ากับฮาร์ดแวร์ เครื่องมืออย่าง Ollama หรือ LM Studio ช่วยให้การรันง่ายขึ้น ในขณะที่ API ผ่าน Apidog ช่วยให้สามารถปรับขนาดได้

นอกจากนี้ ให้ตรวจสอบการใช้งาน VRAM และปรับแต่งสำหรับโดเมนเฉพาะ มาตรการรักษาความปลอดภัยรวมถึงการแยกสภาพแวดล้อม

แนวโน้มในอนาคตของ LLM ที่ไม่มีการเซ็นเซอร์

นักนวัตกรรมคาดการณ์โมเดล MoE ที่ใหญ่ขึ้นและเทคนิค abliteration ที่ดีขึ้น การผสานรวมกับความสามารถแบบ multimodal ขยายการใช้งาน

อย่างไรก็ตาม แรงกดดันด้านกฎระเบียบอาจส่งผลต่อการพัฒนา ผลักดันให้เกิดแนวทางแบบไฮบริด

บทสรุป

การสำรวจนี้เผยให้เห็นว่า LLM ที่ไม่มีข้อจำกัดปฏิวัติแอปพลิเคชัน AI อย่างไร ตั้งแต่ความแม่นยำของ Dolphin 3.0 ไปจนถึงบทสนทนาของ Vicuna โมเดลเหล่านี้มอบอิสระที่ไม่มีใครเทียบได้ นักพัฒนาใช้ประโยชน์จากมันอย่างรับผิดชอบ โดยใช้เครื่องมือเช่น Apidog สำหรับการผสานรวมที่ราบรื่น ในขณะที่เทคโนโลยีก้าวหน้า LLM ที่ไม่มีการเซ็นเซอร์เหล่านี้ยังคงขับเคลื่อนนวัตกรรม เปลี่ยนแปลงภูมิทัศน์ของการวิจัยและพัฒนา