MoltBot ซึ่งเดิมรู้จักกันในชื่อ ClawdBot โดดเด่นในฐานะเอเจนต์แบบโฮสต์เองที่ผสานรวมโดยตรงกับแพลตฟอร์มการส่งข้อความ เช่น Telegram, WhatsApp, Discord และ Slack มันทำงานจริงบนเครื่องของคุณในขณะที่ยังคงความเป็นส่วนตัวและมีความหน่วงต่ำ

การเชื่อมต่อ Kimi K2.5 เข้ากับ MoltBot สร้างผู้ช่วยที่หลากหลายและคุ้มค่า ผู้ใช้จะได้รับประสิทธิภาพที่แข็งแกร่งสำหรับงานทั่วไป งานสร้างสรรค์ และพฤติกรรมเชิงเอเจนต์ในราคาเพียงเศษเสี้ยวของโมเดลอย่าง Claude 3.5 Sonnet หรือ GPT-4o สำหรับการตั้งค่าที่เน้นความเป็นส่วนตัว การปรับใช้ภายในเครื่องโดยใช้ GGUF weights ที่ถูกควอนไทซ์จะช่วยขจัดปัญหาการส่งข้อมูลภายนอก

คู่มือนี้อธิบายทั้งวิธี API และวิธีภายในเครื่องโดยละเอียด ประกอบด้วยตัวอย่างการกำหนดค่า ขั้นตอนการยืนยัน และวิธีแก้ไขปัญหาที่พบบ่อย

ทำไมต้องจับคู่ MoltBot กับ Kimi K2.5?

MoltBot ทำหน้าที่เป็นชั้นการประมวลผล ในขณะที่ LLM ให้ความชาญฉลาด Kimi K2.5 มีข้อดีที่โดดเด่นในบทบาทนี้

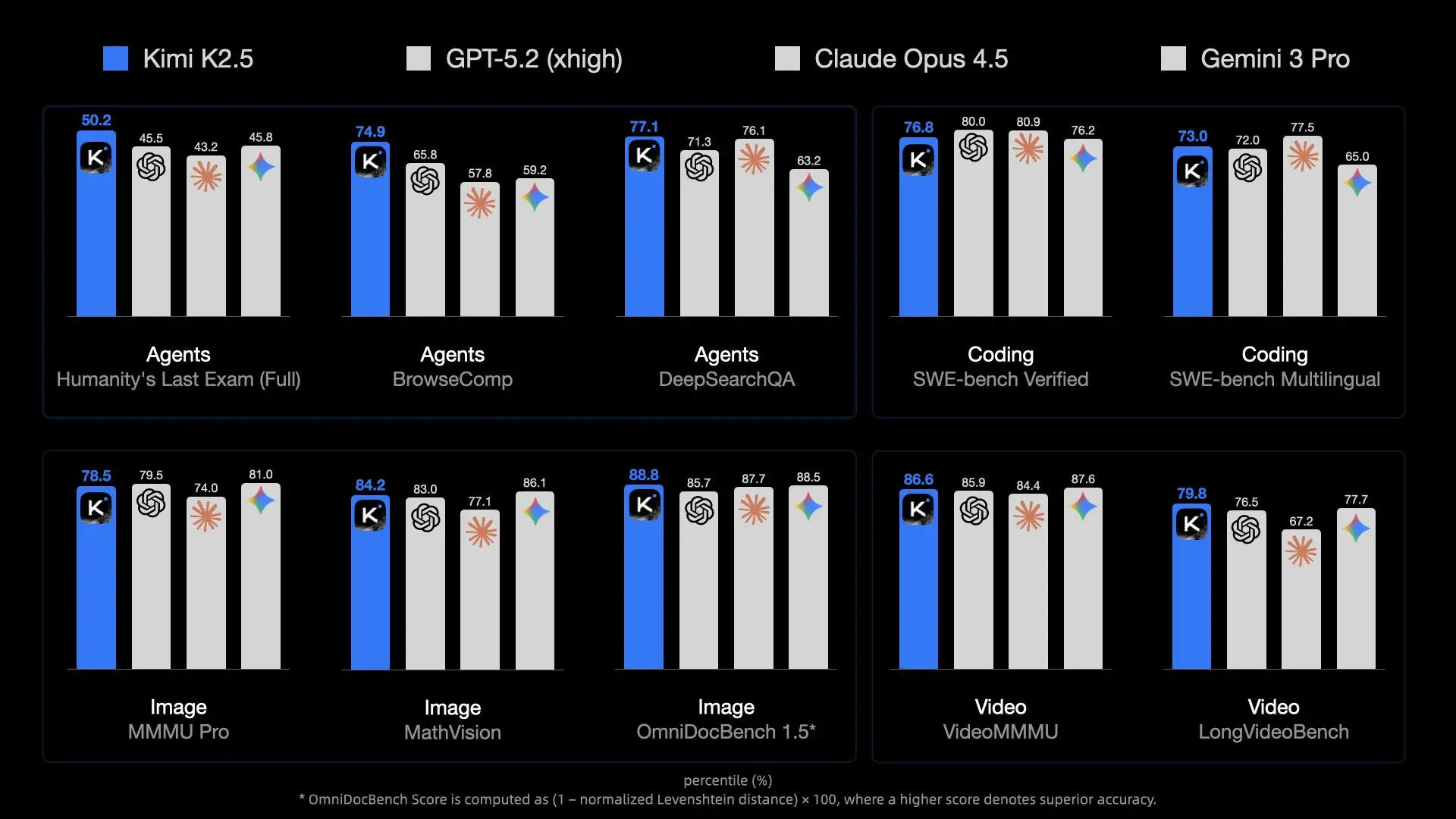

โมเดลนี้มอบความสามารถสูงผ่านการออกแบบ MoE ซึ่งช่วยให้ผู้เชี่ยวชาญที่เกี่ยวข้องทำงานได้อย่างมีประสิทธิภาพ มันจัดการอินพุตแบบมัลติโมดอลได้โดยกำเนิด ทำให้ MoltBot สามารถประมวลผลภาพหน้าจอ การออกแบบ UI หรือวิดีโอสั้นๆ สำหรับงานต่างๆ เช่น การสร้างโค้ดจากภาพ

ความยาวของบริบทสูงถึง 256K โทเค็นในการปรับใช้ส่วนใหญ่ ทำให้สามารถเก็บรักษาฐานโค้ดโครงการที่ครอบคลุม เอกสาร หรือประวัติการสนทนา ซึ่งจำเป็นสำหรับผู้ช่วยที่ทำงานต่อเนื่อง

ค่าใช้จ่าย API ยังคงต่ำเมื่อเทียบกับทางเลือกของฝั่งตะวันตก ผู้ใช้จำนวนมากจะประหยัดได้มากเมื่อเวลาผ่านไป สำหรับค่าใช้จ่ายต่อเนื่องเป็นศูนย์และการควบคุมสูงสุด การอนุมานภายในเครื่องทำงานบนฮาร์ดแวร์สำหรับผู้บริโภคด้วย quantization

Kimi K2.5 แสดงให้เห็นถึงความสามารถเชิงเอเจนต์ที่แข็งแกร่ง รวมถึงฝูงย่อยที่นำตนเองได้มากถึง 100 เอเจนต์สำหรับการเรียกใช้เครื่องมือแบบขนาน เมื่อถูกส่งผ่านระบบทักษะของ MoltBot คุณสมบัติเหล่านี้จะทำให้เวิร์กโฟลว์ที่ซับซ้อนเป็นไปโดยอัตโนมัติโดยตรงจากข้อความแชท

ความยืดหยุ่นของ MoltBot รองรับ OpenAI-compatible endpoint ใดๆ การเปลี่ยนผู้ให้บริการต้องการเพียงการอัปเดตการกำหนดค่าเท่านั้น ทำให้ผู้ใช้สามารถทดลองได้อย่างง่ายดาย

ข้อกำหนดเบื้องต้น

เตรียมองค์ประกอบเหล่านี้ก่อนการกำหนดค่า

ติดตั้ง MoltBot ให้สมบูรณ์ เรียกใช้สคริปต์การติดตั้งหากยังไม่ได้ดำเนินการ:

curl -fsSL https://molt.bot/install.sh | bash

โครงการเปลี่ยนชื่อจาก ClawdBot เป็น MoltBot เมื่อวันที่ 27 มกราคม 2026 ตามคำขอเครื่องหมายการค้าจาก Anthropic การติดตั้งรุ่นเก่าอาจยังคงมีไดเรกทอรี ~/.clawdbot แต่เวอร์ชันล่าสุดใช้คำสั่ง moltbot และ ~/.moltbot หรือพาธที่คล้ายกัน ตรวจสอบเอกสารที่ molt.bot หรือที่เก็บ GitHub (github.com/moltbot/moltbot) สำหรับการตั้งค่าที่ถูกต้องของคุณ

รับสิทธิ์เข้าถึง Kimi K2.5:

- เส้นทาง API: สร้างบัญชีที่ platform.moonshot.ai, สร้าง API key, และจดบันทึกขีดจำกัดงบประมาณโครงการใดๆ

- เส้นทางภายในเครื่อง: ดาวน์โหลด quantized weights (เช่น จาก Hugging Face moonshotai/Kimi-K2.5 หรือ community repos เช่น unsloth/Kimi-K2.5-GGUF) ติดตั้ง llama.cpp และเริ่มเซิร์ฟเวอร์

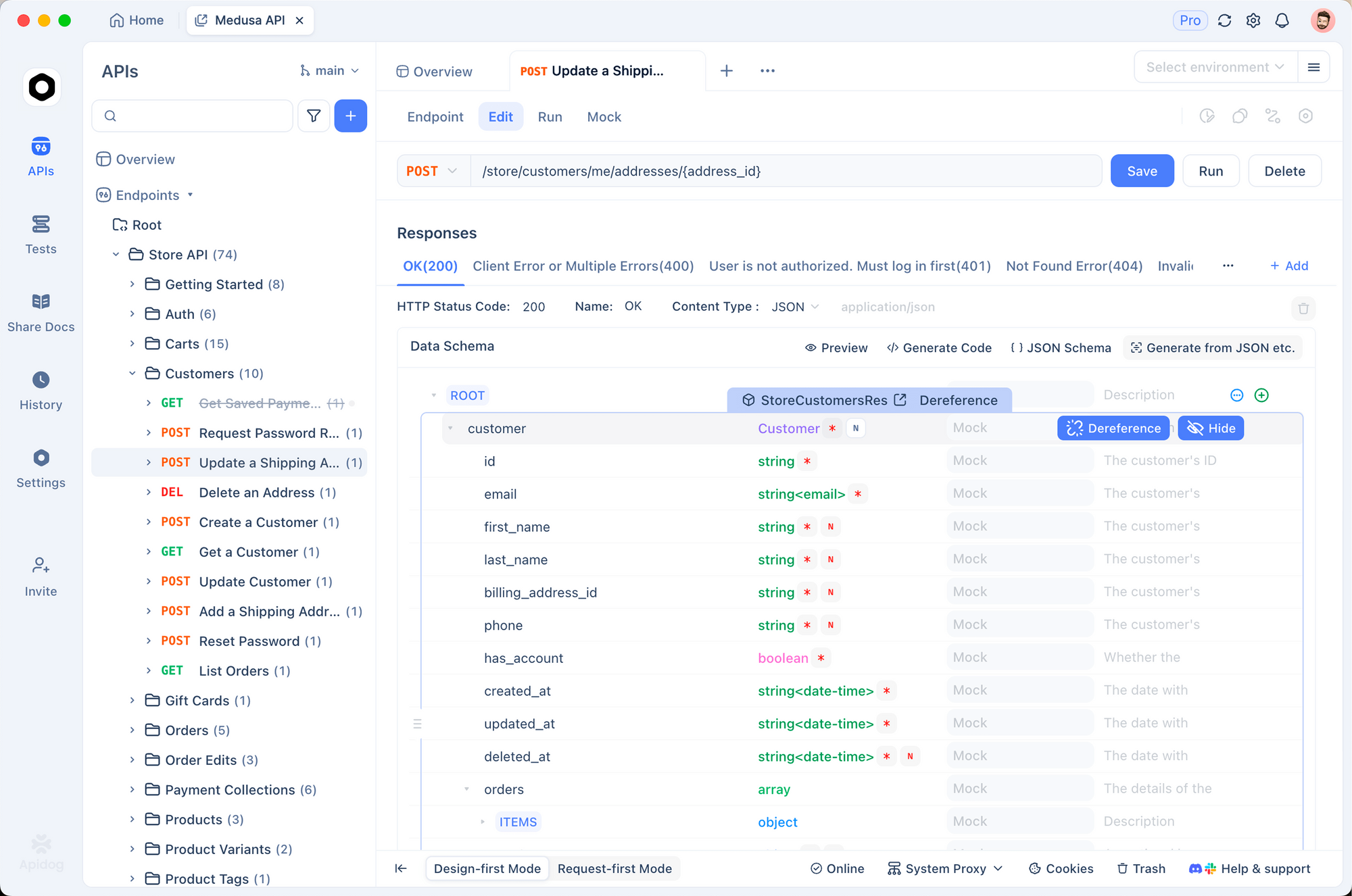

ติดตั้ง Apidog สำหรับการทดสอบ มันจัดการส่วนหัวการยืนยันตัวตน, JSON bodies และการสตรีมการตอบสนองได้อย่างมีประสิทธิภาพ

ตรวจสอบให้แน่ใจว่า Node.js ทำงานสำหรับ MoltBot การคุ้นเคยกับเทอร์มินัลขั้นพื้นฐานช่วยในการแก้ไขไฟล์ JSON

วิธีที่ 1: การเชื่อมต่อผ่าน Moonshot API (แนะนำสำหรับผู้ใช้ส่วนใหญ่)

วิธีนี้ต้องการฮาร์ดแวร์น้อยที่สุดและให้บริบทเต็ม 256K พร้อมการรองรับมัลติโมดอล

ขั้นตอนที่ 1: ตรวจสอบการเชื่อมต่อ API โดยใช้ Apidog

เปิด Apidog และสร้าง POST request ใหม่

ตั้งค่า URL เป็น:

https://api.moonshot.ai/v1/chat/completions

เพิ่มส่วนหัว:

Authorization: Bearer sk-XXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXX

(แทนที่ด้วยคีย์จริงของคุณ)

ใช้ body นี้สำหรับการทดสอบพื้นฐาน:

{

"model": "kimi-k2.5",

"messages": [

{

"role": "user",

"content": "Confirm you are Kimi K2.5 and describe your capabilities briefly."

}

],

"temperature": 0.7,

"max_tokens": 256

}

ส่งคำขอ การตอบกลับ 200 ที่ประสบความสำเร็จพร้อมเอาต์พุตที่สอดคล้องกันยืนยันว่าคีย์ทำงานได้ดี สังเกตข้อผิดพลาดเกี่ยวกับอัตราการจำกัดหรืองบประมาณที่นี่

ขั้นตอนที่ 2: ค้นหาและแก้ไขไฟล์กำหนดค่า

MoltBot จัดเก็บการตั้งค่าในไฟล์ JSON ซึ่งโดยทั่วไปแล้วคือ:

~/.moltbot/moltbot.json- หรือรุ่นเก่า:

~/.clawdbot/moltbot.json/~/.clawdbot/agents/default/config.json

เปิดด้วยโปรแกรมแก้ไข

เพิ่มหรือแก้ไขส่วน providers:

{

"agent": {

"model": {

"primary": "moonshot/kimi-k2.5"

}

},

"models": {

"providers": {

"moonshot": {

"baseUrl": "https://api.moonshot.ai/v1",

"apiKey": "sk-your-moonshot-api-key-here",

"api": "openai-completions",

"models": [

{

"id": "kimi-k2.5",

"name": "Kimi K2.5 (API)",

"contextWindow": 262144,

"maxTokens": 8192

}

]

}

}

}

}

ข้อควรระวังด้านความปลอดภัย: หลีกเลี่ยงการ hardcode คีย์ในการผลิต ตั้งค่าตัวแปรสภาพแวดล้อม (เช่น export MOONSHOT_API_KEY=sk-...) และอ้างอิงถึงมันหาก MoltBot รองรับการขยายตัว

ขั้นตอนที่ 3: ใช้การเปลี่ยนแปลงและรีสตาร์ท

บันทึกไฟล์ จากนั้นรีสตาร์ท:

moltbot restart

หรือหยุดและเริ่มเกตเวย์/บริการตามต้องการ

วิธีที่ 2: การเชื่อมต่อผ่านการปรับใช้ Kimi K2.5 ภายในเครื่อง

การเรียกใช้ภายในเครื่องให้ความสำคัญกับความเป็นส่วนตัวและขจัดค่าใช้จ่ายที่เกิดขึ้นซ้ำๆ แม้ว่าจะต้องใช้ VRAM/RAM จำนวนมากก็ตาม

ขั้นตอนที่ 1: เปิดใช้งาน Local Inference Server

ใช้ llama.cpp เพื่อความเข้ากันได้

สร้าง llama.cpp ด้วยการรองรับ GPU หากมี:

git clone https://github.com/ggerganov/llama.cpp

cd llama.cpp

make LLAMA_CUDA=1 # or appropriate flags

ดาวน์โหลด GGUF variant ที่ถูกควอนไทซ์ (เช่น UD-TQ1_0 เพื่อความสมดุล):

ใช้ huggingface-cli หรือดาวน์โหลดโดยตรง

เริ่มเซิร์ฟเวอร์ที่เข้ากันได้กับ OpenAI:

./llama-server \

-m /path/to/Kimi-K2.5-UD-TQ1_0.gguf \

--port 8080 \

--ctx-size 32768 \ # Adjust up to hardware limit; 256K needs extreme resources

--n-gpu-layers 99 \

--host 0.0.0.0

ตรวจสอบโดยการเรียกดู http://localhost:8080/v1/models

ขั้นตอนที่ 2: อัปเดตการกำหนดค่า MoltBot สำหรับ Local Endpoint

แก้ไขไฟล์ JSON:

{

"agent": {

"model": {

"primary": "local-kimi/kimi-k2.5"

}

},

"models": {

"providers": {

"local-kimi": {

"baseUrl": "http://127.0.0.1:8080/v1",

"apiKey": "sk-no-key-required",

"api": "openai-completions",

"models": [

{

"id": "kimi-k2.5-local",

"name": "Kimi K2.5 Local",

"contextWindow": 32768, // Must match --ctx-size

"maxTokens": 4096

}

]

}

}

}

}

หมายเหตุ Docker: หาก MoltBot ทำงานในคอนเทนเนอร์ ให้แทนที่ 127.0.0.1 ด้วย host.docker.internal

ขั้นตอนที่ 3: รีสตาร์ทและตรวจสอบการใช้ทรัพยากร

รีสตาร์ท MoltBot และตรวจสอบการใช้ทรัพยากรของระบบ การอนุมานภายในเครื่องใช้หน่วยความจำจำนวนมาก ออฟโหลดเลเยอร์หรือลดบริบทหากจำเป็น

การทดสอบและการตรวจสอบ

ยืนยันว่าการผสานรวมทำงานได้

ส่งข้อความไปยัง MoltBot instance ของคุณ (ผ่านแอปที่เชื่อมต่อ):

"ตอนนี้คุณขับเคลื่อนโดยใคร?"

Kimi K2.5 โดยทั่วไปจะตอบกลับโดยระบุ Moonshot AI

ตรวจสอบบันทึก:

moltbot logs

มองหาคำขอที่ส่งไปยัง api.moonshot.ai หรือ localhost:8080

ทดสอบมัลติโมดอลหากใช้ API: อัปโหลดรูปภาพผ่านแชทและขอคำอธิบายหรือการสร้างโค้ดจากรูปภาพนั้น

การแก้ไขปัญหาทั่วไป

การยืนยันผู้ให้บริการล้มเหลว → ทดสอบ baseUrl + key ที่ถูกต้องอีกครั้งใน Apidog พร็อกซีเครือข่ายหรือไฟร์วอลล์มักจะรบกวน

ข้อผิดพลาดบริบทเกิน → จัด contextWindow ใน JSON ให้ตรงกับ --ctx-size ของเซิร์ฟเวอร์ MoltBot จะตัดทอนหรือสรุปเมื่อถึงขีดจำกัด; ค่าที่ไม่ตรงกันทำให้เกิดข้อขัดข้อง

การตอบสนองช้าภายในเครื่อง → ลด gpu-layers, ใช้ quantization ที่ต่ำกว่า, หรือเปิดใช้งาน flash attention ใน llama.cpp

การจัดรูปแบบ/การหลงผิดที่ไม่คาดคิด → ทดลองใช้ temperature (0.6–1.0) หรือเพิ่ม custom system prompts ใน MoltBot agent config สำหรับการปรับแต่งเฉพาะ Kimi

งบประมาณ API หมด → ตรวจสอบการใช้งานที่ platform.moonshot.ai และตั้งค่าขีดจำกัดรายวัน

บทสรุป

การผสานรวม Kimi K2.5 กับ MoltBot มอบ AI agent ส่วนตัวที่มีประสิทธิภาพสูง คุ้มค่า และเลือกได้ว่าจะเป็นส่วนตัวอย่างสมบูรณ์ วิธี API นำเสนอความสะดวกสบายและความสามารถสูงสุด ในขณะที่การตั้งค่าภายในเครื่องช่วยให้มั่นใจถึงอธิปไตยของข้อมูลอย่างสมบูรณ์

ทดลองใช้ทั้งสองวิธี ใช้ Apidog ตลอดกระบวนการเพื่อแยกแยะปัญหาได้อย่างรวดเร็ว ในขณะที่ Moonshot ยังคงอัปเดตโมเดล Kimi และ MoltBot พัฒนาขึ้นเรื่อยๆ การผสมผสานนี้จะทำให้ผู้ใช้อยู่ในแนวหน้าของ AI เชิงเอเจนต์ที่เข้าถึงได้

เริ่มกำหนดค่าเดี๋ยวนี้—ผู้ช่วยที่ได้รับการปรับปรุงของคุณกำลังรออยู่