กำลังประสบปัญหาในการประเมินและเพิ่มประสิทธิภาพไปป์ไลน์โมเดลภาษาขนาดใหญ่ (LLM) ของคุณอยู่ใช่ไหม? ขอแนะนำ LangWatch แพลตฟอร์มที่พลิกโฉมวงการซึ่งช่วยให้การตรวจสอบ ประเมิน และปรับแต่งเวิร์กโฟลว์ LLM ที่กำหนดเองของคุณเป็นเรื่องง่าย ในคู่มือนี้ เราจะเจาะลึกว่า LangWatch คืออะไร ทำไมถึงยอดเยี่ยม และวิธีการติดตั้งและใช้งานเพื่อเสริมพลังให้กับโปรเจกต์ AI ของคุณ เราจะแนะนำวิธีการตั้งค่าแชทบอทง่ายๆ การรวม LangWatch และการทดสอบด้วยคำถามตัวอย่าง—ทั้งหมดนี้ทำได้อย่างง่ายดาย มาเริ่มกันเลย!

ต้องการแพลตฟอร์มแบบครบวงจรสำหรับทีมพัฒนาของคุณเพื่อทำงานร่วมกันด้วย ประสิทธิภาพสูงสุด ใช่ไหม?

Apidog ตอบสนองทุกความต้องการของคุณ และ แทนที่ Postman ด้วยราคาที่คุ้มค่ากว่ามาก!

LangWatch คืออะไร และทำไมคุณถึงควรสนใจ?

LangWatch คือแพลตฟอร์มที่คุณไว้วางใจในการจัดการกับปัญหาที่ซับซ้อนของการประเมิน LLM ซึ่งแตกต่างจากโมเดลแบบดั้งเดิมที่มีเมตริกมาตรฐาน เช่น F1 score สำหรับการจัดหมวดหมู่, BLEU สำหรับการแปล หรือ ROUGE สำหรับการสรุปผล LLM แบบสร้างสรรค์นั้นไม่สามารถคาดเดาผลลัพธ์ได้ตายตัวและยากที่จะระบุได้อย่างแม่นยำ นอกจากนี้ ทุกบริษัทต่างก็มีข้อมูล โมเดลที่ปรับแต่ง และไปป์ไลน์ที่กำหนดเอง ทำให้การประเมินเป็นเรื่องที่น่าปวดหัว นั่นคือจุดที่ LangWatch โดดเด่น!

LangWatch ช่วยให้คุณสามารถ:

- ทดลองและเพิ่มประสิทธิภาพ: ทดสอบและปรับปรุงไปป์ไลน์ LLM ของคุณได้อย่างง่ายดาย

- ตรวจสอบประสิทธิภาพ: ติดตามพฤติกรรม AI ของคุณแบบเรียลไทม์

- ประเมินผลลัพธ์: ใช้ชุดข้อมูลและเครื่องมือประเมินเพื่อวัดความแม่นยำและคุณภาพ

- รองรับไปป์ไลน์ที่กำหนดเอง: ทำงานร่วมกับข้อมูลและโมเดลเฉพาะของคุณ

ไม่ว่าคุณจะกำลังสร้างแชทบอท เครื่องมือแปล หรือแอป AI ที่กำหนดเอง LangWatch ช่วยให้คุณมั่นใจว่า LLM ของคุณจะให้ผลลัพธ์ที่ยอดเยี่ยม พร้อมที่จะเห็นการทำงานแล้วหรือยัง? มาติดตั้งและใช้งาน LangWatch กันเถอะ!

คู่มือการติดตั้งและใช้งาน LangWatch ทีละขั้นตอน

ข้อกำหนดเบื้องต้น

ก่อนที่เราจะเริ่ม คุณจะต้องมี:

- Python 3.8+: สำหรับการรันโปรเจกต์ (python.org)

- บัญชี LangWatch: ลงทะเบียนได้ที่ app.langwatch.ai

- คีย์ API ของ OpenAI: สำหรับการสาธิตแชทบอท (รับได้ที่ platform.openai.com)

- โปรแกรมแก้ไขโค้ด: VS Code, PyCharm, หรือ IDE ที่คุณชื่นชอบ

- Git และ Docker: เป็นทางเลือก สำหรับการตั้งค่า LangWatch ในเครื่อง

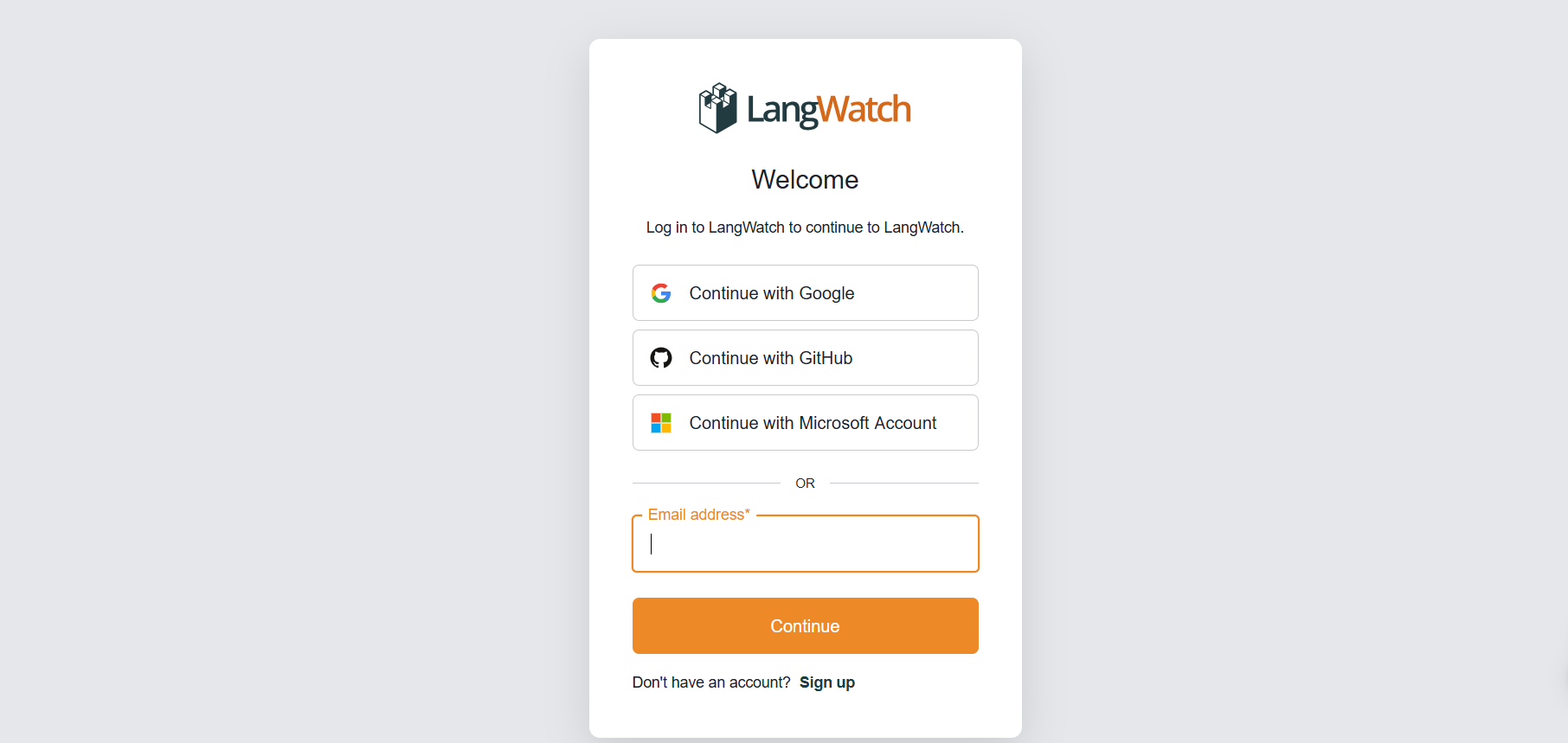

ขั้นตอนที่ 1: ลงทะเบียนสำหรับ LangWatch

สร้างบัญชี:

- ไปที่ app.langwatch.ai และลงทะเบียนบัญชีฟรี

- โปรเจกต์เริ่มต้นชื่อ “AI Bites” จะถูกสร้างขึ้นให้คุณ เราจะใช้โปรเจกต์นี้สำหรับบทเรียนนี้ แต่คุณสามารถสร้างโปรเจกต์ใหม่ได้หากต้องการ

รับคีย์ API ของคุณ:

- ในแดชบอร์ด LangWatch ของคุณ ไปที่ Project Settings เพื่อค้นหา

LANGWATCH_API_KEYคุณจะต้องใช้สิ่งนี้ในภายหลัง

ขั้นตอนที่ 2: ตั้งค่าโปรเจกต์ Python ด้วย LangWatch

มาสร้างโปรเจกต์ Python และรวม LangWatch เพื่อติดตามแชทบอทง่ายๆ กัน

- สร้างโฟลเดอร์โปรเจกต์:

- สร้างไดเรกทอรีใหม่ (เช่น

langwatch-demo) และเข้าไปในไดเรกทอรีนั้น:

mkdir langwatch-demo

cd langwatch-demo

2. ตั้งค่าสภาพแวดล้อมเสมือน (Virtual Environment):

- สร้างและเปิดใช้งานสภาพแวดล้อมเสมือนเพื่อแยกการพึ่งพา (dependencies) ออกจากกัน:

python -m venv venv

source venv/bin/activate # On Windows: venv\Scripts\activate

3. ติดตั้ง LangWatch และ Dependencies:

- ติดตั้ง LangWatch และ Chainlit (สำหรับ UI ของแชทบอท):

pip install langwatch chainlit openai

4. สร้างโค้ดแชทบอท:

- สร้างไฟล์ชื่อ

app.pyและวางโค้ดนี้เพื่อสร้างแชทบอทง่ายๆ โดยใช้โมเดล GPT-4o-mini ของ OpenAI:

import os

import chainlit as cl

import asyncio

from openai import AsyncClient

openai_client = AsyncClient() # Assumes OPENAI_API_KEY is set in environment

model_name = "gpt-4o-mini"

settings = {

"temperature": 0.3,

"max_tokens": 500,

"top_p": 1,

"frequency_penalty": 0,

"presence_penalty": 0,

}

@cl.on_chat_start

async def start():

cl.user_session.set(

"message_history",

[

{

"role": "system",

"content": "You are a helpful assistant that only reply in short tweet-like responses, using lots of emojis."

}

]

)

async def answer_as(name: str):

message_history = cl.user_session.get("message_history")

msg = cl.Message(author=name, content="")

stream = await openai_client.chat.completions.create(

model=model_name,

messages=message_history + [{"role": "user", "content": f"speak as {name}"}],

stream=True,

**settings,

)

async for part in stream:

if token := part.choices[0].delta.content or "":

await msg.stream_token(token)

message_history.append({"role": "assistant", "content": msg.content})

await msg.send()

@cl.on_message

async def main(message: cl.Message):

message_history = cl.user_session.get("message_history")

message_history.append({"role": "user", "content": message.content})

await asyncio.gather(answer_as("AI Bites"))

5. ตั้งค่าคีย์ API ของ OpenAI ของคุณ:

- เพิ่มคีย์ API ของ OpenAI ของคุณเป็นตัวแปรสภาพแวดล้อม:

export OPENAI_API_KEY="your-openai-api-key" # On Windows: set OPENAI_API_KEY=your-openai-api-key

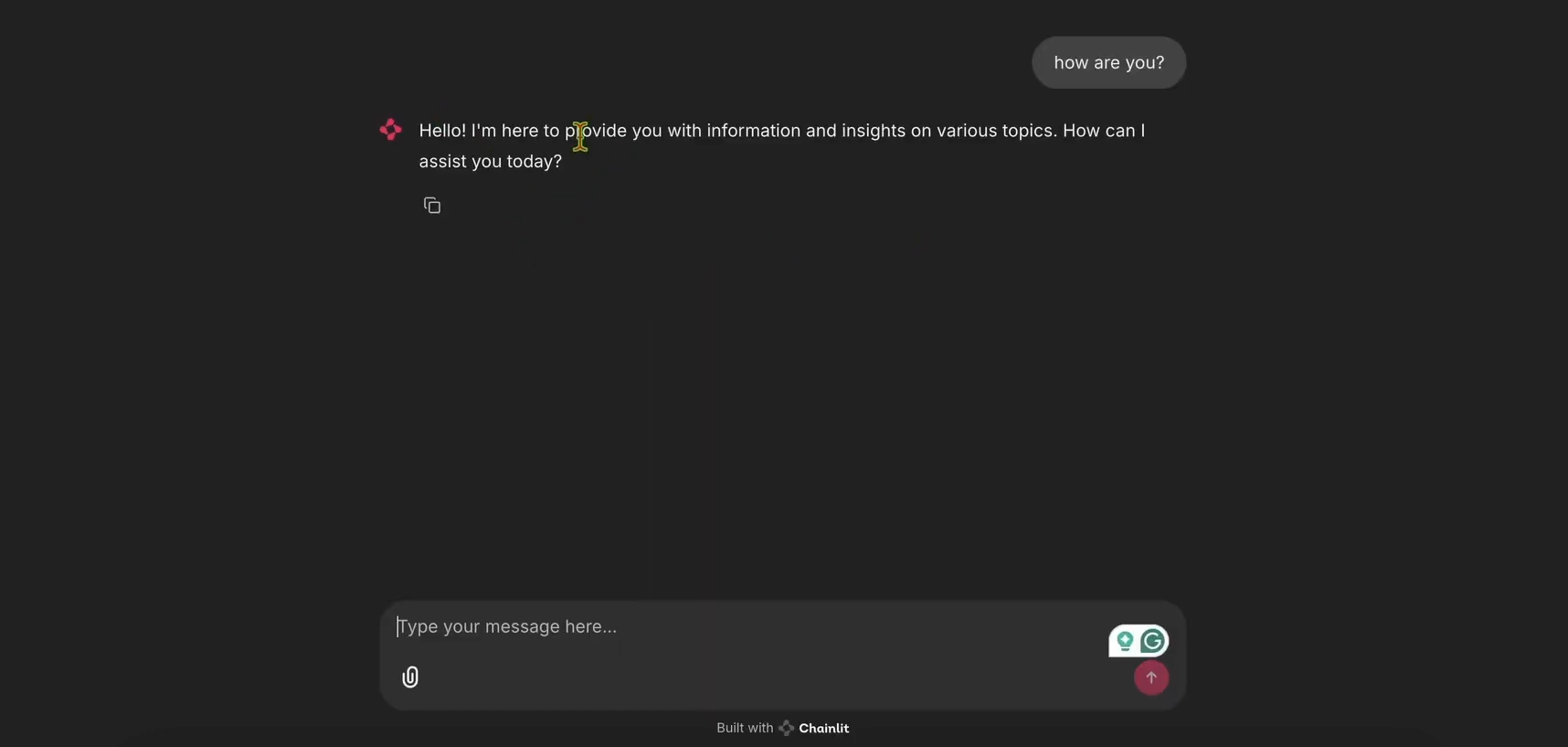

6. รันแชทบอท:

- เริ่มแอป Chainlit:

chainlit run app.py

- เปิด http://localhost:8000 เพื่อดู UI ของแชทบอท ลองใช้งานเพื่อให้แน่ใจว่าทำงานได้!

ขั้นตอนที่ 3: ผสานรวม LangWatch สำหรับการติดตาม

ตอนนี้ มาเพิ่ม LangWatch เพื่อติดตามข้อความของแชทบอทกัน

- แก้ไข

app.pyสำหรับ LangWatch:

- อัปเดต

app.pyเพื่อรวม LangWatch และเพิ่ม decorator@langwatch.trace()ไปยังฟังก์ชันmain:

import os

import chainlit as cl

import asyncio

import langwatch

from openai import AsyncClient

openai_client = AsyncClient()

model_name = "gpt-4o-mini"

settings = {

"temperature": 0.3,

"max_tokens": 500,

"top_p": 1,

"frequency_penalty": 0,

"presence_penalty": 0,

}

@cl.on_chat_start

async def start():

cl.user_session.set(

"message_history",

[

{

"role": "system",

"content": "You are a helpful assistant that only reply in short tweet-like responses, using lots of emojis."

}

]

)

async def answer_as(name: str):

message_history = cl.user_session.get("message_history")

msg = cl.Message(author=name, content="")

stream = await openai_client.chat.completions.create(

model=model_name,

messages=message_history + [{"role": "user", "content": f"speak as {name}"}],

stream=True,

**settings,

)

async for part in stream:

if token := part.choices[0].delta.content or "":

await msg.stream_token(token)

message_history.append({"role": "assistant", "content": msg.content})

await msg.send()

@cl.on_message

@langwatch.trace()

async def main(message: cl.Message):

message_history = cl.user_session.get("message_history")

message_history.append({"role": "user", "content": message.content})

await asyncio.gather(answer_as("AI Bites"))

2. ทดสอบการผสานรวม:

- รีสตาร์ทแอป Chainlit:

chainlit run app.py

- ใน UI ของแชทบอท ให้ถามว่า: “วันนี้ภาษาฝรั่งเศสว่าอะไร?”

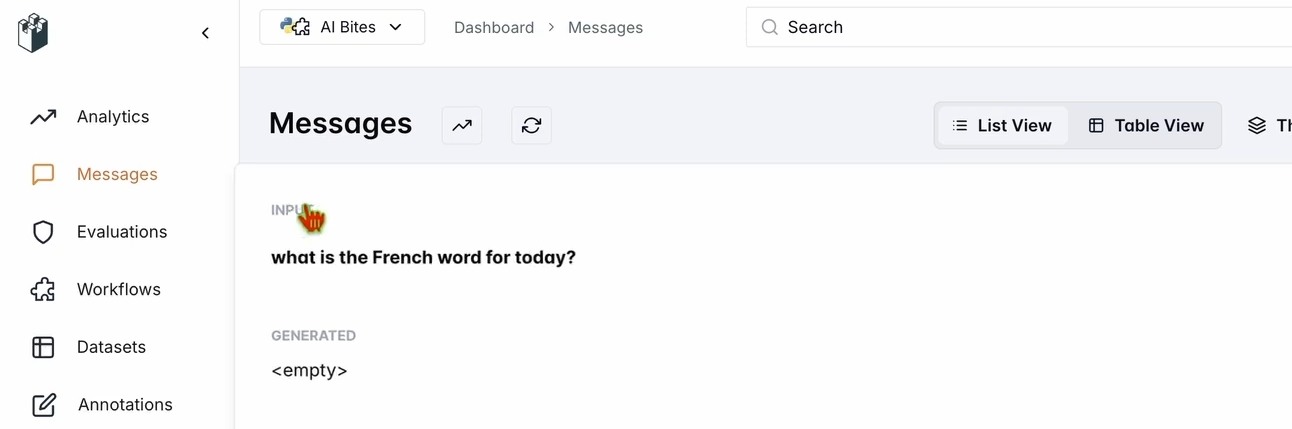

- ตรวจสอบแดชบอร์ด LangWatch ของคุณ:

- ไปที่ app.langwatch.ai

- เลือก Messages จากแถบด้านข้างซ้าย

- ตรวจสอบว่าคำถามของคุณและการตอบกลับของแชทบอท (เช่น “Aujourd’hui! 🇫🇷😊”) ถูกติดตามแล้ว

ขั้นตอนที่ 4: ตั้งค่าเวิร์กโฟลว์เพื่อประเมินแชทบอทของคุณ

มาสร้างชุดข้อมูลและเครื่องมือประเมินใน LangWatch เพื่อประเมินประสิทธิภาพของแชทบอทกัน

- สร้างชุดข้อมูล (Dataset):

- ในแดชบอร์ด LangWatch ไปที่ Datasets และคลิก New Dataset

- เพิ่มชุดข้อมูลอย่างง่ายที่มีคำถามและคำตอบอย่างน้อยหนึ่งชุด ตัวอย่างเช่น:

| คำถาม | คำตอบที่คาดหวัง |

|---|---|

| วันนี้ภาษาฝรั่งเศสว่าอะไร? | Aujourd’hui |

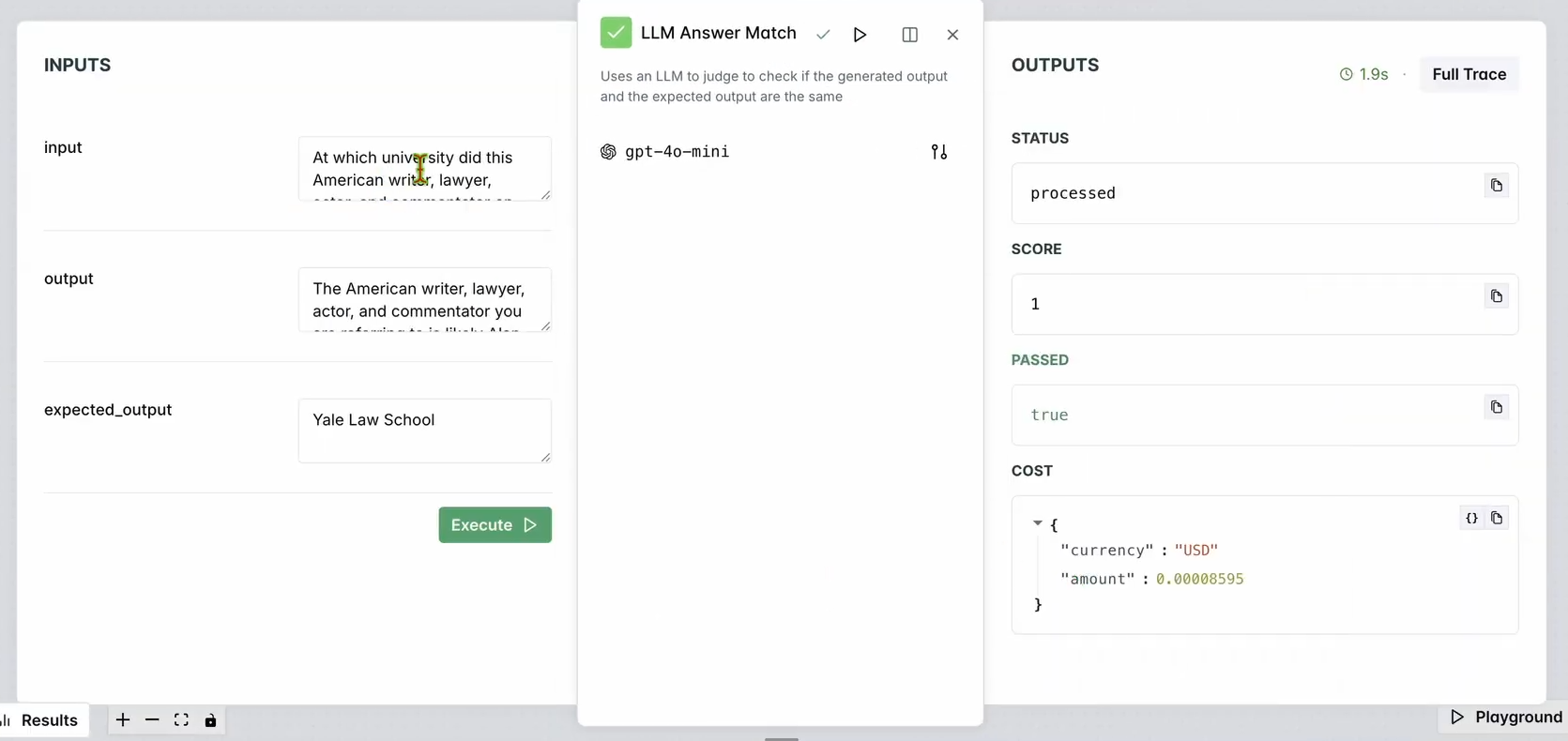

2. ตั้งค่าเครื่องมือประเมิน (Evaluator):

- ไปที่ Evaluators ในแดชบอร์ด LangWatch

- ลากเครื่องมือประเมิน LLM Answer Match เข้าไปในพื้นที่ทำงาน

- กำหนดค่า:

- ตั้งค่า Input Question ให้เป็นคำถามอินพุตในฐานข้อมูลของคุณ (เช่น “วันนี้ภาษาฝรั่งเศสว่าอะไร?”)

- ตั้งค่า Expected Output ให้เป็นคำตอบของฐานข้อมูลของคุณด้วย (เช่น “Aujourd’hui”)

- เลือกได้ว่าจะเปลี่ยนโมเดล LLM ของเครื่องมือประเมิน (เช่น Llama, Gemini, หรือ Claude Sonnet) เพื่อความหลากหลาย

3. รันเครื่องมือประเมิน:

- คลิก Run Workflow Until Here เพื่อทดสอบเครื่องมือประเมิน

- ตรวจสอบผลลัพธ์เพื่อให้แน่ใจว่าการตอบกลับของแชทบอทตรงกับผลลัพธ์ที่คาดหวัง

คุณควรเห็นบางอย่างเช่น:

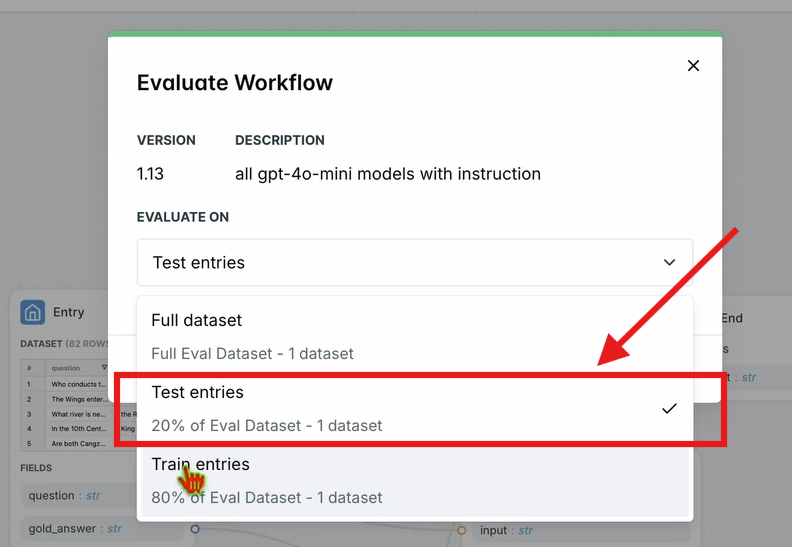

4. ประเมินเวิร์กโฟลว์:

- ในแถบนำทางด้านบน คลิก Evaluate Workflow และเลือก Test Entries

- สิ่งนี้จะประเมินเวิร์กโฟลว์ทั้งหมดเทียบกับชุดข้อมูลของคุณ ผลลัพธ์จะปรากฏขึ้นหลังจากเวลาประมวลผลสั้นๆ

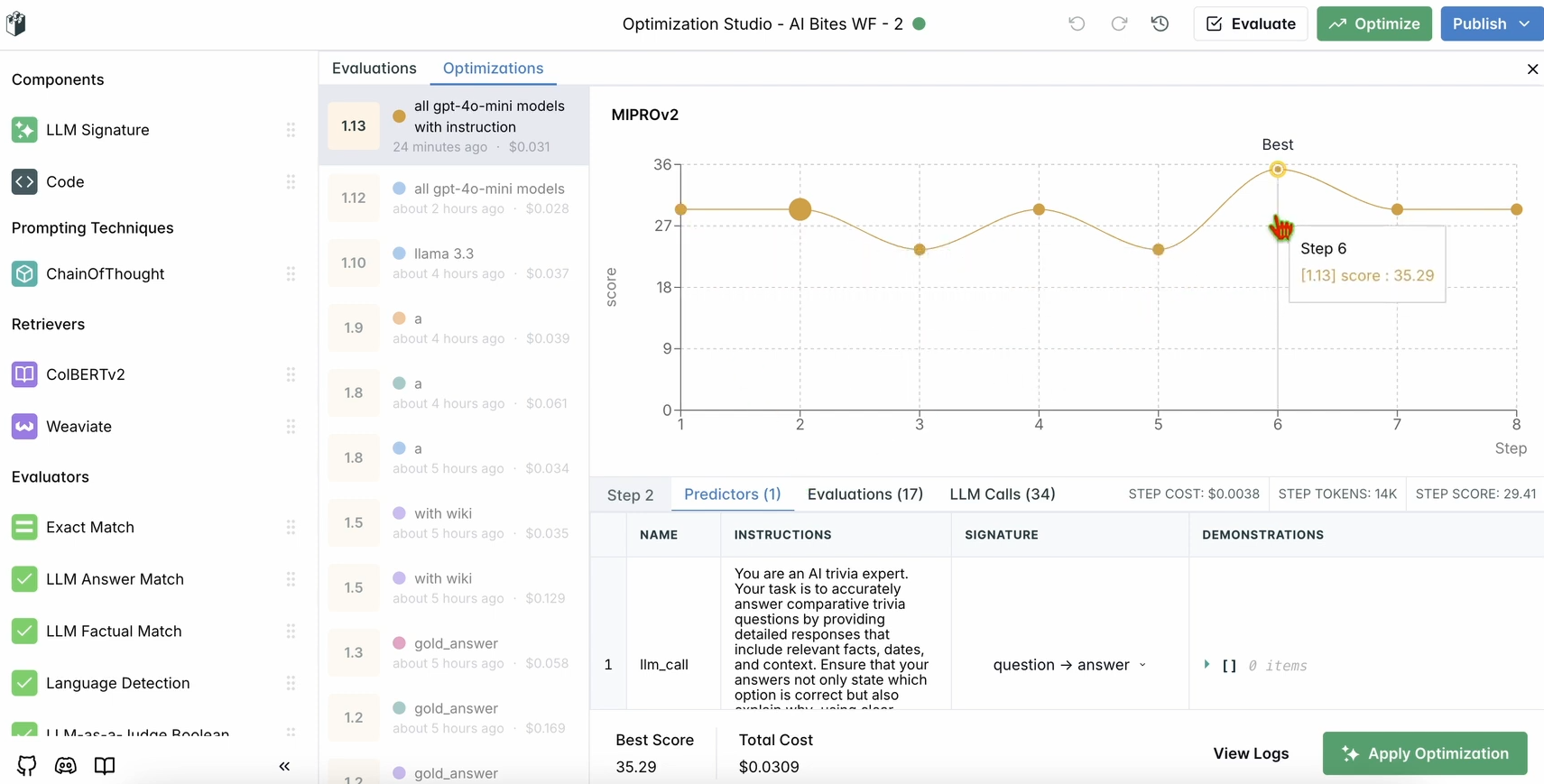

ขั้นตอนที่ 5: เพิ่มประสิทธิภาพเวิร์กโฟลว์ของคุณ

เมื่อการประเมินของคุณเสร็จสมบูรณ์ มาเพิ่มประสิทธิภาพการทำงานของแชทบอทกัน

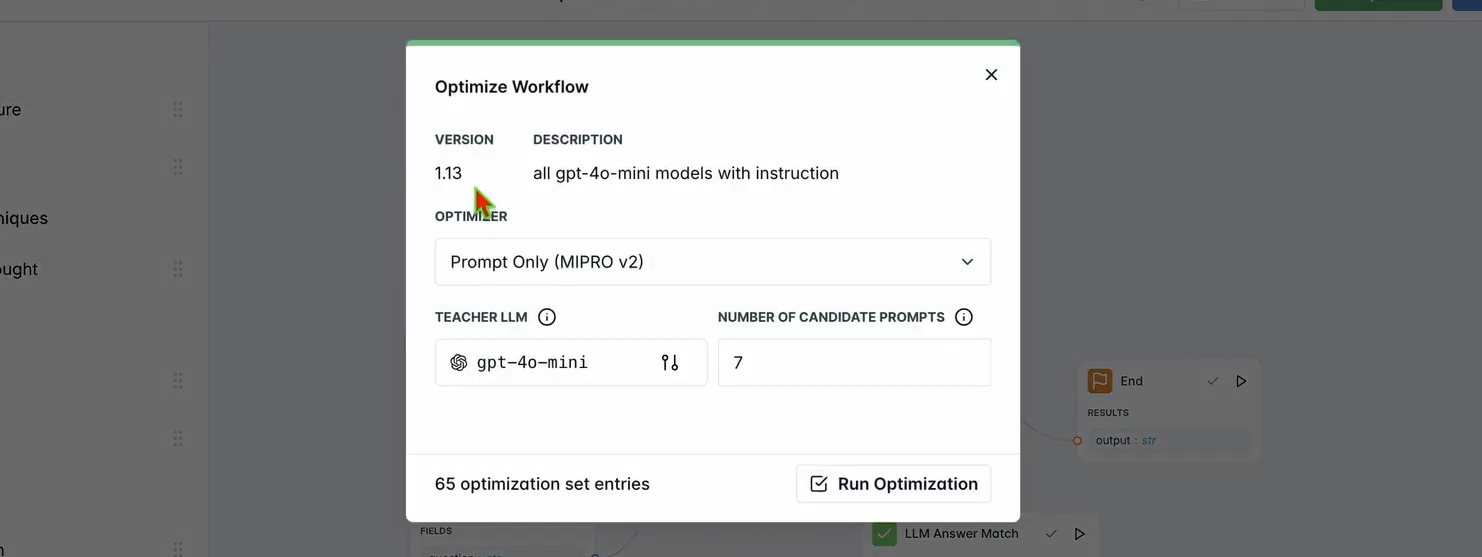

1. รันการเพิ่มประสิทธิภาพ:

- ในแดชบอร์ด LangWatch คลิก Optimize ในแถบนำทางด้านบน

- เลือก Prompt Only เพื่อปรับแต่ง prompt ของแชทบอท

- รอสักครู่เพื่อให้การเพิ่มประสิทธิภาพเสร็จสมบูรณ์

2. ตรวจสอบการปรับปรุง:

- ตรวจสอบผลลัพธ์ที่ได้รับการเพิ่มประสิทธิภาพในแดชบอร์ด คุณควรเห็นความแม่นยำหรือคุณภาพของการตอบกลับที่ดีขึ้นตามคำแนะนำของ LangWatch

ขั้นตอนที่ 6: การตั้งค่า LangWatch ในเครื่อง (ทางเลือก)

ต้องการรัน LangWatch ในเครื่องเพื่อทดสอบกับข้อมูลที่ละเอียดอ่อนใช่ไหม? ทำตามขั้นตอนเหล่านี้:

- โคลน Repository:

git clone https://github.com/langwatch/langwatch.git

cd langwatch

2. ตั้งค่าสภาพแวดล้อม:

- คัดลอกไฟล์สภาพแวดล้อมตัวอย่าง:

cp langwatch/.env.example langwatch/.env

3. รันด้วย Docker:

- เริ่มเซิร์ฟเวอร์ LangWatch:

docker compose up -d --wait --build

4. เข้าถึงแดชบอร์ด:

- เปิด http://localhost:5560 เพื่อเข้าสู่ขั้นตอนการเริ่มต้นใช้งาน (onboarding flow) ของ LangWatch

- ทำตามคำแนะนำเพื่อตั้งค่าอินสแตนซ์ในเครื่องของคุณ

หมายเหตุ: การตั้งค่า Docker นี้มีไว้สำหรับการทดสอบเท่านั้น และไม่สามารถปรับขนาดสำหรับการใช้งานจริงได้ สำหรับการใช้งานจริง โปรดใช้ LangWatch Cloud หรือ Enterprise On-Premises

ทำไมต้องใช้ LangWatch?

LangWatch ช่วยไขปริศนาการประเมิน LLM ด้วยการนำเสนอแพลตฟอร์มแบบครบวงจรเพื่อตรวจสอบ ประเมิน และเพิ่มประสิทธิภาพไปป์ไลน์ AI ของคุณ ไม่ว่าคุณจะกำลังปรับแต่ง prompt วิเคราะห์ประสิทธิภาพ หรือตรวจสอบให้แน่ใจว่าแชทบอทของคุณให้คำตอบที่ถูกต้อง (เช่น “Aujourd’hui” สำหรับ “today” ในภาษาฝรั่งเศส) LangWatch ทำให้เป็นเรื่องง่าย การผสานรวมกับ Python และเครื่องมืออย่าง Chainlit และ OpenAI หมายความว่าคุณสามารถเริ่มติดตามและปรับปรุงแอป LLM ของคุณได้ในไม่กี่นาที

ตัวอย่างเช่น แชทบอทสาธิตของเราตอนนี้ตอบกลับเป็นข้อความสั้นๆ คล้ายทวีตพร้อมอีโมจิ และ LangWatch ช่วยให้มั่นใจว่าถูกต้องและได้รับการเพิ่มประสิทธิภาพ ต้องการขยายขนาดใช่ไหม? เพิ่มคำถามในชุดข้อมูลของคุณ หรือทดลองกับโมเดล LLM ที่แตกต่างกันในเครื่องมือประเมิน

บทสรุป

และนี่คือทั้งหมด! คุณได้เรียนรู้แล้วว่า LangWatch คืออะไร วิธีการติดตั้ง และวิธีการใช้งานเพื่อตรวจสอบและเพิ่มประสิทธิภาพแชทบอท ตั้งแต่การตั้งค่าโปรเจกต์ Python ไปจนถึงการติดตามข้อความและการประเมินประสิทธิภาพด้วยชุดข้อมูล LangWatch ช่วยให้คุณสามารถควบคุมไปป์ไลน์ LLM ของคุณได้ คำถามทดสอบของเรา—“วันนี้ภาษาฝรั่งเศสว่าอะไร?”—แสดงให้เห็นว่าการติดตามและปรับปรุงการตอบกลับของ AI นั้นง่ายดายเพียงใด

พร้อมที่จะยกระดับเกม AI ของคุณแล้วหรือยัง? ไปที่ app.langwatch.ai ลงทะเบียน และเริ่มทดลองกับ LangWatch ได้เลยวันนี้

ต้องการแพลตฟอร์มแบบครบวงจรสำหรับทีมพัฒนาของคุณเพื่อทำงานร่วมกันด้วย ประสิทธิภาพสูงสุด ใช่ไหม?

Apidog ตอบสนองทุกความต้องการของคุณ และ แทนที่ Postman ด้วยราคาที่คุ้มค่ากว่ามาก!