OpenAI พัฒนาขีดความสามารถของปัญญาประดิษฐ์ให้ก้าวหน้ายิ่งขึ้นด้วยการเปิดตัว gpt-realtime พร้อมกับการปรับปรุง Realtime API ครั้งสำคัญ การพัฒนานี้มุ่งเป้าไปที่นักพัฒนาที่สร้างแอปพลิเคชันเสียงแบบโต้ตอบ โดยนำเสนอการประมวลผลเสียงพูดเป็นเสียงพูดโดยตรงที่สามารถจับความแตกต่างเล็กน้อย เช่น น้ำเสียงและสัญญาณที่ไม่ใช่คำพูดได้ วิศวกรสามารถเข้าถึงโมเดลที่ประมวลผลอินพุตเสียงและสร้างการตอบสนองด้วยความหน่วงต่ำ ซึ่งถือเป็นการเปลี่ยนแปลงวิธีที่ AI จัดการการสนทนาแบบเรียลไทม์

นอกจากนี้ การอัปเดตนี้ยังสอดคล้องกับความต้องการที่เพิ่มขึ้นสำหรับระบบ AI แบบหลายโมดอล นักพัฒนาสามารถรวมเสียง ข้อความ และรูปภาพเข้าด้วยกันได้อย่างราบรื่น ขยายความเป็นไปได้สำหรับแอปพลิเคชันในการบริการลูกค้า ผู้ช่วยเสมือน และความบันเทิงแบบโต้ตอบ ในขณะที่เราสำรวจความก้าวหน้าเหล่านี้ โปรดพิจารณาว่าการปรับปรุงเล็กน้อยในการออกแบบ API นำไปสู่การปรับปรุงประสบการณ์ผู้ใช้ที่สำคัญได้อย่างไร

ทำความเข้าใจ GPT-Realtime: โมเดลหลัก

OpenAI เปิดตัว gpt-realtime ในฐานะโมเดลพิเศษที่ออกแบบมาสำหรับการโต้ตอบแบบเสียงพูดเป็นเสียงพูดแบบครบวงจร โมเดลนี้ช่วยขจัดขั้นตอนแบบเดิมที่แยกการรู้จำเสียง การประมวลผลภาษา และการสังเคราะห์ข้อความเป็นเสียงพูดออกไป แต่จะจัดการทุกอย่างในกรอบการทำงานแบบรวมศูนย์ ลดความหน่วงและรักษาความละเอียดอ่อนของเสียงพูดของมนุษย์

gpt-realtime มีความโดดเด่นในการสร้างเอาต์พุตเสียงที่ฟังดูเป็นธรรมชาติ ตัวอย่างเช่น มันตอบสนองต่อคำสั่งเช่น "พูดเร็วและเป็นมืออาชีพ" หรือ "ใช้น้ำเสียงที่เห็นอกเห็นใจพร้อมสำเนียงฝรั่งเศส" การควบคุมที่ละเอียดอ่อนเช่นนี้ช่วยให้นักพัฒนาสามารถปรับแต่งเสียง AI ให้เข้ากับสถานการณ์เฉพาะได้ ซึ่งช่วยเพิ่มการมีส่วนร่วมในแอปพลิเคชันจริง

นอกจากนี้ โมเดลยังแสดงความฉลาดที่เหนือกว่าในการประมวลผลอินพุตเสียงต้นฉบับ มันตรวจจับองค์ประกอบที่ไม่ใช่คำพูด เช่น เสียงหัวเราะหรือการหยุดชั่วคราว และปรับตัวตามความเหมาะสม หากผู้ใช้เปลี่ยนภาษาในระหว่างประโยค gpt-realtime ก็จะดำเนินการตามโดยไม่หยุดชะงัก

ความสามารถนี้เกิดจากการฝึกอบรมขั้นสูงบนชุดข้อมูลที่หลากหลาย ทำให้สามารถทำคะแนนได้ 30.5% ในการวัดประสิทธิภาพเสียง MultiChallenge ซึ่งเป็นการปรับปรุงที่โดดเด่นจากเวอร์ชันก่อนหน้า

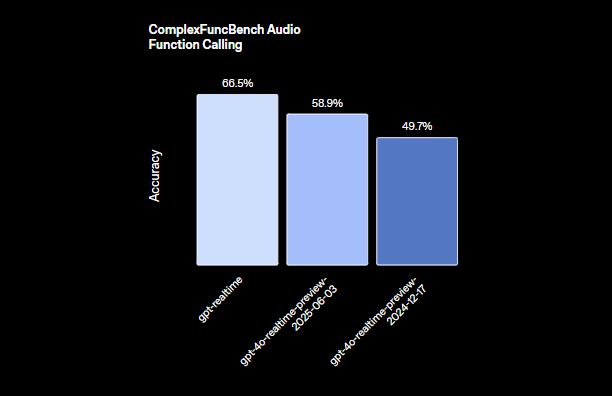

วิศวกรชื่นชมวิธีที่ gpt-realtime รวมการเรียกใช้ฟังก์ชัน ด้วยคะแนน 66.5% ใน ComplexFuncBench ทำให้สามารถเรียกใช้เครื่องมือแบบอะซิงโครนัสได้ ทำให้มั่นใจได้ว่าการสนทนายังคงราบรื่นแม้ในระหว่างการคำนวณที่ยาวนาน ตัวอย่างเช่น ในขณะที่ AI ประมวลผลคำสั่งฐานข้อมูล มันยังคงมีส่วนร่วมกับผู้ใช้ด้วยการตอบกลับแบบเติมเต็มหรือการอัปเดต

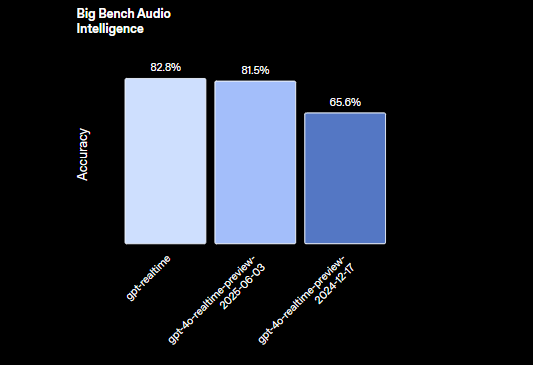

ยิ่งไปกว่านั้น gpt-realtime ยังรองรับงานการให้เหตุผลด้วยความแม่นยำ 82.8% ในการประเมิน Big Bench Audio ซึ่งช่วยให้สามารถจัดการคำถามที่ซับซ้อนที่เกี่ยวข้องกับการอนุมานเชิงตรรกะได้โดยตรงจากอินพุตเสียง โดยไม่ต้องแปลงเป็นข้อความเลย

OpenAI เปิดตัวเสียงใหม่สองเสียง ได้แก่ Marin และ Cedar ซึ่งเป็นเอกสิทธิ์เฉพาะสำหรับโมเดลนี้ พร้อมกับการอัปเดตเสียงที่มีอยู่แปดเสียงเพื่อให้ได้เอาต์พุตที่แสดงออกได้ดียิ่งขึ้น การปรับปรุงเหล่านี้ช่วยให้มั่นใจได้ว่าการโต้ตอบของ AI ให้ความรู้สึกเหมือนมนุษย์มากขึ้น ลดช่องว่างระหว่างการตอบสนองที่เขียนสคริปต์กับการสนทนาที่แท้จริง

เมื่อเปลี่ยนมาพิจารณาถึงผลกระทบในทางปฏิบัติ นักพัฒนาใช้ gpt-realtime เพื่อสร้างแอปพลิเคชันที่ตอบสนองแบบเรียลไทม์ เช่น บริการแปลภาษาแบบสด หรือเครื่องมือเล่าเรื่องแบบโต้ตอบ ประสิทธิภาพของโมเดลช่วยลดภาระการคำนวณ ทำให้เหมาะสำหรับการปรับใช้บนอุปกรณ์ Edge หรือโครงสร้างพื้นฐานคลาวด์

คุณสมบัติหลักของ Realtime API

Realtime API ได้รับการอัปเกรดครั้งสำคัญ เสริมความสามารถของ gpt-realtime OpenAI ได้เพิ่มคุณสมบัติที่อำนวยความสะดวกในการสร้างเอเจนต์เสียงที่พร้อมใช้งานจริง โดยเน้นที่ความน่าเชื่อถือ ความสามารถในการปรับขนาด และความง่ายในการรวมระบบ

ประการแรก การรองรับเซิร์ฟเวอร์ MCP (Multi-Cloud Provider) ระยะไกลมีความโดดเด่น นักพัฒนาสามารถกำหนดค่าเซิร์ฟเวอร์ภายนอกสำหรับการเรียกใช้เครื่องมือ เช่น การรวมเข้ากับ Stripe สำหรับการชำระเงิน การตั้งค่านี้ช่วยลดความซับซ้อนของขั้นตอนการทำงานโดยการถ่ายโอนฟังก์ชันเฉพาะไปยังบริการพิเศษ คุณระบุ URL ของเซิร์ฟเวอร์ โทเค็นการอนุญาต และข้อกำหนดการอนุมัติได้โดยตรงในเซสชัน API

ถัดไป ฟังก์ชันการป้อนข้อมูลรูปภาพช่วยขยายขอบเขตหลายโมดอลของ API แอปพลิเคชันสามารถเพิ่มรูปภาพ ภาพถ่าย หรือภาพหน้าจอลงในเซสชันที่กำลังดำเนินอยู่ ทำให้สามารถสนทนาโดยอิงจากภาพได้ ตัวอย่างเช่น ผู้ใช้อัปโหลดแผนภาพ และ AI จะอธิบายหรือตอบคำถามเกี่ยวกับเนื้อหา คุณสมบัตินี้ถือว่ารูปภาพเป็นองค์ประกอบคงที่ ซึ่งควบคุมโดยตรรกะของแอปพลิเคชันเพื่อรักษาบริบท

นอกจากนี้ การรองรับ SIP (Session Initiation Protocol) ยังเชื่อมต่อ API เข้ากับเครือข่ายโทรศัพท์สาธารณะ ระบบ PBX และโทรศัพท์ตั้งโต๊ะ สิ่งนี้เชื่อมโยง AI ดิจิทัลเข้ากับการโทรศัพท์แบบดั้งเดิม ทำให้เอเจนต์เสียงสามารถจัดการการโทรจากโทรศัพท์บ้านหรือโทรศัพท์มือถือได้อย่างราบรื่น

พร้อมต์ที่นำกลับมาใช้ใหม่ได้เป็นอีกหนึ่งส่วนเพิ่มเติมที่สำคัญ นักพัฒนาสามารถบันทึกและนำข้อความสำหรับนักพัฒนา เครื่องมือ ตัวแปร และตัวอย่างกลับมาใช้ใหม่ได้ในหลายเซสชัน สิ่งนี้ส่งเสริมความสอดคล้องและลดเวลาในการตั้งค่าสำหรับการโต้ตอบที่เกิดขึ้นซ้ำ เช่น สคริปต์การสนับสนุนลูกค้ามาตรฐาน

API ได้รับการปรับให้เหมาะสมสำหรับการโต้ตอบที่มีความหน่วงต่ำ ทำให้มั่นใจได้ถึงความน่าเชื่อถือสูงในสภาพแวดล้อมการผลิต มันประมวลผลอินพุตหลายโมดอล ทั้งเสียงและรูปภาพ ในขณะที่รักษาสถานะเซสชัน ซึ่งป้องกันการสูญเสียบริบทในการสนทนาที่ยาวนาน

ในแง่ของการจัดการเสียง Realtime API เชื่อมต่อโดยตรงกับ gpt-realtime เพื่อสร้างเสียงพูดที่แสดงออกได้ดี มันจับความแตกต่างเล็กน้อยที่ระบบดั้งเดิมมักจะละทิ้งไป ซึ่งนำไปสู่ประสบการณ์ผู้ใช้ที่น่าสนใจยิ่งขึ้น

นักพัฒนายังได้รับประโยชน์จากคุณสมบัติระดับองค์กร รวมถึง EU Data Residency เพื่อการปฏิบัติตามข้อกำหนดและข้อผูกพันด้านความเป็นส่วนตัวที่ปกป้องข้อมูลที่ละเอียดอ่อน

เมื่อเปลี่ยนมาเน้นที่เมตริกประสิทธิภาพ การอัปเดตเหล่านี้โดยรวมช่วยเพิ่มประโยชน์ของ API ตัวอย่างเช่น การเรียกใช้ฟังก์ชันแบบอะซิงโครนัสช่วยป้องกันคอขวด ทำให้ AI สามารถทำงานหลายอย่างพร้อมกันได้โดยไม่ขัดจังหวะการทำงาน

วิธีใช้ GPT-Realtime API: คำแนะนำทีละขั้นตอน

นักพัฒนาสามารถรวม gpt-realtime API ผ่านปลายทางและการกำหนดค่าที่ตรงไปตรงมา เริ่มต้นด้วยการรับคีย์ API จากแพลตฟอร์ม OpenAI เพื่อให้แน่ใจว่าบัญชีของคุณรองรับ Realtime API

ในการเริ่มต้นเซสชัน ให้ส่งคำขอ POST เพื่อสร้าง realtime client secret ใส่พารามิเตอร์เซสชัน เช่น เครื่องมือและประเภท สำหรับการรวม MCP ระยะไกล ให้จัดโครงสร้างเพย์โหลดดังนี้:

// POST /v1/realtime/client_secrets

{

"session": {

"type": "realtime",

"tools": [

{

"type": "mcp",

"server_label": "stripe",

"server_url": "https://mcp.stripe.com",

"authorization": "{access_token}",

"require_approval": "never"

}

]

}

}

โค้ดนี้ตั้งค่าเครื่องมือสำหรับการชำระเงิน Stripe โดยที่ API จะส่งการเรียกไปยังเซิร์ฟเวอร์ที่ระบุโดยไม่ต้องขอการอนุมัติจากผู้ใช้ทุกครั้ง

เมื่อเซสชันเริ่มต้นขึ้น ให้จัดการการโต้ตอบแบบเรียลไทม์ผ่านการเชื่อมต่อ WebSocket สร้าง WebSocket ไปยังปลายทาง Realtime API โดยส่งสตรีมเสียงเป็นข้อมูลไบนารี API จะประมวลผลอินพุตและส่งคืนเอาต์พุตเสียงแบบเรียลไทม์

สำหรับอินพุตเสียง ให้เข้ารหัสเสียงพูดของผู้ใช้แล้วส่งไป gpt-realtime จะวิเคราะห์เสียง สร้างการตอบสนองตามบริบทของเซสชัน หากต้องการรวมรูปภาพ ให้ใช้เหตุการณ์การสร้างรายการการสนทนา:

{

"type": "conversation.item.create",

"previous_item_id": null,

"item": {

"type": "message",

"role": "user",

"content": [

{

"type": "input_image",

"image_url": "data:image/png;base64,{base64_image_data}"

}

]

}

}

แทนที่ {base64_image_data} ด้วยข้อมูลรูปภาพที่เข้ารหัส base64 จริง สิ่งนี้จะเพิ่มบริบททางภาพ ทำให้ AI สามารถอ้างอิงได้ในการตอบสนอง

จัดการสถานะเซสชันโดยการตั้งค่าขีดจำกัดโทเค็นและการตัดทอนรอบสนทนาที่เก่ากว่าเพื่อควบคุมต้นทุน สำหรับการสนทนาที่ยาวนาน ให้ล้างประวัติที่ไม่จำเป็นเป็นระยะๆ ในขณะที่ยังคงรายละเอียดที่สำคัญไว้

ในการจัดการการเรียกใช้ฟังก์ชัน ให้กำหนดเครื่องมือในการตั้งค่าเซสชัน เมื่อ AI เรียกใช้ฟังก์ชัน API จะดำเนินการแบบอะซิงโครนัส โดยส่งการอัปเดตชั่วคราวเพื่อรักษาการสนทนาให้ดำเนินต่อไป

สำหรับการรวม SIP ให้กำหนดค่าแอปพลิเคชันของคุณเพื่อส่งการโทรผ่านเกตเวย์ที่เข้ากันได้ ซึ่งเกี่ยวข้องกับการตั้งค่า SIP trunk และเชื่อมโยงเข้ากับเซสชัน Realtime API

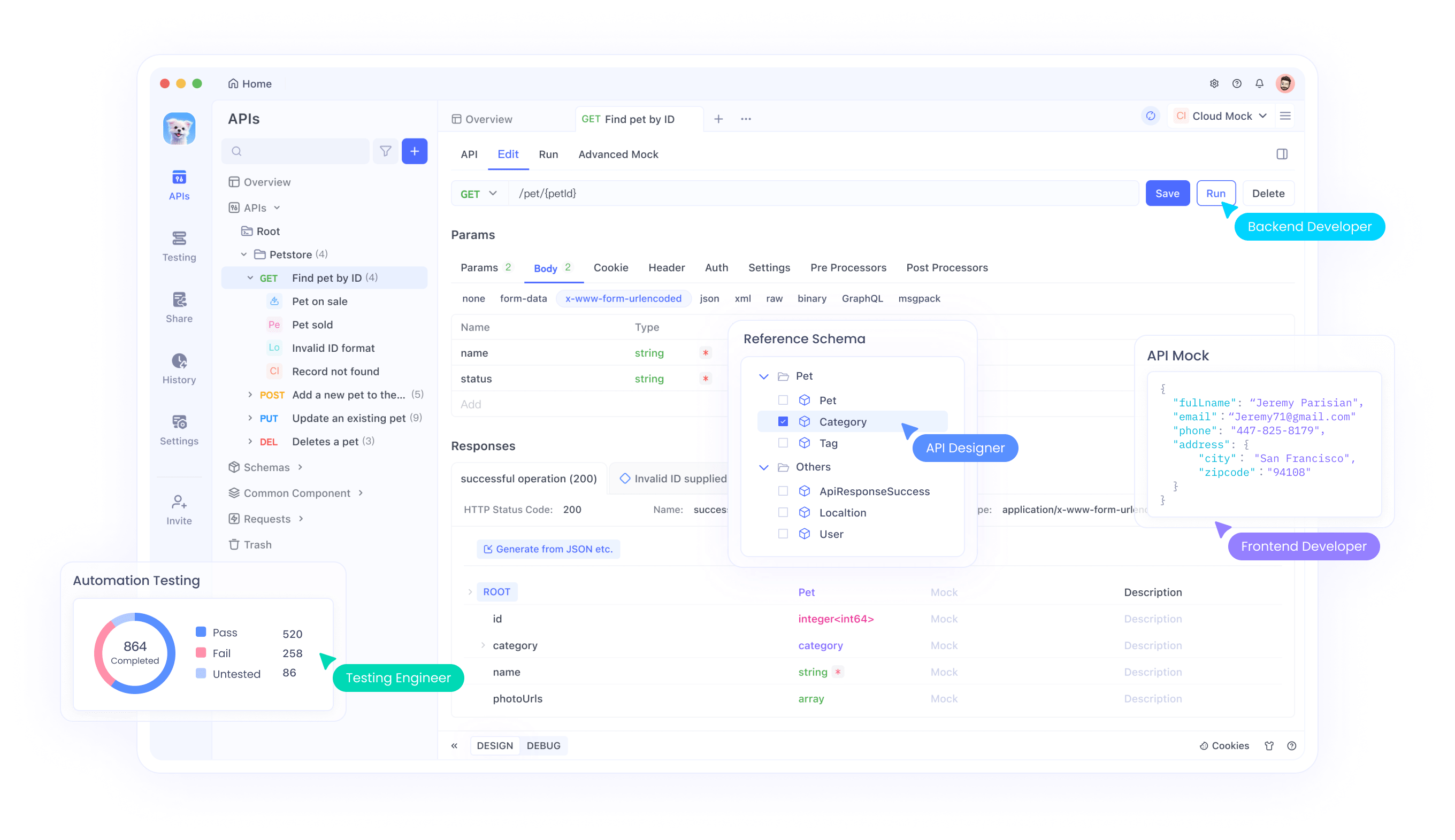

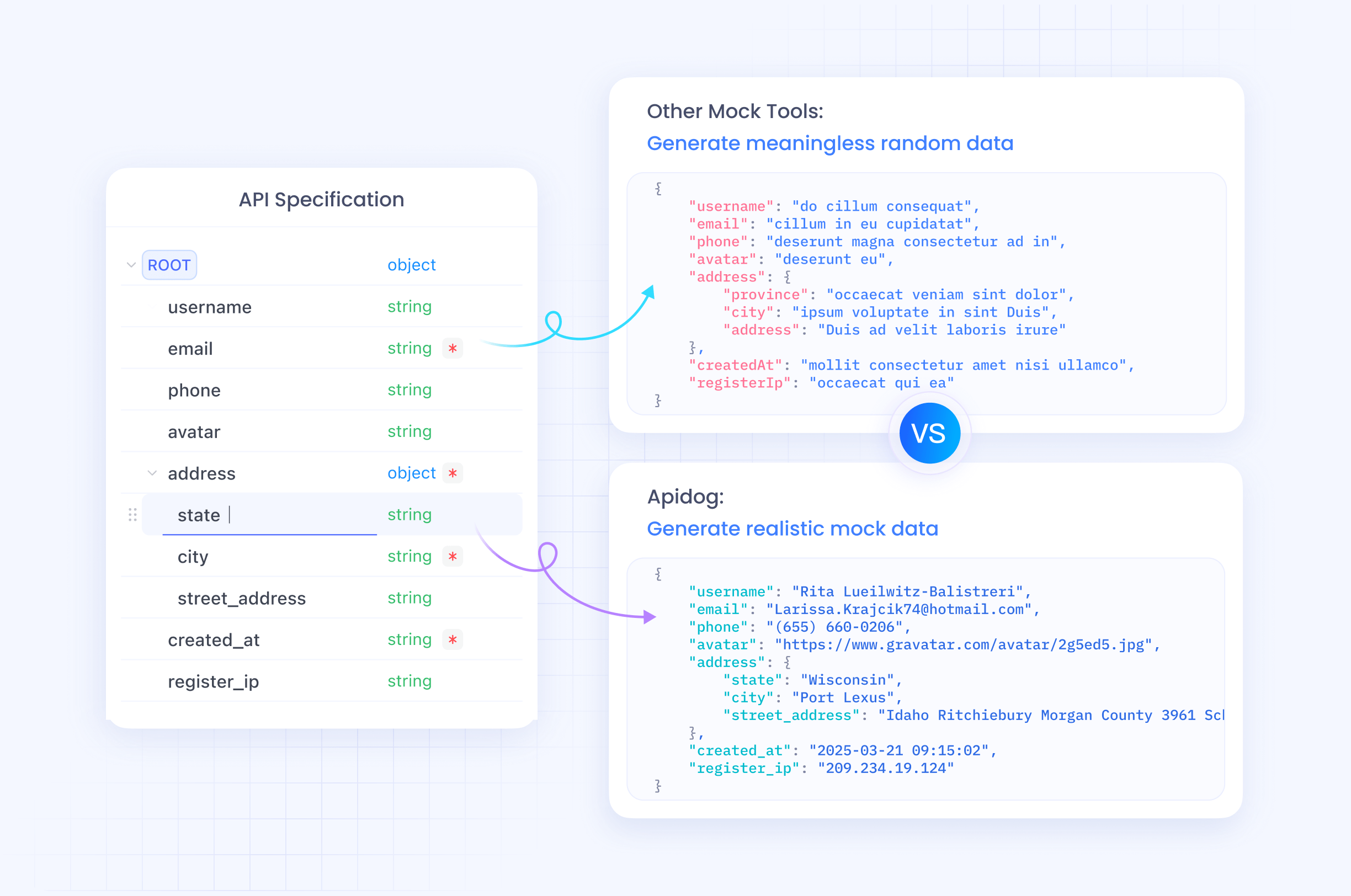

การทดสอบการรวมระบบเหล่านี้มีความสำคัญอย่างยิ่ง ที่นี่ Apidog โดดเด่นในฐานะเครื่องมือจัดการ API มันรองรับการทดสอบ WebSocket ช่วยให้คุณจำลองการแลกเปลี่ยนเสียงแบบเรียลไทม์และตรวจสอบการตอบสนอง ดาวน์โหลด Apidog ได้ฟรีเพื่อจำลองปลายทาง ตรวจสอบเพย์โหลด และรับรองการเชื่อมต่อที่ราบรื่นกับ gpt-realtime

ในทางปฏิบัติ ให้สร้างเอเจนต์เสียงอย่างง่ายโดยการรวมองค์ประกอบเหล่านี้เข้าด้วยกัน บันทึกอินพุตจากไมโครโฟน สตรีมไปยัง API และเล่นเสียงที่สร้างขึ้น ไลบรารีเช่น WebSocket ใน JavaScript หรือโมดูล websockets ของ Python ช่วยอำนวยความสะดวกในเรื่องนี้

ตรวจสอบความหน่วงโดยการจับเวลาการตอบสนองแบบไปกลับ การปรับแต่งของ OpenAI ช่วยให้มั่นใจได้ถึงความล่าช้าที่น้อยกว่าหนึ่งวินาทีในกรณีส่วนใหญ่ แต่สภาพเครือข่ายมีผลต่อประสิทธิภาพ

จัดการข้อผิดพลาดอย่างเหมาะสม เช่น การลองเชื่อมต่อที่ล้มเหลวใหม่ หรือการเปลี่ยนกลับไปใช้การโต้ตอบแบบข้อความหากการประมวลผลเสียงประสบปัญหา

ขยายความนี้ โดยรวมพร้อมต์ที่นำกลับมาใช้ใหม่ได้ จัดเก็บเทมเพลตพร้อมต์พร้อมคำแนะนำเช่น "ตอบกลับด้วยความเห็นอกเห็นใจเสมอ" และนำไปใช้กับเซสชันใหม่ผ่านพารามิเตอร์ API

สำหรับการใช้งานขั้นสูง ให้รวม gpt-realtime เข้ากับโมเดล OpenAI อื่นๆ ส่งการให้เหตุผลที่ซับซ้อนไปยัง GPT-4o ในขณะที่ใช้ gpt-realtime สำหรับ I/O เสียง เพื่อสร้างระบบไฮบริด

ข้อควรพิจารณาด้านความปลอดภัยรวมถึงการเข้ารหัสข้อมูลระหว่างการส่งและจัดการโทเค็นการเข้าถึงอย่างปลอดภัย ข้อผูกพันด้านความเป็นส่วนตัวของ OpenAI ช่วยได้ แต่ควรใช้มาตรการป้องกันเพิ่มเติมสำหรับแอปพลิเคชันที่ละเอียดอ่อน

การรวม Apidog เพื่อการจัดการ API ที่มีประสิทธิภาพ

Apidog กลายเป็นเครื่องมือสำคัญสำหรับนักพัฒนาที่ทำงานกับ gpt-realtime API แพลตฟอร์มนี้มีคุณสมบัติการทดสอบ API การจัดทำเอกสาร และการทำงานร่วมกันที่ครอบคลุม ซึ่งปรับแต่งมาสำหรับการรวมระบบที่ซับซ้อน เช่น WebSockets แบบเรียลไทม์

วิศวกรใช้ Apidog เพื่อออกแบบคำขอ API ด้วยภาพ นำเข้าข้อกำหนด OpenAPI และเรียกใช้การทดสอบอัตโนมัติ สำหรับ Realtime API สามารถจำลองสตรีมเสียงและตรวจสอบอินพุตหลายโมดอลได้โดยไม่ต้องเขียนโค้ดจำนวนมาก

ยิ่งไปกว่านั้น ความสามารถในการจำลองของ Apidog ยังช่วยให้สามารถสร้างต้นแบบก่อนการนำไปใช้งานจริง สร้างเซิร์ฟเวอร์จำลองที่เลียนแบบการตอบสนองของ gpt-realtime ซึ่งช่วยเร่งวงจรการพัฒนา

เครื่องมือนี้รองรับการทำงานร่วมกันเป็นทีม การแบ่งปันกรณีทดสอบและสภาพแวดล้อม สิ่งนี้พิสูจน์แล้วว่ามีคุณค่าอย่างยิ่งสำหรับทีมที่กระจายตัวซึ่งสร้างเอเจนต์เสียง

เนื่องจาก Apidog จัดการการเข้ารหัส base64 สำหรับรูปภาพและข้อมูลไบนารีสำหรับเสียง จึงช่วยลดความซับซ้อนในการแก้ไขข้อบกพร่อง ติดตามวงจรคำขอ/การตอบกลับแบบเรียลไทม์ ระบุจุดคอขวดได้ตั้งแต่เนิ่นๆ

เมื่อเปลี่ยนไปสู่การปรับใช้ ให้ใช้การตรวจสอบของ Apidog เพื่อให้แน่ใจว่า API ทำงานได้ตลอดเวลาและมีประสิทธิภาพหลังการเปิดตัว

ราคา ความพร้อมใช้งาน และผลกระทบในอนาคต

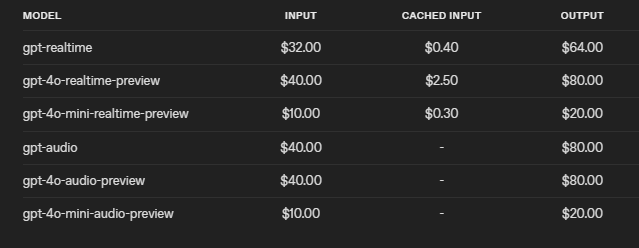

OpenAI กำหนดราคา gpt-realtime อย่างแข่งขัน โดยลดต้นทุนลง 20% จากเวอร์ชันพรีวิว คิดค่าบริการ 32 ดอลลาร์ต่อ 1 ล้านโทเค็นอินพุตเสียง (0.40 ดอลลาร์สำหรับโทเค็นที่แคชไว้) และ 64 ดอลลาร์ต่อ 1 ล้านโทเค็นเอาต์พุต โครงสร้างนี้ส่งเสริมการใช้งานอย่างมีประสิทธิภาพ ด้วยการควบคุมเพื่อจำกัดบริบทและตัดทอนเซสชัน

API จะพร้อมใช้งานสำหรับนักพัฒนาทุกคนในวันที่ 28 สิงหาคม 2025 โดยสามารถเข้าถึงได้ทั่วโลกรวมถึงภูมิภาค EU

เมื่อมองไปข้างหน้า ความก้าวหน้าเหล่านี้ปูทางไปสู่ AI เสียงที่แพร่หลาย อุตสาหกรรมต่างๆ เช่น การดูแลสุขภาพนำไปใช้สำหรับการโต้ตอบกับผู้ป่วย ในขณะที่การศึกษาใช้สำหรับการสอนแบบโต้ตอบ

อย่างไรก็ตาม ยังคงมีความท้าทายอยู่ เช่น การรับรองการใช้งานอย่างมีจริยธรรมและการลดอคติในการประมวลผลเสียง

โดยสรุป gpt-realtime และ Realtime API ของ OpenAI ได้กำหนดนิยามใหม่ของ AI แบบเรียลไทม์ โดยนำเสนอเครื่องมือที่นักพัฒนาสามารถนำไปใช้สำหรับแอปพลิเคชันที่เป็นนวัตกรรม การปรับเปลี่ยนเล็กน้อยในการรวมระบบให้ผลลัพธ์ที่สำคัญ โดยเน้นย้ำถึงการนำไปใช้ที่แม่นยำ