ต้องการเพิ่มประสิทธิภาพเวิร์กโฟลว์การเขียนโค้ดของคุณด้วย GPT-OSS ซึ่งเป็นโมเดลแบบ open-weight ของ Open AI โดยตรงใน Claude Code ใช่ไหม คุณมาถูกที่แล้ว! GPT-OSS (รุ่น 20B หรือ 120B) ที่เปิดตัวในเดือนสิงหาคม 2025 เป็นขุมพลังสำหรับการเขียนโค้ดและการให้เหตุผล และคุณสามารถจับคู่กับอินเทอร์เฟซ CLI ที่ทันสมัยของ Claude Code สำหรับการตั้งค่าฟรีหรือต้นทุนต่ำ ในคู่มือเชิงสนทนานี้ เราจะแนะนำคุณตลอดสามเส้นทางในการรวม GPT-OSS เข้ากับ Claude Code โดยใช้ Hugging Face, OpenRouter หรือ LiteLLM มาเริ่มกันเลยและทำให้ผู้ช่วย AI ในการเขียนโค้ดของคุณพร้อมใช้งาน!

ต้องการแพลตฟอร์มแบบ All-in-One ที่รวมทุกอย่างเข้าด้วยกันเพื่อให้ทีมพัฒนาของคุณทำงานร่วมกันด้วย ประสิทธิภาพสูงสุด?

Apidog ตอบสนองทุกความต้องการของคุณ และ แทนที่ Postman ในราคาที่ย่อมเยาขึ้นมาก!

GPT-OSS คืออะไร และทำไมต้องใช้กับ Claude Code?

GPT-OSS คือตระกูลโมเดลแบบ open-weight ของ Open AI โดยมีรุ่น 20B และ 120B ที่ให้ประสิทธิภาพที่ยอดเยี่ยมสำหรับการเขียนโค้ด การให้เหตุผล และงานที่ต้องใช้ Agent ด้วยหน้าต่างบริบท 128K โทเค็นและใบอนุญาต Apache 2.0 ทำให้เหมาะสำหรับนักพัฒนาที่ต้องการความยืดหยุ่นและการควบคุม Claude Code ซึ่งเป็นเครื่องมือ CLI ของ Anthropic (เวอร์ชัน 0.5.3+) เป็นที่ชื่นชอบของนักพัฒนาสำหรับความสามารถในการเขียนโค้ดแบบสนทนา ด้วยการกำหนดเส้นทาง Claude Code ไปยัง GPT-OSS ผ่าน API ที่เข้ากันได้กับ OpenAI คุณสามารถเพลิดเพลินกับอินเทอร์เฟซที่คุ้นเคยของ Claude ในขณะที่ใช้ประโยชน์จากพลังโอเพนซอร์สของ GPT-OSS โดยไม่มีค่าใช้จ่ายในการสมัครสมาชิกของ Anthropic พร้อมที่จะทำให้มันเกิดขึ้นแล้วใช่ไหม มาสำรวจตัวเลือกการตั้งค่ากัน!

ข้อกำหนดเบื้องต้นสำหรับการใช้ GPT-OSS กับ Claude Code

ก่อนที่เราจะเริ่มต้น ตรวจสอบให้แน่ใจว่าคุณมีสิ่งต่อไปนี้:

- Claude Code ≥ 0.5.3: ตรวจสอบด้วย

claude --versionติดตั้งผ่านpip install claude-codeหรืออัปเดตด้วยpip install --upgrade claude-code - บัญชี Hugging Face: สมัครที่ huggingface.co และสร้างโทเค็นแบบอ่าน/เขียน (การตั้งค่า > โทเค็นการเข้าถึง)

- คีย์ API ของ OpenRouter: เป็นทางเลือกสำหรับเส้นทาง B รับได้ที่ openrouter.ai

- Python 3.10+ และ Docker: สำหรับการตั้งค่าในเครื่องหรือ LiteLLM (เส้นทาง C)

- ความรู้พื้นฐานเกี่ยวกับ CLI: ความคุ้นเคยกับตัวแปรสภาพแวดล้อมและคำสั่งเทอร์มินัลจะเป็นประโยชน์

เส้นทาง A: โฮสต์ GPT-OSS ด้วยตัวเองบน Hugging Face

ต้องการควบคุมอย่างเต็มที่ใช่ไหม โฮสต์ GPT-OSS บน Inference Endpoints ของ Hugging Face เพื่อการตั้งค่าส่วนตัวที่ปรับขนาดได้ นี่คือวิธีการ:

ขั้นตอนที่ 1: รับโมเดล

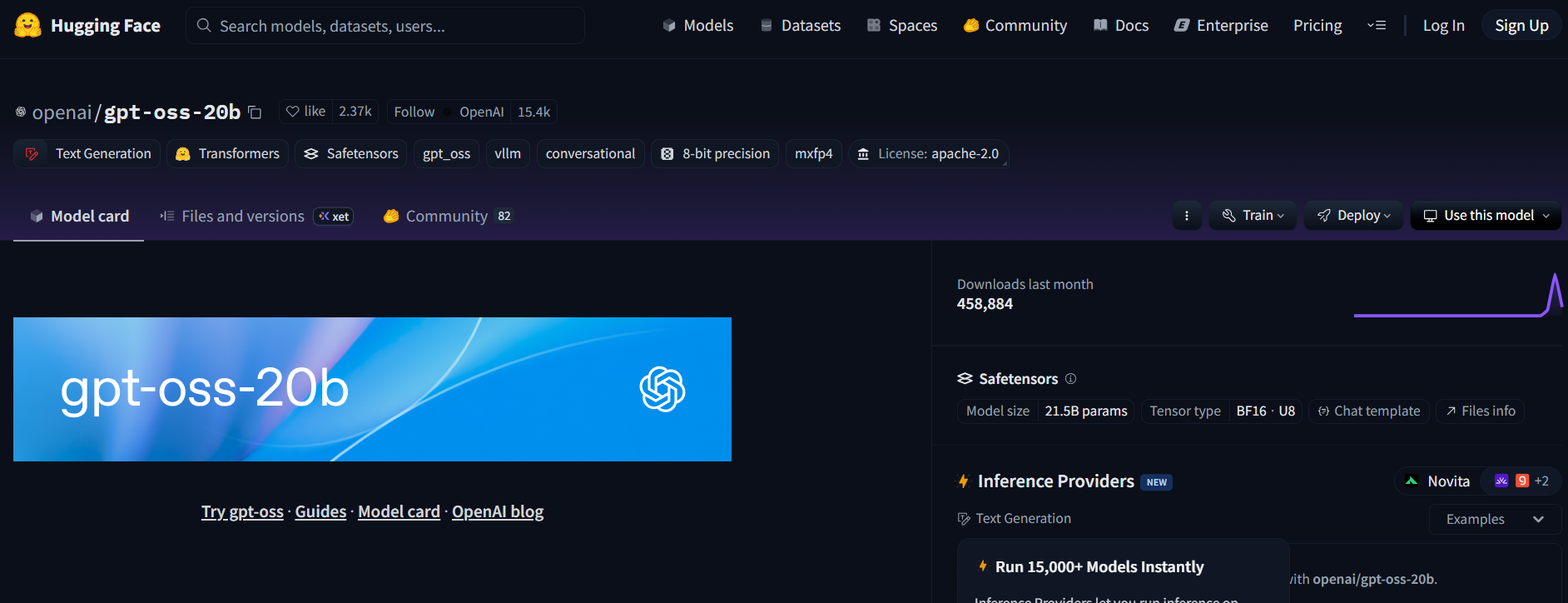

- เยี่ยมชมที่เก็บ GPT-OSS บน Hugging Face (openai/gpt-oss-20b หรือ openai/gpt-oss-120b)

- ยอมรับใบอนุญาต Apache 2.0 เพื่อเข้าถึงโมเดล

- อีกทางเลือกหนึ่ง ลองใช้ Qwen3-Coder-480B-A35B-Instruct (Qwen/Qwen3-Coder-480B-A35B-Instruct) สำหรับโมเดลที่เน้นการเขียนโค้ด (ใช้เวอร์ชัน GGUF สำหรับฮาร์ดแวร์ที่เบากว่า)

ขั้นตอนที่ 2: ปรับใช้ Text Generation Inference Endpoint

- บนหน้าโมเดล คลิก Deploy > Inference Endpoint

- เลือกเทมเพลต Text Generation Inference (TGI) (≥ v1.4.0)

- เปิดใช้งานความเข้ากันได้กับ OpenAI โดยการทำเครื่องหมายที่ Enable OpenAI compatibility หรือเพิ่ม

--enable-openaiในการตั้งค่าขั้นสูง - เลือกฮาร์ดแวร์: A10G หรือ CPU สำหรับ 20B, A100 สำหรับ 120B สร้าง Endpoint

ขั้นตอนที่ 3: รวบรวมข้อมูลรับรอง

- เมื่อสถานะ Endpoint เป็น Running ให้คัดลอก:

- ENDPOINT_URL: มีลักษณะคล้ายกับ

https://<your-endpoint>.us-east-1.aws.endpoints.huggingface.cloud - HF_API_TOKEN: โทเค็น Hugging Face ของคุณจาก การตั้งค่า > โทเค็นการเข้าถึง

2. จดรหัสโมเดล (เช่น gpt-oss-20b หรือ gpt-oss-120b)

ขั้นตอนที่ 4: กำหนดค่า Claude Code

- ตั้งค่าตัวแปรสภาพแวดล้อมในเทอร์มินัลของคุณ:

export ANTHROPIC_BASE_URL="https://<your-endpoint>.us-east-1.aws.endpoints.huggingface.cloud"

export ANTHROPIC_AUTH_TOKEN="hf_xxxxxxxxxxxxxxxxx"

export ANTHROPIC_MODEL="gpt-oss-20b" # หรือ gpt-oss-120b

แทนที่ <your-endpoint> และ hf_xxxxxxxxxxxxxxxxx ด้วยค่าของคุณ

2. ทดสอบการตั้งค่า:

claude --model gpt-oss-20b

Claude Code จะกำหนดเส้นทางไปยัง Endpoint GPT-OSS ของคุณ โดยสตรีมการตอบกลับผ่าน API /v1/chat/completions ของ TGI ซึ่งเลียนแบบ Schema ของ OpenAI

ขั้นตอนที่ 5: หมายเหตุเกี่ยวกับค่าใช้จ่ายและการปรับขนาด

- ค่าใช้จ่าย Hugging Face: Inference Endpoints จะปรับขนาดอัตโนมัติ ดังนั้นโปรดตรวจสอบการใช้งานเพื่อหลีกเลี่ยงการใช้เครดิตจนหมด A10G มีค่าใช้จ่ายประมาณ $0.60/ชั่วโมง, A100 ประมาณ $3/ชั่วโมง

- ตัวเลือกในเครื่อง: สำหรับค่าใช้จ่ายคลาวด์ที่เป็นศูนย์ ให้รัน TGI ในเครื่องด้วย Docker:

docker run --name tgi -p 8080:80 -e HF_TOKEN=hf_xxxxxxxxxxxxxxxxx ghcr.io/huggingface/text-generation-inference:latest --model-id openai/gpt-oss-20b --enable-openai

จากนั้นตั้งค่า ANTHROPIC_BASE_URL="http://localhost:8080"

เส้นทาง B: พร็อกซี GPT-OSS ผ่าน OpenRouter

ไม่มี DevOps ใช่ไหม ไม่มีปัญหา! ใช้ OpenRouter เพื่อเข้าถึง GPT-OSS ด้วยการตั้งค่าที่น้อยที่สุด มันรวดเร็วและจัดการการเรียกเก็บเงินให้คุณ

ขั้นตอนที่ 1: ลงทะเบียนและเลือกโมเดล

- ลงทะเบียนที่ openrouter.ai และคัดลอกคีย์ API ของคุณจากส่วน Keys

- เลือก slug โมเดล:

openai/gpt-oss-20bopenai/gpt-oss-120bqwen/qwen3-coder-480b(สำหรับโมเดล coder ของ Qwen)

ขั้นตอนที่ 2: กำหนดค่า Claude Code

- ตั้งค่าตัวแปรสภาพแวดล้อม:

export ANTHROPIC_BASE_URL="https://openrouter.ai/api/v1"

export ANTHROPIC_AUTH_TOKEN="or_xxxxxxxxx"

export ANTHROPIC_MODEL="openai/gpt-oss-20b"

แทนที่ or_xxxxxxxxx ด้วยคีย์ API ของ OpenRouter ของคุณ

2. ทดสอบ:

claude --model openai/gpt-oss-20b

Claude Code เชื่อมต่อกับ GPT-OSS ผ่าน API แบบรวมของ OpenRouter พร้อมการสตรีมและการรองรับการสำรองข้อมูล

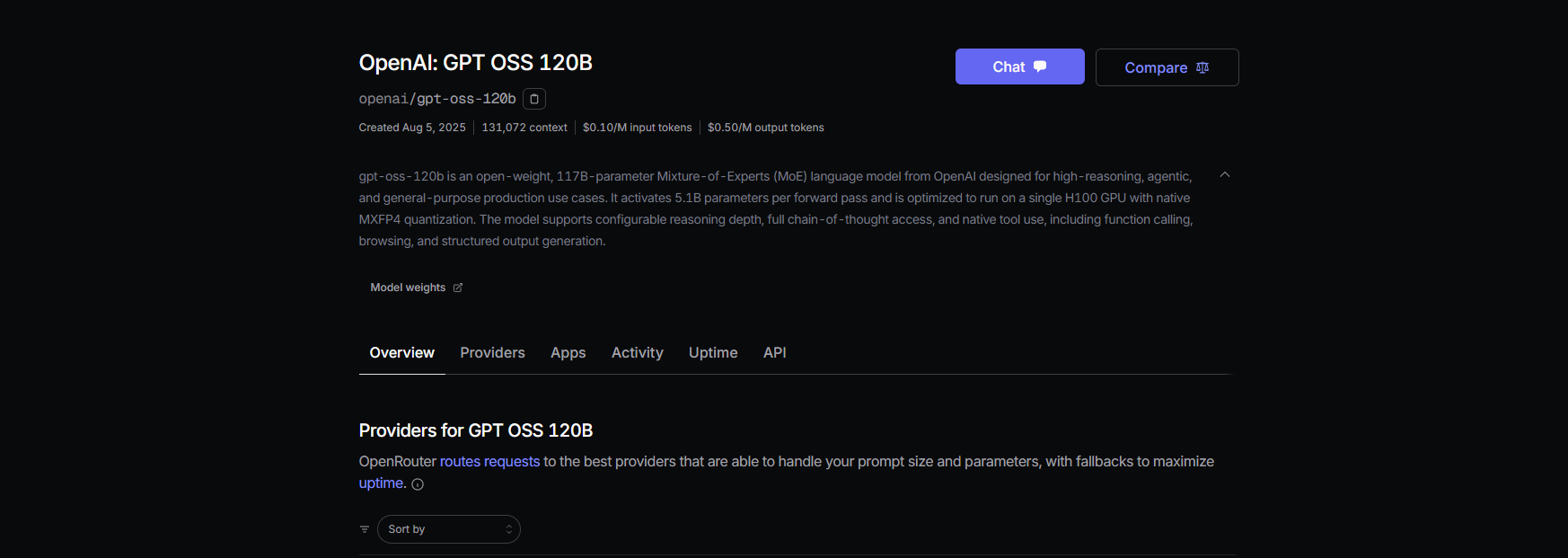

ขั้นตอนที่ 3: หมายเหตุเกี่ยวกับค่าใช้จ่าย

- ราคา OpenRouter: ประมาณ $0.50/ล้านโทเค็นอินพุต, ประมาณ $2.00/ล้านโทเค็นเอาต์พุตสำหรับ GPT-OSS-120B ซึ่งถูกกว่าโมเดลที่เป็นกรรมสิทธิ์อย่าง GPT-4 (ประมาณ $20.00/ล้าน) อย่างมาก

- การเรียกเก็บเงิน: OpenRouter จัดการการใช้งาน คุณจึงจ่ายเฉพาะสิ่งที่คุณใช้เท่านั้น

เส้นทาง C: ใช้ LiteLLM สำหรับกลุ่มโมเดลแบบผสม

ต้องการสลับใช้โมเดล GPT-OSS, Qwen และ Anthropic ในเวิร์กโฟลว์เดียวใช่ไหม LiteLLM ทำหน้าที่เป็นพร็อกซีเพื่อสลับโมเดลได้อย่างราบรื่น

ขั้นตอนที่ 1: ติดตั้งและกำหนดค่า LiteLLM

- ติดตั้ง LiteLLM:

pip install litellm

2. สร้างไฟล์คอนฟิก (litellm.yaml):

model_list:

- model_name: gpt-oss-20b

litellm_params:

model: openai/gpt-oss-20b

api_key: or_xxxxxxxxx # คีย์ OpenRouter

api_base: https://openrouter.ai/api/v1

- model_name: qwen3-coder

litellm_params:

model: openrouter/qwen/qwen3-coder

api_key: or_xxxxxxxxx

api_base: https://openrouter.ai/api/v1

แทนที่ or_xxxxxxxxx ด้วยคีย์ OpenRouter ของคุณ

3. เริ่มพร็อกซี:

litellm --config litellm.yaml

ขั้นตอนที่ 2: ชี้ Claude Code ไปยัง LiteLLM

- ตั้งค่าตัวแปรสภาพแวดล้อม:

export ANTHROPIC_BASE_URL="http://localhost:4000"

export ANTHROPIC_AUTH_TOKEN="litellm_master"

export ANTHROPIC_MODEL="gpt-oss-20b"

2. ทดสอบ:

claude --model gpt-oss-20b

LiteLLM กำหนดเส้นทางคำขอไปยัง GPT-OSS ผ่าน OpenRouter พร้อมการบันทึกค่าใช้จ่ายและการกำหนดเส้นทางแบบ simple-shuffle เพื่อความน่าเชื่อถือ

ขั้นตอนที่ 3: หมายเหตุ

- หลีกเลี่ยง Latency Routing: ใช้โหมด simple-shuffle ใน LiteLLM เพื่อป้องกันปัญหาที่เกิดกับโมเดล Anthropic

- การติดตามค่าใช้จ่าย: LiteLLM บันทึกการใช้งานเพื่อความโปร่งใส

การทดสอบ GPT-OSS ด้วย Claude Code

มาตรวจสอบให้แน่ใจว่า GPT-OSS ทำงานได้! เปิด Claude Code และลองใช้คำสั่งเหล่านี้:

การสร้างโค้ด:

claude --model gpt-oss-20b "Write a Python REST API with Flask"

คาดว่าจะได้รับคำตอบเช่น:

from flask import Flask, jsonify

app = Flask(__name__)

@app.route('/api', methods=['GET'])

def get_data():

return jsonify({"message": "Hello from GPT-OSS!"})

if __name__ == '__main__':

app.run(debug=True)

การวิเคราะห์ Codebase:

claude --model gpt-oss-20b "Summarize src/server.js"

GPT-OSS ใช้ประโยชน์จากหน้าต่างบริบท 128K เพื่อวิเคราะห์ไฟล์ JavaScript ของคุณและส่งคืนสรุป

การดีบัก:

claude --model gpt-oss-20b "Debug this buggy Python code: [paste code]"

ด้วยอัตราการผ่าน HumanEval 87.3% GPT-OSS ควรจะสามารถตรวจจับและแก้ไขปัญหาได้อย่างแม่นยำ

เคล็ดลับการแก้ไขปัญหา

- 404 บน /v1/chat/completions? ตรวจสอบให้แน่ใจว่า

--enable-openaiทำงานอยู่บน TGI (เส้นทาง A) หรือตรวจสอบความพร้อมใช้งานของโมเดลของ OpenRouter (เส้นทาง B) - การตอบกลับว่างเปล่า? ตรวจสอบว่า

ANTHROPIC_MODELตรงกับ slug (เช่นgpt-oss-20b) - ข้อผิดพลาด 400 หลังจากเปลี่ยนโมเดล? ใช้การกำหนดเส้นทางแบบ simple-shuffle ใน LiteLLM (เส้นทาง C)

- โทเค็นแรกช้า? วอร์มอัพ Hugging Face endpoints ด้วยพรอมต์ขนาดเล็กหลังจากปรับขนาดเป็นศูนย์

- Claude Code ขัดข้อง? อัปเดตเป็น ≥ 0.5.3 และตรวจสอบให้แน่ใจว่าตัวแปรสภาพแวดล้อมถูกตั้งค่าอย่างถูกต้อง

ทำไมต้องใช้ GPT-OSS กับ Claude Code?

การจับคู่ GPT-OSS กับ Claude Code คือความฝันของนักพัฒนา คุณจะได้รับ:

- ประหยัดค่าใช้จ่าย: โทเค็นอินพุต $0.50/ล้านของ OpenRouter ดีกว่าโมเดลที่เป็นกรรมสิทธิ์ และการตั้งค่า TGI ในเครื่องนั้นฟรีหลังจากค่าใช้จ่ายฮาร์ดแวร์

- พลังโอเพนซอร์ส: ใบอนุญาต Apache 2.0 ของ GPT-OSS ช่วยให้คุณสามารถปรับแต่งหรือปรับใช้แบบส่วนตัวได้

- เวิร์กโฟลว์ที่ราบรื่น: CLI ของ Claude Code ให้ความรู้สึกเหมือนกำลังสนทนากับเพื่อนร่วมเขียนโค้ด ในขณะที่ GPT-OSS จัดการงานหนักด้วยคะแนน MMLU 94.2% และ AIME 96.6%

- ความยืดหยุ่น: สลับระหว่างโมเดล GPT-OSS, Qwen หรือ Anthropic ด้วย LiteLLM หรือ OpenRouter

ผู้ใช้ต่างชื่นชมความสามารถในการเขียนโค้ดของ GPT-OSS โดยเรียกมันว่า “สัตว์ร้ายที่ประหยัดงบประมาณสำหรับโปรเจกต์หลายไฟล์” ไม่ว่าคุณจะโฮสต์ด้วยตัวเองหรือใช้พร็อกซีผ่าน OpenRouter การตั้งค่านี้จะช่วยให้ต้นทุนต่ำและประสิทธิภาพการทำงานสูง

บทสรุป

ตอนนี้คุณพร้อมแล้วที่จะใช้ GPT-OSS กับ Claude Code! ไม่ว่าคุณจะโฮสต์ด้วยตัวเองบน Hugging Face, ใช้พร็อกซีผ่าน OpenRouter หรือใช้ LiteLLM สำหรับการสลับโมเดล คุณก็มีการตั้งค่าการเขียนโค้ดที่ทรงพลังและคุ้มค่า ตั้งแต่การสร้าง REST API ไปจนถึงการดีบักโค้ด GPT-OSS ก็ทำได้ดีเยี่ยม และ Claude Code ก็ทำให้มันดูง่ายดาย ลองใช้ดู แชร์พรอมต์ที่คุณชื่นชอบในความคิดเห็น และมาสนุกกับการเขียนโค้ดด้วย AI กันเถอะ!

ต้องการแพลตฟอร์มแบบ All-in-One ที่รวมทุกอย่างเข้าด้วยกันเพื่อให้ทีมพัฒนาของคุณทำงานร่วมกันด้วย ประสิทธิภาพสูงสุด?

Apidog ตอบสนองทุกความต้องการของคุณ และ แทนที่ Postman ในราคาที่ย่อมเยาขึ้นมาก!