นักพัฒนาค้นหาโมเดลภาษาที่มีประสิทธิภาพสูงอย่างต่อเนื่อง ซึ่งให้ประสิทธิภาพที่แข็งแกร่งในแอปพลิเคชันที่หลากหลาย Zhipu AI ขอแนะนำ GLM-4.6 ซึ่งเป็นเวอร์ชันขั้นสูงในซีรีส์ GLM ที่ผลักดันขีดจำกัดของความสามารถด้านปัญญาประดิษฐ์ โมเดลนี้สร้างขึ้นจากเวอร์ชันก่อนหน้าโดยรวมการปรับปรุงที่สำคัญในการจัดการบริบท การให้เหตุผล และประโยชน์ใช้สอยจริง วิศวกรได้รวม GLM-4.6 เข้ากับเวิร์กโฟลว์ของพวกเขาเพื่อจัดการกับงานที่ซับซ้อน ตั้งแต่การสร้างโค้ดไปจนถึงการสร้างเนื้อหา ด้วยประสิทธิภาพและความแม่นยำที่มากขึ้น

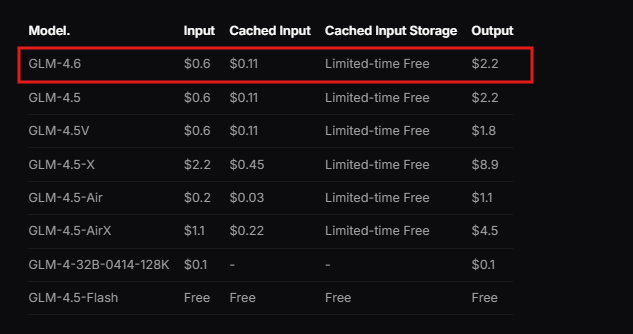

Zhipu AI ออกแบบ GLM-4.6 โดยเป็นส่วนหนึ่งของ GLM Coding Plan ซึ่งเป็นบริการแบบสมัครสมาชิกที่เริ่มต้นในราคาที่เข้าถึงได้ ผู้ใช้สามารถเข้าถึงโมเดลนี้ผ่านเครื่องมือที่รวมเข้าด้วยกัน เช่น Claude Code, Cline, OpenCode และอื่น ๆ ซึ่งช่วยให้การพัฒนาที่ขับเคลื่อนด้วย AI เป็นไปอย่างราบรื่น โมเดลนี้โดดเด่นในสถานการณ์จริง โดยประมวลผลบริบทที่กว้างขวางและสร้างผลลัพธ์คุณภาพสูง นอกจากนี้ GLM-4.6 ยังแสดงประสิทธิภาพที่เหนือกว่าในการวัดประสิทธิภาพ โดยสามารถแข่งขันกับผู้นำระดับนานาชาติอย่าง Claude Sonnet 4 ได้ สิ่งนี้ทำให้ GLM-4.6 เป็นตัวเลือกอันดับต้น ๆ สำหรับนักพัฒนาในประเทศจีนและที่อื่น ๆ ที่ต้องการการสนับสนุน AI ที่เชื่อถือได้

จากการทำความเข้าใจพื้นฐานของโมเดล เรามาดูคุณสมบัติหลักของโมเดลและประโยชน์ที่มีต่อการนำไปใช้งานทางเทคนิคกัน

GLM-4.6 คืออะไร?

Zhipu AI พัฒนา GLM-4.6 ให้เป็นโมเดลภาษาขนาดใหญ่ที่ได้รับการปรับแต่งสำหรับงานทางเทคนิคและความคิดสร้างสรรค์ที่หลากหลาย โมเดลนี้มีสถาปัตยกรรม Mixture of Experts (MoE) ที่มีพารามิเตอร์ 355 พันล้านตัว ซึ่งช่วยให้การคำนวณมีประสิทธิภาพในขณะที่ยังคงประสิทธิภาพสูง ผู้ใช้ชื่นชอบหน้าต่างบริบทที่ขยายใหญ่ขึ้นถึง 200K โทเค็น ซึ่งเป็นการอัปเกรดที่โดดเด่นจากขีดจำกัด 128K ในเวอร์ชันก่อนหน้า การขยายนี้ช่วยให้โมเดลสามารถจัดการกับการโต้ตอบที่ซับซ้อนและยาวนานโดยไม่สูญเสียความสอดคล้องกัน

นอกจากนี้ GLM-4.6 ยังรองรับรูปแบบการป้อนข้อมูลและเอาต์พุตที่เป็นข้อความ ทำให้มีความหลากหลายสำหรับการใช้งานที่ต้องการการประมวลผลภาษาที่แม่นยำ ขีดจำกัดโทเค็นเอาต์พุตสูงสุดถึง 128K ซึ่งให้พื้นที่เพียงพอสำหรับคำตอบที่มีรายละเอียด นักพัฒนาใช้ประโยชน์จากคุณสมบัติเหล่านี้เพื่อสร้างระบบที่จัดการข้อมูลจำนวนมาก เช่น การวิเคราะห์เอกสาร หรือห่วงโซ่การให้เหตุผลแบบหลายขั้นตอน

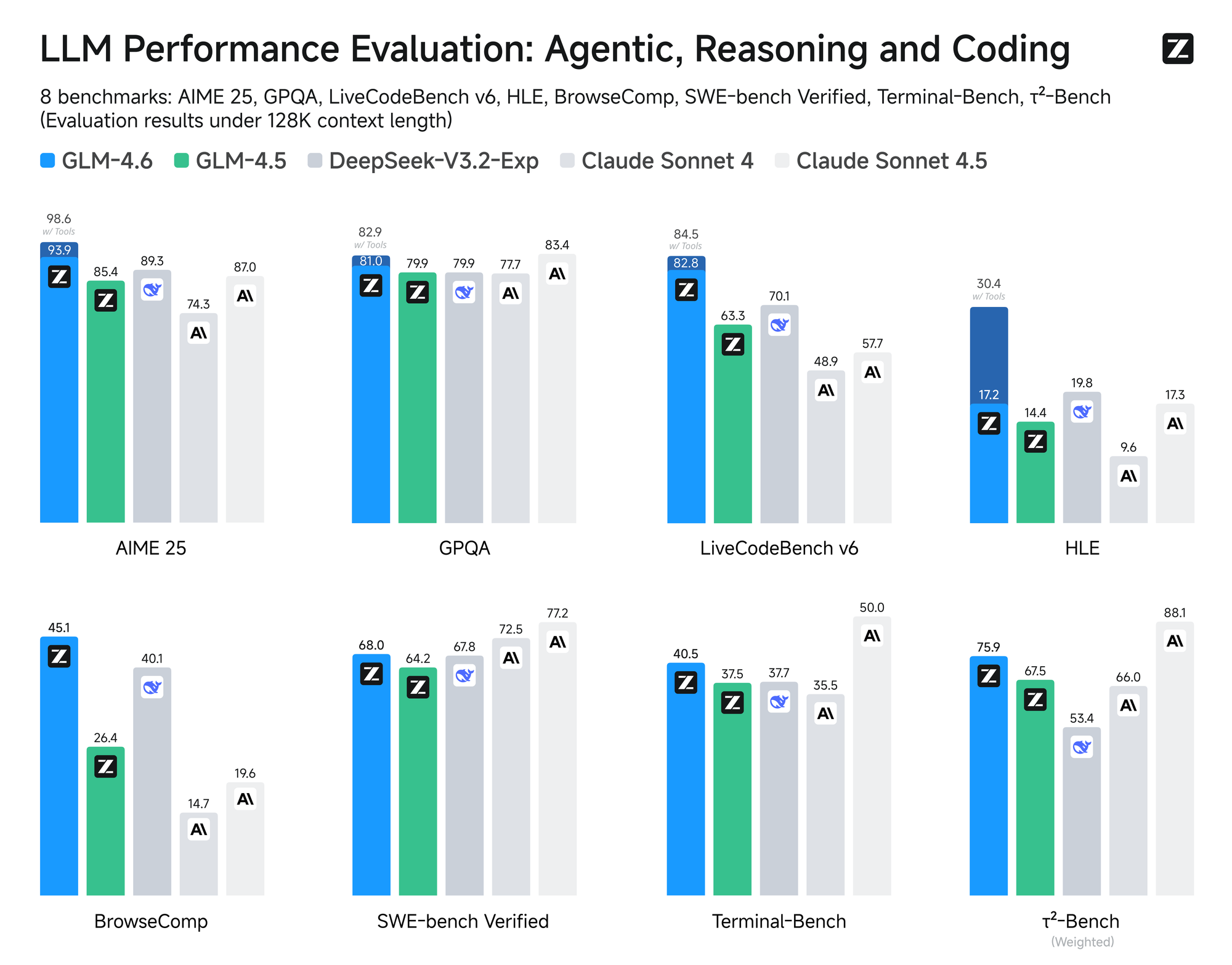

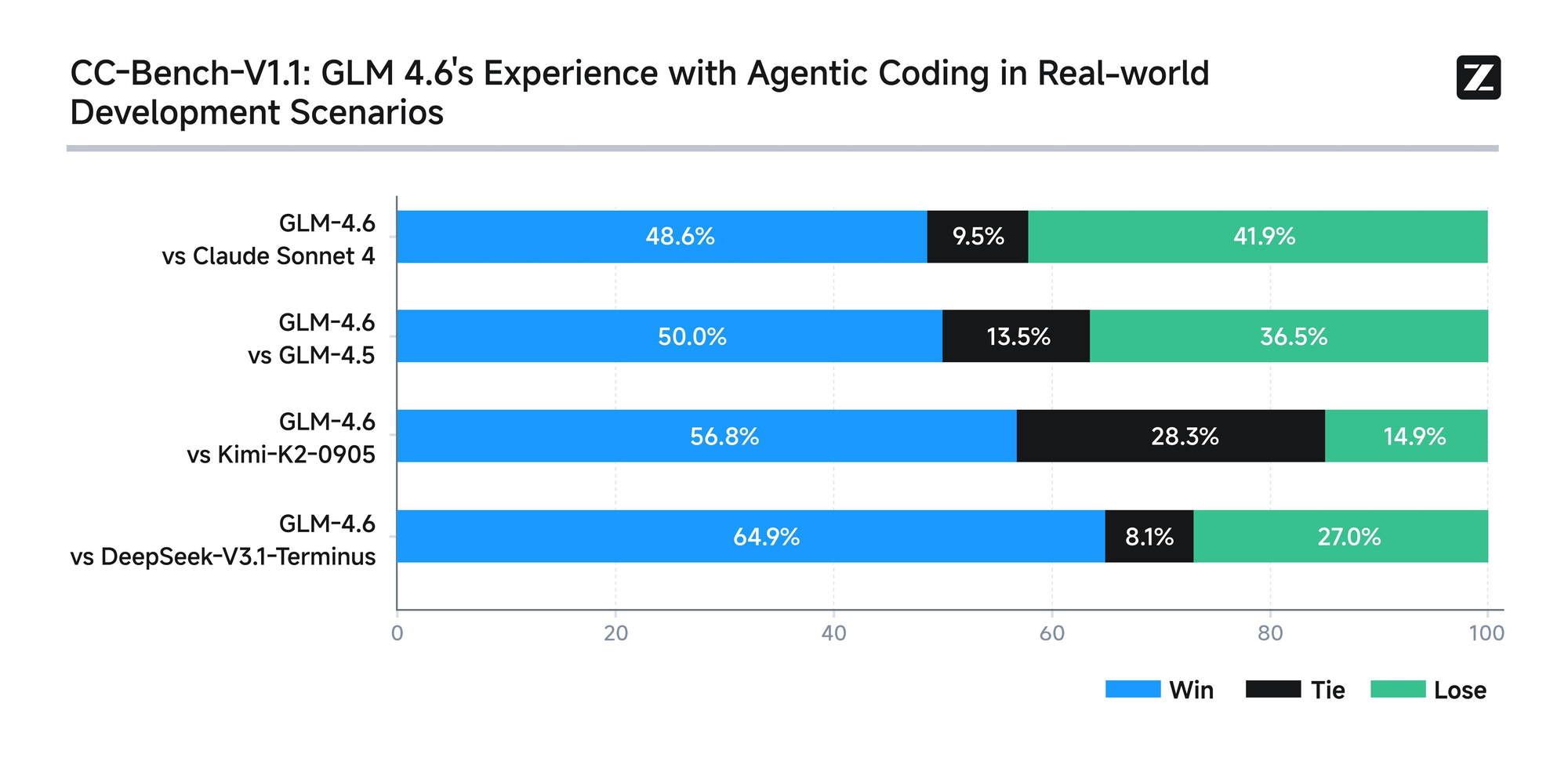

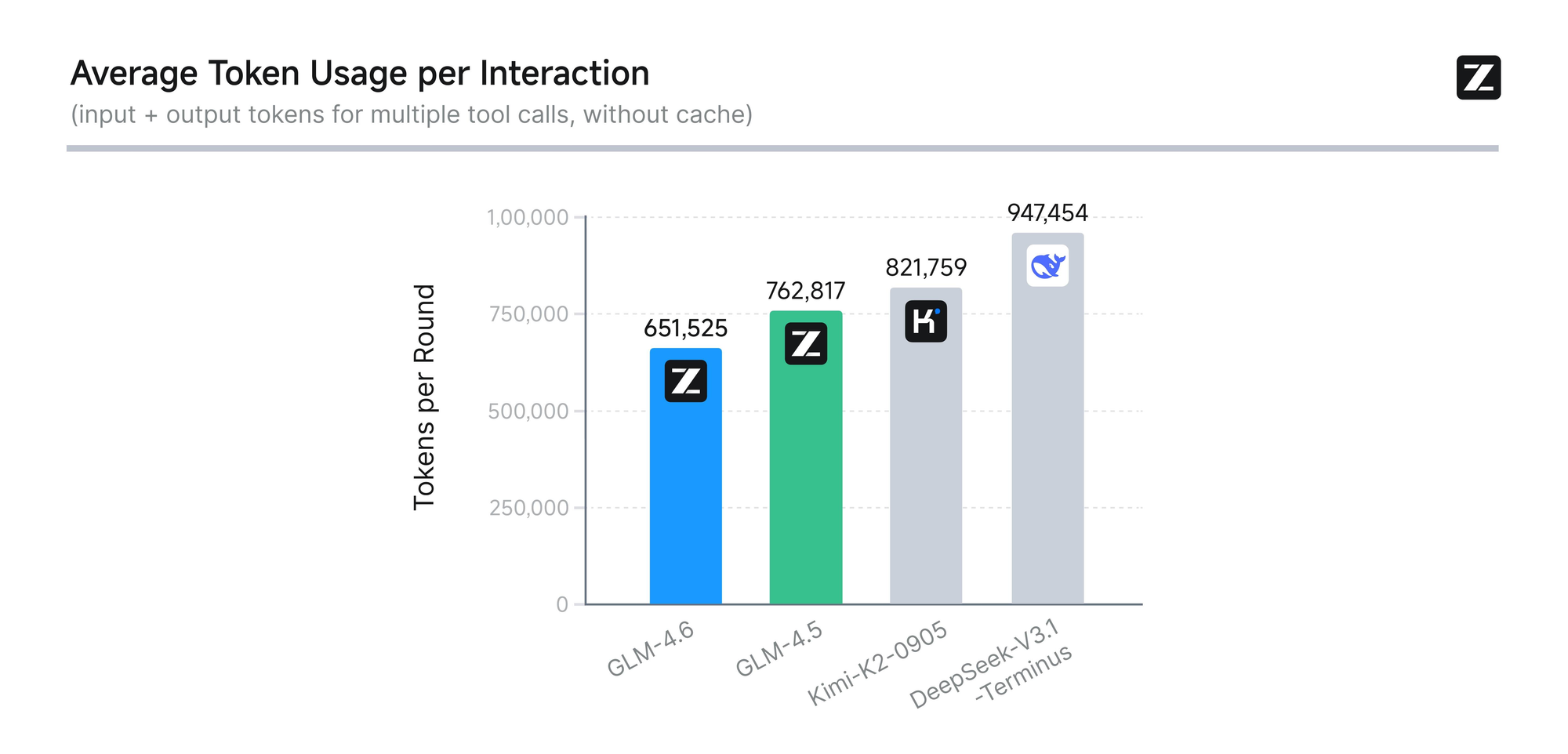

โมเดลนี้ผ่านการประเมินอย่างเข้มงวดในแปดเกณฑ์มาตรฐานที่เชื่อถือได้ ได้แก่ AIME 25, GPQA, LCB v6, HLE และ SWE-Bench Verified ผลลัพธ์แสดงให้เห็นว่า GLM-4.6 มีประสิทธิภาพเทียบเท่ากับโมเดลชั้นนำอย่าง Claude Sonnet 4 และ 4.6 ตัวอย่างเช่น ในการทดสอบการเขียนโค้ดในสถานการณ์จริงที่ดำเนินการในสภาพแวดล้อม Claude Code นั้น GLM-4.6 มีประสิทธิภาพเหนือกว่าคู่แข่งใน 74 สถานการณ์จริง โดยทำได้ด้วยประสิทธิภาพในการใช้โทเค็นที่สูงกว่า 30% ซึ่งช่วยลดต้นทุนการดำเนินงานสำหรับผู้ใช้ที่มีปริมาณการใช้งานสูง

นอกจากนี้ Zhipu AI ยังมุ่งมั่นที่จะโปร่งใสโดยการเผยแพร่คำถามทดสอบและเส้นทางของเอเจนต์ทั้งหมดต่อสาธารณะ การปฏิบัตินี้ช่วยให้นักพัฒนาสามารถตรวจสอบข้อเรียกร้องและสร้างผลลัพธ์ซ้ำได้ ซึ่งส่งเสริมความไว้วางใจในเทคโนโลยี GLM-4.6 ยังรวมความสามารถในการให้เหตุผลขั้นสูง โดยรองรับการใช้เครื่องมือในระหว่างการอนุมาน คุณสมบัตินี้ช่วยเพิ่มประโยชน์ใช้สอยในกรอบการทำงานของเอเจนต์ ซึ่งโมเดลจะวางแผนและดำเนินการงานโดยอัตโนมัติ

นอกเหนือจากการเขียนโค้ดแล้ว GLM-4.6 ยังโดดเด่นในด้านอื่น ๆ อีกด้วย มันปรับปรุงการเขียนให้สอดคล้องกับความชอบของมนุษย์อย่างใกล้ชิด ปรับปรุงสไตล์ ความสามารถในการอ่าน และความสมจริงในการสวมบทบาท ในงานแปล โมเดลนี้ได้รับการปรับให้เหมาะสมสำหรับภาษาเล็ก ๆ เช่น ฝรั่งเศส รัสเซีย ญี่ปุ่น และเกาหลี เพื่อให้มั่นใจถึงความสอดคล้องกันทางความหมายในบริบทที่ไม่เป็นทางการ ผู้สร้างเนื้อหาใช้มันสำหรับนวนิยาย บทภาพยนตร์ และการเขียนคำโฆษณา โดยได้รับประโยชน์จากการขยายบริบทและความแตกต่างทางอารมณ์

การพัฒนาตัวละครเสมือนจริงแสดงถึงจุดแข็งอีกประการหนึ่ง เนื่องจาก GLM-4.6 รักษาน้ำเสียงที่สอดคล้องกันตลอดการสนทนาหลายรอบ สิ่งนี้ทำให้เหมาะสำหรับ AI ทางสังคมและการสร้างบุคลิกภาพของแบรนด์ ในการค้นหาอัจฉริยะและการวิจัยเชิงลึก โมเดลนี้ช่วยเพิ่มความเข้าใจในเจตนาและการสังเคราะห์ผลลัพธ์ โดยให้ผลลัพธ์เชิงลึก

โดยรวมแล้ว GLM-4.6 ช่วยให้นักพัฒนาสามารถสร้างแอปพลิเคชันที่ชาญฉลาดขึ้นได้ การผสมผสานระหว่างการประมวลผลบริบทที่ยาวนาน การใช้โทเค็นอย่างมีประสิทธิภาพ และการประยุกต์ใช้ที่หลากหลาย ทำให้โดดเด่นในวงการ AI เมื่อเราเข้าใจแก่นแท้ของโมเดลแล้ว เราจะดำเนินการเข้าถึง API เพื่อนำไปใช้งานจริงต่อไป

วิธีเข้าถึง GLM-4.6 API

Zhipu AI ให้การเข้าถึง GLM-4.6 API ได้อย่างตรงไปตรงมาผ่านแพลตฟอร์มเปิดของพวกเขา นักพัฒนาเริ่มต้นด้วยการลงทะเบียนบัญชีบนเว็บไซต์ Zhipu AI โดยเฉพาะที่ open.bigmodel.cn หรือ z.ai กระบวนการนี้ต้องมีการยืนยันอีเมลหรือหมายเลขโทรศัพท์เพื่อให้แน่ใจว่าการลงทะเบียนปลอดภัย

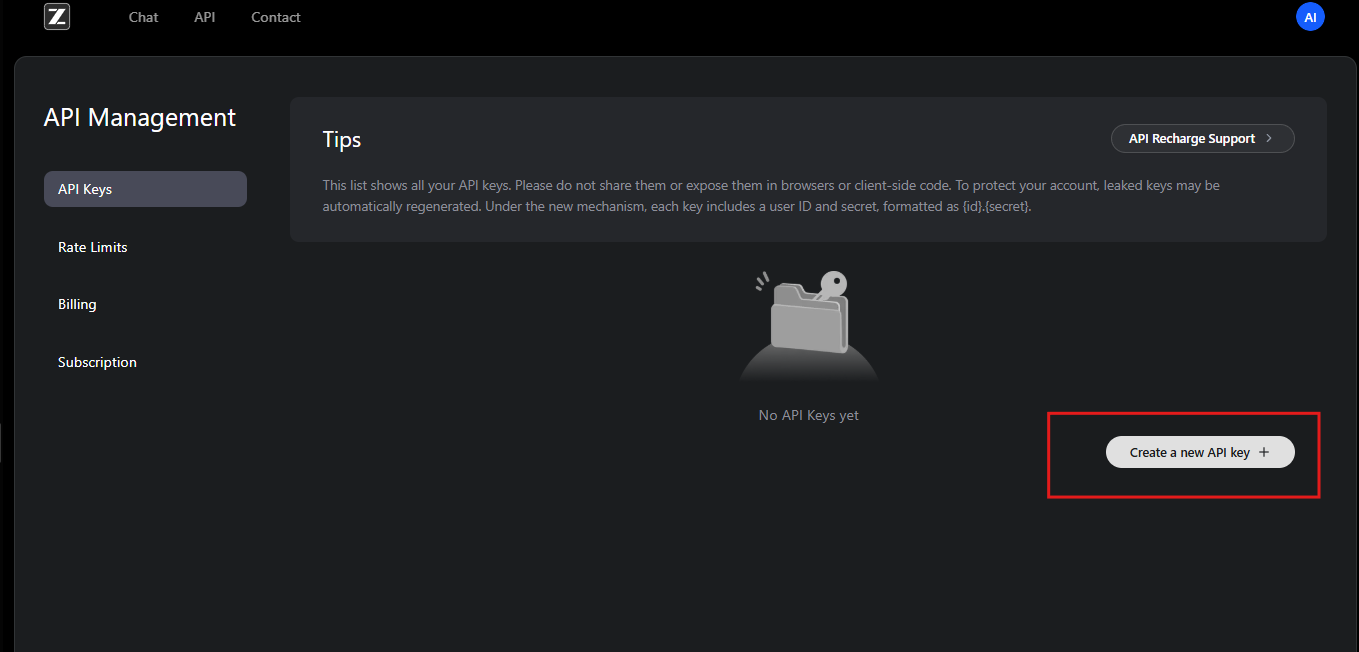

เมื่อลงทะเบียนแล้ว ผู้ใช้จะสมัครสมาชิก GLM Coding Plan แผนนี้จะปลดล็อก GLM-4.6 และโมเดลที่เกี่ยวข้อง สมาชิกจะได้รับสิทธิ์เข้าถึงแดชบอร์ด API ซึ่งพวกเขาสามารถสร้างคีย์ API ได้ คีย์เหล่านี้ทำหน้าที่เป็นข้อมูลประจำตัวสำหรับการยืนยันคำขอ

นอกจากนี้ Zhipu AI ยังมีเอกสารประกอบ ซึ่งให้รายละเอียดขั้นตอนการรวมระบบ นักพัฒนาตรวจสอบแหล่งข้อมูลนี้เพื่อทำความเข้าใจข้อกำหนดเบื้องต้น เช่น สภาพแวดล้อมการเขียนโปรแกรมที่เข้ากันได้ API เป็นไปตามการออกแบบ RESTful ซึ่งเข้ากันได้กับไคลเอ็นต์ HTTP มาตรฐาน

ในการเริ่มต้น ผู้ใช้จะไปที่ส่วนการจัดการ API ในบัญชีของตน ที่นี่ พวกเขาสร้างคีย์ API ใหม่และจดบันทึกค่าของมันอย่างปลอดภัย Zhipu AI แนะนำให้หมุนเวียนคีย์เป็นระยะเพื่อความปลอดภัย นอกจากนี้ แพลตฟอร์มยังจัดหาโควตาการใช้งานตามระดับการสมัครสมาชิก เพื่อป้องกันการใช้งานมากเกินไป

หากนักพัฒนาพบปัญหา ทีมสนับสนุนของ Zhipu AI จะให้ความช่วยเหลือผ่านอีเมลหรือฟอรัม พวกเขายังมีแหล่งข้อมูลชุมชนสำหรับการแก้ไขปัญหาการเข้าถึงทั่วไป เมื่อเข้าถึงได้อย่างปลอดภัย ขั้นตอนต่อไปคือการตั้งค่าการยืนยันตัวตนเพื่อโต้ตอบกับ GLM-4.6 API อย่างมีประสิทธิภาพ

การยืนยันตัวตนและการตั้งค่าสำหรับ GLM-4.6 API

การยืนยันตัวตนเป็นแกนหลักของการโต้ตอบ API ที่ปลอดภัย Zhipu AI ใช้การยืนยันตัวตนด้วย Bearer token สำหรับ GLM-4.6 API นักพัฒนาจะรวมคีย์ API ไว้ในส่วนหัว Authorization ของแต่ละคำขอ

สำหรับการตั้งค่า ให้ติดตั้งไลบรารีที่จำเป็นในสภาพแวดล้อมการพัฒนาของคุณ ตัวอย่างเช่น ผู้ใช้ Python สามารถใช้ไลบรารี requests คุณนำเข้าและกำหนดค่าส่วนหัวดังนี้:

import requests

api_key = "your-api-key"

headers = {

"Authorization": f"Bearer {api_key}",

"Content-Type": "application/json"

}

โค้ดนี้เตรียมสภาพแวดล้อมสำหรับการส่งคำขอ ในทำนองเดียวกัน ใน JavaScript กับ Node.js นักพัฒนาใช้ fetch API หรือไลบรารี axios พวกเขากำหนดส่วนหัวในออบเจกต์ options

นอกจากนี้ ตรวจสอบให้แน่ใจว่าระบบของคุณตรงตามข้อกำหนดของเครือข่าย ปลายทางของ GLM-4.6 API อยู่ที่ https://api.z.ai/api/paas/v4/chat/completions ทดสอบการเชื่อมต่อโดยการ ping โดเมนหรือส่งคำขออย่างง่าย

ในระหว่างการตั้งค่า นักพัฒนาจะกำหนดค่าตัวแปรสภาพแวดล้อมเพื่อจัดเก็บคีย์ API อย่างปลอดภัย การปฏิบัตินี้หลีกเลี่ยงการเขียนข้อมูลที่ละเอียดอ่อนลงในสคริปต์โดยตรง เครื่องมือเช่น dotenv ใน Python หรือ process.env ใน Node.js ช่วยอำนวยความสะดวกในเรื่องนี้

หากใช้พร็อกซีหรือ VPN ให้ตรวจสอบว่าอนุญาตให้มีการรับส่งข้อมูลไปยังเซิร์ฟเวอร์ของ Zhipu AI ความล้มเหลวในการยืนยันตัวตนมักเกิดจากการจัดรูปแบบคีย์ไม่ถูกต้องหรือการสมัครสมาชิกหมดอายุ Zhipu AI บันทึกข้อผิดพลาดในการตอบกลับ ซึ่งช่วยในการวินิจฉัยปัญหา

เมื่อยืนยันตัวตนแล้ว นักพัฒนาจะดำเนินการสำรวจปลายทาง การตั้งค่านี้ช่วยให้มั่นใจได้ถึงการเข้าถึงความสามารถของ GLM-4.6 ที่เชื่อถือได้และปลอดภัย

การสำรวจปลายทาง GLM-4.6 API

GLM-4.6 API มุ่งเน้นไปที่ปลายทางหลักสำหรับการเติมข้อความในการสนทนา นักพัฒนาส่งคำขอ POST ไปยัง https://api.z.ai/api/paas/v4/chat/completions เพื่อสร้างการตอบกลับ

ปลายทางนี้รองรับทั้งโหมดพื้นฐานและโหมดสตรีมมิ่ง ในโหมดพื้นฐาน เซิร์ฟเวอร์จะประมวลผลคำขอทั้งหมดและส่งคืนการตอบกลับที่สมบูรณ์ อย่างไรก็ตาม โหมดสตรีมมิ่งจะส่งออกผลลัพธ์ทีละน้อย ซึ่งเหมาะสำหรับแอปพลิเคชันแบบเรียลไทม์

ในการเรียกใช้ปลายทาง ให้สร้างเพย์โหลด JSON พร้อมพารามิเตอร์ที่จำเป็น ฟิลด์ model ระบุ "glm-4.6" อาร์เรย์ Messages ประกอบด้วยคู่ role-content ซึ่งจำลองการสนทนา

ตัวอย่างเช่น คำขอ curl พื้นฐานมีลักษณะดังนี้:

curl -X POST "https://api.z.ai/api/paas/v4/chat/completions" \

-H "Content-Type: application/json" \

-H "Authorization: Bearer your-api-key" \

-d '{

"model": "glm-4.6",

"messages": [

{"role": "user", "content": "Generate a Python function for sorting a list."}

]

}'

เซิร์ฟเวอร์จะตอบกลับด้วย JSON ที่มีเนื้อหาที่สร้างขึ้น นักพัฒนาจะแยกวิเคราะห์ข้อมูลนี้เพื่อดึงข้อความจากผู้ช่วย

นอกจากนี้ ปลายทางยังรองรับคุณสมบัติขั้นสูง เช่น ขั้นตอนการคิด กำหนดออบเจกต์ thinking เพื่อเปิดใช้งานการให้เหตุผลโดยละเอียดในผลลัพธ์

การทำความเข้าใจปลายทางนี้ช่วยให้นักพัฒนาสามารถสร้างระบบ AI แบบโต้ตอบได้ ต่อไป เราจะอธิบายพารามิเตอร์คำขอโดยละเอียด

คำอธิบายโดยละเอียดเกี่ยวกับพารามิเตอร์คำขอ GLM-4.6 API

พารามิเตอร์คำขอควบคุมพฤติกรรมของ GLM-4.6 API พารามิเตอร์ model กำหนดให้ใช้ "glm-4.6" เพื่อเลือกเวอร์ชันเฉพาะนี้

อาร์เรย์ messages เป็นตัวขับเคลื่อนการสนทนา แต่ละออบเจกต์ประกอบด้วย role – "user" สำหรับอินพุต, "assistant" สำหรับการตอบกลับก่อนหน้า – และ content เป็นสตริงข้อความ นักพัฒนาจัดโครงสร้างการสนทนาแบบหลายรอบโดยการสลับบทบาท

นอกจากนี้ max_tokens จะจำกัดความยาวของการตอบกลับ ป้องกันไม่ให้มีเอาต์พุตมากเกินไป กำหนดค่าเป็น 4096 เพื่อผลลัพธ์ที่สมดุล Temperature ปรับความสุ่ม; ค่าที่ต่ำกว่า เช่น 0.6 ให้ผลลัพธ์ที่กำหนดได้ ในขณะที่ค่าที่สูงกว่าส่งเสริมความคิดสร้างสรรค์

สำหรับการสตรีม ให้รวม "stream": true สิ่งนี้จะเปลี่ยนรูปแบบการตอบกลับเป็นข้อมูลแบบแบ่งส่วน

พารามิเตอร์ thinking เปิดใช้งานการให้เหตุผลแบบทีละขั้นตอน กำหนด "thinking": {"type": "enabled"} เพื่อรวมความคิดระหว่างกลางไว้ในการตอบกลับ

พารามิเตอร์เสริมอื่น ๆ ได้แก่ top_p สำหรับการสุ่มแบบ nucleus และ presence_penalty เพื่อลดการซ้ำซ้อน นักพัฒนาปรับแต่งสิ่งเหล่านี้ตามกรณีการใช้งาน

พารามิเตอร์ที่ไม่ถูกต้องจะทำให้เกิดการตอบกลับข้อผิดพลาดพร้อมรหัสเช่น 400 สำหรับคำขอที่ไม่ถูกต้อง ตรวจสอบเพย์โหลดก่อนส่งเสมอ

ด้วยการควบคุมพารามิเตอร์เหล่านี้ นักพัฒนาสามารถปรับแต่งการเรียกใช้ GLM-4.6 API เพื่อประสิทธิภาพสูงสุด

การจัดการการตอบกลับจาก GLM-4.6 API

การตอบกลับจาก GLM-4.6 API จะมาในรูปแบบ JSON นักพัฒนาจะแยกวิเคราะห์อาร์เรย์ choices เพื่อเข้าถึงเนื้อหาที่สร้างขึ้น

ในโหมดพื้นฐาน การตอบกลับจะรวมถึง:

{

"id": "chatcmpl-...",

"object": "chat.completion",

"created": 1694123456,

"model": "glm-4.6",

"choices": [

{

"index": 0,

"message": {

"role": "assistant",

"content": "Your generated text here."

},

"finish_reason": "stop"

}

]

}

ดึงฟิลด์ content เพื่อใช้ในแอปพลิเคชัน

ในโหมดสตรีมมิ่ง การตอบกลับจะสตรีมเป็น Server-Sent Events (SSE) แต่ละส่วนจะตามด้วย:

data: {"id":"chatcmpl-...","choices":[{"delta":{"content":" partial text"}}]}

นักพัฒนาจะสะสม deltas เพื่อสร้างเอาต์พุตที่สมบูรณ์

การจัดการข้อผิดพลาดเกี่ยวข้องกับการตรวจสอบรหัสสถานะ รหัส 401 บ่งชี้ถึงความล้มเหลวในการยืนยันตัวตน ในขณะที่ 429 บ่งชี้ถึงขีดจำกัดอัตรา

บันทึกการตอบกลับสำหรับการดีบัก วิธีการนี้ช่วยให้มั่นใจได้ถึงการรวมเข้ากับ GLM-4.6 API ที่แข็งแกร่ง

ตัวอย่างโค้ดสำหรับการรวม GLM-4.6 API

นักพัฒนาสามารถนำ GLM-4.6 API ไปใช้ในภาษาต่าง ๆ ได้ ใน Python ให้ใช้ requests สำหรับการเรียกใช้งานพื้นฐาน:

import requests

import json

url = "https://api.z.ai/api/paas/v4/chat/completions"

payload = {

"model": "glm-4.6",

"messages": [{"role": "user", "content": "Explain quantum computing."}],

"max_tokens": 500,

"temperature": 0.7

}

headers = {

"Authorization": "Bearer your-api-key",

"Content-Type": "application/json"

}

response = requests.post(url, data=json.dumps(payload), headers=headers)

print(response.json()["choices"][0]["message"]["content"])

โค้ดนี้จะส่งคำค้นหาและพิมพ์การตอบกลับ

ใน JavaScript ด้วย Node.js:

const fetch = require('node-fetch');

const url = 'https://api.z.ai/api/paas/v4/chat/completions';

const payload = {

model: 'glm-4.6',

messages: [{ role: 'user', content: 'Write a haiku about AI.' }],

max_tokens: 100

};

const headers = {

'Authorization': 'Bearer your-api-key',

'Content-Type': 'application/json'

};

fetch(url, {

method: 'POST',

body: JSON.stringify(payload),

headers

})

.then(res => res.json())

.then(data => console.log(data.choices[0].message.content));

สำหรับการสตรีมใน Python ให้ใช้ไลบรารีการแยกวิเคราะห์ SSE เช่น sseclient

ตัวอย่างเหล่านี้แสดงให้เห็นถึงการรวมระบบที่ใช้งานได้จริง ช่วยให้นักพัฒนาสามารถสร้างต้นแบบได้อย่างรวดเร็ว

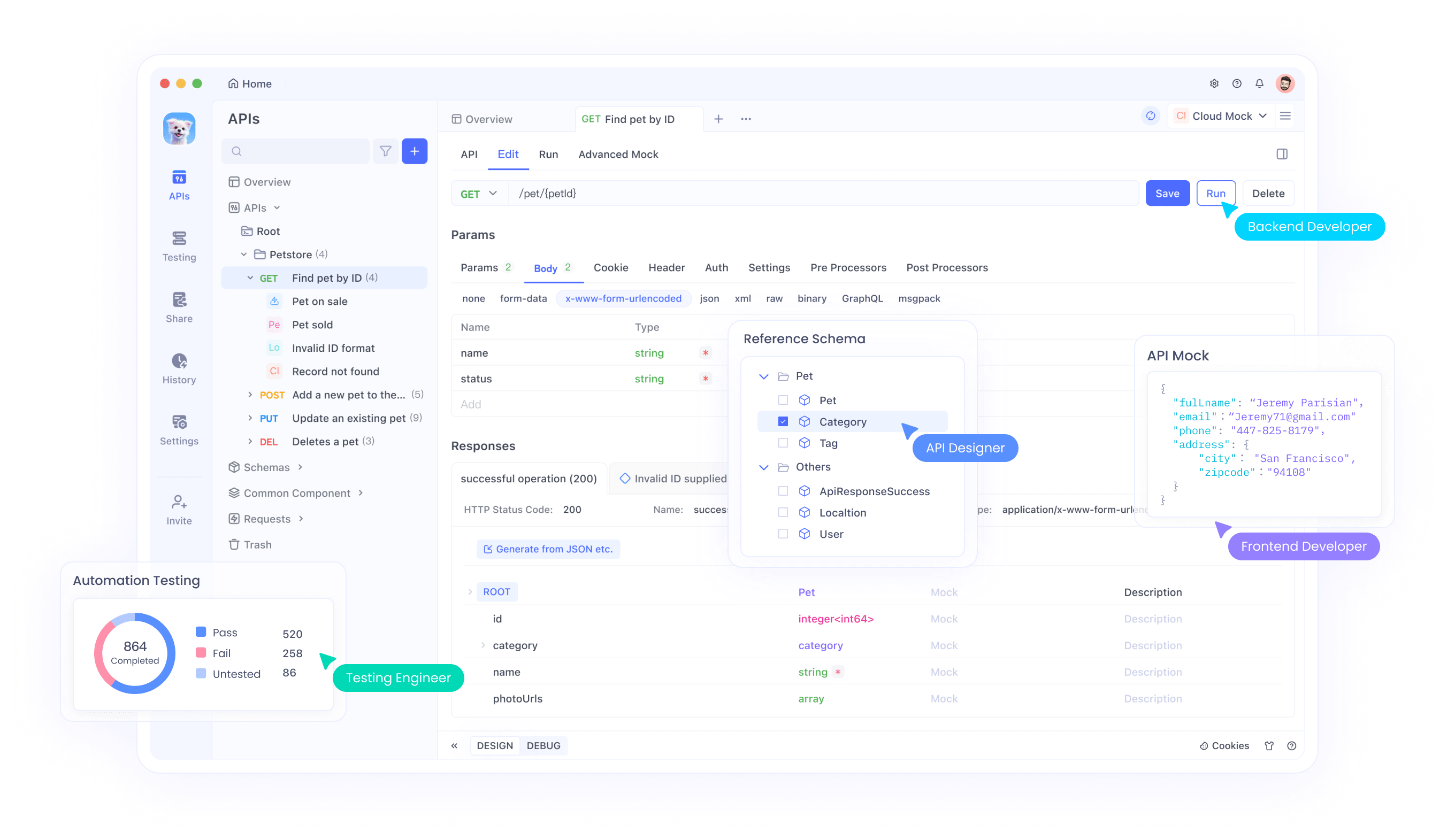

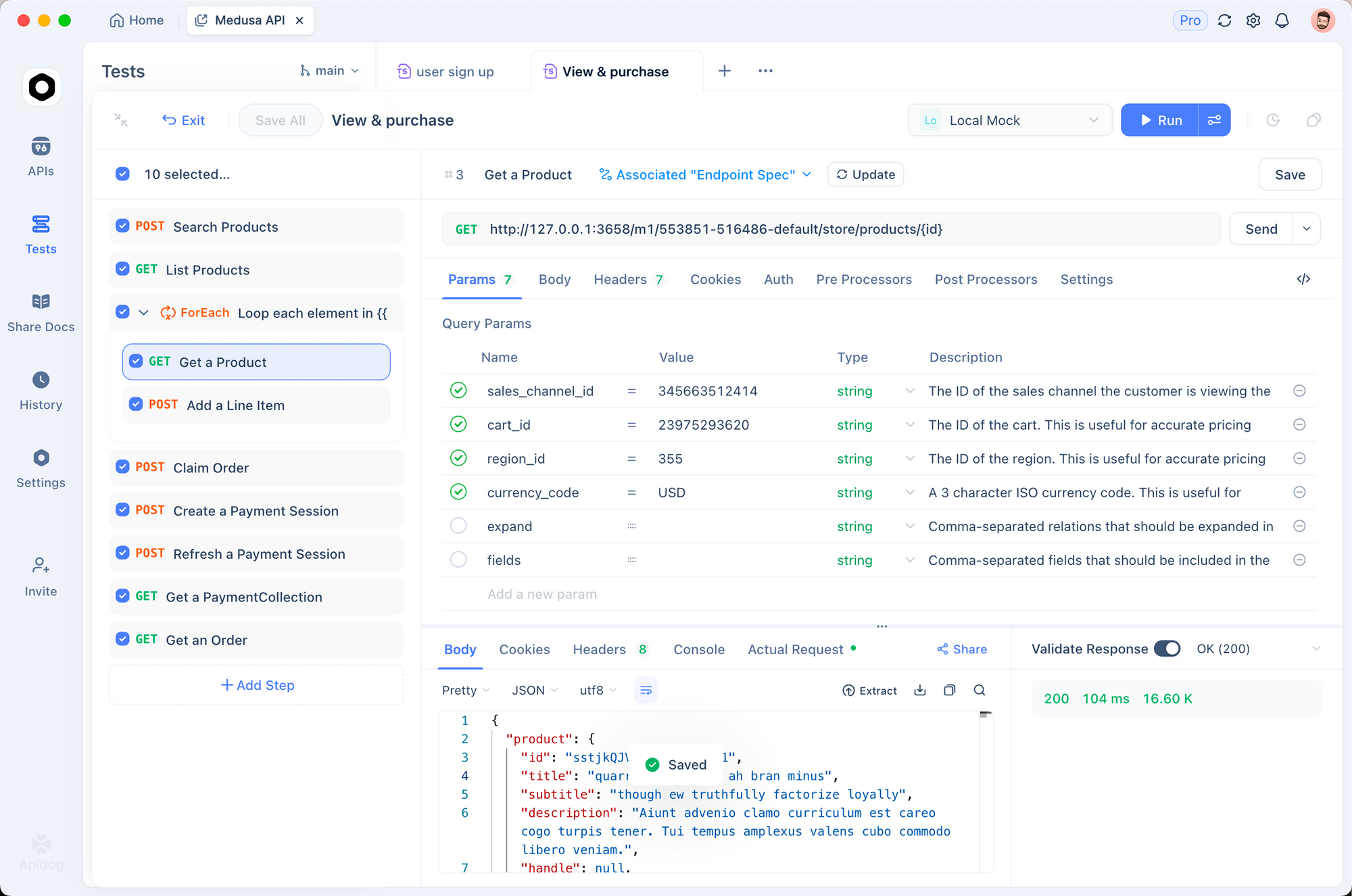

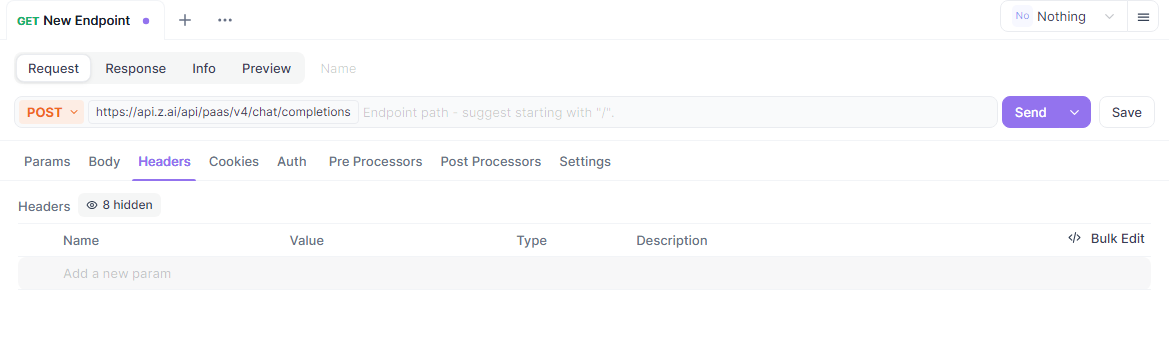

การใช้ Apidog สำหรับการทดสอบ GLM-4.6 API

Apidog เป็นเครื่องมือที่ยอดเยี่ยมสำหรับการทดสอบ GLM-4.6 API แพลตฟอร์มแบบครบวงจรนี้ช่วยให้นักพัฒนาสามารถออกแบบ ดีบัก จำลอง และทำให้การโต้ตอบ API เป็นไปโดยอัตโนมัติ

เริ่มต้นด้วยการดาวน์โหลด Apidog จาก apidog.com และสร้างโปรเจกต์ นำเข้าปลายทาง GLM-4.6 API โดยการเพิ่ม API ใหม่ด้วย URL https://api.z.ai/api/paas/v4/chat/completions

ตั้งค่าการยืนยันตัวตนในส่วนส่วนหัวของ Apidog โดยเพิ่ม "Authorization: Bearer your-api-key" กำหนดค่าเนื้อหาคำขอด้วยพารามิเตอร์ JSON เช่น model และ messages

Apidog ช่วยให้สามารถส่งคำขอและดูการตอบกลับในอินเทอร์เฟซที่ใช้งานง่าย นักพัฒนาสามารถทดสอบความแตกต่างโดยการทำซ้ำคำขอและปรับพารามิเตอร์

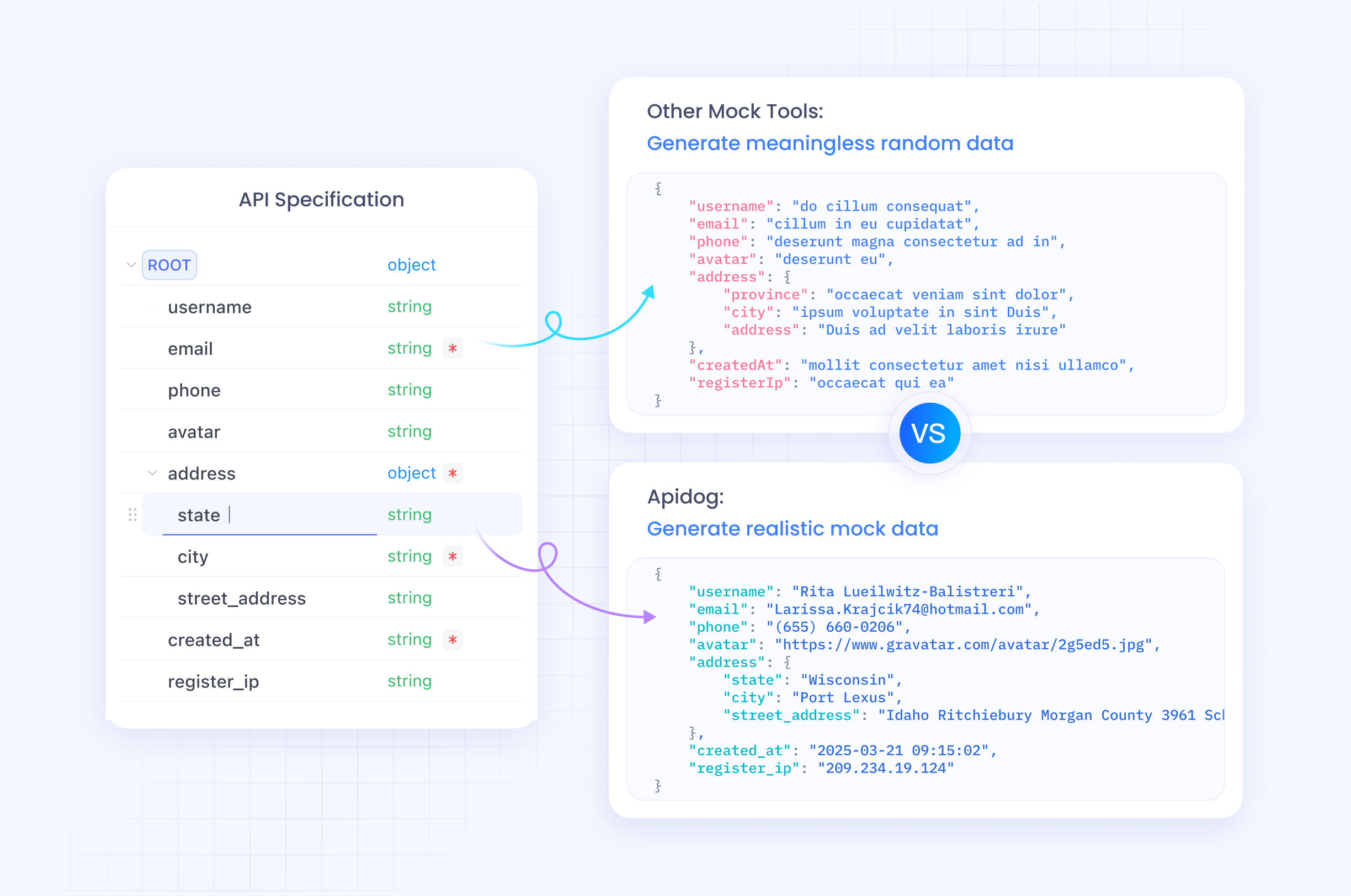

นอกจากนี้ ทำให้การทดสอบเป็นไปโดยอัตโนมัติโดยการสร้างสถานการณ์ใน Apidog กำหนดการยืนยันเพื่อตรวจสอบเนื้อหาการตอบกลับ เพื่อให้แน่ใจว่า GLM-4.6 API ทำงานได้ตามที่คาดไว้

เซิร์ฟเวอร์จำลองใน Apidog จำลองการตอบกลับสำหรับการพัฒนาแบบออฟไลน์ คุณสมบัตินี้ช่วยเร่งการสร้างต้นแบบโดยไม่ต้องเรียกใช้ API จริง

ด้วยการรวม Apidog นักพัฒนาจะปรับปรุงเวิร์กโฟลว์ GLM-4.6 API ลดข้อผิดพลาดและเร่งการปรับใช้

แนวทางปฏิบัติที่ดีที่สุดและขีดจำกัดอัตราสำหรับ GLM-4.6 API

การปฏิบัติตามแนวทางปฏิบัติที่ดีที่สุดจะช่วยเพิ่มศักยภาพของ GLM-4.6 API ได้สูงสุด นักพัฒนาจะตรวจสอบการใช้งานเพื่อให้เป็นไปตามขีดจำกัดอัตรา ซึ่งโดยทั่วไปจะกำหนดโดยจำนวนโทเค็นต่อนาทีหรือจำนวนคำขอต่อวันตามการสมัครสมาชิก

ใช้ exponential backoff สำหรับการลองใหม่เมื่อเกิดข้อผิดพลาดเช่น 429 สิ่งนี้จะช่วยป้องกันไม่ให้เซิร์ฟเวอร์ทำงานหนักเกินไป

ปรับปรุงพร้อมต์ให้ชัดเจนเพื่อปรับปรุงคุณภาพการตอบกลับ ใช้ข้อความระบบเพื่อกำหนดบริบท นำทางโมเดลได้อย่างมีประสิทธิภาพ

รักษาความปลอดภัยคีย์ API ในสภาพแวดล้อมการผลิต หลีกเลี่ยงการเปิดเผยในโค้ดฝั่งไคลเอ็นต์

บันทึกการโต้ตอบสำหรับการตรวจสอบและการวิเคราะห์ประสิทธิภาพ ข้อมูลนี้ใช้ในการปรับปรุง

จัดการกรณีพิเศษ เช่น การตอบกลับว่างเปล่าหรือการหมดเวลา ด้วยกลไกสำรอง

Zhipu AI อัปเดตขีดจำกัดอัตราในเอกสารประกอบ ตรวจสอบเป็นประจำ

การปฏิบัติตามแนวทางเหล่านี้ช่วยให้มั่นใจได้ถึงการใช้งาน GLM-4.6 API ที่มีประสิทธิภาพและเชื่อถือได้

การใช้งานขั้นสูงของ GLM-4.6 API

ผู้ใช้ขั้นสูงสำรวจการสตรีมสำหรับแอปพลิเคชันแบบโต้ตอบ กำหนด "stream": true และประมวลผลข้อมูลเป็นส่วน ๆ แบบเรียลไทม์

รวมเครื่องมือโดยการใส่การเรียกใช้ฟังก์ชันในข้อความ GLM-4.6 รองรับการเรียกใช้เครื่องมือ ทำให้เอเจนต์สามารถดำเนินการภายนอกได้

ตัวอย่างเช่น กำหนดเครื่องมือในเพย์โหลด:

"tools": [

{

"type": "function",

"function": {

"name": "get_weather",

"description": "Get current weather",

"parameters": {...}

}

}

]

โมเดลจะตอบกลับด้วยการเรียกใช้เครื่องมือหากจำเป็น

ปรับแต่ง temperature สำหรับงานเฉพาะ; ต่ำสำหรับคำถามเชิงข้อเท็จจริง, สูงสำหรับงานสร้างสรรค์

รวมกับบริบทที่ยาวนานสำหรับการสรุปเอกสาร ป้อนข้อความขนาดใหญ่ในข้อความ

รวมเข้ากับเฟรมเวิร์กของเอเจนต์ เช่น LangChain สำหรับเวิร์กโฟลว์ที่ซับซ้อน

เทคนิคเหล่านี้จะปลดล็อกศักยภาพสูงสุดของ GLM-4.6 ในระบบที่ซับซ้อน

บทสรุป

GLM-4.6 API นำเสนอเครื่องมืออันทรงพลังสำหรับนักพัฒนาในการสร้างสรรค์นวัตกรรม AI ด้วยการปฏิบัติตามคู่มือนี้ คุณจะสามารถรวมเข้ากับโปรเจกต์ได้อย่างราบรื่น ทดลองใช้คุณสมบัติ ทดสอบโดยใช้ Apidog และนำแนวทางปฏิบัติที่ดีที่สุดไปใช้เพื่อความสำเร็จ Zhipu AI ยังคงพัฒนา GLM-4.6 อย่างต่อเนื่อง ซึ่งสัญญาว่าจะมีความสามารถที่ดียิ่งขึ้นในอนาคต