ข้อมูลเป็นแรงขับเคลื่อนการตัดสินใจทางธุรกิจในปัจจุบัน แต่จะเกิดผลก็ต่อเมื่อข้อมูลนั้นถูกต้อง ครบถ้วน และทันเวลาเท่านั้น การทดสอบ ELT ช่วยให้มั่นใจว่าข้อมูลที่ไหลผ่านไปป์ไลน์ของคุณ — ไม่ว่าจะเข้าสู่ data lakes, warehouses, หรือแพลตฟอร์มวิเคราะห์ — เป็นไปตามมาตรฐานที่กำหนด ELT (Extract, Load, Transform) ได้กลายเป็นรูปแบบที่โดดเด่นสำหรับการรวมข้อมูลสมัยใหม่ แต่หลายทีมยังคงประสบปัญหาในการทดสอบอย่างมีประสิทธิภาพ คู่มือนี้จะนำเสนอเฟรมเวิร์กเชิงปฏิบัติสำหรับการตรวจสอบไปป์ไลน์ ELT ในทุกขั้นตอน

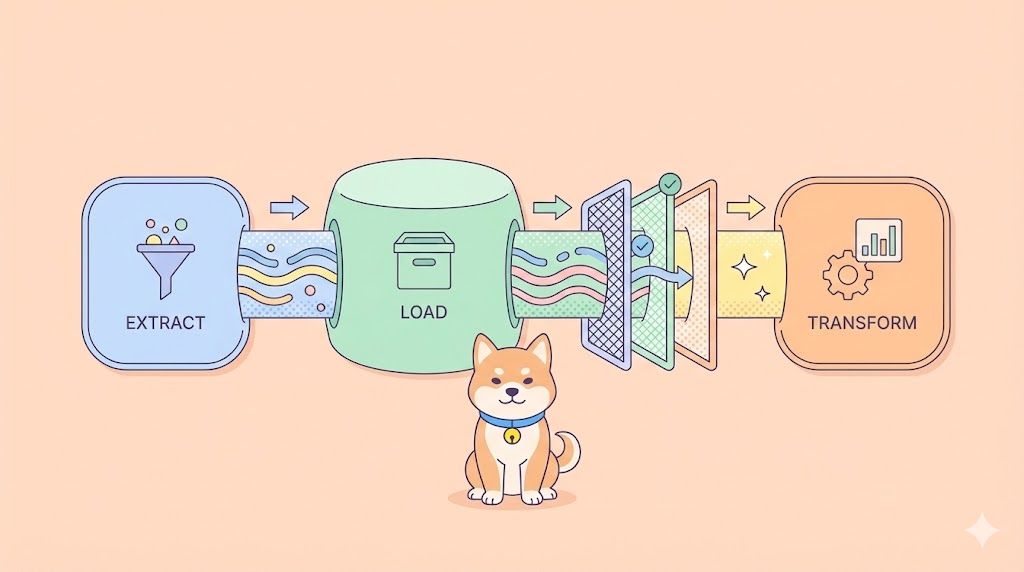

ELT คืออะไร และแตกต่างจาก ETL อย่างไร

ELT (Extract, Load, Transform) จะสลับลำดับขั้นตอนแบบ ETL ดั้งเดิม แทนที่จะแปลงข้อมูลก่อนการโหลด คุณจะดึงข้อมูลดิบจากระบบต้นทาง โหลดเข้าสู่ปลายทางโดยตรง (data lake หรือ warehouse) จากนั้นจึงแปลงข้อมูลในแหล่งที่เก็บโดยใช้พลังการประมวลผลของปลายทางนั้นๆ

| ขั้นตอน | รูปแบบ ETL | รูปแบบ ELT |

|---|---|---|

| Extract (ดึงข้อมูล) | ดึงข้อมูลจากแหล่งที่มา | ดึงข้อมูลจากแหล่งที่มา |

| Transform (แปลงข้อมูล) | ทำความสะอาด/แก้ไขในขั้นตอนเตรียมการ | เกิดขึ้นในระบบปลายทาง |

| Load (โหลดข้อมูล) | ผลักข้อมูลที่แปลงแล้ว | ผลักข้อมูลดิบก่อน |

การทดสอบ ELT ต้องตรวจสอบความถูกต้องในแต่ละขั้นตอน: ความสมบูรณ์ของการดึงข้อมูล (extraction completeness), ความถูกต้องของการโหลด (loading integrity), และความแม่นยำของการแปลงข้อมูล (transformation accuracy) — ทั้งหมดนี้ในขณะที่ยังคงรักษาประสิทธิภาพและคุณภาพของข้อมูล

ทำไมการทดสอบ ELT ถึงสำคัญ: ผลกระทบทางธุรกิจ

ไปป์ไลน์ ELT ที่ทดสอบไม่ดีจะก่อให้เกิดปัญหาเป็นลูกโซ่:

- ข้อมูลเสียหาย (Data Corruption): ข้อผิดพลาดในการแปลงข้อมูลเพียงเล็กน้อยสามารถทำให้ตัวชี้วัดที่ไม่ถูกต้องกระจายไปสู่แดชบอร์ดของผู้บริหาร ซึ่งนำไปสู่การตัดสินใจที่ผิดพลาดมูลค่านับล้านดอลลาร์

- ความเสี่ยงด้านการปฏิบัติตามกฎระเบียบ (Compliance Risk): GDPR และ HIPAA กำหนดให้คุณต้องพิสูจน์ที่มาของข้อมูล (data lineage) และความถูกต้อง การทดสอบ ELT ช่วยให้มีบันทึกการตรวจสอบ (audit trails)

- ประสิทธิภาพลดลง (Performance Degradation): ไปป์ไลน์ที่ไม่ได้ทดสอบซึ่งประมวลผลข้อมูลหลายเทราไบต์ทุกวัน สามารถทำงานช้าลงอย่างเงียบๆ ทำให้ไม่สามารถปฏิบัติตามข้อตกลงระดับบริการ (SLA) ได้

- ความน่าเชื่อถือลดลง (Trust Erosion): เมื่อทีมธุรกิจพบปัญหาคุณภาพข้อมูล พวกเขาจะหยุดเชื่อถือแพลตฟอร์มการวิเคราะห์โดยสิ้นเชิง

ครั้งหนึ่ง บริษัทค้าปลีกเคยพบว่า 15% ของข้อมูลการขายของพวกเขาหายไปจากรายงาน เนื่องจากช่องโหว่ในการทดสอบ ELT ไม่สามารถตรวจจับการเปลี่ยนแปลงสคีมาในระบบต้นทางได้ ผลกระทบคือ: การวางแผนสินค้าคงคลังที่ไม่ถูกต้องและการขาดสต็อกในช่วงฤดูท่องเที่ยว

วิธีการทดสอบ ELT: แนวทางทีละขั้นตอน

การทดสอบ ELT ติดตามเส้นทางข้อมูลตั้งแต่ต้นทางจนถึงการใช้งาน นี่คือวิธีการตรวจสอบแต่ละเฟส:

เฟสที่ 1: การทดสอบการดึงข้อมูล (Extraction Testing)

ตรวจสอบว่าข้อมูลถูกดึงมาจากระบบต้นทางอย่างครบถ้วนและแม่นยำ

กรณีทดสอบ:

- ความสมบูรณ์ (Completeness): นับจำนวนเรคคอร์ดที่ดึงเทียบกับระบบต้นทาง

- การตรวจสอบสคีมา (Schema Validation): ตรวจสอบให้แน่ใจว่าสคีมาต้นทางไม่ได้เปลี่ยนแปลงอย่างไม่คาดคิด

- ความถูกต้องของประเภทข้อมูล (Data Type Correctness): ตัวเลขยังคงเป็นตัวเลข, วันที่ยังคงเป็นวันที่

- การดึงข้อมูลเพิ่มขึ้น (Incremental Extraction): ดึงเฉพาะเรคคอร์ดใหม่/ที่เปลี่ยนแปลงเท่านั้น

# Extraction completeness test

def test_extraction_completeness():

source_count = source_db.query("SELECT COUNT(*) FROM orders WHERE date = '2024-01-01'")

extracted_count = staging_area.query("SELECT COUNT(*) FROM raw_orders WHERE date = '2024-01-01'")

assert extracted_count == source_count, f"Missing {source_count - extracted_count} records"

เฟสที่ 2: การทดสอบการโหลดข้อมูล (Loading Testing)

ตรวจสอบว่าข้อมูลดิบถูกโหลดลงในระบบปลายทางอย่างถูกต้องโดยไม่มีความเสียหาย

กรณีทดสอบ:

- การโหลดสำเร็จ (Load Success): เรคคอร์ดที่ดึงมาทั้งหมดถูกโหลดแล้ว

- ความสมบูรณ์ของข้อมูล (Data Integrity): ไม่มีการตัดทอน, ปัญหาการเข้ารหัส, หรือความเสียหาย

- การแบ่งพาร์ติชัน (Partitioning): ข้อมูลลงในพาร์ติชัน/บัคเก็ตที่ถูกต้อง

- การตรวจจับข้อมูลซ้ำ (Duplicate Detection): ไม่มีเรคคอร์ดซ้ำถูกเพิ่มเข้ามา

-- Loading integrity test

SELECT

source_table,

COUNT(*) as loaded_records,

SUM(CASE WHEN loaded_at IS NULL THEN 1 ELSE 0 END) as failed_records

FROM raw_data_audit

WHERE load_date = CURRENT_DATE

GROUP BY source_table

HAVING failed_records > 0;

เฟสที่ 3: การทดสอบการแปลงข้อมูล (Transformation Testing)

ตรวจสอบว่าตรรกะทางธุรกิจแปลงข้อมูลดิบเป็นรูปแบบที่พร้อมสำหรับการวิเคราะห์ได้อย่างถูกต้อง

กรณีทดสอบ:

- ความแม่นยำของกฎทางธุรกิจ (Business Rule Accuracy): การคำนวณตรงตามข้อกำหนด

- ความสมบูรณ์เชิงอ้างอิง (Referential Integrity): คีย์นอก (Foreign keys) แก้ไขได้อย่างถูกต้อง

- คุณภาพข้อมูล (Data Quality): การจัดการค่าว่าง (Null handling), ค่าเริ่มต้น (default values), การล้างข้อมูล (cleansing)

- ตรรกะการรวมข้อมูล (Aggregation Logic): ผลรวม, การนับ, ค่าเฉลี่ยถูกต้องทางคณิตศาสตร์

-- Transformation accuracy test

SELECT

order_id,

raw_amount,

calculated_tax,

(raw_amount * 0.08) as expected_tax

FROM transformed_orders

WHERE ABS(calculated_tax - (raw_amount * 0.08)) > 0.01

เฟสที่ 4: การตรวจสอบความถูกต้องแบบครบวงจร (End-to-End Validation)

รันไปป์ไลน์ทั้งหมดและตรวจสอบเอาต์พุตสุดท้ายเทียบกับความคาดหวังทางธุรกิจ

กรณีทดสอบ:

- ความแม่นยำของรายงาน (Report Accuracy): แดชบอร์ดสุดท้ายแสดง KPI ที่ถูกต้อง

- การกระทบยอด (Reconciliation): ผลรวมที่รวบรวมตรงกับระบบต้นทาง

- ไทม์ไลน์ (Timeline): ความทันสมัยของข้อมูลเป็นไปตาม SLA (เช่น ภายใน 2 ชั่วโมง)

- ผลกระทบปลายน้ำ (Downstream Impact): เครื่องมือ BI สามารถสอบถามข้อมูลที่แปลงแล้วโดยไม่มีข้อผิดพลาด

การทดสอบ ELT เทียบกับการทดสอบข้อมูลแบบดั้งเดิม

การทดสอบ ELT แตกต่างจากการทดสอบ Data Warehouse แบบดั้งเดิมในประเด็นสำคัญดังนี้:

| ด้าน | การทดสอบ ETL แบบดั้งเดิม | การทดสอบ ELT |

|---|---|---|

| ตำแหน่งการทดสอบ | เลเยอร์การจัดเตรียม (Staging layer) | ระบบปลายทาง (Snowflake, BigQuery) |

| เน้นประสิทธิภาพ | เอนจินการแปลงข้อมูล | ประสิทธิภาพการประมวลผลของปลายทาง |

| การเปลี่ยนแปลงสคีมา | จัดการในเครื่องมือ ETL | ทดสอบในระบบปลายทาง |

| เครื่องมือ | เครื่องมือทดสอบเฉพาะ ETL | เครื่องมือที่ใช้ SQL + API |

การทดสอบ ELT ที่ทันสมัยต้องการให้คุณตรวจสอบความถูกต้องของการแปลงข้อมูล SQL ภายในคลาวด์แวร์เฮาส์, ตรวจสอบเอนด์พอยต์การนำเข้าข้อมูล API, และติดตามที่มาของข้อมูล (data lineage) ในสถาปัตยกรรมแบบ schema-on-read

เครื่องมือสำหรับการทดสอบ ELT

การทดสอบแบบ SQL-Based:

- dbt (data build tool) พร้อมการทดสอบในตัว

- Great Expectations สำหรับคุณภาพข้อมูล

- สคริปต์ SQL แบบกำหนดเองในคลังข้อมูลปลายทาง

การทดสอบแบบ API-Based (สำคัญสำหรับ ELT):

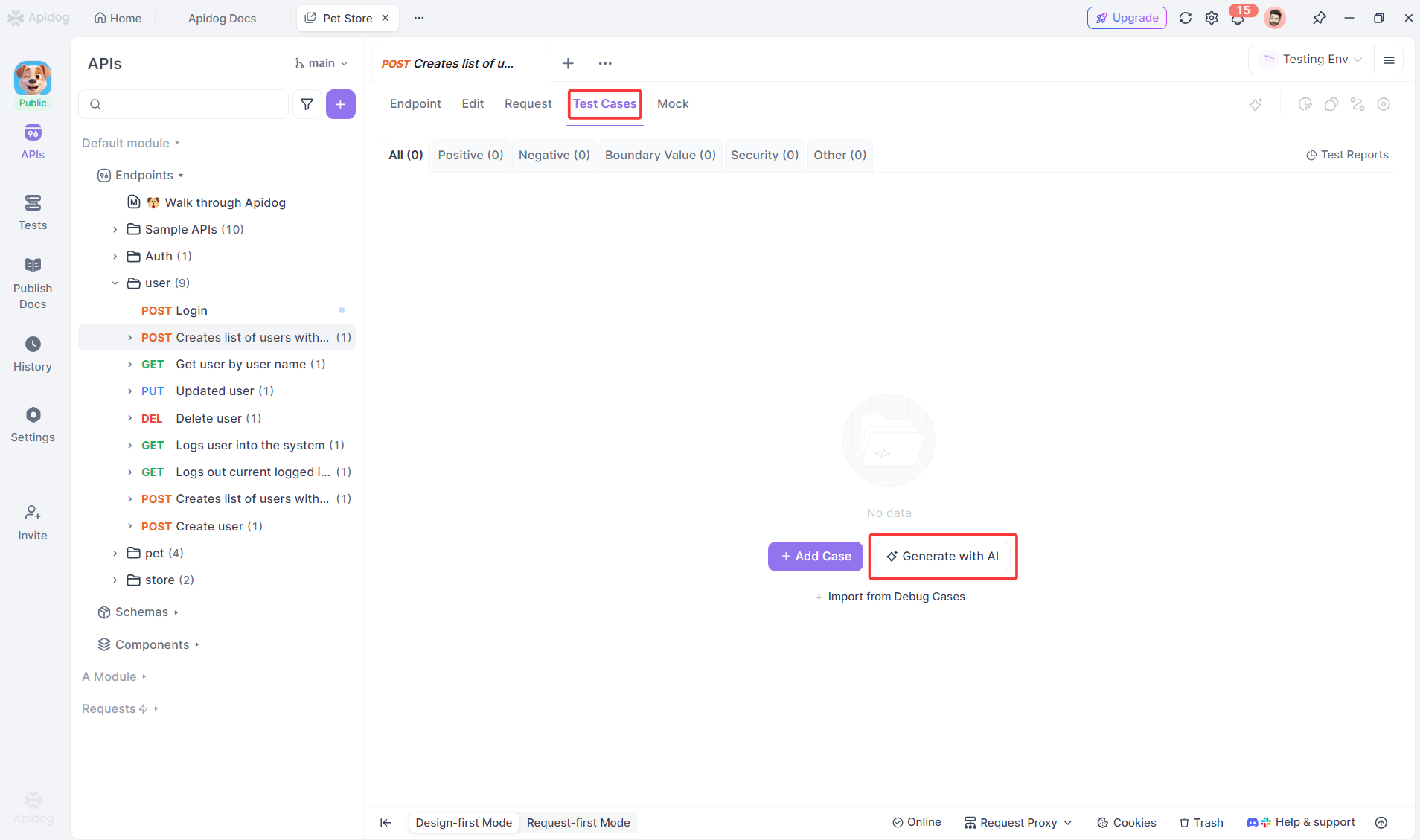

- Apidog สำหรับการตรวจสอบ API การนำเข้าและตรวจสอบ API แบบเฉพาะหน้า

- สคริปต์แบบกำหนดเองสำหรับการตรวจสอบ webhook

การทดสอบ Orchestration:

- การตรวจสอบงาน Apache Airflow

- การทดสอบโฟลว์ Prefect

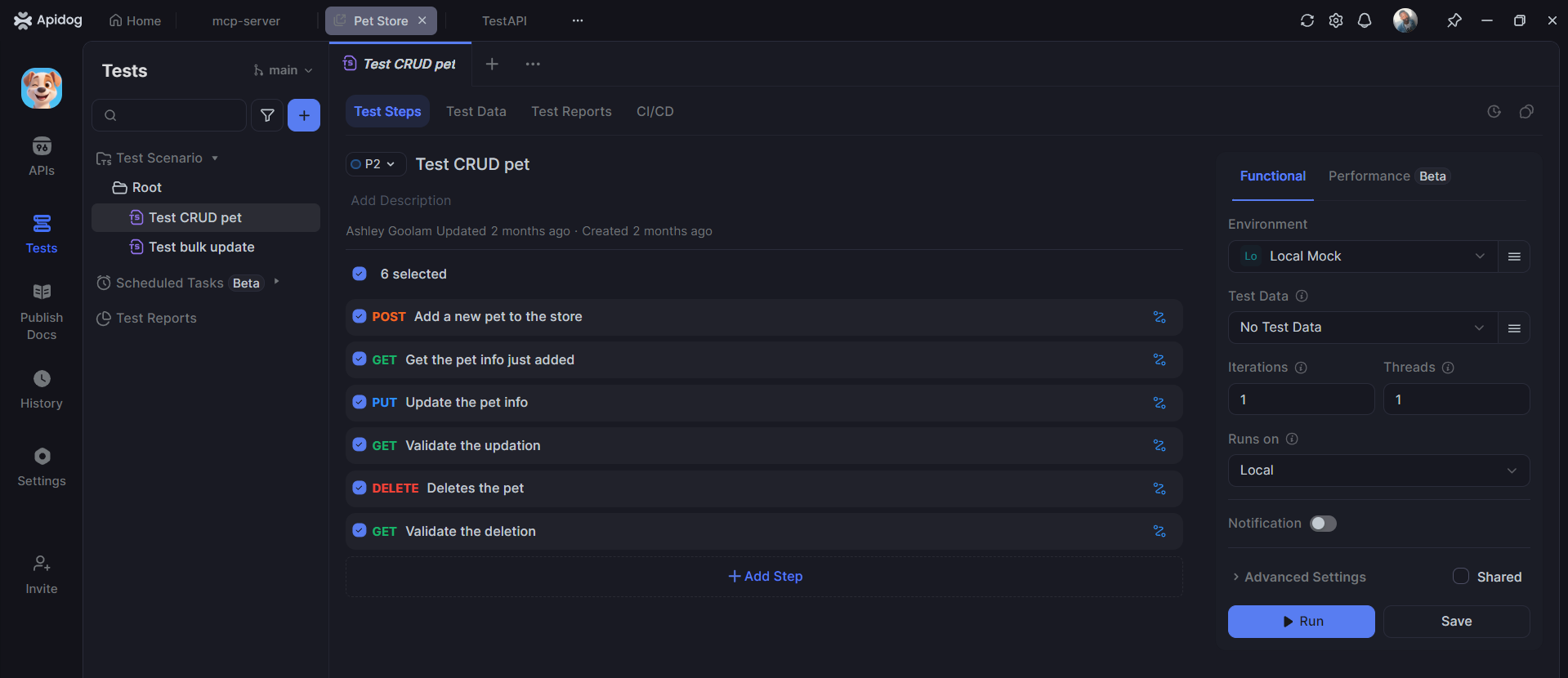

Apidog ช่วยในการทดสอบ ELT ได้อย่างไร

ในขณะที่เครื่องมือ SQL จัดการการแปลงข้อมูลได้ Apidog ก็มีความโดดเด่นในการทดสอบเลเยอร์ API ของไปป์ไลน์ ELT ซึ่งมีความสำคัญต่อการนำเข้าและตรวจสอบข้อมูลสมัยใหม่

การทดสอบ API การนำเข้าข้อมูล

ไปป์ไลน์ ELT ส่วนใหญ่ใช้ API ในการดึงข้อมูล Apidog ช่วยให้การตรวจสอบเอนด์พอยต์เหล่านี้เป็นไปโดยอัตโนมัติ:

# Apidog test for data ingestion API

Test: POST /api/v1/extract/orders

Given: Valid API key and date range

When: Request sent with parameters {"start_date": "2024-01-01", "end_date": "2024-01-31"}

Test 1: Response status 202 (accepted for processing)

Test 2: Response contains job_id for tracking

Test 3: Webhook notification received within 5 minutes

Test 4: Data appears in staging table

ข้อดีของ Apidog สำหรับ การทดสอบ ELT:

- การสร้างการทดสอบอัตโนมัติ จาก OpenAPI specs

- เครื่องมือสร้างเวิร์กโฟลว์ด้วยภาพ (Visual workflow builder) สำหรับไปป์ไลน์ที่ซับซ้อน

- การจัดการสภาพแวดล้อม (Environment management) สำหรับ data warehouses ใน dev/staging/prod

- การผสานรวม CI/CD เพื่อรันการตรวจสอบคุณภาพข้อมูลตามกำหนดเวลา

- การบันทึกรายละเอียด (Detailed logging) สำหรับบันทึกการตรวจสอบ

แนวทางปฏิบัติที่ดีที่สุดสำหรับการทดสอบ ELT

- ทดสอบแบบเพิ่มทีละน้อย (Test incrementally): ตรวจสอบการดึงข้อมูลก่อนการโหลด, โหลดก่อนการแปลง

- ตรวจสอบอย่างต่อเนื่อง (Monitor continuously): รันการตรวจสอบคุณภาพข้อมูลทุกชั่วโมง ไม่ใช่แค่ครั้งเดียว

- ควบคุมเวอร์ชันการทดสอบ (Version control tests): จัดเก็บการทดสอบ SQL ใน Git ควบคู่ไปกับโค้ดการแปลงข้อมูล

- ทดสอบในสภาพแวดล้อมที่เหมือนการใช้งานจริง (Test in production-like environment): ใช้ปริมาณข้อมูลจริงในสภาพแวดล้อมการจัดเตรียม (staging)

- ทำการกระทบยอดอัตโนมัติ (Automate reconciliation): เปรียบเทียบจำนวนข้อมูลต้นทางและปลายทางโดยอัตโนมัติ

- แจ้งเตือนความผิดปกติ (Alert on anomalies): แจ้งเตือนเมื่อจำนวนแถวเบี่ยงเบนเกิน 5% จากค่าเฉลี่ยในอดีต

- บันทึกที่มาของข้อมูล (Document data lineage): ติดตามว่าแต่ละฟิลด์มีการเปลี่ยนแปลงอย่างไรจากข้อมูลดิบไปสู่ข้อมูลสุดท้าย

คำถามที่พบบ่อย

คำถามที่ 1: เราควรเรียกใช้การทดสอบ ELT บ่อยแค่ไหน?

คำตอบ: การทดสอบการดึงข้อมูลจะทำงานทุกครั้งที่มีการเรียกใช้ไปป์ไลน์ การทดสอบคุณภาพข้อมูลจะทำงานอย่างต่อเนื่อง (รายชั่วโมง) การตรวจสอบความถูกต้องแบบครบวงจรจะทำงานอย่างน้อยวันละครั้ง

คำถามที่ 2: ใครเป็นผู้รับผิดชอบการทดสอบ ELT — Data Engineers หรือ QA?

คำตอบ: Data Engineers เป็นเจ้าของชุดการทดสอบเพราะพวกเขาเข้าใจการแปลงข้อมูล QA จัดเตรียมเฟรมเวิร์กและตรวจสอบความถูกต้องของผลลัพธ์ตรรกะทางธุรกิจ

คำถามที่ 3: Apidog สามารถแทนที่การทดสอบ ELT แบบ SQL-based ได้หรือไม่?

คำตอบ: ไม่ได้ Apidog เสริมการทดสอบ SQL โดยการตรวจสอบเลเยอร์ API (การนำเข้า, การตรวจสอบ, การจัดระเบียบ) คุณยังคงต้องใช้การทดสอบ SQL สำหรับการแปลงข้อมูลภายในคลังข้อมูล

คำถามที่ 4: เราจะทดสอบไปป์ไลน์ ELT ที่ประมวลผลข้อมูลหลายเทราไบต์ได้อย่างไร?

คำตอบ: ทดสอบกับตัวอย่างที่มีนัยสำคัญทางสถิติ (เช่น 1% ของข้อมูล) แทนที่จะเป็นปริมาณทั้งหมด ใช้การทำโปรไฟล์ข้อมูลเพื่อตรวจสอบว่าการกระจายข้อมูลตรงตามความคาดหวัง

คำถามที่ 5: การทดสอบ ELT ที่สำคัญที่สุดที่จะต้องนำไปใช้ก่อนคืออะไร?

คำตอบ: การกระทบยอดจำนวนแถวแบบครบวงจร (End-to-end row count reconciliation) หากจำนวนเรคคอร์ดต้นทางและปลายทางไม่ตรงกัน สิ่งอื่นใดก็ไม่มีความหมาย การทดสอบนี้จะตรวจจับความล้มเหลวของไปป์ไลน์ส่วนใหญ่

บทสรุป

การทดสอบ ELT เป็นสิ่งที่ขาดไม่ได้สำหรับองค์กรที่ขับเคลื่อนด้วยข้อมูล ซึ่งแตกต่างจากการทดสอบซอฟต์แวร์แบบดั้งเดิมที่ข้อผิดพลาดส่งผลกระทบต่อฟีเจอร์ แต่ข้อผิดพลาดในไปป์ไลน์ข้อมูลส่งผลกระทบต่อการตัดสินใจทางธุรกิจ การปฏิบัติตามกฎระเบียบ และรายได้ แนวทางที่เป็นระบบ — การทดสอบการดึงข้อมูล การโหลด การแปลงข้อมูล และกระบวนการแบบครบวงจร — ช่วยป้องกันข้อมูลเสียหายที่มีค่าใช้จ่ายสูงและสร้างความไว้วางใจในแพลตฟอร์มการวิเคราะห์ของคุณ

ไปป์ไลน์ ELT สมัยใหม่พึ่งพา API อย่างมากสำหรับการนำเข้าและการตรวจสอบ Apidog ช่วยให้งานที่น่าเบื่อในการทดสอบ API เหล่านี้เป็นไปโดยอัตโนมัติ ช่วยให้วิศวกรข้อมูลสามารถมุ่งเน้นไปที่ตรรกะการแปลงข้อมูล ในขณะที่มั่นใจว่าจุดเข้าและออกของไปป์ไลน์ได้รับการตรวจสอบอย่างต่อเนื่อง การผสมผสานระหว่างการทดสอบการแปลงข้อมูลแบบ SQL-based และการทำงานอัตโนมัติของ API ของ Apidog สร้างตาข่ายนิรภัยที่ครอบคลุมสำหรับสินทรัพย์ทางธุรกิจที่สำคัญที่สุดของคุณ: ข้อมูล

เริ่มต้นด้วยการทดสอบการกระทบยอด เพิ่มการตรวจสอบคุณภาพข้อมูล ทำให้การตรวจสอบ API เป็นไปโดยอัตโนมัติ ตัวคุณในอนาคต — และผู้มีส่วนได้ส่วนเสียทางธุรกิจของคุณ — จะขอบคุณเมื่อการนำเสนอของคณะกรรมการแสดงตัวเลขที่แม่นยำ