กลยุทธ์การทดสอบส่วนใหญ่มุ่งเป้าไปที่การป้องกันความล้มเหลว โดยมีเป้าหมายเพื่อตรวจสอบว่าระบบทำงานได้อย่างถูกต้องภายใต้เงื่อนไขที่คาดหวัง **Chaos Testing** ใช้วิธีตรงกันข้าม; โดยจงใจทำให้เกิดความล้มเหลวเพื่อพิสูจน์ว่าระบบของคุณสามารถทนทานต่อสิ่งเหล่านั้นได้ วิธีการที่ดูขัดกับสามัญสำนึกนี้ได้กลายเป็นสิ่งจำเป็นสำหรับการสร้างแอปพลิเคชัน cloud-native ที่ยืดหยุ่นซึ่งสามารถอยู่รอดได้ในความผันผวนของโลกแห่งความเป็นจริง

Chaos Testing คืออะไรกันแน่?

Chaos Testing คือการปฏิบัติที่จงใจฉีดข้อบกพร่องเข้าไปในระบบเพื่อตรวจสอบความสามารถในการรักษาระบบให้พร้อมใช้งานและความสมบูรณ์ของข้อมูลในช่วงที่มีการหยุดชะงักที่ไม่คาดคิด แทนที่จะถามว่า "ฟีเจอร์นี้ใช้งานได้หรือไม่?" แต่จะถามว่า "ระบบของเราจะยังทำงานต่อไปได้หรือไม่เมื่อโหนดฐานข้อมูลล่ม, ความหน่วงของเครือข่ายพุ่งสูงขึ้น หรือทั้งภูมิภาคออฟไลน์ไป?"

แนวคิดนี้มีต้นกำเนิดที่ Netflix ในปี 2010 ด้วย Chaos Monkey ซึ่งเป็นเครื่องมือที่ยุติการทำงานของเซิร์ฟเวอร์การผลิตแบบสุ่ม ปรัชญาเรียบง่าย: หากคุณจงใจทำให้สิ่งต่างๆ ล้มเหลวเป็นประจำ คุณจะค้นพบจุดอ่อนก่อนที่จะกลายเป็นปัญหาขัดข้อง วันนี้ Chaos Testing ได้พัฒนาเป็นวินัยที่ซับซ้อนพร้อมแพลตฟอร์มเฉพาะ การทดลองที่ควบคุมได้ และตัวชี้วัดความยืดหยุ่นที่สามารถวัดผลได้

ความสำคัญอย่างยิ่งยวดของ Chaos Testing

การทดสอบแบบดั้งเดิมตั้งสมมติฐานถึงโลกที่สมบูรณ์แบบ—เครือข่ายที่เสถียร เซิร์ฟเวอร์ที่แข็งแรง และโหลดที่คาดเดาได้ ความเป็นจริงของการผลิตนั้นยุ่งเหยิง Chaos Testing เผยให้เห็นช่องว่างระหว่างสมมติฐานของเรากับความเป็นจริง:

- ป้องกันความล้มเหลวแบบต่อเนื่อง: ความล้มเหลวของไมโครเซอร์วิสเพียงตัวเดียวสามารถกระตุ้นให้เกิดปฏิกิริยาลูกโซ่ได้ การทดลอง Chaos จะเปิดเผยการพึ่งพากันเหล่านี้ก่อนที่จะทำให้เกิดการหยุดชะงัก

- ตรวจสอบการเฝ้าระวังและการแจ้งเตือน: หากระบบแจ้งเตือนของคุณไม่สังเกตเห็นการทดลอง Chaos ก็จะไม่สังเกตเห็นความล้มเหลวที่แท้จริงเช่นกัน

- สร้างความมั่นใจ: ทีมที่ฝึกฝนความล้มเหลวเป็นประจำจะตอบสนองอย่างใจเย็นเมื่อเกิดเหตุการณ์จริง แทนที่จะตื่นตระหนก

- ปรับปรุงเวลาในการกู้คืน: การฝึกฝนความล้มเหลวซ้ำๆ จะช่วยลดเวลาเฉลี่ยในการกู้คืน (MTTR) จากหลายชั่วโมงเป็นหลายนาที

- ประหยัดค่าใช้จ่าย: การทดสอบ Chaos ที่วางแผนไว้หนึ่งชั่วโมงจะช่วยป้องกันค่าใช้จ่ายจากการหยุดชะงักที่ไม่ได้วางแผนไว้หลายวัน

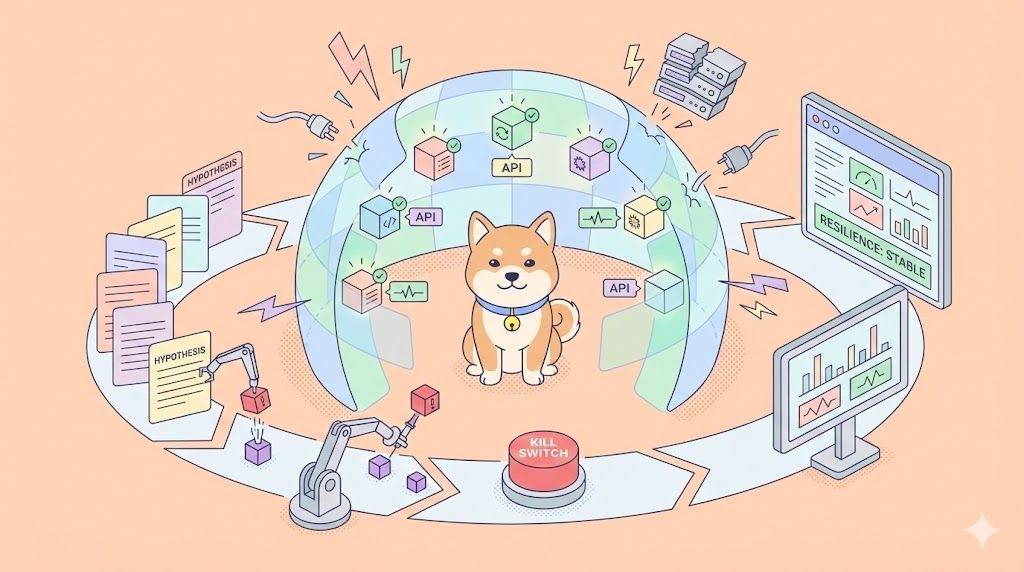

Chaos Testing ทำได้อย่างไร: วิธีการทางวิทยาศาสตร์

**Chaos Testing** ที่มีประสิทธิภาพปฏิบัติตามแนวทางที่มีโครงสร้าง ไม่ใช่การทำลายแบบสุ่ม:

ขั้นตอนที่ 1: กำหนดสถานะปกติ (Steady State)

ระบุตัวชี้วัดพฤติกรรมระบบปกติ: เวลาตอบสนอง, อัตราข้อผิดพลาด, ปริมาณงาน (throughput) ข้อมูลพื้นฐานนี้พิสูจน์ว่าระบบทำงานเป็นปกติก่อนที่คุณจะฉีด Chaos เข้าไป

ขั้นตอนที่ 2: สร้างสมมติฐาน

ระบุสิ่งที่คุณคาดหวัง: "หากเราปิดสำเนาฐานข้อมูล (database replica) ความหน่วงจะเพิ่มขึ้นน้อยกว่า 10% และจะไม่มีข้อมูลสูญหาย"

ขั้นตอนที่ 3: ฉีดข้อบกพร่อง

แนะนำความล้มเหลวที่ควบคุมได้:

- ยุติอินสแตนซ์ของเซิร์ฟเวอร์

- สร้างความหน่วงของเครือข่าย

- เติมพื้นที่ดิสก์

- ทำให้การตอบกลับ DNS เสียหาย

- จำลองภาระ CPU สูง

ขั้นตอนที่ 4: ตรวจสอบและวัดผล

สังเกตพฤติกรรมของระบบแบบเรียลไทม์ มันเสื่อมสภาพอย่างค่อยเป็นค่อยไปหรืออย่างหายนะ?

ขั้นตอนที่ 5: วิเคราะห์และปรับปรุง

บันทึกผลการค้นพบ, แก้ไขจุดอ่อน, และทำการทดลองซ้ำเพื่อตรวจสอบการปรับปรุง

เครื่องมือและเฟรมเวิร์กสำหรับ Chaos Testing

แพลตฟอร์ม **Chaos Testing** ที่ทันสมัยช่วยให้สามารถฉีดข้อบกพร่องได้อย่างปลอดภัยและควบคุมได้:

Gremlin

แพลตฟอร์มวิศวกรรม Chaos ระดับองค์กรพร้อมเว็บ UI และ API ฉีด CPU spikes, ความหน่วงของเครือข่าย, ความล้มเหลวของดิสก์ และอื่นๆ ทั่วทั้งโครงสร้างพื้นฐานคลาวด์

# ตัวอย่าง Gremlin CLI: เพิ่มความหน่วง 100ms ให้กับการเรียก API

gremlin attack latency --delay 100 --duration 60s --targets api-server

Chaos Monkey

เครื่องมือดั้งเดิมสำหรับยุติอินสแตนซ์ของ AWS แบบสุ่ม ปัจจุบันเป็นส่วนหนึ่งของชุด Simian Army

Litmus

วิศวกรรม Chaos แบบ Kubernetes-native พร้อมการทดลองที่สร้างไว้ล่วงหน้าสำหรับพอด โหนด และนโยบายเครือข่าย

# การทดลอง Litmus chaos สำหรับการลบพอด

apiVersion: litmuschaos.io/v1alpha1

kind: ChaosEngine

metadata:

name: pod-delete-chaos

spec:

appinfo:

appns: default

applabel: app=api-server

chaosServiceAccount: pod-delete-sa

experiments:

- name: pod-delete

spec:

components:

env:

- name: TOTAL_CHAOS_DURATION

value: '30'

Chaos Mesh

เครื่องมืออีกตัวที่เน้น Kubernetes ซึ่งฉีดข้อบกพร่องในระดับแพลตฟอร์ม

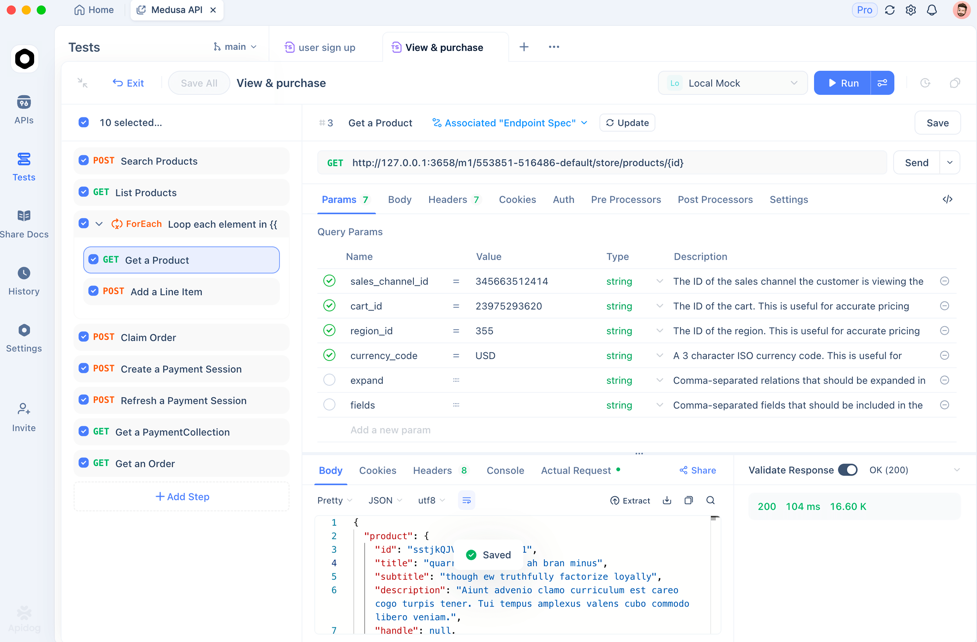

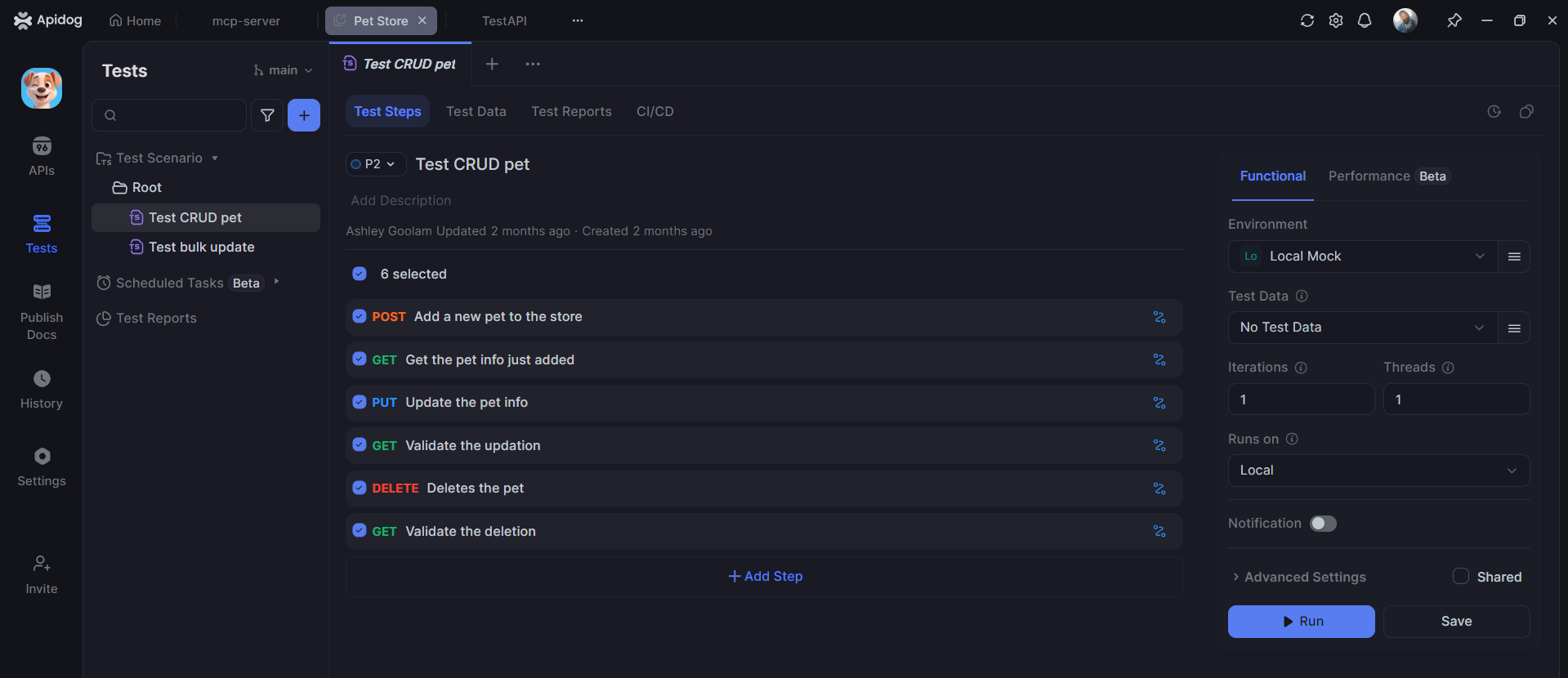

Apidog สำหรับการทดสอบ Chaos ในระดับ API

ในขณะที่เครื่องมือ Chaos ระดับโครงสร้างพื้นฐานมุ่งเป้าไปที่เซิร์ฟเวอร์และเครือข่าย **Apidog** จัดการ Chaos ในระดับ API ซึ่งมีความสำคัญอย่างยิ่งสำหรับแอปพลิเคชันบล็อกเชนและไมโครเซอร์วิส:

Chaos การตอบกลับ API:

// การทดสอบ Apidog: จำลอง API ส่งคืนข้อผิดพลาด 500 แบบสุ่ม

Test: GET /api/balance - โหมด Chaos

When: ส่งคำขอ

Oracle 1: หากการตอบกลับเป็น 500, การลองใหม่ควรสำเร็จภายใน 3 ครั้ง

Oracle 2: ระบบควรบันทึกข้อผิดพลาดและแจ้งเตือน

Oracle 3: UI ควรสแสดงข้อความที่เป็นมิตรกับผู้ใช้

Chaos ประสิทธิภาพ:

// Apidog: ทดสอบพฤติกรรม API ภายใต้ความหน่วง

Test: POST /api/transactions - เครือข่ายช้า

When: ส่งคำขอด้วยการจำลองความล่าช้า 2000ms

Oracle 1: การหมดเวลาควรเริ่มทำงานหลังจาก 5 วินาที

Oracle 2: ธุรกรรมไม่ควรซ้ำกัน

Oracle 3: ผู้ใช้ควรมองเห็นข้อความ "ลองใหม่"

Chaos ข้อมูล:

// Apidog: ทดสอบ API ด้วยข้อมูลบล็อกเชนที่ไม่ถูกต้อง

Test: API จัดการแฮชธุรกรรมที่ไม่ถูกต้อง

When: ส่งแฮชที่มีรูปแบบผิด (0x123 แทน 0x123...64)

Oracle 1: สถานะ 400 พร้อมข้อผิดพลาดการตรวจสอบเฉพาะ

Oracle 2: ข้อความแสดงข้อผิดพลาดอธิบายรูปแบบที่ถูกต้อง

Oracle 3: ระบบบันทึกความพยายามแต่ไม่ล่ม

ข้อดีของ Apidog คือการสร้างกรณีทดสอบ Chaos เหล่านี้โดยอัตโนมัติจาก OpenAPI spec ของคุณ จากนั้นดำเนินการแบบขนานเพื่อค้นหาจุดที่ล้มเหลวได้อย่างรวดเร็ว

Chaos Testing vs. การทดสอบประเภทอื่นๆ

| ประเภทการทดสอบ | จุดเน้น | ตัวกระตุ้น | เป้าหมาย | ความถี่ |

|---|---|---|---|---|

| การทดสอบโหลด | รูปแบบโหลดปกติ | ผู้ใช้จำลอง | ค้นหาขีดจำกัดความจุ | ก่อนการเผยแพร่ |

| การทดสอบความเครียด | โหลดสูงสุด | ใช้ทรัพยากรจนเต็ม | ค้นหาจุดที่ล้มเหลว | ก่อนการเผยแพร่ |

| การทดสอบ Failover | ความล้มเหลวของส่วนประกอบเดียว | การปิดระบบด้วยตนเอง | ตรวจสอบว่าระบบสำรองทำงาน | รายไตรมาส |

| Chaos Testing | ความล้มเหลวแบบสุ่มในโลกแห่งความเป็นจริง | การฉีดอัตโนมัติ | สร้างความยืดหยุ่น | ต่อเนื่อง |

**Chaos Testing** แตกต่างออกไปเพราะเป็นแบบต่อเนื่องและคาดเดาไม่ได้ ในขณะที่การทดสอบโหลดจะตรวจสอบว่าคุณสามารถจัดการกับการเข้าชมในวัน Black Friday ได้หรือไม่ การทดสอบ Chaos จะช่วยให้แน่ใจว่าคุณจะอยู่รอดได้เมื่อฐานข้อมูลของผู้ประมวลผลการชำระเงินของคุณล่ม *ระหว่าง* วัน Black Friday

แนวปฏิบัติที่ดีที่สุดสำหรับ Chaos Testing

เริ่มต้นในสภาพแวดล้อม Staging: อย่าเริ่มต้นการทดลอง Chaos ในสภาพแวดล้อมการผลิต พิสูจน์ความยืดหยุ่นในสภาพแวดล้อมที่ไม่ใช่การผลิตก่อน

- เริ่มต้นเล็กๆ: เริ่มต้นด้วยความล้มเหลวของอินสแตนซ์เดียว ก่อนที่จะจำลองการหยุดชะงักของทั้งภูมิภาค

- มีสวิตช์หยุดฉุกเฉิน (Kill Switch): การทดลองทุกครั้งจะต้องสามารถย้อนกลับได้ทันที ฝึกฝนการยกเลิกการทดลอง

- วัดทุกอย่าง: รวบรวมตัวชี้วัดเกี่ยวกับความหน่วง, อัตราข้อผิดพลาด, เวลาในการกู้คืน และความสมบูรณ์ของข้อมูล

- วันเกม (Game Days): กำหนด "วันเกม Chaos" เป็นประจำ ซึ่งทีมจะดำเนินการทดลองที่ประสานงานกันและฝึกฝนการตอบสนองต่อเหตุการณ์

- วัฒนธรรมที่ไม่ตำหนิ (Blameless Culture): เมื่อการทดลอง Chaos พบจุดอ่อน ให้ถือว่าเป็นโอกาสในการเรียนรู้ ไม่ใช่ความล้มเหลว

คำถามที่พบบ่อย

คำถามที่ 1: Chaos Testing อันตรายหรือไม่? อาจทำให้ระบบการผลิตล่มได้หรือไม่?

คำตอบ: จะอันตรายก็ต่อเมื่อทำโดยประมาทเท่านั้น ให้เริ่มต้นในสภาพแวดล้อม Staging, ใช้ขีดจำกัดของรัศมีผลกระทบ และมีสวิตช์หยุดฉุกเฉิน (kill switch) เสมอ วิศวกรรม Chaos คือการทดลองที่ควบคุมได้ ไม่ใช่การทำลายแบบสุ่ม

คำถามที่ 2: Chaos Testing แตกต่างจากการทำให้สิ่งต่างๆ เสียหายอย่างไร?

คำตอบ: **Chaos Testing** เป็นวิทยาศาสตร์ คุณเริ่มต้นด้วยสมมติฐาน ฉีดข้อบกพร่องที่เฉพาะเจาะจง วัดผลลัพธ์ที่เป็นรูปธรรม และใช้ผลการค้นพบเพื่อปรับปรุง ความล้มเหลวแบบสุ่มไม่ได้สอนอะไรเลยหากไม่มีการวัดผลและการวิเคราะห์

คำถามที่ 3: ฉันจำเป็นต้องมีเครื่องมือพิเศษเพื่อเริ่มต้น Chaos Testing หรือไม่?

คำตอบ: ไม่จำเป็นต้องมีในตอนแรก คุณสามารถจำลองความล้มเหลวด้วยตนเองได้ (หยุดบริการ, สร้างความหน่วงของเครือข่าย) แต่ในระดับที่ใหญ่ขึ้น เครื่องมืออย่าง Gremlin หรือ Litmus ให้การควบคุมความปลอดภัย ระบบอัตโนมัติ และการวัดผลที่ Chaos แบบแมนนวลไม่สามารถเทียบได้

คำถามที่ 4: Chaos Testing สามารถทดแทน QA แบบดั้งเดิมได้หรือไม่?

คำตอบ: ไม่ได้ **Chaos Testing** เป็นส่วนเสริมของการทดสอบฟังก์ชันการทำงาน คุณต้องการทั้งสองอย่าง: การทดสอบฟังก์ชันการทำงานตรวจสอบว่าคุณสมบัติทำงานได้; การทดสอบ Chaos ตรวจสอบว่าคุณสมบัติยังคงทำงานได้เมื่อเกิดความล้มเหลว

คำถามที่ 5: Apidog ช่วยอะไรในการทำ Chaos Testing?

คำตอบ: Apidog ทำให้การทดสอบ Chaos ในระดับ API เป็นไปโดยอัตโนมัติ โดยการสร้างกรณีทดสอบที่ตรวจสอบว่า API ของคุณจัดการกับการตอบสนองที่ช้า ข้อผิดพลาด และข้อมูลที่ไม่ถูกต้องได้อย่างไร นี่เป็นสิ่งสำคัญสำหรับไมโครเซอร์วิสที่ขึ้นอยู่กับโหนดบล็อกเชนหรือบริการภายนอก

บทสรุป

**Chaos Testing** ได้พัฒนาจากการยุติเซิร์ฟเวอร์แบบรุกรานของ Netflix กลายมาเป็นแนวปฏิบัติทางวิศวกรรมที่มีระเบียบวินัย ซึ่งสร้างความมั่นใจผ่านความล้มเหลวที่ควบคุมได้ ด้วยการพิสูจน์อย่างเป็นระบบว่าระบบของคุณสามารถอยู่รอดได้ในสภาวะที่ผันผวน คุณจะป้องกันการแจ้งเตือนตอนตี 3 ที่ทำลายวันหยุดสุดสัปดาห์และชื่อเสียงได้

กุญแจสำคัญคือการเริ่มต้นเล็กๆ วัดทุกอย่าง และปฏิบัติต่อการทดลองที่ล้มเหลวทุกครั้งเหมือนเป็นของขวัญที่เผยให้เห็นจุดอ่อนก่อนที่จะกลายเป็นการหยุดชะงัก เครื่องมืออย่าง Gremlin และ Litmus จัดการ Chaos ระดับโครงสร้างพื้นฐาน ในขณะที่ Apidog ทำให้การทดสอบความยืดหยุ่นระดับ API เป็นไปโดยอัตโนมัติ ซึ่งมีคุณค่าอย่างยิ่งสำหรับสถาปัตยกรรมบล็อกเชนและไมโครเซอร์วิสที่การพึ่งพากันของ API สร้างความเสี่ยงต่อความล้มเหลวแบบต่อเนื่อง

เริ่มต้นเส้นทาง Chaos ของคุณวันนี้ เลือกบริการที่ไม่สำคัญหนึ่งรายการ กำหนดสถานะปกติ (steady state) ของมัน ฉีดข้อบกพร่องเล็กๆ หนึ่งรายการ สังเกต เรียนรู้ ปรับปรุง ทำซ้ำ นี่คือ **วิธีการทดสอบแอปพลิเคชันบล็อกเชน** และระบบแบบกระจายใดๆ เพื่อความยืดหยุ่นในโลกแห่งความเป็นจริง