Desenvolvedores e entusiastas de IA recorrem cada vez mais a modelos generativos poderosos como o Wan 2.2 para criar vídeos cinematográficos a partir de entradas simples. Este modelo se destaca por sua arquitetura de Mistura de Especialistas (Mixture-of-Experts), que aumenta a capacidade sem sacrificar a velocidade. Ao combinar a API do Wan 2.2 (com LoRA), você obtém a capacidade de ajustar as saídas para estilos ou movimentos específicos, tornando-o ideal para geração de vídeo personalizada.

O Que é o Wan 2.2?

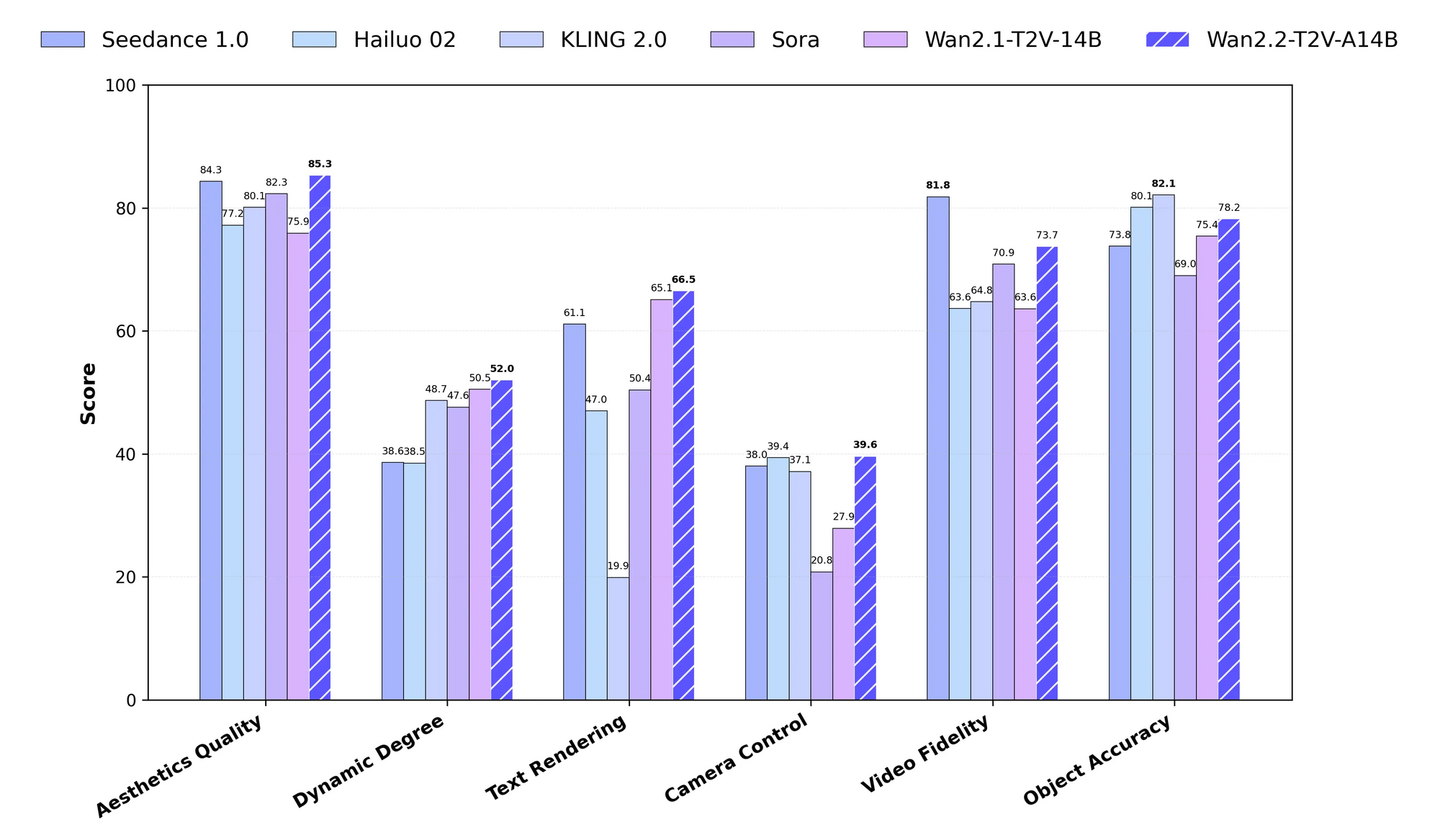

Wan 2.2 representa um modelo generativo de vídeo em larga escala, avançado e de código aberto, desenvolvido pela equipe Wan. Engenheiros o projetam para lidar com tarefas complexas como geração de texto para vídeo (T2V), imagem para vídeo (I2V) e fala para vídeo (S2V). O modelo emprega uma estrutura de Mistura de Especialistas (MoE), que divide o processo de denoising em modelos de difusão entre especialistas especializados. Por exemplo, especialistas de alto ruído gerenciam os timesteps iniciais, enquanto os de baixo ruído refinam as etapas posteriores. Essa abordagem resulta em um total de 27 bilhões de parâmetros, com apenas 14 bilhões ativos por etapa de inferência, garantindo eficiência.

Além disso, o Wan 2.2 incorpora estética cinematográfica por meio de conjuntos de dados curados que enfatizam iluminação, composição e tons de cor. Os dados de treinamento se expandem significativamente em relação às versões anteriores, incluindo 65,6% mais imagens e 83,2% mais vídeos, o que aprimora a complexidade do movimento e a compreensão semântica. Você acessa variantes como o modelo TI2V de 5 bilhões de parâmetros, que gera vídeos 720P a 24 FPS em hardware de consumidor como uma RTX 4090.

O aspecto da API se manifesta principalmente por meio de scripts como `generate.py` no repositório oficial, mas plataformas hospedadas o estendem para endpoints baseados na web. Portanto, você escolhe entre execução local para controle total ou serviços em nuvem para escalabilidade ao trabalhar com a API do Wan 2.2 (com LoRA).

O Que é LoRA no Contexto do Wan 2.2?

LoRA, ou Adaptação de Baixo Rank, serve como um método de ajuste fino eficiente em termos de parâmetros para modelos grandes como o Wan 2.2. Desenvolvedores aplicam LoRA para adaptar o modelo base a conjuntos de dados específicos sem retreinar toda a arquitetura. No Wan 2.2, o LoRA tem como alvo os pesos do transformador, permitindo injetar estilos, personagens ou movimentos personalizados nas gerações de vídeo.

Por exemplo, você treina um LoRA em um conjunto de dados de tomadas orbitais para especializar a variante I2V na criação de movimentos de câmera rotativos. A documentação oficial alerta contra o uso de LoRA treinado no Wan 2.2 para certas tarefas como animação devido à potencial instabilidade, mas ferramentas da comunidade superam isso. Plataformas como fal.ai integram o LoRA diretamente em sua API, onde você especifica caminhos para os pesos do LoRA e fatores de escala.

Consequentemente, incorporar o LoRA na API do Wan 2.2 (com LoRA) reduz os custos de treinamento e permite uma personalização rápida. Você mescla adaptadores LoRA no momento da inferência, preservando a eficiência do modelo base enquanto alcança saídas direcionadas.

Por Que Usar a API do Wan 2.2 com LoRA?

Você opta pela API do Wan 2.2 (com LoRA) para equilibrar poder e flexibilidade em aplicativos de IA de vídeo. O ajuste fino tradicional exige recursos massivos, mas o LoRA minimiza isso atualizando apenas matrizes de baixo rank. Este método reduz o uso de memória e o tempo de treinamento, tornando-o acessível para desenvolvedores individuais.

Além disso, a estrutura MoE do Wan 2.2 complementa o LoRA, permitindo adaptações específicas de especialistas. Você gera vídeos com estética ou movimentos aprimorados que modelos padrão teriam dificuldade em produzir. Por exemplo, na criação de conteúdo, você usa o LoRA para manter estilos de personagens consistentes em diferentes cenas.

APIs hospedadas amplificam esses benefícios, transferindo o cálculo para a nuvem. Serviços como fal.ai cuidam do trabalho pesado, para que você se concentre em prompts e parâmetros. Portanto, essa combinação é adequada para prototipagem, produção e experimentação, especialmente quando você integra ferramentas como o Apidog para um gerenciamento contínuo da API.

Como Configurar Seu Ambiente para Uso Local da API do Wan 2.2?

Você começa clonando o repositório do Wan 2.2 do GitHub. Execute o comando git clone https://github.com/Wan-Video/Wan2.2.git em seu terminal, em seguida, navegue para o diretório com cd Wan2.2. Em seguida, instale as dependências usando pip install -r requirements.txt. Para tarefas S2V, adicione pip install -r requirements_s2v.txt.

Certifique-se de que seu sistema esteja executando o PyTorch versão 2.4.0 ou superior. Você também instala o CLI do Hugging Face com pip install "huggingface_hub[cli]" para downloads de modelos. Defina variáveis de ambiente se planeja usar a extensão de prompt, como export DASH_API_KEY=sua_chave para integração com Dashscope.

Para configurações de multi-GPU, configure o Fully Sharded Data Parallel (FSDP) e o DeepSpeed Ulysses. Você os habilita com flags como --dit_fsdp e --ulysses_size 8. Usuários de GPU única ativam otimizações de memória via --offload_model e --convert_model_dtype. Essa configuração o prepara para executar o script `generate.py`, o núcleo da API local do Wan 2.2 (com LoRA).

Como Baixar e Instalar Modelos do Wan 2.2?

Você baixa modelos do Hugging Face ou ModelScope. Para a variante T2V-A14B, use huggingface-cli download Wan-AI/Wan2.2-T2V-A14B --local-dir ./Wan2.2-T2V-A14B. Repita isso para outras variantes como I2V-A14B ou TI2V-5B.

Coloque os checkpoints nos diretórios apropriados. Os modelos de 14B exigem VRAM substancial – cerca de 80GB para inferência multi-GPU – enquanto o TI2V de 5B se encaixa em uma placa de 24GB. Após o download, verifique os arquivos para evitar corrupção.

Se você encontrar problemas, mude para os mirrors do ModelScope para regiões com restrições de acesso. Esta etapa garante que você tenha os modelos base prontos antes de aplicar os adaptadores LoRA na API do Wan 2.2 (com LoRA).

Como Usar o Script generate.py para Tarefas Básicas no Wan 2.2?

Você invoca o script generate.py para realizar gerações. Para uma tarefa T2V simples em uma única GPU, execute python generate.py --task t2v-A14B --size 1280x720 --ckpt_dir ./Wan2.2-T2V-A14B --offload_model True --convert_model_dtype --prompt "Dois gatos antropomórficos com equipamento de boxe confortável lutam intensamente em um palco iluminado.".

Ajuste os parâmetros para outros modos. Em I2V, adicione --image examples/i2v_input.JPG. Para S2V, inclua --audio examples/audio_input.wav e habilite TTS com --enable_tts. A execução multi-GPU usa torchrun --nproc_per_node=8 generate.py com flags FSDP.

Esses comandos formam a espinha dorsal da API local do Wan 2.2 (com LoRA). Você experimenta com prompts e tamanhos para refinar as saídas, transitando suavemente para a integração do LoRA para personalizações avançadas.

Como Treinar um LoRA para o Wan 2.2?

Você treina o LoRA usando ferramentas da comunidade como AI Toolkit ou treinadores Trooper.AI. Primeiro, prepare seu conjunto de dados — selecione vídeos ou imagens alinhados com o seu estilo-alvo. Para um LoRA I2V, concentre-se em clipes específicos de movimento, como tomadas orbitais.

Configure o ambiente do treinador em plataformas como RunPod para acesso à GPU. Carregue os pesos base do Wan 2.2 nos diretórios esperados. Configure os hiperparâmetros: defina a taxa de aprendizado para 1e-5, o tamanho do lote para 1 e as épocas para 10-20, dependendo do tamanho do conjunto de dados.

Execute o script de treinamento, monitorando as métricas de perda. Ferramentas como a biblioteca PEFT do Hugging Face facilitam isso, permitindo que você salve o LoRA como um arquivo .safetensors. Uma vez treinado, você aplica esse adaptador nas gerações, aprimorando a API do Wan 2.2 (com LoRA) para tarefas especializadas.

Como Aplicar LoRA na Geração Local do Wan 2.2?

Você integra LoRA em configurações locais via ComfyUI ou scripts personalizados. No ComfyUI, use o nó `LoadLoRAModelOnly` entre o carregador do modelo e o sampler. Especifique o caminho e a força do LoRA (por exemplo, 0.8).

Para `generate.py`, forks ou extensões da comunidade adicionam suporte a LoRA, pois a versão oficial não possui integração direta. Alternativamente, use o pipeline Diffusers para modos de animação, carregando LoRA com pipe.load_lora_weights("caminho/para/lora").

Esta aplicação transforma saídas padrão em vídeos personalizados. Portanto, você alcança consistência em estilos ou movimentos, tornando a API do Wan 2.2 (com LoRA) mais versátil para uso em produção.

Quais São os Melhores Serviços Hospedados para a API do Wan 2.2 com LoRA?

Você acessa a API hospedada do Wan 2.2 (com LoRA) por meio de plataformas como fal.ai. O endpoint deles em https://api.fal.ai/v1/fal-ai/wan/v2.2-a14b/text-to-video/lora suporta LoRA nativamente. Cadastre-se para obter uma chave de API e configure-a em seu cliente.

Outros serviços incluem WaveSpeed.ai para I2V LoRA e Trooper.AI para treinamento. Estes eliminam a necessidade de hardware local, escalando para altas resoluções sem esforço. Consequentemente, você prototipa mais rápido, integrando-se com ferramentas como Apidog para gerenciamento de requisições.

Como Autenticar e Enviar Requisições para a API do fal.ai Wan 2.2?

Você se autentica definindo a variável de ambiente FAL_KEY. Instale o cliente fal-ai com npm install --save @fal-ai/client para JavaScript, ou use equivalentes em Python.

Envie uma requisição POST com payload JSON, incluindo prompt e um array loras. Por exemplo: {"prompt": "Uma cidade cyberpunk à noite", "loras": [{"path": "https://example.com/loras/cyberpunk.safetensors", "scale": 0.8}]}.

Monitore as respostas para URLs de vídeo. Este processo utiliza a API do Wan 2.2 (com LoRA) em ambientes de nuvem, garantindo desempenho confiável.

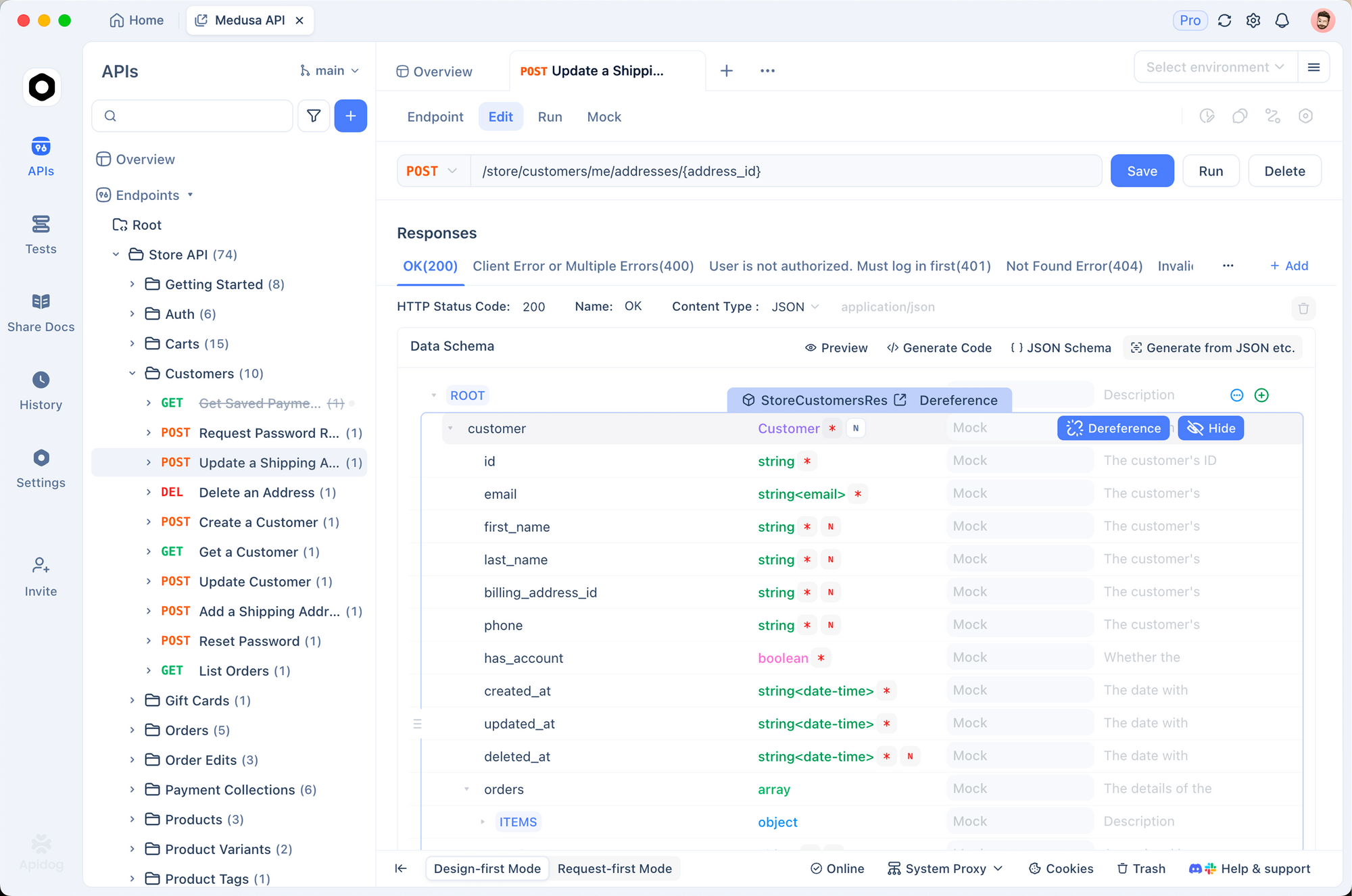

Como Usar o Apidog para Testar a API do Wan 2.2 com LoRA?

Você começa instalando o Apidog e criando um novo projeto de API. Importe os detalhes do endpoint fal.ai, definindo o método como POST e a URL para o caminho text-to-video LoRA.

Adicione cabeçalhos para autenticação, como Authorization: Key sua_chave_fal. Na aba do corpo (body), construa um JSON com os parâmetros de prompt e LoRA. Envie a requisição e inspecione a resposta, que inclui o link do vídeo gerado.

Recursos do Apidog como variáveis de ambiente e validação de resposta otimizam a depuração. Por exemplo, você salva configurações comuns de LoRA como coleções. Assim, o Apidog aprimora seu fluxo de trabalho ao testar a API do Wan 2.2 (com LoRA), permitindo iterações rápidas.

Quais Parâmetros Você Deve Ajustar na API do Wan 2.2 com LoRA?

Você ajusta parâmetros chave para otimizar as saídas. Defina num_inference_steps para 27 para equilíbrio, ou mais alto para qualidade. Escalas de guidance como 3.5 influenciam a aderência aos prompts.

Para LoRA, ajuste a scale entre 0.5-1.0 para controlar a força do adaptador. As opções de resolução incluem 720p, enquanto o FPS varia de 4 a 60. Habilite a aceleração para gerações mais rápidas, embora possa reduzir a fidelidade.

Além disso, use prompts negativos para evitar elementos indesejados. Esses ajustes refinam a API do Wan 2.2 (com LoRA), adaptando-a às necessidades específicas do projeto.

Como Lidar com Entradas Multimodais no Wan 2.2 com LoRA?

Você incorpora imagens ou áudio especificando --image ou --audio em scripts locais, ou campos equivalentes em APIs hospedadas. Aplique LoRA para aprimorar estes, como estilizar saídas I2V.

No fal.ai, adicione image_url para modos TI2V. O LoRA adapta a fusão, garantindo vídeos coerentes. Portanto, você cria conteúdo dinâmico como personagens animados, aproveitando todo o potencial da API do Wan 2.2 (com LoRA).

Quais São as Técnicas Avançadas de Otimização para Inferência do Wan 2.2?

Você emprega otimizações de memória como descarregamento de modelo (model offloading) e conversão de tipo de dado (dtype conversion) para rodar em hardware limitado. Para multi-GPU, FSDP distribui fragmentos eficientemente.

Em configurações hospedadas, enfileire requisições assíncronas para lidar com lotes. Use a expansão de prompt com LLMs para enriquecer as entradas. Essas técnicas aceleram a API do Wan 2.2 (com LoRA), tornando-a adequada para aplicações em tempo real.

Como Integrar a API do Wan 2.2 com LoRA em Aplicações?

Você constrói aplicações encapsulando chamadas de API em serviços de backend. Por exemplo, crie um servidor Node.js que atua como proxy para requisições do fal.ai, adicionando LoRA com base nas entradas do usuário.

Gerencie webhooks para trabalhos de longa duração, notificando usuários após a conclusão. Integre com frontends para geração interativa de vídeo. Essa integração incorpora a API do Wan 2.2 (com LoRA) em ferramentas como plataformas de conteúdo.

Que Exemplos Demonstram o Wan 2.2 com LoRA em Ação?

Considere gerar uma cena cyberpunk: Use o prompt "Ruas iluminadas por neon com carros voadores" e um LoRA treinado em arte distópica. A saída produz vídeos estilizados com detalhes aprimorados.

Outro exemplo: Treinar LoRA em movimentos de dança para S2V, sincronizando áudio com coreografia. Esses casos ilustram usos práticos da API do Wan 2.2 (com LoRA).

Como Solucionar Problemas Comuns com a API do Wan 2.2 e LoRA?

Você resolve erros de falta de memória habilitando flags de descarregamento (offload) ou reduzindo a resolução. Se o LoRA causar instabilidade, diminua as escalas ou retreine com conjuntos de dados estáveis.

Para falhas de API, verifique a autenticação e a validade dos parâmetros no Apidog. Problemas de rede exigem lógica de repetição. Assim, você resolve problemas eficientemente, mantendo operações suaves com a API do Wan 2.2 (com LoRA).

Quais Desenvolvimentos Futuros Podem Impactar o Wan 2.2 com LoRA?

Pesquisadores continuam avançando nos modelos de difusão, potencialmente integrando variantes mais eficientes de LoRA. Contribuições da comunidade podem adicionar suporte nativo a LoRA aos scripts oficiais.

Serviços hospedados poderiam expandir as modalidades. Manter-se atualizado garante que você aproveite as evoluções na API do Wan 2.2 (com LoRA).

Conclusão

Agora você possui um entendimento completo de como acessar e usar a API do Wan 2.2 (com LoRA). Desde configurações locais até APIs hospedadas, e com ferramentas como o Apidog, você gera vídeos impressionantes. Aplique essas técnicas para inovar na criação de conteúdo impulsionada por IA.