O Protocolo de Contexto de Modelo (MCP) é um padrão aberto projetado para criar uma linguagem comum entre aplicativos de Modelos de Linguagem Grande (LLM) e serviços externos. Ele estabelece uma maneira padronizada para um modelo de IA descobrir e interagir com ferramentas, acessar dados e usar prompts predefinidos, independentemente de como o modelo ou os serviços externos são construídos.

Em sua essência, o MCP permite que um aplicativo, conhecido como "Cliente MCP", se conecte a um ou mais "Servidores MCP". Esses servidores expõem capacidades que o LLM pode então utilizar. Isso desacopla a lógica central da IA das implementações específicas das ferramentas que ela usa, tornando os sistemas de IA mais modulares, escaláveis e interoperáveis.

O protocolo define vários tipos de recursos que um servidor pode oferecer. Um cliente MCP pode suportar alguns ou todos esses recursos, dependendo de sua finalidade. Compreender esses recursos é fundamental para entender o que uma integração MCP possibilita.

| Recurso | Descrição |

|---|---|

| Ferramentas | Funções executáveis que um LLM pode invocar para realizar ações. |

| Prompts | Modelos predefinidos para estruturar interações com o LLM. |

| Recursos | Dados e conteúdo expostos pelo servidor que um LLM pode ler. |

| Descoberta | A capacidade de ser notificado quando as capacidades de um servidor mudam. |

| Instruções | Orientações fornecidas pelo servidor sobre como o LLM deve se comportar. |

| Amostragem | Conclusões de LLM iniciadas pelo servidor e sugestões de parâmetros. |

| Raízes | Definições de limites do sistema de arquivos para as operações do LLM. |

| Elicitação | Um mecanismo para o servidor solicitar informações do usuário. |

| Tarefas | Uma forma de rastrear o status de operações de longa duração. |

| Aplicativos | Interfaces HTML interativas fornecidas pelo servidor. |

Ao suportar esses recursos, diferentes aplicativos podem aproveitar o mesmo conjunto de ferramentas externas e fontes de dados de maneira consistente, promovendo um ecossistema mais rico de serviços de IA interconectados.

Um Guia para Clientes MCP

Um Cliente MCP é qualquer aplicativo que pode se conectar a um Servidor MCP para consumir os recursos que ele oferece. Esses clientes atuam como a ponte entre o usuário, o LLM e o vasto mundo de capacidades externas. Eles podem variar de ferramentas focadas em desenvolvedores, como editores de código e interfaces de linha de comando, a aplicativos de desktop amigáveis ao usuário e plataformas no-code.

A função principal de um cliente é gerenciar a conexão a um ou mais servidores MCP e integrar as Ferramentas, Prompts e Recursos descobertos em sua própria experiência de usuário. Por exemplo, um assistente de codificação pode usar o MCP para encontrar e executar uma ferramenta que executa testes, enquanto um chatbot poderia usá-lo para puxar dados da base de conhecimento interna de uma empresa via um Recurso.

O crescimento do ecossistema MCP levou a uma gama diversa de clientes, cada um adaptado a diferentes fluxos de trabalho e casos de uso. Explorar alguns dos principais clientes pode fornecer uma imagem mais clara de como este protocolo está sendo implementado na prática para construir aplicativos de IA mais poderosos e cientes do contexto.

Os 10 Principais Clientes MCP

Os seguintes clientes demonstram a amplitude da adoção do MCP, desde produtos comerciais amplamente utilizados a projetos inovadores de código aberto. Cada um oferece uma maneira única de interagir com o crescente ecossistema de servidores MCP.

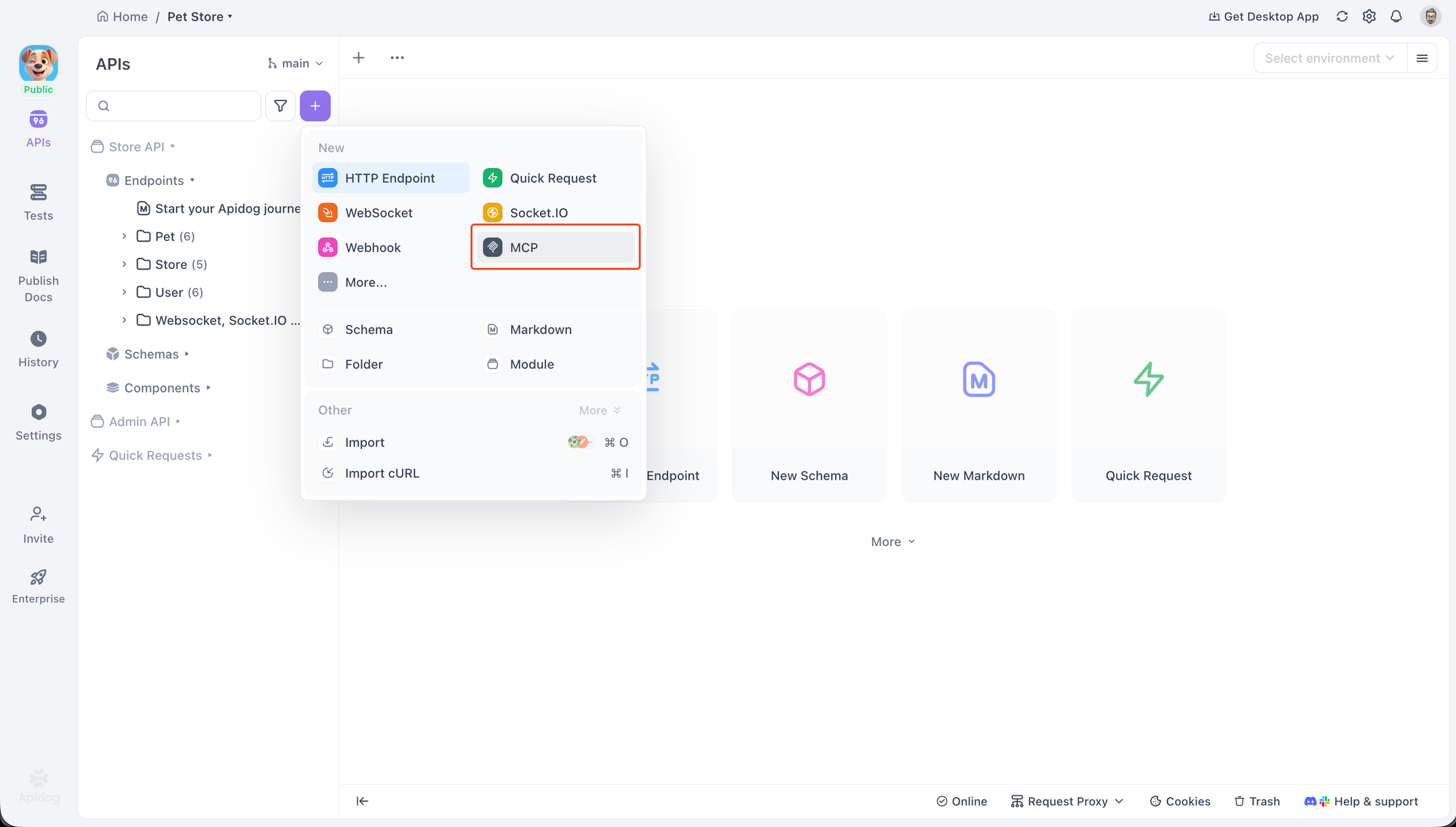

Cliente MCP Apidog

Apidog é uma plataforma abrangente de desenvolvimento de API que inclui um Cliente MCP integrado para depuração e teste de servidores MCP. Isso o torna uma excelente ferramenta para desenvolvedores que estão construindo ou integrando com MCP, pois fornece uma interface dedicada para interagir com todos os principais recursos do MCP.

O cliente suporta dois métodos principais de transporte para se conectar a servidores: STDIO para processos locais e HTTP para servidores remotos. Essa flexibilidade permite que os desenvolvedores testem uma ampla variedade de configurações de servidor.

Para começar, uma nova requisição MCP pode ser criada dentro de um projeto Apidog. Conectar a um servidor é simples. Basta colar um comando usado para iniciar um servidor local. Por exemplo, para conectar a um servidor de exemplo, você pode usar um comando como este:

npx -y @modelcontextprotocol/server-everything

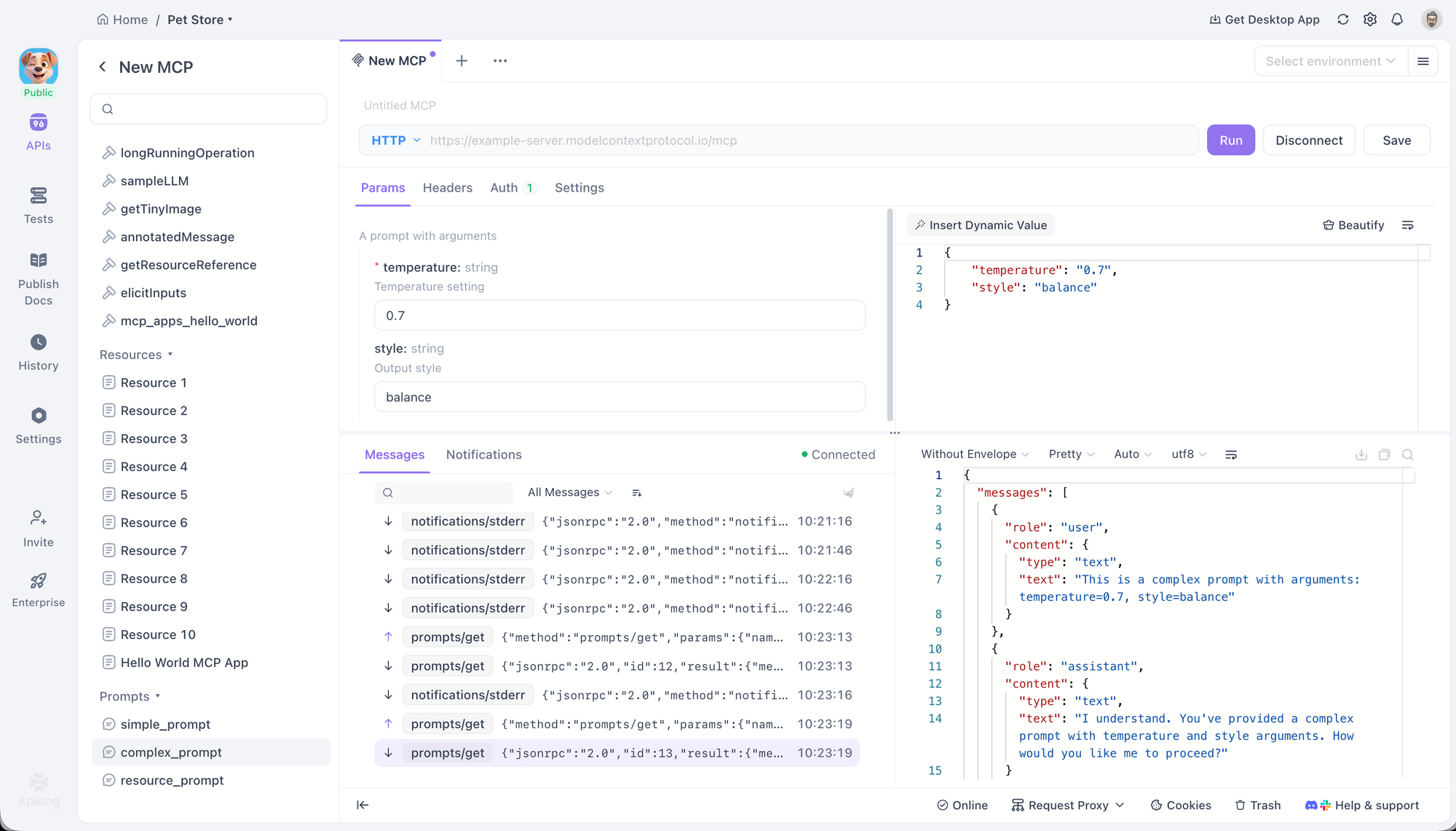

Apidog reconhecerá isso como um comando, selecionará automaticamente o protocolo STDIO e solicitará confirmação de segurança antes de iniciar o processo local. Para servidores remotos, colar uma URL mudará o protocolo para HTTP.

Uma vez conectado, Apidog exibe uma árvore de diretórios de todas as Ferramentas, Prompts e Recursos fornecidos pelo servidor. Isso permite interação direta e depuração. Os usuários podem selecionar uma Ferramenta, preencher seus parâmetros usando um formulário ou um editor JSON, e executá-la para ver a resposta. Da mesma forma, os Prompts podem ser executados para visualizar a saída gerada, e os Recursos podem ser buscados para inspecionar seu conteúdo.

O cliente também oferece opções de configuração avançadas. Para conexões HTTP, ele suporta vários métodos de autenticação, incluindo OAuth 2.0, Chaves de API e Tokens Bearer, e pode lidar automaticamente com o fluxo OAuth 2.0. Cabeçalhos personalizados e variáveis de ambiente também podem ser definidos, com suporte total ao sistema de variáveis do Apidog.

ChatGPT

Como o principal assistente de IA da OpenAI, a integração do MCP pelo ChatGPT é um indicador significativo da crescente importância do protocolo. Ele suporta a conexão a servidores MCP remotos, permitindo-lhe aproveitar ferramentas externas para realizar pesquisas aprofundadas e acessar funcionalidades especializadas.

A integração é gerenciada através da interface de conexões nas configurações do ChatGPT. Uma vez configurado um servidor, suas ferramentas ficam disponíveis para o modelo. Isso permite que o ChatGPT vá além de suas capacidades embutidas, usando ferramentas de servidores configurados para realizar tarefas como pesquisar bancos de dados proprietários ou interagir com APIs de terceiros de maneira padronizada. Este suporte é particularmente valioso em ambientes empresariais onde segurança e conformidade são primordiais.

O Ecossistema Claude

A Anthropic integrou profundamente o MCP em seu conjunto de produtos, incluindo seu assistente web claude.ai, o Aplicativo de Desktop Claude e a ferramenta de codificação agentic Claude Code. Este suporte multifacetado demonstra diferentes aspectos do padrão MCP.

claude.ai suporta servidores MCP remotos, permitindo que usuários web conectem suas conversas com Claude a ferramentas externas, prompts e recursos.

O Aplicativo de Desktop Claude vai além, permitindo conexões a servidores locais, o que melhora a privacidade e a segurança ao manter os dados na máquina do usuário. Ele tem suporte total para Recursos, Prompts, Ferramentas e até mesmo Aplicativos interativos.

Claude Code é um exemplo poderoso de integração bidirecional. Ele atua como um cliente MCP, consumindo Ferramentas, Prompts e Recursos de outros servidores para auxiliar em suas tarefas de codificação. Simultaneamente, ele também funciona como um servidor MCP, expondo suas próprias capacidades a outros clientes MCP.

Agente de Codificação GitHub Copilot

O GitHub Copilot, o assistente de codificação de IA mais amplamente adotado, aproveita o MCP para aumentar seu contexto e capacidades. O agente de codificação Copilot pode delegar tarefas e interagir com servidores MCP locais e remotos para usar ferramentas externas.

Esta integração permite que os desenvolvedores adaptem o Copilot às suas necessidades específicas de projeto. Por exemplo, um desenvolvedor pode conectar o Copilot a um servidor MCP interno que fornece ferramentas para interagir com um sistema de build proprietário ou um banco de dados específico do projeto. Isso estende a consciência do Copilot além do próprio código, permitindo-lhe realizar tarefas de desenvolvimento mais complexas e cientes do contexto.

Cursor

Cursor é um editor de código focado em IA, projetado desde o início para o desenvolvimento impulsionado por IA. Seu suporte nativo para MCP é uma parte central de sua arquitetura, permitindo uma profunda integração com o fluxo de trabalho de um desenvolvedor.

O editor suporta Ferramentas MCP através de seu recurso Composer, permitindo que os usuários invoquem funções externas diretamente durante a codificação. Ele também suporta Prompts, Raízes e Elicitação, o que lhe permite ter sessões mais complexas e interativas com servidores. Cursor pode se conectar a servidores via STDIO e SSE, oferecendo flexibilidade para conjuntos de ferramentas locais e remotos.

LM Studio

LM Studio é um aplicativo de desktop popular que facilita a descoberta, o download e a execução de LLMs de código aberto localmente. Sua principal contribuição para o ecossistema MCP é sua capacidade de conectar esses modelos locais a servidores MCP.

Isso preenche a lacuna entre o mundo dos modelos de código aberto e o uso padronizado de ferramentas fornecido pelo MCP. Os usuários podem adicionar configurações de servidor a um arquivo mcp.json local para começar. Um recurso de destaque é sua interface de usuário de confirmação de ferramenta, que solicita a aprovação do usuário antes que um modelo local possa executar uma chamada de ferramenta, fornecendo uma importante camada de segurança e controle.

Amazon Q

O assistente com IA da Amazon, Amazon Q, adotou o MCP em suas versões de linha de comando (Amazon Q CLI) e IDE (Amazon Q IDE). Isso demonstra a utilidade do protocolo em ambientes de desenvolvimento profissional para gerenciar a infraestrutura em nuvem e otimizar as tarefas de codificação.

O Amazon Q CLI é um assistente de codificação agentic para o terminal que oferece suporte total para servidores MCP. Ele permite que os usuários acessem ferramentas e prompts salvos diretamente de sua linha de comando.

O Amazon Q IDE, disponível para IDEs importantes como VS Code e JetBrains, traz capacidades semelhantes para uma interface gráfica. Ele permite aos usuários controlar e organizar recursos AWS e gerenciar permissões para cada ferramenta MCP através da interface do usuário do IDE, oferecendo controle granular sobre as capacidades do assistente.

AIQL TUUI

AIQL TUUI é um aplicativo de chat de IA para desktop gratuito e de código aberto que se destaca pelo seu suporte abrangente ao padrão MCP e sua natureza multiplataforma. Funciona em macOS, Windows e Linux e suporta uma ampla gama de provedores de IA e modelos locais.

Sua integração MCP é extensa, cobrindo Recursos, Prompts, Ferramentas, Descoberta, Amostragem e Elicitação. Isso permite uma experiência rica e interativa onde os usuários podem alternar perfeitamente entre diferentes LLMs e agentes. O aplicativo oferece controle avançado sobre os parâmetros de amostragem e permite a personalização de ferramentas, tornando-o uma escolha poderosa para usuários avançados e desenvolvedores que desejam um cliente altamente configurável.

Langflow

Langflow é um construtor visual de código aberto para criar aplicativos de IA. Sua posição única no ecossistema MCP é seu duplo papel como cliente e servidor, facilitado por uma interface gráfica baseada em fluxo.

Como cliente MCP, Langflow pode usar ferramentas de qualquer servidor MCP para construir agentes e fluxos de trabalho. Isso permite que os usuários arrastem e soltem nós que representam ferramentas MCP em seus fluxos, tornando integrações complexas mais acessíveis.

Inversamente, os usuários também podem exportar seus agentes e fluxos criados como um servidor MCP completo. Este recurso poderoso permite que os desenvolvedores prototipem visualmente um conjunto de ferramentas e, em seguida, as exponham a outros clientes MCP, reduzindo drasticamente a barreira para criar e compartilhar capacidades de IA personalizadas.

AgenticFlow

AgenticFlow segmenta um público diferente, fornecendo uma plataforma de IA no-code para construir agentes que lidam com tarefas de vendas, marketing e criativas. Ele usa o MCP como protocolo subjacente para se conectar com segurança a uma vasta biblioteca de mais de 10.000 ferramentas e 2.500 APIs.

A plataforma simplifica o processo de conexão a um servidor MCP em apenas algumas etapas, abstraindo os detalhes técnicos. Isso permite que não-desenvolvedores construam agentes de IA poderosos que podem interagir com uma ampla gama de serviços externos. Os usuários podem gerenciar suas conexões com segurança e revogar o acesso a qualquer momento, tornando-o um ponto de entrada seguro e acessível no mundo do uso de ferramentas de IA.

Conclusão

O Protocolo de Contexto de Modelo está rapidamente se tornando uma camada fundamental de como os sistemas de IA interagem com o mundo exterior. Ao padronizar a forma como os LLMs descobrem e usam ferramentas, prompts e fontes de dados, o MCP remove o acoplamento rígido entre modelos e serviços e o substitui por uma arquitetura limpa, modular e interoperável. Essa mudança torna os aplicativos de IA mais fáceis de estender, mais seguros de operar e muito mais adaptáveis aos fluxos de trabalho do mundo real.

Como mostra a crescente lista de clientes MCP, o protocolo já está sendo adotado em um amplo espectro de casos de uso — desde ferramentas de desenvolvedor como Apidog, Cursor e GitHub Copilot, a assistentes empresariais como ChatGPT e Amazon Q, e até mesmo plataformas no-code como Langflow e AgenticFlow. Cada cliente aplica o MCP de forma diferente, mas todos se beneficiam da mesma promessa central: reuso, flexibilidade e integração consistente de ferramentas.

Olhando para o futuro, o valor real do MCP reside no ecossistema que ele possibilita. À medida que mais servidores expõem ferramentas de alta qualidade e mais clientes adotam o protocolo, desenvolvedores e usuários ganham a liberdade de misturar modelos, ferramentas e fluxos de trabalho sem reconstruir integrações do zero. Seja você depurando um servidor MCP, construindo um assistente de codificação agentic ou projetando fluxos de trabalho de IA visualmente, o MCP oferece um terreno comum que permite que a inovação seja escalável.