Dados impulsionam decisões de negócios modernas, mas apenas quando são precisos, completos e oportunos. O Teste ELT garante que os dados fluindo através de seus pipelines — seja para data lakes, warehouses ou plataformas de análise — atendam aos padrões especificados. ELT (Extração, Carregamento, Transformação) tornou-se o padrão dominante para a integração de dados moderna, mas muitas equipes lutam para testá-lo eficazmente. Este guia fornece uma estrutura prática para validar pipelines ELT em todas as etapas.

botão

O que é ELT e Como Ele Difere do ETL

O ELT (Extrair, Carregar, Transformar) inverte a sequência tradicional do ETL. Em vez de transformar os dados antes de carregar, você extrai dados brutos dos sistemas de origem, carrega-os diretamente em seu destino (data lake ou warehouse) e, em seguida, os transforma no local usando o poder computacional do destino.

| Etapa | Padrão ETL | Padrão ELT |

|---|---|---|

| Extração | Extrair dados das fontes | Extrair dados das fontes |

| Transformação | Limpar/modificar no staging | Ocorre no sistema de destino |

| Carregamento | Enviar dados transformados | Enviar dados brutos primeiro |

O Teste ELT deve validar cada etapa: completude da extração, integridade do carregamento e precisão da transformação — tudo isso enquanto garante desempenho e qualidade dos dados.

Por que o Teste ELT Importa: O Impacto nos Negócios

Pipelines ELT mal testados criam problemas em cascata:

- Corrupção de Dados: Um único bug de transformação pode propagar métricas incorretas para painéis executivos, levando a decisões equivocadas de milhões de dólares.

- Risco de Conformidade: GDPR e HIPAA exigem que você comprove a linhagem e a precisão dos dados. O Teste ELT fornece trilhas de auditoria.

- Degradação de Desempenho: Pipelines não testados que processam terabytes diariamente podem desacelerar silenciosamente, perdendo janelas de SLA.

- Erosão da Confiança: Quando as equipes de negócios descobrem problemas de qualidade de dados, elas param de confiar totalmente na plataforma de análise.

Uma empresa de varejo descobriu uma vez que 15% de seus dados de vendas estavam faltando nos relatórios porque uma falha no Teste ELT não conseguiu identificar uma mudança de esquema em seu sistema de origem. O impacto: planejamento de estoque incorreto e falta de produtos durante a alta temporada.

Como o Teste ELT é Realizado: Uma Abordagem Fase a Fase

O Teste ELT acompanha a jornada dos dados da origem ao consumo. Veja como validar cada fase:

Fase 1: Teste de Extração

Verifique se os dados são extraídos de forma completa e precisa dos sistemas de origem.

Casos de Teste:

- Completude: Contagem de registros extraídos vs. sistema de origem

- Validação de Esquema: Garanta que o esquema da origem não mudou inesperadamente

- Correção do Tipo de Dado: Números permanecem números, datas permanecem datas

- Extração Incremental: Apenas registros novos/alterados são extraídos

# Teste de completude da extração

def test_extraction_completeness():

source_count = source_db.query("SELECT COUNT(*) FROM orders WHERE date = '2024-01-01'")

extracted_count = staging_area.query("SELECT COUNT(*) FROM raw_orders WHERE date = '2024-01-01'")

assert extracted_count == source_count, f"Missing {source_count - extracted_count} records"

Fase 2: Teste de Carregamento

Valide se os dados brutos chegam corretamente ao sistema de destino sem corrupção.

Casos de Teste:

- Sucesso do Carregamento: Todos os registros extraídos são carregados

- Integridade dos Dados: Sem truncamento, problemas de codificação ou corrupção

- Particionamento: Os dados chegam nas partições/buckets corretos

- Detecção de Duplicatas: Nenhum registro duplicado introduzido

-- Teste de integridade do carregamento

SELECT

source_table,

COUNT(*) as loaded_records,

SUM(CASE WHEN loaded_at IS NULL THEN 1 ELSE 0 END) as failed_records

FROM raw_data_audit

WHERE load_date = CURRENT_DATE

GROUP BY source_table

HAVING failed_records > 0;

Fase 3: Teste de Transformação

Verifique se a lógica de negócios transforma corretamente os dados brutos em um formato pronto para análise.

Casos de Teste:

- Precisão da Regra de Negócio: Cálculos correspondem às especificações

- Integridade Referencial: Chaves estrangeiras resolvem corretamente

- Qualidade dos Dados: Tratamento de nulos, valores padrão, limpeza

- Lógica de Agregação: Somas, contagens, médias são matematicamente corretas

-- Teste de precisão da transformação

SELECT

order_id,

raw_amount,

calculated_tax,

(raw_amount * 0.08) as expected_tax

FROM transformed_orders

WHERE ABS(calculated_tax - (raw_amount * 0.08)) > 0.01

Fase 4: Validação de Ponta a Ponta

Execute todo o pipeline e valide os resultados finais em relação às expectativas de negócios.

Casos de Teste:

- Precisão do Relatório: Os painéis finais mostram os KPIs corretos

- Reconciliação: Totais agregados correspondem ao sistema de origem

- Linha do Tempo: A atualidade dos dados atende ao SLA (ex: dentro de 2 horas)

- Impacto a Jusante: Ferramentas de BI podem consultar dados transformados sem erros

Teste ELT vs Teste de Dados Tradicional

O Teste ELT difere do teste de data warehouse tradicional em aspectos-chave:

| Aspecto | Teste ETL Tradicional | Teste ELT |

|---|---|---|

| Local do Teste | Camada de staging | Sistema de destino (Snowflake, BigQuery) |

| Foco no Desempenho | Motor de transformação | Eficiência de computação do destino |

| Mudanças de Esquema | Tratado na ferramenta ETL | Testado no sistema de destino |

| Ferramentas | Testadores nativos de ETL | Ferramentas baseadas em SQL + API |

O Teste ELT moderno exige que você valide as transformações SQL dentro de data warehouses na nuvem, monitore os endpoints de ingestão de dados da API e rastreie a linhagem dos dados em arquiteturas de schema-on-read.

Ferramentas para Teste ELT

Teste Baseado em SQL:

- dbt (ferramenta de construção de dados) com testes integrados

- Great Expectations para qualidade de dados

- scripts SQL personalizados no data warehouse de destino

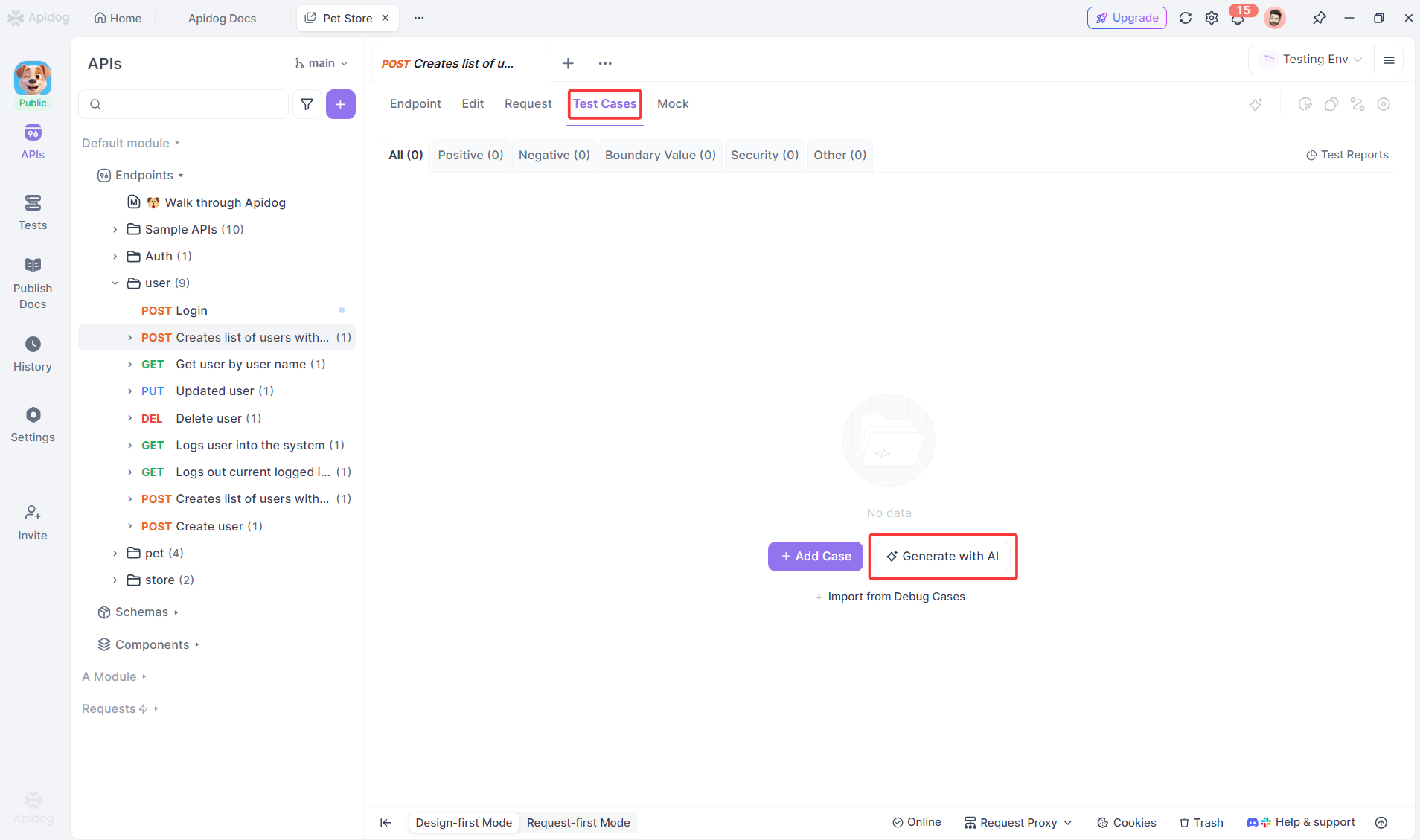

Teste Baseado em API (Crítico para ELT):

- Apidog para validação de API de ingestão e verificações ad-hoc de API

- scripts personalizados para monitoramento de webhook

botão

Teste de Orquestração:

- Validação de tarefas do Apache Airflow

- Teste de fluxo do Prefect

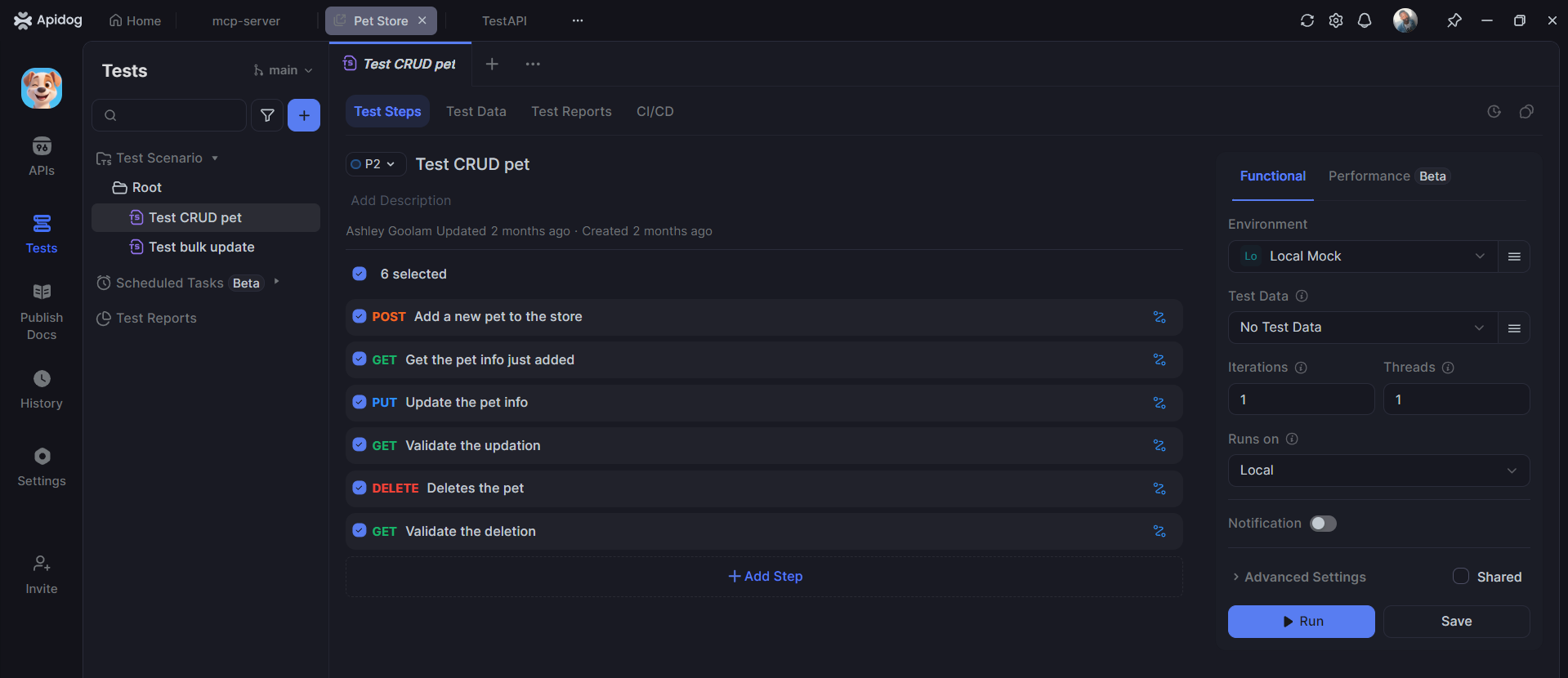

Como o Apidog Ajuda no Teste ELT

Enquanto as ferramentas SQL lidam com transformações, o Apidog se destaca no teste da camada de API de pipelines ELT — fundamental para a ingestão e monitoramento de dados modernos.

Testando APIs de Ingestão de Dados

A maioria dos pipelines ELT usa APIs para extrair dados. O Apidog automatiza a validação desses endpoints:

# Teste Apidog para API de ingestão de dados

Test: POST /api/v1/extract/orders

Given: Chave API válida e intervalo de datas

When: Solicitação enviada com parâmetros {"start_date": "2024-01-01", "end_date": "2024-01-31"}

Test 1: Status de resposta 202 (aceito para processamento)

Test 2: Resposta contém job_id para rastreamento

Test 3: Notificação de webhook recebida em 5 minutos

Test 4: Dados aparecem na tabela de staging

Vantagens do Apidog para Teste ELT:

- Geração automática de testes a partir de especificações OpenAPI

- Construtor visual de fluxo de trabalho para pipelines complexos

- Gerenciamento de ambiente para data warehouses de dev/staging/prod

- Integração CI/CD para executar verificações de qualidade de dados conforme agendado

- Registro detalhado (logging) para trilhas de auditoria

Melhores Práticas para Teste ELT

- Testar incrementalmente: Validar extração antes do carregamento, carregamento antes da transformação

- Monitorar continuamente: Executar verificações de qualidade de dados a cada hora, não apenas uma vez

- Controlar versões dos testes: Armazenar testes SQL no Git junto com o código de transformação

- Testar em ambiente semelhante ao de produção: Usar volume de dados de produção no ambiente de staging

- Automatizar a reconciliação: Comparar contagens de origem e destino automaticamente

- Alertar sobre anomalias: Notificar quando as contagens de linhas desviarem >5% da média histórica

- Documentar a linhagem dos dados: Rastrear como cada campo se transforma do bruto ao final

Perguntas Frequentes

P1: Com que frequência devemos executar testes ELT?

Resp: Testes de extração são executados a cada execução de pipeline. Testes de qualidade de dados são executados continuamente (a cada hora). A validação completa de ponta a ponta é executada pelo menos uma vez por dia.

P2: Quem é responsável pelo Teste ELT — engenheiros de dados ou QA?

Resp: Engenheiros de dados são responsáveis pelos testes porque entendem as transformações. QA fornece estruturas e valida os resultados da lógica de negócios.

P3: O Apidog pode substituir o teste ELT baseado em SQL?

Resp: Não. O Apidog complementa o teste SQL validando a camada de API (ingestão, monitoramento, orquestração). Você ainda precisa de testes SQL para transformações dentro do warehouse.

P4: Como testamos pipelines ELT que processam terabytes de dados?

Resp: Teste em uma amostra estatisticamente significativa (ex: 1% dos dados) em vez do volume total. Use o perfil de dados para verificar se as distribuições correspondem às expectativas.

P5: Qual é o teste ELT mais crítico para implementar primeiro?

Resp: Reconciliação de contagem de linhas de ponta a ponta. Se as contagens de registros de origem e destino não corresponderem, nada mais importa. Este teste detecta a maioria das falhas de pipeline.

Conclusão

O Teste ELT é inegociável para organizações orientadas por dados. Ao contrário dos testes de software tradicionais, onde bugs afetam funcionalidades, bugs em pipelines de dados afetam decisões de negócios, conformidade e receita. Uma abordagem sistemática — testando extração, carregamento, transformação e fluxos de ponta a ponta — previne a corrupção de dados cara e constrói confiança em sua plataforma de análise.

Pipelines ELT modernos dependem fortemente de APIs para ingestão e monitoramento. O Apidog automatiza o trabalho tedioso de testar essas APIs, permitindo que os engenheiros de dados se concentrem na lógica de transformação, enquanto garantem que os pontos de entrada e saída do pipeline sejam validados continuamente. A combinação de testes de transformação baseados em SQL e a automação de API do Apidog cria uma rede de segurança abrangente para seu ativo de negócios mais crítico: os dados.

Comece com o teste de reconciliação. Adicione verificações de qualidade de dados. Automatize a validação da API. Seu futuro eu — e seus stakeholders de negócios — agradecerão quando a apresentação da diretoria mostrar números precisos.

botão