Uma equipe confiou pesadamente na IA para gerar seu código de aplicação — uma prática agora chamada de "vibe coding". Uma semana após a implantação, o servidor foi comprometido. O desenvolvedor que compartilhou este incidente pôde adivinhar imediatamente o vetor de ataque porque as vulnerabilidades eram previsíveis. Este artigo detalha o que deu errado, por que o código gerado por IA é unicamente vulnerável a exploits de segurança e fornece um checklist concreto para proteger projetos assistidos por IA antes que cheguem à produção.

O Incidente: O Que Aconteceu

A história surgiu na comunidade r/webdev do Reddit em janeiro de 2026, rapidamente ganhando mais de 400 upvotes e gerando intensa discussão. Um desenvolvedor compartilhou o que aconteceu em sua empresa quando dois colegas adotaram o "vibe coding" — a prática de construir aplicativos rapidamente usando ferramentas de geração de código por IA como ChatGPT, Claude ou Cursor com revisão manual mínima.

A equipe estava animada. Eles entregaram rápido. A IA cuidava de tudo, desde consultas a bancos de dados até fluxos de autenticação. Quando chegou a hora da implantação, a IA até sugeriu o número de versão "16.0.0" para o primeiro lançamento — um detalhe que mais tarde pareceria ironicamente sombrio.

Uma semana após a implantação, o servidor foi invadido.

O desenvolvedor que contou a história não ficou surpreso. Ao analisar o código-fonte, ele pôde identificar imediatamente várias vulnerabilidades de segurança que a IA havia introduzido. Os atacantes também as encontraram.

Este não é um incidente isolado. Pesquisadores de segurança têm alertado sobre o que chamam de "vulnerabilidades sintéticas" — falhas de segurança que aparecem quase exclusivamente em códigos gerados por IA devido à forma como os modelos de linguagem são treinados e como abordam as tarefas de codificação.

Por Que o Código Gerado por IA é Vulnerável

Assistentes de codificação de IA são treinados em vastos repositórios de código público. Isso cria vários pontos cegos de segurança:

1. Dados de Treinamento Incluem Código Vulnerável

GitHub, Stack Overflow e sites de tutoriais contêm milhões de linhas de código inseguro. Exemplos escritos para fins de aprendizado frequentemente ignoram considerações de segurança. Padrões obsoletos permanecem nos dados de treinamento. A IA aprende com tudo isso igualmente.

Quando você pede a uma IA para escrever código de autenticação, ela pode reproduzir um padrão de um tutorial de 2018 que não tinha proteção CSRF, ou uma resposta do Stack Overflow que armazenava senhas em texto simples por simplicidade.

2. A IA Otimiza para "Funciona", Não para "Seguro"

Modelos de linguagem geram código que satisfaz a solicitação. Se você pedir um endpoint de login, a IA cria algo que faz os usuários logarem. Se essa implementação resiste a injeção de SQL, faz hash de senhas corretamente ou valida tokens de sessão é secundário ao objetivo principal.

Isso é fundamentalmente diferente de como desenvolvedores experientes pensam. Desenvolvedores conscientes da segurança perguntam "como isso pode ser explorado?" a cada passo. Assistentes de IA não aplicam naturalmente essa mentalidade adversária.

3. Limitações da Janela de Contexto Impedem Segurança Holística

Vulnerabilidades de segurança frequentemente surgem de interações entre componentes. Uma verificação de autenticação pode existir em um arquivo, enquanto uma consulta de banco de dados em outro arquivo assume que a autenticação já ocorreu. A IA, ao gerar código arquivo por arquivo ou função por função, nem sempre consegue manter esse contexto de segurança.

4. Desenvolvedores Confiam Demais na Saída da IA

Este é o fator humano. Quando o código vem de uma IA que parece confiante e competente, os desenvolvedores frequentemente pulam a revisão cuidadosa que aplicariam a um código de um membro júnior da equipe. A abordagem de "vibe coding" explicitamente abraça isso: gere rápido, entregue rápido, corrija depois.

O problema é que vulnerabilidades de segurança muitas vezes não podem ser "corrigidas depois" quando os atacantes as encontram primeiro.

Os 7 Buracos de Segurança Mais Comuns em APIs Geradas por IA

Com base na análise de repositórios de código gerados por IA e auditorias de segurança, estas vulnerabilidades aparecem com mais frequência:

1. Validação de Entrada Ausente ou Fraca

Endpoints gerados por IA frequentemente aceitam entrada do usuário diretamente sem sanitização:

// Gerado por IA: Vulnerável a injeção

app.post('/search', (req, res) => {

const query = req.body.searchTerm;

db.query(`SELECT * FROM products WHERE name LIKE '%${query}%'`);

});

A correção exige consultas parametrizadas, limites de comprimento de entrada e validação de caracteres — etapas que a IA frequentemente omite.

2. Fluxos de Autenticação Quebrados

Problemas comuns incluem:

- Tokens armazenados em localStorage em vez de cookies httpOnly

- Expiração de token ausente

- IDs de sessão fracos ou previsíveis

- Sem limitação de taxa em tentativas de login

- Tokens de redefinição de senha que não expiram

3. Exposição Excessiva de Dados

A IA tende a retornar objetos de banco de dados completos em vez de selecionar campos específicos:

// Gerado por IA: Retorna campos sensíveis

app.get('/user/:id', (req, res) => {

const user = await User.findById(req.params.id);

res.json(user); // Inclui passwordHash, internalNotes, etc.

});

4. Verificações de Autorização Ausentes

A IA cria endpoints que funcionam, mas esquece de verificar se o usuário solicitante tem permissão:

// Gerado por IA: Sem verificação de propriedade

app.delete('/posts/:id', async (req, res) => {

await Post.deleteOne({ _id: req.params.id });

res.json({ success: true });

});

// Qualquer usuário autenticado pode excluir qualquer post

5. Dependências Inseguras

A IA frequentemente sugere pacotes populares sem verificar vulnerabilidades conhecidas:

// A IA sugere pacote desatualizado com CVEs

const jwt = require('jsonwebtoken'); // Versão não especificada

Sem a fixação explícita de versões e a varredura de vulnerabilidades, os projetos herdam débitos de segurança desde o primeiro dia.

6. Segredos e Credenciais Hardcoded

Isso aparece surpreendentemente frequentemente em códigos gerados por IA:

// Gerado por IA: Segredo no código-fonte

const stripe = require('stripe')('sk_live_abc123...');

A IA aprende com tutoriais e exemplos onde chaves hardcoded são comuns para fins de ilustração.

7. Cabeçalhos de Segurança Ausentes

Aplicativos Express, Flask ou Rails gerados por IA geralmente não possuem:

- Configuração CORS (ou CORS excessivamente permissivo)

- Cabeçalhos Content-Security-Policy

- X-Frame-Options

- Middleware de limitação de taxa

- Imposição de HTTPS

Um Checklist de Teste de Segurança para Projetos Assistidos por IA

Antes de implantar qualquer projeto com código gerado por IA, siga este checklist:

Autenticação e Autorização

- [ ] Todos os endpoints exigem autenticação onde apropriado

- [ ] As verificações de autorização verificam se o usuário possui/pode acessar os recursos solicitados

- [ ] As senhas são hash com bcrypt, Argon2 ou similar (fator de custo ≥10)

- [ ] Os tokens de sessão são criptograficamente aleatórios e expiram

- [ ] As tentativas de login falhas são limitadas por taxa

- [ ] Os tokens de redefinição de senha são de uso único e com tempo limitado

- [ ] Os JWTs incluem expiração e são validados no lado do servidor

Validação de Entrada

- [ ] Todas as entradas do usuário são validadas quanto ao tipo, comprimento e formato

- [ ] As consultas ao banco de dados usam instruções parametrizadas

- [ ] Os uploads de arquivos validam tipo, tamanho e verificam malware

- [ ] URLs e redirecionamentos são validados contra listas de permissão

- [ ] Os parsers JSON/XML têm limites de tamanho configurados

Proteção de Dados

- [ ] As respostas da API retornam apenas os campos necessários

- [ ] Dados sensíveis são criptografados em repouso

- [ ] As credenciais do banco de dados usam variáveis de ambiente, não código

- [ ] Os segredos são armazenados em sistemas de gerenciamento de segredos adequados

- [ ] Os logs não contêm senhas, tokens ou PII

Segurança de Transporte

- [ ] HTTPS é imposto em produção

- [ ] Os cabeçalhos HSTS estão configurados

- [ ] TLS 1.2+ é necessário

- [ ] Cookies seguros têm as flags Secure e HttpOnly

Segurança Específica da API

- [ ] A limitação de taxa evita abusos

- [ ] CORS é configurado para origens específicas, não

* - [ ] O versionamento da API permite descontinuar endpoints inseguros

- [ ] As mensagens de erro não vazam detalhes internos

- [ ] GraphQL tem limites de profundidade/complexidade de consulta

Dependências

- [ ] Todos os pacotes têm fixação de versão específica

- [ ]

npm audit/pip check/ similar não mostra vulnerabilidades críticas - [ ] As atualizações automatizadas de dependências estão configuradas

- [ ] Nenhum pacote está abandonado ou sem manutenção

Como Testar a Segurança da Sua API Antes da Implantação

A revisão manual não é suficiente. Você precisa de testes sistemáticos que capturem as vulnerabilidades que a IA introduziu e que sua revisão perdeu.

Passo 1: Varredura de Segurança Automatizada

Use ferramentas projetadas para encontrar vulnerabilidades comuns:

# Para projetos Node.js

npm audit --audit-level=high

# Para projetos Python

pip-audit

# Para imagens de container

trivy image your-app:latest

Passo 2: Teste de Segurança de API

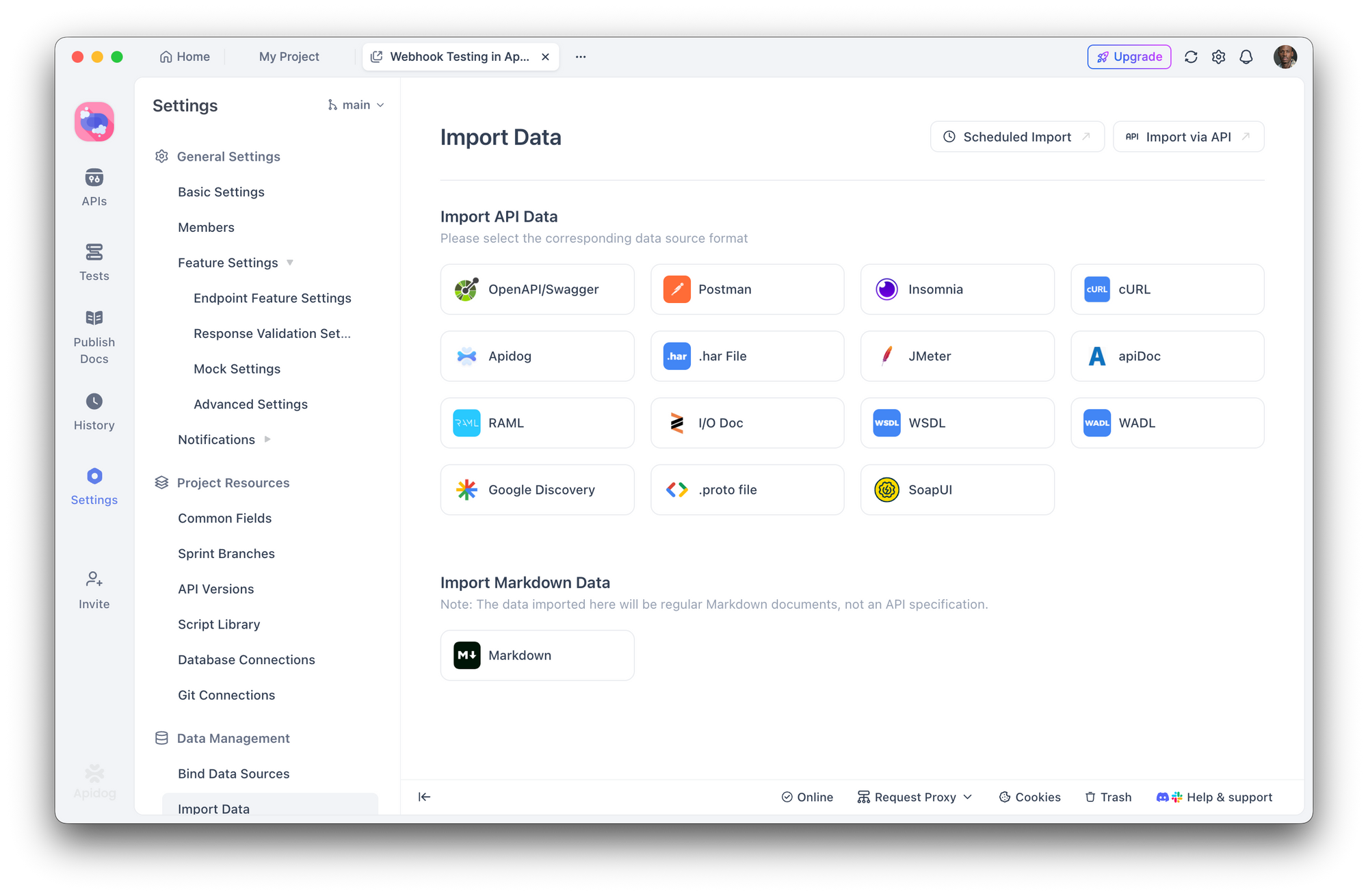

É aqui que o Apidog se torna essencial. Em vez de testar manualmente cada endpoint, você pode:

- Importar sua especificação de API (OpenAPI/Swagger) ou deixar o Apidog descobrir os endpoints

2. Criar cenários de teste de segurança que verificam:

- Autenticação ausente retorna 401

- Usuário errado acessando recursos retorna 403

- Entrada inválida retorna 400 com mensagens de erro seguras

- Tentativas de injeção de SQL são bloqueadas

- Executar suites de teste automatizadas antes de cada implantação

- Integrar com CI/CD para capturar regressões

Com o construtor de testes visuais do Apidog, você não precisa escrever testes de segurança do zero. Defina asserções como "a resposta não deve conter 'password'" ou "uma requisição sem token de autenticação deve retornar 401" e execute-as em toda a superfície da sua API.

Passo 3: Simulação de Teste de Penetração

Teste sua API como um atacante faria:

- Enumerar endpoints - Existem rotas ocultas ou não documentadas?

- Testar bypass de autenticação - Você pode acessar rotas protegidas sem tokens válidos?

- Tentar ataques de injeção - SQL, NoSQL, injeção de comando em todos os campos de entrada

- Verificar IDOR - O usuário A pode acessar os dados do usuário B alterando IDs?

- Abusar dos limites de taxa - O que acontece com 1000 requisições por segundo?

Os cenários de teste do Apidog permitem simular esses ataques sistematicamente, salvando os resultados para comparação entre as implantações.

Passo 4: Auditoria de Cabeçalhos de Segurança

Verifique seus cabeçalhos de resposta:

curl -I https://your-api.com/endpoint

Procure por:

Strict-Transport-SecurityX-Content-Type-Options: nosniffX-Frame-Options: DENYContent-Security-Policy

Construindo um Fluxo de Trabalho "Security-First" com Ferramentas de IA

Os assistentes de codificação de IA não vão desaparecer — eles estão se tornando mais poderosos. A solução não é evitá-los, mas construir a segurança em seu fluxo de trabalho.

Engenharia de Prompt para Segurança

Ao usar IA para gerar código, solicite explicitamente considerações de segurança:

Em vez de:

"Crie um endpoint de registro de usuário"

Pergunte:

"Crie um endpoint de registro de usuário com validação de entrada, hashing de senha usando bcrypt com fator de custo 12, proteção contra ataques de temporização, limitação de taxa e tratamento de erros adequado que não vaze informações sobre a existência de e-mails"

Etapas de Revisão Obrigatórias

Estabeleça um fluxo de trabalho onde o código gerado por IA deve passar por:

- Revisão humana - Este código faz o que pretendemos?

- Linting automatizado - ESLint, Pylint com plugins de segurança

- Varredura de segurança - Snyk, npm audit, OWASP dependency check

- Teste de API - Suites de teste Apidog validando requisitos de segurança

- Implantação em staging - Executar testes de integração em ambiente realista

Trate o Código de IA como Entrada Não Confiável

Esta é a principal mudança de mentalidade. O código de IA deve ser tratado com o mesmo ceticismo que o código de um colaborador desconhecido. Você implantaria código de um pull request aleatório sem revisão? Aplique o mesmo padrão ao código gerado por IA.

Conclusão

O ataque ao servidor que aconteceu uma semana após a implantação não foi causado por atacantes sofisticados ou exploits de dia zero. Foi causado por vulnerabilidades comuns que as ferramentas de IA rotineiramente introduzem e que as práticas de "vibe coding" rotineiramente ignoram.

A geração de código por IA é poderosa. Ela acelera o desenvolvimento e torna tarefas complexas acessíveis. Mas sem testes de segurança sistemáticos, essa velocidade se torna uma responsabilidade.

Ferramentas como o Apidog tornam os testes de segurança práticos, permitindo que você defina e automatize os requisitos de segurança em toda a superfície da sua API. O objetivo não é desacelerar o desenvolvimento assistido por IA — é construir a camada de verificação que o código gerado por IA exige.

Seu servidor não se importa se o código foi escrito por um humano ou por uma IA. Ele só se importa se esse código é seguro.