À medida que a IA se integra cada vez mais ao desenvolvimento e teste de APIs, a barreira de entrada para testes automatizados diminui constantemente. Tarefas que antes exigiam operações manuais repetitivas e preparação de dados agora podem ser realizadas pela IA. O Apidog também reflete essa mudança nos testes de API.

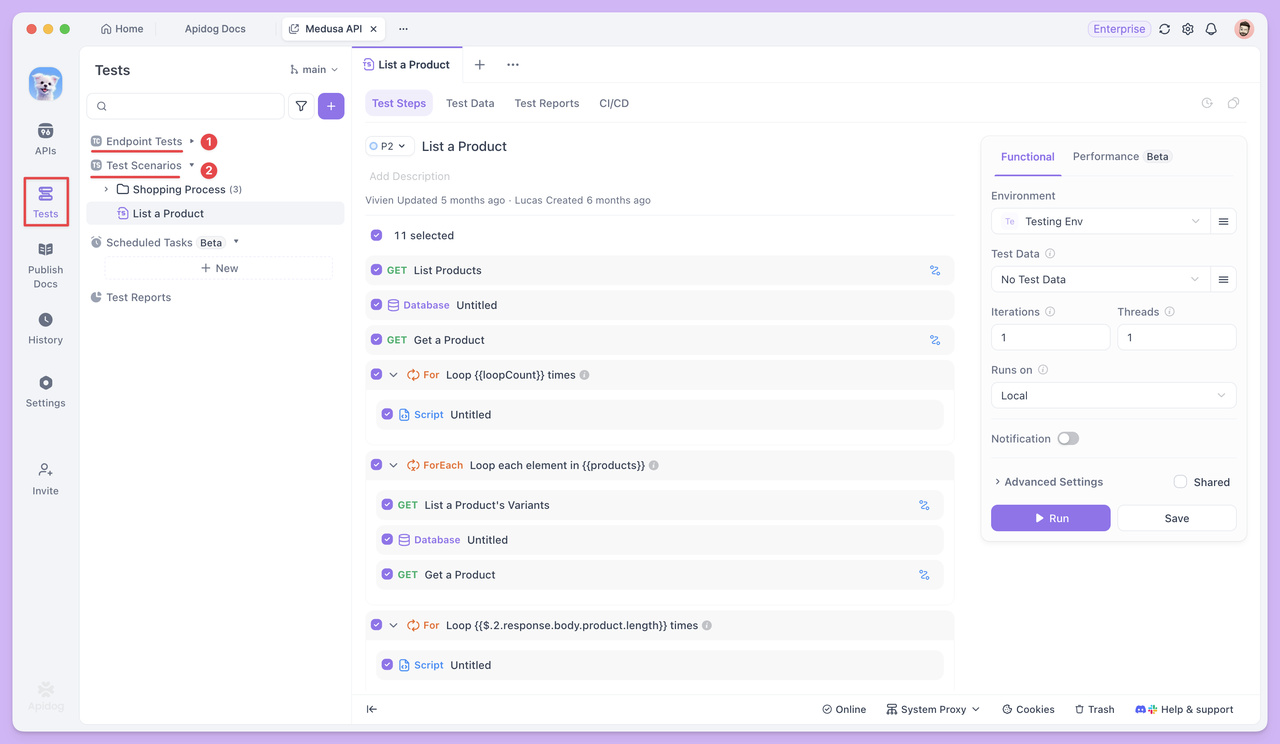

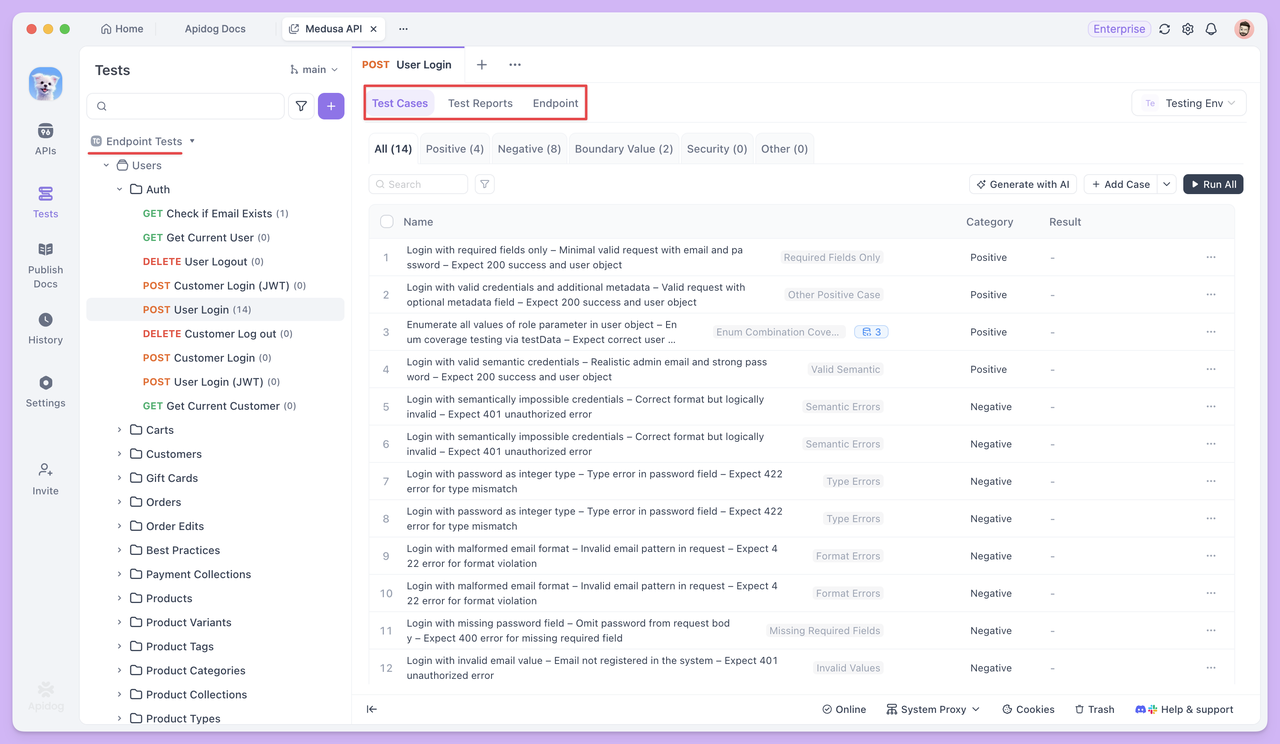

No Apidog, os testes automatizados giram principalmente em torno de duas abordagens: Testes de Endpoint e Cenários de Teste.

Se você não vir o módulo Teste de Endpoint, significa que sua versão do Apidog está desatualizada. Basta atualizar para a versão mais recente.

O módulo Testes de Endpoint exibe todos os endpoints HTTP das suas APIs, tornando os desenvolvedores de QA mais focados. Ele inclui apenas casos de teste, relatórios de teste e documentação — sem permitir a edição de endpoints. Este design garante que os testadores possam se concentrar em criar e executar casos de teste de forma eficiente.

Os Cenários de Teste, em contraste, conectam múltiplos endpoints ou casos de teste. Eles permitem definir a ordem de execução e as relações de passagem de dados entre os endpoints, simulando efetivamente um processo de negócio completo.

Com a IA integrada tanto nos Testes de Endpoint quanto nos Cenários de Teste, o teste de API pode mudar gradualmente para uma execução mais automatizada, reutilizável e eficiente. A seguir, exploraremos como esses dois métodos de teste ajudam a resolver desafios do mundo real.

Testes de Endpoint com Automação

O Teste de Endpoint foca em se o próprio endpoint é estável e se a entrada/saída atende às expectativas. Cada caso de teste é executado independentemente, com ênfase na verificação completa de um único endpoint com dados diferentes.

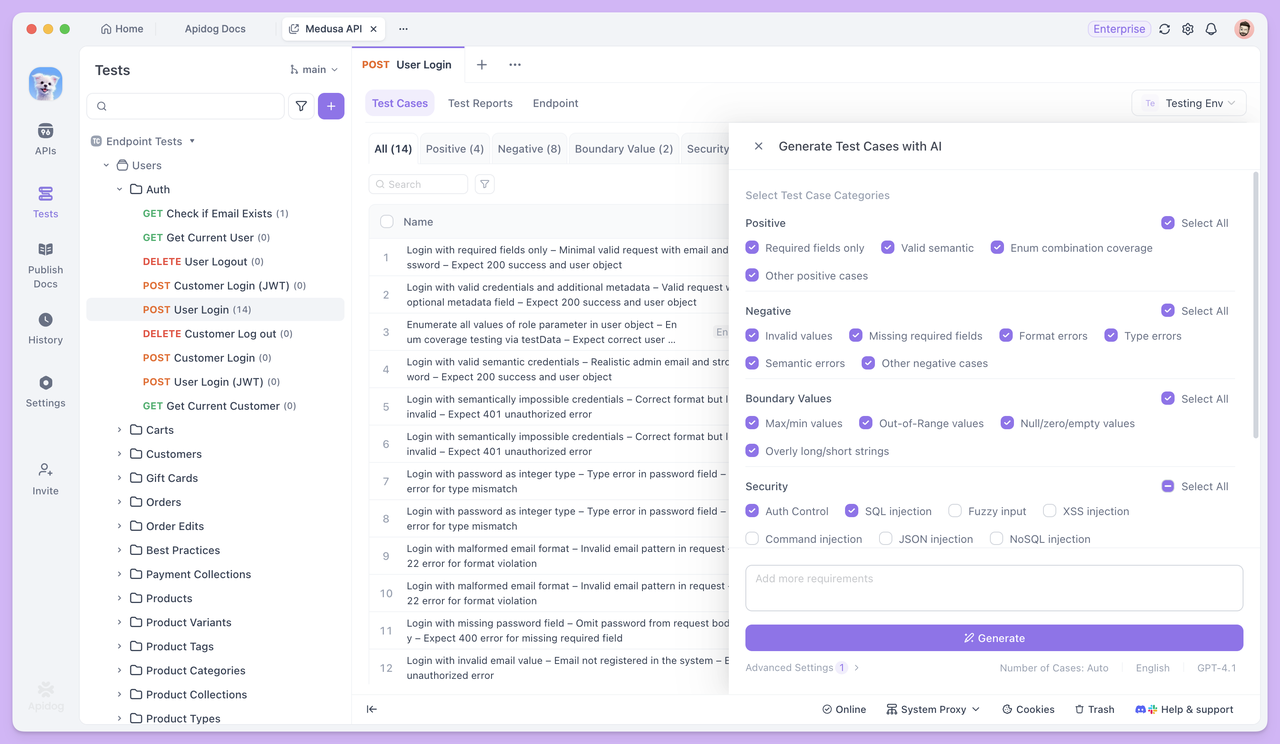

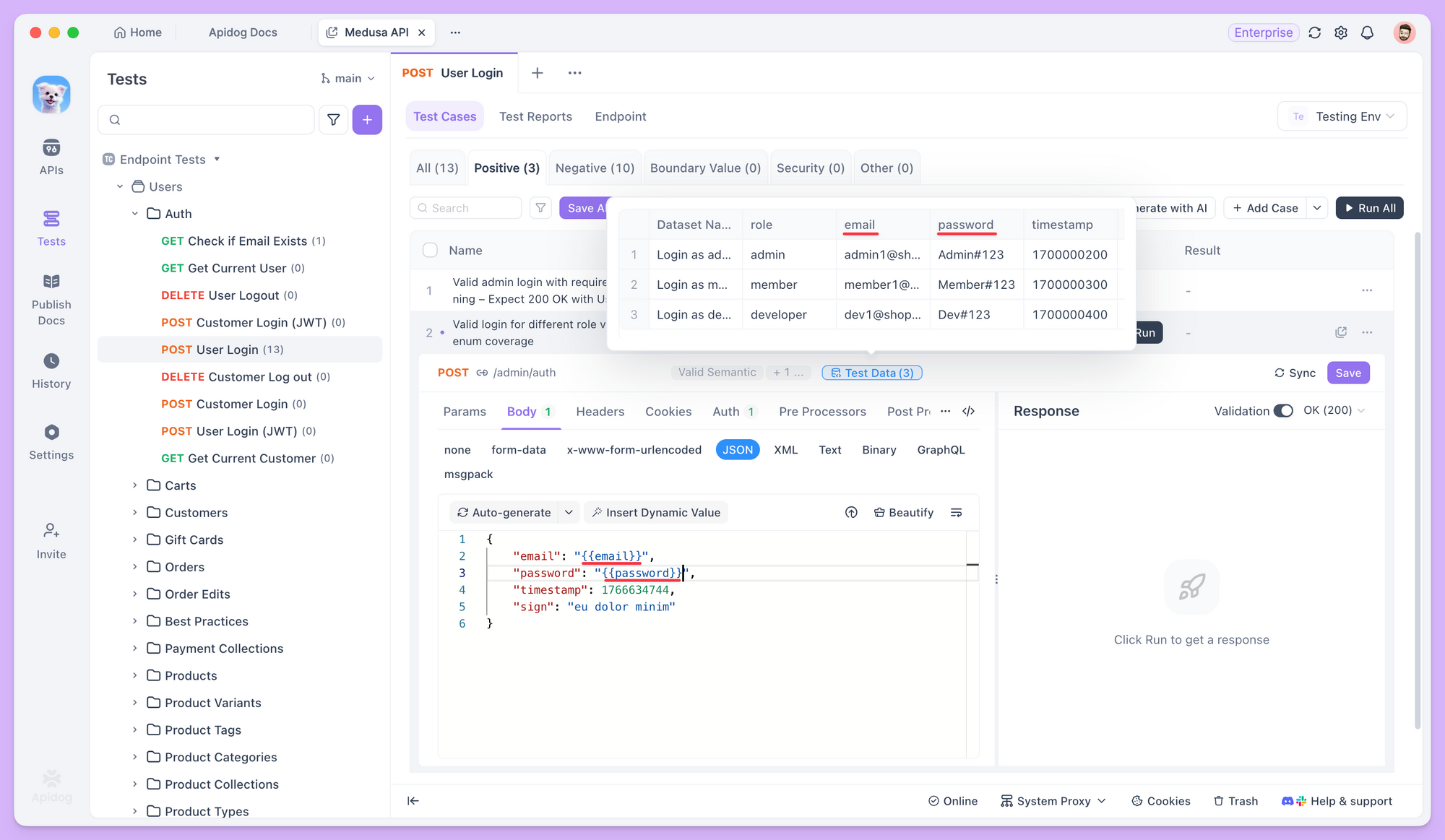

Casos de Teste Gerados por IA

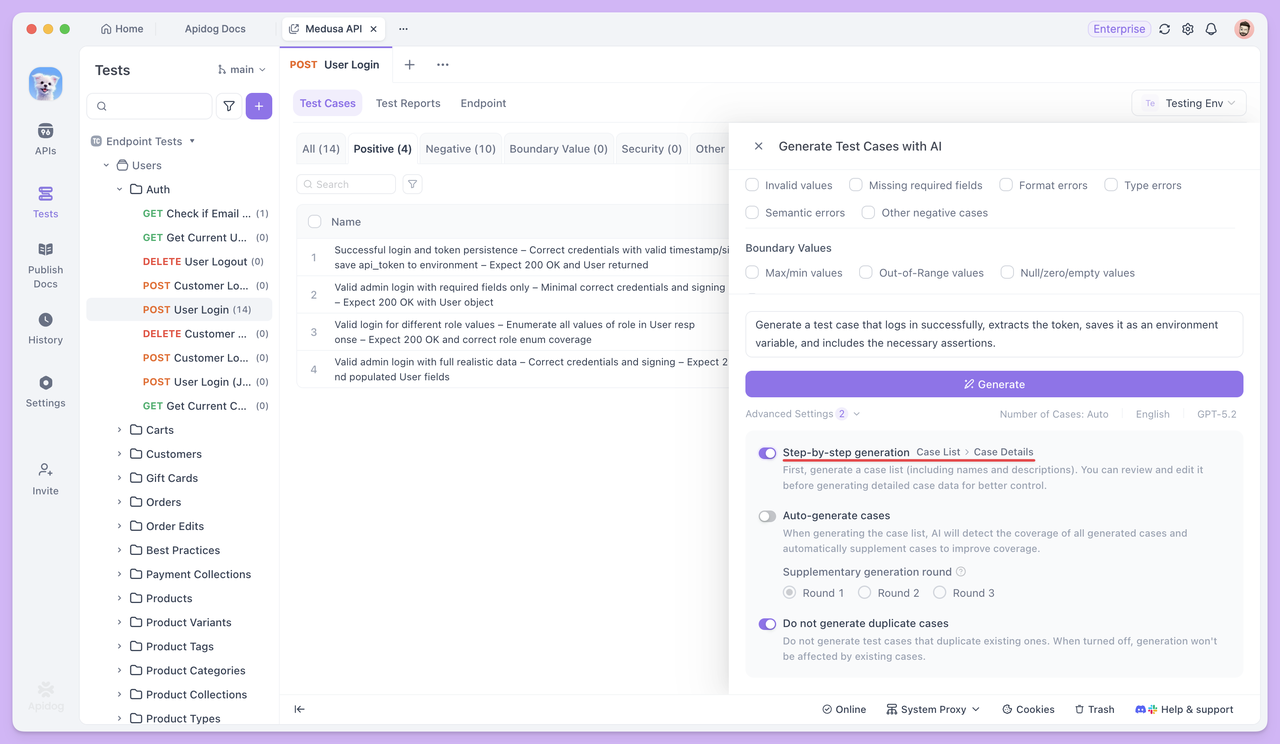

Abra qualquer endpoint no módulo Teste de Endpoint e clique em Gerar com IA. A IA gerará automaticamente um conjunto de casos de teste com base nos parâmetros do endpoint e na estrutura da resposta.

Se você precisar apenas de casos de teste específicos, não há necessidade de selecionar os tipos padrão. Basta descrever seus requisitos diretamente para a IA, e ela gerará o caso de teste correspondente. Por exemplo, você pode pedir à IA para:

- Gerar um caso de teste para "fazer login com sucesso e extrair o token".

- Gerar um caso de teste para "criar o campo de assinatura `sign` com base nos parâmetros existentes e enviá-lo".

Para resultados mais precisos, você pode fornecer condições e regras detalhadas, como:

Gerar um caso de teste positivo para este endpoint.

O endpoint requer um parâmetro de assinatura sign, com as seguintes regras de assinatura:

1. Coletar todos os parâmetros de requisição não vazios (excluindo sign), ordená-los pelo nome do parâmetro em ordem ASCII, concatená-los no formato chave=valor unidos por &, e anexar a chave secreta SECRET_KEY no final.

2. Aplicar hash MD5 à string resultante e converter o hash para maiúsculas. O resultado final é usado como o valor de sign.

Requisitos do caso de teste:

1. Antes de enviar a requisição, usar um script pré-requisição para gerar o sign, com comentários claros incluídos.

2. Adicionar o sign gerado aos parâmetros da requisição e enviar a requisição.Dessa forma, a IA gerará casos estritamente de acordo com suas regras, sem omissões ou mal-entendidos.

Geração de Dados de Teste

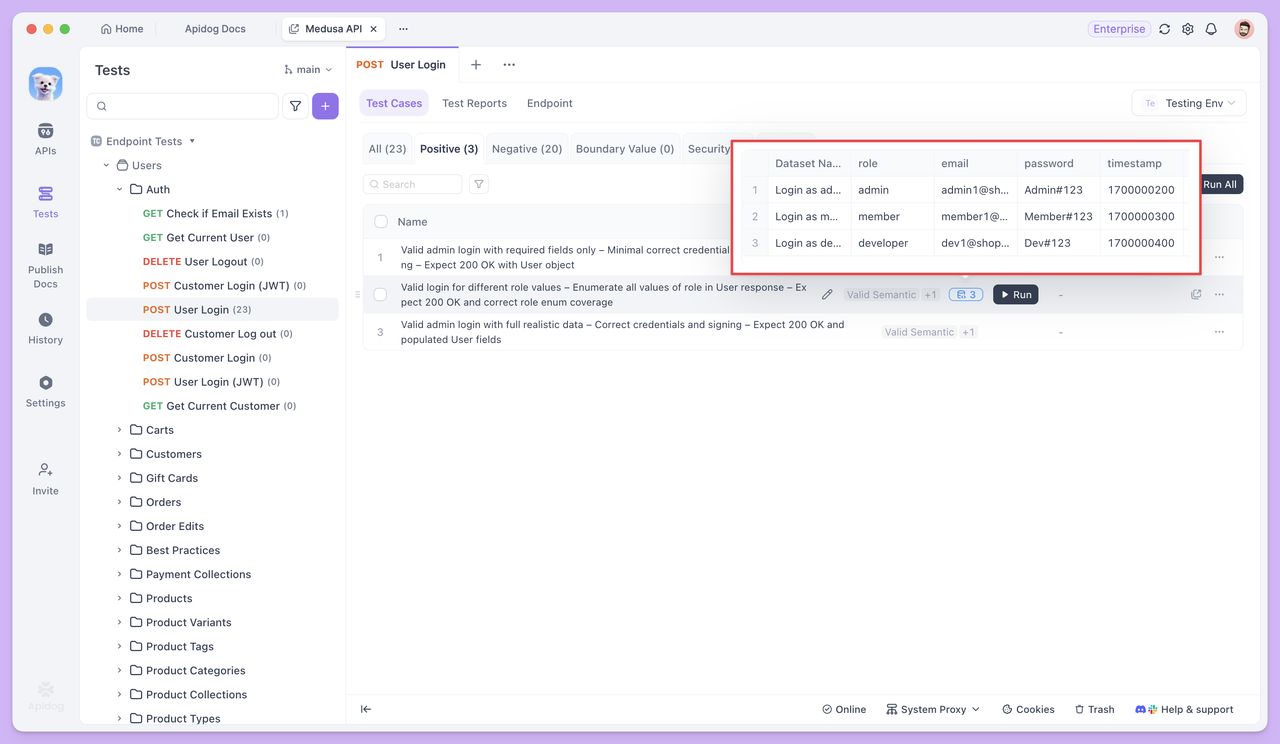

Ao gerar casos de teste, a IA também prepara conjuntos de dados de teste correspondentes para diferentes tipos de casos, a fim de cobrir diversas situações de entrada do mundo real.

Em casos de cenário de negócio padrão, os dados de teste geralmente consistem em múltiplos conjuntos de valores de parâmetros semanticamente válidos. Por exemplo, em um teste de endpoint de login, embora todos os e-mails e senhas sejam válidos, o conjunto de dados incluirá vários formatos de e-mail comuns — como aqueles com pontos, sinais de mais, e-mails numéricos ou e-mails corporativos — para verificar a compatibilidade e estabilidade do endpoint em cenários de uso normal.

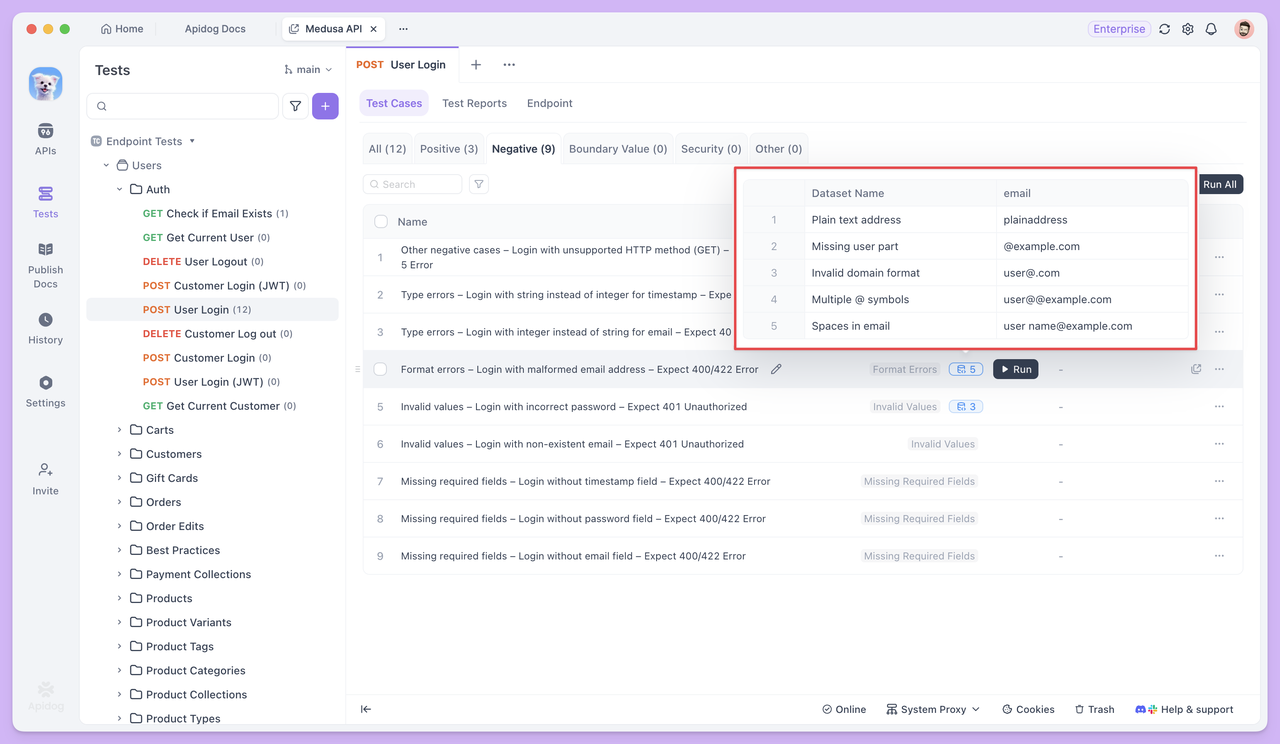

Em casos de teste anormais ou de limite, os dados de teste são intencionalmente projetados para incluir entradas que violam as regras de validação.

Por exemplo, em um caso de teste como "Fazer login com um formato de e-mail inválido e esperar um erro 400", o conjunto de dados conteria diferentes tipos de endereços de e-mail inválidos — como e-mails sem o símbolo `@`, sem um nome de domínio, ou contendo espaços. O objetivo é verificar se o endpoint da API pode detectar corretamente essas entradas inválidas e rejeitar a requisição adequadamente.

Referenciando Dados de Teste

Em casos de teste, você pode usar a sintaxe {{nome_da_variavel}} para referenciar dados de teste e inserir variáveis em parâmetros de requisição, corpos de requisição e outros campos.

Quando o teste é executado, o Apidog extrai automaticamente os valores do conjunto de dados um por um e envia requisições usando cada valor. Isso permite testar o mesmo endpoint várias vezes com dados diferentes — sem precisar reescrever o caso de teste.

Execução em Lote e Relatórios de Teste

Uma vez que os casos de teste e seus dados correspondentes estejam prontos, você pode selecionar múltiplos casos de teste e executá-los juntos. Cada caso de teste é executado independentemente com base em sua própria configuração, e todos os resultados são coletados em um único relatório de teste para fácil revisão.

Em aplicações do mundo real, os endpoints raramente operam isoladamente. Quando a resposta de uma requisição é usada como entrada para a próxima, o teste não é mais sobre um único endpoint, mas sobre a **cadeia de chamadas completa**.

É aqui que os **Cenários de Teste** entram em jogo.

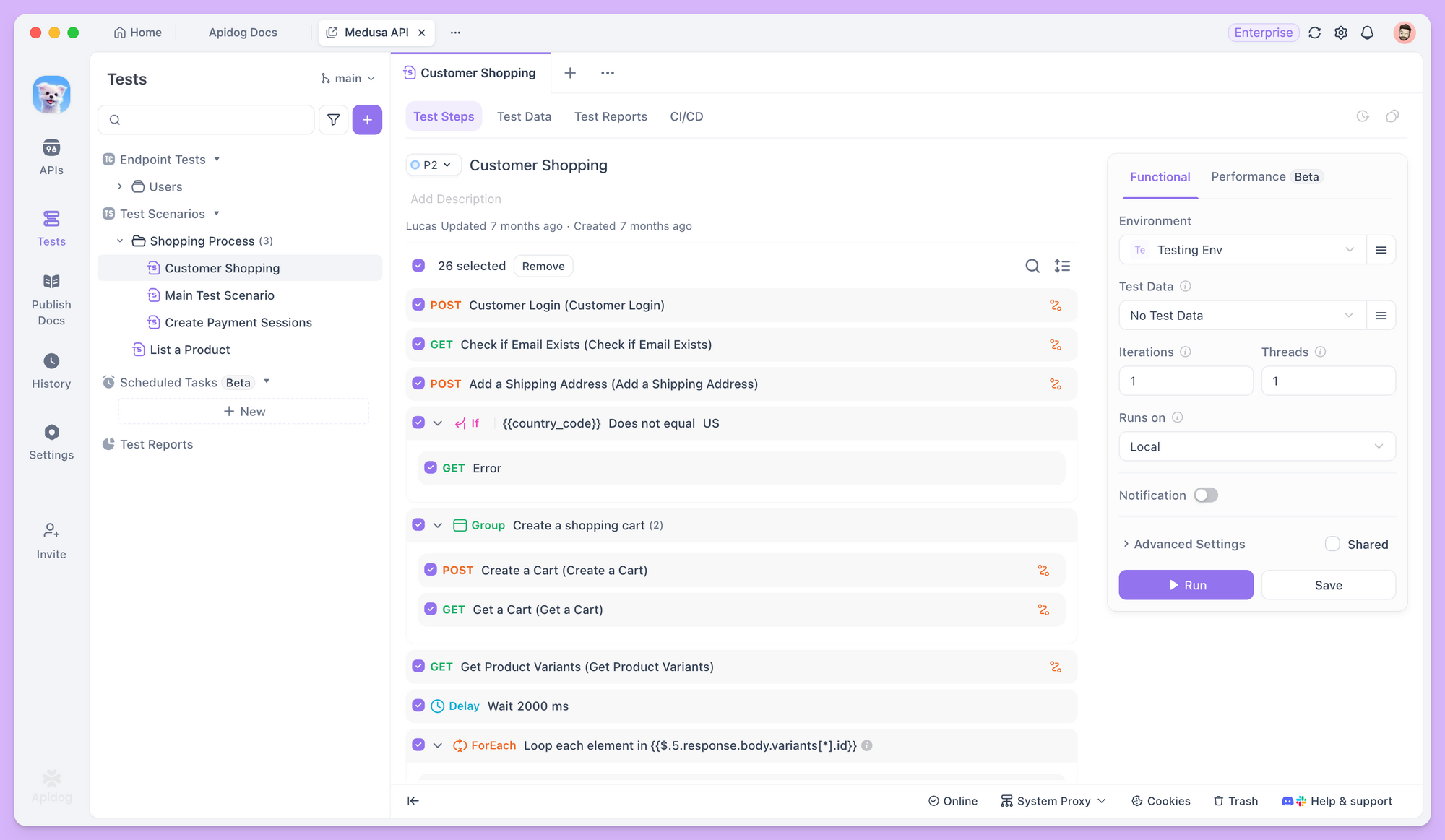

Cenários de Teste

Um único endpoint geralmente não é suficiente para completar uma tarefa de negócio. Por exemplo, um usuário deve fazer login antes de fazer um pedido, e somente depois que o pedido é criado com sucesso, os detalhes do pedido podem ser consultados. A resposta de um endpoint muitas vezes se torna a entrada para o próximo.

Essas dependências são difíceis de validar completamente com um único **teste de endpoint**.

Os **Cenários de Teste** mudam o foco de verificar se um endpoint funciona corretamente para verificar se uma cadeia de chamadas inteira é executada sem problemas e conforme o esperado.

Orquestrando Endpoints em um Fluxo de Trabalho

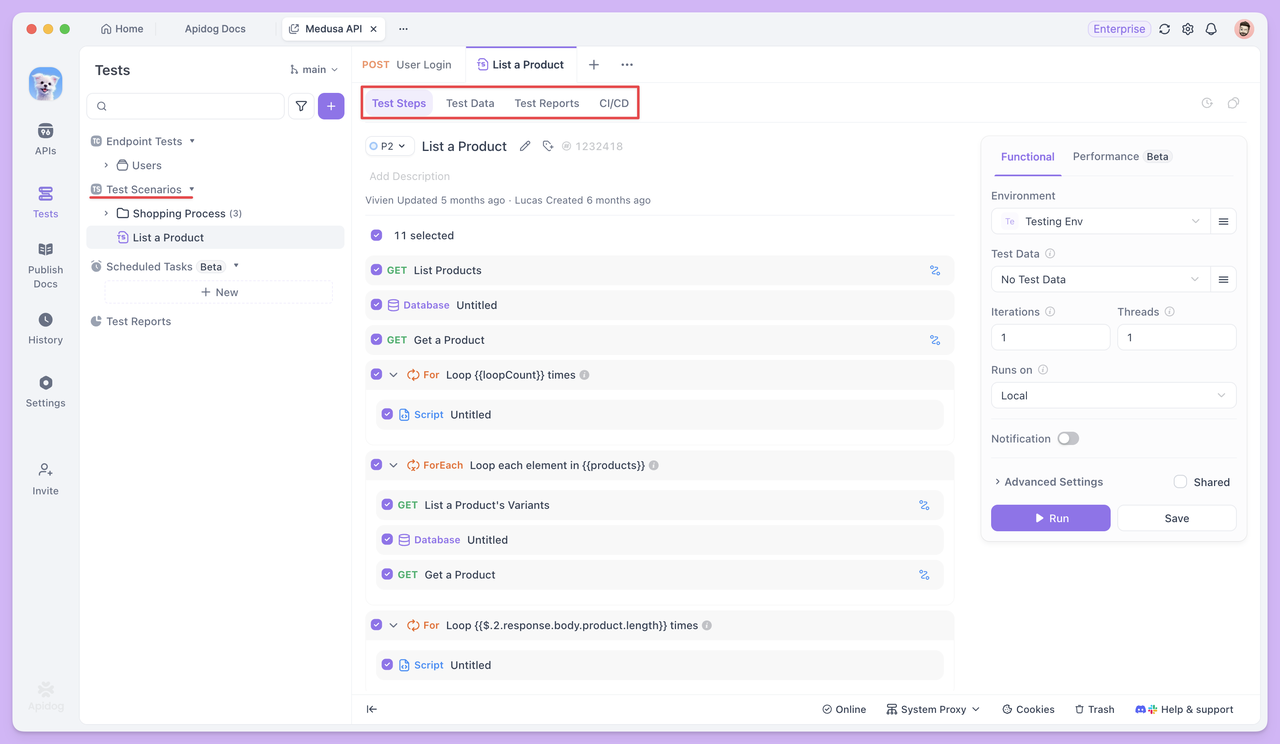

No Apidog, após criar um novo cenário de teste, você pode adicionar múltiplos endpoints ou casos de teste existentes em uma ordem específica, definindo claramente a sequência de execução para cada etapa.

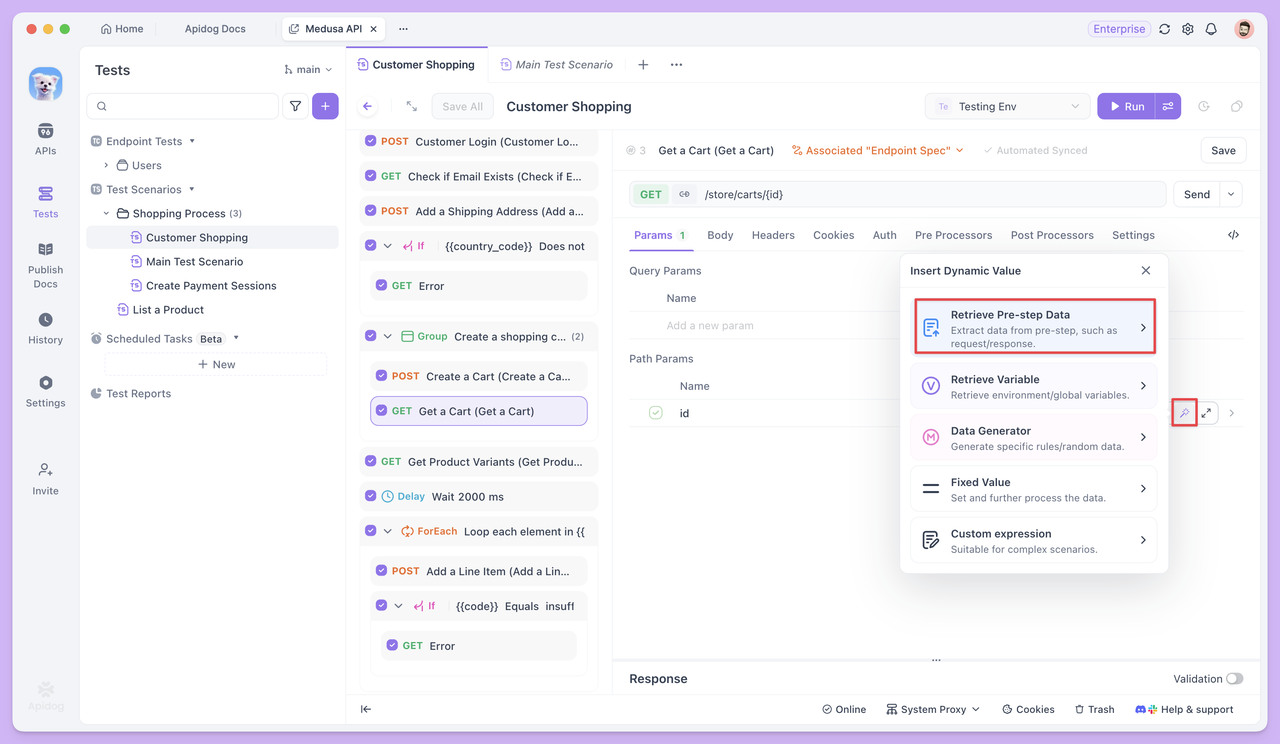

Passando Dados Entre as Etapas do Teste

Quando os endpoints dependem uns dos outros, os cenários de teste permitem que você passe dados de uma etapa para a próxima como variáveis. Por exemplo, o `id` retornado pelo endpoint **Criar Pedido** pode ser reutilizado diretamente em etapas posteriores, como consultar ou atualizar o pedido.

Essa passagem de dados não requer código adicional. Em vez disso, ela se baseia na referência de variáveis para definir claramente as relações a montante e a jusante entre os endpoints.

E se os Casos de Teste Estiverem Ausentes?

Ao orquestrar cenários de teste, o primeiro objetivo é frequentemente garantir que o fluxo de trabalho principal seja executado sem problemas — por exemplo, **Login → Criar Pedido → Consultar Pedido**, onde cada etapa corresponde a um caso de teste existente.

No entanto, na prática, você pode encontrar um desafio comum: **algumas etapas do fluxo de trabalho podem não ter casos de teste prontos, ou os casos existentes podem não atender totalmente aos requisitos do fluxo de trabalho.**

Por exemplo, na etapa de login, você pode precisar não apenas verificar um login bem-sucedido, mas também extrair o token retornado como uma variável de ambiente para requisições subsequentes. Um caso de teste de endpoint único existente pode apenas realizar uma validação básica de login sem lidar com a extração do token.

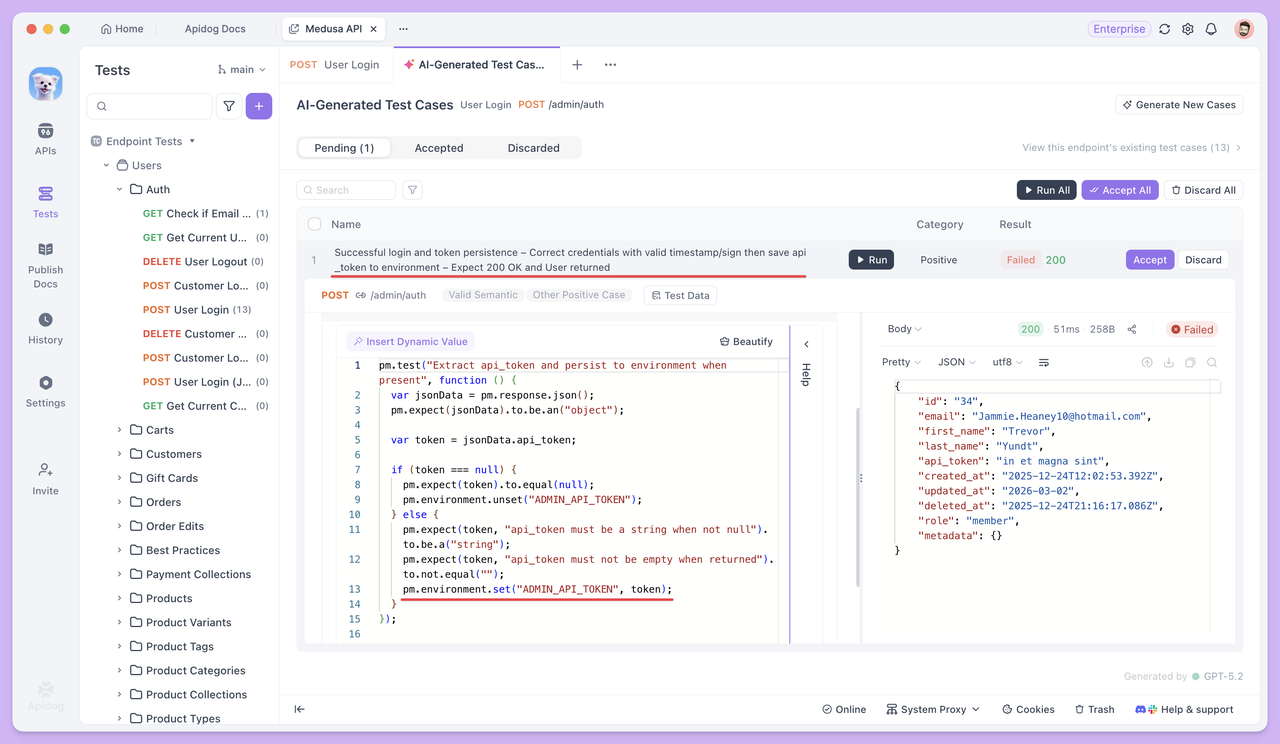

Se você não tem certeza de como extrair campos retornados como variáveis ou não está familiarizado com scripting, você pode pausar a orquestração do cenário. Em seguida, vá para a página **Teste de Endpoint** para aquele endpoint e utilize a IA para lidar com o requisito. Por exemplo, você poderia especificar:

"Gerar um caso de teste que extrai o token e o salva como uma variável de ambiente após um login bem-sucedido, incluindo as asserções necessárias."

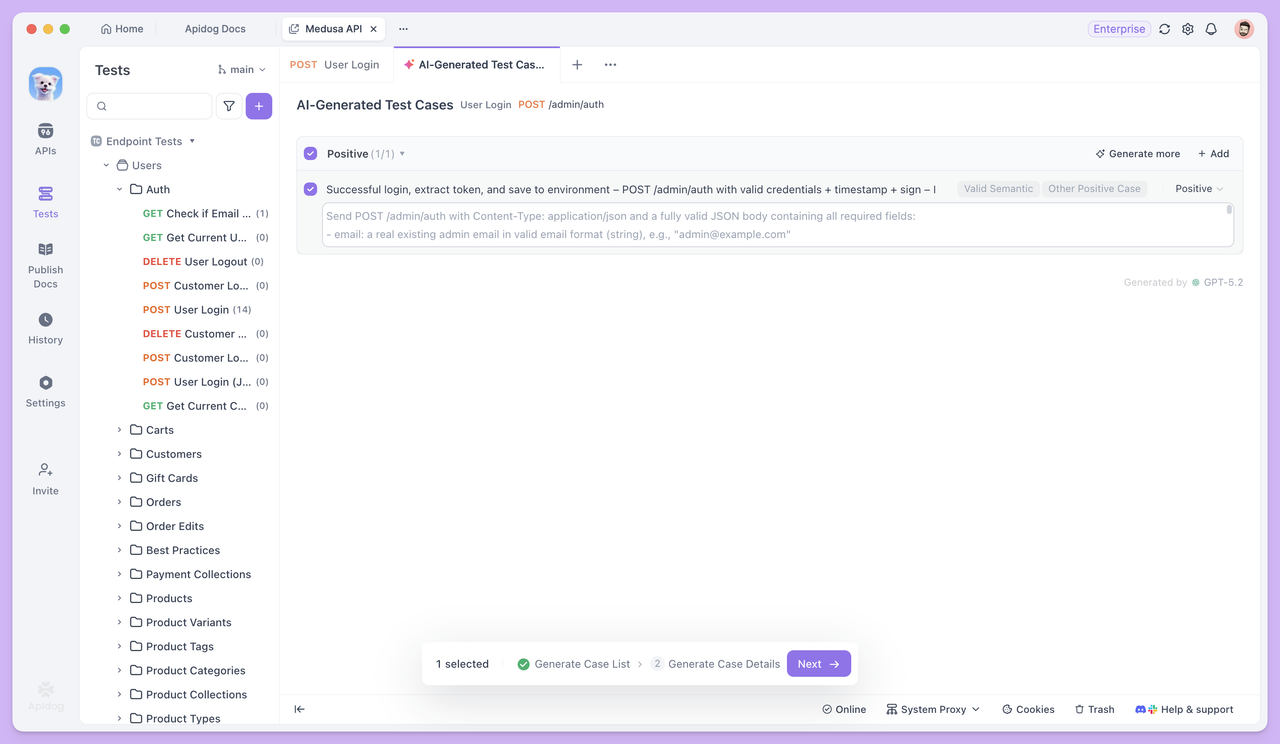

Se você deseja um controle mais preciso sobre seus casos de teste, pode ativar a **geração passo a passo** nas **Configurações Avançadas**.

Uma vez ativado, o Apidog gerará primeiro uma lista de casos de teste, incluindo seus nomes e descrições. Você poderá então revisá-los, modificá-los e confirmá-los manualmente antes de gerar os dados completos e detalhados do caso de teste.

Após a geração do caso de teste, retorne ao cenário de teste. Você pode usar este caso diretamente como a etapa de login, e os endpoints subsequentes podem referenciar o token através de **Valores Dinâmicos**, permitindo que o fluxo de trabalho continue sem interrupções.

Se você precisar de dados de teste em seus **Cenários de Teste**, pode primeiro pedir à IA para gerar casos com **Dados de Teste** no **Teste de Endpoint**. Em seguida, copie o conjunto de dados formatado em CSV para o cenário de teste usando a **Edição em Massa**, tornando a configuração de dados muito mais rápida e conveniente.

Essa abordagem garante que o cenário de teste esteja sempre centrado no **fluxo de trabalho principal**, enquanto a IA atua como um **assistente "preencha à medida que avança"**. Sempre que uma etapa estiver faltando, basta usar a IA para gerar o caso de teste correspondente para aquele endpoint e, em seguida, vinculá-lo de volta ao fluxo de trabalho imediatamente.

Resumo

A IA não mudou **o que os testes de API precisam verificar**, mas reduziu significativamente o esforço necessário para iniciar e concluir os testes.

Durante os **Testes de Endpoint**, a IA aborda principalmente a criação lenta de casos de teste e a cobertura incompleta. Isso permite que os testes avancem mais rapidamente para a fase de validação, em vez de ficarem presos à preparação de dados e à escrita manual de casos.

Quando os testes progridem para os **Cenários de Teste**, o foco muda da verificação de um único endpoint para garantir que os endpoints possam funcionar juntos corretamente em sequências de chamadas reais.

Neste fluxo de trabalho, você não precisa preparar todos os casos de teste com antecedência. À medida que o cenário é gradualmente construído, você pode retornar ao Teste de Endpoint Único a qualquer momento para que a IA gere os casos específicos necessários para o fluxo de trabalho atual, e então continuar orquestrando as etapas. Isso reduz o esforço inicial desnecessário e economiza no uso de créditos.

No geral, o Apidog integra **Teste de Endpoint**, **Cenários de Teste** e **recursos de IA** em um único fluxo de trabalho, transformando os gargalos usuais dos testes de API — escrever casos, preparar dados e encadear processos — em tarefas gerenciáveis.

Se você ainda pensa que testes automatizados significam "configuração complexa e uma curva de aprendizado íngreme", comece pequeno: escolha um único endpoint no Apidog, gere alguns casos e execute um cenário de teste. Você experimentará rapidamente como o processo pode ser muito mais suave e rápido na prática.