Vercel은 v0-1.0-md 모델을 특징으로 하는 v0 API를 통해 AI 분야에 발을 들였습니다. 이 API는 속도, 효율성 및 통합 용이성을 위해 설계된 다양한 기능을 제공하여 개발자가 최신 웹 애플리케이션을 만들 수 있도록 지원합니다. 이 글은 Vercel v0-1.0-md API의 기능, 가격, 시작 방법은 물론 APIdog와 같은 API 개발 도구를 활용하는 방법까지 포괄적인 개요를 제공합니다.

최대 생산성으로 개발 팀이 함께 작업할 수 있는 통합 올인원 플랫폼을 원하시나요?

Apidog는 귀하의 모든 요구를 충족하며 Postman을 훨씬 저렴한 가격으로 대체합니다!

Vercel v0-1.0-md API의 기능

v0-1.0-md 모델은 v0 API의 핵심이며, 현대 웹 개발 과제에 맞춰 강력한 기능 세트를 제공합니다.

프레임워크 인식 완성: 주요 기능 중 하나는 최신 웹 개발 스택을 인식한다는 것입니다. 이 모델은 Next.js 및 Vercel 자체 플랫폼과 같은 인기 프레임워크에 대해 평가 및 최적화되었습니다. 즉, 개발자는 이러한 생태계 내에서 작업할 때 보다 관련성 높고 문맥에 맞는 코드 완성 및 제안을 기대할 수 있습니다.

자동 수정 기능: 첫 시도에 완벽한 코드를 작성하는 것은 드뭅니다. v0-1.0-md 모델은 생성 과정에서 일반적인 코딩 문제를 식별하고 자동으로 수정하여 이를 돕습니다. 이를 통해 디버깅 시간을 크게 줄이고 전반적인 코드 품질을 향상시킬 수 있습니다.

빠른 편집 기능: 속도는 v0 API의 반복되는 주제입니다. 빠른 편집 기능은 인라인 편집이 가능해지면 스트리밍합니다. 이 실시간 피드백 루프를 통해 개발자는 변경 사항을 즉시 확인할 수 있어 보다 동적이고 상호 작용적인 개발 경험을 얻을 수 있습니다.

OpenAI 호환성: OpenAI API 표준의 광범위한 채택을 인식하여 Vercel은 v0-1.0-md 모델이 OpenAI 채팅 완성 API 형식과 호환되도록 보장했습니다. 이는 개발자가 이미 OpenAI 구조를 지원하는 기존 도구, SDK 또는 라이브러리를 사용하여 v0 API를 사용할 수 있도록 하므로 상당한 이점입니다. 이러한 상호 운용성은 진입 장벽을 낮추고 기존 워크플로에 더 쉽게 통합할 수 있도록 합니다.

다중 모드 입력: API는 텍스트 기반 상호 작용에만 국한되지 않습니다. 다중 모드 입력을 지원하며, 이는 텍스트 및 이미지 데이터를 모두 처리할 수 있음을 의미합니다. 이미지는 Base64로 인코딩된 데이터로 제공해야 합니다. 이는 텍스트 프롬프트와 함께 시각적 정보를 기반으로 콘텐츠를 이해하거나 생성해야 하는 애플리케이션에 다양한 가능성을 열어줍니다.

함수/도구 호출: 최신 AI 애플리케이션은 종종 외부 시스템과의 상호 작용 또는 특정 기능 실행을 요구합니다. v0-1.0-md 모델은 함수 및 도구 호출을 지원하여 개발자가 AI가 호출할 수 있는 사용자 지정 도구를 정의할 수 있도록 합니다. 이를 통해 모델의 기능이 단순한 텍스트 생성 이상으로 확장되어 응답 생성의 일부로 작업을 수행하거나, 다른 API에서 데이터를 검색하거나, 다른 서비스와 상호 작용할 수 있습니다.

저지연 스트리밍 응답: 챗봇 또는 라이브 코딩 도우미와 같이 실시간 상호 작용이 필요한 애플리케이션의 경우 대기 시간은 중요한 요소입니다. v0 API는 빠르고 스트리밍되는 응답을 제공하도록 설계되었습니다. 즉, 전체 응답이 생성될 때까지 기다리는 대신, 데이터가 사용 가능해지면 청크 단위로 전송되어 훨씬 더 반응적이고 매력적인 사용자 경험을 제공합니다.

웹 개발에 최적화: 이 모델은 프런트엔드 및 풀스택 웹 개발 작업에 특별히 최적화되었습니다. 이러한 초점은 UI 구성 요소 생성부터 서버 측 로직 작성에 이르기까지 최신 웹 애플리케이션 구축의 일반적인 과제 및 요구 사항에 맞춰 훈련 및 기능이 조정되도록 보장합니다.

개발자는 Vercel이 제공하는 AI Playground에서 v0-1.0-md 모델을 직접 실험해 볼 수 있습니다. 이를 통해 프로젝트에 통합하기 전에 다양한 프롬프트를 테스트하고 모델의 응답을 관찰하며 기능을 파악할 수 있습니다.

Vercel v0 API 가격 및 접근

Vercel v0 API 및 결과적으로 v0-1.0-md 모델에 대한 접근은 현재 베타 버전입니다. API를 사용하려면 사용량 기반 청구가 활성화된 Premium 또는 Team 플랜에 가입해야 합니다. 가격 구조에 대한 자세한 정보는 일반적으로 Vercel 공식 가격 페이지에서 찾을 수 있습니다. 많은 베타 프로그램과 마찬가지로 최신 약관 및 조건을 Vercel에서 직접 확인하는 것이 좋습니다.

API 사용을 시작하려면 v0.dev에서 API 키를 생성하는 것이 첫 번째 단계입니다. 이 키는 API에 대한 요청을 인증하는 데 사용됩니다.

사용량 제한

대부분의 API 서비스와 마찬가지로 Vercel v0 API에는 공정한 사용을 보장하고 서비스 안정성을 유지하기 위한 사용량 제한이 있습니다. v0-1.0-md 모델에 대해 현재 문서화된 제한은 다음과 같습니다.

- 일일 최대 메시지 수: 200

- 최대 컨텍스트 창 크기: 128,000 토큰

- 최대 출력 컨텍스트 크기: 32,000 토큰

이러한 제한은 특히 API가 베타 단계를 벗어남에 따라 변경될 수 있습니다. 더 높은 제한이 필요한 사용자 또는 애플리케이션의 경우 Vercel은 잠재적인 증가에 대해 논의할 수 있는 연락처(support@v0.dev)를 제공합니다. 또한 API를 사용함으로써 개발자는 Vercel의 API 약관에 동의하는 것입니다.

Vercel v0 API 사용 방법

Vercel v0 API를 프로젝트에 통합하는 것은 특히 OpenAI API 형식에 익숙하거나 Vercel 생태계를 사용하는 개발자에게는 간단하게 설계되었습니다.

AI SDK와의 통합: Vercel은 <V0Text /> 및 기타 OpenAI 호환 모델 작업을 위해 특별히 설계된 TypeScript 라이브러리인 자체 AI SDK 사용을 권장합니다. 이 SDK는 API 호출, 응답 처리 및 애플리케이션에 AI 기능 통합 프로세스를 단순화합니다.

시작하려면 일반적으로 필요한 패키지를 설치합니다.

npm install ai @ai-sdk/openai

사용 예 (JavaScript/TypeScript):

다음 예는 AI SDK의 generateText 함수를 사용하여 v0-1.0-md 모델과 상호 작용하는 방법을 보여줍니다.

import { generateText } from 'ai';

import { createOpenAI } from '@ai-sdk/openai';

// Configure the Vercel v0 API client

const vercel = createOpenAI({

baseURL: 'https://api.v0.dev/v1', // The v0 API endpoint

apiKey: process.env.VERCEL_V0_API_KEY, // Your Vercel v0 API key

});

async function getAIChatbotResponse() {

try {

const { text } = await generateText({

model: vercel('v0-1.0-md'), // Specify the Vercel model

prompt: 'Create a Next.js AI chatbot with authentication',

});

console.log(text);

return text;

} catch (error) {

console.error("Error generating text:", error);

// Handle the error appropriately

}

}

getAIChatbotResponse();

이 예에서:

ai라이브러리에서generateText를,@ai-sdk/openai에서createOpenAI를 가져옵니다.createOpenAI를 사용하여 OpenAI 호환 클라이언트를 생성하고, v0 API의 기본 URL(https://api.v0.dev/v1)과 Vercel v0 API 키(예: 환경 변수로 안전하게 저장해야 함)로 구성합니다.- 구성된

vercel클라이언트(v0-1.0-md모델 지정)와 원하는 프롬프트를 전달하여generateText함수를 호출합니다. - 생성된 텍스트를 포함하는 API의 응답은

text변수에서 사용할 수 있습니다.

API 참조:

SDK 없이 직접 API와 상호 작용하거나 기본 메커니즘을 이해하려면 API 참조가 핵심입니다.

엔드포인트: POST https://api.v0.dev/v1/chat/completions

이 단일 엔드포인트는 대화 기록을 기반으로 모델 응답을 생성하는 데 사용됩니다.

헤더:

Authorization: 필수.Bearer $V0_API_KEY형식의 Bearer 토큰.Content-Type: 필수.application/json이어야 합니다.

요청 본문: 요청 본문은 다음 주요 필드를 가진 JSON 객체입니다.

model(문자열, 필수): 모델 이름. 이 API의 경우"v0-1.0-md"여야 합니다.messages(배열, 필수): 대화 기록을 구성하는 메시지 객체 목록. 각 메시지 객체는 다음을 포함해야 합니다.role(문자열, 필수): 발신자를 식별하며"user","assistant"또는"system"일 수 있습니다.content(문자열 또는 배열, 필수): 실제 메시지 내용. 단순 문자열 또는 다중 모드 입력을 위한 텍스트 및 이미지 블록 배열일 수 있습니다.stream(부울, 선택 사항):true로 설정하면 API는 응답을 Server-Sent Events(SSE) 스트림으로 반환합니다. 기본값은false입니다.tools(배열, 선택 사항): 모델이 호출할 수 있는 사용자 지정 도구(예: 함수)의 정의.tool_choice(문자열 또는 객체, 선택 사항): 도구가 제공된 경우 모델이 호출해야 하는 도구를 지정합니다.

요청 예 (cURL):

다음은 cURL을 사용하여 직접 API 호출을 수행하는 방법입니다.

curl https://api.v0.dev/v1/chat/completions \

-H "Authorization: Bearer $V0_API_KEY" \

-H "Content-Type: application/json" \

-d '{

"model": "v0-1.0-md",

"messages": [

{ "role": "user", "content": "Create a Next.js AI chatbot" }

]

}'

스트리밍 예 (cURL):

스트리밍된 응답을 받으려면:

curl https://api.v0.dev/v1/chat/completions \

-H "Authorization: Bearer $V0_API_KEY" \

-H "Content-Type: application/json" \

-d '{

"model": "v0-1.0-md",

"stream": true,

"messages": [

{ "role": "user", "content": "Add login to my Next.js app" }

]

}'

응답 형식:

비스트리밍 (stream: false): API는 전체 응답을 포함하는 단일 JSON 객체를 반환합니다. 이 객체에는 id, model 이름, object 유형(예: chat.completion), created 타임스탬프 및 choices 배열이 포함됩니다. 배열의 각 선택 항목에는 message(role: "assistant" 및 응답 content 포함)와 finish_reason(예: "stop")이 포함됩니다.

{

"id": "v0-123",

"model": "v0-1.0-md",

"object": "chat.completion",

"created": 1715620000,

"choices": [

{

"index": 0,

"message": {

"role": "assistant",

"content": "Here's how to add login to your Next.js app..."

},

"finish_reason": "stop"

}

]

}

스트리밍 (stream: true): 서버는 Server-Sent Events(SSE)로 형식이 지정된 일련의 데이터 청크를 보냅니다. 각 이벤트는 data: 로 시작하며, 그 뒤에 응답의 부분적인 델타를 나타내는 JSON 객체가 옵니다. 이를 통해 클라이언트는 응답을 점진적으로 처리할 수 있습니다.

data: {

"id": "v0-123",

"model": "v0-1.0-md",

"object": "chat.completion.chunk",

"choices": [

{

"delta": {

"role": "assistant",

"content": "Here's how"

},

"index": 0,

"finish_reason": null

}

]

}

최종 청크에는 일반적으로 null이 아닌 finish_reason이 있습니다.

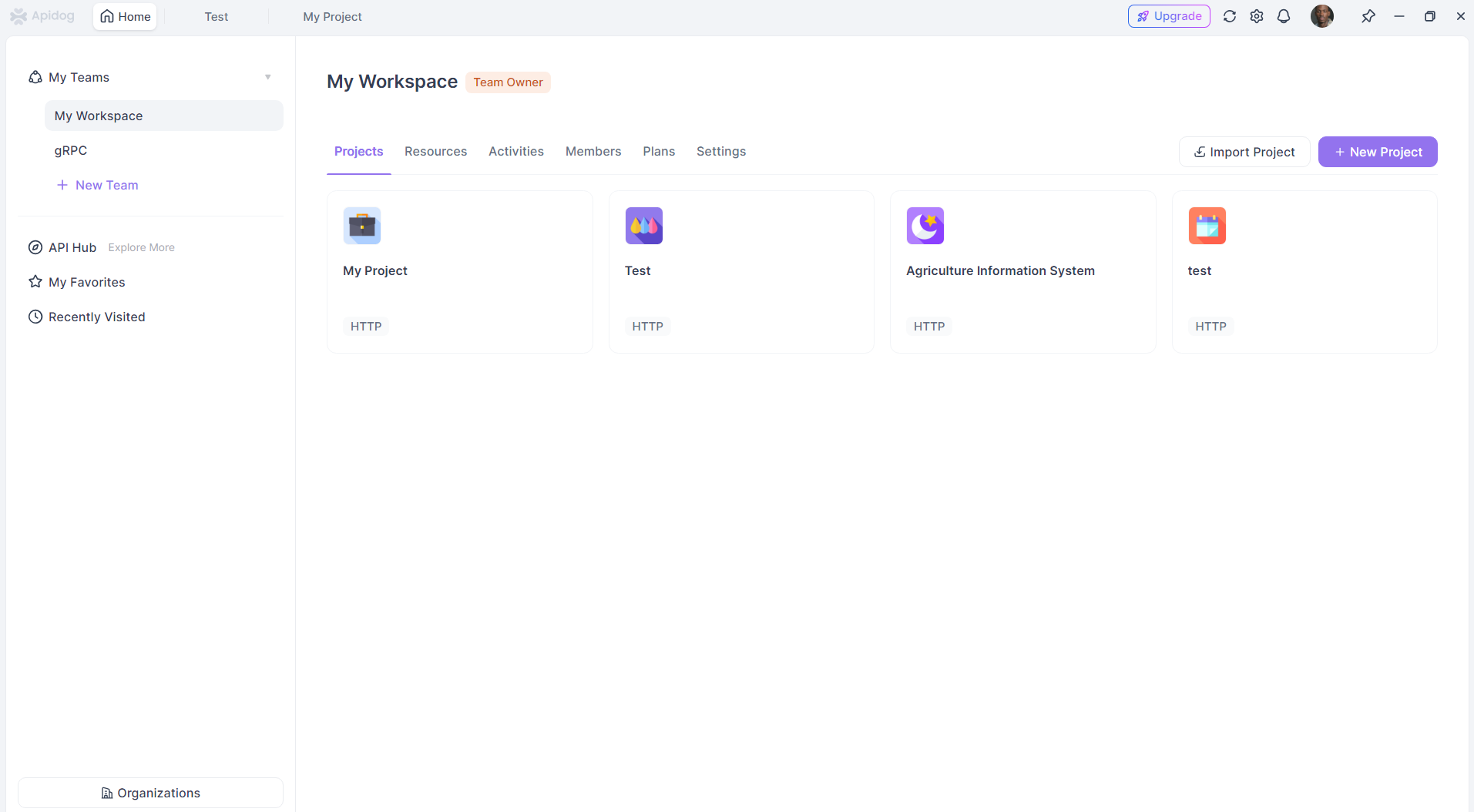

APIdog와 함께 Vercel v0 API 사용하기

APIdog는 API 설계, 개발, 테스트 및 문서화를 위해 설계된 포괄적인 API 플랫폼입니다. 그 강점은 API 수명 주기의 이러한 다양한 단계를 통합하는 데 있습니다. 다른 HTTP 기반 API와 마찬가지로 APIdog를 사용하여 Vercel v0 API와 상호 작용할 수 있습니다.

다음은 APIdog를 사용하여 Vercel v0 API를 사용하는 일반적인 접근 방식입니다.

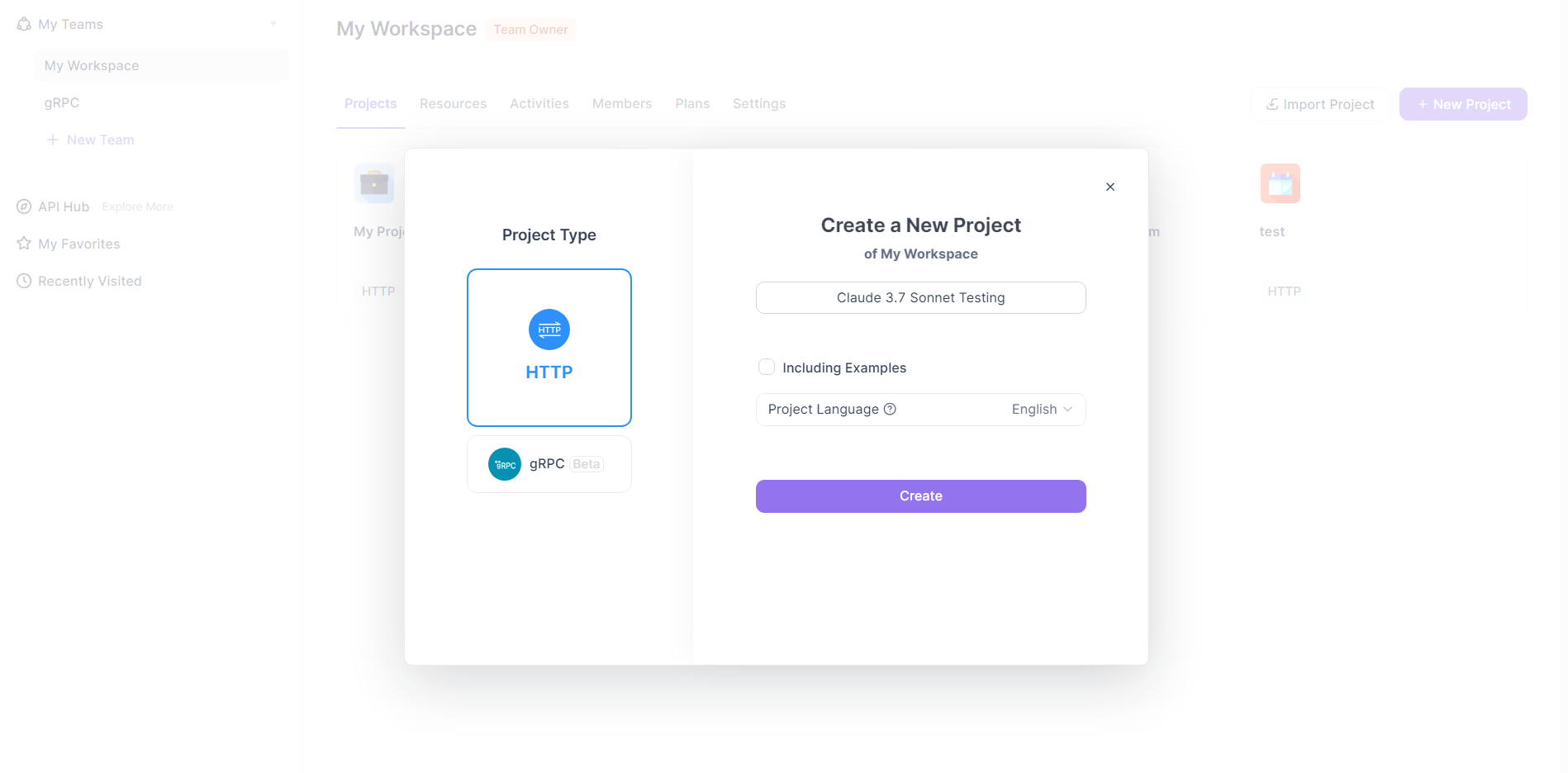

APIdog에서 새 요청 생성:

- APIdog 프로젝트 내에서 새 요청 생성을 시작합니다. 일반적으로 "+" 아이콘을 클릭하고 "새 요청" 또는 유사한 옵션을 선택하여 수행합니다.

- APIdog는 다양한 요청 유형을 지원합니다. Vercel v0 API의 경우 HTTP 요청을 생성하게 됩니다.

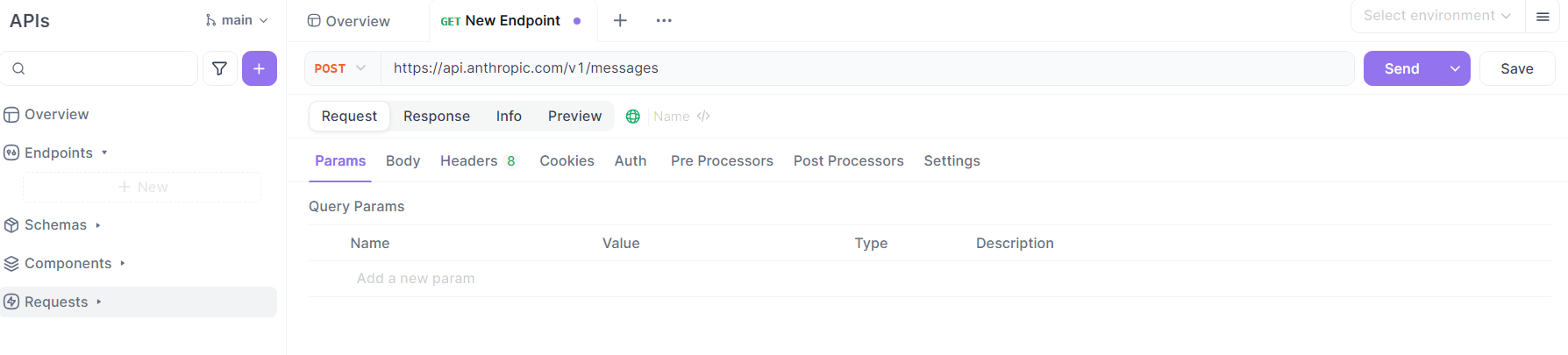

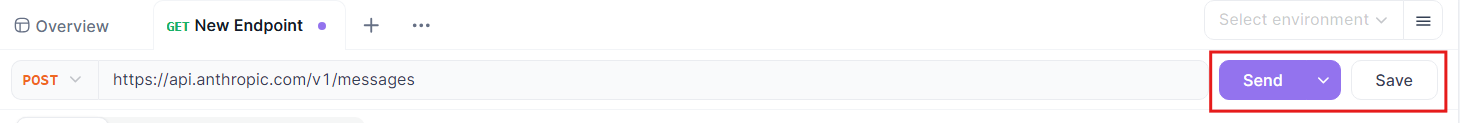

요청 세부 정보 구성:

- 메서드: Vercel v0 API 문서에 지정된 대로 HTTP 메서드로

POST를 선택합니다. - URL: Vercel v0 API 엔드포인트인

https://api.v0.dev/v1/chat/completions를 입력합니다. - 헤더:

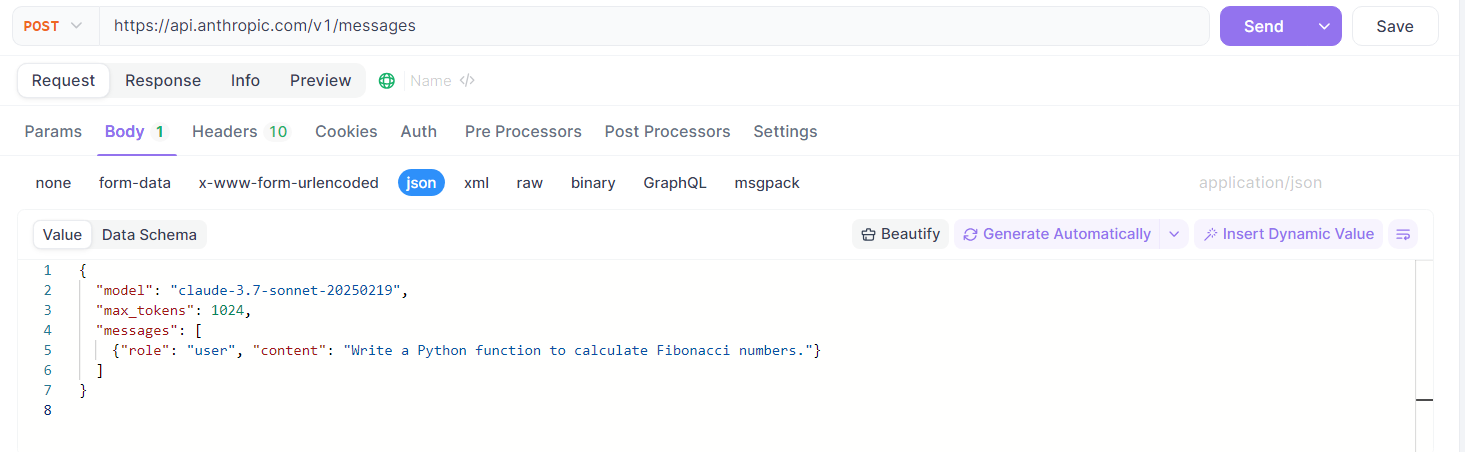

Authorization헤더를 추가합니다. 값은Bearer YOUR_VERCEL_V0_API_KEY여야 하며,YOUR_VERCEL_V0_API_KEY를 v0.dev에서 얻은 실제 API 키로 바꿉니다.Content-Type헤더를 값application/json과 함께 추가합니다.- 본문:

APIdog에서 "본문" 탭으로 전환하고 "raw" 입력 유형을 선택한 다음 형식으로 "JSON"을 선택합니다.

Vercel v0 API 사양에 따라 JSON 페이로드를 구성합니다. 예를 들어:

{

"model": "v0-1.0-md",

"messages": [

{ "role": "user", "content": "Generate a React component for a loading spinner." }

],

"stream": false // or true, depending on your needs

}

원하는 대화 기록 및 프롬프트로 messages 배열을 사용자 지정할 수 있습니다. 필요에 따라 stream, tools 또는 tool_choice와 같은 선택적 필드를 포함할 수도 있습니다.

요청 보내기:

- 모든 세부 정보가 구성되면 APIdog에서 "보내기" 버튼을 클릭합니다.

응답 보기:

- APIdog는 응답 패널에 서버의 응답을 표시합니다.

stream이false이면 완전한 JSON 응답을 볼 수 있습니다.stream이true이면 APIdog의 SSE 처리가 다를 수 있습니다. 청크가 도착할 때 표시하거나 누적할 수 있습니다. 스트리밍 응답 처리에 대한 자세한 내용은 APIdog 문서를 참조하십시오. 더 고급 스트림 처리를 위해 APIdog의 스크립팅 기능 또는 테스트 시나리오를 사용해야 할 수도 있습니다.

APIdog 기능 활용 (선택 사항):

- 환경: 다른 요청 또는 프로젝트에서 더 쉽게 관리할 수 있도록 APIdog에

V0_API_KEY및 기본 URL(https://api.v0.dev)을 환경 변수로 저장합니다. - 엔드포인트 저장: 구성된 이 요청을 APIdog의 "엔드포인트 케이스" 또는 API 정의 내에 저장합니다. 이를 통해 Vercel v0 API와의 상호 작용을 쉽게 재사용하고 버전을 관리할 수 있습니다.

- 테스트 시나리오: 일련의 호출을 수행하거나 Vercel v0 API를 더 큰 테스트 워크플로에 통합해야 하는 경우 APIdog에서 테스트 시나리오를 생성합니다.

- 자동 유효성 검사: APIdog 내에서 Vercel v0 API에 대한 API 사양을 정의하거나(사용 가능한 경우 가져오기) APIdog는 이 스키마에 대해 응답의 유효성을 자동으로 검사할 수 있습니다.

이 단계를 따르면 APIdog를 클라이언트로 효과적으로 사용하여 Vercel v0 API에 요청을 보내고, 응답을 검사하고, 구조화된 방식으로 API 상호 작용을 관리할 수 있습니다. 이는 개발 및 테스트 단계에서 프롬프트 테스트, API 기능 탐색, AI 생성 콘텐츠 또는 로직을 애플리케이션에 통합하는 데 특히 유용합니다.

결론

Vercel v0-1.0-md API는 Vercel이 AI 지원 개발 영역으로 진입하는 중요한 단계를 나타냅니다. 최신 웹 프레임워크, OpenAI 호환성, 자동 수정 및 다중 모드 입력과 같은 기능에 중점을 두어 차세대 웹 애플리케이션 구축을 목표로 하는 개발자에게 매력적인 옵션입니다. 현재 베타 버전이며 특정 플랜 요구 사항이 적용되지만, API 설계와 지원되는 AI SDK는 강력하면서도 접근 가능한 도구를 제공하려는 노력을 시사합니다. REST API를 통해 직접 사용하든, AI SDK를 통해 사용하든, 또는 APIdog와 같은 도구로 관리하든, v0-1.0-md 모델은 고급 AI 기능을 웹 개발 워크플로에 통합하여 작업을 간소화하고 새로운 창의적 가능성을 열어주는 유망한 길을 제공합니다. API가 성숙해지고 잠재적으로 제공 범위를 확장함에 따라, 프로젝트에서 AI 활용에 열심인 개발자들에게 의심할 여지 없이 주목해야 할 공간이 될 것입니다.